unicode 字符范围从 0x0000 到 0xFFFF,包含可能看到和接触到的所有(各种语言的)标准打印字符,这些字符成为基本多语言平面( Basic Multilingual Plane, Bmp)。

在Bmp集之外还有很多其他扩展Unicode字符,范围直到0x10FFFF。这些符号通常是星形符号(astral symbol)。这个名称是指BMP之外的字符的16个平面的集合

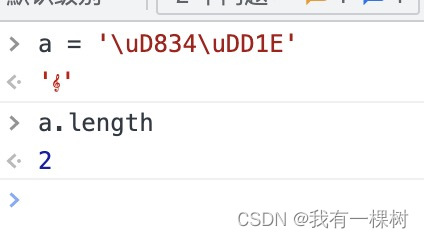

对于某些星形符号,使用 .length 计算长度不准确,比如,下面的例子变量 a 实际上是一个字符,但是 长度是2,这样显然是不对的

这种情况,可以使用 Array.from(a).length 才能算出字符真正的长度

let a = '\uD834\uDD1E'

console.log(a.length)

console.log(Array.from(a).length)

466

466

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?