EM算法是一种迭代算法,分为E、M两步。他就是含有隐变量的概率模型参数的极大似然估计法,或极大后验概率估计法 (将求已知量P(Y|θ)转换为求隐变量P(Y|Z,θ)P(Z|θ)的过程)

E步:利用当前估计的参数值,求出在该参数下隐含变量的条件概率值(计算对数似然的期望值);

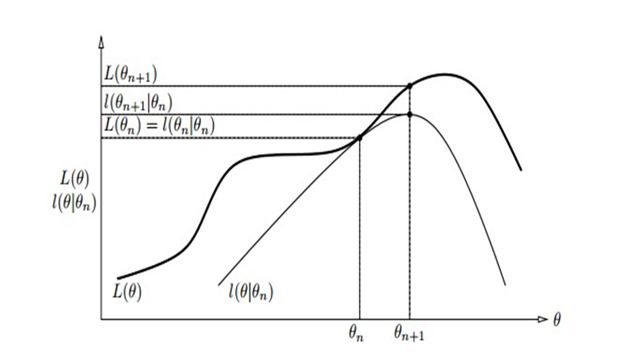

M步:结合E步求出的隐含变量条件概率,求出似然函数下界函数的最大值(寻找能使E步产生的似然期望最大化的参数 值。)然后,新得到的参数值重新被用于E步.....直到收敛到局部最优解。(note:每次迭代实际在求Q函数及其极大,即每次迭代使似然函数增大或达到局部极值。)

优点:简单性和普适性,可看作是一种非梯度优化方法(解决梯度下降等优化方法的缺陷:求和的项数将随 着隐变量的数目以指数级上升,会给梯度计算带来麻烦)

缺点:对初始值敏感,不同的初值可能得到不同的参数估计值;不能保证找到全局最优值。

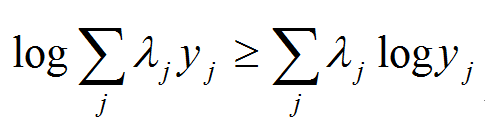

一、Jensen 不等式

在EM算法的推导过程中,用到了数学上的Jensen不等式,这里先来介绍一下。

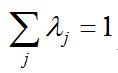

其中

二、EM算法推导

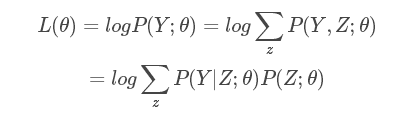

面对一个含有隐含变量Z的概率模型,目标是极大化观测数据Y关于参数 θ 的对数似然函数,即极大化:

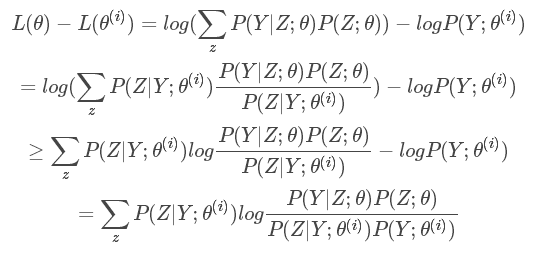

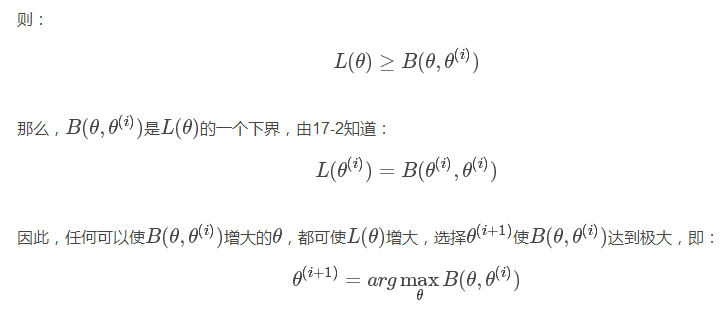

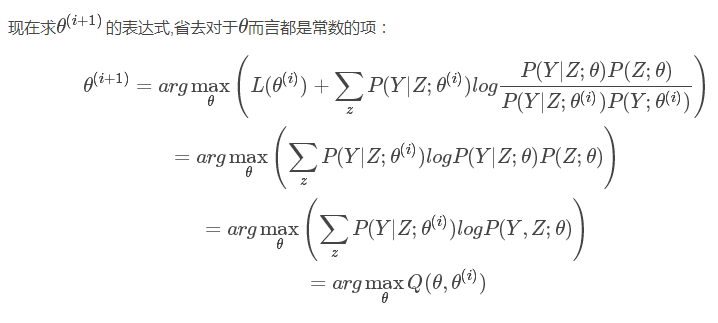

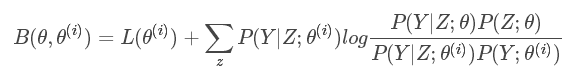

事实上,EM算法是通过迭代逐步极大化L(θ)L(θ)的。假设在第ii次迭代后θθ的估计值是θ(i)θ(i)。我们希望新的估计值θθ能使L(θ)L(θ)增加,即L(θ)>L(θ(i))L(θ)>L(θ(i)),并逐步达到极大值。为此考虑两者的差:

上式利用了Jensen不等式, 且∑zP(Z|Y;θ(i))=1∑zP(Z|Y;θ(i))=1,则可得上述推导。注意loglog为凹函数,不等号要改变方向

令

三、EM算法在高斯混合模型中的应用:

高斯混合模型:

步骤:(1)明确隐变量,写出完全数据的对数似然函数。

(2)EM算法的E步:确定Q函数(即:完全数据的对数似然函数关于在给定观测数据和参数的条件下对隐变量的条件概率的期望):

(3)M步:求Q函数对theta的极大值,即求新一轮迭代的模型参数。

四、采用EM算法求解的模型有哪些?为什么不用牛顿法或者梯度下降法?

一般有混合高斯、协同过滤、k-means。算法一定会收敛,但是可能会收敛到局部最优。求和的项数会随着隐变量的数目指数上升,会给梯度计算带来麻烦。EM算法是一种非梯度优化算法。

五、用EM算法推导解释K-means:

k-means算法是高斯混合聚类在混合成分方差相等,且每个样本仅指派一个混合成分时候的特例。k-means算法与EM算法的关系是这样的:

注意k-means在运行之前需要进行归一化处理,不然可能会因为样本在某些维度上过大导致距离计算失效。

k-means中每个样本所属的类就可以看成是一个隐变量,在E步中,我们固定每个类的中心,通过对每一个样 本选择最近的类优化目标函数,在M步,重新更新每个类的中心点,该步骤可以通过对目标函数求导实现,最终可得新的类中心就是类中样本的均值。

·1k-means是两个步骤交替进行:确定中心点,对每个样本选择最近中心点--> E步和M步。

· 2E步中将每个点选择最近的类优化目标函数,分给中心距它最近的类(硬分配),可以看成是EM算法中E步(软分配)的近似。

·3 M步中更新每个类的中心点,可以认为是在「各类分布均为单位方差的高斯分布」的假设下,最大化似然值;

1520

1520

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?