一、环境准备

请看上一篇Hadoop于VMware下配置----------Ubuntu18.04(单主机Hadoop环境),该篇将在上一篇的基础上介绍如何安装多台机器的Haddop集群,以及Hadoop资源管理与NameNode HDFS Web界面

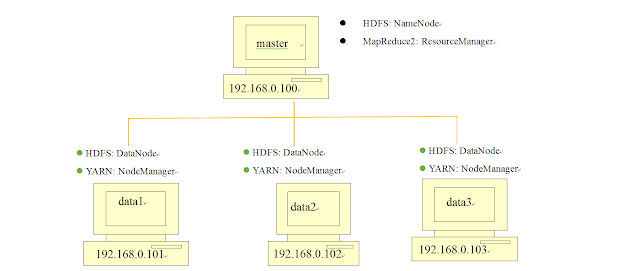

集群结构规划

二、 创建data1节点服务器

1.将master服务器 完整克隆,并命名为data1

2.设置data1虚拟主机使用固定IP:192.168.56.101

注:虚拟机的网络适配器必须选择NAT模式,以下所有虚拟机一样

3.更改主机名

sudo gedit /etc/hostname

将原主机名master改为data1

4.设置hosts文件

设置各节点的主机名与相应的IP地址,以便ssh连接时只用输入主机名即可

sudo gedit /etc/hostshosts文件内容更改

127.0.0.1 localhost

127.0.1.1 hadoop

192.168.56.100 master

192.168.56.101 datanode1

192.168.56.102 datanode2

192.168.56.103 datanode3

# The following lines are desirable for IPv6 capable hosts5.编辑core-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml将里面的localhost改为master

6.编辑yarn-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/yarn-site.xml将内容增加为:

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8025</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8050</value>

</property>

</configuration>上述命令设置的作用为:ResourceManager 主机与 NodeManager的连接地址为 8025

ResourceManager 主机与 ApplicationMaster的连接地址为 8030

ResourceManager 与客户端的连接地址为 8050

7.编辑mapred-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/mapred-site.xml将其更改为:

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>master:54311</value>

</property>

</configuration>8.编辑hdfs-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/hdfs-site.xml将其内容更改为:

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.datanode.name.dir</name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/datanode</value>

</property>

</configuration>9.data1关机

一边后面以data1为模板进行克隆

三、复制data1服务器到data2,data3与master

1.设置data2的固定IP为:192.168.56.102

修改data2的hostname文件,将主机名改为data2

2.设置data3的固定IP为:192.168.56.103

修改data3的hostname文件,将主机名改为data3

四、配置master服务器

1.设置master的固定IP为:192.168.56.100

修改master的hostname文件,将主机名改为master

2.设置hdfs-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/hdfs-site.xml更改为

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/namenode</value>

</property>

</configuration>3.编辑masters文件

masters文件主要是告诉Hadoop系统那台服务器是NameNode

sudo gedit /usr/local/hadoop/etc/hadoop/master在文件中加入master即可

4.编辑slaves文件

slaves文件 主要是告诉Hadoop系统那台服务器是DataNode

sudo gedit /usr/local/hadoop/etc/hadoop/slaves输入data1 data2 data3即可

五、启动所有服务器

1.master通过ssh连接到data1

连接data1

ssh data1

删除HDFS所有目录

sudo rm -rf /usr/local/hadoop/hadoop_data/hdfs

创建DataNode存储目录

sudo mkdir -p /usr/local/hadoop/hadoop_data/hdfs/datanode

将目录的所有者更改为登陆用户

sudo chown hduser:wxk -R /usr/local/hadoop

中断连接

exit2.master通过ssh连接到data2,data3完成上述操作

3. 创建并格式化NameNode HDFS目录

删除之前的HDFS目录

sudo rm -rf /usr/local/hadoop/hadoop_data/hdfs

创建NameNode目录

mkdir -p /usr/local/hadoop/hadoop_data/hdfs/namenode

将目录所有者更改为登陆用户

sudo chown -R hduser:wxk /usr/local/hadoop

格式化NameNode HDFS目录

hadoop namenode -format4.启动 Hadoop

start-all.sh六、打开Hadoop Web界面

因为电脑性能缘故,我只开启了data1

1.开启Hadoop Resource-Manager Web界面(http://master:8088/)

2.开启HDFS Web UI界面(http://master:50070/)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?