犀牛7基本训练学习教程 Rhino 7 Essential Training

MP4 |视频:h264,1280x720 |音频:AAC,44.1 KHz,2 Ch

技能水平:初级|语言:英语+中英文字幕(根据原英文字幕机译更准确) |时长:2h 9m |大小解压后:925 MB 含课程练习文件

云桥网络 平台获取教程!

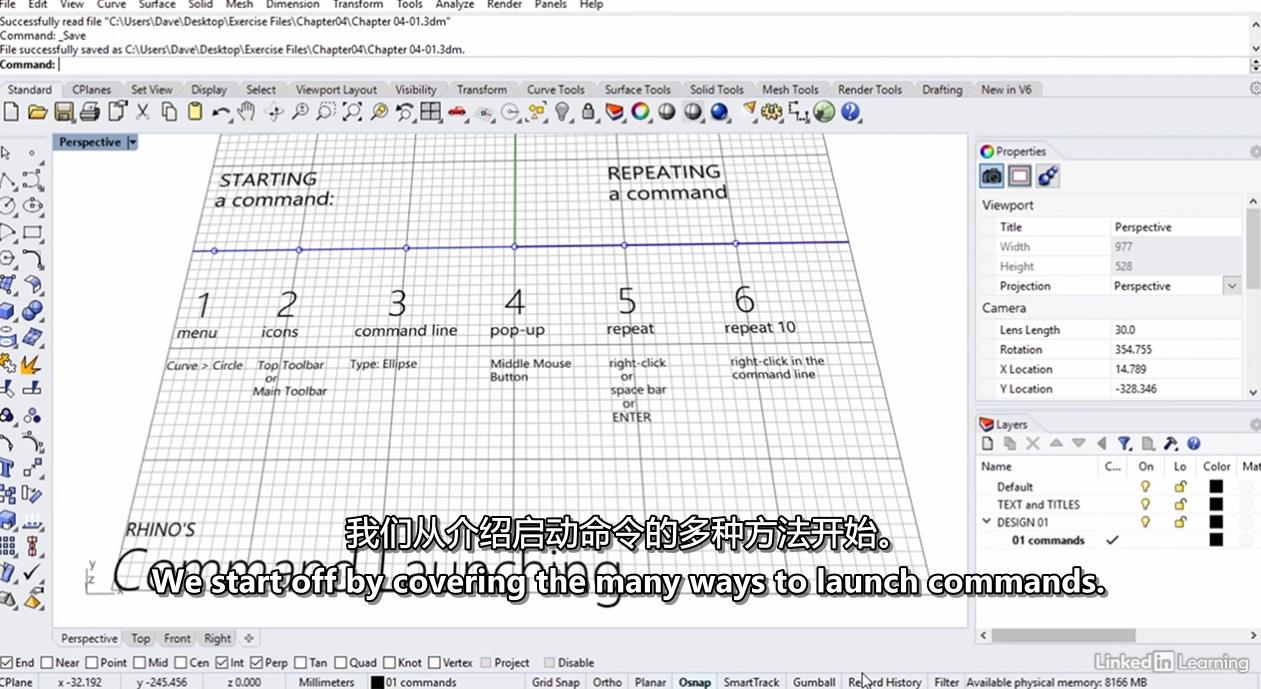

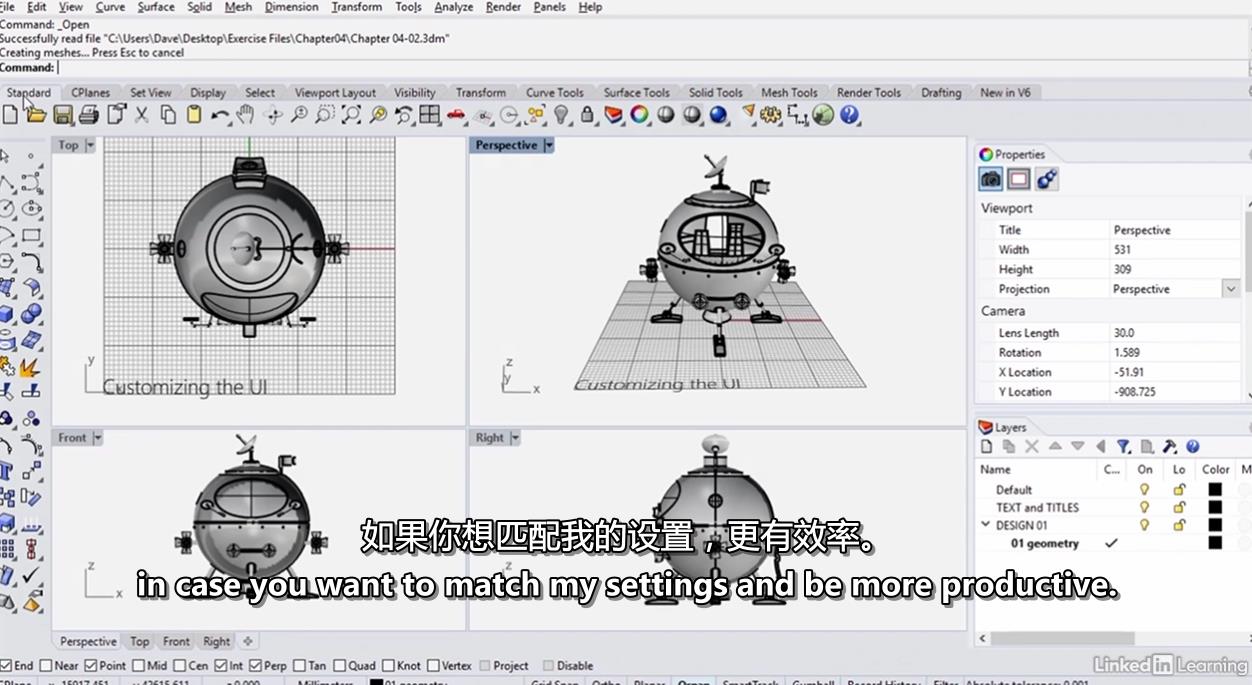

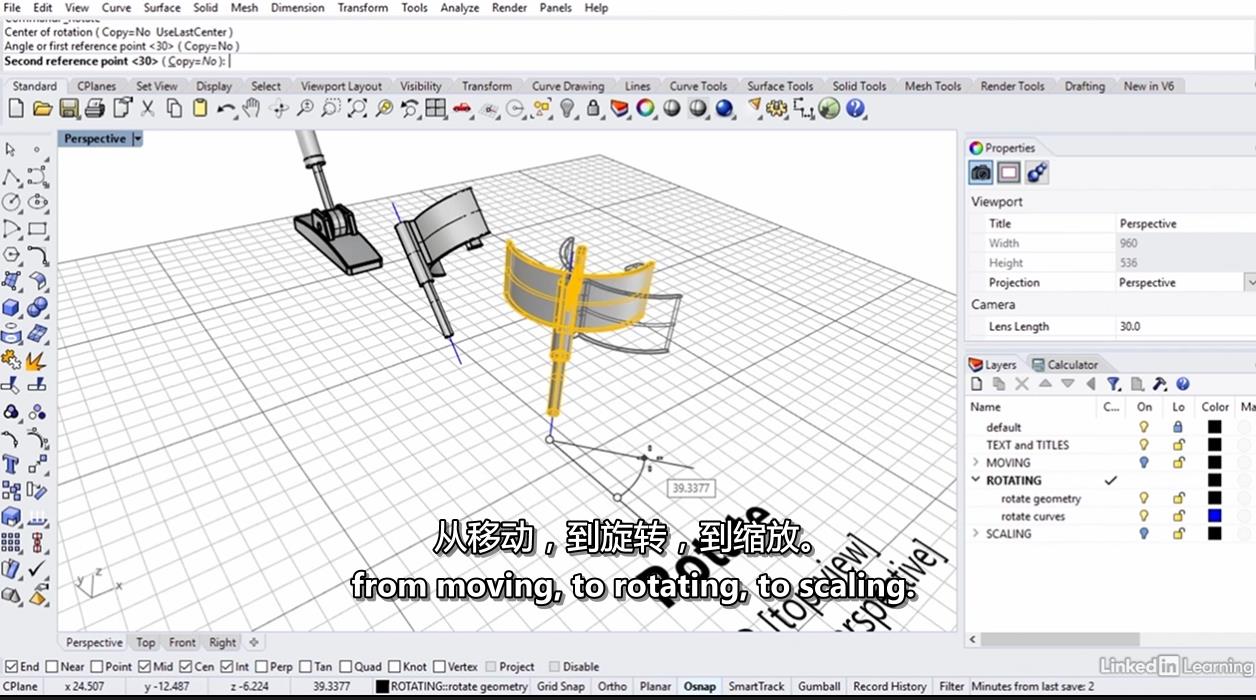

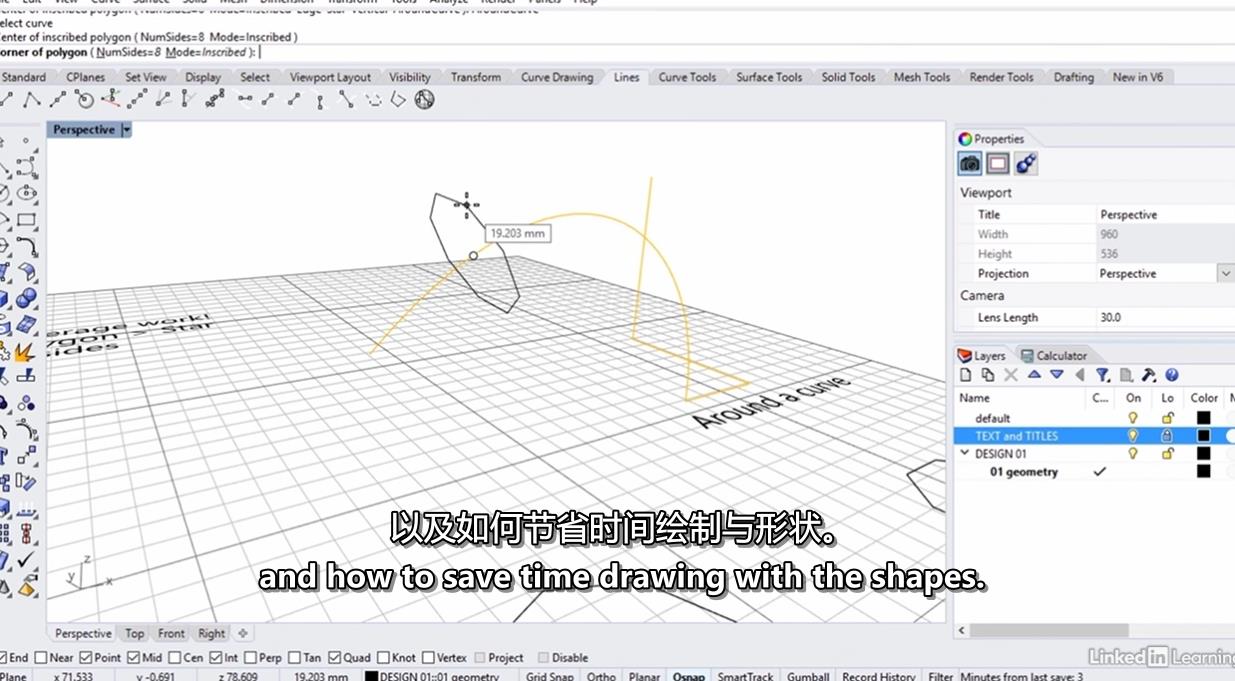

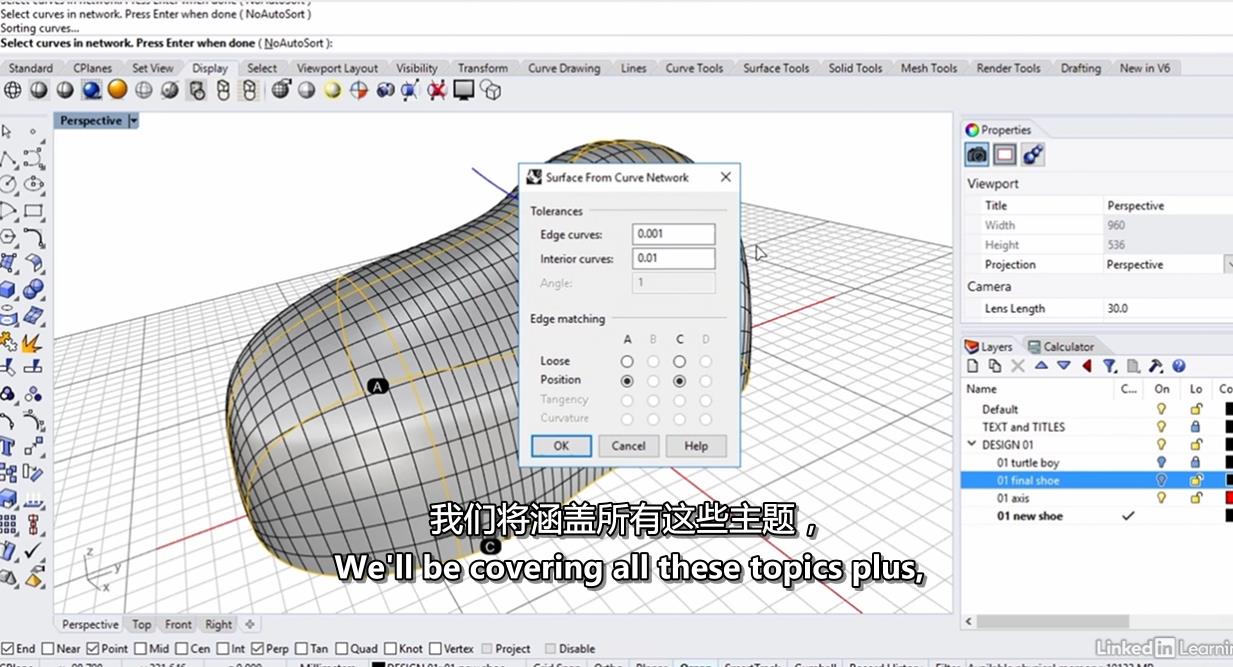

Rhino是一个流行且易于使用的3D建模程序。在本课程中,教师戴夫·舒尔茨(Dave Schultze)使用清晰的解释和有用的练习来帮助您开始在Rhino 7中绘图和建模。戴夫向您介绍了Rhino界面中的命令和定制,以及有用的属性面板和Gumball。他引导您完成工作流基础知识,例如选择对象、使用层组织项目以及基本转换。戴夫向你展示了如何使用2D几何绘图。最后,他向您展示了一些有用的命令和功能来开始对基本曲面进行建模。

犀牛7基本训练学习教程 Rhino 7 Essential Training

犀牛7基本训练学习教程 Rhino 7 Essential Training

犀牛7基本训练学习教程 Rhino 7 Essential Training

犀牛7基本训练学习教程 Rhino 7 Essential Training

犀牛7基本训练学习教程 Rhino 7 Essential Training

犀牛7基本训练学习教程 Rhino 7 Essential Training

22万+

22万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?