作者: Suncong Zheng, Yuexin Hao等人

论文地址: https://doi.org/10.1016/j.neucom.2016.12.075

摘要: 实体和关系抽取是一个可以从无结构的文本中联合检测实体和识别实体间的语义关系的任务。*我们提出了一个混合的神经模型,在没有任何手工特征的情况下抽取实体以及它们之间的关系。*这个混合的神经网络模型包含了一个用来实体抽取的novel bidirectional encoder-decoder LSTM模型和一个用来实体关系分类的CNN模型。在BiLSTM-ED获得的上下文信息经过CNN模型去提高关系分类。我们在公共数据集ACE05做的实验验证了我们方法的有效性。我们提出的方法在实体和关系抽取任务上实现了the state-of-the-art(当前最高水平)的结果。

Itroduction: 传统的抽取系统把实体和关系抽取作为两个分离的任务的流水线,比如命名实体识别NER和关系RC分类。这种分离的框架使得NER和RC更加容易处理,并且每个部分的灵活度更高。但是它很少关注两个子任务的相关性。联合学习框架是一个关联NER和RC的有效方法,这个方法可以避免一连串的错误。

优点: 当与经典的流水线的方法比较时,我们的模型不仅考虑了NER和CR之间的相关性,而且还考虑了实体标签之间的长距离关系。并且当与现存的联合提取方法没有复杂的特征工程。

框架: 图一展示了混合的神经网络框架,第一层是bi-LSTM编码层,NER和CR共享此层,在编码层之后有两个通道,一个连接到NER模型(它是一个LSTM解码层),另一个喂到到CR模型(CNN分类)进行关系抽取。

Bidirectional LSTM encoding layer:

Bi-LSTM 编码层包含词嵌入层,前向LSTM层,后向LSTM层 和连接层。

1.词嵌入层:将用one-hot 的表示形式表示的词转换成词嵌入向量,因此单词的句子可以被表示成W={w1,…wt,wt+1…wn}, w(t) ∈ R(d),是句子中第t个词对应的d维词向量,n是给定句子的长度。

2.词嵌入层之后,有两个平行的LSTM层:前向LSTM层和后向LSTM层。对于每一个词wt,前向LSTM层将通过考虑从W1到Wt的上下文词信息对wt进行编码,记为

同样,后向LSTM层将基于从Wn到Wt的上下文词信息进行编码,记为

同样,后向LSTM层将基于从Wn到Wt的上下文词信息进行编码,记为

3.LSTM的结构由被称为记忆单元的一系列循环的连接子网组成,在前向隐层和后向隐层中的每个时间步被称为一个记忆块或者记忆单元。一个记忆块包含一个或者多个自我连接的记忆细胞和三个增加的单元:input,output,forget Gates ,这个为细胞提供了连续类似的写、读和重置操作。

4.最后连接前向和后向隐藏状态值,可以表示为

Named entity recognition (NER) module:

1.每个词将被分配一个实体标签,这个标签通常用于BILOS编码方案,每个标记包含实体中一个词的位置信息, 我们还采用了LSTM结构来显式地表示。

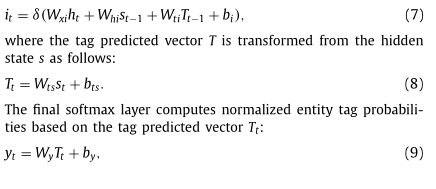

2.标签的交互模型。除了输入门,解码层的每个单元都和编码层的记忆块一样

3.Wy 是softmax矩阵,nt是实体标签数量,因为T和标签嵌入是相似的并且LSTM有长短期依赖能力,这种方式可以为标签的互信息建模。

Relation classification (RC) module:

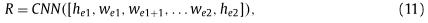

当识别实体语义关系的时候,我们拼接实体和实体之间的子句的编码信息,然后把他们喂进CNN model。

可以表示为:

R是关系标签,he是实体的编码信息,W是词嵌入。

Experiment:

Datasets: 对于实体和关系抽取,我们使用公共数据ACE05,它有6个coarse-grained粗粒度的关系类型,1个额外其他关系类型去表示non-entity or non-relation

classes.

6个粗粒度关系:“ART (artifact)”, “G-A (Gen-affiliation)”, “O- A (Org-affiliation)”, “P-W (PART-WHOLE)”,“P-S (person-social)” and “PHYS (physical)”。

对于“PART-WHOLE (e1,e2)” and “PART-WHOLE(e2,e1)” 是不同的关系,

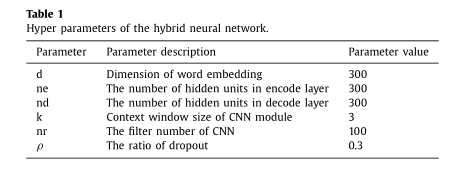

超参数:

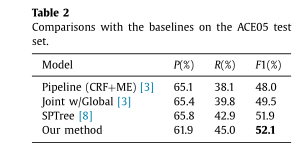

结果:

2168

2168

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?