HashMap 源码详细分析(JDK1.8)

https://segmentfault.com/a/1190000012926722HashMap

HashMap 是应用更加广泛的哈希表实现,行为上大致上与 HashTable 一致,主要区别在于HashMap 不是同步的,支持 null 键和值等。通常情况下,HashMap 进行 put 或者 get 操作,可以达到常数时间的性能,所以它是绝大部分利用键值对存取场景的首选,比如,实现一个用户 ID 和用户信息对应的运行时存储结构。

TreeMap 则是基于红黑树的一种提供顺序访问的 Map,和 HashMap 不同,它的 get、put、remove 之类操作都是 O(log(n))的时间复杂度,具体顺序可以由指定的 Comparator 来决定,或者根据键的自然顺序来判断。

1.Map 整体结构

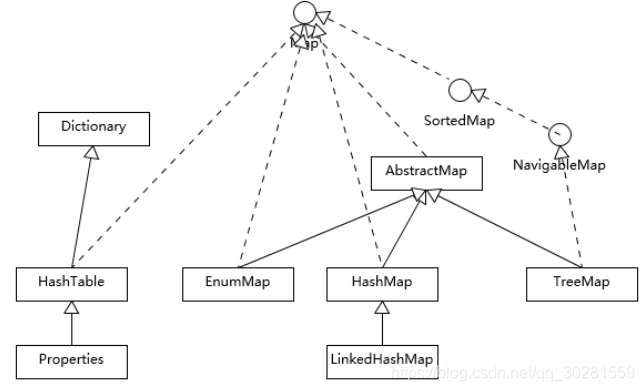

首先,我们先对 Map 相关类型有个整体了解,Map 虽然通常被包括在 Java 集合框架里,但是其本身并不是狭义上的集合类型(Collection),具体你可以参考下面这个简单类图。

Hashtable 比较特别,作为类似 Vector、Stack 的早期集合相关类型,它是扩展了 Dictionary类的,类结构上与 HashMap 之类明显不同。

HashMap 等其他 Map 实现则是都扩展了 AbstractMap,里面包含了通用方法抽象。不同Map 的用途,从类图结构就能体现出来,设计目的已经体现在不同接口上。

大部分使用 Map 的场景,通常就是放入、访问或者删除,而对顺序没有特别要求,HashMap在这种情况下基本是最好的选择。HashMap 的性能表现非常依赖于哈希码的有效性,请务必掌握 hashCode 和 equals 的一些基本约定,比如:

- equals 相等,hashCode 一定要相等。

- 重写了 hashCode 也要重写 equals。

- hashCode 需要保持一致性,状态改变返回的哈希值仍然要一致。

- equals 的对称、反射、传递等特性

LinkedHashMap 通常提供的是遍历顺序符合插入顺序,它的实现是通过为条目(键值对)维护一个双向链表。注意,通过特定构造函数,我们可以创建反映访问顺序的实例,所谓的 put、get、compute 等,都算作“访问”。

对于 TreeMap,它的整体顺序是由键的顺序关系决定的,通过 Comparator 或Comparable(自然顺序)来决定

2.HashMap 源码分析

前面提到,HashMap 设计与实现是个非常高频的面试题,所以我会在这进行相对详细的源码解读,主要围绕:

HashMap 内部实现基本点分析。

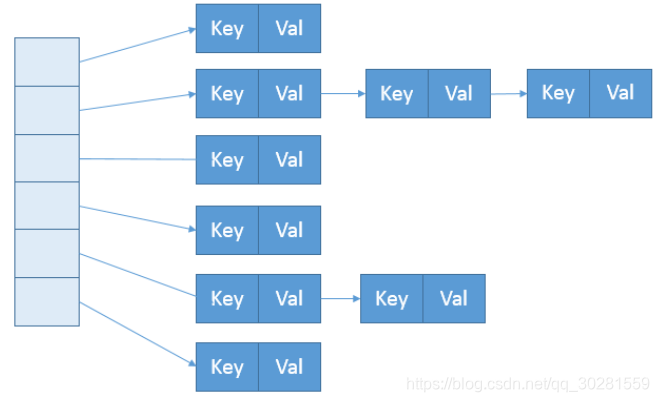

首先,我们来一起看看 HashMap 内部的结构,它可以看作是数组(Node[] table)、链表、红黑树结合组成的复合结构,数组被分为一个个桶(bucket),通过哈希值决定了键值对在这个数组的寻址;哈希值相同的键值对,则以链表形式存储,你可以参考下面的示意图。这里需要注意的是,如果链表大小超过阈值(TREEIFY_THRESHOLD, 8),图中的链表就会被改造为红黑树形结构

Node节点

Node(int hash, K key, V value, Node<K,V> next) {

this.hash = hash;

this.key = key;

this.value = value;

this.next = next;

}

从非拷贝构造函数的实现来看,这个表格(数组)似乎并没有在最初就初始化好,仅仅设置了一些初始值而已。

public HashMap(int initialCapacity, float loadFactor){

// ...

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

}

1.put()方法

JDK8 HashMap put的基本思路:

1. 对key的hashCode()进行hash后计算数组下标index;

2. 然后进入putVal()方法,如果当前数组table为null,进行resize()初始化;

3. 如果没碰撞,即tab[i]==null,直接放到对应下标的位置上;

4. 如果碰撞了,且节点已经存在,即key相等,就替换掉 value;

5. 如果碰撞后,发现为树结构,挂载到树上。

6. 如果碰撞后,为链表,添加到链表尾,并判断链表如果过长(大于等于TREEIFY_THRESHOLD,默认8),就把链表转换成树结构;

7. 数据 put 后,如果数据量超过threshold,就要resize扩容。

HashMap 也许是按照 lazy-load 原则,在首次使用时被初始化(拷贝构造函数除外,我这里仅介绍最通用的场景)。既然如此,我们去看看 put 方法实现,似乎只有一个 putVal 的调用:

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

看来主要的密码似乎藏在 putVal 里面,到底有什么秘密呢?为了节省空间,我这里只截取了putVal 比较关键的几部分。

final V putVal(int hash, K key, V value, boolean onlyIfAbsent, boolean evict) {

Node<K,V>[] tab;

Node<K,V> p;

int n, i;

//判断table是否初始化,否则初始化操作resize()

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

//计算存储的索引位置,如果没有元素,直接赋值

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

//发生碰撞

Node<K,V> e;

K k;

//判断 key是否存在 如果存在就覆盖原来的value

if (p.hash == hash && ((k = p.key) == key || (key != null && key.equals(k))))

e = p;

//key不存在,判断链表是否是红黑树

else if (p instanceof TreeNode)

//红黑树是为了防止哈希表碰撞攻击,当链表链长度为8时,及时转成红黑树,提高map的效率

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

//为链表,

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

//链表长度8,将链表转化为红黑树存储

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

//key存在,直接覆盖

if (e.hash == hash && (k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

//记录修改次数

++modCount;

//判断是否需要扩容(HashMap这一步是元素插入完成之后才开始判断的)

if (++size > threshold)

resize();

//空操作 afterNodeInsertion(evict);

return null;

}

从 putVal 方法最初的几行,我们就可以发现几个有意思的地方:

- 如果表格是 null,resize 方法会负责初始化它,这从 tab = resize() 可以看出。

- resize 方法兼顾两个职责,创建初始存储表格,或者在容量不满足需求的时候,进行扩容(resize)。

- 在放置新的键值对的过程中,如果发生下面条件,就会发生扩容。

if (++size > threshold)

resize();

具体键值对在哈希表中的位置(数组 index)取决于下面的位运算:i = (n - 1) & hash

仔细观察哈希值的源头,我们会发现,它并不是 key 本身的 hashCode,而是来自于HashMap 内部的另外一个 hash 方法。注意,为什么这里需要将高位数据移位到低位进行异或 运算呢?这是因为有些数据计算出的哈希值差异主要在高位,而 HashMap 里的哈希寻址是忽略容量以上的高位的,那么这种处理就可以有效避免类似情况下的哈希碰撞。

static final int hash(Object kye) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>>16);

}

可以看到,putVal 方法本身逻辑非常集中,从初始化、扩容到树化,全部都和它有关

2.resize 方法

不管是list还是map,都会遇到容量不足需要扩容的时候,但是不同于list,HashMap的扩容设计的非常巧妙,首先在上文提到过数组的长度为2的N次方,也就是说初始为16,扩容一次为32…

好处呢?就是上文提到的扩容是性能优化和减少碰撞,就是体现在此处。

数组下标计算: index = (table.length - 1) & hash ,由于 table.length 也就是capacity 肯定是2的N次方,使用 & 位运算意味着只是多了最高位,这样就不用重新计算 index,元素要么在原位置,要么在原位置+ oldCapacity.

如果增加的高位为0,resize 后 index 不变;高位为1在原位置+ oldCapacity。resize 的过程中原来碰撞的节点有一部分会被分开。

扩容简单说有两步:

- 扩容:创建一个新的Entry空数组,长度是原数组的2倍。

- ReHash:遍历原Entry数组,把所有的Entry重新Hash到新数组。

我进一步分析一下身兼多职的 resize 方法

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

// 如果 table 不为空,表明已经初始化过了

if (oldCap > 0) {

// 当 table 容量超过容量最大值,则不再扩容

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

// 按旧容量和阈值的2倍计算新容量和阈值的大小

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY && oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

} else if (oldThr > 0) // initial capacity was placed in threshold

/*

* 初始化时,将 threshold 的值赋值给 newCap,

* HashMap 使用 threshold 变量暂时保存 initialCapacity 参数的值

*/

newCap = oldThr;

else { // zero initial threshold signifies using defaults

/*

* 调用无参构造方法时,桶数组容量为默认容量,

* 阈值为默认容量与默认负载因子乘积

*/

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

// newThr 为 0 时,按阈值计算公式进行计算

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

// 创建新的桶数组,桶数组的初始化也是在这里完成的

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;

if (oldTab != null) {

// 如果旧的桶数组不为空,则遍历桶数组,并将键值对映射到新的桶数组中

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

//先把就数组该位置清空

oldTab[j] = null;

if (e.next == null)

//这一步的hash算法狠关键

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

// 重新映射时,需要对红黑树进行拆分

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // preserve order

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

// 遍历链表,并将链表节点按原顺序进行分组

do {

next = e.next;

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

// 将分组后的链表映射到新桶中

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

上面的源码总共做了3件事,分别是:

- 计算新桶数组的容量 newCap 和新阈值 newThr

- 根据计算出的 newCap 创建新的桶数组,桶数组 table 也是在这里进行初始化的

- 将键值对节点重新映射到新的桶数组里。如果节点是 TreeNode 类型,则需要拆分红黑树。如果是普通节点,则节点按原顺序进行分组。

依据 resize 源码,不考虑极端情况(容量理论最大极限由 MAXIMUM_CAPACITY 指定,数值为 1<<30,也就是 2 的 30 次方),我们可以归纳为:

- 门限值等于(负载因子)x(容量),如果构建 HashMap 的时候没有指定它们,那么就是依据相应的默认常量值。

- 门限通常是以倍数进行调整 (newThr = oldThr << 1),我前面提到,根据 putVal 中的逻辑,当元素个数超过门限大小时,则调整 Map 大小。

- 扩容后,需要将老的数组中的元素重新放置到新的数组,这是扩容的一个主要开销来源。

容量、负载因子和树化

前面我们快速梳理了一下 HashMap 从创建到放入键值对的相关逻辑,现在思考一下,为什么我们需要在乎容量和负载因子呢?

这是因为容量和负载系数决定了可用的桶的数量,空桶太多会浪费空间,如果使用的太满则会严重影响操作的性能。极端情况下,假设只有一个桶,那么它就退化成了链表,完全不能提供所谓常数时间存的性能。

既然容量和负载因子这么重要,我们在实践中应该如何选择呢?

如果能够知道 HashMap 要存取的键值对数量,可以考虑预先设置合适的容量大小。具体数值我们可以根据扩容发生的条件来做简单预估,根据前面的代码分析,我们知道它需要符合计算条件:负载因子 * 容量 > 元素数量

所以,预先设置的容量需要满足,大于“预估元素数量 / 负载因子”,同时它是 2 的幂数,结论已经非常清晰了。

3.获取方法:get

- 首先将 key hash 之后取得所定位的桶。

- 如果桶为空则直接返回 null 。

- 否则判断桶的第一个位置(有可能是链表、红黑树)的 key 是否为查询的 key,是就直接返回 value。

- 如果第一个不匹配,则判断它的下一个是红黑树还是链表。

- 红黑树就按照树的查找方式返回值。

- 不然就按照链表的方式遍历匹配返回值。

public V get(Object key) {

Node<K,V> e;

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

final Node<K,V> getNode(int hash, Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & hash]) != null) {

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

return first;

if ((e = first.next) != null) {

if (first instanceof TreeNode)

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

在get方法中,首先计算hash值,然后调用indexFor()方法得到该key在table中的存储位置,得到该位置的单链表,遍历链表找到key和指定key内容相等的Entry,返回entry.value值。

HashMap和Hashtable的区别

- HashMap允许key和value为null,Hashtable不允许。

- HashMap的默认初始容量为16,Hashtable为11。

- HashMap的扩容为原来的2倍,Hashtable的扩容为原来的2倍加1。

- HashMap是非线程安全的,Hashtable是线程安全的。

- HashMap的hash值重新计算过,Hashtable直接使用hashCode。

- HashMap去掉了Hashtable中的contains方法。

- HashMap继承自AbstractMap类,Hashtable继承自Dictionary类。

如何让HashMap实现线程安全?

1. 直接使用Hashtable

2. Collections.synchronizeMap方法

3. 使用ConcurrentHashMap

总结

1. HashMap 在第一次 put 时初始化,类似 ArrayList 在第一次 add 时分配空间。

2. HashMap 的 bucket 数组大小一定是2的n次方

3. HashMap 在 put 的元素数量大于 Capacity LoadFactor(默认16 0.75) 之后会进行扩容

4. 负载因子是可以修改的,也可以大于1,但是建议不要轻易修改,除非情况非常特殊

5. JDK8处于提升性能的考虑,在哈希碰撞的链表长度达到TREEIFY_THRESHOLD(默认8)后,会把该链表转变成树结构

6. JDK8在 resize 的时候,通过巧妙的设计,减少了 rehash 的性能消耗

7. 扩容是一个特别耗性能的操作,所以当在使用HashMap的时候,估算map的大小,初始化的时候给一个大致的数值,避免map进行频繁的扩容

https://segmentfault.com/a/1190000015213253#articleHeader4

https://segmentfault.com/a/1190000013650892

https://segmentfault.com/a/1190000015726870#articleHeader3

406

406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?