代码和完整的报告在文章最后

城市空气质量数据采集系统设计与实现 🏙️

研究背景 🌬️

- 城市化与环境挑战:随着城市化进程的加快,环境污染问题,尤其是空气质量问题,已成为公众关注的焦点。

- 数据监测的重要性:城市空气质量数据的准确获取对于环境管理和政策制定至关重要,但目前存在数据来源不稳定和质量参差不齐的问题。

国外经验借鉴 🌐

- 发达国家的监测体系:许多发达国家已建立完善的空气质量监测体系,并实施严格的环保政策。

- 研究与技术进展:国外研究机构和大学在空气质量数据采集和分析方面取得了显著成果,为我国提供了宝贵的经验。

国内现状分析 🏠

- 环保意识的提升:随着环保意识的增强,城市空气质量监测受到政府和公众的高度关注。

- 监测站点的建立:中国各地政府和科研机构已建立空气质量监测站点,但数据获取和整合仍面临挑战。

研究目标和内容 🎯

-

目标城市:采集中国33个城市的空气质量数据。

-

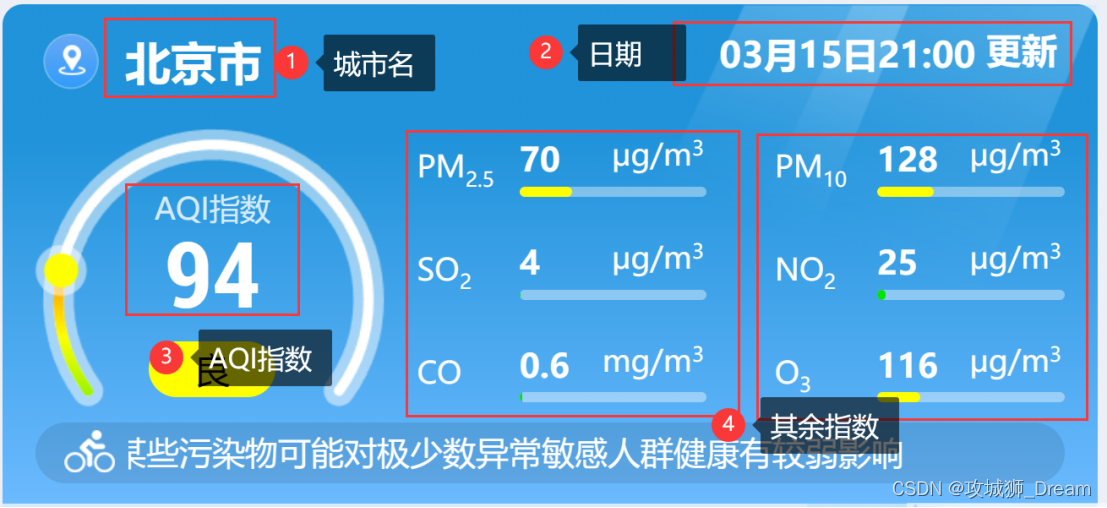

数据指标:包括城市名、更新时间、AQI指数、PM2.5、So2、CO、PM0、No2、O3等。

-

-

数据采集与保存:使用网络爬虫技术实时抓取数据,并通过pandas保存到本地Excel表格。

-

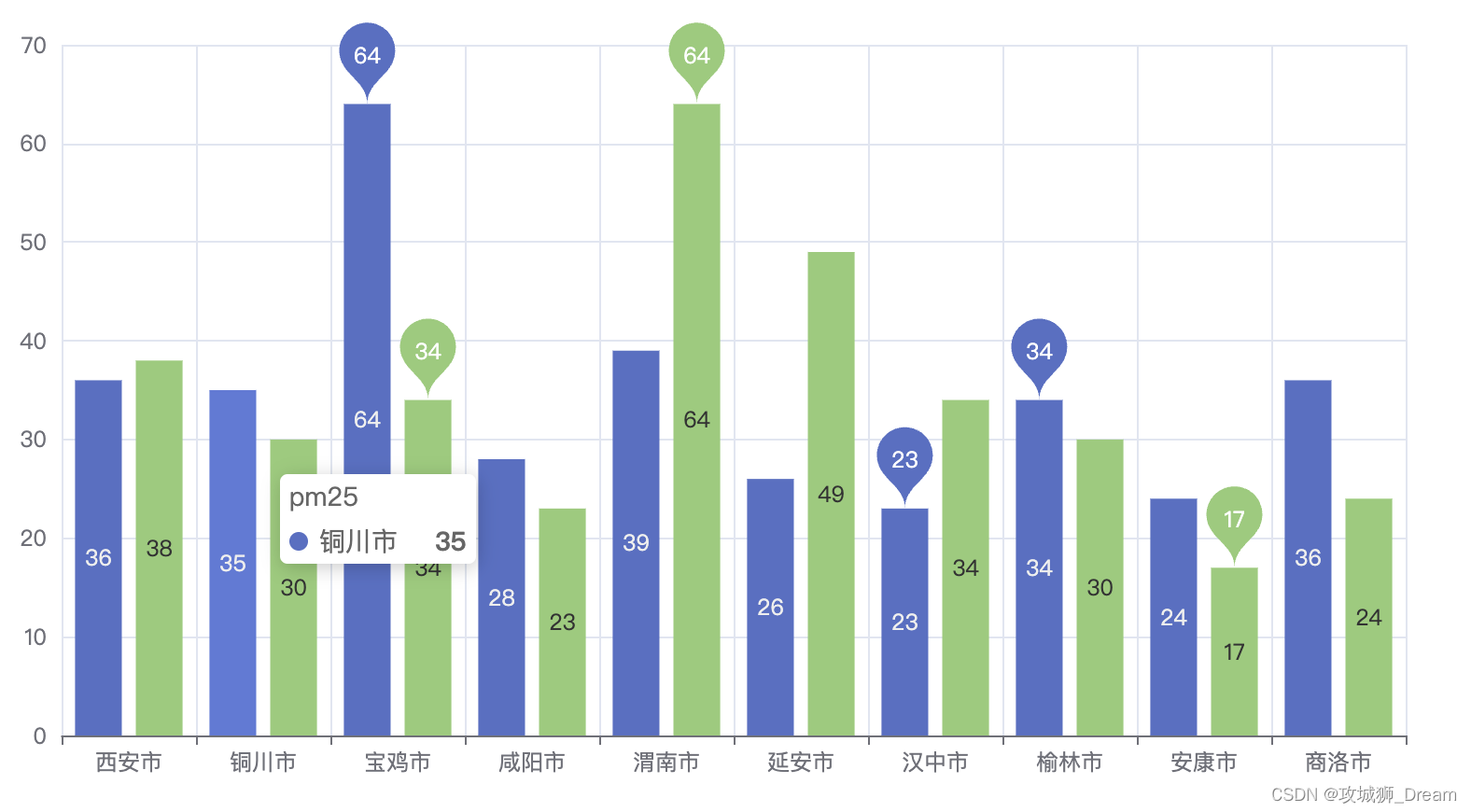

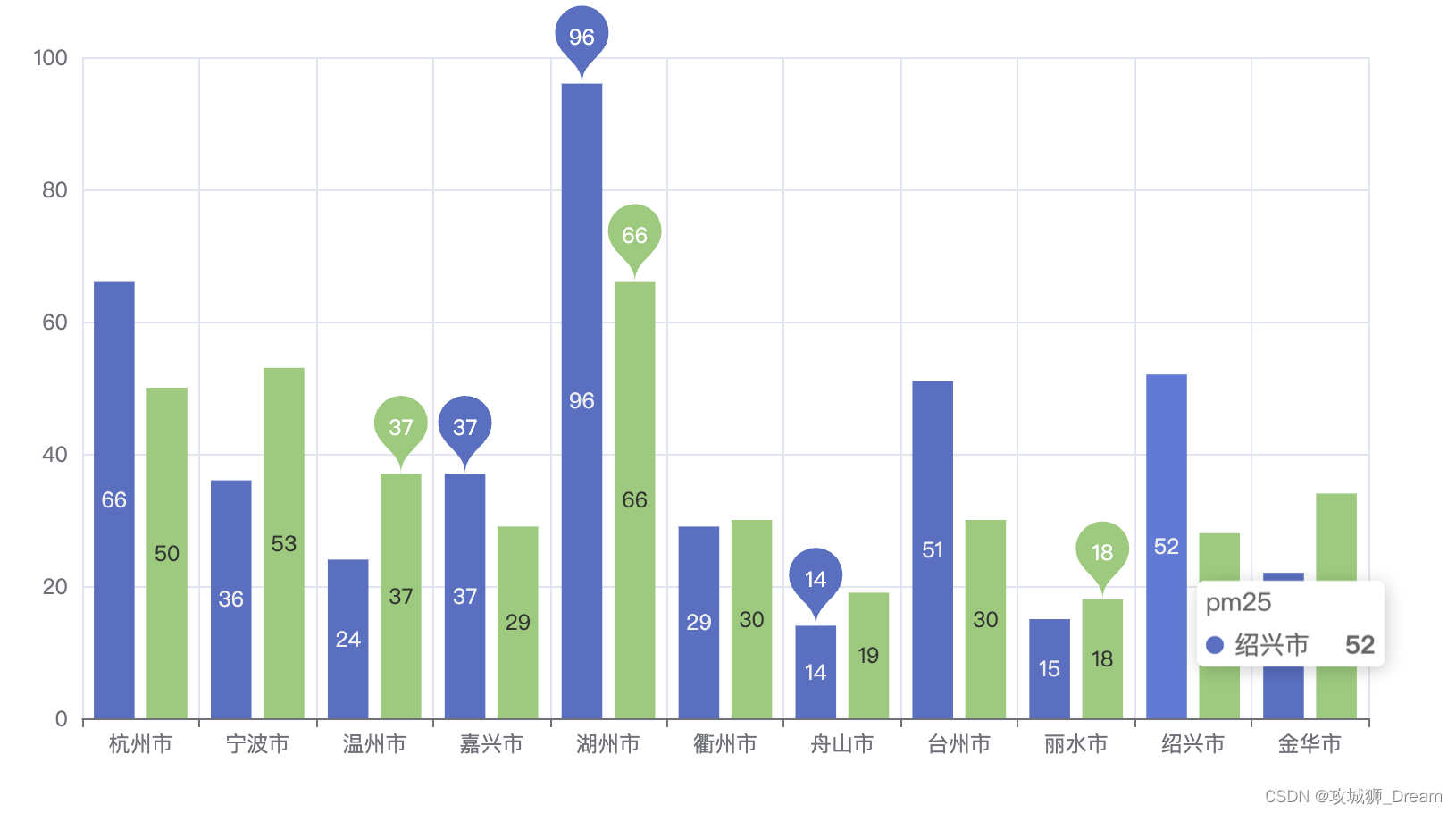

数据可视化:利用Echarts技术对数据进行可视化,分析影响空气质量的关键参数。

研究方法 🛠️

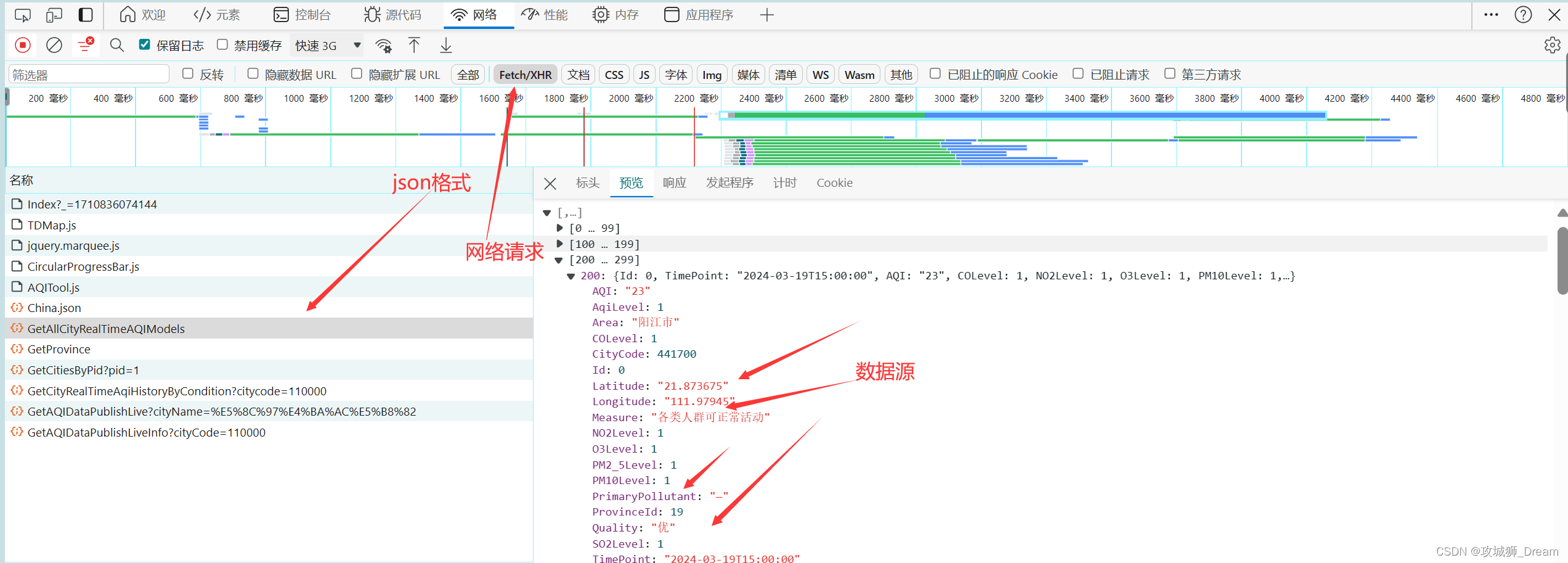

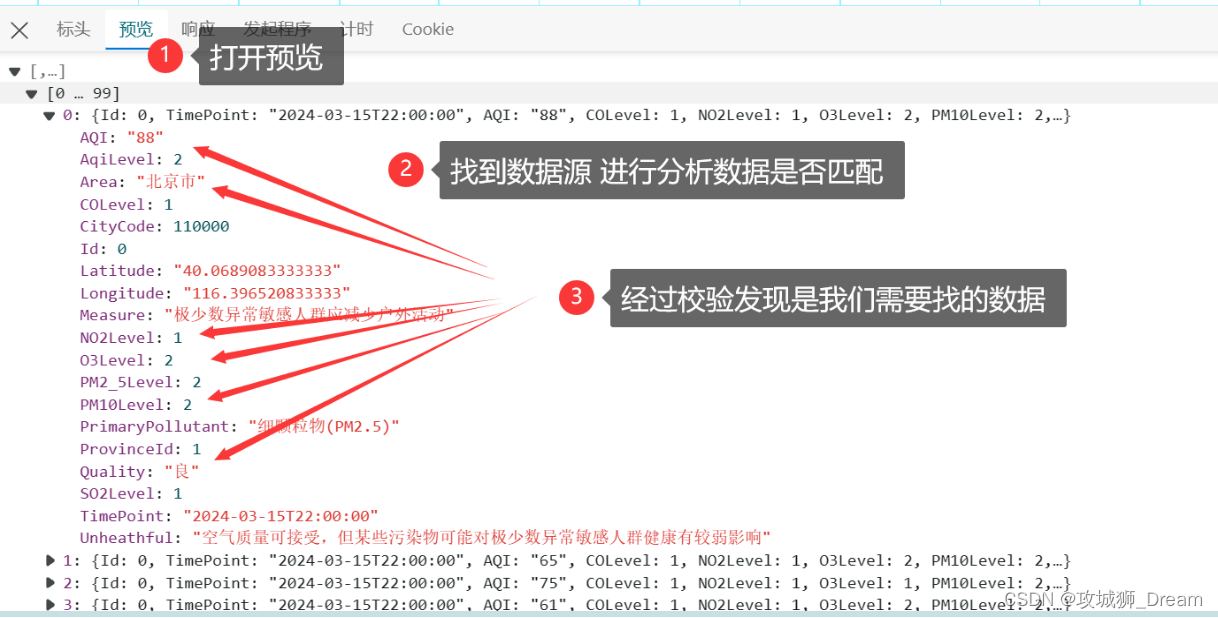

- 网络抓包分析:通过Chrome浏览器分析XHR动态请求,确定数据源。

- 数据校验:对采集到的数据进行校验,确保数据的准确性。

- 实时数据抓取:运用网络爬虫技术在线抓取空气质量数据。

- 数据整合与保存:使用pandas工具整合数据,并保存到本地。

结语 📜

本研究旨在通过设计并实现一个城市空气质量数据采集系统,提高数据采集的效率和准确性,为城市环境管理和公众健康提供科学依据。通过这一系统,我们期望能够为相关部门提供决策支持,促进环保政策的制定和城市环境质量的改善。

步骤概述

- 分析网页结构:检查目标网页的HTML结构,确定数据存放的位置。

- 选择爬虫工具:使用如Python的

requests和BeautifulSoup库。 - 发送HTTP请求:获取目标网页的内容。

- 解析响应内容:使用

BeautifulSoup提取所需数据。 - 数据清洗和存储:对提取的数据进行清洗,并存储到适当的格式中。

- 遵守法律法规:确保爬虫行为符合法律法规和网站政策。

示例代码

以下是一个使用Python编写的简单爬虫示例,用于爬取和打印目标网页上的空气质量数据。

import requests

from bs4 import BeautifulSoup

# 目标网页URL

url = 'https://air.cnemc.cn:18007/'

# 发送HTTP请求

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')

# 根据实际的HTML结构找到包含空气质量数据的元素

# 假设数据在一个类名为"city-data"的<div>中

cities_data = soup.find_all('div', class_='city-data')

# 遍历每个城市的数据

for city_data in cities_data:

# 提取城市名

city_name = city_data.find('span', class_='city-name').text

# 提取AQI值

aqi_value = city_data.find('span', class_='aqi-value').text

# 打印提取的数据

print(f"城市: {city_name}, AQI: {aqi_value}")

else:

print("无法获取网页内容。")

1075

1075

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?