文章目录

- 1、IndexError: invalid index of a 0-dim tensor. Use tensor.item() to convert a 0-dim

- 2、UserWarning: Legacy autograd function with non-static forward method is deprecate and will be removed in 1.3

- 3、TypeError: _mean() got an unexpected keyword argument 'dim'报错解决【numpy中用axis和pytorch中用dim,因为一个是numpy变量一个是tensor变量】

- 4、RuntimeError: kind_.is_prim() INTERNAL ASSERT FAILED at /pytorch/torch/csrc/jit/ir.cpp:904, please report a bug to PyTorch.

1、IndexError: invalid index of a 0-dim tensor. Use tensor.item() to convert a 0-dim

报错如下:

IndexError: invalid index of a 0-dim tensor. Use tensor.item() to convert a 0-dim tensor to a Python number

报错原因: pytorch版本问题

loss.data[0] 是pytorch0.3.1版本代码

在0.4-0.5版本的pytorch会出现警告,不会报错;

在0.5版本以上的pytorch就会报错。

解决方法:

将loss.data[0]修改为:loss.item()

2、UserWarning: Legacy autograd function with non-static forward method is deprecate and will be removed in 1.3

报错如下:

UserWarning: Legacy autograd function with non-static forward method is deprecated and will be removed in 1.3. Please use new-style autograd function with static forward method. (Example: https://pytorch.org/docs/stable/autograd.html#torch.autograd.Function)

报错原因: pytorch版本问题

使用PyTorch编写代码的时候,我们通常将模型整合进一个类,在init方法里声明模型结构,在forward方法里约定模型里数据的正向流动,然后PyTorch自动生成数据的方向传播backward方法。

PyTorch在1.3版本及之后,规定forward方法必须是静态方法。

违反了该原则的代码将会在运行时报上述错误。

解决方法:

一般的解决办法是,在forward方法声明上一行加入@staticmethod装饰器,即可完成修改。

参考官方给的Example:

但是在一些没那么规范的代码下,这个改进可能会成为我们的绊脚石。所以有临时的解决办法:

- 方法一:将PyTorch降级到1.2版本及以下,因为这个改进1.3版本才生效;

- 方法二:加入代码忽略掉UserWarning:

import warnings

warnings.filterwarnings("ignore")

(我最后用的临时方法二,虽然warning其实可以不管它,但是它一直出现在终端里太烦了,我都看不见每个epoch执行的过程了,哼)

3、TypeError: _mean() got an unexpected keyword argument 'dim’报错解决【numpy中用axis和pytorch中用dim,因为一个是numpy变量一个是tensor变量】

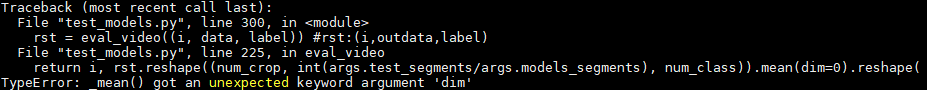

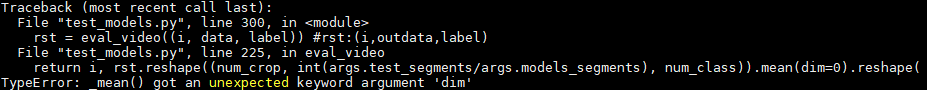

报错如下:

TypeError: _mean() got an unexpected keyword argument 'dim'

报错原因: numpy中用axis和pytorch中用dim,因为一个是numpy变量一个是tensor变量

发生错误的过程如下:

刚开始,我的代码是这样的:

此处省略若干行

input_var = torch.autograd.Variable(data.view(-1, length, data.size(2), data.size(3)),volatile=True)

rst = net(input_var).data

return i, rst.reshape((num_crop, int(args.test_segments/args.models_segments), num_class)).mean(axis=0).reshape((int(args.test_segments/args.models_segments), 1, num_class)), label[0]

这时候运行是没有问题的,因为用torch.autograd.Variable接口封装成Variable类型数据并作为模型的输入。net(input_var)得到的结果是Variable,这时候rst是tensor变量,可以用dim参数。

但是因为我要读取Tensor内容,需读取data变量,所以代码改成了:

此处省略若干行

input_var = torch.autograd.Variable(data.view(-1, length, data.size(2), data.size(3)),volatile=True)

rst = net(input_var).data

return i, rst.reshape((num_crop, int(args.test_segments/args.models_segments), num_class)).mean(axis=0).reshape((int(args.test_segments/args.models_segments), 1, num_class)), label[0]

其中,cpu()表示存储到cpu,numpy()表示Tensor转为numpy array,copy()表示拷贝

然后就

转成了numpy变量之后,就得用axis了

解决办法: dim改成axis

附:numpy中的axis和Pytorch中的dim参数

Numpy中有许多函数都带有一个参数:axis(对应于pytorch中的dim参数),用来指定函数计算是在哪个维度上进行的。这些函数包括:mean() 、sum()等。 这里说一下axis(dim)的用法:

简单的记忆方式:

1、二维:

axis=0表示分别对每一列做运算;

axis=1表示分别对每一行做运算。

2、高维:

假设输入的形状是(m, n, k):

-如果指定axis(dim)=0, 输出的size就是(1, n, k)或者(n, k)

-如果指定axis(dim)=1, 输出的size就是(m, 1, k)或者(m, k)

-如果指定axis(dim)=2, 输出的size就是(m, n, 1)或者(m, n).

size中是否有“1”,取决于参数keepdims(或keepdim)。keepdims=True会保留维度1,通常默认是等于False。

注意:以上只是经验总结,对于绝大部分函数适用,少数函数如cumsum(累加)不符合。

此外,对于二维数组(矩阵),可以用一句话记住:axis=0表示分别对每一列做运算;如果axis=1表示分别对每一行做运算。这个tip对几乎所有场景适用(包括cumsum函数等)。

4、RuntimeError: kind_.is_prim() INTERNAL ASSERT FAILED at /pytorch/torch/csrc/jit/ir.cpp:904, please report a bug to PyTorch.

报错如下:

RuntimeError: kind_.is_prim() INTERNAL ASSERT FAILED at /pytorch/torch/csrc/jit/ir.cpp:904, please report a bug to PyTorch. Only prim ops are allowed to not have a registered operator but aten::_convolution doesn't have one either. We don't know if this op has side effects. (hasSideEffects at /pytorch/torch/csrc/jit/ir.cpp:904)

报错原因:

Pytorch使用tensorboardX可视化,使用语句from tensorboardX import SummaryWriter

解决方法:

将

from tensorboardX import SummaryWriter

改成

from torch.utils.tensorboard import SummaryWriter

875

875

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?