0. 前言

上一节课讲解了机器学习中提升分类器泛化能力的一种方法–Validation。即讲数据分成训练样本和测试样本,用训练样本训练分类器,用测试样本筛选分类器,最后得到再测试样本中性能最好的分类器。这一节课我们讲解机器学习中非常实用的三个“锦囊妙计”。

1. Occam’s Razor

奥卡姆剃刀定律(Occam’s Razor):在选择模型的时候尽量选简单的,低阶的能用就别用高阶分类器。所以在选择分类器时,一般先从简单的开始考虑,或者用regularization,让hypothesis中参数个数减少,都能降低模型复杂度。

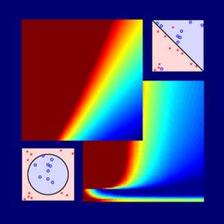

为什么要用简单的?看一个图就明白了:

右图的分类器更加复杂,但是从直觉上来看左边的模型更简单,符合人类直觉的解释方式。相应的,VC维更小、泛化能力更强。

2. Sampling Bias

- Sampling Bias:训练数据和验证数据要服从同一个分布,最好都是独立同分布的,这样训练得到的模型才能更好地具有代表性。

3. Data Snooping

- Data Snooping:在选用模型的时候,尽量不要被数据所影响,而是根据经验和知识来做判断选择。比如说,测试数据集里包含训练样本就属于使用了数据的信息,这样子得到的分类器就不够正确,容易被表象所蒙蔽。

4. Power of Three

机器学习基石的课程结束了,这里将会进行回顾。为什么题目叫做Power of Three呢?因为很多东西都和3这个数字有关。

机器学习相关的三个领域:

- 三种理论保证:

- 三种线性模型:

- 三种重要工具:

- 本节课讲的3个锦囊妙计:

- 我们未来机器学习的方向也分为三种:

- 16课中用到的一些关键词:

5. 总结

这一小节讲了三个锦囊妙计,并对16课进行了一个总结。机器学习基石课程结束了,下面开始机器学习技法课程。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?