在把scrapy爬虫整合成插件形式的时候,遇到了No module named ‘baidujs.settings’; ‘baidujs’ is not a package这个问题,百度之后发现是文件名的问题,文件名和文件夹的名字相同了,所以就错了,改过来就好啦!

本来是酱的:

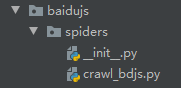

现在是酱的:

嘻嘻!

No module named 'baidujs.settings'; 'baidujs' is not a package

最新推荐文章于 2021-07-30 17:40:59 发布

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?