视频链接:

7.1 MobileNet网络详解_哔哩哔哩_bilibili

7.1.2 MobileNetv3网络详解_哔哩哔哩_bilibili

目录

3. Depthwise Convolution(DW 卷积)

一、MobileNet V1

1. Motivation

现有模型参数量大 VGG:490M、ResNet152:644M,本论文专注于移动端或嵌入式设备的轻量级 CNN。和 VGG16 对比,MobileNet 在 ImageNet 数据集上准确率下降 0.9%,但模型的参数量只有 VGG 的 1/32。

2. Novelty

- Depthwise Convolution(DW 卷积)

- 增加了两个超参数 α(控制卷积层里卷积核个数)、β(控制输入图像大小)

3. Depthwise Convolution(DW 卷积)

DW 卷积由两部分组成:Depthwise Conv + Pointwise Conv(卷积核大小为 1*1 的普通卷积)

节省计算量的计算:

4. 模型结构和性能对比

类 VGG 结构

二、MobileNet V2

1. Introduction

相比起 MobileNet V1 网络,准确率更高,模型更小。

2. Novelty

- Inverted Residuals(倒挂残差结构)

- Linear Bottlenecks

3. Inverted Residuals(倒挂残差结构)

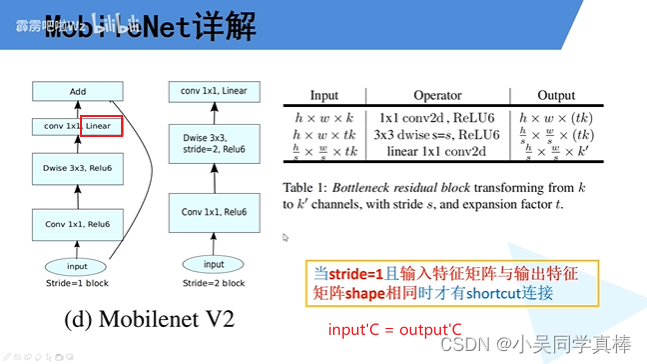

激活函数用的是 ReLU6 函数

4. Linear Bottlenecks

指的是在 bottleneck 结构里最后一层 1*1 卷积层的激活函数用的是线性激活函数。

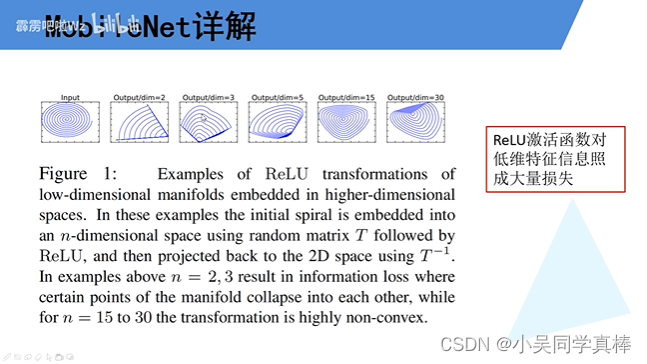

现象:随机初始化一个矩阵 T,将输入映射到一个 n 维空间里,经过 ReLU;再将结果乘上 T^-1,得到。

说明:维度(n)越高,经过 relu 函数损失的信息越少。

由于 bottleneck 结构是一个两端维度低,中间维度(C)高的结构,所以最后一层 1*1 卷积的输出不能接 relu 激活函数,避免损失过多信息。

5. 模型结构和性能对比

类 ResNet 结构

三、MobileNet V3

1. Introduction

相比起 MobileNet V2 网络,更准确,更高效。

2. Novelty

- 更新了 Block:bneck

- 使用 NAS 搜索参数

- 重新设计耗时层结构

3. bneck

图中的 NL:非线性激活函数

SE 模块:

4. 重新设计耗时层结构

这是 NAS 搜索出来的结果

5. 重新设计激活函数

H-Sigmoid 和 H-Swish 激活函数:

补充:量化是用更少的数据位宽表示数据,可以起到节约资源、提升性能的作用。(来源:弹幕)

6. 模型结构和性能对比

表中两个结论:

- V3-Large 比 V2 准确率高 3.2% 的同时,latency(延迟)还减少了 20%

- 在 V3-Small 1.0 和 V2 0.35 这两种模型 latency(延迟)差不多的条件下,V3 的准确率比 V2 高 6.6%

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?