目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

本次分享的课题是

🎯机器学习图像卡通动漫化图像风格迁移

背景和意义

随着数字图像处理技术的不断发展,图像的表现形式和风格变得愈发多样化。卡通化和风格迁移技术作为图像处理中的重要研究方向,受到了广泛关注。图像卡通化旨在将真实的图像转换为卡通风格的图像,使其具有更强的艺术性和表现力。这一技术在娱乐、广告、社交媒体等领域有着广泛的应用,例如为用户生成个性化的头像或用于动画制作。风格迁移技术通过将一幅图像的艺术风格应用到另一幅图像上,使得图像能够融合多种风格,创造出全新的视觉效果。近年来,随着深度学习的兴起,风格迁移技术得到了极大的推动,尤其是卷积神经网络(CNN)在图像处理中的应用,使得这一领域的效果和效率大幅提升。

技术思路

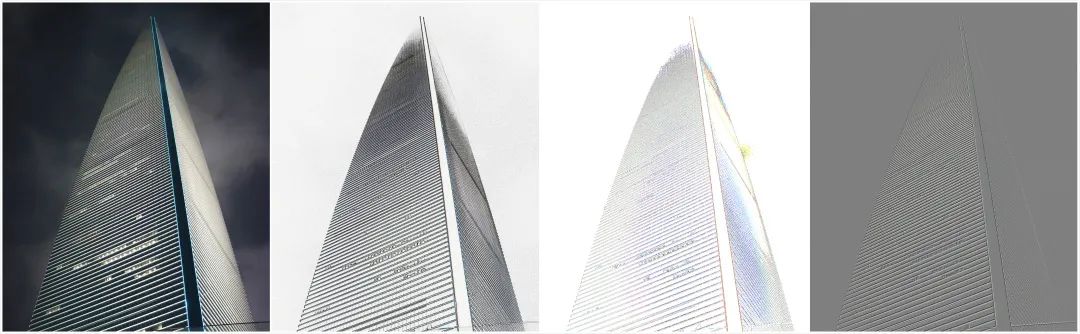

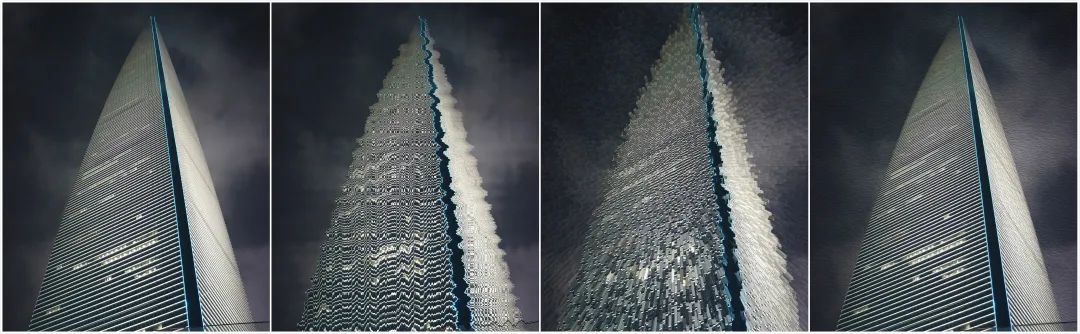

图像风格化是将普通图像通过特定的处理方法转化为具有独特艺术风格的图像。这一过程不仅仅是对图像的简单修改,而是通过算法和技术,将图像的视觉表现提升到艺术层面。以Photoshop软件为例,它内置了多种滤镜和风格化效果,帮助用户快速实现风格化作品。这些风格化效果通常可以分为两大类:基于边缘的风格化和基于颜色的风格化。

第一类风格化方法是基于边缘的风格化,这种方法旨在突出图像的轮廓和主体,通过对边缘的突出处理创造出独特的视觉效果。在Photoshop中,我们可以找到多种基于边缘的风格效果,例如“查找边缘”、“等高线”和“浮雕效果”。这些效果虽然各自呈现出不同的视觉风格,但它们的核心技术在于边缘检测。这一过程可以通过传统的边缘检测算法,如Sobel算子或Canny检测算子来实现,也可以采用深度学习方法,通过训练卷积神经网络(CNN)自动识别和提取图像中的边缘特征。图像的边缘信息对于后续的艺术效果处理至关重要,它为风格化提供了明确的结构基础。

第二类风格化方法则是基于颜色的风格化。此类方法通过改变图像中像素的值或分布,创造出新的视觉效果,例如油画效果、波纹效果等。在Photoshop中,这些效果可以通过调整图像的色彩、对比度和饱和度等参数来实现。例如,用户可以使用“波纹”或“油画”滤镜将普通图像转化为具有艺术气息的作品。这种风格化方法相对灵活,通过对像素值的细致调整,可以生成大量的风格变化。然而,传统的颜色风格化方法依赖于特定的算法规则,模式固定,能够处理的风格数量有限。

随着深度学习技术的迅速发展,基于深度学习的风格化方法逐渐成为研究的热点,尤其是风格迁移技术的出现,开启了新的研究领域。深度学习能够通过训练模型自动提取图像的特征,从而实现高效的风格迁移。与传统方法相比,深度学习的风格化方法不仅能够处理更多样的风格,还能够通过学习多个艺术作品的特征,实现更丰富的艺术效果。这种方法通过将内容图像与风格图像结合,生成新的图像,从而实现了风格的自由迁移和创新。这一技术的兴起为数字艺术创作、图像处理和计算机视觉领域注入了新的活力,推动了图像风格化技术的不断发展。

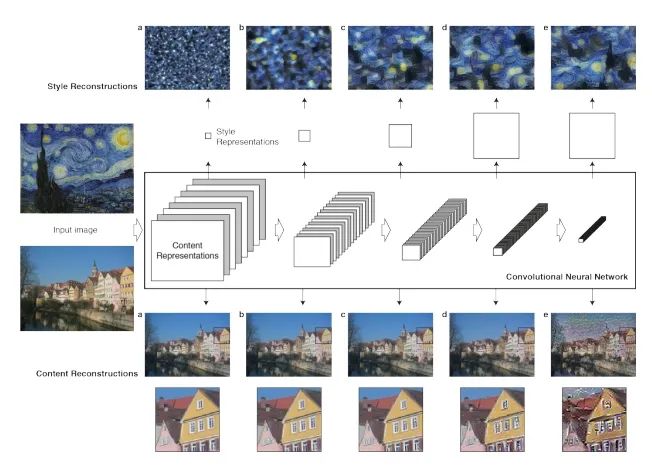

图像风格迁移技术的核心思想是将一张图像的内容与另一张图像的风格进行结合,从而生成具有目标艺术风格的新图像。这一过程得到了生物学家对人脑信息处理机制的启发,表明人类通过不同的抽象层次来理解视觉信息。具体来说,人眼在观察物体时,能够根据观察的距离调节抽象层次:近距离观察时,能够捕捉到细致的纹理和局部特征,而远距离观察则更多地关注整体轮廓和结构。卷积神经网络(CNN)恰好利用了这种分层机制,逐层提取图像特征,形成从具体到抽象的特征表示。将图像描述为内容层和风格层的两个概念。内容层代表了图像的整体信息,包括图像中包含的对象及其位置等语义信息,而风格层则更关注图像的细节信息,如笔触、颜色和纹理等。这种划分为图像风格迁移提供了清晰的理论基础,使得图像的风格与内容可以相对独立地进行处理。

在数学上,风格的表达通常涉及到格拉姆矩阵(Gram Matrix),该矩阵通过计算特征图之间的内积来捕捉图像的风格特征。格拉姆矩阵可以看作是特征之间的协方差矩阵,能够反映不同特征之间的关系。因此,通过比较两幅图像的格拉姆矩阵,我们可以度量它们风格的差异。具体而言,给定一幅内容图像 ccc 和一幅风格图像 sss,我们希望生成一幅图像 xxx,其目标是最小化一个综合的损失函数,该函数通常包括内容损失和风格损失,从而实现内容与风格的有效融合。

单模型单风格框架是一种经典的风格迁移方法,它通过图像转换网络(Image Transform Net)来实现图像的风格渲染,并在VGG16损失网络的约束下分别学习内容和风格。这种方法要求用于训练的风格图必须属于同一种风格,而内容图则可以是任意选择。与基于图像优化的方法相比,基于模型优化的方法在计算效率上有显著提高,模型的训练速度快了两到三个数量级。该模型主要由两个部分组成:图像转换网络负责将输入图像转换为输出图像,而损失网络则用于计算风格损失和内容损失。在实现过程中,内容损失采用感知损失的方式进行计算,风格损失则依然采用基于Gram矩阵的定义,确保了风格特征的有效提取和融合。

针对单模型单风格的局限性,Style Bank是一个典型的代表。该方法通过使用一组滤波器来表示多个风格,首先输入图像经过编码器得到特征图,再与多个并行的风格滤波器组相互作用,形成多种不同的风格输出。模型分为两个分支:第一个分支从编码器到解码器,要求输出图像在内容上与输入图像一致,使用逐像素的均方误差损失;第二个分支则从编码器经过风格化滤波器到解码器,旨在生成不同风格的图像,包含内容损失、风格损失以及平滑损失。训练过程中,针对不同风格的滤波器组进行多轮训练,以便提高模型的多样性和灵活性。Style Bank的优势在于多个风格可以共享一个自编码器,并且能够在不更改自编码器的情况下实现对新风格的增量学习。此外,实例归一化方法也被提出,通过学习不同风格的缩放和偏移系数来控制风格的表现,进一步增强了风格迁移的灵活性和效果。

import torch

import torch.nn as nn

class StyleBank(nn.Module):

def __init__(self, num_styles):

super(StyleBank, self).__init__()

self.encoder = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(64, 128, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True)

)

self.style_filters = nn.ModuleList([nn.Conv2d(128, 128, kernel_size=3, padding=1) for _ in range(num_styles)])

self.decoder = nn.Sequential(

nn.ConvTranspose2d(128, 64, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.ConvTranspose2d(64, 3, kernel_size=3, stride=1, padding=1),

nn.Tanh() # 输出范围在[-1, 1]

)

def forward(self, x, style_index):

features = self.encoder(x) # 编码输入图像

style_features = self.style_filters[style_index](features) # 应用对应风格的滤波器

output = self.decoder(style_features) # 解码生成风格化图像

return output

# 创建模型示例

model = StyleBank(num_styles=5)

input_image = torch.randn(1, 3, 256, 256) # 假设输入图像为256x256的RGB图像

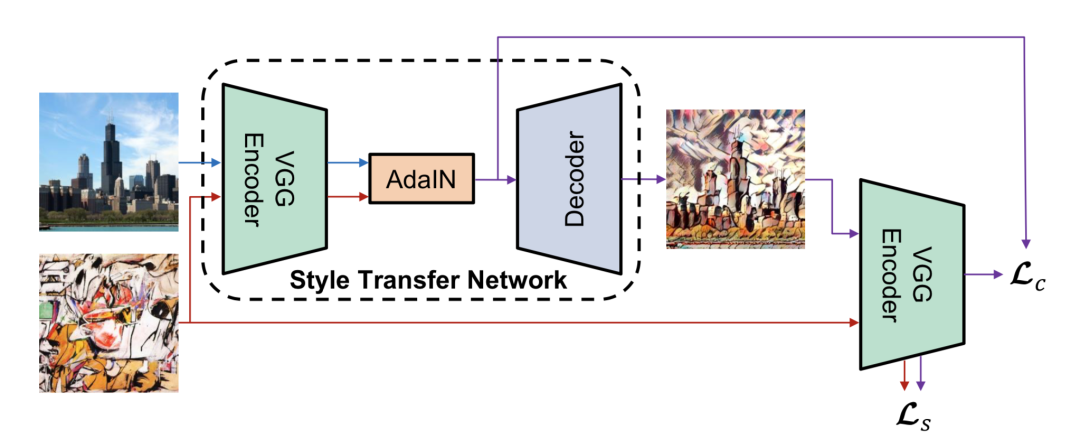

output_image = model(input_image, style_index=0) # 选择第一个风格单模型任意风格框架突破了单模型多风格方法的局限性,能够在不重新训练模型的情况下实现多种风格的转换。该方法通过学习实例归一化的仿射变换系数来控制风格的表现,研究表明这些仿射参数可以用风格图本身的统计信息来替代,即通过风格图像的均值和方差来生成任意风格的图像。这一过程通过AdaIN层实现,具体做法是利用内容图的均值和方差进行归一化处理,然后将风格图的均值和方差作为偏移量和缩放系数,从而有效地融合内容与风格。这一创新使得模型能够灵活地适应多样化的风格要求,同时避免了反复训练的计算成本,极大地提升了风格迁移的效率和实用性。

import torch

import torch.nn as nn

class AdaIN(nn.Module):

def __init__(self):

super(AdaIN, self).__init__()

def forward(self, content, style):

# 计算内容图的均值和方差

content_mean = content.mean([2, 3], keepdim=True)

content_var = content.var([2, 3], keepdim=True)

# 计算风格图的均值和方差

style_mean = style.mean([2, 3], keepdim=True)

style_var = style.var([2, 3], keepdim=True)

# 实现归一化

normalized_content = (content - content_mean) / torch.sqrt(content_var + 1e-5)

# 使用风格均值和方差进行缩放和偏移

stylized_content = normalized_content * torch.sqrt(style_var + 1e-5) + style_mean

return stylized_content

# 示例使用

adain_layer = AdaIN()

content_image = torch.randn(1, 64, 256, 256) # 假设内容图的特征图

style_image = torch.randn(1, 64, 256, 256) # 假设风格图的特征图

# 生成风格化的内容图

stylized_image = adain_layer(content_image, style_image)效果图样例

我是海浪学长,创作不易,欢迎点赞、关注、收藏、留言。

毕设帮助,疑难解答,欢迎打扰!

1387

1387

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?