目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于生成对抗网络的局部写实感漫画图像风格转换技术

课题背景和意义

在数字艺术创作中,风格迁移技术为艺术家提供了丰富的表达手段,能够将不同艺术风格巧妙结合。局部写实感漫画图像风格迁移方法的研究,旨在通过深度学习技术将写实艺术的细腻表现与漫画艺术的生动风格相结合,创造出具有新颖视觉效果的艺术作品。这种方法不仅可以提升图像的艺术表现力,还能为插画、动画制作和游戏设计等领域提供创新的创作思路。随着个性化艺术需求的上升,探索局部写实感与漫画风格的融合,将为数字艺术的多样性和艺术创作的技术革新提供新的可能性。

实现技术思路

一、算法理论基础

1.1 生成对抗网络

对抗生成网络(GAN)是一种深度学习架构,由生成器和鉴别器组成。生成器的任务是生成尽可能真实的样本,而鉴别器则负责区分真实样本与生成样本。两者通过对抗训练,不断优化,推动生成器生成更高质量的图像。GAN在图像生成、图像翻译和风格迁移等领域取得了显著成果,成为现代计算机视觉中的重要工具。循环对抗生成网络旨在解决无监督图像到图像转换问题。通过引入循环一致性损失,CycleGAN能够在没有成对样本的情况下,实现源域与目标域之间的风格转换。该模型通过两个生成器和两个鉴别器相互配合,能够有效捕捉并重建图像特征,广泛应用于图像修复、风格迁移和图像转换等任务。

AnimeGAN解决了CartoonGAN中歧义色块的问题,但在人物图像迁移时,生成图像的人物脸部细节及纹理存在严重丢失。通过参考人眼观察的关注度优先级,引入了注意力机制,在AnimeGAN的网络基础上添加了挤压激励残差块(SE-Residual Block),同时对损失函数进行了优化,提出了ExpressionGAN,利用其进行人物图像的风格迁移。AnimeGAN结合了神经网络与对抗生成网络,旨在将现实世界图像转换为漫画风格图像。其在CartoonGAN的基础上增加了三个新颖的损失函数,并扩展了输入图像种类,以真实还原现实图像的颜色。

AnimeGAN的网络结构主要由生成器和鉴别器组成,鉴别器输入为现实图像,生成器输出漫画图像及其他变体,鉴别器负责计算损失与反向传播。网络结构可视为对称的编码器-解码器,生成器包含标准卷积、反向残差块(IRB)、上采样和下采样模块,最后使用tanh非线性激活函数。鉴别器沿用CartoonGAN的设计,但增加了漫画灰度图像和去线条化漫画灰度图像,以计算额外的损失。

在图像处理领域,注意力机制的核心目标是增强重要信息的权重,并减少无关信息的影响。注意力可以划分为空间域、通道域、层域和混合域。其原理在于利用自注意力机制,使特征图之间自主学习和分配权重。通过引入SE-Residual Block和优化损失函数,同时在数据集处理方面引入漫画脸部检测机制进行筛选和提炼,改善了AnimeGAN的性能。

在原始AnimeGAN中,残差块对每个通道一视同仁,未能区分通道的重要性。这可能导致无用信息影响重要特征,并在筛选过程中丢失重要信息。SE-Residual Block通过添加挤压激励模块(SE-Module)实现通道注意力机制,为特征提取提供重新校准机制,使网络能够学习和利用全局信息,为每个通道赋予不同权重,以选择性地强调重要特征并抑制不必要的特征。

SE-Module分为挤压和激励两个部分。挤压部分通过全局池化操作对特征图进行聚合,生成通道描述符,嵌入通道特征响应的全局分布。激励部分基于通道间的关系学习计算每个通道的权值,对特征图进行加权,作为最终输出传入后续网络。挤压激励残差块优化了人物特征提取,并减少了背景图像对生成图像的影响,因此改进了AnimeGAN的网络结构,采用SE-Residual Block替换了反转残差块,提出了ExpressionGAN。

1.2 图像分割

图像分割是计算机视觉中的一项基本任务,相较于图像分类和检测,图像分割是一项更加精准的工作,需要对每一个像素点进行分类。图像分割可以分为语义分割和实例分割,语义分割需要对图像中每个像素点进行分类,而实例分割则在此基础上进一步区分不同的物体。本章中的图像分割主要关注语义分割,将人像和背景进行分类。

图像的语义分割建立在分类模型的基础上,利用卷积神经网络(CNN)提取特征进行分类。CNN分类模型通常采用大于1的步长的卷积层和池化层进行下采样,通过降低特征图维度,提取更高级的特征,丰富语义内容。然而,传统分类模型根据最终结果预测的全局概率无法满足分类需求。虽然较大的步长对提取高层特征至关重要,但过大的步长会对分割的感受野造成较大影响,特征图在获取高层特征语义的同时,还需保持更多的空间位置信息,确保分割的精准度。

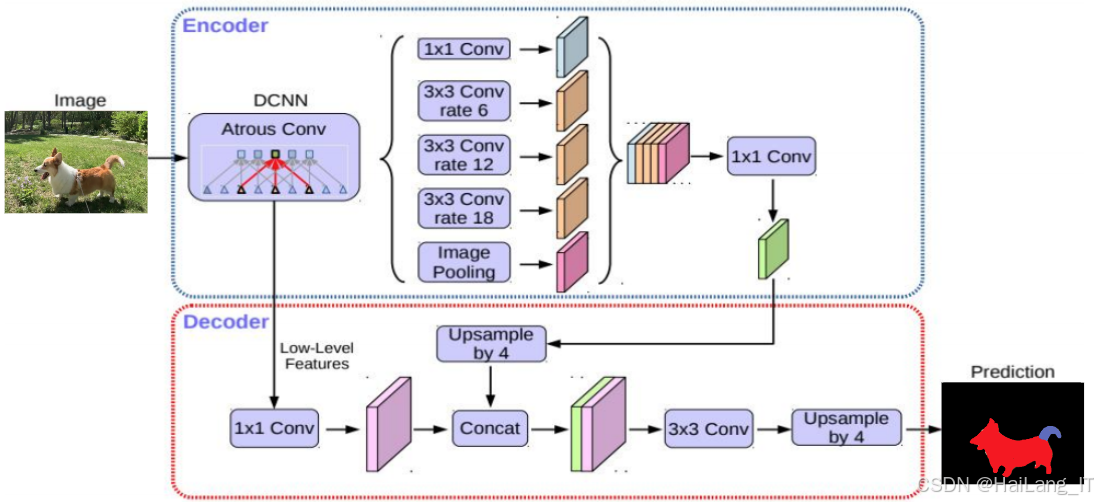

Deeplabv3+的整体网络结构中,将空洞卷积放置于编码器部分,用于进行高级特征提取的语义信息。空洞卷积通过插值的方式恢复原始分辨率,降低采样率并保证感受野的有效性。使用空洞卷积代替原先编码器中的向下采样,可以有效地保持空间信息。

在Deeplabv3+模型中,在Dilated FCN的基础上引入了解码器。解码器通过双线性插值将预测的特征图放大至期望尺寸的16倍,确保输出图像的分辨率与输入图像相匹配。解码器部分利用编码器提取的具有相同分辨率的特征层结果进行处理,从而提高分割精度。Deeplabv3+的一大优势在于其使用的空洞卷积,这种卷积方式能够在不改变特征图大小的前提下,灵活地控制感受野的大小,确保模型在提取特征时能够兼顾全局与局部信息。因此,选择Deeplabv3+进行图像分割时,由于其技术相对成熟,且在图像语义分割方面表现出色,得到了广泛应用。

选择Deeplabv3+进行图像分割的原因主要基于其相对成熟的技术背景和在图像语义分割领域的优异表现。该模型通过结合空洞卷积和编码器-解码器结构,使其在处理复杂图像时能够有效提取多层次、多尺度的特征信息。这种能力使得Deeplabv3+在诸如自然场景解析、医学图像分析和自动驾驶等应用中展现出极高的准确性和鲁棒性。此外,Deeplabv3+还支持不同的上下文信息整合,能在多种背景条件下实现稳定的分割效果,显著提升了分割结果的细节和边缘清晰度。

二、 数据集

2.1 数据集

局部写实感漫画图像风格转换数据集的制作过程首先包括图像采集,主要采用自主拍摄和互联网采集相结合的方式。自主拍摄的环节中,选择在不同的环境和背景下进行拍摄,确保涵盖多样化的人物和场景。选择高质量的公开图像资源,尤其是那些具有丰富情感和动感的场景。这些图像不仅要具备高分辨率,还需包含多种风格和主题,以便于模型在训练过程中学习到不同风格的特征。

2.2 数据增强

在许多情况下,特别是在低光照环境下或存在阴影的场景中生成的图像,提升其整体质量,图像细节可能会因为颜色暗淡而被遮盖,导致视觉效果不佳。通过引入曝光校正机制优化模型框架主要包括两个关键步骤:前向照度估计和反向照度估计。前向照度图负责恢复图像中的欠曝光区域,而反向照度图则专注于修复过曝光区域。通过对输入图像进行双照度估计,分别生成两个照度图,以便更精确地恢复各自的细节和色彩信息。这一过程确保在图像增强时,能够同时处理欠曝光和过曝光的区域,避免信息损失。

在生成了中间曝光校正图像后,进一步进行局部融合。通过将中间曝光校正图像与输入图像的局部最佳部分进行融合,最终得到全局曝光校正图像。这一融合过程不仅可以增强图像的亮度和对比度,还能够保留更多的细节和色彩,使得生成的图像更加生动和真实。经过该曝光校正技术处理后的图像,无论在明亮还是阴暗的场景中,都能够展现出更佳的视觉效果,为后续的图像风格转换提供了更为坚实的基础。

三、实验及结果分析

3.1 实验环境搭建

深度学习框架为构建、训练、优化和推理深度神经网络提供了必要的基础工具,使开发者能够更高效地进行相关工作。这些框架不仅简化了复杂的计算过程,还提供了丰富的功能和灵活的接口,帮助开发者快速实现各种深度学习算法。在众多深度学习框架中,PyTorch因其高度的扩展性和可移植性而受到广泛欢迎,尤其在学术研究和工业应用中表现出色。它的动态计算图特性使得模型的调试和修改变得更加直观和方便,同时,PyTorch拥有一个活跃的开发者社区,提供了大量的资源和支持,极大地推动了深度学习的研究和应用。

3.2 模型训练

数据准备是模型训练的基础。首先,需要收集和处理图像数据集,包括真实场景图像和对应的漫画风格图像。数据集的质量直接影响模型的训练效果,因此需要确保数据集的多样性和代表性。通常会进行图像预处理,如调整图像大小、裁剪、归一化,以及数据增强(例如随机旋转、翻转等),以增加数据的多样性。

import os

import cv2

import numpy as np

def load_and_preprocess_images(image_dir, target_size=(256, 256)):

images = []

for filename in os.listdir(image_dir):

img_path = os.path.join(image_dir, filename)

img = cv2.imread(img_path)

img = cv2.resize(img, target_size)

img = img / 255.0 # Normalize to [0, 1]

images.append(img)

return np.array(images)

real_images = load_and_preprocess_images('path/to/real_images')

comic_images = load_and_preprocess_images('path/to/comic_images')模型构建是训练流程中的重要环节。在局部写实感漫画图像风格转换中,通常采用生成对抗网络(GAN)架构,如SceneryGAN和ExpressionGAN。这些网络由生成器和判别器组成,生成器负责生成漫画风格图像,而判别器则负责判断生成图像的真实性。生成器和判别器的设计应考虑到网络的深度、卷积层的数量、激活函数等,以便于网络能够捕捉到图像中的细微特征。在模型训练阶段,采用对抗训练的方式。生成器生成图像并传递给判别器,判别器评估图像的真实性并返回反馈。训练过程中,通过优化生成器和判别器的损失函数来不断提升模型性能。常用的损失函数包括对抗损失和内容损失。训练过程需要设置合适的学习率、批量大小及迭代次数,以确保模型的稳定性和收敛性。

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=7, stride=1, padding=3),

nn.ReLU(inplace=True),

# Additional layers...

)

def forward(self, x):

return self.model(x)

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=4, stride=2, padding=1),

nn.LeakyReLU(0.2, inplace=True),

# Additional layers...

)

def forward(self, x):

return self.model(x)

generator = Generator()

discriminator = Discriminator()使用定量指标(如PSNR、SSIM)和定性评估(如人眼观察)来判断生成图像的质量。此外,可以通过调节超参数、增加训练数据或采用更复杂的模型架构来进一步优化模型性能。完成训练和优化后,最终模型可以用于推理阶段。输入新的真实场景图像,生成相应的局部写实感漫画风格图像。推理过程中需确保与训练时使用的图像预处理方式一致,以保证生成结果的质量。

from skimage.metrics import peak_signal_noise_ratio as PSNR, structural_similarity as SSIM

def evaluate_model(real_images, generated_images):

psnr = PSNR(real_images, generated_images)

ssim = SSIM(real_images, generated_images, multichannel=True)

return psnr, ssim

psnr, ssim = evaluate_model(real_images, generated_images)海浪学长项目示例:

最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?