目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于文本挖掘的Steam游戏评论分析与可视化

课题背景和意义

随着数字游戏市场的快速发展,Steam平台已成为全球最大的游戏分发平台之一。用户评论不仅反映了玩家对游戏的真实反馈,也是开发者改进游戏的重要依据。对Steam游戏评论进行深入的数据分析与可视化,可以帮助开发者理解用户需求,识别游戏的优缺点,提升用户体验。同时,通过对评论数据的可视化展示,能够更直观地呈现玩家的情感倾向、评论趋势等信息,为游戏市场的决策提供数据支持。

实现技术思路

一、算法理论基础

1.1 网络爬虫

网络爬虫是一种自动化程序,旨在通过模拟人类用户的浏览行为,自动访问互联网并提取所需的信息。这种程序可以被设计成遍历整个网站或特定网页,抓取其中的文本、图像、链接和其他数据。网络爬虫广泛应用于许多领域,例如搜索引擎的索引构建、数据挖掘、市场调研、价格监控以及社交媒体分析等。在搜索引擎中,爬虫负责抓取网页并将其内容存储在数据库中,以便用户在进行搜索时能够迅速找到相关信息。

实现网络爬虫通常涉及几个关键步骤。首先,开发者需要选择适合的编程语言和工具,Python因其丰富的库而成为开发爬虫的热门选择。常用的库包括requests用于发送HTTP请求,BeautifulSoup用于解析HTML和XML文档,Scrapy则是一个功能强大的爬虫框架,可以处理复杂的爬取任务。爬虫程序的第一步是向目标网站发送请求,获取网页的HTML响应。接下来,程序会解析响应数据,提取出所需的信息,比如评论内容、产品价格或用户数据。开发者还可以设置爬虫的行为,例如请求间隔、并发请求数等,以确保爬虫在不影响网站性能的情况下高效运行。

为了提高网络爬虫的效率和准确性,开发者可以采用多种优化策略。首先,可以利用异步请求和并发处理技术,以加快数据抓取速度。使用Python的aiohttp库或Scrapy框架的异步特性,可以在进行多个请求时有效地节省时间。其次,合理设计爬虫的请求间隔,确保在抓取数据的同时不对目标网站造成过大压力。适当的请求延迟可以降低被网站封禁的风险,同时也使数据抓取更加稳定。最后,灵活运用数据存储和处理技术,例如将抓取的数据存储在数据库中,便于后续的数据分析和可视化处理,从而提升整个爬虫系统的性能和可维护性。

1.2 情感分析

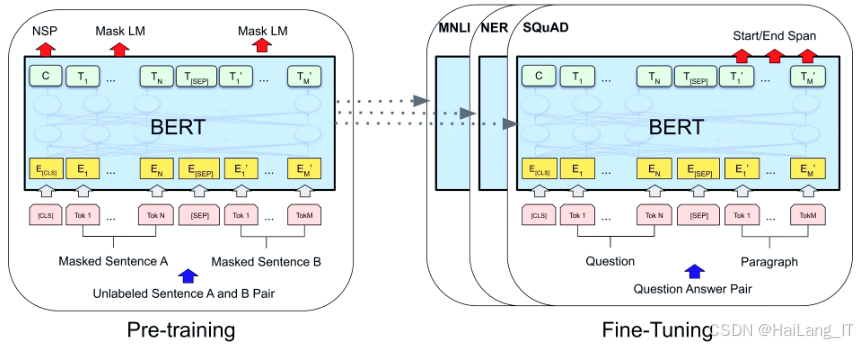

BERT预训练语言模型,旨在通过深度学习技术提高自然语言处理(NLP)任务的性能。与传统的单向语言模型不同,BERT采用了双向的Transformer结构,这意味着它能够同时考虑上下文信息,从而更好地理解句子的语义。BERT的基础架构是Transformer模型,该模型由多个自注意力层和前馈神经网络组成,使得模型能够有效地捕捉长范围的依赖关系。BERT的训练过程包括两个主要阶段:预训练和微调。在预训练阶段,模型通过大量无标注文本进行学习,主要采用了掩蔽语言模型和下一句预测任务,以学习词汇的上下文关系和句子间的逻辑关系。

BERT的预训练任务包括两个关键部分:掩蔽语言模型(MLM)和下一句预测(NSP)。在掩蔽语言模型任务中,模型会随机掩蔽输入句子中的一些单词,并训练模型预测这些被掩蔽的单词。例如,在句子“我爱玩游戏”中,如果“游戏”这个词被掩蔽,模型需要根据上下文推测出“游戏”这个词是什么。通过这种方式,BERT能够学习到词汇的上下文表示。下一句预测任务则是为了帮助模型理解句子间的关系。具体而言,模型随机选择一对句子,并判断第二个句子是否是第一个句子的后续句子。这种训练方式使得BERT能够在多种自然语言处理任务中,如问答系统、文本分类和情感分析等,表现出色。

在情感分析任务中,BERT的强大能力得益于其深度的上下文理解能力。通过在大规模文本数据上进行预训练,BERT能够捕捉到语言的细微差别和复杂的语义关系。在进行情感分析时,开发者可以通过微调BERT模型,使其适应特定的情感分类任务。这一过程中,模型会使用带有情感标签的标注数据进行训练,从而调整其参数以优化分类效果。BERT不仅能够识别评论的情感倾向(如积极、消极或中性),还能够处理包含多重情感或复杂语句的情况。此外,BERT的双向特性使其在理解评论上下文时更加敏感,从而提高了情感分析的准确性。借助BERT,研究者和开发者能够更深入地分析用户评论,揭示潜在的用户情感和需求,为产品优化和市场策略提供数据支持。

二、 数据集

数据集的制作,通常包括数据的收集、清洗和预处理。通过爬虫技术或Steam API,可以获取游戏评论的基本信息,如评论内容、用户评分和评论日期等。对获取的评论进行去重、去除无效字符和文本标准化处理。使用自然语言处理工具,如NLTK,可以进行分词、去除停用词等操作,从而提升文本数据的质量。情感标签的添加是情感分析中的关键步骤,可以通过情感词典或人工标注来完成,以便后续的情感分类。清洗后的数据集应保存为易于使用的格式(如CSV或JSON),并附上相应的文档说明,以确保他人能够理解数据的来源和结构。

三、实验及结果分析

3.1 实验环境搭建

3.2 模型训练

从Steam平台上抓取游戏评论数据。通过编写爬虫程序,开发者可以自动化地访问特定游戏的评论页面,提取用户评论、评分和其他相关信息。使用Python中的requests库可以发送HTTP请求,BeautifulSoup库则可以解析HTML文档,提取所需的数据。这一步骤的关键在于设计有效的爬虫策略,以确保获取到丰富且多样的评论数据,并遵循网站的爬虫协议(robots.txt)以避免对网站造成负担。

import requests

from bs4 import BeautifulSoup

import pandas as pd

def fetch_steam_reviews(game_id, num_pages=5):

reviews = []

for page in range(num_pages):

url = f'https://store.steampoadfes.com/appreviews/{game_id}?cursor=&start={page * 20}&max=20&review_type=all&language=all&purchase_type=all'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

review_elements = soup.find_all('div', class_='review_box')

for review in review_elements:

content = review.find('div', class_='review_desc').text.strip()

rating = review.find('span', class_='title').text.strip()

date = review.find('div', class_='date_posted').text.strip()

reviews.append({'content': content, 'rating': rating, 'date': date})

return pd.DataFrame(reviews)

# 使用实例

# df = fetch_steam_reviews('游戏ID', num_pages=5)数据清洗是处理原始评论数据的重要步骤,旨在提高数据质量,确保后续分析的准确性。 需要去除重复评论和无效字符(如HTML标签),然后对评论内容进行标准化处理,包括小写化、去除标点符号和特殊字符。接下来,可以使用自然语言处理技术进行分词,并去除停用词,以提升后续情感分析的效果。情感分析,需要为每条评论添加情感标签(如积极、消极、中性),这可以通过情感词典或人工标注来实现。

import pandas as pd

import re

from nltk.corpus import stopwords

def clean_text(text):

text = re.sub(r'[^a-zA-Z\s]', '', text) # 仅保留字母和空格

words = text.lower().split()

words = [word for word in words if word not in stopwords.words('english')]

return ' '.join(words)

# 数据清洗示例

df['cleaned_content'] = df['content'].apply(clean_text)选择和训练BERT预训练语言模型进行情感分析。BERT模型因其双向特性和对上下文的深入理解而成为目前最先进的文本处理模型之一。首先,需要对BERT模型进行微调(fine-tuning),使其适应特定的情感分析任务。这一过程通常涉及使用带有情感标签的训练数据来训练模型,以优化其参数并提升分类性能。BERT的输出将用于生成每条评论的情感预测,进一步用于后续的评估指标计算。

from transformers import BertTokenizer, BertForSequenceClassification

from transformers import Trainer, TrainingArguments

# 加载BERT模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=3)

# 编码输入数据

inputs = tokenizer(df['cleaned_content'].tolist(), padding=True, truncation=True, return_tensors="pt")

# 定义训练参数

training_args = TrainingArguments(

output_dir='./results',

num_train_epochs=3,

per_device_train_batch_size=16,

evaluation_strategy='epoch',

)

# 使用Trainer进行训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=inputs,

)

trainer.train()使用准确率、召回率和F1值作为评估指标,可以全面反映模型在情感分类任务中的表现。准确率表示模型预测的正确性,召回率衡量模型在所有实际正例中正确预测的比例,而F1值则是准确率和召回率的调和平均数,能够有效平衡两者之间的关系。

from sklearn.metrics import accuracy_score, recall_score, f1_score

# 假设y_true为真实标签,y_pred为模型预测的标签

accuracy = accuracy_score(y_true, y_pred)

recall = recall_score(y_true, y_pred, average='weighted')

f1 = f1_score(y_true, y_pred, average='weighted')

print(f'准确率: {accuracy:.2f}, 召回率: {recall:.2f}, F1值: {f1:.2f}')海浪学长项目示例:

最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

2389

2389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?