目录

一. 部署 InternLM2-Chat-1.8B 模型进行智能对话

4. 在本地浏览器打开:http://127.0.0.1:6006/

三. 使用 Lagent 运行 InternLM2-Chat-7B 模型为内核的智能体

4. 修改examples/internlm2_agent_web_demo_hf.py 文件

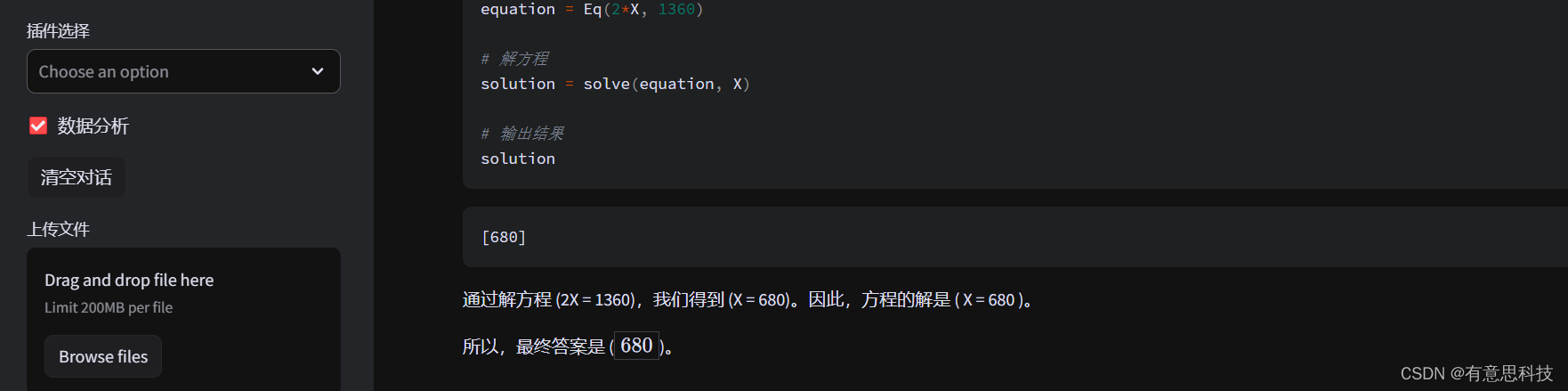

7. 浏览器打开:http://127.0.0.1:6006/

5.参考上面小结的启动 SSH映射端口到本地,并开启web界面

一. 部署 InternLM2-Chat-1.8B 模型进行智能对话

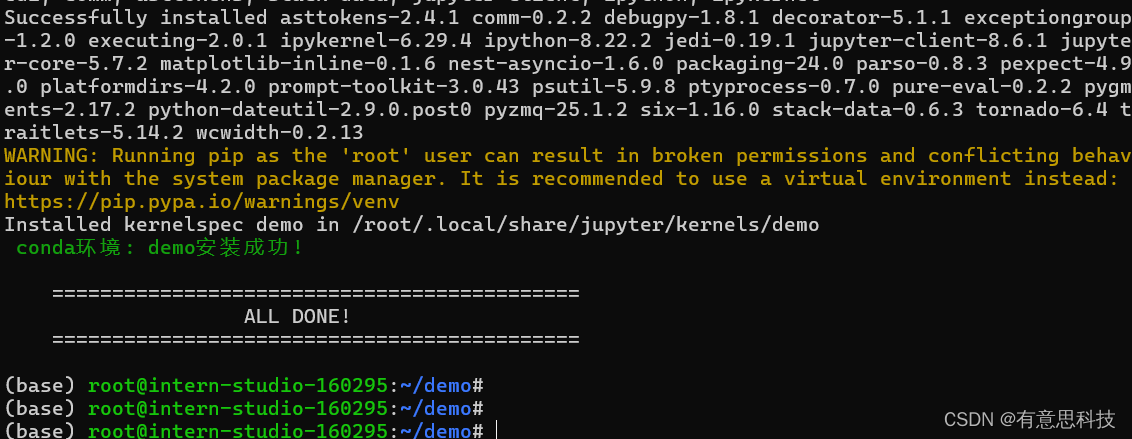

1. 环境准备

创建conda 环境

studio-conda -o internlm-base -t demo

安装库:

pip install huggingface-hub==0.17.3 transformers==4.34 psutil==5.9.8 accelerate==0.24.1 streamlit==1.32.2 matplotlib==3.8.3 modelscope==1.9.5 sentencepiece==0.1.99

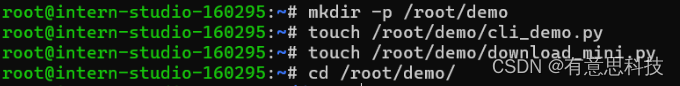

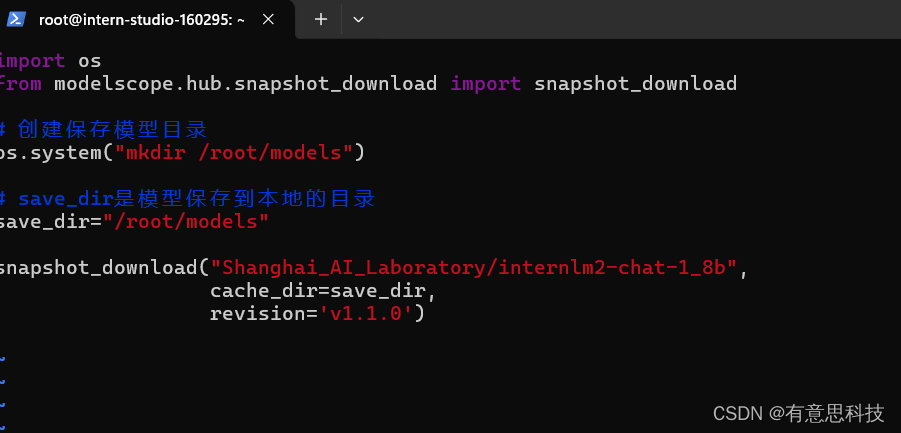

2. 下载模型参数

首先创建文件夹

编写下载脚本文件

执行脚本文件下载:

python download_mini.py

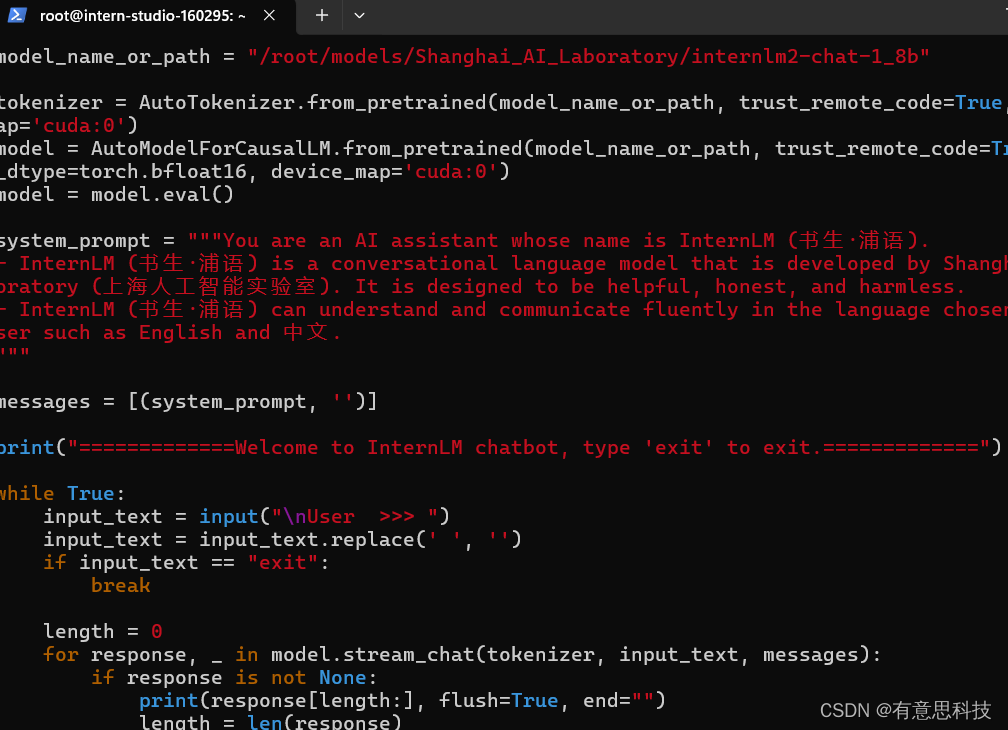

编辑cli demo脚本文件

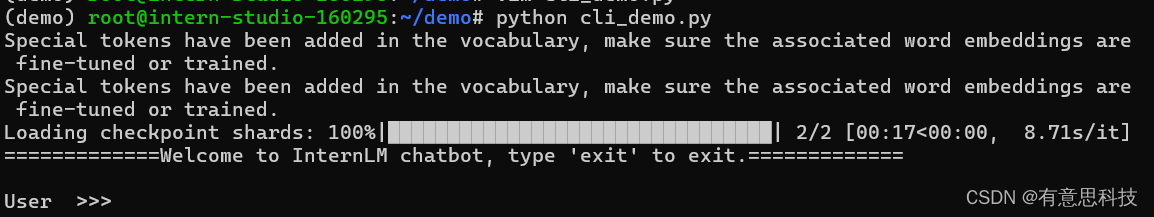

3. 运行Demo

让它 帮我们 创作一个300字的小故事

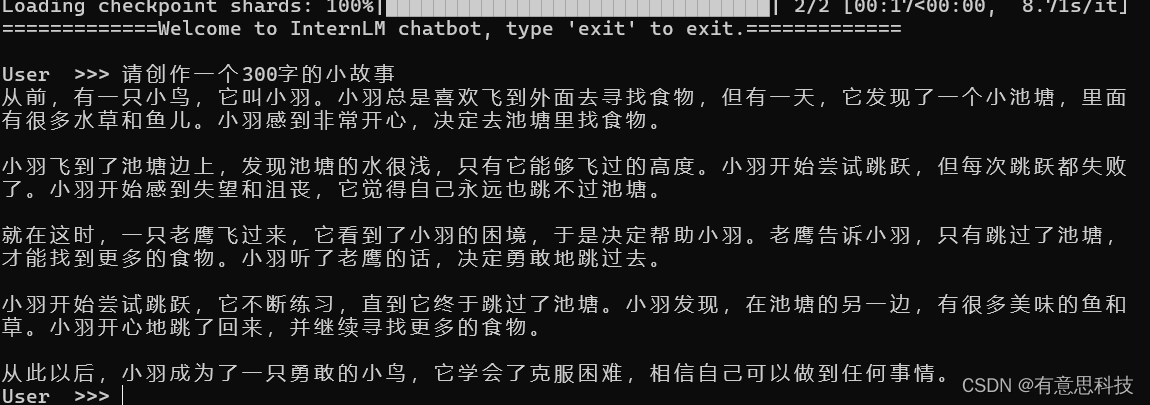

二. 部署实战营 八戒-Chat-1.8B 模型

1. 下载Demo仓库

git clone https://gitee.com/InternLM/Tutorial -b camp2

下载八戒模型:python Tutorial/helloworld/bajie_download.py

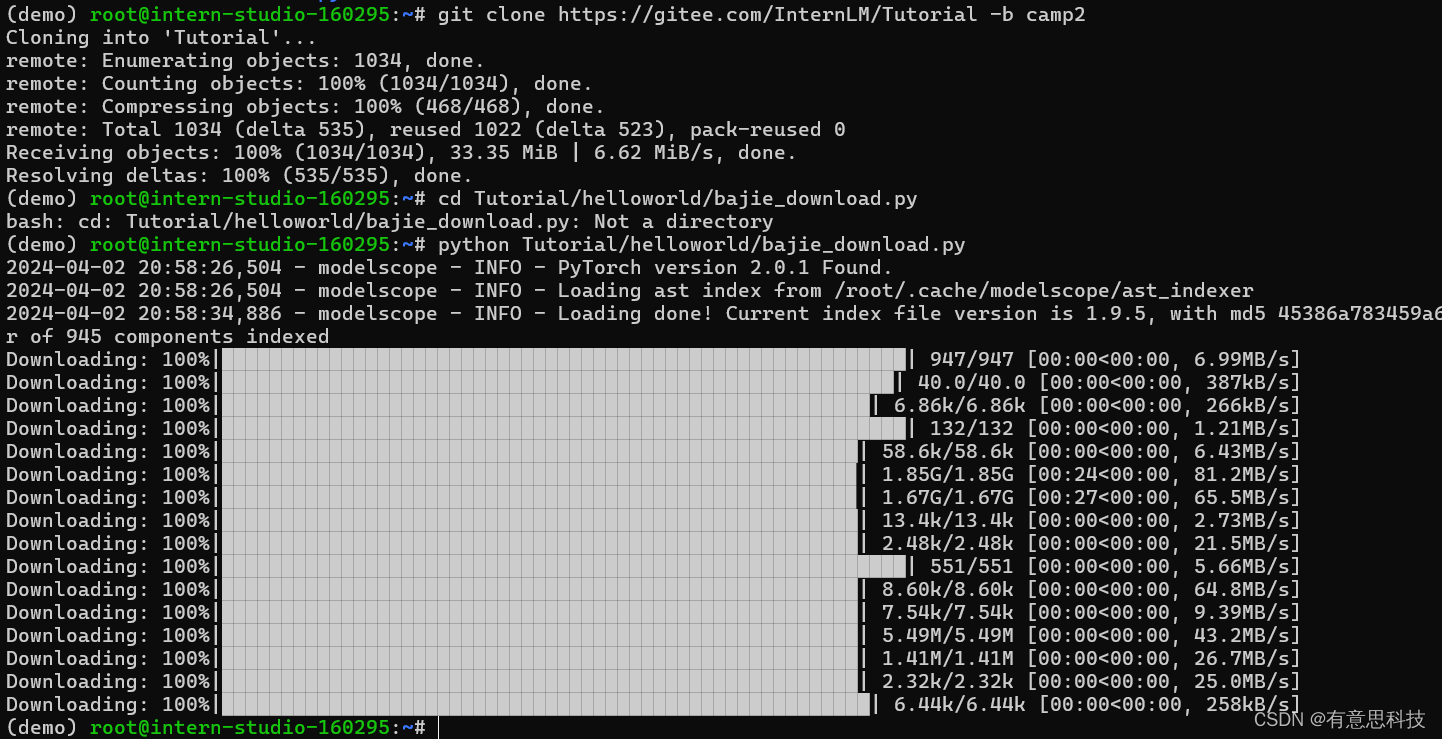

2. 启动web服务端加载八戒模型:

streamlit run /root/Tutorial/helloworld/bajie_chat.py --server.address 127.0.0.1 --server.port 6006

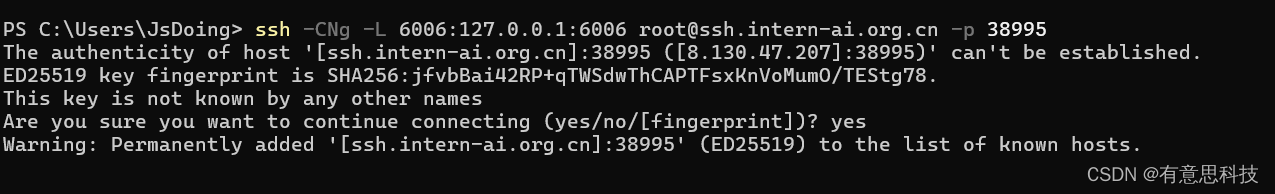

3. 将SSH远程端口映射到本地

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 38995

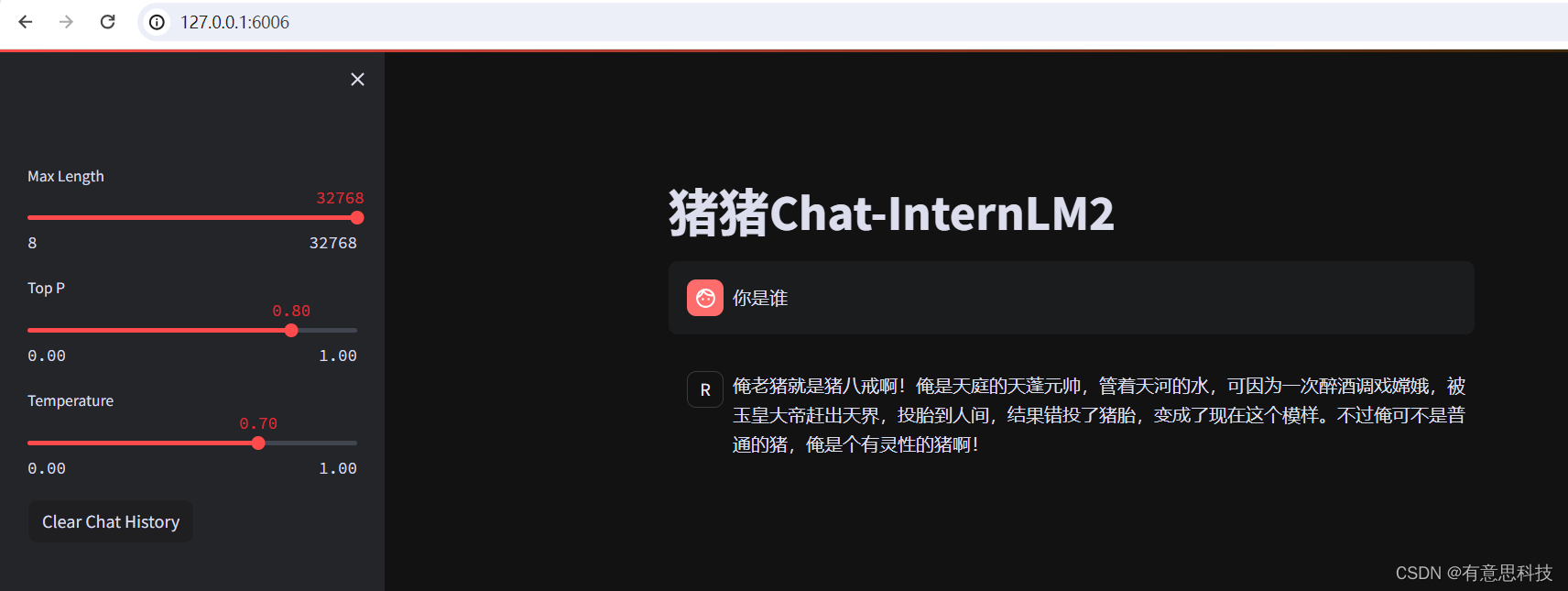

4. 在本地浏览器打开:http://127.0.0.1:6006/

三. 使用 Lagent 运行 InternLM2-Chat-7B 模型为内核的智能体

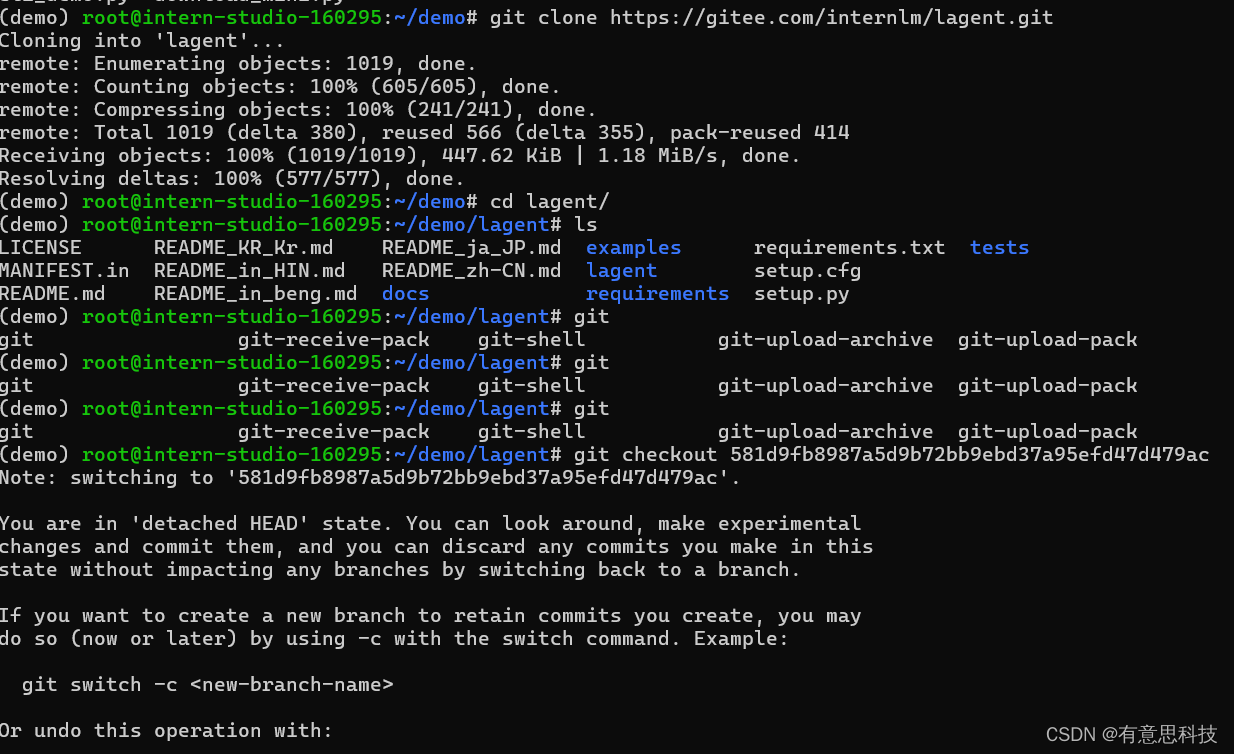

1. 下载代码仓库:

git clone https://gitee.com/internlm/lagent.git

切换到相应commit上:

git checkout 581d9fb8987a5d9b72bb9ebd37a95efd47d479ac

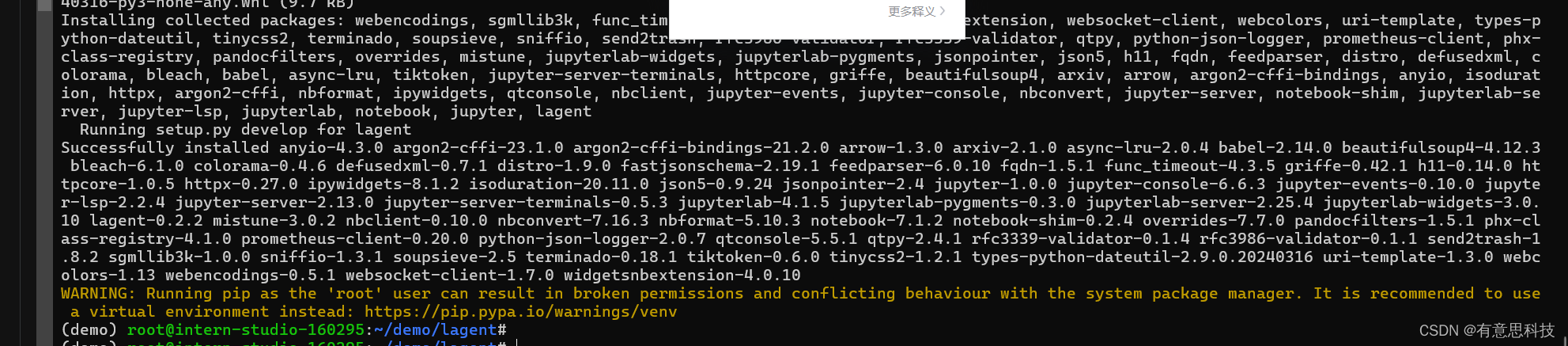

2. 安装

pip install -e .

3. 构造软链接

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-7b /root/models/internlm2-chat-7b

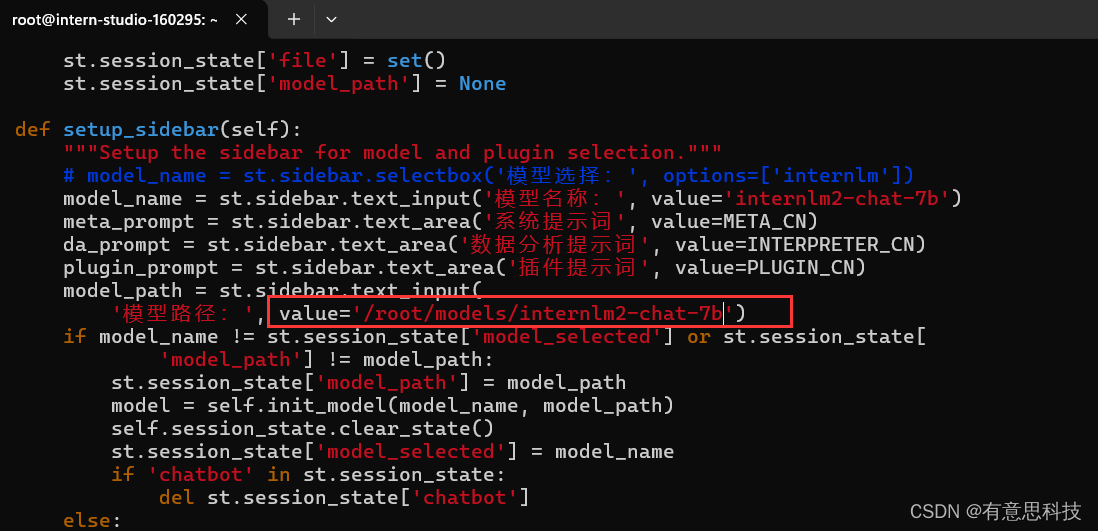

4. 修改examples/internlm2_agent_web_demo_hf.py 文件

修改为:

value='/root/models/internlm2-chat-7b'

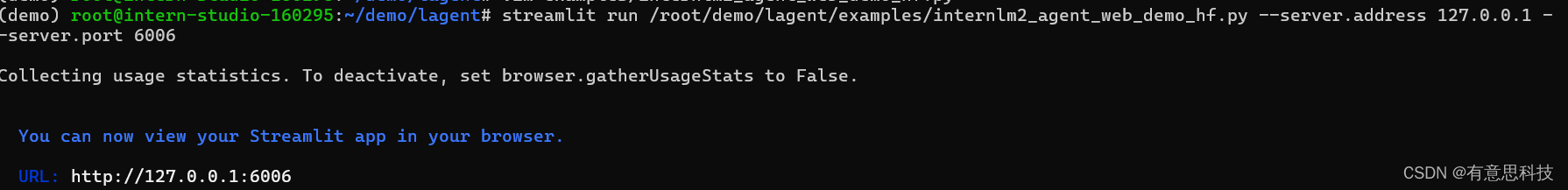

5. 运行web服务端程序加载模型

streamlit run /root/demo/lagent/examples/internlm2_agent_web_demo_hf.py --server.address 127.0.0.1 --server.port 6006

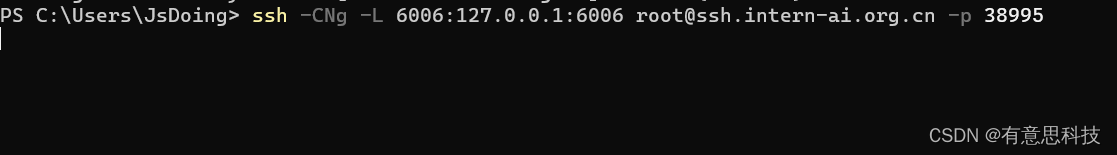

6. web映射到本地

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 42351

7. 浏览器打开:http://127.0.0.1:6006/

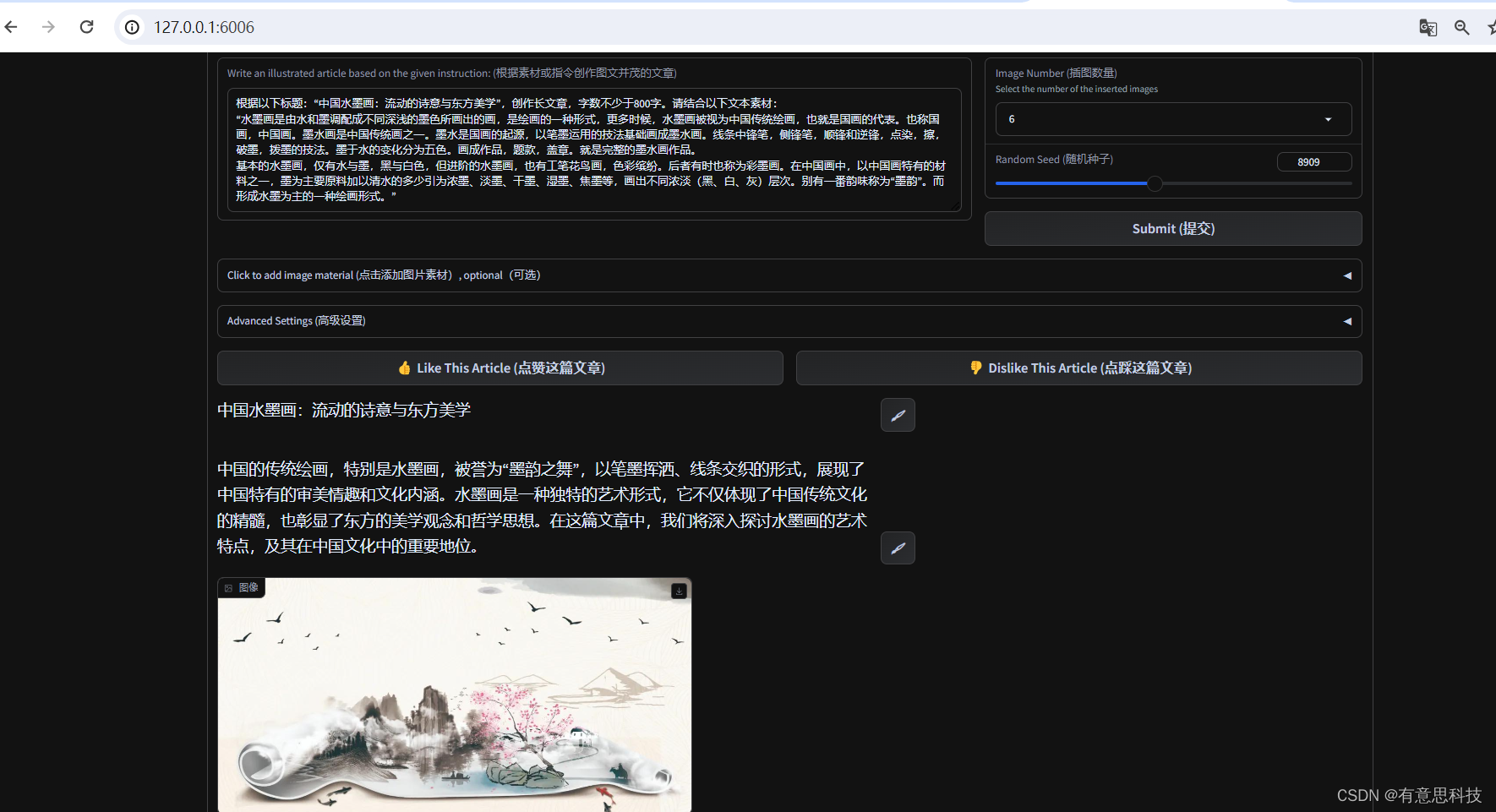

四. 实践部署 浦语·灵笔2 模型

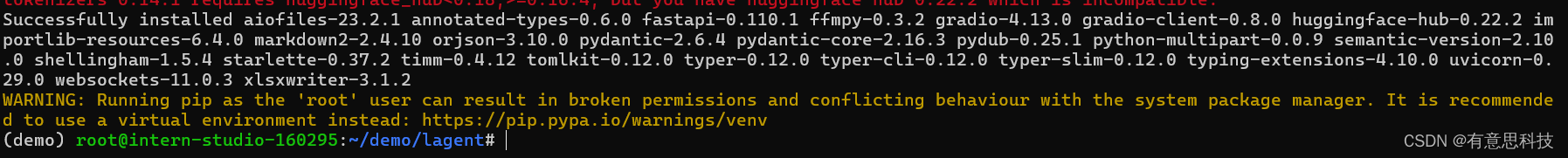

1. 补充环境包

pip install timm==0.4.12 sentencepiece==0.1.99 markdown2==2.4.10 xlsxwriter==3.1.2 gradio==4.13.0 modelscope==1.9.5

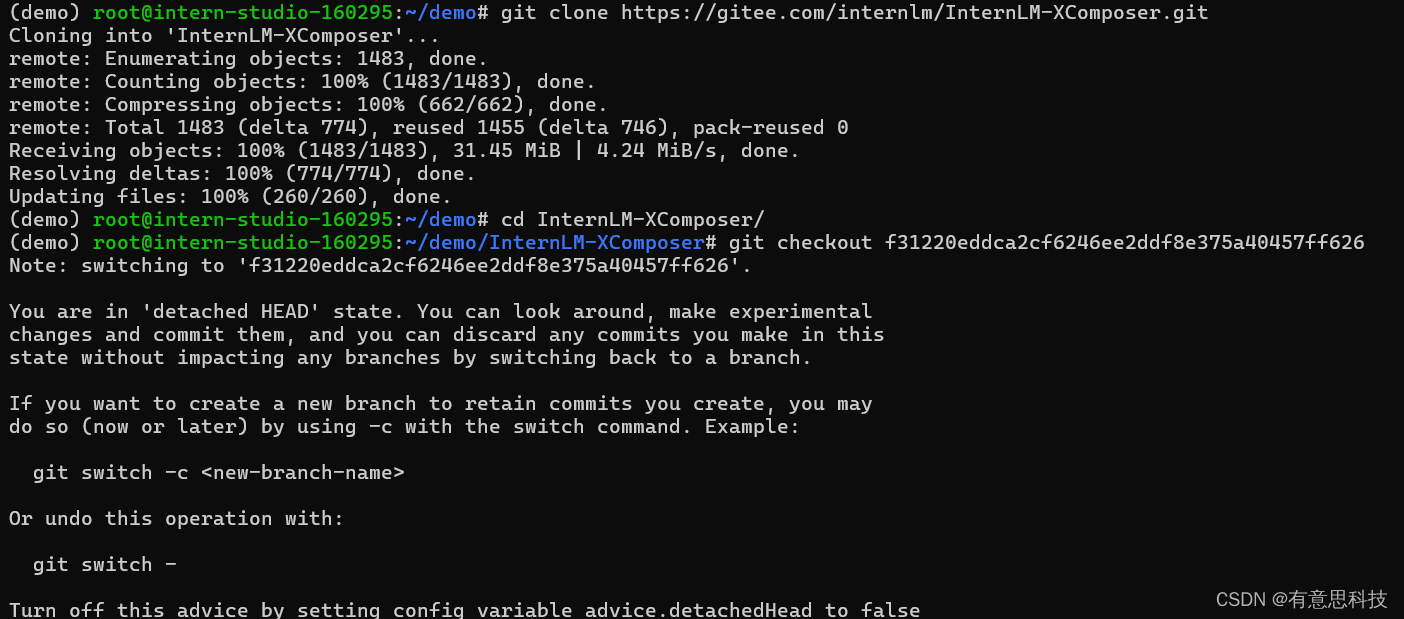

2. 下载代码仓库

git clone https://gitee.com/internlm/InternLM-XComposer.git

并切换到对应commit上

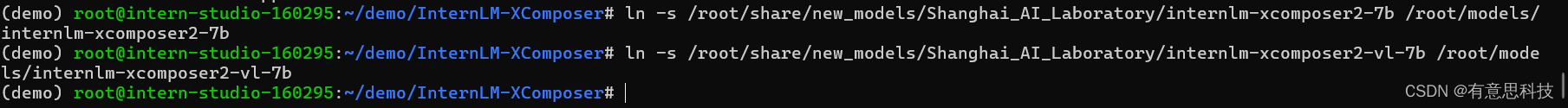

3. 构建软链接

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-7b /root/models/internlm-xcomposer2-7b

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-vl-7b /root/models/internlm-xcomposer2-vl-7b

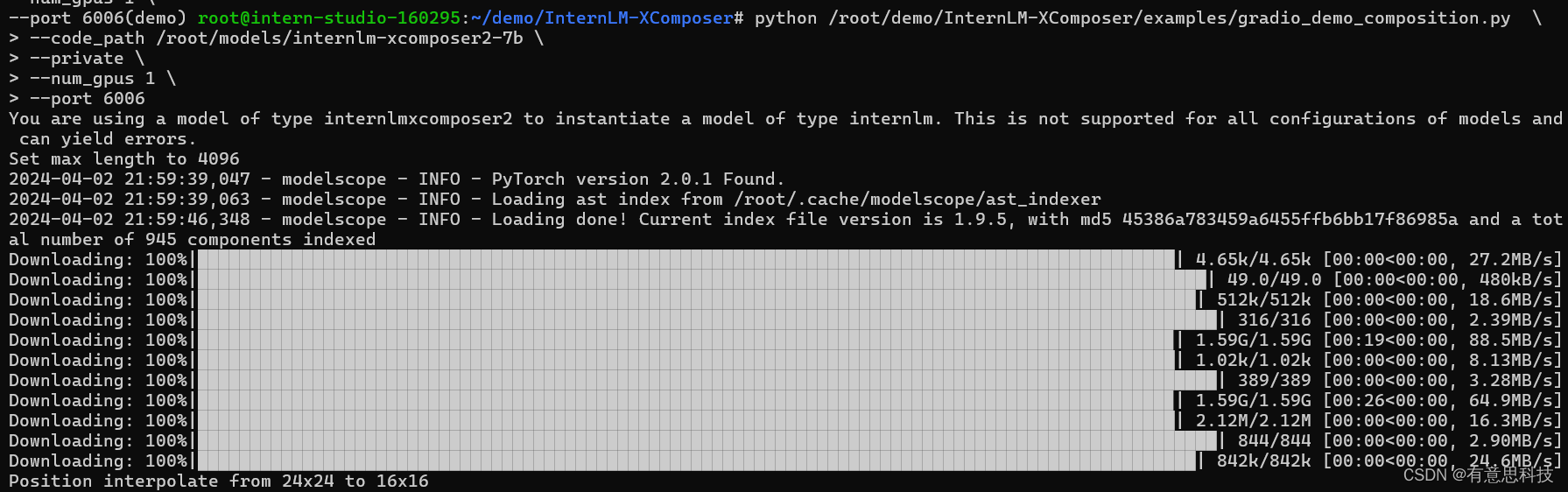

4. 启动InternLM-XComposer

python /root/demo/InternLM-XComposer/examples/gradio_demo_composition.py \ --code_path /root/models/internlm-xcomposer2-7b \ --private \ --num_gpus 1 \ --port 6006

5.参考上面小结的启动 SSH映射端口到本地,并开启web界面

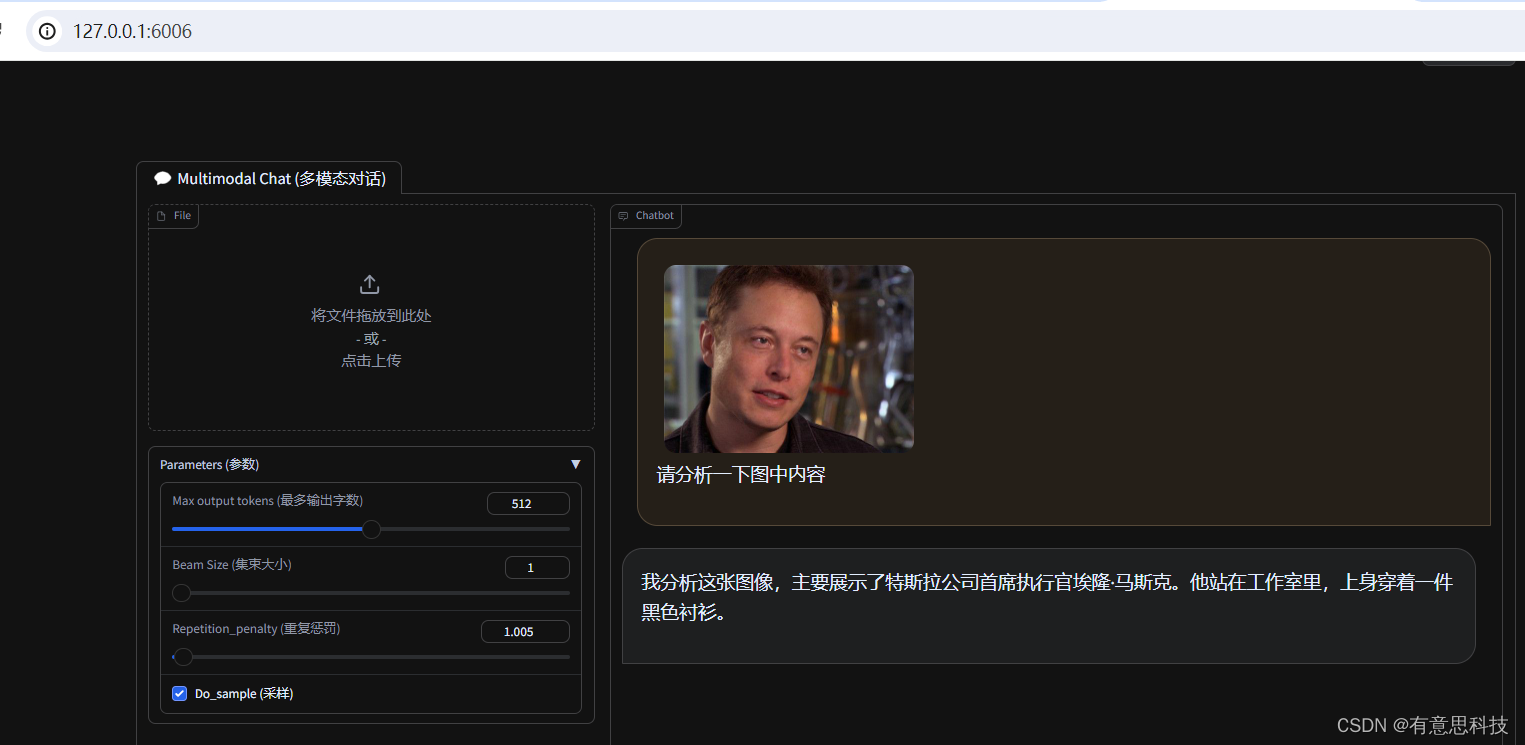

6. 图片理解实战

关闭上面启动程序,重新运行

python /root/demo/InternLM-XComposer/examples/gradio_demo_chat.py \ --code_path /root/models/internlm-xcomposer2-vl-7b \ --private \ --num_gpus 1 \ --port 6006

打开web页面:

644

644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?