摘要

更深的神经网络更难训练。 我们提出了一个残差学习框架,以减轻网络训练的负担,这些网络比以前使用的网络要深得多。我们明确地将这些层重新定义为根据参考层的输入来学习残差函数,而不是学习无参考的函数。我们提供了全面的经验证据,表明这些残差网络更容易优化,并且可以从深度增加中获得准确性的提高。 在ImageNet数据集上,我们评测了深度达152层的残差网络,其深度是VGG网络8倍[40],却仍然有着相对较低的复杂度。 这些残差网络的集合在ImageNet测试集上取得了3.57%的错误率,这一成绩赢得了ILSVRC 2015分类任务的第一名。我们也在CIFAR-10上分析了100层和1000层的残差网络。

表示的深度对于许多视觉识别任务来说至关重要。 完全是因为我们的网络有着极其深的表示,我们在COCO目标检测数据集上才能获得了28%的改进。 深度残差网络是我们提交ILSVRC&COCO 2015比赛的基础,我们还在ImageNet检测,ImageNet定位,COCO检测和COCO分割任务中赢得了第一名。

1.介绍

深度卷积神经网络[22,21]为图像分类带来了一系列突破[21,49,39]。 深度网络自然地以端到端的多层方式集成了低/中/高级特征[49]和分类器,并且特征的“级别”可以通过堆叠层数(深度)来丰富。 最近的证据[40,43]表明,网络深度是至关重要的,并且具有挑战性的ImageNet数据集[35]上领先的结果[40,43,12,16]都利用了“非常深”[40]模型, 深度从16[40]至30[16]。 许多其他重要的视觉识别任务[7,11,6,32,27]也从非常深的模型中获益匪浅。

受深度的重要性的驱动,引发了这样一个问题:学习更好的网络就像堆叠更多层一样简单吗? 回答这个问题的一个障碍是著名的梯度消失/爆炸的问题[14,1,8],它从一开始就妨碍了收敛。 然而,这个问题主要通过标准初始化层(normalized initialization )[23,8,36,12]和中间的标准化层(intermediate normalization layers)[16]来解决,这使得数十层的网络能通过具有反向传播的随机梯度下降(SGD)开始收敛。

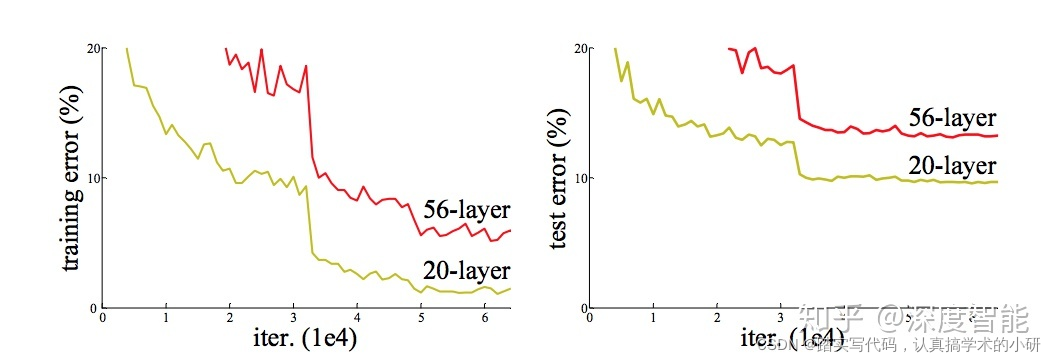

当更深的网络能够开始收敛时,就会出现退化问题:随着网络深度的增加,准确度变得饱和(这可能不令人意外),然后迅速退化。 出乎意料的是,这种退化不是由过度拟合引起的,并且向适当深度的模型中添加更多层会导致更高的训练误差,如[10,41]中所报告并且我们的实验已经充分验证。 图1显示了一个典型的例子。

图1. 20层和56层普通网络在CIFAR-10上的训练误差(左)和测试误差(右)。更深的网络有更大的训练误差和测试误差。ImageNet上的类似现象如图4所示。

(训练准确率的)退化表明并非所有系统都同样易于优化。 让我们考虑一个较浅的架构,和一个在较浅架构上添加更多层而构成的更深层的架构。 构建更深的模型的一个解决方案是:增加的层是恒等映射,而其他层是从已经训练好的浅层模型复制来的。 这种构建解决方案的存在表明,深层模型不应该比浅层模型产生更高的训练误差。 但是实验表明,我们目前已有的方案无法找到与这种构建解决方案相当或比之更好的解决方案(或在合理时间内无法做到)。

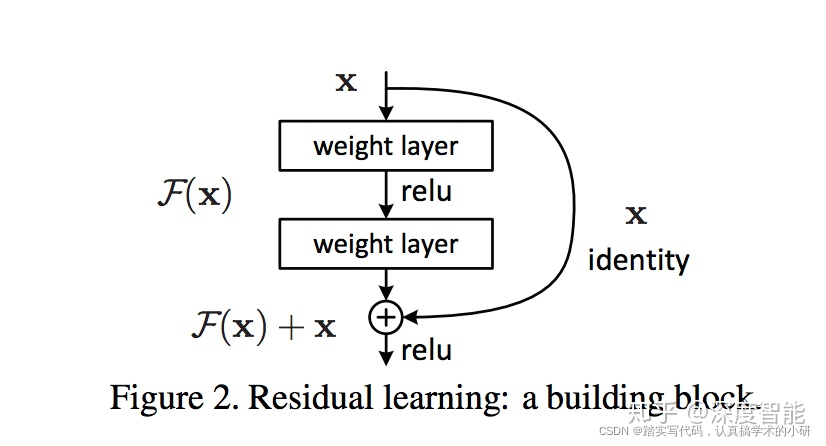

在本文中,我们通过引入深度残差学习框架来解决退化问题。我们明确地让这些层拟合残差映射,而不是希望每几个堆叠的层直接拟合期望的基础映射。 形式上,将期望的基础映射表示为H(x),我们让堆叠的非线性层拟合另一个映射F(x):= H(x)-x。 那么原来的基础映射H( x )重写为F(x)+ x。 我们假设优化残差映射比优化原来无参考的映射更容易。 极端情况下,如果恒等映射是最优的,那么将残差逼近零比通过一堆非线性层拟合恒等映射更容易。

公式F(x) + x 可以通过具有“捷径连接”(shortcut connections)的前馈神经网络来实现(图2)。捷径连接[2,34,49]是那些跳过一层或多层的连接。在我们的例子中,捷径连接只需执行恒等映射,并将其输出添加到堆叠层的输出中(图2)。恒等捷径连接不会增加额外的参数和计算复杂性。整个网络仍然可以通过反向传播的SGD进行端对端训练,并且可以在不修改求解器的情况下使用公共库(例如Caffe [19])轻松实现。

图2:残差学习:构建块

- 相关工作

剩差表示。在图像识别中,VLAD [18]是一个用残差向量对字典进行编码的表示形式,Fisher Vector [30]可以表示为VLAD的概率形式[18]。它们都是图像检索和分类中强大的浅层表示[4,48]。向量量化,编码残差向量[17]被证实比编码原始向量更有效。

在低级视觉和计算机图形学中,为了求解偏微分方程(PDE),广泛使用的Multigrid方法[3]将系统重构为多尺度的子问题,其中每个子问题负责对较粗的和较细的尺寸间的残差解。Multigrid的一种替代方法是层次化预处理([45,46],它依赖于代表两个尺度之间的残差向量的变量。[3,45,46]已经表明,这些求解器比不知道解的残差性质的标准求解器收敛速度要快得多。这些方法表明良好的重构或预处理可以简化优化。

捷径连接。促成捷径连接的实践和理论[2,34,49]已经被研究了很长的时间。训练多层感知器(MLP)的早期实践是添加一个从网络输入连接到输出的线性层[34,49]。在[44,24]中,几个中间层直接连接到辅助分类器,以解决梯度消失/爆炸问题。 论文[39,38,31,47]提出了通过捷径连接实现层间响应,梯度和传递错误的方法。在[44]中,“Inception”层由一个捷径分支和几个更深的分支组成。

与我们的工作同时,“高速网络”(highwar networks)[42,43]提出了门控[15]功能的捷径连接。这些门依赖于数据并且具有参数,这与我们的无参数的恒等捷径不同。当门控捷径“闭合”(逼近零)时,高速网络中的层代表非残差函数。相反,我们的公式总是学习残差函数;我们的恒等捷径永远不会关闭,并且所有信息总是通过,还有额外的残差函数需要学习。另外,高速网络在深度非常深的情况下(例如超过100层)没有表现出准确性的提高。

428

428

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?