论文阅读笔记:深度残差网络:Deep Residual Learning

本文主要包含如下内容:

论文地址

论文来自微软 Kaiming He 何恺明,是2016的CVPR

主要思想

论文利用信號叠加合并的優點,解決了超深度CNN網絡訓練問題。提出了一个 deep residual learning 框架来解决这种因为深度增加而导致性能下降问题。

残差网络 Residual networks 赢得了 ImageNet 的 detection, localization, 以及COCO数据集上的 detection 和 segmentation 的第一名。

现阶段网络存在的问题

越深的网络效果越好,但是随着网络层数的增加,问题随之而来:首先,梯度的消失和发散 vanishing/exploding gradients,导致训练难以收敛。但是随着 normalized initialization [23, 9, 37, 13] 和 intermediate normalization layers[16] 的提出,这个问题得到解决。

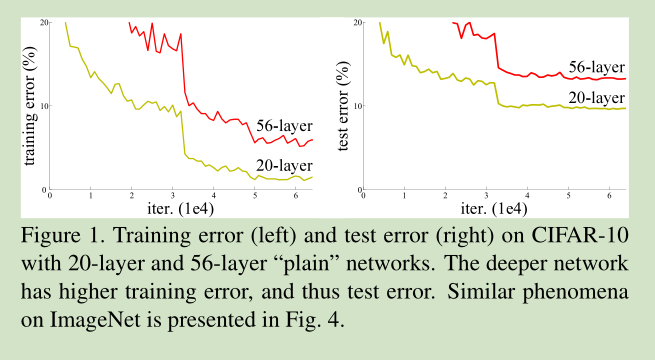

其次,随着网络深度的增加,在系统精度得到饱和之后,精度迅速下降。对一个合适深度的模型加入额外的层数反而会导致训练误差变大。因为训练误差也会随着深度增加而增大。

网络结构

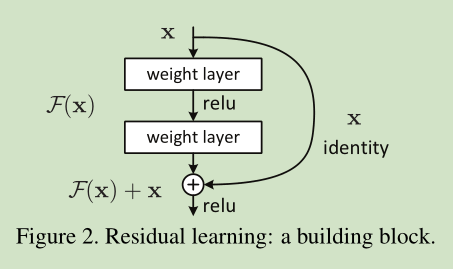

那么,如果我们增加的层数可以构建为一个 identity mappings,那么增加层数后的网络训练误差应该不会增加。这里我们提出一个 deep residual learning 框架来解决这种因为深度增加而导致性能下降问题。 假设我们期望的网络层关系映射为 H(x), 我们让 the stacked nonlinear layers 拟合另一个映射, F(x):= H(x)-x , 那么原先的映射就是 F(x)+x。 这里我们假设优化残差映射F(x) 比优化原来的映射 H(x)容易。

思想:“假如目前有一个可以工作的很好的网络A,这时来了一个比它更深的网络B,只需要让B的前一部分与A完全相同,后一部分只实现一个恒等映射,这样B最起码能获得与A相同的性能,而不至于更差。深度残差学习的思想也由此而产生,既然B后面的部分完成的是恒等映射,何不在训练网络的时候加上这一先验,于是构造网络的时候加入了shortcut连接,即每层的输出不是传统神经网络当中输入的映射,而是映射和输入的叠加”

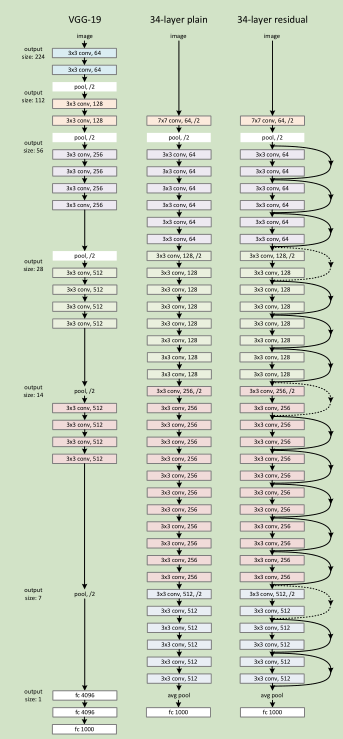

该网络结构受 VGG 网络的启发,设计思路:对于相同输出特征图尺寸,卷积层有相同个数的滤波器;如果特征图尺寸缩小一半,滤波器个数加倍以保持每个层的计算复杂度。通过步长为2的卷积来进行降采样。一共34个权重层。 (全卷积网络 FCN)

实验结果

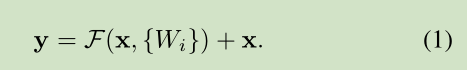

实验结果表明,残差网络有利的解决了随着深度的增加,网络精度反而进一步降低的问题。该网络能够随着网络深度的增加进一步提高网络的精度。

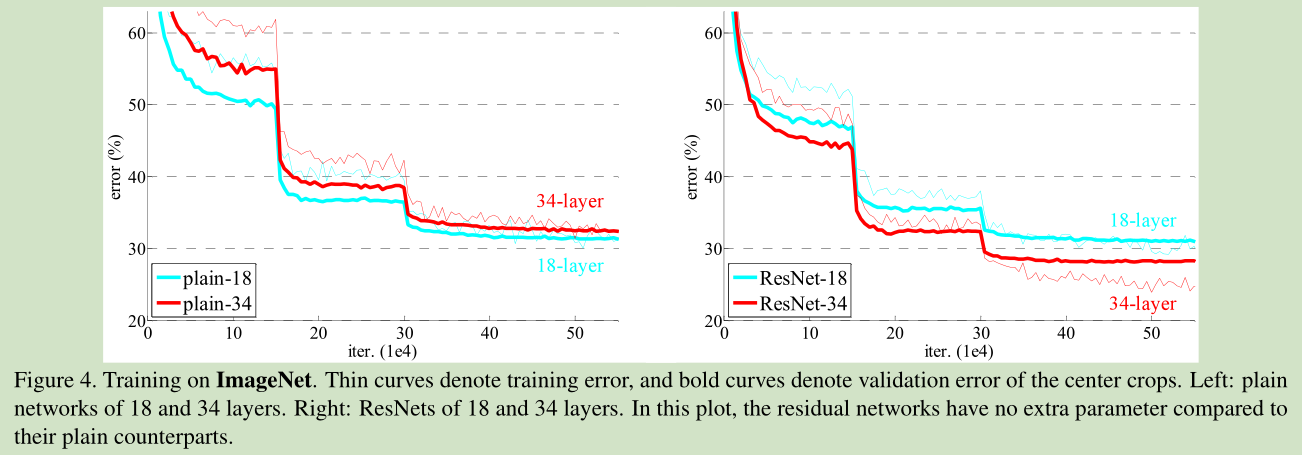

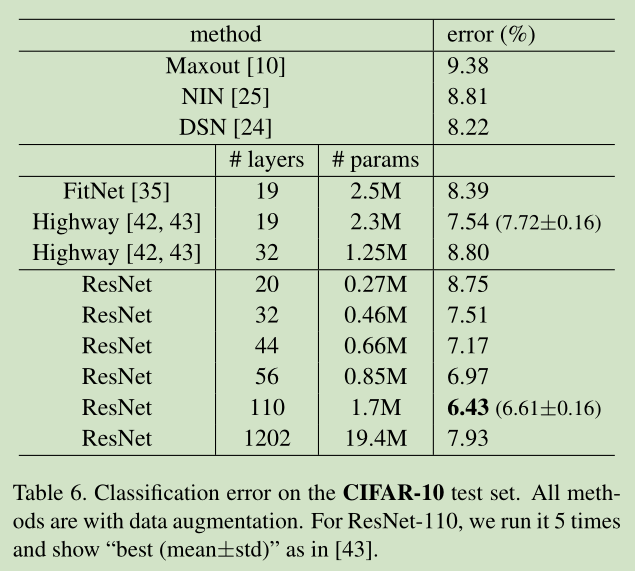

在数据集 CIFAR-10 上,残差网络展现了最好的结果。

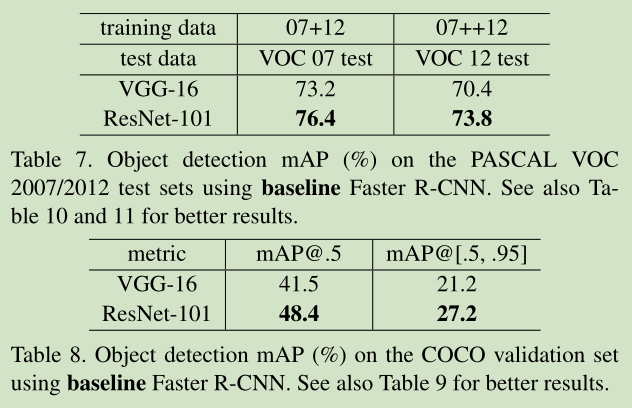

实验结果表明,在数据集 PASCAL VOC 和 COCO,针对分类任务和检测任务,残差网络都有较好的表现。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?