常用软件

VirtualBox

-

类似VMWare的虚拟机

Vagrant

-

VirtualBox的Linux系统各发行版镜像仓库,使用vagrant连接VirtualBox能快速拉取centos镜像通过一行命令快速创建centos虚拟机

-

详细使用见Linux指南

Kibana

- Kibana的Dev Tools可用于使用Elasticsearch的WEB API,管理和操作ES中的数据

- Dev Tools界面使用快捷键Ctrl+Home或者Ctrl+End可以快速跳转至控制台的首行或者最后一行

- Dev Tools界面的格式化快捷键为Ctrl+I

JMeter

- Jmeter中选择Options–Choose Language中可以选择简体中文

-

JMeter设置

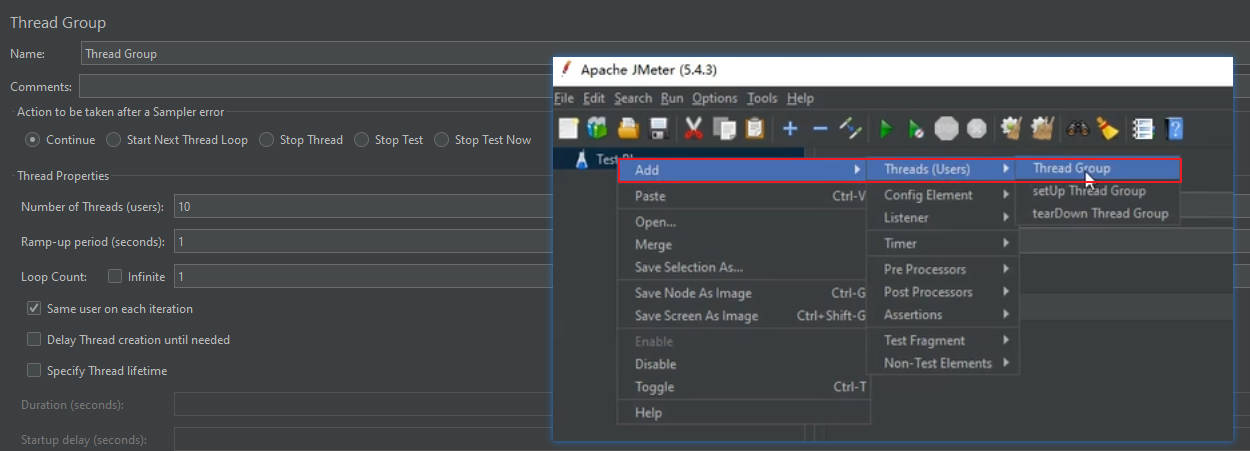

【线程组设置】

-

Thread Group表示发送请求的最小单位是以线程作为单位的

-

Name是线程组的名称,Comments是该线程组的摘要说明,这两个都可以不填

-

Number of Threads是并发请求的用户数,意思是给并发请求启动多少个线程来模拟用户数量

-

Ramp-up period指的是这些线程在多长时间内将这些线程启动起来,可以看做多长时间内把所有请求发送出去,注意这里只是发送请求的时间,总的时间包含等待响应的时间,不同的服务器性能和响应内容可能导致总时间远远超出发送请求的时间

- ❓:注意不是单个循环发送的时间,因为设置50个循环请求少的时候也是瞬间发完,这里具体的意思还需要明确,倾向于多长时间将这些线程启动起来,因为请求少,每个线程50次请求可以瞬间发完

-

Loop Count该线程组发送请求循环的次数【每个线程发送多少个请求】,infinite表示无限次发送请求

【请求设置】

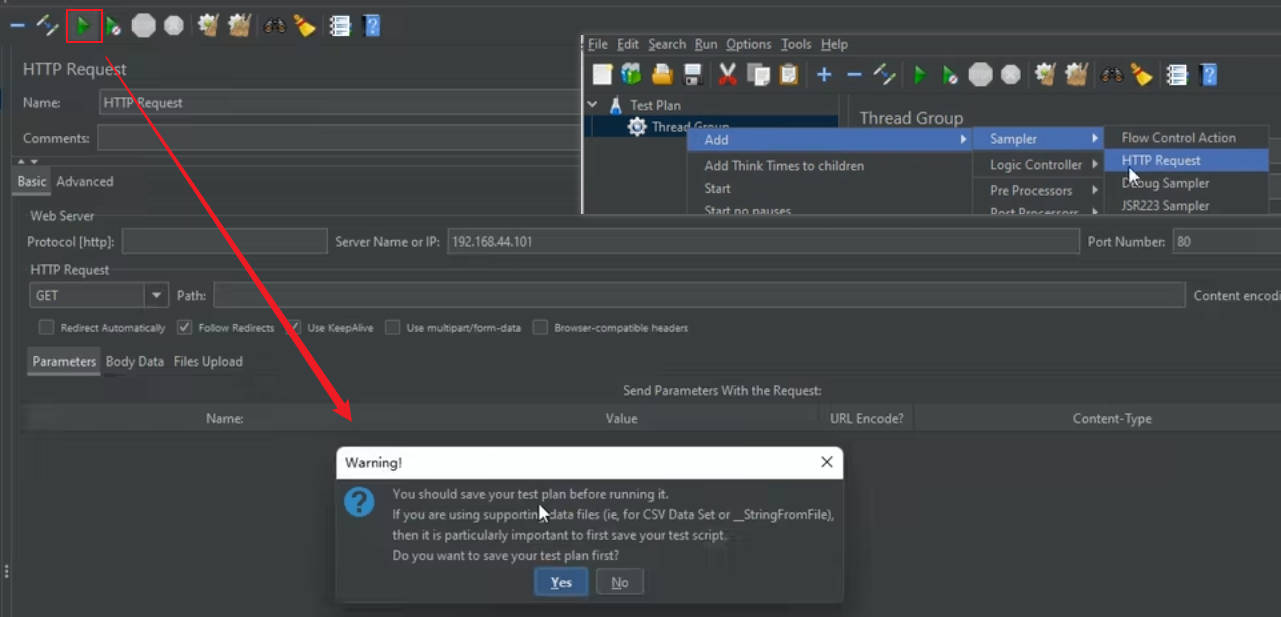

- 点击绿色按钮是启动该线程组,弹框是提示是否保存当前设置的请求计划,点击保存会将请求设置保存在本地的jmeter的bin目录下的Summary Report.jmx文件中【就是持久化操作】,齿轮加两个扫把图标是清空全部统计数据【不清空每次测试数据会累计】

- 取样器是选择要发送请求的样式

- 需要在Web Server菜单指定请求的协议,目标服务器的IP地址或者被DNS解析的域名,目标服务器端口号

- 在Http Request中指定请求的方式和请求路径

-

-

使用jmeter分析测试结果

【jmeter的查看测试结果集菜单】

-

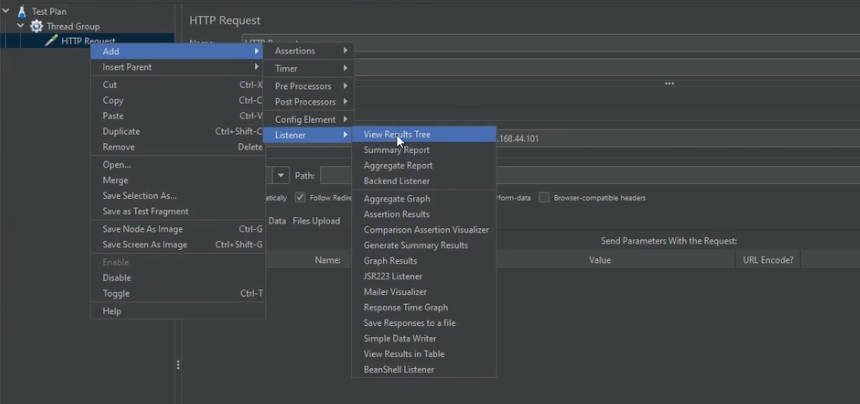

listener【监听器】下有很多展示测试数据的测试结果集选项,比较常用的有以下三种,要像图中这样选中对应的选项卡,在选项卡菜单中运行线程组

-

View Result Tree:查看结果树,能够看到每次请求的响应状态和对应的响应结果

-

Summary Report:汇总报告,显示请求总数,平均、最小、最大响应时间,响应时间的方差和标准差【反应每个样本响应时间和平均值的偏差程度】,异常比例,吞吐量【该指标非常重要,通过该指标来衡量接口每秒的并发能力】,每秒接收和发送的网络数据【网络数据太慢会影响对服务器性能的判断,因为发送请求太慢】

-

View Result in Table:

-

Aggregate Report:聚合报告,显示样本总量、平均响应时间、响应时间中位数、90%、95%、99%请求完成的时间【单位是毫秒】,请求最小最大响应时间、异常比例、吞吐量、接收和发送网络数据的速率

-

Aggregation Graph:能够将统计数据以图表的形式进行展示,在列设置中设置柱状图展示的数据类型、

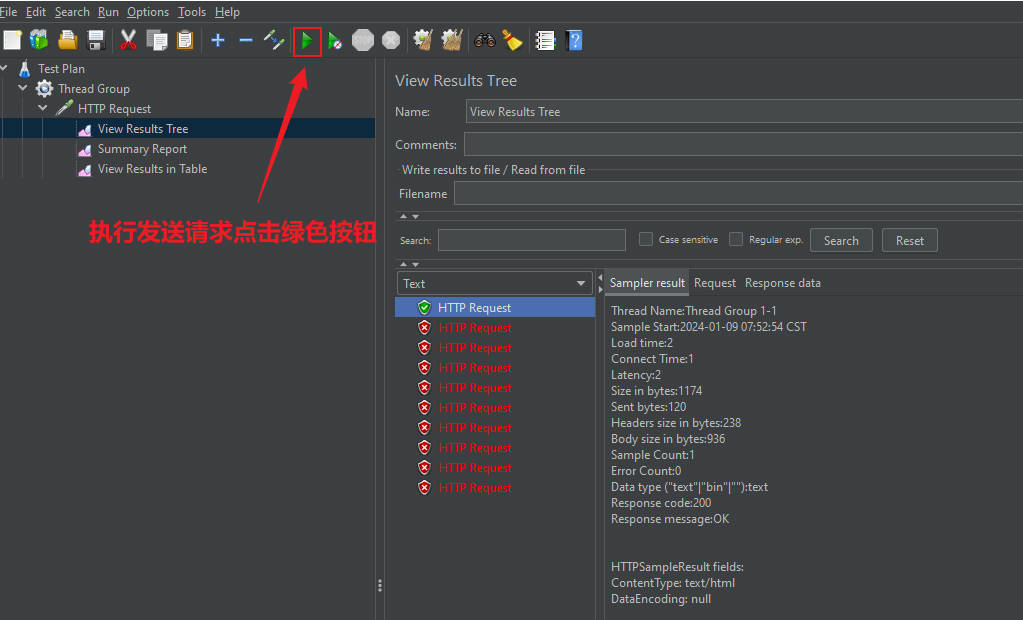

【View Result Tree测试效果】

-

直接选中对应的结果集选项,并按此前操作点击绿色按钮

-

在此前的限流设置下,一秒内的十次并发请求,只有第一个成功了

-

该结果集选项卡下能看到每个请求的请求协议信息、请求的URL和响应数据

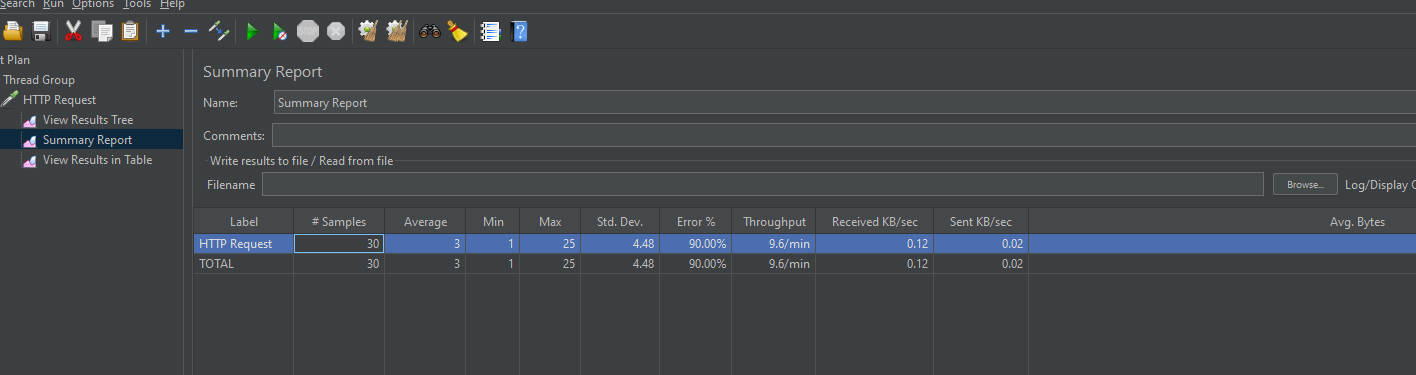

【Summary Report测试效果】

Label字段指是发送的是哪一类请求,Http Request表示发送的是http请求,Total表示所有请求的统计信息

Sample表示发送请求的样本个数,我发了3次十个请求,这里就显示的30个

Average、Min、Max、Std.DEV都是响应时间,意思是响应时间的平均值,最小值、最大值和中位值

Error是请求发送发生错误的请求比例有多少

Throughput是指吞吐量,就是指QPS,卧槽我这里怎么是9.6个每分钟,老师的演示是11个每秒,说样本太少,展示数据的结果不准确

Received KB/sec是指每秒接收数据的吞吐量,即网络消耗的吞吐

Send KB/sec是指每秒发送数据的吞吐量

Avg.Bytes是平均每秒数据吞吐量的大小

需要关注的主要就是QPS和发送接收数据的吞吐量,如果QPS怎么也上不去,就像下图演示的情况,此时一定要关注传输数据的吞吐量,因为数据传输的速率是由网卡决定的,比如百兆网卡下载速度应该是100除以8,即12M左右,到达数据传输上限或者延迟很高QPS也是上不去的,不知道是不是我这里的网络太差的原因,但是我这儿用的是同一台主机,难道也是用网卡进行通信的吗

注意上面的工具栏两个小扫把【悬停显示clear】可以清除页面的数据【一个是清除当前,一个是清除所有】,每次发送请求都最好点一下清除数据,方便统计

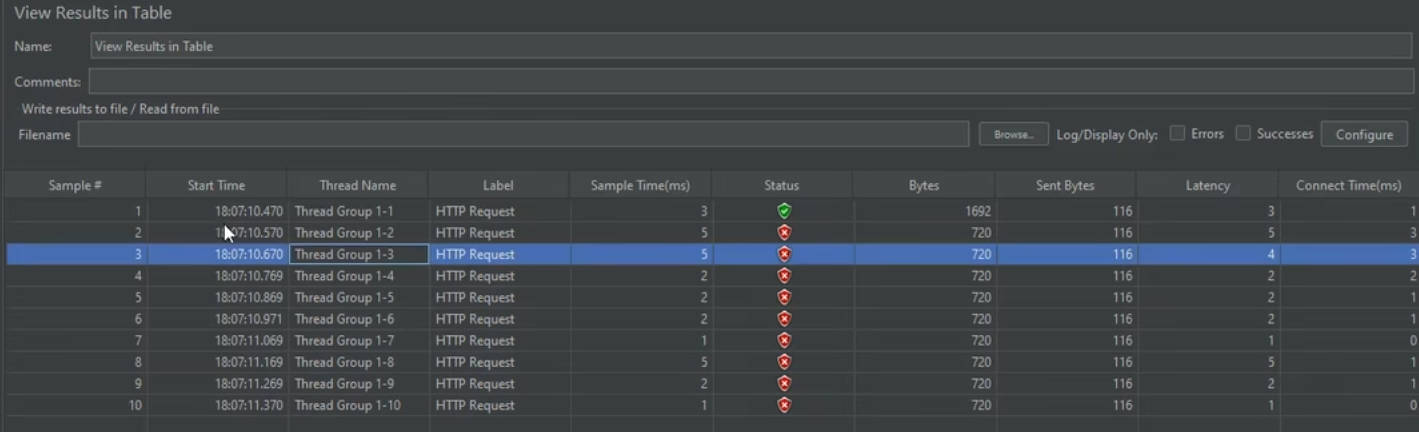

【View Result in Table测试效果】

能够看到每个请求的开始时间【毫秒级别】,请求线程、响应时间、响应状态、请求和响应数据量

-

-

对Nginx服务器无限次请求,观察jmeter统计效果

我这里发了十二万个请求,在nginx服务器的设定限流规则下,只有几个成功了【因为试验了几秒钟】,此时我的QPS上来了,能达到42.4每秒,卧槽老师的都快10000每秒了

连续发起请求,整个过程40多万个请求,可以动态的显示QPS效果。我这里QPS稳定达到了14000左右每秒【最高一万七,一万七不是真实数据,我第二次请求一直单增,但是最终还是稳定1万四】,老师的还是10000左右

虚拟机的配置相比于实际生产机极低,也能到一万多的QPS,QPS高的原因是nginx性能高此外还有请求几乎都报错,即有很多无效的QPS

顶上error和success分别勾选能单独统计成功请求和失败请求的QPS,在ngixn设置的限流策略下随时间推移勾选成功会将QPS稳定在设置值1r/s

而且在View Result in Table中能看到成功请求的时间间隔严格的遵循1s,完全精确到jmeter的时间刻度1ms

JMeter常见问题

- JMeter报错Address Already in use

- 问题描述:Jmeter访问测试本机127.0.0.1的端口服务,在无限请求的情况下请求产生大量异常,异常率迅速飙升超过50%,响应体报错,提示信息

Address already in use - 原因分析:该问题实际是windows的问题,windows本身提供给TCP/IP的端口是1024-5000,且需要四分钟才会循环回收这些端口,短时间内跑大量的请求会将端口占满

- 解决方法一:修改windows的注册文件,windows官方文档中指出当尝试大于5000的TCP端口连接时会收到大量错误,可以通过以下方案来解决

- 1️⃣:在win+r打开窗口中使用命令

regedit打开注册表 - 2️⃣:选择

计算机\HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\Tcpip\Parameters, - 3️⃣:右击

parameters,新建–DWORD32位,修改对应名字为MaxUserPort,点击该MaxUserPort,在弹出窗口将数值改为65534,基数为十进制【这是设置最大可用端口数量】 - 4️⃣:右击

parameters,新建–DWORD32位,修改对应名字为TCPTimedWaitDelay,点击该TCPTimedWaitDelay,在弹出窗口将数值改为30,基数为十进制【这是】设置windows回收关闭端口的等待时间为30s - 5️⃣:退出注册表编辑器,重启计算机配置才能生效

- 1️⃣:在win+r打开窗口中使用命令

- 问题描述:Jmeter访问测试本机127.0.0.1的端口服务,在无限请求的情况下请求产生大量异常,异常率迅速飙升超过50%,响应体报错,提示信息

Jconsole

- 该工具用于远程或者本地监控Java进程的线程数目、线程运行状态、内存占用等信息

- Jconsole远程连接Java进程需要被连接Java进程在虚拟机做一些额外配置才能允许远程连接,一般项目上线测试使用Jvisualvm也需要这些配置,弹幕说叫jmx配置

-

jconsole远程连接Java进程配置

-

被远程连接Java程序使用以下命令启动

- ip地址:这个是当前虚拟机的IP地址,不是jconsole所在主机的IP地址

- 连接端口:是Jconsole与远程主机的通讯端口,可以随意指定

- 是否需要安全连接:一般自己用也不需要安全连接选择false,如果需要选择true

- 是否需要认证:一般自己使用不需要安全认证可以选择false,如果需要选择true

java -Djava.rmi.server.hostname=`ip地址` -Dcom.sun.management.jmxremote - Dcom.sun.management.jmxremote.port=`连接端口` -Dcom.sun.management.jmxremote.ssl=是否安全连接 - Dcom.sun.management.jmxremote.authenticate=是否认证 java类名 -

通过该启动参数启动的Java进程并提供了远程监控服务,jconsole可以通过该ip和指定的监听端口连接到远程的Java进程上来进行调试,没有设置认证jconsole直接通过ip地址和端口直连就行,不需要输入用户名和口令;需要服务器开放对应端口通讯

-

-

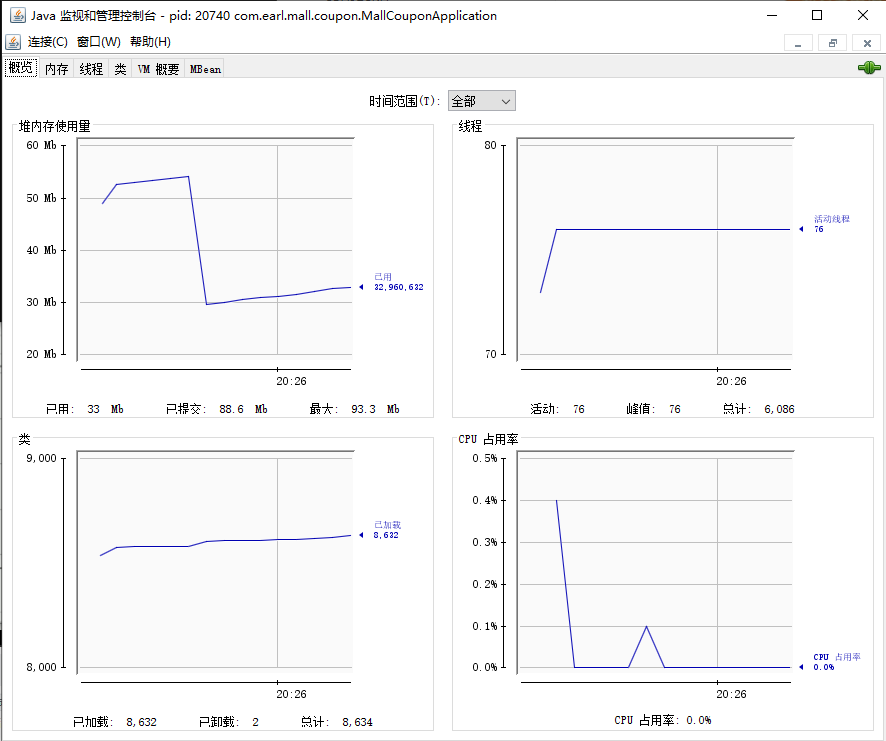

监控堆内存变化、CPU、线程指标的jconsole和jvisualvm工具

-

这两个工具都是Java提供的,jvisualvm是jdk6以后提供的工具,是jconsole的升级版工具,一般推荐使用jvisualvm,相比于jconsole功能更强大,还可以将运行期间出现的问题以快照的形式下载下来慢慢分析来优化应用

-

jconsole的使用

-

安装了java环境直接在CMD窗口敲命令

jconsole启动jconsole控制台 -

上来就提示需要新建连接,指要连接的具体应用,可以连接本地的,也可以连接远程的,本地进程会列举所有运行java程序的进程名称和对应的进程号,选择对应的应用进行监控

-

监控面板

-

概览面板

- 监控的数据包括堆内存使用量,线程数【压力测试线程数会一直向上涨】,已加载的类数量,CPU占用率

-

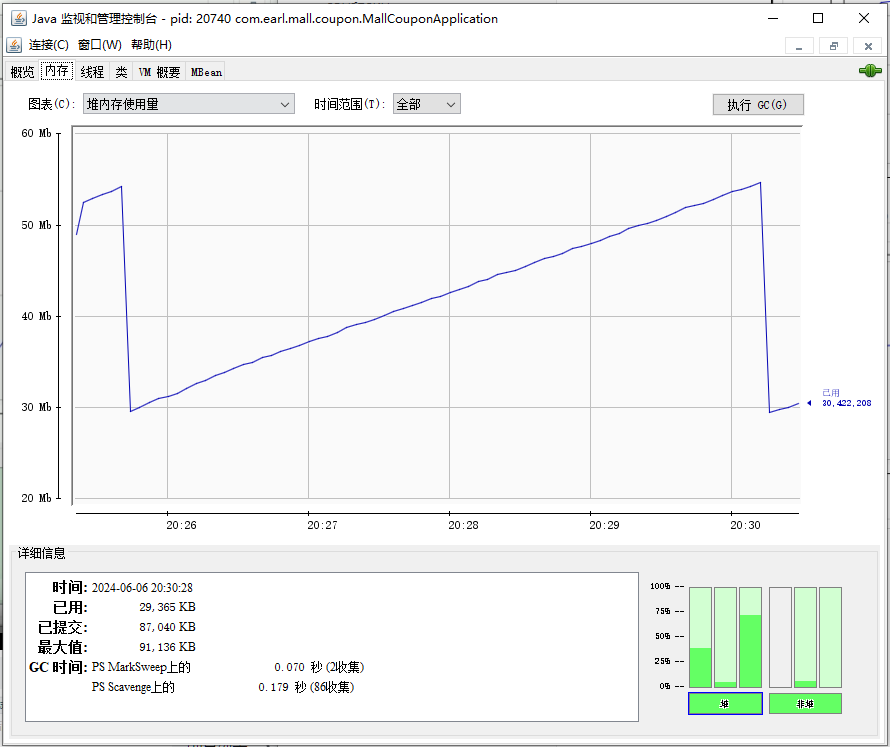

内存面板

- 绿条第一个是老年代内存,第二个是伊甸园区内存,第三个是幸存者区内存,

-

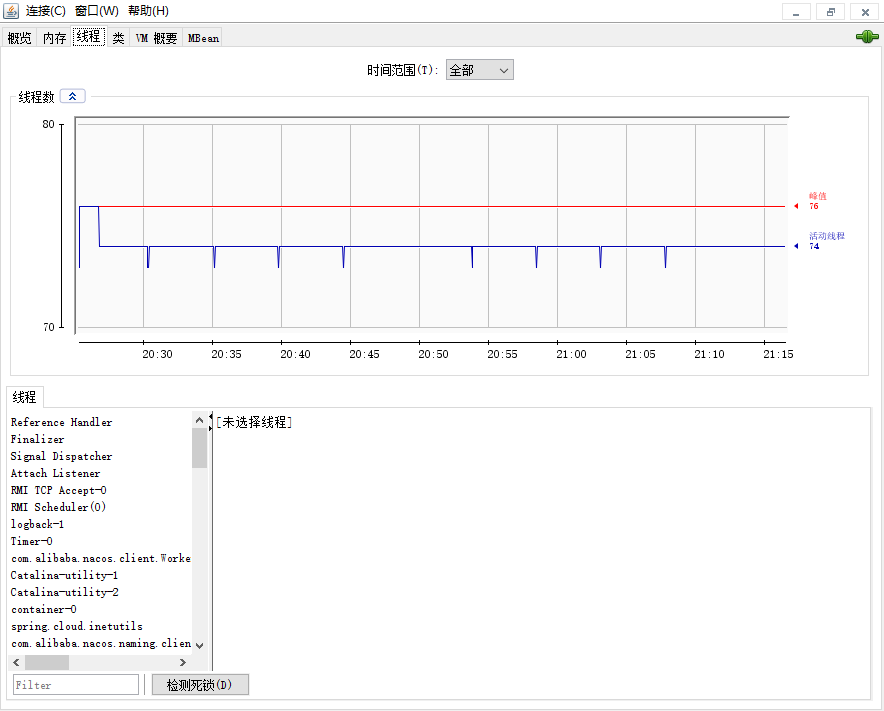

线程面板

- 显示当前的每个线程和对应的堆栈跟踪信息

-

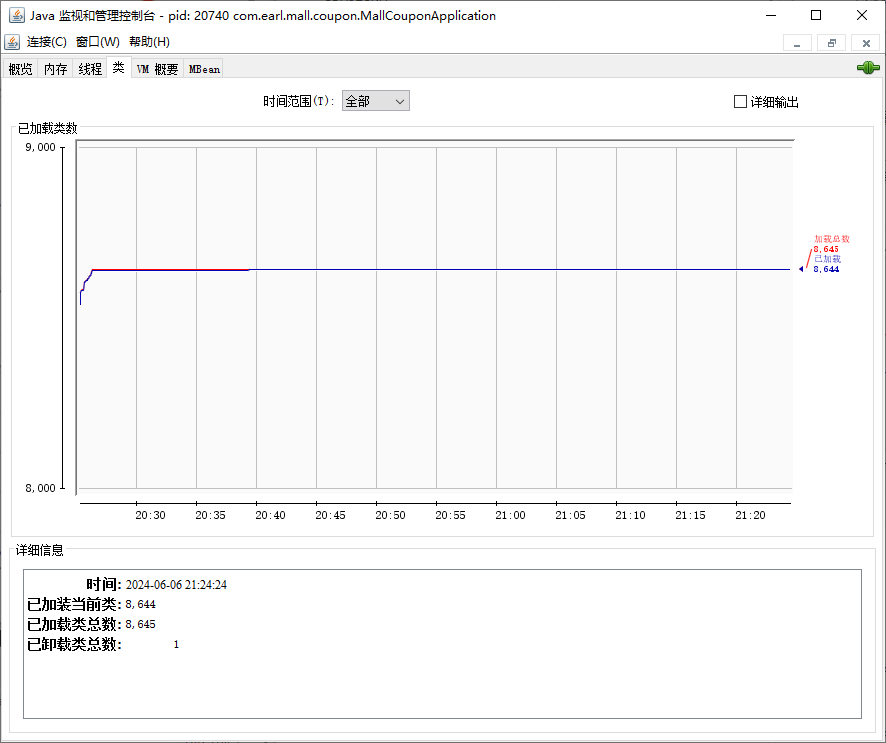

类面板

- 显示当前加载的类信息

-

-

-

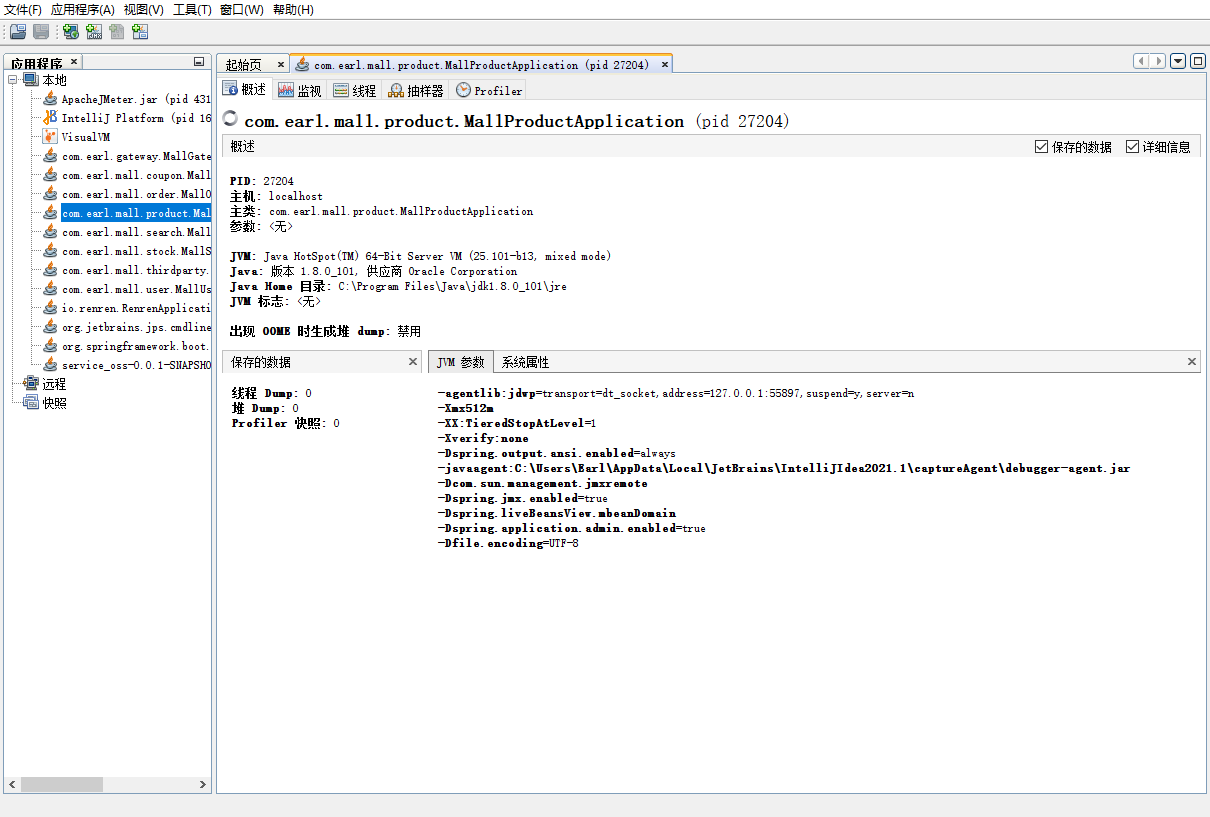

Jvisualvm

-

jvisualvm的使用

-

安装了java环境直接在CMD窗口使用命令

jvisualvm启动,弹幕说IDEA可以安装VisualVM Launcher插件,启动后选择连接目标进程,注意Java8以后不再自带jvisualvm -

概述面板显示了JVM参数和系统变量属性

-

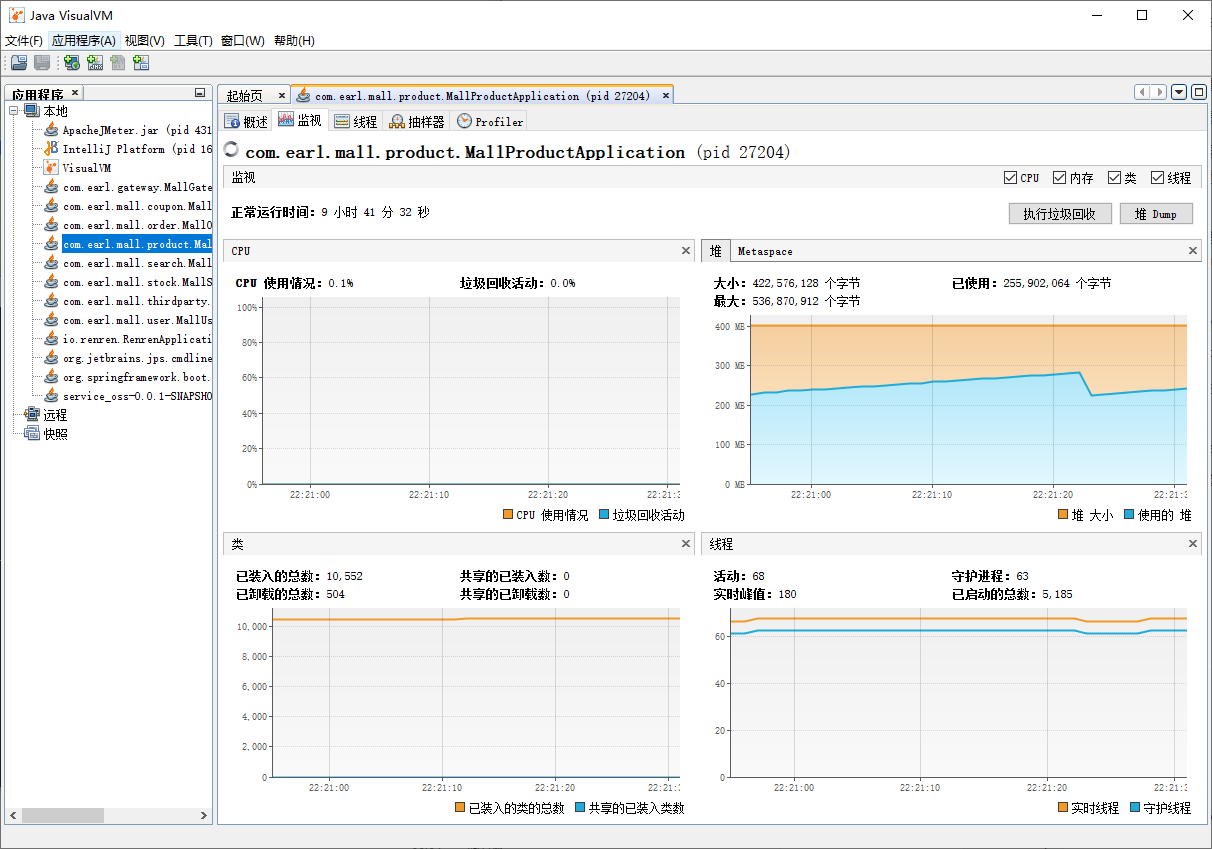

监视面板显示CPU信息、堆内存信息、线程数,已装载类

- 压测期间需要观察已经使用的堆空间和已经使用的堆空间大小,线程情况和CPU情况,来观察当前应用到底是局限在CPU的计算上,还是内存经常容易满,还是线程数不够导致运行太慢等等,像下图CPU的使用了一直维持个位数的使用率,说明CPU太闲了

-

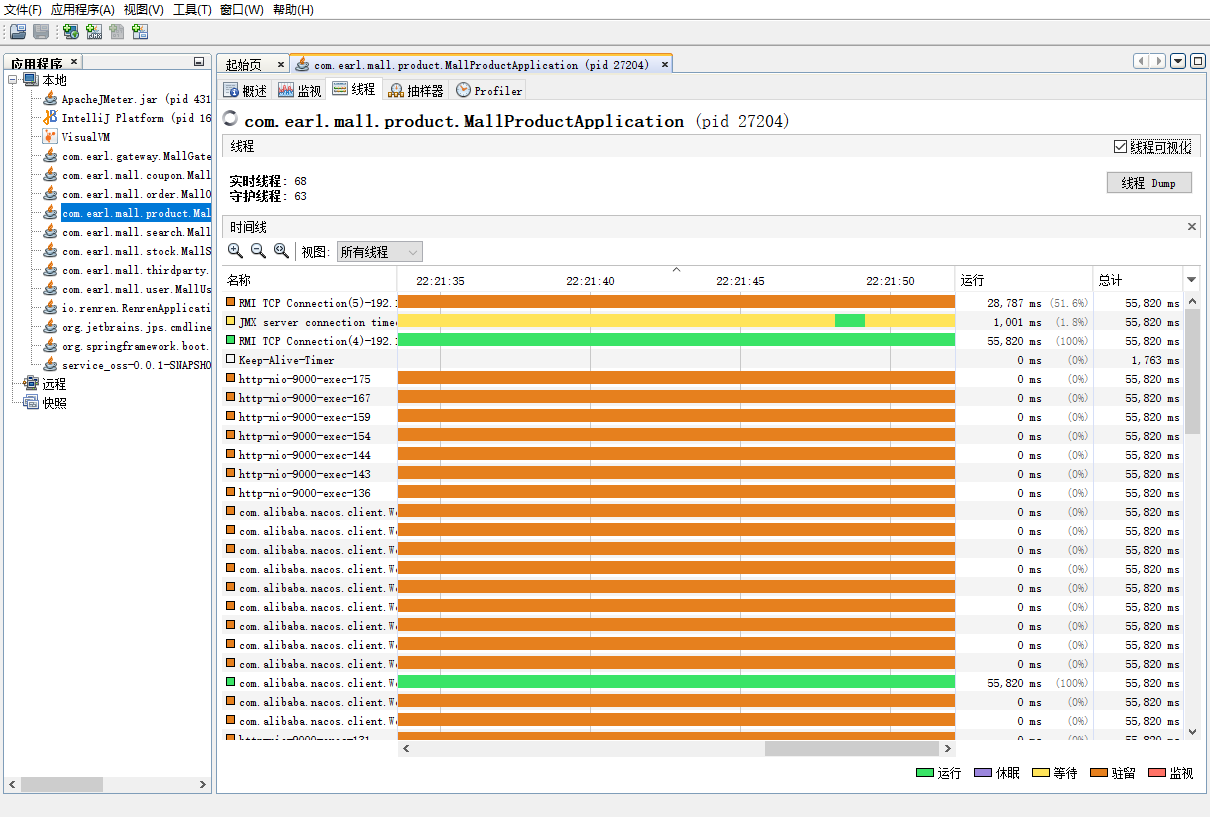

线程面板显示线程的具体信息,还展示当前线程是在运行、休眠【休眠状态是调用了sleep方法的线程】、等待【等待是调用了wait方法的线程】、驻留【线程池中等待接收新任务的空闲线程】以及监视【监视的意思是两个线程发生了锁的竞争,当前线程正在进行等待锁】

-

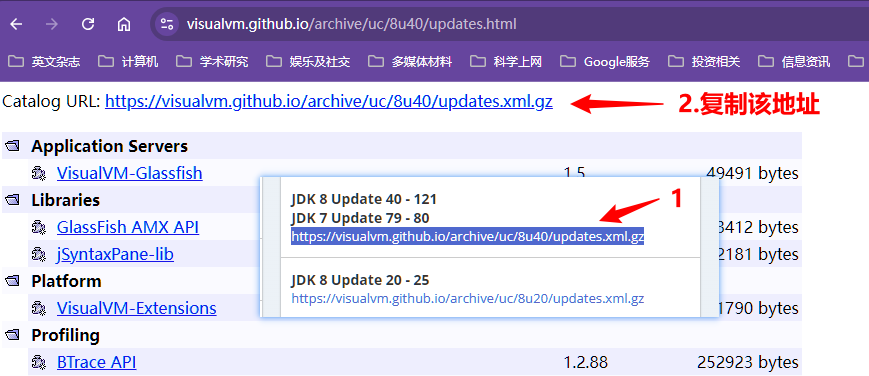

项目中还需要监控内存的垃圾回收等信息,jvisualvm默认是不带该功能的,需要安装插件,点击工具–插件,点击可用插件–检查最新版本来测试是否报错无法连接到VisualVM插件中心,如果报错,原因是需要指定插件中心的版本【修改插件中心的地址】,按照以下方式解决

-

打开插件中心的网址

https://visualvm.github.io/pluginscenters.html -

使用命令

java -version查看本机的jdk版本java version "1.8.0_101",重点关注小版本号101 -

在插件中心的网址中找到小版本所在对应的版本号区间,拷贝对应版本区间的插件更新地址【点进该地址,复制页面最顶上的地址】

-

在jvisualvm中点击设置–编辑Java VisualVM插件中心,将地址粘贴到弹出框的URL栏中,点击确定后会自动进行更新

-

此时就可以直接使用可用插件菜单的插件了,安装不来用个梯子,因为github有可能连不上

-

-

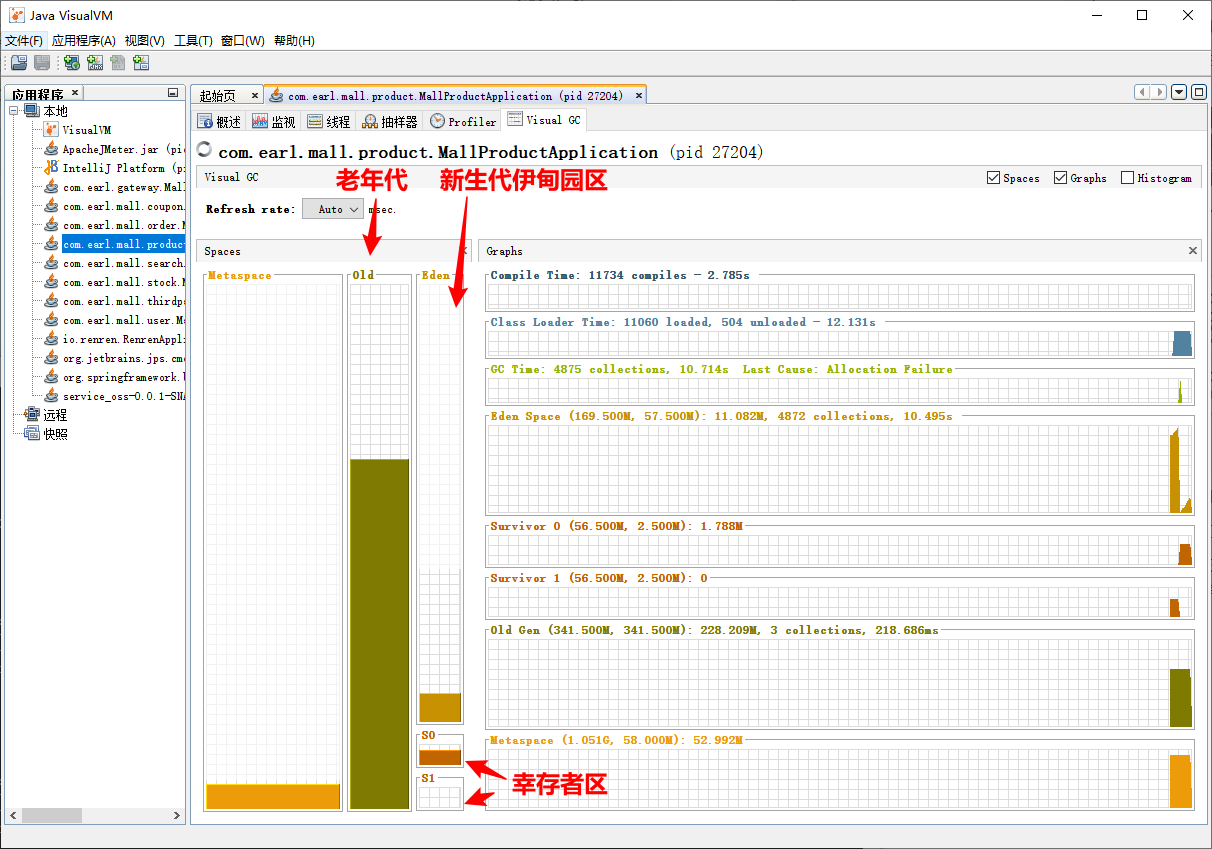

在可用插件中选择插件VisualVM GC,通过该插件可以观察到垃圾回收的过程,点击安装,安装完点击文件–退出,重启jvisualvm,面板会多出一个Visual GC面板,其中Old表示老年代,右边的表示新生代【最上面是伊甸园区、下面是两个幸存者区】

-

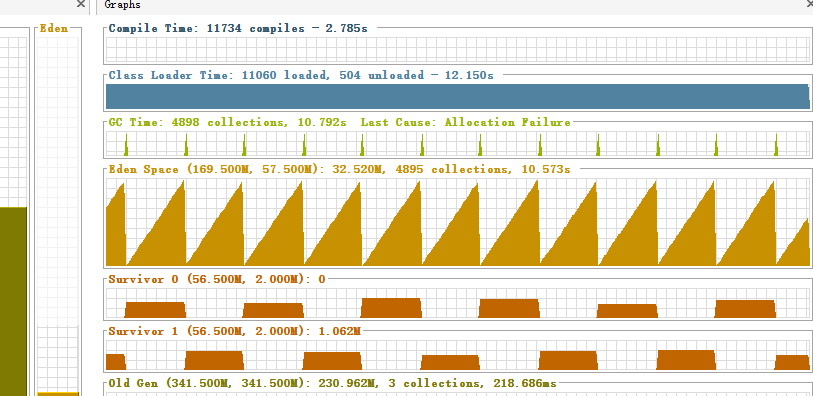

GC Time 4875 collections表示总共GC的次数为4875次,后面跟的是GC花费的总时间10.714s

-

Eden Space中是4872次GC,耗时10.495s,单次约2.15毫秒,下面的图标显示的是内存用量的实时曲线,正常健康的曲线是如下图所示的类直角三角形曲线,意味着伊甸园区的内存满了以后触发一次GC然后内存用量清零

-

Old Gen是老年代,是3次GC,耗时218.686毫秒,单次约72.9毫秒,性能远远低于YGC,因此线上一定要避免频繁地进行FGC,老年代内存缓慢增长,老年代满了以后执行一次FGC

-

Metaspace是元空间,是直接操作物理空间的,前面的数字是最大空间,后面的数字是当前用量,元空间的内存用量不需要关心

-

-

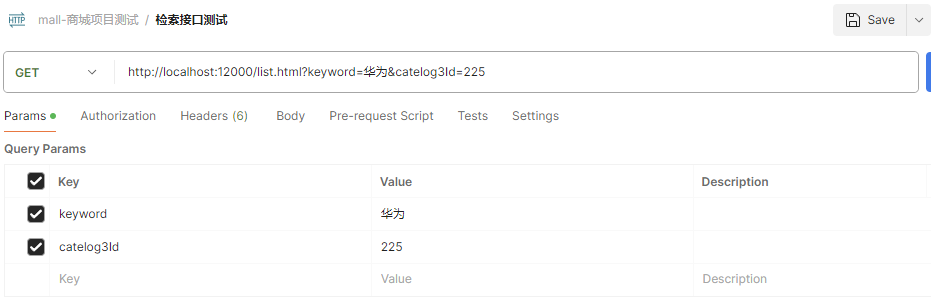

PostMan

-

请求路径带参数

Java生态

SpringBoot生态

MyBatisPlus

整合MyBatisPlus

-

引入依赖

<!--mybatisPlus--> <dependency> <groupId>com.baomidou</groupId> <artifactId>mybatis-plus-boot-starter</artifactId> <version>3.2.0</version> </dependency> -

引入mysql数据库驱动依赖

最好是对应mysql版本的mysql驱动,但是从中央仓库发现没有对应5.7.27的mysql驱动,官网给出的解释是mysql驱动5.1和8.0版本可以适配mysql5.6、5.7和8.0的所有版本,5.1兼容jre1.5、1.6、1.7、1.8,8.0只兼容jre1.8;官方推荐使用8.0版本的mysql驱动

<!--mysql驱动--> <dependency> <groupId>mysql</groupId> <artifactId>mysql-connector-java</artifactId> <version>8.0.17</version> </dependency> -

在

application.yml配置数据源信息Spring: datasource: username: root password: Haworthia0715 url: jdbc:mysql://192.168.56.10:3306?mall_pms driver-class-name: com.mysql.jdbc.Driver -

使用MyBatisPlus需要以下配置

-

启动类上添加注解

@MapperScan("com/earl/mall/product/dao")来告诉MybatisPlus该应用的相关Mapper接口位置实际该注解写在配置类上即可,接口写成Dao或者Mapper无所谓

@MapperScan("com/earl/mall/product/dao") @SpringBootApplication public class MallProductApplication { public static void main(String[] args) { SpringApplication.run(MallProductApplication.class, args); } } -

在配置文件

application.yml配置mybatis-plus.mapper-locations属性来告诉MybatisPlus该应用的相关SQL映射文件的位置默认配置就是

classpath*:/mapper/**/*.xml,classpath*的意思是不仅扫描当前类路径,连引入依赖的类路径下也一起扫描;如果只是classpath表示只扫描当前类路径下,不扫描引入依赖的类路径mybatis-plus: mapper-locations: classpath*:/mapper/**/*.xml

-

配置主键自增

在实体类的主键上有注解

@TableId,如下源码所示,该注解的自增属性默认是没有开启的,属性值为none如果只是在实体类的主键上设置主键类型只会对当前实体类对应的数据库表生效,如果不想每个表都设置一次,可以在配置文件通过属性值

mybatis-plus.global-config.db-config.id-type=auto来进行设置

@Documented

@Retention(RetentionPolicy.RUNTIME)

@Target({ElementType.FIELD})

public @interface TableId {

String value() default "";

//默认没有开启主键自增功能

IdType type() default IdType.NONE;

}

-

实体类的

@TableId注解@Data @TableName("pms_attr_attrgroup_relation") public class AttrAttrgroupRelationEntity implements Serializable { private static final long serialVersionUID = 1L; /** * id */ @TableId private Long id; /** * 属性id */ private Long attrId; /** * 属性分组id */ private Long attrGroupId; /** * 属性组内排序 */ private Integer attrSort; } -

相关的IdType属性值

0或者AUTO是自增主键

@Getter public enum IdType { /** * 数据库ID自增 */ AUTO(0), /** * 该类型为未设置主键类型(注解里等于跟随全局,全局里约等于 INPUT) */ NONE(1), /** * 用户输入ID * <p>该类型可以通过自己注册自动填充插件进行填充</p> */ INPUT(2), /* 以下3种类型、只有当插入对象ID 为空,才自动填充。 */ /** * 分配ID (主键类型为number或string), * 默认实现类 {@link com.baomidou.mybatisplus.core.incrementer.DefaultIdentifierGenerator}(雪花算法) * * @since 3.3.0 */ ASSIGN_ID(3), /** * 分配UUID (主键类型为 string) * 默认实现类 {@link com.baomidou.mybatisplus.core.incrementer.DefaultIdentifierGenerator}(UUID.replace("-","")) */ ASSIGN_UUID(4), /** * @deprecated 3.3.0 please use {@link #ASSIGN_ID} */ @Deprecated ID_WORKER(3), /** * @deprecated 3.3.0 please use {@link #ASSIGN_ID} */ @Deprecated ID_WORKER_STR(3), /** * @deprecated 3.3.0 please use {@link #ASSIGN_UUID} */ @Deprecated UUID(4); private final int key; IdType(int key) { this.key = key; } } -

配置该应用中所有的实体类主键自增

mybatis-plus: global-config: db-config: id-type: auto

排除数据源自动配置

如果基础环境引入了数据库配置需要在微服务中配置数据源,但是有些微服务如网关不需要配置数据库,此时方法一是在子pom文件中排除引入的数据库依赖,方法二是在启动类上的

@SpringBootApplication注解的exclude属性配置排除DatasourceAutoConfiguration.class

-

方法1实现

在子pom文件中排除引入的数据库依赖

<dependency> <groupId>com.earl.mall</groupId> <artifactId>mall-common</artifactId> <version>0.0.1-SNAPSHOT</version> <exclusions> <exclusion> <groupId>com.baomidou</groupId> <artifactId>mybatis-plus-boot-starter</artifactId> </exclusion> </exclusions> </dependency> -

方法2实现

在启动类上的

@SpringBootApplication注解的exclude属性配置排除DatasourceAutoConfiguration.class@EnableDiscoveryClient @SpringBootApplication(exclude = {DataSourceAutoConfiguration.class}) public class MallGatewayApplication { public static void main(String[] args) { SpringApplication.run(MallGatewayApplication.class, args); } }

配置逻辑删除

mybatisplus的逻辑删除是更新操作,根据id和对应的逻辑删除字段将逻辑存在的指定id的记录的逻辑删除字段改成逻辑删除

配置了逻辑删除查询操作也会自动变成查询满足条件且逻辑删除字段为逻辑未删除的记录

-

在对应模块的application.yml文件中配置逻辑删除字段值

和默认配置相同可省略

#mybatisplus逻辑删除配置,这是统一的全局配置,该配置就默认配置,如果配置和默认配置相同可以不写 #从mybatisPlus3.3.0以后要配置logic-delete-field属性了,这里是3.2.0不需要配置 #logic-delete-field: flag # 全局逻辑删除的实体字段名(since 3.3.0,配置后可以忽略不配置步骤2) logic-delete-value: 1 # 逻辑已删除值(默认为 1) logic-not-delete-value: 0 # 逻辑未删除值(默认为 0) -

配置逻辑删除组件ISqlInjector并注入IOC容器

从MybatisPlus3.1.1开始不再需要配置该ISqlInjector组件,即高版本可省略

@Configuration public class MyBatisPlusConfiguration{ @Bean public ISqlInjector sqlInjector(){ return new LogicSqlInjector(); } } -

在实体类的逻辑删除标识字段上添加

@Tablelogic注解@Tablelogic注解内部有两个属性value和delval,分别表示代表逻辑未删除的字面值和逻辑删除的字面值,该属性值的默认值都为空字符串,为空字符串会自动获取全局配置,全局配置没有使用默认配置,如果不为空字符串就会优先使用该注解的配置来确定哪些值表示逻辑删除和逻辑未删除【

@Tablelogic注解】@Documented @Retention(RetentionPolicy.RUNTIME) @Target(ElementType.FIELD) public @interface TableLogic { /** * 默认逻辑未删除值(该值可无、会自动获取全局配置) */ String value() default ""; /** * 默认逻辑删除值(该值可无、会自动获取全局配置) */ String delval() default ""; }【配置实例】

@TableLogic(value = "1",delval = "0") private Integer showStatus;【执行的SQL语句】

==> Preparing: UPDATE pms_category SET show_status=0 WHERE cat_id IN ( ? ) AND show_status=1 ==> Parameters: 1432(Long) <== Updates: 1

打印SQL语句

SpringBoot调整日志级别配置打印MyBatisPlus的SQL语句

-

在应用的application.yml中配置MyBatisPlus日志级别

这样就能打印dao包下的MyBatisPlus的SQL执行语句

#将SpringBoot应用的com.earl.mall包下所有类的日志级别调整成DEBUG级别 logging: level: com.earl.mall: debug

renren分页查询处理

-

配置mp的分页插件

@Configuration //@EnableTransactionManagement开启事务 @EnableTransactionManagement @MapperScan("com.earl.mall.product.dao")//指定Mapper接口的位置 public class MPPagePluginConfig { @Bean//引入分页插件 public PaginationInterceptor paginationInterceptor(){ PaginationInterceptor paginationInterceptor = new PaginationInterceptor(); //设置请求页码大于最后一页的操作,true表示调回到首页,false表示继续请求,默认为false paginationInterceptor.setOverflow(true); //设置最大单页限制数量,默认为500条,设置为-1表示不受限制 paginationInterceptor.setLimit(1000); return paginationInterceptor; } } -

分页相关工具类

-

分页参数处理

/** * Copyright (c) 2016-2019 人人开源 All rights reserved. * * https://www.renren.io * * 版权所有,侵权必究! */ package com.earl.common.utils; import com.baomidou.mybatisplus.core.metadata.IPage; import com.baomidou.mybatisplus.core.metadata.OrderItem; import com.baomidou.mybatisplus.extension.plugins.pagination.Page; import com.earl.common.xss.SQLFilter; import org.apache.commons.lang.StringUtils; import java.util.Map; /** * 查询参数 * * @author Mark sunlightcs@gmail.com */ public class Query<T> { public IPage<T> getPage(Map<String, Object> params) { return this.getPage(params, null, false); } public IPage<T> getPage(Map<String, Object> params, String defaultOrderField, boolean isAsc) { //分页参数 long curPage = 1; long limit = 10; if(params.get(Constant.PAGE) != null){ curPage = Long.parseLong((String)params.get(Constant.PAGE)); } if(params.get(Constant.LIMIT) != null){ limit = Long.parseLong((String)params.get(Constant.LIMIT)); } //分页对象 Page<T> page = new Page<>(curPage, limit); //分页参数 params.put(Constant.PAGE, page); //排序字段 //防止SQL注入(因为sidx、order是通过拼接SQL实现排序的,会有SQL注入风险) String orderField = SQLFilter.sqlInject((String)params.get(Constant.ORDER_FIELD)); String order = (String)params.get(Constant.ORDER); //前端字段排序 if(StringUtils.isNotEmpty(orderField) && StringUtils.isNotEmpty(order)){ if(Constant.ASC.equalsIgnoreCase(order)) { return page.addOrder(OrderItem.asc(orderField)); }else { return page.addOrder(OrderItem.desc(orderField)); } } //没有排序字段,则不排序 if(StringUtils.isBlank(defaultOrderField)){ return page; } //默认排序 if(isAsc) { page.addOrder(OrderItem.asc(defaultOrderField)); }else { page.addOrder(OrderItem.desc(defaultOrderField)); } return page; } } -

Query中自定义工具类

SQLFilter/** * Copyright (c) 2016-2019 人人开源 All rights reserved. * * https://www.renren.io * * 版权所有,侵权必究! */ package com.earl.common.xss; import com.earl.common.exceptions.RRException; import org.apache.commons.lang.StringUtils; /** * SQL过滤 * * @author Mark sunlightcs@gmail.com */ public class SQLFilter { /** * SQL注入过滤 * @param str 待验证的字符串 */ public static String sqlInject(String str){ if(StringUtils.isBlank(str)){ return null; } //去掉'|"|;|\字符 str = StringUtils.replace(str, "'", ""); str = StringUtils.replace(str, "\"", ""); str = StringUtils.replace(str, ";", ""); str = StringUtils.replace(str, "\\", ""); //转换成小写 str = str.toLowerCase(); //非法字符 String[] keywords = {"master", "truncate", "insert", "select", "delete", "update", "declare", "alter", "drop"}; //判断是否包含非法字符 for(String keyword : keywords){ if(str.indexOf(keyword) != -1){ throw new RRException("包含非法字符"); } } return str; } } -

涉及自定义异常类

/** * Copyright (c) 2016-2019 人人开源 All rights reserved. * * https://www.renren.io * * 版权所有,侵权必究! */ package com.earl.common.exceptions; /** * 自定义异常 * * @author Mark sunlightcs@gmail.com */ public class RRException extends RuntimeException { private static final long serialVersionUID = 1L; private String msg; private int code = 500; public RRException(String msg) { super(msg); this.msg = msg; } public RRException(String msg, Throwable e) { super(msg, e); this.msg = msg; } public RRException(String msg, int code) { super(msg); this.msg = msg; this.code = code; } public RRException(String msg, int code, Throwable e) { super(msg, e); this.msg = msg; this.code = code; } public String getMsg() { return msg; } public void setMsg(String msg) { this.msg = msg; } public int getCode() { return code; } public void setCode(int code) { this.code = code; } } -

分页数据封装工具类

/** * Copyright (c) 2016-2019 人人开源 All rights reserved. * * https://www.renren.io * * 版权所有,侵权必究! */ package com.earl.common.utils; import com.baomidou.mybatisplus.core.metadata.IPage; import java.io.Serializable; import java.util.List; /** * 分页工具类 * * @author Mark sunlightcs@gmail.com */ public class PageUtils implements Serializable { private static final long serialVersionUID = 1L; /** * 总记录数 */ private int totalCount; /** * 每页记录数 */ private int pageSize; /** * 总页数 */ private int totalPage; /** * 当前页数 */ private int currPage; /** * 列表数据 */ private List<?> list; /** * 分页 * @param list 列表数据 * @param totalCount 总记录数 * @param pageSize 每页记录数 * @param currPage 当前页数 */ public PageUtils(List<?> list, int totalCount, int pageSize, int currPage) { this.list = list; this.totalCount = totalCount; this.pageSize = pageSize; this.currPage = currPage; this.totalPage = (int)Math.ceil((double)totalCount/pageSize); } /** * 分页 */ public PageUtils(IPage<?> page) { this.list = page.getRecords(); this.totalCount = (int)page.getTotal(); this.pageSize = (int)page.getSize(); this.currPage = (int)page.getCurrent(); this.totalPage = (int)page.getPages(); } public int getTotalCount() { return totalCount; } public void setTotalCount(int totalCount) { this.totalCount = totalCount; } public int getPageSize() { return pageSize; } public void setPageSize(int pageSize) { this.pageSize = pageSize; } public int getTotalPage() { return totalPage; } public void setTotalPage(int totalPage) { this.totalPage = totalPage; } public int getCurrPage() { return currPage; } public void setCurrPage(int currPage) { this.currPage = currPage; } public List<?> getList() { return list; } public void setList(List<?> list) { this.list = list; } }

-

-

分页查询的使用方法

-

参数格式

不需要的比如排序字段、排序方式、key等属性可以不写

{ page: 1,//当前页码 limit: 10,//每页记录数 sidx: 'id',//排序字段 order: 'asc/desc',//排序方式 key: '华为'//检索关键字 } -

查询方式

【控制器方法】

/** * @param params * @param catelogId * @return {@link R } * @描述 根据商品分类id查询属性分组 ,@RequestParam注解能获取到get请求请求路径中的参数并封装对对应名字的参数中,如果是Map, * 会将参数封装到Map集合中 * @author Earl * @version 1.0.0 * @创建日期 2024/02/29 * @since 1.0.0 */ @RequestMapping("/list/{catelogId}") //@RequiresPermissions("product:attrgroup:list") public R list(@RequestParam Map<String, Object> params, @PathVariable("catelogId") Long catelogId){ PageUtils page = attrGroupService.queryPage(params,catelogId); return R.ok().put("page", page); }【分页查询代码】

/** * @param params * @param catelogId * @return {@link PageUtils } * @描述 分页查询请求的参数中有一个key字段,key字段就是检索关键字,分页查询参数和key都是连接在请求url后的, * 这个key是renren-generator封装在自动生成的前端列表组件中的搜索框的,因为这个搜索框只有一个,想要尽可能多的展示 * 数据,需要对该key进行模糊匹配 * 带搜索框的查询条件为select * from pms_attr_group where catelog_id=? and (attr_group_id=key or * attr_group_name like %key% * 即查询属性分组表中商品分类id为指定值且属性分组id为搜索框内容或者属性分组的名字模糊匹配搜素内容的属性分组 * Spring中有一个工具类StringUtils.isEmpty(str)方法能判断str是否空字符串,自5.3版本起,isEmpty(Object)已建议弃用, * 使用hasLength(String)或hasText(String)替代。 * QueryWrapper的and方法可以接受函数式接口Consumer,自动传参QueryWrapper,可以在函数式接口中连续添加查询条件 * @author Earl * @version 1.0.0 * @创建日期 2024/02/29 * @since 1.0.0 */ @Override public PageUtils queryPage(Map<String, Object> params, Long catelogId) { QueryWrapper<AttrGroupEntity> wrapper = new QueryWrapper<AttrGroupEntity>(); String key = (String) params.get("key"); if (StringUtils.hasLength(key)) { wrapper.and(obj->{ obj.eq("attr_group_id",key). or().like("attr_group_name",key) .or().like("descript",key) ; }); } if(catelogId!=0){ wrapper.eq("catelog_id", catelogId); } IPage<AttrGroupEntity> page = this.page( new Query<AttrGroupEntity>().getPage(params), wrapper ); return new PageUtils(page); } -

响应结果格式

{ "msg": "success", "code": 0, "page": { "totalCount": 0, "pageSize": 10, "totalPage": 0, "currPage": 1, "list": [{ "attrGroupId": 0, //分组id "attrGroupName": "string", //分组名 "catelogId": 0, //所属分类 "descript": "string", //描述 "icon": "string", //图标 "sort": 0 //排序 "catelogPath": [2,45,225] //分类完整路径 }] } }

-

-

将查询列表数据处理成自定义封装的列表数据

-

实例

/** * @param params * @return {@link PageUtils } * @描述 带条件分页查询所有属性和属性关联的属性分组和商品分类名称 * 从page中取出数据二次封装以后传递个PageUtils的list属性 * @author Earl * @version 1.0.0 * @创建日期 2024/03/05 * @since 1.0.0 */ @Override public PageUtils queryPage(Map<String, Object> params,Long catelogId) { String key = (String) params.get("key"); QueryWrapper<AttrEntity> wrapper = new QueryWrapper<>(); if (StringUtils.hasLength(key)){ wrapper.and(obj->{ obj.eq("attr_id",key).or().like("attr_name",key); }); } if(catelogId!=0){ wrapper.eq("catelog_id",catelogId); } IPage<AttrEntity> page = this.page( new Query<AttrEntity>().getPage(params), wrapper ); PageUtils pageUtils = new PageUtils(page); //将分页数据从page中取出来再加工 List<AttrListVo> responseVo = page.getRecords().stream().map(attrEntity -> { AttrListVo attrListVo = new AttrListVo(); BeanUtils.copyProperties(attrEntity, attrListVo); AttrAttrgroupRelationEntity relation = attrAttrgroupRelationService.getOne(new QueryWrapper<AttrAttrgroupRelationEntity>().eq("attr_id", attrEntity.getAttrId())); if (relation != null && relation.getAttrGroupId() != null) { attrListVo.setGroupName(attrGroupDao.selectById(relation.getAttrGroupId()).getAttrGroupName()); } if (attrEntity.getCatelogId() != null) { attrListVo.setCatelogName(categoryDao.selectById(attrEntity.getCatelogId()).getName()); } return attrListVo; }).collect(Collectors.toList()); pageUtils.setList(responseVo); return pageUtils; }

-

事务

-

在配置类上使用注解

@EnableTransactionManagement开启事务只有在配置类上使用了该注解才能在需要控制事务的方法上使用

@Transactional注解控制事务@Configuration //@EnableTransactionManagement开启事务 @EnableTransactionManagement @MapperScan("com.earl.mall.product.dao")//指定Mapper接口的位置 public class MPPagePluginConfig { @Bean//引入分页插件 public PaginationInterceptor paginationInterceptor(){ PaginationInterceptor paginationInterceptor = new PaginationInterceptor(); //设置请求页码大于最后一页的操作,true表示调回到首页,false表示继续请求,默认为false paginationInterceptor.setOverflow(true); //设置最大单页限制数量,默认为500条,设置为-1表示不受限制 paginationInterceptor.setLimit(1000); return paginationInterceptor; } } -

在目标方法上使用注解

@Transactional控制操作的事务@Override @Transactional public void updateRelatedData(BrandEntity brand) { this.updateById(brand); if(StringUtils.hasLength(brand.getName())){ categoryBrandRelationService.updateBrandNameByBrandId(brand.getBrandId(),brand.getName()); } //TODO 品牌名称更新时更新相应的冗余数据 }

配置自动填充字段

-

向Spring容器注入组件

-

代码实例

/** * @author Earl * @version 1.0.0 * @描述 Mp的字段自动填充组件 * @创建日期 2024/03/27 * @since 1.0.0 */ @Component public class MyMetaObjectHandler implements MetaObjectHandler { /** * @param metaObject * @描述 设置生成记录时需要自动填充的字段 * @author Earl * @version 1.0.0 * @创建日期 2024/03/27 * @since 1.0.0 */ @Override public void insertFill(MetaObject metaObject) { this.setFieldValByName("createTime", new Date(), metaObject); this.setFieldValByName("updateTime", new Date(), metaObject); } /** * @param metaObject * @描述 设置更新记录时需要自动填充的字段 * @author Earl * @version 1.0.0 * @创建日期 2024/03/27 * @since 1.0.0 */ @Override public void updateFill(MetaObject metaObject) { this.setFieldValByName("updateTime", new Date(), metaObject); } }

-

-

在实体类指定字段上设置填充策略

-

配置实例

@Data @TableName("pms_spu_info") public class SpuInfoEntity implements Serializable { private static final long serialVersionUID = 1L; /** * 商品id */ @TableId private Long id; /** * 商品名称 */ private String spuName; /** * 商品描述 */ private String spuDescription; /** * 所属分类id */ private Long catelogId; /** * 品牌id */ private Long brandId; /** * 商品重量 */ private BigDecimal weight; /** * 上架状态[0 - 下架,1 - 上架] */ private Integer publishStatus; /** * 记录创建时间 */ @TableField(fill = FieldFill.INSERT) private Date createTime; /** * 记录更新时间 */ @TableField(fill = FieldFill.INSERT_UPDATE) private Date updateTime; }

-

Junit

-

引入Junit依赖

非maven项目引入junit依赖需要在本地仓库找到junit.junit-4.12和org.hamcrest.hamcrest-core-1.3,同时导入才不会报错,同时需要添加测试目录才能生效

-

Junit依赖

junit的依赖已经被spring-boot-starter-test依赖了

<dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> -

单元测试格式

注意,没有

@RunWith(SpringRunner.class)老版本的SpringBoot涉及到自动注入的对象就会报空指针异常,新版本的SpringBoot单元测试没有这个注解@RunWith(SpringRunner.class)//指定使用Spring的驱动来跑单元测试,这是老版本SpringBoot的写法,新版本已经不这么写了 @SpringBootTest public class MallProductApplicationTests { @Autowired BrandService brandService; @Test public void contextLoads() { BrandEntity brandEntity = new BrandEntity(); brandEntity.setName("华为"); System.out.println(brandService.save(brandEntity)); } } -

异常情况

在IDEA使用默认的SpringBoot初始化工具初始化的项目可能单元测试是以下结构

这种结构在更换SpringBoot和SpringCloud的版本后无法直接进行单元测试,需要添加注解

@RunWith(SpringRunner.class)和将测试类和方法上添加public前缀@SpringBootTest class MallOrderApplicationTests { @Test void contextLoads() { } }

-

Lombok

- 使用Lombok需要添加对应的Lombok依赖,而且IDEA需要安装Lombok插件,作用是简化JavaBean开发

-

依赖导入

<!--lombok--> <dependency> <groupId>org.projectlombok</groupId> <artifactId>lombok</artifactId> <version>1.18.8</version> </dependency> -

API详解

@Data:在程序编译的时候自动为标注了@Data注解的实体类的所有非final字段添加@setter、@AllArgsConstructor、@NoArgsConstructor注解、为所有字段添加@ToString、@EqualsAndHashCode注解、@Getter注解@TableName("pms_attr"):标注当前实体类对应的数据库表名@NoArgsConstructor:为当前实体类填充无参构造方法@AllArgsConstructor:为当前实体类填充全参构造方法@ToString:重写当前实体类的toString方法@Getter:自动生成Getter方法@Setter:自动生成Setter方法

-

用法综合示例

import lombok.AllArgsConstructor; import lombok.Data; import lombok.NoArgsConstructor; import lombok.ToString; @Data//为属性自动填充getter和setter方法 @NoArgsConstructor//无参构造 @AllArgsConstructor//全参构造 @ToString//重写实体类的toString方法 public class Product { private Long id;//商品唯一标识 private String title;//商品名称 private String category;//分类名称 private Double price;//商品价格 private String images;//图片地址 }

Logback

- 引入Logback依赖可以使用slf4j来打印日志,slf4j是接口,logback是该接口的一种实现

-

引入依赖

<dependency> <groupId>ch.qos.logback</groupId> <artifactId>logback-classic</artifactId> <version>1.2.3</version> </dependency> -

logback配置文件

logback.xml【类路径下】<?xml version="1.0" encoding="UTF-8"?> <configuration xmlns="http://ch.qos.logback/xml/ns/logback" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://ch.qos.logback/xml/ns/logback logback.xsd"> <appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender"> <encoder> <pattern>%date{HH:mm:ss} [%t] %logger - %m%n</pattern> </encoder> </appender> <logger name="c" level="debug" additivity="false"> <appender-ref ref="STDOUT"/> </logger> <root level="ERROR"> <appender-ref ref="STDOUT"/> </root> </configuration> -

常用API

@Slf4j(topic="c.Test2")- 标注该注解类中产生的日志都会在线程信息后面紧跟注解中的topic属性值,一般用作日志的记录位置区分标识

log.debug("{}",task.get());- log对象的日志函数中字符串中的大括号叫占位符,占位符的数据来自于后面紧跟着的参数,可以使用多个占位符和多个参数,依次按顺序填充

HttpCore

内含包

org.apache.httpcomponents,是Apache用java代码实现的使用java代码发送HTTP请求的一个工具类

<!--httpCore-->

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpcore</artifactId>

<version>4.4.12</version>

</dependency>

Servlet-api

在SpringBoot中使用Servlet相关的东西【如ServletRequest】需要在项目中引入依赖servlet-api,但是tomcat自带了servlet-api依赖,将scope改为provided,表示目标环境已经存在

<!--servlet-api-->

<dependency>

<groupId>javax.servlet</groupId>

<artifactId>servlet-api</artifactId>

<version>2.5</version>

<scope>provided</scope>

</dependency>

Commons-lang

- apache的

Commons-lang工具包,关注一下commons-lang包和commons-lang3包的不同

<!--commons-lang-->

<dependency>

<groupId>commons-lang</groupId>

<artifactId>commons-lang</artifactId>

<version>2.6</version>

</dependency>

gson

-

依赖引入

<dependency> <groupId>com.google.code.gson</groupId> <artifactId>gson</artifactId> <version>2.8.5</version> </dependency>

validation-api

validation-api是javax旗下的,引入后可以在项目中使用JSR303规范的数据校验功能以及自定义校验注解;在SpringBoot2.3.x以前是随web-starter的hibernate-validator一起引入的

-

依赖引入

<!--validation-api--> <dependency> <groupId>javax.validation</groupId> <artifactId>validation-api</artifactId> <version>2.0.1.Final</version> </dependency>

JSR303数据校验

-

使用JSR303【Java Specification Requests,即Java规范提案】,JSR303规定了数据校验的相关标准;

-

SpringBoot从2.3.x版本开始其中不再内置校验了,从依赖关系上来看SpringBoot的

web starter引入了校验注解相关的依赖hibernate-validator,包括javax.validation.contraints包也是hibernate-validator下的,高版本SpringBoot似乎不再包含该依赖了,注意甄别

基础校验

-

用法

- 通过在实体类的属性上使用校验注解来对数据指定校验规则

- 此外在

Controller中要在参数列表中参数前面使用@Valid注解进行标注,只在实体类上标注数据校验注解不在Controller中对应位置标注@Valid注解是不会主动对数据进行校验的 - 响应状态码是

400,提示Bad Request,说明服务端数据校验是不通过的,校验错误信息封装在响应数据的errors属性中,errors.defaultMessage是校验错误信息、errors.field是发生校验错误的属性、errors.rejectValue是发生校验错误的属性值,但是这个校验错误信息返回格式不规范,实际开发中都需要专门封装成统一响应格式返回 - 多个校验注解可以一起使用

-

常见数据校验相关的注解

这些注解全部可以在包

javax.validation.contraints下找到,具体含义看每个注解的注释,注释还规定了注解能放在哪些参数类型上-

@Email- 作用:被该注解标注的属性值必须是邮箱

-

@NotNull- 作用:被该注解标注的属性值不能为

null - 补充说明:该注解可以标注在任意类型的属性上

- 作用:被该注解标注的属性值不能为

-

@Future- 作用:被该注解标注的属性值必须是未来时间

-

@Min()-

作用:被该注解标注的属性值必须比

value属性的指定值大 -

配置实例:

@Min(value = 0,message = "排序数字必须大于等于0") private Integer sort;

-

-

@Max- 作用:被该注解标注的属性值必须比指定值小

-

@NotEmpty- 作用:被该注解标注的属性值不能为

null或者空字符串,但是可以是空格字符串 - 补充说明:

@NotEmpty只支持放在字符串、集合、Map和数组类型的属性上

- 作用:被该注解标注的属性值不能为

-

@Size- 作用:被该注解标注的属性值必须满足长度要求

-

@NotBlank- 作用:被该注解标注的属性值不能为null、空字符串、空格字符串,字符串至少包含一个非空格字符

-

@Pattern-

作用:自定义校验规则

-

补充说明:

- 该注解中有一个

regexp属性,需要写一个字符串正则表示式【注意正则表达式再Java中需要去掉两边的斜杠,经过本地测试有斜杠偶尔能成功,但是肯定会出问题】,通过正则表达式来指定自定义的校验规则; message属性仍然为校验错误的错误提示信息- 该注解不支持

Integer类型进行正则表达式校验,报错500 @Pattern注解仅支持有值情况下的正则表达式校验,值为null或者空字符串的情况下默认是校验正确的,注意啊,因为空值情况下有专门的非空注解来进行校验,所以基本上注解是不会对空值情况还进行相应的校验,也就是会默认校验正确,因为一个实体类针对不同的操作比如新增和修改可能涉及到指定多组校验,此时某些字段修改时可能会提交修改也可能不会提交修改,此时分组内的校验规则没指定非空校验,此时就会默认触发对应有值情况下需要校验的规则返回为正确,这样能同时实现空值情况下不进行入参校验【或者说空值默认校验结果为真】,有值的情况下严格执行入参校验规则

- 该注解中有一个

-

配置实例:

@Pattern(regexp = "/^[a-zA-Z]$/",message = "检索首字母必须是一个字母") private String firstLetter;

-

-

@Length-

作用:限定入参长度,

min属性限定入参长度最小值,max属性限定入参长度最大值 -

配置实例:

-

-

-

第三方校验注解

@URL- 作用:被该注解标注的属性值必须为一个

url,入参该参数为空会默认不进行校验 - 补充说明:这个注解是

org.hibernate.validator.constraint包提供的,是hibernate对JSR303的额外实现,从依赖关系上来看SpringBoot的web starter引入了校验注解相关的依赖hibernate-validator,包括javax.validation.contraints包也是hibernate-validator下的,高版本SpringBoot似乎不再包含该依赖了,注意甄别

- 作用:被该注解标注的属性值必须为一个

-

自定义返回服务端校验错误信息

-

每个校验规则中都有一个message属性,如果没有自定义message信息就会默认使用

ValidationMessage.properties文件中的对应校验错误的message消息,中文地区会使用ValidationMessage_zh_CN.properties文件中的校验错误信息对默认消息不满意就自己指定校验注解的message信息

-

自定义校验信息响应格式

-

在被校验的Bean参数后面紧跟

BindingResult类型的参数,SpringBoot会自动将校验结果封装到该对象中, -

该

bindingResult对象的hasErrors布尔类型属性中封装了本次校验的结果,如果为true表示校验失败,为false表示校验成功 -

可以从

bindingResult中获取到错误的信息,封装成一个Map进行返回,校验错误信息封装见以下示例- 注意写了

bindingResult,校验异常会被自动处理,将错误信息封装到bindingResult,这种情况是不会抛校验异常的;不写bindingResult出现异常是会抛异常信息的,每个控制器方法中都写校验错误处理代码显得太冗余,使用全局异常专门处理校验异常能省去很多冗余代码 - 弹幕说会有重复key的问题,同一个属性上使用俩个验证的话,任何一项不满足,

BindingResult中会封装两个fieldError对象,但是这两个对象的field属性是相同的,但是defaultMessage属性分别是两个校验注解校验错误的对应提示信息,封装到Map中就会出现一个重复key不同value的情况

@RequestMapping("/save") public R save(@Valid @RequestBody BrandEntity brand, BindingResult bindingResult){ if(bindingResult.hasErrors()){ //1. 准备封装错误校验信息的容器 Map<String,String> bingErrors = new HashMap<>(); //2. 获取所有的错误校验结果并封装进Map bindingResult.getFieldErrors().forEach(item->{ //获取校验错误的属性名字 String field = item.getField(); //获取对应错误属性的错误校验信息 String msg = item.getDefaultMessage(); bingErrors.put(field,msg); }); return R.error(400,"提交的数据不合法").put("data",bingErrors); }else{ brandService.save(brand); } return R.ok(); } - 注意写了

-

-

-

自定义校验处理全局统一处理

使用

@ControllerAdvice+@ExceptionHandler的方式定义全局的数据校验异常处理,注意有全局参数校验异常处理的前提下,在控制器方法中对异常进行了捕获是不会触发这个全局异常的,即数据校验个别方法还可以通过控制器方法捕获的方式进行个性化处理-

实例

@Slf4j //@ResponseBody //@ControllerAdvice(basePackages = "com.earl.mall.product.controller") @RestControllerAdvice(basePackages = "com.earl.mall.product.controller") public class MallControllerExceptionHandler { @ExceptionHandler(MethodArgumentNotValidException.class) public R handleValidException(MethodArgumentNotValidException e){ //特定异常类型可以通过发生异常后对应异常的getClass方法获取 log.error("数据校验错误:{},异常类型:{}",e.getMessage(),e.getClass()); //1. bindingResult可以通过e.getBindingResult()获取 BindingResult bindingResult = e.getBindingResult(); //1. 准备封装错误校验信息的容器 Map<String,String> bingErrors = new HashMap<>(); //2. 获取所有的错误校验结果并封装进Map bindingResult.getFieldErrors().forEach(item->{ //获取错误属性名字 String field = item.getField(); //获取对应错误属性的错误校验信息 String msg = item.getDefaultMessage(); bingErrors.put(field,msg); }); //StatusCode.VALID_EXCEPTION是自定义异常枚举类型 return R.error(StatusCode.VALID_EXCEPTION.getCode(), StatusCode.VALID_EXCEPTION.getMsg()).put("data",bingErrors); } }

-

分组校验

-

校验注解分组

对于一个品牌实体类,新增品牌和修改品牌的参数很可能是不一样的,比如新增不需要携带品牌ID,但是修改必须要带品牌ID、新增品牌和修改品牌时品牌名都不能为空。但是此时实体类的校验规则只有一套,此时就需要使用JSR303分组校验功能

-

每一种校验注解都有一个

groups属性,group属性是一个接口【Classs<?>】数组,这个接口是自定义的接口,比如在包valid下创建两个接口AddGroup和UpdateGroup,这是两个空接口,标注在不同的校验注解中分别表示在新增的时候才调用新增的校验,修改的时候才调用修改的校验,只是作为一种校验组合的区分在控制器方法中进行区分 -

如果一个校验规则新增和修改都需要校验,则在group属性同时指定

AddGroup和UpdateGroup两个接口 -

实例:

/** * 品牌 * * @author Earl * @email 18794830715@163.com * @date 2024-01-27 08:45:26 */ @Data @TableName("pms_brand") public class BrandEntity implements Serializable { private static final long serialVersionUID = 1L; /** * 品牌id */ @TableId @NotNull(message = "品牌ID不能为空",groups = {UpdateGroup.class}) private Long brandId; /** * 品牌名 */ @NotBlank(message = "必须填写品牌名",groups = {AddGroup.class,UpdateGroup.class}) private String name; /** * 品牌logo地址 */ @URL(message = "请输入合法的logo地址",groups = {AddGroup.class,UpdateGroup.class}) @NotBlank(groups = {AddGroup.class}) private String logo; /** * 介绍 */ private String descript; /** * 显示状态[0-不显示;1-显示] */ @ListValue(vals={0,1},groups = {AddGroup.class,UpdateGroup.class, UpdateSingleFieldGroup.class}) @NotNull(groups = {AddGroup.class,UpdateGroup.class}) private Integer showStatus; /** * 检索首字母 */ @NotBlank(groups = {AddGroup.class}) @Pattern(regexp = "^[a-zA-Z]$",message = "检索首字母必须是一个字母",groups = {AddGroup.class,UpdateGroup.class}) private String firstLetter; /** * 排序 */ @Min(value = 0,message = "排序数字必须大于等于0",groups = {AddGroup.class,UpdateGroup.class}) @NotNull(groups = {AddGroup.class}) private Integer sort; }

-

-

分组校验的使用

制定好校验规则后在控制器方法中将原来validation中的校验注解换成spring框架提供的

@Validated注解,该注解中的value属性也是接口数组,即在其中指定校验分组,用来实现多场景情况下的复杂校验-

🔎:

@validated如果指定了分组,那么Bean中只校验属于该分组注解标注的值是否合法,没有指定分组的注解不会进行校验,如果@validated没有标注group,就会校验bean中所有没有分组的校验注解,此时被分组的注解反而不会生效 -

🔎:因为空值情况下有专门的非空注解来进行校验,所以基本上注解是不会对空值情况还进行相应的校验,也就是会默认校验正确,因为一个实体类针对不同的操作比如新增和修改可能涉及到指定多组校验,此时某些字段修改时可能会提交修改也可能不会提交修改,此时分组内的校验规则没指定非空校验,此时就会默认触发对应有值情况下需要校验的规则返回为正确,这样能同时实现空值情况下不进行入参校验【或者说空值默认校验结果为真】,有值的情况下严格执行入参校验规则

-

实例:

@RequestMapping("/save") //@RequiresPermissions("product:brand:save") public R save(@Validated(AddGroup.class) @RequestBody BrandEntity brand){ brandService.save(brand); return R.ok(); } @RequestMapping("/update") //@RequiresPermissions("product:brand:update") public R update(@Validated(UpdateGroup.class) @RequestBody BrandEntity brand){ brandService.updateById(brand); return R.ok(); }

-

自定义校验注解

现有的校验注解可能无法满足需求,比如校验排序字段必须为非负整数,此时能想到使用

@Pattern注解使用正则表达式对字段进行校验,但是该字段类型为Integer类型,@Pattern注解不能使用在Integer类型上【正则只能校验字符串】,此时就需要考虑使用自定义校验注解了自定义校验的实现需要三步:编写一个自定义校验注解,编写一个自定义检验器,关联自定义校验器和自定义校验注解

-

自定义校验注解要求

-

一个自定义校验注解必须满足JSR303规范,必须包含3个属性

message、groups、payload- message是校验出错以后的默认提示消息去哪儿获取

- groups是注解必须支持分组校验功能

- payload是自定义校验注解还可以自定义一些负载信息

-

自定义校验注解必须标注指定的元信息数据【标注指定的注解并配置源信息数据】

-

@Target({METHOD,FIELD,ANNOTATION_TYPE,CONSTRACTOR,PARAMTER,TYPE_USE})@Target注解指定该注解可以标注的位置 -

@Retention(RUNTIME)@Retention(RUNTIME)指定该注解运行时可被获取 -

Constraint(validatedBy={})Constraint(validatedBy={})指定该注解关联的校验器,这个地方不指定就需要在系统初始化的时候进行指定 -

@Repeatable(List.calss)@Repeatable(List.calss)表示该注解是一个可重复注解 -

@Documented

-

-

-

自定义校验注解实例

自定义校验注解

@Documented // validatedBy要指定一个ConstraintValidator的子类数组,我们可以指定自定义校验器, // 以自定义校验器ListValueConstraintValidator为例 // 一个校验器只能适配一种参数类型,如果还需要适配其他参数类型,需要再定义一个校验器,并在同一个自定义校验注解使用validatedBy属性 // 进行多个校验器的关联,校验注解会自动根据注解标注参数的类型自动地选出对应类型的校验器进行校验 @Constraint( validatedBy = {ListValueConstraintValidator.class} ) @Target({ElementType.METHOD, ElementType.FIELD, ElementType.ANNOTATION_TYPE, ElementType.CONSTRUCTOR, ElementType.PARAMETER, ElementType.TYPE_USE}) @Retention(RetentionPolicy.RUNTIME) //可重复注解,ListValue.List是校验注解内部自定义的可重复注解容器 @Repeatable(ListValue.List.class) public @interface ListValue { //JSR303规范中message消息都统一在ValidationMessages.properties //我们也可以创建一个和该文件名一样的文件,在其中写对应的消息,Spring找不到会自动到自定义的同名文件中查找 //消息的属性名一般都使用注解全类名.message String message() default "{com.earl.common.validate.annotation.ListValue.message}"; Class<?>[] groups() default {}; Class<? extends Payload>[] payload() default {}; int[] vals() default {}; //java8新特性,定义可重复注解,一个注解可能对多种情况进行分组标注,可能使用多个相同注解,这是校验注解的重复注解定义 @Target({ElementType.METHOD, ElementType.FIELD, ElementType.ANNOTATION_TYPE, ElementType.CONSTRUCTOR, ElementType.PARAMETER, ElementType.TYPE_USE}) @Retention(RetentionPolicy.RUNTIME) @Documented public @interface List { ListValue[] value(); } } -

创建

ValidationMessages.properties同名文件并配置默认消息提示这个属性配置文件properties文件可能中文读取会乱码,这个地方需要修改IDEA的File–Setting–Editor–File Encodings–将Properties Files中的Transparent native-to-ascii conversion勾选上并重新创建文件【最好将File Encodings中的所有编码格式都改成UTF-8】

com.earl.common.validate.annotation.ListValue.message=必须提交指定的值 -

自定义校验器

/** * @author Earl * @version 1.0.0 * @描述 * 自定义注解需要实现ConstraintValidator接口 * ConstraintValidator<A extends Annotation, T>有两个泛型,第一个泛型是关联的注解@ListValue,第二个 * 泛型是@ListValue注解能标注的地方,该接口中有两个抽象方法 * @创建日期 2024/02/28 * @since 1.0.0 */ public class ListValueConstraintValidator implements ConstraintValidator<ListValue,Integer> { private Set<Integer> set=new HashSet<>(); /** * @param constraintAnnotation * @描述 该方法能获取到ListValue注解中的属性值,该属性值能在isValid中对数据进行校验,遍历vals中的值封装到set集合中供 * initialize方法对实际传参进行判断 * @author Earl * @version 1.0.0 * @创建日期 2024/02/28 * @since 1.0.0 */ @Override public void initialize(ListValue constraintAnnotation) { int[] vals = constraintAnnotation.vals(); for (int val:vals) { set.add(val); } } /** * @param value 要检验的实际入参 * @param context * @return boolean * @描述 判断是否校验成功 * @author Earl * @version 1.0.0 * @创建日期 2024/02/28 * @since 1.0.0 */ @Override public boolean isValid(Integer value, ConstraintValidatorContext context) { return set.contains(value); } }

Elasticsearch-Rest-Client

- 业务中ES检索请求的处理逻辑是前端发起检索请求给后端Java服务器,Java服务器向ES服务器发起检索请求获取数据并响应给前端,Java客户端操作ES的方式有两种

- 第一种方式是使用

spring-data-elasticsearch:transport-api.jar通过ES的TCP端口9300,也即节点间的通信端口;这种方式SpringBoot版本不同,对应的transport-api.jar也不同,更换ES的版本就要更换对应的transport-api.jar和SpringBoot的版本,而且ES版本对应的transport-api.jar根本就没出或者SpringBoot压根还没整合,这样不好;其次7.x版本已经不建议使用transport-api.jar,8以后就直接准备废弃了通过9300端口操作ES的jar包 - 第二种方式是通过HTTP协议走9200端口发送请求操作ES,市面上通过这种方式操作ES的产品有

- JestClient:非官方,更新慢,从maven仓库可以查询到最近版本的更新时间,比较慢,落后ES好几个小版本

- RestTemplate:这个产品只是模拟发送HTTP请求,ES很多操作需要自己进行封装,封装起来很麻烦

- HttpClient:该产品也只是模拟发送HTTP请求,ES的相关请求和响应数据处理需要自己封装,很麻烦;像这些只能用来发送HTTP请求的如OKHTTP等等都可以操作ES,但是DSL语句和响应结果需要自己封装工具进行处理

- Elasticsearch-Rest-Client:官方RestClient,封装了ES操作,API层次比较分明,官方的ES发布到哪个版本,这个工具也会同时更新相应的版本,本项目就使用该客户端

- 据说有个开源的ebatis,用起来也非常爽

- Elasticsearch-Rest-Client的官方文档在ES的Docs中的Elasticsearch Clients章节,里面列举了各种语言对ES的操作API,其中还有JavaScript客户端,但是ES一般属于后台服务器集群中一部分,一般不直接对外暴露,暴露可能会被公网恶意利用;使用js操作也不需要使用ES官方的工具,直接用js发送请求即可;Java API是基于9300端口操作ES的【而且文档标记7.0版本已经过时,在8.0版本将移除,在文档中推荐使用Java High Level REST Client,Java High Level REST Client是Java REST Client中两个工具的一种,还有一种是Java Low Level REST Client,两者的关系相当于mybatis和JDBC的关系;现在8.13版本都过时了,现在只有一个

Java Client了】,Java REST Client是基于9200端口操作ES的- ❓:为什么不用js发送查询请求,由nginx进行转发呢,还是因为安全的原因吗?反正就是用后端服务器调用来查询,以后再去看实际的情况

- 创建一个单独的模块

mall-search来使用Elasticsearch-Rest-Client中的Java High Level REST Client来操作ES服务器集群

-

搭建操作ES的模块

-

1️⃣:创建模块

mall-search,勾选整合Web中的Spring Web- 说明:NoSQL中有个Spring Data Elasticsearch因为最新只整合到6.3版本的ES【当时ES的最新版本是7.4】,所以就不考虑SpringData Elasticsearch,如果ES使用的版本不是那么新,选择SpringData Elasticsearch其实也是很好的选择,相比于官方的Elasticsearch-Rest-Client做了更简化的封装

-

2️⃣:导入

Java High Level REST Client的maven依赖,将版本号改为对应ES服务器的版本号,将ES服务器的版本号在properties标签中进行重新指定- 注意通过右侧的maven依赖树能够看到elasticsearch-rest-high-level-client虽然版本是7.4.2,但是子依赖中的部分版本还是6.8.5,这是因为SpringBoot对ES的版本进行了默认仲裁,SpringBoot2.2.2.RELEASE当引入SpringData Elasticsearch会自动仲裁Elasticsearch的版本为6.8.5【点开父依赖中的

spring-boot-starter-parent的父依赖的spring-boot-dependencies能够看见相关的版本信息】

<!--导入es的rest-high-level-client--> <dependency> <groupId>org.elasticsearch.client</groupId> <artifactId>elasticsearch-rest-high-level-client</artifactId> <version>7.4.2</version> </dependency>-

更改SpringBoot对Elasticsearch的版本自动仲裁,刷新maven直到依赖树中的相关依赖版本全部变成7.4.2

<properties> <elasticsearch.version>7.4.2</elasticsearch.version> </properties>

- 注意通过右侧的maven依赖树能够看到elasticsearch-rest-high-level-client虽然版本是7.4.2,但是子依赖中的部分版本还是6.8.5,这是因为SpringBoot对ES的版本进行了默认仲裁,SpringBoot2.2.2.RELEASE当引入SpringData Elasticsearch会自动仲裁Elasticsearch的版本为6.8.5【点开父依赖中的

-

3️⃣:对

rest-high-level-client进行配置-

🔎:如果使用SpringData Elasticsearch对ES操作,配置就非常简单,这个在ES的整合SpringData Elasticsearch中已经实现了,这里要配置我们自己选择的

rest-high-level-client会稍微复杂一些 -

编写配置类

MallElasticsearchConfig并注入IoC容器,这个配置类参考ES的官方文档Java High Level REST Client中的Getting started中的Initialization- 需要创建一个

RestHighLevelClient实例client,通过该实例来创建ES的操作对象

【单节点集群的创建客户端实例】

/** * @author Earl * @version 1.0.0 * @描述 对Java High Level REST Client进行配置,配置ES操作对象 * @创建日期 2024/05/24 * @since 1.0.0 */ @Configuration public class MallElasticSearchConfig { /** * @return {@link RestHighLevelClient } * @描述 通过单节点集群的ip地址和端口以及通信协议名称来创建RestHighLevelClient对象 * @author Earl * @version 1.0.0 * @创建日期 2024/05/24 * @since 1.0.0 */ @Bean public RestHighLevelClient esRESTClient(){ RestHighLevelClient client = new RestHighLevelClient( RestClient.builder(new HttpHost("192.168.56.10", 9200, "http")) ); return client; } }【多节点集群下的创建客户端实例】

- 多节点集群就在

RestClient.builder(HttpHost...)方法中的可变长度参数列表中输入各个节点的IP信息

@Bean public RestHighLevelClient esRESTClient(){ RestHighLevelClient client = new RestHighLevelClient( RestClient.builder( new HttpHost("localhost", 9200, "http"), new HttpHost("localhost", 9201, "http") ) ); return client; } - 需要创建一个

-

-

4️⃣:导入模块

mall-common引入注册中心【这里面引入的其他依赖挺多的,包含mp、Lombok、HttpCore、数据校验、Servlet API等】,配置配置中心、注册中心,服务名称在主启动类上使用注解@EnableDiscoveryClient开启服务的注册发现功能,在主启动类使用@SpringBootApplication(exclude = DataSourceAutoConfiguration.class)排除数据源【配置中心

bootstrap.properties配置】- 注意

bootstrap.properties文件必须在引入nacos的配置中心依赖后才会展示出小叶子图标

spring.application.name=mall-stock spring.cloud.nacos.config.server-addr=127.0.0.1:8848 spring.cloud.nacos.config.namespace=9c29064b-64f8-4a43-9375-eceb6e3c7957 - 注意

-

5️⃣:编写测试类检查ES操作对象是否创建成功

- 只要能打印出client对象,说明成功连接并创建ES操作对象,后续只需要参考官方文档使用对应的API即可,对应的文档也在Java High Level REST Client中的所有APIs部分

@RunWith(SpringRunner.class)//指定使用Spring的驱动来跑单元测试,这是老版本SpringBoot的写法,新版本已经不这么写了 @SpringBootTest public class MallSearchApplicationTests { @Autowired private RestHighLevelClient esRESTClient; @Test public void contextLoads() { System.out.println(esRESTClient);//org.elasticsearch.client.RestHighLevelClient@3c9c6245 } }

-

fastjson

-

引入依赖

<dependency> <groupId>com.alibaba</groupId> <artifactId>fastjson</artifactId> <version>1.2.47</version> </dependency>-

🔎:注意nacos注册中心

spring-cloud-alibaba-nacos-discovery的父依赖nacos-client的父依赖nacos-api的父依赖中自带fastjson<!--nacos注册中心--> <dependency> <groupId>com.alibaba.cloud</groupId> <artifactId>spring-cloud-alibaba-nacos-discovery</artifactId> </dependency>

-

API

-

String--->JSON.toJSONString(Object object)- 功能解析:将对象

object转换为json格式字符串 - 使用示例:

String userJSONStr = JSON.toJSONString(user);- 示例含义:将user对象转换为json格式字符串

- 功能解析:将对象

-

T--->JSON.paseObject(String jsonStr,Class T.class)- 功能解析:将Json格式字符串jsonStr转换为指定对象T

- 使用示例:``

- 示例含义:将商品文档json数据转换为Product对象

-

使用fastjson的TypeReference指定要将Map类型的键值对转换为指定的数据类型,

- 原理是先将Map转换成json,再用fastjson将json字符串转成通过泛型指定的实体类

- 这种用法一般用在如服务调用,调用方拿到数据默认会将属性对应的json对象【包含多个属性】转换成LinkedHashMap,这是因为json格式的k-v数据天然符合Map类型的数据组织形式,默认转换成Map方便数据的读取,但是这样就无法将Map类型的数据强转为我们的目标类型如To类,这时候就可以使用fastjson的TypeReference来将Map转成json,再将json转成我们指定的目标数据类型

【响应类封装转换数据类型的fastjson的TypeReference】

public class R extends HashMap<String, Object> { private static final long serialVersionUID = 1L; //使用泛型需要声明泛型,方法中使用的泛型在方法名前面声明<T> T public <T> T getData(TypeReference<T> typeReference){ //接收到的Object类型里面的对象被自动反序列化成Map了,因为互联网传输过程中使用JSON天然符合Map特性 //系统底层默认转成Map是为了更方便数据的读取,R里面data存的数据的数据类型默认是LinkedMap类型的,LinkedHashMap无法被强转为我们自定义的To类 //需要使用fastjson的TypeReference先将Map转换成json,再用fastjson将json字符串转成通过泛型指定的实体类 Object data =get("data"); String dataJSONStr = JSON.toJSONString(data); T t = JSON.parseObject(dataJSONStr, typeReference); return t; } public R setData(Object data){ put("data",data); return this; } public R() { put("code", 0); put("msg", "success"); } public static R error() { return error(HttpStatus.SC_INTERNAL_SERVER_ERROR, "未知异常,请联系管理员"); } public static R error(String msg) { return error(HttpStatus.SC_INTERNAL_SERVER_ERROR, msg); } public static R error(int code, String msg) { R r = new R(); r.put("code", code); r.put("msg", msg); return r; } public static R ok(String msg) { R r = new R(); r.put("msg", msg); return r; } public static R ok(Map<String, Object> map) { R r = new R(); r.putAll(map); return r; } public static R ok() { return new R(); } public R put(String key, Object value) { super.put(key, value); return this; } /** * @return {@link Integer } * @描述 获取响应的响应码判断响应状态 * @author Earl * @version 1.0.0 * @创建日期 2024/03/26 * @since 1.0.0 */ public Integer getCode(){ return (Integer) this.get("code"); } }【在调用者解析并将数据转换为指定类型】

Map<Long, Boolean> stockStatus = null; try{ //远程服务调用获取数据并将数据利用fastjson的TypeReference转换成指定目标数据类型List<SkuStockExistTo> List<SkuStockExistTo> skuStockExistTos = stockFeignClient.isStockExist(skuIds).getData(new TypeReference<List<SkuStockExistTo>>() { }); //将该集合skuStockExistTos转成Map准备属性对拷 stockStatus = skuStockExistTos.stream().collect(Collectors.toMap(SkuStockExistTo::getSkuId, SkuStockExistTo::getIsExist)); }catch (Exception e){ log.error("远程调用库存服务异常,原因:{}",e); }

dev-tools

-

引入依赖

- 引入以后修改文件还是需要重新编译整个项目或者重新编译当前资源【Ctrl+Shift+F9】才能在前端看到对应效果,据说使用jrebel插件可以更高效地大道热部署效果

- 如果是配置更改推荐还是重启项目,避免出现各种问题

<!--不重启服务器实现代码动态更新dev-tools,本质是修改代码自动触发重新启动--> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-devtools</artifactId> <optional>true</optional> </dependency>

Thymeleaf

-

集中修改首页中对静态资源的超链接方法[给所有静态资源的uri添加前缀static],这个要根据具体情况具体分析啊,链接的写法很多样,比如很多喜欢以当前路径开始,此时这么修改就是错误的,这里只是展示所有的链接标签,实际修改要根据链接的情况来确定

href="替换为href="/static,<script src="替换为<script src="static/,<img src="替换为<img src="static/<src="index替换为<src="static/index

-

注意如果属性值是常量字符串,比如

action="/registry",此时使用Thymeleaf来处理该属性可能会报错,比如th:action="/registry"此时后端就会报错Thymeleaf渲染出错 -

通过

Thymeleaf来从error这个Map中获取错误校验信息,在没有发生校验错误的情况下error会为null,此时仍然从error中获取错误校验信息就会出现空指针异常,只有在error不为null的情况下才去执行从error中获取对应参数的错误校验信息- 注意即使

Map类型的error不为null,但是Map中没有指定的属性如username,此时仍然使用error.get("username"),Thymeleaf仍然会报错,即Map不包含指定key的数据但是仍然进行取值Thymeleaf会直接报错,我们还需要通过Thymeleaf对Map处理的API#maps.containsKey(map,key)来判断Map类型的error中是否包含key为username的数据,包含才进行取值,不包含就不取值

- 注意即使

-

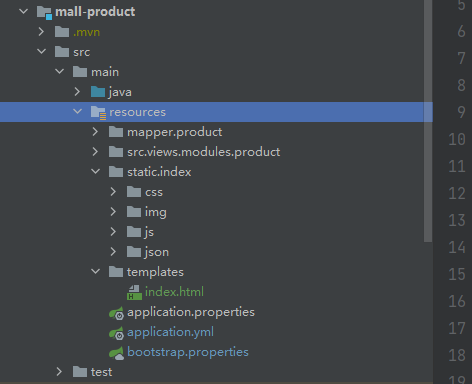

在商品模块引入Thymeleaf依赖做首页渲染

-

pom.xml

<!--模板引擎Thymeleaf--> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-thymeleaf</artifactId> </dependency> -

将首页用到的静态资源目录index拷贝到类目录下的static目录下,将首页模板页面放在类路径目录

template目录下

-

-

Thymeleaf相关配置

-

在

application.yml使用下列配置关闭Thymeleaf的缓存- 关闭Thymeleaf缓存,这样开发期间就能看见实时的更改效果

- Thymeleaf的前缀默认配置

spring.thymeleaf.prefix="classpath:/templates/" - 后缀默认配置是

spring.thymeleaf.suffix=".html"

Spring: thymeleaf: cache: false #关闭Thymeleaf缓存,这样开发期间就能看见实时的更改效果 -

在项目包

com.earl.product目录下创建web包用来专门放商城前台的控制器方法 -

静态资源目录

-

静态资源放在默认的

static目录下可以通过路径如http://127.0.0.1:9000/index/css/GL.css直接访问【访问不到可能是target目录没有载入】,静态页面模板index.html放在template目录下此时可以直接通过http://127.0.0.1:9000直接访问,注意默认不能通过http://127.0.0.1:9000/index.html访问【默认情况下没有做对应URI为index.html的映射】 -

注意项目里的前端静态资源统一加了

static前缀,即http://127.0.0.1:10000/static/index/css/GL.css,此时对应的静态资源需要放在目录static/static下,使用下列配置让SpringBoot忽略static前缀,这样将静态资源放在static目录下即可访问Spring: thymeleaf: cache: false #关闭Thymeleaf缓存,这样开发期间就能看见实时的更改效果 mvc: static-path-pattern: /static/** #这里前端所有的静态资源路径加了static前缀,使用该配置让SpringBoot处理过程中去掉该前缀,这样仍然将index目录放在static目录下即可,而不需要放在static/static目录下

-

-

-

业务逻辑演示

-

设置URI路径数组跳转的首页视图

-

引入

Thymeleaf就是要做视图渲染的,因为才需要控制器方法来获取数据并存入视图,如果只是访问页面不需要视图数据渲染,不需要控制器方法也能根据路径匹配到对应的index.html -

注意使用

Thymeleaf渲染页面,控制器方法要响应对应的页面,不能在控制器方法上加@ResponseBody注解,这样会直接导致响应对象 -

❓:注意一下这里有点问题,在不配置控制器方法的情况下,浏览器只能通过

search.earlmall.com/直接访问到templates/index.html,竟然连search.earlmall.com/index.html都访问不到,而且将index.html转移到SpringBoot的静态文件默认路径static下也不行,真让人摸不着头脑,复习SpringBoot的时候注意一下这个地方

-

-

@Controller

public class IndexController {

/**

* @return {@link String }

* @描述 匹配uri为"/"和"/index.html"都跳转首页视图

* 1. Thymeleaf的前缀默认配置spring.thymeleaf.prefix="classpath:/templates/"

* 2. 后缀默认配置是spring.thymeleaf.suffix=".html"

* 3. 返回视图地址,视图解析器会自动对视图地址进行拼串 前缀+返回值+后缀 即视图地址

* @author Earl

* @version 1.0.0

* @创建日期 2024/06/03

* @since 1.0.0

*/

@GetMapping({"/","/index.html"})

public String urisToIndexPage(){

return "index";

}

}

-

跳转页面后需要查询到所有商品的一级分类。模板中数据是写死的,使用

ModelAndView来缓存数据并从视图中取出相应的数据- 从表

pms_category中查询出所有一级分类商品,特征是字段cat_level字段属性值为1 - 使用

Thymeleaf从ModelAndView中获取数据渲染到视图中需要使用Thymeleaf的语法,[Thymeleaf官方文档-英文](Documentation - Thymeleaf),点击Using Thymeleaf下的链接可以下载对应版本的说明文档,包括PDF、EPUB、MOBI等等版本 - 使用

Thymeleaf的优点是渲染以html为后缀的文件,浏览器可以直接打开,和前端沟通起来成本小,使用JSP浏览器打不开且前端不好做优化

【获取一级分类数据并存入

ModelAndView】model.addAttribute("firstLevelCategories",firstLevelCategories);需要指明变量的名称,否则只有打断点才知道对应变量的名称

@Controller public class IndexController { @Autowired private CategoryService categoryService; /** * @return {@link String } * @描述 匹配uri为"/"和"/index.html"都跳转首页视图 * 1. Thymeleaf的前缀默认配置spring.thymeleaf.prefix="classpath:/templates/" * 2. 后缀默认配置是spring.thymeleaf.suffix=".html" * 3. 返回视图地址,视图解析器会自动对视图地址进行拼串 前缀+返回值+后缀 即视图地址 * 4. 在跳转首页的过程中将数据查询出来放在ModelAndView中等待渲染 * @author Earl * @version 1.0.0 * @创建日期 2024/06/03 * @since 1.0.0 */ @GetMapping({"/","/index.html"}) public String urisToIndexPage(Model model){ List<CategoryEntity> firstLevelCategories=categoryService.getAllFirstLevelCategory(); model.addAttribute("firstLevelCategories",firstLevelCategories); return "index"; } }【使用Thymeleaf语法需要在渲染视图引入Thymeleaf的名称空间

xmlns:th="http://www.thymeleaf.org"】- 注意:

<!DOCTYPE html>是H5的标头

<html lang="en" xmlns:th="http://www.thymeleaf.org"> ... </html>【获取变量并渲染成标签的文本内容】

th:text="${}"表示获取变量并将其渲染成文本填充到当前标签

<div th:text="${}"> </div>【表格遍历语法】

<tr th:each="prod : ${prods}">的作用是循环遍历指定元素prods,并根据元素集合中元素的个数决定循环创建多少个当前tr标签及其子标签,${prods}是要遍历的元素,prod是当前元素,使用th:text来展示当前元素的各个属性变量【如果标签已经有文本,会使用当前变量值直接进行替换】,th:each表示有多少个子元素就会生成多少个tr标签和其子标签,这个标签也可以是其他html标签

<table> <tr> <th>NAME</th> <th>PRICE</th> <th>IN STOCK</th> </tr> <tr th:each="prod : ${prods}"> <td th:text="${prod.name}">Onions</td> <td th:text="${prod.price}">2.41</td> <td th:text="${prod.inStock}? #{true} : #{false}">yes</td> </tr> </table> - 从表

-

使用Thymeleaf渲染商品一级分类列表

- Thymeleaf自定义属性

th:attr="ctg-data=${category.catId},渲染后的展示效果是ctg-data=商品分类id,该属性是用来查询该分类id下的二三级商品分类的

<ul> <li th:each="category : ${firstLevelCategories}"> <a href="#" class="header_main_left_a" th:attr="ctg-data=${category.catId}"> <b th:text="${category.name}"></b> </a> </li> </ul> - Thymeleaf自定义属性

语法

-

获取请求路径中的参数并渲染到页面中

${param.keyword}中param表示请求路径中的所有参数,param.keyword表示从所有请求路径的参数中获取keyword这个参数的参数值,如果该参数没有参数则显示placeholder属性的值

<div class="header_form"> <input type="text" id="keyword_input" placeholder="手机" th:value="${param.keyword}"/> <a href="javascript:specifySearchParamKeyword()">搜索</a> </div> -

Thymeleaf在字符串中拼接变量的写法th:href="|http://item.earlmall.com/${product.skuId}.html|"即用两个竖线将字符串框起来 -

Thymeleaf的#lists.contains(list,elements)能判断list集合中是够含有某个元素 -

Thymeleaf提供对两个数字之间的所有整数进行遍历的numbers.sequence函数,使用方法是th:each="i:${#numbers.sequence(1,totalPages)}",作用是对数字1和总页数totalPages之间的所有整数进行遍历,i是每次取出的整数 -

Thymeleaf的Numbers章节的Formatting decimal Numbers展示了格式化api,其中${#numbers.formatDecimal(num,3,2)}表示num整数位保留3位,小数位保留2位,整数位超出3位也能正常显示 -

th:each="val:${#strings.listSplit(String str,',')}"将字符串用逗号分隔返回字符串片段数组 -

th:if="${!#strings.isEmpty(skuImage.imgUrl)}",其中的#strings.isEmpty(skuImage.imgUrl)是判断字符串是否为空值

Redis

整合Redis

-

安装

redis以及构建集群见Linux指南中的安装redis部分 -

SpringBoot配置

-

引入场景启动器依赖

<!--redis做缓存操作,搜索RedisAutoConfiguration能找到redis相关配置对应的属性类,所有相关配置都在该属性类中--> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-data-redis</artifactId> </dependency> -

SpringBoot对redis的配置

- host指定redis所在主机地址,

- port指定redis在主机上的端口号,默认就是6379

- 如果指定了用户和密码还可以在配置文件中指定用户和密码,默认安装没有密码和用户名

Spring: redis: host: 192.168.56.10 port: 6379

-

操作Redis

-

redis的自动配置类

- redis的自动配置类给容器中添加了

RedisTemplate<Object,Object>对象【对应k-v键值对的数据】,用于操作redis对数据进行CRUD操作 - 一般操作k-v键值对都是字符串较多,因此自动配置类还专门给容器添加了一个

StringRedisTemplate对象,该类继承自RedisTemplate<String,String>,对应的key和value是用String的序列化来做的- 🔎:

StringRedisTemplate对象和RedisTemplate<Object,Object>对象的区别是序列化器不一样,RedisTemplate<Object,Object>对象默认使用的是JDK的序列化器defaultSerializer=new JdkSerializationRedisSerializer,意为着如果我们使用RedisTemplate<Object,Object>对象来操作Redis,写入redis中的数据都是二进制的,没有可读性,即便服务器写入字符串,存入redis中的数据也会变成二进制的数据,在redis客户端上根本无法浏览;如果要使用RedisTemplate<Object,Object>对象需要设置对应的序列化器为String或者json的序列化器; - 🔎:

StringRedisTemplate对象就是使用的String的序列化器,RedisSerializer.string()就是给StringRedisTemplate对象设置Sting序列化器的方法,使用StringRedisTemplate对象存放的时候数据是怎么样的,读取出来就是怎么样的,使用该对象操作Redis可读性非常高,操作字符串k-v键值对直接使用StringRedisTemplate对象即可

- 🔎:

【

StringRedisTemplate的源码】- 注意这个

RedisSerializer.string()

public class StringRedisTemplate extends RedisTemplate<String, String> { public StringRedisTemplate() { setKeySerializer(RedisSerializer.string()); setValueSerializer(RedisSerializer.string()); setHashKeySerializer(RedisSerializer.string()); setHashValueSerializer(RedisSerializer.string()); } public StringRedisTemplate(RedisConnectionFactory connectionFactory) { this(); setConnectionFactory(connectionFactory); afterPropertiesSet(); } protected RedisConnection preProcessConnection(RedisConnection connection, boolean existingConnection) { return new DefaultStringRedisConnection(connection); } } - redis的自动配置类给容器中添加了

-

RedisTemplate的使用

-

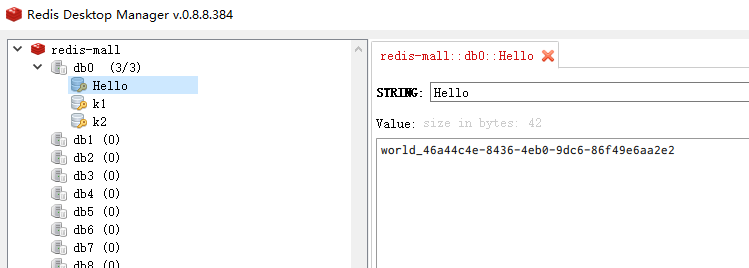

代码示例

@RunWith(SpringRunner.class) @SpringBootTest public class MallProductApplicationTests { @Autowired StringRedisTemplate stringRedisTemplate; @Test public void testStringRedisTemplate(){ //RedisTemplate下有很多opsXXX,这主要牵扯到redis中不同的数据类型,本项目基本使用以下五种类型,更多后面复习redis再说 //1. stringRedisTemplate.opsForValue() 这是存放简单类型 //拿到ops操作对象 ValueOperations<String, String> ops = stringRedisTemplate.opsForValue(); //保存数据 ops.set("Hello","world_"+ UUID.randomUUID()); //从redis中查询对应key的数据 String hello = ops.get("Hello"); System.out.println("Hello:"+hello);//Hello:world_46a44c4e-8436-4eb0-9dc6-86f49e6aa2e2 //stringRedisTemplate.opsForHash() 这是value类型也是一个Map类型 //stringRedisTemplate.opsForList() 这是value类型是一个数组 //stringRedisTemplate.opsForSet() 这是value类型是一个Set集合 //stringRedisTemplate.opsForZSet() 这是value类型是一个ZSet带排序集合类型 } } -

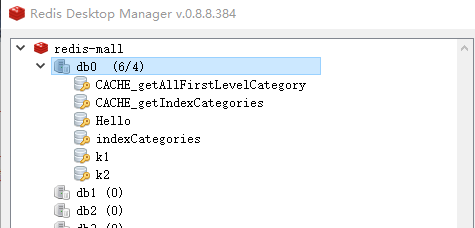

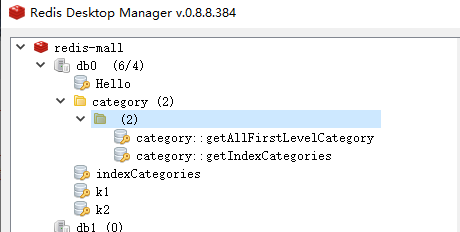

redis中的存入的数据

-

jol-core

- jol-core用来查看java对象的对象头信息,这是openjdk提供的

-

引入依赖

<!-- https://mvnrepository.com/artifact/org.openjdk.jol/jol-core --> <dependency> <groupId>org.openjdk.jol</groupId> <artifactId>jol-core</artifactId> <version>0.17</version> </dependency> -

使用方法

- 这里老师修改了原来的jar包重新打包的,里面的api是他自定义的,B站没有相关教程,后续看文档补充,后续更改使用jol-core自身的api以后成功运行

package cn.itcast.n4; import lombok.extern.slf4j.Slf4j; import org.openjdk.jol.info.ClassLayout; import java.io.IOException; import java.util.Vector; import java.util.concurrent.locks.LockSupport; // -XX:-UseCompressedOops -XX:-UseCompressedClassPointers -XX:BiasedLockingStartupDelay=0 -XX:+PrintFlagsFinal //-XX:-UseBiasedLocking tid=0x000000001f173000 -XX:BiasedLockingStartupDelay=0 -XX:+TraceBiasedLocking @Slf4j(topic = "c.TestBiased") public class TestBiased { /* [t1] - 29 00000000 00000000 00000000 00000000 00011111 01000101 01101000 00000101 [t2] - 29 00000000 00000000 00000000 00000000 00011111 01000101 11000001 00000101 */ public static void main(String[] args) throws IOException, InterruptedException { test1(); } private static void test5() throws InterruptedException { log.debug("begin"); for (int i = 0; i < 6; i++) { Dog d = new Dog(); log.debug(ClassLayout.parseInstance(d).toPrintable()); Thread.sleep(1000); } } static Thread t1, t2, t3; private static void test4() throws InterruptedException { Vector<Dog> list = new Vector<>(); int loopNumber = 39; t1 = new Thread(() -> { for (int i = 0; i < loopNumber; i++) { Dog d = new Dog(); list.add(d); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } } LockSupport.unpark(t2); }, "t1"); t1.start(); t2 = new Thread(() -> { LockSupport.park(); log.debug("===============> "); for (int i = 0; i < loopNumber; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } LockSupport.unpark(t3); }, "t2"); t2.start(); t3 = new Thread(() -> { LockSupport.park(); log.debug("===============> "); for (int i = 0; i < loopNumber; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } }, "t3"); t3.start(); t3.join(); log.debug(ClassLayout.parseInstance(new Dog()).toPrintable()); } private static void test3() throws InterruptedException { Vector<Dog> list = new Vector<>(); Thread t1 = new Thread(() -> { for (int i = 0; i < 30; i++) { Dog d = new Dog(); list.add(d); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } } synchronized (list) { list.notify(); } }, "t1"); t1.start(); Thread t2 = new Thread(() -> { synchronized (list) { try { list.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug("===============> "); for (int i = 0; i < 30; i++) { Dog d = list.get(i); log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); synchronized (d) { log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } log.debug(i + "\t" + ClassLayout.parseInstance(d).toPrintable()); } }, "t2"); t2.start(); } // 测试撤销偏向锁 private static void test2() throws InterruptedException { Dog d = new Dog(); Thread t1 = new Thread(() -> { synchronized (d) { log.debug(ClassLayout.parseInstance(d).toPrintable()); } synchronized (TestBiased.class) { TestBiased.class.notify(); } }, "t1"); t1.start(); Thread t2 = new Thread(() -> { synchronized (TestBiased.class) { try { TestBiased.class.wait(); } catch (InterruptedException e) { e.printStackTrace(); } } log.debug(ClassLayout.parseInstance(d).toPrintable()); synchronized (d) { log.debug(ClassLayout.parseInstance(d).toPrintable()); } log.debug(ClassLayout.parseInstance(d).toPrintable()); }, "t2"); t2.start(); } // 测试偏向锁 private static void test1() { Dog d = new Dog(); log.debug(ClassLayout.parseInstance(d).toPrintable()); try { Thread.sleep(4000); } catch (InterruptedException e) { e.printStackTrace(); } log.debug(ClassLayout.parseInstance(new Dog()).toPrintable()); } } class Dog { }

commons-lang3

- 工具包,包括字符串处理工具类

StringUtils等功能

-

引入依赖

<dependency> <groupId>org.apache.commons</groupId> <artifactId>commons-lang3</artifactId> </dependency>

API

StringUtils

boolean--->StringUtils.equals(CharSequence cs1, CharSequence cs2)-

功能解析:比较两个字符序列

cs1、cs2是否相等,如果相等该方法返回true,如果不相等返回false;该方法区分字符串的大小写,如StringUtils.equals("abc","ABC") = false -

使用示例:

queryWrapper.eq(dadAge,momAge);- 示例含义:检查字符串变量

dadAge和字符串变量momAge的字符内容和次序是否相等

- 示例含义:检查字符串变量

-

补充说明:

- 🔎:

String类型实现了CharSequence接口 - 🔎:该

StringUtils.equals(CharSequence cs1, CharSequence cs2)方法的参数列表的任意参数传参null都不会抛异常,如StringUtils.equals(null, null) = true,StringUtils.equals(null, "abc") = false,StringUtils.equals("abc",null) = false

- 🔎:

-

boolean ---> StringUtils.startsWith(final CharSequence str, final CharSequence prefix)- 功能解析:判断字符串

str是否以字符串prefix作为前缀,如果是则返回true,否则返回false - 使用示例:

StringUtils.startWith(str,"lock-")- 示例含义:判断字符串

str是否以lock-作为前缀,是返回true,否则返回false

- 示例含义:判断字符串

- 功能解析:判断字符串

String ---> StringUtils.substringAfterLast(final String str, final String separator)- 功能解析:截取字符串

str中最后一个separator字符或字符串后面的内容,不包含separator字符或字符串 - 使用示例:

StringUtils.substringAfterLast(str,"/")- 示例含义:截取字符串

str最后一个/后面的内容

- 示例含义:截取字符串

- 功能解析:截取字符串

DigestUtils

-

String ---> DigestUtils.md5Hex(String data)- 功能解析:将文本数据转换成16进制格式的MD5值

- 使用示例:

String s=DigestUtils.md5Hex("123456")- 示例含义:将字符串转换为对应的16进制MD5值

- 补充说明:

- 这是基本的MD5加密算法,不是加盐版本,计算出的密文大部分都可以通过彩虹表还原出原文

-

String ---> DigestUtils.md5Crypt(Bytes bytes)- 功能解析:在文本数据data前加上盐

$1$+8位随机字符然后一起计算MD5值 - 使用示例:

String s=DigestUtils.md5Crypt("123456".getBytes())- 示例含义:将字符串数据前加上随机盐值后再整体计算MD5值

- 补充说明:

- 这里的盐值是随机的,格式为

$1$+8位随机字符,添加位置是我猜的,后面验证一下

- 这里的盐值是随机的,格式为

- 功能解析:在文本数据data前加上盐

-

String ---> DigestUtils.md5Crypt(Bytes bytes,String salt)- 功能解析:在文本数据data前加上盐

$1$+8位随机字符然后一起计算MD5值 - 使用示例:

String s=DigestUtils.md5Crypt("123456".getBytes(),"$1$qqqqqqqq")- 示例含义:将字符串数据

123456前加上盐值$1$qqqqqqqq后再整体计算MD5值

- 示例含义:将字符串数据

- 补充说明:

- 我们可以使用随机盐值对用户密码进行加密,同时保存加密使用的盐值,验证的时候再取出盐值进行验证

- 功能解析:在文本数据data前加上盐

zookeeper客户端

- Zookeeper官方提供的Java客户端,用于在Java应用程序中实现对Zookeeper服务器的操作

-

使用官方Zookeeper客户端

-

引入依赖

-

在zookeeper的客户端中已经引入了

slf4j-log4j12,如果已经在其他地方也引入就会有Slf4j日志标红提示,老师的解决办法是从zookeeper的依赖中移除slf4j-log4j12-

我认为这里老师讲的是错误的,因为maven会自动处理重复的依赖项,除非两个相同依赖的版本不一致,另一方面从依赖树形结构图中没有找到期望被移除的

slf4j-log4j12,从报错信息上来看是logback-classic1.2.11中的org.slf4j.impl.StaticLoggerBinder.class和slf4j-reload4j.1.7.36中的org.slf4j.impl.StaticLoggerBinder.class两个类发生了冲突,通过网络搜索发现网上那个和slf4j-log4j12冲突的报错信息确实是slf4j-log4j12-1.7.25.jar,总之就是logback和log4j之间关于org/slf4j/impl/StaticLoggerBinder.class这个类发生的冲突,不同jar包下的相同的全限定类名的类在不破坏JVM的双亲委派模型类加载机制情况下全限定类名相同的类只会加载被先加载的jar包中的对应类,jar包的加载顺序和classpath参数有关,包路径越靠前越先被加载,加载顺序靠后的jar包中的全限定类名相同的类会被直接忽略掉不会再被加载,SpringBoot的默认日志是logback,log4j是以前的主流日志,很多第三方工具包都使用的是log4j,解决办法是排除logback或者log4j的其中一个,让整个项目使用其中的一种日志;【具体原因还需要深入分析】【报错信息】

SLF4J: Class path contains multiple SLF4J bindings. SLF4J: Found binding in [jar:file:/D:/maven-repository/ch/qos/logback/logback-classic/1.2.11/logback-classic-1.2.11.jar!/org/slf4j/impl/StaticLoggerBinder.class] SLF4J: Found binding in [jar:file:/D:/maven-repository/org/slf4j/slf4j-reload4j/1.7.36/slf4j-reload4j-1.7.36.jar!/org/slf4j/impl/StaticLoggerBinder.class] SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation. SLF4J: Actual binding is of type [ch.qos.logback.classic.util.ContextSelectorStaticBinder]【springboot排除logback依赖实例】

- 排除

logback就要把项目中所有的logback都排除,只使用log4j

<dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter</artifactId> <exclusions> <!-- 排除自带的logback依赖 --> <exclusion> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-logging</artifactId> </exclusion> </exclusions> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> <exclusions> <!-- 排除自带的logback依赖 --> <exclusion> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-logging</artifactId> </exclusion> </exclusions> </dependency> - 排除

-

【正常依赖】

<dependency> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> <version>3.7.0</version> </dependency>【老师的排除

slf4j-log4j12示例】- 🔎:这个方式是有效的

<dependency> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> <version>3.7.0</version> <exclusions> <exclusion> <groupId>org.slf4j</groupId> <artifactId>slf4j-log4j12</artifactId> </exclusion> </exclusions> </dependency>【实测排除

slf4j-reload4j也行】<dependency> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> <version>3.7.0</version> <exclusions> <exclusion> <groupId>org.slf4j</groupId> <artifactId>slf4j-reload4j</artifactId> </exclusion> </exclusions> </dependency> -

-

-

zookeeper客户端对象的获取

Zookeeper对象通过构造方法创建,构造方法只能是有参构造,必须传参连接字符串connectString、连接超时时间sessionTimeOut、监听器watcher,该对象使用完以后必须调用close方法来手动关闭连接- 连接字符串

connectString:格式必须为"127.0.0.1:3000,127.0.0.1:3001,127.0.0.1:3002",参数值是Zookeeper服务器集群的地址- 用逗号分隔各地址,注意逗号两边不能有空格

- 连接超时时间

sessionTimeOut:参数为int类型,单位是毫秒 - 监听器

Watcher:Watcher是一个接口,需要使用匿名内部类的方式重写process方法来实例化对象,process方法会在连接建立时和连接关闭时各执行一次 - 注意调用完Zookeeper的构造方法以后还在获取连接程序就会执行后续的代码,此时zookeeper对象只是赋值了对象地址因为建立连接较慢还没有完成初始化,其中的功能是无法正常使用,此时需要使用闭锁

CountdownLatch来实现对zookeeper初始化进行等待的效果

- 连接字符串

- zookeeper对象的API简介

zookeeper.create()方法能创建节点zookeeper.exist()方法能判断某个节点是否存在zookeeper.getChildren()方法能获取节点的子节点和数据内容

public static void main(String[] args) { ZooKeeper zooKeeper = null; try { //Zookeeper操作对象可以直接通过构造方法创建,构造方法只能是有参构造,必须传参连接字符串connectString、sessionTimeOut、watcher //连接字符串connectString的格式必须为"127.0.0.1:3000,127.0.0.1:3001,127.0.0.1:3002",参数值是Zookeeper服务器集群的地址,用逗号分隔各地址,注意逗号两边不能有空格 //参数sessionTimeOut是int类型的连接超时时间,单位是毫秒 //监听器Watcher是一个接口,需要使用匿名内部类的方式来实例化对象 //使用完客户端对象以后调用close方法来关闭该客户端 zooKeeper = new ZooKeeper("192.168.200.132:2181", 30000, new Watcher() { @Override public void process(WatchedEvent event) { System.out.println("此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次"); } }); //Zookeeper对象的Api //zookeeper.create方法能创建节点 //zookeeper.exist方法能判断某个节点是否存在 //zookeeper.getChildren方法能获取节点的子节点和数据内容 //注意,Zookeeper在获取连接的时候,调用获取Zookeeper对象的方法后续代码就已经在执行了 //这里经过测试zookeeper不是null,这里是老师讲错了,根据以往JUC里面学到的知识认为是赋值操作已经完成,但是还没有初始化好,实际该对象虽然不是null但是需要在建立好连接后才能使用 System.out.println("此时还在建立连接,Zookeeper仍然为null但是这里已经能够执行了"); System.out.println(zooKeeper==null); /**执行效果 * 此时还在建立连接,Zookeeper仍然为null但是这里已经能够执行了 * false * 此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次 * 此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次 * */ //Zookeeper客户端中引入了Slf4j } catch (IOException e) { e.printStackTrace(); }finally { if (zooKeeper != null) { try { zooKeeper.close(); } catch (InterruptedException e) { e.printStackTrace(); } } } }-

使用闭锁

CountdownLatch等待zookeeper对象初始化完成- 注意,两次process方法回调时传参的

WatchedEvent对象的state属性值是不同的,第一次获取连接是SyncConnected,关闭连接时是Closed,可以根据两个属性值来区分是获取连接还是关闭连接,该属性值的类型是枚举Event.keeperState,可以通过该属性值和枚举值对比决定是否需要放行countDownLatch.await()从而继续执行获取到zookeeper连接后的动作- ❓:不是异步获取连接吗为什么这里属性值是同步连接

/**执行效果 * 此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次 * 此时还在建立连接,Zookeeper已赋值对象地址但是对象还没完成初始化,此时这里已经能够执行了 * false * WatchedEvent state:SyncConnected type:None path:null * 此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次 * WatchedEvent state:Closed type:None path:null * */ public static void main(String[] args) { CountDownLatch countDownLatch = new CountDownLatch(1); ZooKeeper zooKeeper = null; try { zooKeeper = new ZooKeeper("192.168.200.132:2181", 30000, new Watcher() { @Override public void process(WatchedEvent event) { countDownLatch.countDown(); System.out.println("此时才真正获取连接进行回调process方法,该方法会在获取Zookeeper连接和关闭Zookeeper连接的时候分别调用一次,因此一共会调用两次"); System.out.println(event); } }); try { countDownLatch.await(); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("此时还在建立连接,Zookeeper以赋值对象地址但是对象还没完成初始化,此时这里已经能够执行了"); System.out.println(zooKeeper==null); } catch (IOException e) { e.printStackTrace(); }finally { if (zooKeeper != null) { try { zooKeeper.close(); } catch (InterruptedException e) { e.printStackTrace(); } } } }【优化后的通用模板代码】

public static void main(String[] args) { CountDownLatch countDownLatch = new CountDownLatch(1); ZooKeeper zooKeeper = null; try { zooKeeper = new ZooKeeper("192.168.200.132:2181", 30000, new Watcher() { @Override public void process(WatchedEvent event) { if(Event.KeeperState.SyncConnected.equals(event.getState())){ countDownLatch.countDown(); } } }); try { countDownLatch.await(); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("业务操作"); } catch (IOException e) { e.printStackTrace(); }finally { if (zooKeeper != null) { try { zooKeeper.close(); } catch (InterruptedException e) { e.printStackTrace(); } } } } - 注意,两次process方法回调时传参的

-

上述代码还不够完善,因为节点事件的监听回调依然会执行

process()方法,此时process方法传参的event和获取连接时回调process方法的event分别为WatchedEvent state:SyncConnected type:NodeChildrenChanged path:/earl[1]和WatchedEvent state:SyncConnected type:None path:null;注意这些event中的state属性为SyncConnected,和关闭连接时的WatchedEvent state:Closed type:None path:null该state属性Closed不同,由此区分关闭连接和其他事件;可以通过event参数的type属性来区分事件类型从而执行不同的回调逻辑,在state属性为SyncConnected的前提下,当type为None时表明回调由成功获取连接发起,当type属性为事件类型时表明回调由事件发起;此外注意event中的path存储了事件监听节点的路径,通过该路径可以制定不同节点的事件回调逻辑;由此可以将节点事件回调分成获取连接、关闭连接、节点事件三个大类执行对应的回调逻辑,对节点事件可以通过事件节点路径来区分执行不同的回调逻辑,示例代码如下- 在Zookeeper对象的构造方法传参watcher对象中通过

event对象的state属性、type属性和path属性来分区获取连接回调、关闭连接回调和不同类型不同节点的节点事件回调 - 节点事件回调直接在Zookeeper构造方法传参中写一起不优雅,不方便读和改,判断逻辑复杂;业界常用的方式是在节点事件监听方法中传参

Watcher匿名实现重写process方法来自定义节点事件的回调逻辑,连续回调需要对节点事件方法进行封装,通过在回调方法中递归调用该方法来实现连续回调

public static void main(String[] args) { CountDownLatch countDownLatch = new CountDownLatch(1); ZooKeeper zooKeeper = null; try { zooKeeper = new ZooKeeper("192.168.200.132:2181", 30000, new Watcher() { @Override public void process(WatchedEvent event) { Event.KeeperState eventState = event.getState(); if (Event.KeeperState.SyncConnected.equals(eventState) && Event.EventType.None.equals(event.getType())) { //获取连接回调逻辑,通常让闭锁计数减1来放行主业务执行或者其他逻辑 countDownLatch.countDown(); } else if (Event.KeeperState.Closed.equals(eventState)) { //关闭连接后的回调业务逻辑 } else { //节点事件回调逻辑,可以根据事件类型和节点路径进一步区分具体节点不同事件类型的回调逻辑,这些事件回调都是一次性的,后续相同事件发生不会再回调,想要后续继续回调可以在回调事件中再调用对应的事件比如getChildren("/earl",true)来实现,但是这种在一个process方法中写完所有回调逻辑的方式不优雅;回调的业务逻辑一般不写在该process方法中,一般是在业务方法中通过重载方法getChildren("/earl",watcher)传参一个Watcher类型的匿名实现来替换布尔类型的watch变量,在匿名实现需要重写的process方法中去自定义回调逻辑,这种方式更方便代码的组织和修改,读起来也更容易,如下业务代码所示 } } }); countDownLatch.await(); System.out.println("业务操作"); //常用的事件监听和回调方式 List<String> children = zooKeeper.getChildren("/earl", new Watcher() { @Override public void process(WatchedEvent event) { System.out.println("节点/earl的子节点发生变化触发的回调"); //如果需要多次回调,回调的方式一般是把该监听方法封装成一个单独的方法,在该方法的回调中递归调用方法本身,如果只是一次回调则只需要这种实现即可 } }); //这个等待回调的方式有点野蛮,感觉JUC里面的保护性暂停用在这里很不错 System.in.read(); } catch (IOException e) { e.printStackTrace(); } catch (InterruptedException e) { e.printStackTrace(); } finally { if (zooKeeper != null) { try { zooKeeper.close(); } catch (InterruptedException e) { e.printStackTrace(); } } } } - 在Zookeeper对象的构造方法传参watcher对象中通过

API

String ---> zookeeper.create(final String path,byte[] data,List<ACL> acl,CreateMode createMode) throws KeeperException, InterruptedException- 功能解析:创建指定数据、指定数据下的节点,返回值为被创建节点的路径

- 使用示例:

zooKeeper.create("/earl/testJavaClient", "Hello zookeeper".getBytes(), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);- 示例含义:创建一个路径为

/earl/testJavaClient,数据内容为Hello zookeeper,允许所有客户端对该节点进行任何操作的永久节点

- 示例含义:创建一个路径为

- 补充说明:

- 数据内容

data要求传参一个byte数组,可以通过字符串.getBytes()方法获取对应的byte数组 - 权限

List<ACL>有专门的枚举类ZooDefs.Ids,常用的三种权限包括ZooDefs.Ids.OPEN_ACL_UNSAFE:所有客户端都可以对创建的节点做任何操作ZooDefs.Ids.CREATOR_ALL_ACL:创建节点的客户端可以对节点做任何操作ZooDefs.Ids.READ_ACL_UNSAFE:所有客户端都能对创建的节点做读取操作

- 节点类型

createMode也使用专门的枚举类CreateMode,对应节点类型有以下四种CreateMode.PERSISTENT:创建的节点是永久节点CreateMode.EPHEMERAL:创建的节点是临时节点,这种方式创建的临时节点在调用zookeeper.close()方法后节点会直接被zookeeper服务器秒删CreateMode.EPHEMERAL_SEQUENTIAL:创建的节点是序列化临时节点CreateMode.PERSISTENT_SEQUENTIAL:创建的节点是序列化永久节点

- 数据内容

Stat ---> zookeeper.exists(String path, boolean watch) throws KeeperException, InterruptedException- 功能解析:判断指定路径节点是否存在,如果返回值为

null说明对应节点不存在,如果返回值不为null说明对应的节点存在;第一个参数是指定节点路径,第二个参数是指定是否要监听,指定true表示要监听时间,指定false表示不监听 - 使用示例:

zooKeeper.exists("/earl/testJavaClient", false);- 示例含义:查询路径为

/earl/testJavaClient的节点是否存在

- 示例含义:查询路径为

- 补充说明:

exists方法相当于zookeeper中的stat指令,可以通过该方法的重载方法来做对节点删除和节点创建事件的监听

- 功能解析:判断指定路径节点是否存在,如果返回值为

byte[] ---> zookeeper.getData(String path, boolean watch, Stat stat) throws KeeperException, InterruptedException- 功能解析:查询已经存在的指定路径节点的内容数据,这里传参

stat是zooKeeper.exists("/earl/testJavaClient", false);的返回值,暂时认为要查询指定节点的内容数据必须先查询该节点是否存在。第二个参数是指定是否要监听,指定true表示要监听时间,指定false表示不监听 - 使用示例:

zooKeeper.getData("/earl/testJavaClient", false, exists);- 示例含义:查询已经存在节点

/earl/testJavaClient的数据内容

- 示例含义:查询已经存在节点

- 补充说明:

getData方法相当于zookeeper中的get指令,可以通过该方法的重载方法来做对节点的数据变化监听

- 功能解析:查询已经存在的指定路径节点的内容数据,这里传参

List<String> ---> zookeeper.getChildren(String path, boolean watch) throws KeeperException, InterruptedException- 功能解析:查询一个指定节点下的全部子节点

- 使用示例:

zooKeeper.getChildren("/earl", false);- 示例含义:查询节点

/earl下的所有子节点

- 示例含义:查询节点

- 补充说明:

getChildren方法相当于zookeeper中的ls指令,可以通过该方法的重载方法来做对子节点的创建、删除、数据内容变化监听

Stat ---> zookeeper.setData(final String path, byte[] data, int version) throws KeeperException, InterruptedException- 功能解析:更新一个指定节点的数据内容,第三个参数

version需要使用exists方法查询获取Stat返回值,用stat.getVersion()来获取指定路径节点的版本号,如果更新时发现当前数据版本号和传参不一致,更新操作就会失败;即更新操作也需要事先查询指定节点是否存在且获取Stat返回值作为更新方法传参 - 使用示例:

zooKeeper.setData("/earl/testJavaClient", "hello earl".getBytes(), exists.getVersion())- 示例含义:把节点

/earl/testJavaClient下的数据内容更新为hello earl

- 示例含义:把节点

- 补充说明:

- 版本号也可以指定为-1,表示更新操作不关心版本号,本次更新操作一定会成功

- 功能解析:更新一个指定节点的数据内容,第三个参数

void ---> zookeeper.delete(final String path, int version) throws InterruptedException, KeeperException- 功能解析:删除指定路径节点,如果当前版本号和指定版本号不一致则删除失败

- 使用示例:

zooKeeper.delete("earl/testJavaClient",exists.getVersion());- 示例含义:删除节点

/earl/testJavaClient

- 示例含义:删除节点

- 补充说明:

- 版本号也可以指定为-1,表示删除操作不关心版本号,本次删除操作一定会成功

- 如果要删除的节点不存在仍然执行了该方法会抛出异常,注意凡是涉及到事件监听的方法调用,调用事件监听方法的线程在事件发生前不能提前结束执行,事件发生时线程运行结束会导致无法执行事件监听成功后的回调,因此调用事件监听方法的线程不能在事件发生前结束,不能在等待期间发生异常,发生了异常如果没有捕获处理也会直接结束当前线程

slf4j-log4j12

Curator

- Curator是Netflix贡献给Apache的,目前属于Apache的顶级项目,Curator针对Zookeeper提供了很多高级工具的封装,比如分布式锁、还解决了Zookeeper官方客户端诸如失败重连、多次反复事件监听很多缺陷

- Curator主要解决了Zookeeper官方客户端的三类问题

- 封装

ZooKeeper client与ZooKeeper server之间的连接处理 - 提供了一套Fluent风格的操作API

- 提供基于

ZooKeeper各种应用场景实现, 比如分布式锁服务、集群领导选举、共享计数器、缓存机制、分布式队列等抽象封装,这些实现都遵循Zookeeper的最佳实践,并考虑了各种极端情况

- 封装

- Curator由核心框架

curator-framework和curator-recipes两部分组成,curator-framework主要对Zookeeper的底层做了许多封装,便于用户更方面操作Zookeeper;curator-recipes对一些Zookeeper典型应用场景比如分布式锁做了封装

-

引入依赖

- 使用Curator需要分别引入

curator-framework和curator-recipes,注意这两个依赖中都含有zookeeper官方客户端依赖,使用zookeeper客户端需要与服务端的版本相同,实际上也没这么严格,我这里使用zookeeper3.5.7的服务器使用zookeeper3.7.0的客户端也没有出现任何问题,使用Curator并不需要使用zookeeper客户端,因此为了避免版本冲突问题,最好将zookeeper客户端从curator-framework和curator-recipes中排除出去,有需要的时候再单独进行引入

<dependency> <groupId>org.apache.curator</groupId> <artifactId>curator-framework</artifactId> <version>4.3.0</version> <exclusions> <exclusion> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> </exclusion> </exclusions> </dependency> <dependency> <groupId>org.apache.curator</groupId> <artifactId>curator-recipes</artifactId> <version>4.3.0</version> <exclusions> <exclusion> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> </exclusion> </exclusions> </dependency> <dependency> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> <version>3.4.14</version> </dependency> - 使用Curator需要分别引入

-

编写配置类初始化

curator-framework的客户端CuratorFrameWork,该客户端对象类似于Redis客户端中的RedisTemplate,Redisson中的RedissonClient-

配置类

CuratorFramework是一个接口,该接口有一个子接口WatcherRemoveCuratorFramework和一个子实现类CuratorFrameworkImpl,子实现类CuratorFrameworkImpl有两个子类NamespaceFacade和WatcherRemovalFacade,一般常用工厂类的newClient方法来初始化CuratorFramework组件,该方法有两个重载方法CuratorFramework. newClient()- Zookeeper官方客户端是不具备连接重试功能的,这就是Curator对Zookeeper官方客户端做出的优化之一

- 其中

newClient(String connectString, RetryPolicy retryPolicy)方法不需要指定会话和连接超时时间- 第一个参数是指定Zookeeper服务器地址,参数格式为

192.168.200.132:2181,注释说这是一个服务器地址列表,虽然注释没指明具体格式,猜测使用逗号分隔多个服务器地址 - 第二个参数

retryPolicy是指定重试策略,RetryPolicy是一个接口,有两个直接子类分别是SleepingRetry和RetryForever,前者表示有间歇的重试,后者表示持续重试,持续重试可能导致服务器浪费大量的资源,一般不推荐使用该策略;可以使用SleepingRetry的子类RetryNTime,该策略可以指定每隔多少时间重试一次,最多重试多少次;一般使用SleepingRetry的子类ExponentialBackoffRetry指数补偿重试,除了可以指定重试次数,还可以指定一个初始间隔时间,第一次在初始间隔时间重试,以后每次重试的间隔时间会递增,重试次数越多间隔时间越长,这样的策略设计更符合节省服务器资源的标准

- 第一个参数是指定Zookeeper服务器地址,参数格式为

- 第二个重载方法

CuratorFramework newClient(String connectString, int sessionTimeoutMs, int connectionTimeoutMs, RetryPolicy retryPolicy)需要额外指定会话和连接超时时间

- 初始化

CuratorFramework对象以后需要使用start方法手动启动一下,否则Curator底层很多方法或者功能都是不工作的,即使调用了也无法使用,Curator的大多功能都通过该对象进行调用