首先logistic 回归是一个用于二分分类的算法。举个例子来说,我想要识别出图片中是否是一只猫,如果是猫的话输出y=1,如果不是输出y=0。因为计算机要保存一张图片要保存三个独立矩阵,分别对应图片左下角的红、绿、蓝三个颜色通道。所以如果一个图片的像素是64 * 64,那么就有三个64 * 64的矩阵。我们将这三个矩阵的像素亮度值放进一个特征向量x中。向量x的总维度就是64* 64 * 3 = 12288。我们用nx = 12288来表示输入的特征向量x的维度。在二分分类问题中,目标是训练处一个分类器,它以图片的特征向量x作为输入,来预测输出结果y是1还是0。

接下来我们用(x,y)表示一个单独样本、x是nx维的特征向量、y={0,1}、训练集由m个训练样本构成。因此(x(1),y(1))表示样本一的输入和输出。所以m training examples = {

(x(1),y(1)),(x(2),y(2)),…,(x(m),y(m))}。在这里我们定义一个大写的由X来表示的矩阵,它由训练集中的x(1),x(2),…,x(m)组成。

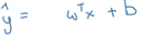

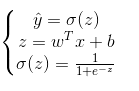

当给出了输入x时,我们想要预测这张图片上是一只猫的概率,这里用y帽表示。由于这张图片上是否是猫,是由0或1决定的,所以y帽的范围是0~1。如果我们现在已知logistic回归方程的参数是w,也是一个nx维的向量,实数是b时,我们可以写出回归方程。

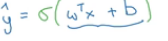

但是由于y帽的范围是0~1所以我们要将方程写成这种形式。

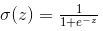

该函数也称为sigmoid(z)函数,如下图所示。

其中w^T*x+b就相当于z,而

所以将该方程改写成下列形式。

不难看出z的值越大,e^-z越趋近于0,y帽的值越接近1 ;同理z的值越小,y帽的值越接近0。所以当我们实现logistic回归时,我们要做的是学习参数w和b 。想要训练好logistic回归模型的参数w以及b需要定义一个成本函数。

损失函数

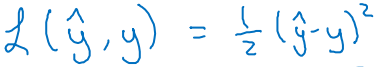

我们通过定义损失函数(误差函数)来衡量预测输出值y帽和y的实际值有多接近。我们可以定义损失为y帽和y的差的平方。误差平方越小越好。

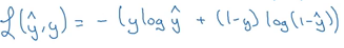

但是通常在logistic回归中大家不这样定义,因为最后我们会得到很多个局部最优解,梯度下降法可能找不到全局最优值。所以我们在logistic回归中使用下面所写的损失函数。

损失函数是在单个训练样本中定义的,它衡量了在单个训练样本上的表现。

成本函数

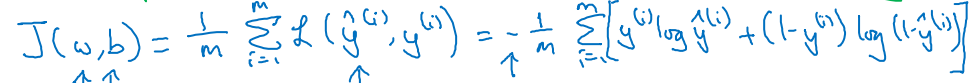

它衡量的是在全体训练样本上的表现。

成本函数是基于参数的总成本,所以我们要找到合适的参数w和b,就要让成本函数里J尽可能地小。

452

452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?