llama.cpp的主要目标是在本地和云端的各种硬件上以最小的设置和最先进的性能实现LLM推理。是一个专为大型语言模型(LLM)设计的高性能推理框架,完全使用C和C++编写,没有外部依赖,这使得它可以很容易地被移植到不同的操作系统和硬件平台上。简化大型语言模型部署流程。

一、下载llama.cpp

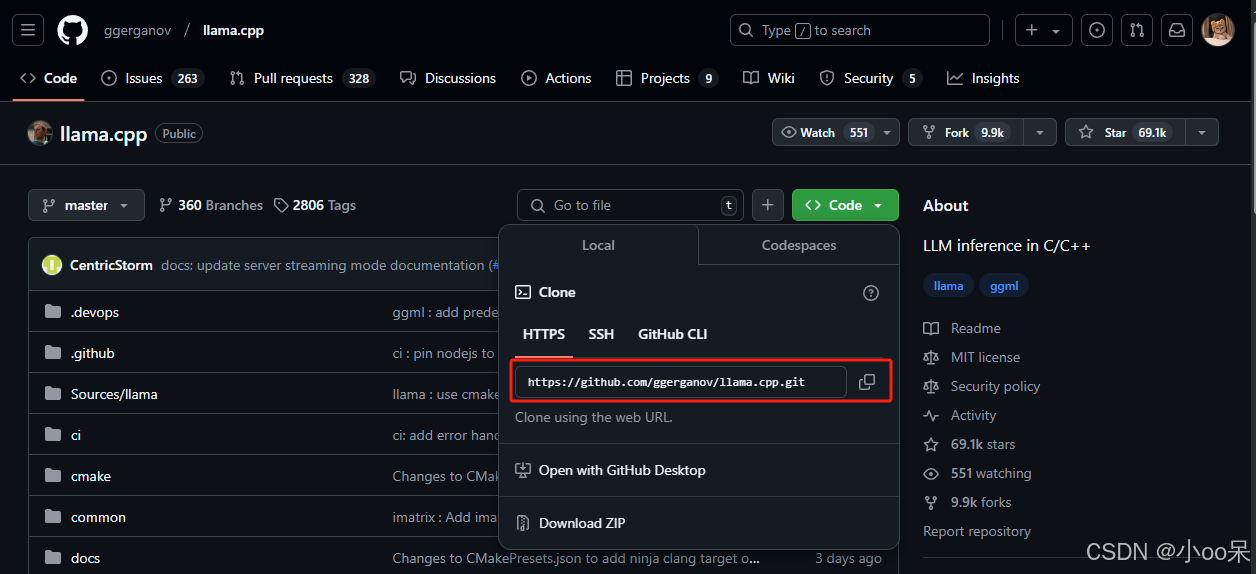

1、访问其GitHub官方仓库:llama.cpp

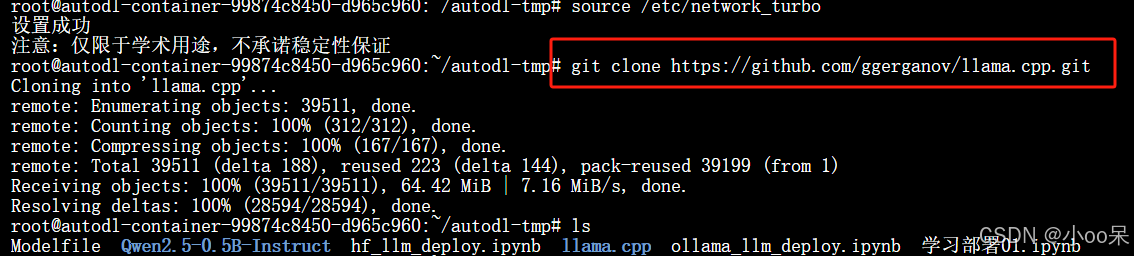

2、在你的服务器指定路径下克隆仓库

git clone https://github.com/ggerganov/llama.cpp.git

3、安装llama.cpp所需环境

pip install -r requirements.txt

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?