chatglm3-6b是智谱AI开源的一款大模型,参数规模为62亿,相比于动辄千亿规模参数的大模型来说,这个模型,只需要一块3090的显卡就可以进行推理,非常适合本地化部署。

文章目录

1、克隆模型代码

//从gitee下载模型代码。如果你能科学上网,也可以从github下载

https://gitee.com/mirrors/chatglm3.git

代码检出成功后,进入代码的根目录

cd ChatGLM3

2、安装模型依赖

在模型代码的根目录,执行下述的命令安装模型的相关依赖。(机器的网速得有保证,否则这个过程会很长)

//这里使用的是清华的镜像源。清华的镜像源如果不行,也可以考虑使用阿里的镜像源:https://mirrors.aliyun.com/pypi/simple/

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

3、git-lfs安装

由于模型很大(大概10个G左右),直接用git下载可能会失败。这里我们使用git-lfs命令来下载模型,lfs是Large File Storage的缩写,用来帮助git管理大的文件。git lfs并不是git的命令,所以我们需要先安装这个命令

下面提供了3种系统的安装方式

3.1、ubuntu系统

1. curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

2. sudo apt-get install git-lfs

//验证git-lfs命令

3. git lfs install

3.2、centos系统

1、curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.rpm.sh | sudo bash

2、sudo yum install git-lfs

//验证

3、git lfs install

3.3、mac系统

使用brew安装

brew install git-lfs

4、下载模型

git lfs install

//从modelscope下载

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

5、启动模型

进入ChatGLM3/basic_demo目录,修改cli_demo.py文件,指定我们上面下载的模型的路径,我这里使用的是绝对路径

MODEL_PATH = os.environ.get('MODEL_PATH', '/home/wuyou/LLM/code/ChatGLM3/chatglm3-6b')

启动模型

python basic_demo/cli_demo.py

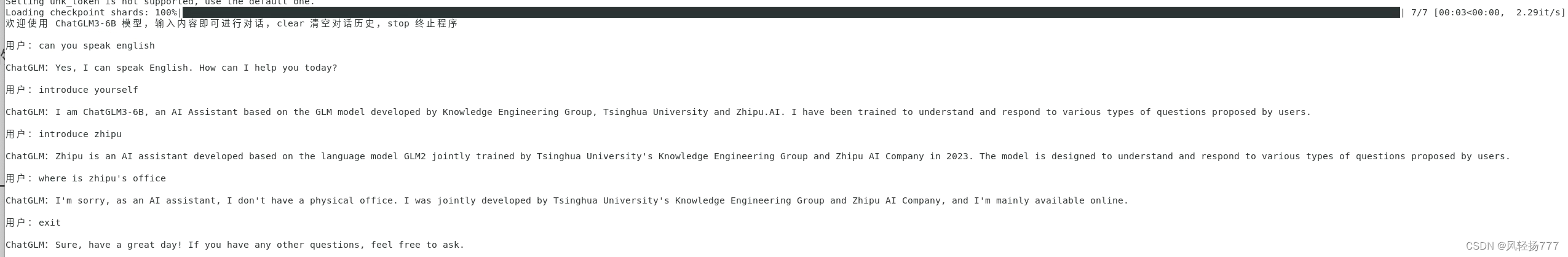

出现下面的黑色进度条,并且进度是100%,代表模型启动成功。然后我们就可以和模型对话了

6、问题

6.1、机器没有gpu

这个可以从淘宝上租用gpu,挺便宜的。直接使用cpu,模型推理速度很慢。

6.2、启动模型报错

这种问题基本都是模型下载的不全。

保证你机器的网速够快,否则时间长了,就有一些超时什么的,导致模型下载的不全。

如果你从国内的站点下载模型,注意关掉科学上网

7、参考资料

1)、极客时间-<AI大模型实战高手课>

2)、git-lfs安装。https://blog.csdn.net/michaelshare/article/details/83183806

1008

1008

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?