文章目录

八股文

本文章是一篇内容较为全面的java秋招八股文,内容包含数据结构、计算机网络、数据库、Redis、消息队列、JavaSE、JVM、JUC、海量数据题目、高并发场景、项目的亮点难点、ssm框架、dubbo框架等等。这是我整个秋招不停面试的总结和反思,最后也是靠它拿到了菜鸟的offer,希望可以帮助到马上进行秋招的朋友。

数据结构

Java的排序Arrays.sort()是怎么做的

先说总结:

数组长度为n,则1 <= n < 47 使用插入排序

数组长度为n,则47 <= n < 286 使用使用快速排序

数组长度为n,则286 < n 使用归并排序或快速排序(有一定顺序使用归并排序,毫无顺序使用快排)

n的数量小的话,可能插入排序比快排更快。当n的数量47到286之间时,用快速排序就行了。当大于286时,先判断数组结构是不是基本有序的(官方称之为有结构的),如果是的话就用归并排序,如果不是的话就用快速排序。因为数组数量太少不值得去判断数组结构是不是基本有序。

判断是不是有结构的代码: 时间复杂度大概O(n)

// Check if the array is nearly sorted

for (int k = left; k < right; run[count] = k) {

if (a[k] < a[k + 1]) { // ascending

while (++k <= right && a[k - 1] <= a[k]);

} else if (a[k] > a[k + 1]) { // descending

while (++k <= right && a[k - 1] >= a[k]);

for (int lo = run[count] - 1, hi = k; ++lo < --hi; ) {

int t = a[lo]; a[lo] = a[hi]; a[hi] = t;

}

} else { // equal

for (int m = MAX_RUN_LENGTH; ++k <= right && a[k - 1] == a[k]; ) {

if (--m == 0) {

sort(a, left, right, true);

return;

}

}

}

/*

* The array is not highly structured,

* use Quicksort instead of merge sort.

*/

if (++count == MAX_RUN_COUNT) {

sort(a, left, right, true);

return;

}

}

这里主要作用是看他数组具不具备结构:实际逻辑是分组排序,每降序为一个组,像1,9,8,7,6,8。9到6是降序,为一个组,然后把降序的一组排成升序:1,6,7,8,9,8。然后最后的8后面继续往后面找。

每遇到这样一个降序组,++count,当count大于MAX_RUN_COUNT(67),被判断为这个数组不具备结构(也就是这数据时而升时而降),然后送给之前的sort(里面的快速排序)的方法(The array is not highly structured,use Quicksort instead of merge sort.)

如果count少于MAX_RUN_COUNT(67)的,说明这个数组还有点结构,就继续往下走下面的归并排序。

快速排序

为什么基准元素(第一个)和处理完的元素互换的时候,能保证处理完的元素是比基准元素小的呢?

因为是让right指针先走的,且看这几种情况:

- left right交换完中间就剩一个元素了,right先走,如果中间的数大于基准数,那么right还要走,走到和left相等,left这时候是比基准小的

- 如果是递增的,那么right一路左移动,最后基准元素等于left等于right,也满足

class Solution {

public void quickSort(int[] nums,int start,int end) {

// 遵守循环不变量,start和end为左闭右闭结构

// 如果传过来的数组只有一个,或者end比start还小,就没必要继续了

if(start >= end){

return;

}

// 基准选本数组的第一个

int pivot = nums[start];

// 两个指针开始 左从基准元素开始 右从最右边开始

int left = start;

int right = end;

while(left<right){

// right指针先走,找到第一个小于基准的数

while(nums[right] >= pivot && left<right){

right--;

}

while(nums[left] <= pivot && left<right){

left++;

}

if(left<right){

int temp = nums[left];

nums[left] = nums[right];

nums[right] = temp;

}

}

// 将基准元素和left交换顺序

nums[start] = nums[left];

nums[left] = pivot;

// 遍历基准左边的数组

if(start<left){

quickSort(nums,start,left-1);

}

// 遍历基准右边的数组

if(left<end){

quickSort(nums,left+1,end);

}

}

}

// 测试:

class test{

public static void main(String[] args) {

Solution solution =new Solution();

int[] nums = new int[]{6 ,1 ,2 ,5 ,9 ,3 ,4 ,7 ,10 ,8};

solution.quickSort(nums,0,nums.length-1);

for (int a:nums){

System.out.print(a);

}

}

}

递归是n方,而快排使用二分思想,n✖️logn 因为递归深度是logn。

选第一个元素为基准,然后分成两拨。

假设我们现在对“6 1 2 7 9 3 4 5 10 8”这个10个数进行排序。首先在这个序列中随便找一个数作为基准数(不要被这个名词吓到了,就是一个用来参照的数,待会你就知道它用来做啥的了)。为了方便,就让第一个数6作为基准数吧。接下来,需要将这个序列中所有比基准数大的数放在6的右边,比基准数小的数放在6的左边,类似下面这种排列:

3 1 2 5 4 6 9 7 10 8

在初始状态下,数字6在序列的第1位。我们的目标是将6挪到序列中间的某个位置,假设这个位置是k。现在就需要寻找这个k,并且以第k位为分界点,左边的数都小于等于6,右边的数都大于等于6。想一想,你有办法可以做到这点吗?

方法其实很简单:分别从初始序列“6 1 2 7 9 3 4 5 10 8”两端开始“探测”。先从右往左找一个小于6的数,再从左往右找一个大于6的数,然后交换他们。这里可以用两个变量i和j,分别指向序列最左边和最右边。我们为这两个变量起个好听的名字“哨兵i”和“哨兵j”。刚开始的时候让哨兵i指向序列的最左边(即i=1),指向数字6。让哨兵j指向序列的最右边(即=10),指向数字。

快速排序如何优化?

如果选第一个,数组基本有序的话,不就退化为冒泡了吗,空间复杂度还高,怎么优化呢

随机基准

在待排数组有序或基本有序的情况下,选择使用固定基准影响快排的效率。为了解决数组基本有序的问题,可以采用随机基准的方式来化解这一问题。算法如下:

int Random(int a[], int low, int high)//在low和high间随机选择一元素作为划分的基准

{

srand(time(0));

int pivot = rand()%(high - low) + low;

Swap(a[pivot],a[low]); //把随机基准位置的元素和low位置元素互换

return a[low];

}

此时,原来Partition()函数里的T x = a[low];相应的改为T x = Random(a, low, high);

虽然使用随机基准能解决待排数组基本有序的情况,但是由于这种随机性的存在,对其他情况的数组也会有影响(若数组元素是随机的,使用固定基准常常优于随机基准)。随机数算法(Sherwood算法)能有效的减少升序数组排序所用的时间,数组元素越多,随机数算法的效果越好。可以试想,上述升序数组中有10万个元素而且各不相同,那么在第一次划分时,基准选的最差的概率就是十万分之一。当然,选择最优基准的概率也是十万分之一,随机数算法随机选择一个元素作为划分基准,算法的平均性能较好,从而避免了最坏情况的多次发生。许多算法书中都有介绍随机数算法,因为算法对程序的优化程度和下面所讲的三数取中方法很接近,所以我只记录了一种方法的运行时间。

三数取中

由于随机基准选取的随机性,使得它并不能很好的适用于所有情况(即使是同一个数组,多次运行的时间也大有不同)。目前,比较好的方法是使用三数取中选取基准。它的思想是:选取数组开头,中间和结尾的元素,通过比较,选择中间的值作为快排的基准。其实可以将这个数字扩展到更大(例如5数取中,7数取中等)。这种方式能很好的解决待排数组基本有序的情况,而且选取的基准没有随机性。

例如:序列[1][1][6][5][4][7][7],三个元素分别是[1]、[5]、[7],此时选择[5]作为基准。

第一趟:[1][1][4][5][6][7][7]

三数取中算法如下:

int NumberOfThree(int arr[],int low,int high)

{

int mid = low + ((high - low) >> 1);//右移相当于除以2

if (arr[mid] > arr[high])

{

Swap(arr[mid],arr[high]);

}

if (arr[low] > arr[high])

{

Swap(arr[low],arr[high]);

}

if (arr[mid] > arr[low])

{

Swap(arr[mid],arr[low]);

}

//此时,arr[mid] <= arr[low] <= arr[high]

return arr[low];

}

快排3.0随机版本,partition是划分成三部分 小于部分 等于部分 大于部分 等于部分不止一个 荷兰国旗问题

归并排序

归并排序过程 需要额外用一个数组空间,比如最后那两个,两个指针,在两个有序的数组中按照顺序放到一个新数组中

从小的,各自有序的子数组,慢慢归并到大数组

public class MergeSort {

public static void main(String[] args) {

int[] nums = new int[]{1,3,2,1,7,5,4,6};

mergeSort(nums,0,nums.length-1);

for (int a:nums){

System.out.println(a);

}

}

// 归并排序

public static void mergeSort(int[] nums,int left,int right){

// base case 两指针指向一个了

if (left == right){

return;

}

int mid = (left+right)/2;

mergeSort(nums,left,mid);

mergeSort(nums,mid+1,right);

merge(nums,left,mid,right);

}

// 归并

public static void merge(int[] nums,int left,int mid,int right){

int[] help = new int[right-left+1];

int i=0;

int cur1=left;

int cur2=mid+1;

while (cur1 <=mid && cur2 <=right){ // 左右两个数组,两个指针,放更大的数

help[i++] = nums[cur1]<nums[cur2]?nums[cur1++]:nums[cur2++];

}

// 如果用右面的用尽了,把左面剩余的加入

while (cur1<=mid){

help[i++] = nums[cur1++];

}

// 如果左面的用尽了,把右面剩余的加入

while (cur2<=right){

help[i++] = nums[cur2++];

}

// 把归并的数组复制到原数组中

for (int j = 0; j < help.length; j++) {

nums[left+j] = help[j];

}

}

}

堆排序

堆排序的地位远远没有堆结构重要

堆排序是稳定在O N*logN 复杂度,空间复杂度稳定在O(1)的,性能不错

大根堆、小根堆,以大根堆举例,大根堆就是一个完全二叉树,其结点的值比子树的结点值都大,就是爸爸大于儿子

不是维护一个真的树结构,只是一个数组结构,使用数组下标就可以模拟树的父子关系,使用heapSize控制堆结点数量

1.往大根堆插入结点:插入后比较父结点和自己的大小,如果自己大就交换,该while到达根结点后,自己就是父 index-1除2也是0,所以也退出循环

2.还有一个重要操作,heapify,如果把最大值拿掉,把堆最后一个元素放到第一位,就要重新调整回大根堆,heapify就是把当前元素下沉到合适的位置

两个孩子中最大的那个跟当前比较,如果比当前的大,当前的和最大孩子交换位置

代码:

取大根堆第一个,就是最大的,和最后一个数,交换,把排序好的剔除出大根堆,新的根调整成大根堆,就行了。

package Sort;

public class HeapSort {

public static void main(String[] args) {

int[] nums = new int[]{1,3,2,-1,8,4};

heapSort(nums);

for (int a:nums){

System.out.println(a);

}

}

public static void heapSort(int[] nums){

if (nums == null || nums.length < 2){

return;

}

// 建立大根堆策略1:从左到右插入,O(N*logN),但是性能不太好,因为整个数组已经给出了,没必要一个个插入

// for (int i = 0; i < nums.length; i++) { // O(N)

// heapInsert(nums,i); // O(logn)

// }

// 建立大根堆策略2:类似与王道的策略,完全二叉树从后往前,先保证小树是大根堆,然后调整当前结点,让大树慢慢也变成大根堆,不需要一个个插入,只需要把数组调整成大根堆就行了

for (int i = nums.length-1; i >= 0 ; i--) { // 复杂度 O(N)比上面的从左往右插入 N* logN 快点

heapify(nums,i,nums.length);

}

int heapSize = nums.length;

swap(nums,0,--heapSize); // 已经排序好的部分,剔除大根堆

while(heapSize>0){ // o(N )

heapify(nums,0,heapSize); // O(logn)

swap(nums,0,--heapSize);

}

}

// 往堆里插入数据

public static void heapInsert(int[] nums,int index){

while(nums[index] > nums[(index-1)/2]){ // 如果比父亲的值大,也包含了边界判断,不能比根还小,等于0就不满足了

swap(nums,index,(index-1)/2);

index = (index-1)/2; // 交换完后索引指向父结点,接着比较

}

}

// 下沉调整

public static void heapify(int[] nums,int index,int heapSize){

// heapSize控制了堆的界限,而不是看数组下标

int left = index*2+1; // 左孩子的下标

while (left < heapSize){ // 下方还有孩子的时候

int largest = left+1 < heapSize && nums[left+1] > nums[left]?left+1:left; // 取左右孩子最大值下标,如果右孩子不在堆里,只能用左孩子

largest = nums[largest] > nums[index]?largest:index; // 最大孩子和当前比较

if (largest == index){ // 当前最大,下沉可以结束了

break;

}

// 孩子大,交换

swap(nums,largest,index);

index = largest;

left = index*2+1;

}

}

public static void swap(int[] nums,int i,int j){

int temp = nums[i];

nums[i] = nums[j];

nums[j] =temp;

}

}

LRU缓存(lfu哈希表加小根堆即可)

明显需要实现一个带访问顺序的Hash表的数据结构,Java中已经有了就是LinkedHashMap

分析上面的操作过程,要让 put 和 get 方法的时间复杂度为 O(1),我们可以总结出 cache 这个数据结构必要的条件:

1、显然 cache 中的元素必须有时序,以区分最近使用的和久未使用的数据,当容量满了之后要删除最久未使用的那个元素腾位置。

2、我们要在 cache 中快速找某个 key 是否已存在并得到对应的 val;

3、每次访问 cache 中的某个 key,需要将这个元素变为最近使用的,也就是说 cache 要支持在任意位置快速插入和删除元素。

那么,什么数据结构同时符合上述条件呢?哈希表查找快,但是数据无固定顺序;链表有顺序之分,插入删除快,但是查找慢。所以结合一下,形成一种新的数据结构:哈希链表 LinkedHashMap。

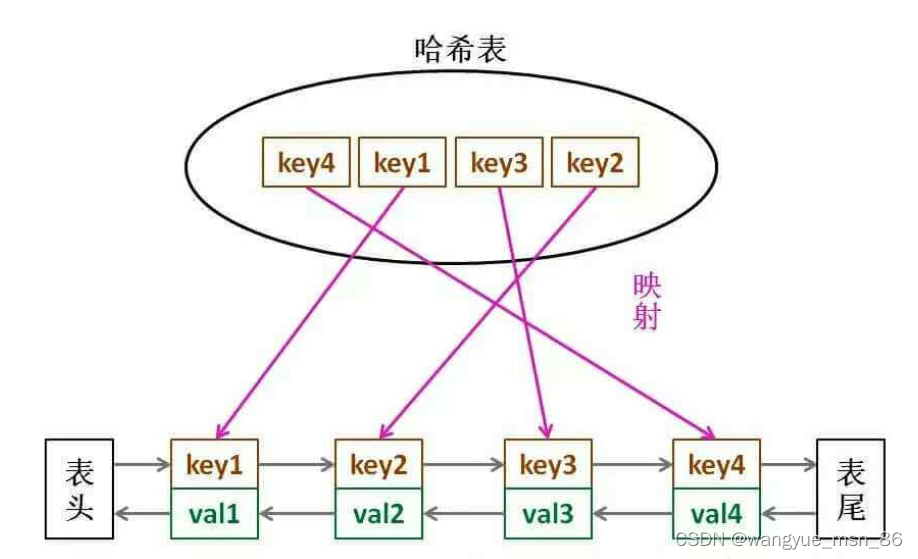

LRU 缓存算法的核心数据结构就是哈希链表,双向链表和哈希表的结合体。这个数据结构长这样:

我们把entry维护为一个双向链表就行了,维护一个头结点和尾结点,HashMap中的entry只指向了后继,但是这里是双向的,就是为了方便删除来维护访问顺序,我们把最右边的理解为最近访问的,最左边的理解为最久未访问的就行了。

class Node {

public int key, val;

public Node next, prev;

public Node(int k, int v) {

this.key = k;

this.val = v;

}

}

然后依靠我们的 Node 类型构建一个双链表,实现几个 LRU 算法必须的 API:

class DoubleList {

// 头尾虚节点

private Node head, tail;

// 链表元素数

private int size;

public DoubleList() {

// 初始化双向链表的数据

head = new Node(0, 0);

tail = new Node(0, 0);

head.next = tail;

tail.prev = head;

size = 0;

}

// 在链表尾部添加节点 x,时间 O(1)

public void addLast(Node x) {

x.prev = tail.prev;

x.next = tail;

tail.prev.next = x;

tail.prev = x;

size++;

}

// 删除链表中的 x 节点(x 一定存在)

// 由于是双链表且给的是目标 Node 节点,时间 O(1)

public void remove(Node x) {

x.prev.next = x.next;

x.next.prev = x.prev;

size--;

}

// 删除链表中第一个节点,并返回该节点,时间 O(1)

public Node removeFirst() {

if (head.next == tail)

return null;

Node first = head.next;

remove(first);

return first;

}

// 返回链表长度,时间 O(1)

public int size() { return size; }

}

注意我们实现的双链表 API 只能从尾部插入,也就是说靠尾部的数据是最近使用的,靠头部的数据是最久为使用的。

有了双向链表的实现,我们只需要在 LRU 算法中把它和哈希表结合起来即可,先搭出代码框架:

class LRUCache {

// key -> Node(key, val)

private HashMap<Integer, Node> map;

// Node(k1, v1) <-> Node(k2, v2)...

private DoubleList cache;

// 最大容量

private int cap;

public LRUCache(int capacity) {

this.cap = capacity;

map = new HashMap<>();

cache = new DoubleList();

}

先不慌去实现 LRU 算法的 get 和 put 方法。由于我们要同时维护一个双链表 cache 和一个哈希表 map,很容易漏掉一些操作,比如说删除某个 key 时,在 cache 中删除了对应的 Node,但是却忘记在 map 中删除 key。

解决这种问题的有效方法是:在这两种数据结构之上提供一层抽象 API。

说的有点玄幻,实际上很简单,就是尽量让 LRU 的主方法 get 和 put 避免直接操作 map 和 cache 的细节。我们可以先实现下面几个函数:

/* 将某个 key 提升为最近使用的 */

private void makeRecently(int key) {

Node x = map.get(key);

// 先从链表中删除这个节点

cache.remove(x);

// 重新插到队尾

cache.addLast(x);

}

/* 添加最近使用的元素 */

private void addRecently(int key, int val) {

Node x = new Node(key, val);

// 链表尾部就是最近使用的元素

cache.addLast(x);

// 别忘了在 map 中添加 key 的映射

map.put(key, x);

}

/* 删除某一个 key */

private void deleteKey(int key) {

Node x = map.get(key);

// 从链表中删除

cache.remove(x);

// 从 map 中删除

map.remove(key);

}

/* 删除最久未使用的元素 */

private void removeLeastRecently() {

// 链表头部的第一个元素就是最久未使用的

Node deletedNode = cache.removeFirst();

// 同时别忘了从 map 中删除它的 key

int deletedKey = deletedNode.key;

map.remove(deletedKey);

}

这里就能回答之前的问答题「为什么要在链表中同时存储 key 和 val,而不是只存储 val」,注意 removeLeastRecently 函数中,我们需要用 deletedNode 得到 deletedKey。

也就是说,当缓存容量已满,我们不仅仅要删除最后一个 Node 节点,还要把 map 中映射到该节点的 key 同时删除,而这个 key 只能由 Node 得到。如果 Node 结构中只存储 val,那么我们就无法得知 key 是什么,就无法删除 map 中的键,造成错误。

上述方法就是简单的操作封装,调用这些函数可以避免直接操作 cache 链表和 map 哈希表,下面我先来实现 LRU 算法的 get 方法:

public int get(int key) {

if (!map.containsKey(key)) {

return -1;

}

// 将该数据提升为最近使用的

makeRecently(key);

return map.get(key).val;

}

总结:get的时候,就把原来的结点删了,插入到链表尾部。put的时候,也是到尾部

这样我们可以轻松写出 put 方法的代码:

public void put(int key, int val) {

if (map.containsKey(key)) {

// 删除旧的数据

deleteKey(key);

// 新插入的数据为最近使用的数据

addRecently(key, val);

return;

}

if (cap == cache.size()) {

// 删除最久未使用的元素

removeLeastRecently();

}

// 添加为最近使用的元素

addRecently(key, val);

}

至此,你应该已经完全掌握 LRU 算法的原理和实现了,我们最后用 Java 的内置类型 LinkedHashMap 来实现 LRU 算法,逻辑和之前完全一致,我就不过多解释了:

class LRUCache {

int cap;

LinkedHashMap<Integer, Integer> cache = new LinkedHashMap<>();

public LRUCache(int capacity) {

this.cap = capacity;

}

public int get(int key) {

if (!cache.containsKey(key)) {

return -1;

}

// 将 key 变为最近使用

makeRecently(key);

return cache.get(key);

}

public void put(int key, int val) {

if (cache.containsKey(key)) {

// 修改 key 的值

cache.put(key, val);

// 将 key 变为最近使用

makeRecently(key);

return;

}

if (cache.size() >= this.cap) {

// 链表头部就是最久未使用的 key

int oldestKey = cache.keySet().iterator().next();

cache.remove(oldestKey);

}

// 将新的 key 添加链表尾部

cache.put(key, val);

}

private void makeRecently(int key) {

int val = cache.get(key);

// 删除 key,重新插入到队尾

cache.remove(key);

cache.put(key, val);

}}

红黑树

红黑树的特点:

- 结点不是红色就是黑色

- 根结点和叶子结点是黑色的,这里的叶子结点不是通常意义上的叶子结点,是指的null值

- 红色结点不能相邻

- 任一结点到叶子结点(null)值的黑色一样多

本质上来看,红黑树没有严格的约束平衡,而是保证最大情况是最小情况的二倍,比如最大是红黑交替的,最小是全黑的,最多差二倍

查找的效率也是log n级别的,虽然查找比avl稍微差了一些,但是插入和删除的效率比avl高,由于hashmap常有插入和删除,并且concurrentHashMap加锁时,插入时间更是影响性能,所以使用红黑树。

红黑树的插入过程的调整:可以看到,最多涉及三层的改动(旋转和变色),要看叔叔结点的状态,所以整个性能比avl要好,avl旋转可能涉及到整个树的旋转

海量数据场景题目

海量数据场景中的题目,面试官的问题往往给出的是模糊的,这个时候也考验你问清楚问题的能力。

1.统计不同号码的个数(位图的各种思考)

题目描述

已知某个文件内包含大量电话号码,每个号码为8位数字,如何统计不同号码的个数?

这类题目其实是求解数据重复的问题。对于这类问题,可以使用位图法处理

8位电话号码可以表示的范围为00000000~99999999。如果用 bit表示一个号码,那么总共需要1亿个

bit,总共需要大约10MB的内存。

申请一个位图并初始化为0,然后遍历所有电话号码,把遍历到的电话号码对应的位图中的bit设置为1。

当遍历完成后,如果bit值为1,则表示这个电话号码在文件中存在,否则这个bit对应的电话号码在文件

中不存在。

最后这个位图中bit值为1的数量就是不同电话号码的个数了。

首先位图可以使用一个int数组来实现(在Java中int占用4byte)。

假设电话号码为 P,而通过电话号码获取位图中对应位置的方法为:

第一步,因为int整数占用4*8=32bit,通过 P/32 就可以计算出该电话号码在 bitmap 数组中的下标,从

而可以确定它对应的 bit 在数组中的位置。

第二步,通过 P%32 就可以计算出这个电话号码在这个int数字中具体的bit的位置。只要把1向左移

P%32 位,然后把得到的值与这个数组中的值做或运算,就可以把这个电话号码在位图中对应的位设置

为1。

这样极大的减少了内存,但是我感觉映射关系的设计不能直接设计对应的位,如果号码是以1300000000为最小值的话,那么需要进行一个映射,把位图的第一位映射为1300000000。

如果有移动,联通,电信三家的号码,分别是13,15,18打头的话,那么就三家各用各的位图,各用各的映射规则,先判断是哪家的,然后存到对应的位图中。

但是想解决位图稀疏数据存储问题怎么办,比如1,50001,98,45600222,我们至少需要初始化45600222位的bit数组,

在es,hive等知名开源组件中都应用过这种算法。

2.查找两个大文件共同的url个数

题目

给定 a、b 两个文件,各存放 50 亿个 URL,每个 URL 各占 64B,找出 a、b 两个文件共同的 URL。内

存限制是 4G。

分析

每个 URL 占 64B,那么 50 亿个 URL占用的空间大小约为 320GB。

5,000,000,000 * 64B ≈ 320GB

由于内存大小只有 4G,因此,不可能一次性把所有 URL 加载到内存中处理。

可以采用分治策略,也就是把一个文件中的 URL 按照某个特征划分为多个小文件,使得每个小文件大小

不超过 4G,这样就可以把这个小文件读到内存中进行处理了。首先遍历文件a,对遍历到的 URL 进行哈希取余 hash(URL) % 1000 ,根据计算结果把遍历到的 URL

存储到 a0, a1,a2, …, a999,这样每个大小约为 300MB。使用同样的方法遍历文件 b,把文件 b 中的

URL 分别存储到文件 b0, b1, b2, …, b999 中。这样处理过后,所有可能相同的 URL 都在对应的小文件

中,即 a0 对应 b0, …, a999 对应 b999,不对应的小文件不可能有相同的 URL。那么接下来,我们只需

要求出这 1000 对小文件中相同的 URL 就好了。

接着遍历 ai( i∈[0,999] ),把 URL 存储到一个 HashSet 集合中。然后遍历 bi 中每个 URL,看在

HashSet 集合中是否存在,若存在,说明这就是共同的 URL, 把共同的url记录到保存最终结果的大文件中。

总结

最后总结一下:

-

分而治之,进行哈希取余;

-

对每个子文件进行 HashSet 统计。

因为小文件是一个个处理的,HashSet也是记录小文件的内容,所以内存可以承担的下。

本题也可以使用布隆过滤器来处理,就可以直接在内存中操作了,布隆过滤器比较节省空间,但是有一定的误判率。把出现过的元素都存一下就行了。如果此元素之前还出现过就是重复的元素。

3. 出现频率最高的100个词

题目描述

假如有一个1G大小的文件,文件里每一行是一个词,每个词的大小不超过16byte,要求返回出现频率

最高的100个词。内存大小限制是10M

解法1

由于内存限制,我们无法直接将大文件的所有词一次性读到内存中。

可以采用分治策略,把一个大文件分解成多个小文件,保证每个文件的大小小于10M,进而直接将单个

小文件读取到内存中进行处理。

第一步,首先遍历大文件,对遍历到的每个词x,执行 hash(x) % 500 ,将结果为i的词存放到文件f(i)

中,遍历结束后,可以得到500个小文件,每个小文件的大小为2M左右;

第二步,接着统计每个小文件中出现频数最高的100个词。可以使用HashMap来实现,其中key为词,

value为该词出现的频率。

对于遍历到的词x,如果在map中不存在,则执行 map.put(x, 1)。

若存在,则执行 map.put(x, map.get(x)+1) ,将该词出现的次数加1。

第三步,在第二步中找出了每个文件出现频率最高的100个词之后,通过维护一个小顶堆来找出所有小

文件中出现频率最高的100个词。

具体方法是,遍历第一个文件,把第一个文件中出现频率最高的100个词构建成一个小顶堆。

如果第一个文件中词的个数小于100,可以继续遍历第二个文件,直到构建好有100个结点的小顶堆为

止。

继续遍历其他小文件,如果遍历到的词的出现次数大于堆顶上词的出现次数,可以用新遍历到的词替换

堆顶的词,然后重新调整这个堆为小顶堆。

当遍历完所有小文件后,这个小顶堆中的词就是出现频率最高的100个词。总结一下,这种解法的主要思路如下:

\1. 采用分治的思想,进行哈希取余

\2. 使用HashMap统计每个小文件单词出现的次数

\3. 使用小顶堆,遍历步骤2中的小文件,找出词频top100的单词

但是很容易可以发现问题,在第二步中,如果这个1G的大文件中有某个词词频过高,可能导致小文件大

小超过10m。这种情况下该怎么处理呢?

接下来看另外一种解法。

解法2

第一步:使用多路归并排序对大文件进行排序,这样相同的单词肯定是紧挨着的

多路归并排序对大文件进行排序的步骤如下:

① 将文件按照顺序切分成大小不超过2m的小文件,总共500个小文件

② 使用10MB内存分别对 500 个小文件中的单词进行排序

③ 使用一个大小为500大小的堆,对500个小文件进行多路排序,结果写到一个大文件中

其中第三步,对500个小文件进行多路排序的思路如下:

初始化一个最小堆,大小就是有序小文件的个数500。堆中的每个节点存放每个有序小文件对应的

输入流。

按照每个有序文件中的下一行数据对所有文件输入流进行排序,单词小的输入文件流放在堆顶。

拿出堆顶的输入流,并其下一行数据写入到最终排序的文件中,如果拿出来的输入流中还有数据的

话,那么将这个输入流再一次添加到栈中。否则说明该文件输入流中没有数据了,那么可以关闭这

个流。

循环这个过程,直到所有文件输入流都没有数据为止。

第二步:

① 初始化一个100个节点的小顶堆,用于保存100个出现频率最多的单词

② 遍历整个文件,一个单词一个单词的从文件中取出来,并计数

③ 等到遍历的单词和上一个单词不同的话,那么上一个单词及其频率如果大于堆顶的词的频率,那么放

在堆中,否则不放

最终,小顶堆中就是出现频率前100的单词了。

解法2相对解法1,更加严谨,如果某个词词频过高或者整个文件都是同一个词的话,解法1不适用。

4.海量数据排序问题

当所要排序的的数据量太多或者文件太大,无法直接在内存里排序,而需要依赖外部设备时,就会使用到外部排序(外部归并)。

1、算法描述

假设有一堆小文件要进行排序,即使是一个大文件,也要拆分成小文件,通过hash映射等方式,然后内存才可以处理小文件

-

依次读入每个文件块,在内存中对当前文件块进行排序(应用恰当的内排序算法,如快排),此时,每块文件相当于一个由小到大排列的有序队列;

-

在内存中建立一个小根堆,读入每块文件的队列头(如果是10路归并,堆的大小比10大就行);

-

弹出堆顶元素,如果元素来自第i块,则从第i块文件中补充一个元素到最小值堆。弹出的元素暂存至临时数组;

-

当临时数组存满时,将数组写至磁盘,并清空数组内容;

-

重复过程3、4,直至所有文件块读取完毕。

就这样,m路归并,从小的有序一步步变成最终大文件的有序。

计算机网络

三次握手和四次挥手

三次握手:

最开始,客户端和服务端都处于 CLOSE(关闭)状态,服务端监听客户端的请求,进入 LISTEN(监听) 状态。

客户端发送连接请求,进行第一次握手(同步位 SYN=1,序号字段 seq=x),发送完毕后,客户端就进入 SYN_SENT(同步已发送) 状态。

服务端确认连接,进行第二次握手(同步位 SYN=1,确认位 ACK=1,序号字段 seq=y,确认号字段 ack=x+1), 发送完毕后,服务端就进入 SYN_RCV(同步已接收) 状态。

客户端收到服务端的确认后,再次向服务端确认,进行第三次握手(确认位 ACK=1,确认号字段 ack=y+1),发送完毕后,客户端就进入 ESTABLISHED(连接已建立) 状态,当服务端接收到这个包时,也进入 ESTABLISHED(连接已建立) 状态。

为什么是三次握手?不是两次、四次? 第三次握手证明了客户端收信息的能力没问题

- 三次握手才可以阻止重复历史连接的初始化(主要原因)

- 三次握手才可以同步双方的初始序列号

- 三次握手才可以避免资源浪费

四次挥手:

为什么 TIME_WAIT 等待的时间是 2MSL?

MSL 是 Maximum Segment Lifetime,报文最大生存时间,它是任何报文在网络上存在的最长时间,超过这个时间报文将被丢弃。因为 TCP 报文基于是 IP 协议的,而 IP 头中有一个 TTL 字段,是 IP 数据报可以经过的最大路由数,每经过一个处理他的路由器此值就减 1,当此值为 0 则数据报将被丢弃,同时发送 ICMP 报文通知源主机。

MSL 与 TTL 的区别: MSL 的单位是时间,而 TTL 是经过路由跳数。所以 MSL 应该要大于等于 TTL 消耗为 0 的时间,以确保报文已被自然消亡。

TTL 的值一般是 64,Linux 将 MSL 设置为 30 秒,意味着 Linux 认为数据报文经过 64 个路由器的时间不会超过 30 秒,如果超过了,就认为报文已经消失在网络中了。

TIME_WAIT 等待 2 倍的 MSL,比较合理的解释是: 网络中可能存在来自发送方的数据包,当这些发送方的数据包被接收方处理后又会向对方发送响应,所以一来一回需要等待 2 倍的时间。

比如,如果被动关闭方没有收到断开连接的最后的 ACK 报文,就会触发超时重发 FIN 报文,另一方接收到 FIN 后,会重发 ACK 给被动关闭方, 一来一去正好 2 个 MSL。

为什么是4次挥手,三次挥手行吗?

四次挥手是因为服务器可能还有数据发送给客户端,所以收到客户端的Fin报文只能一个ACK,然后发送完剩下的数据后,再发送fin给客户端,「**没有数据要发送」并且「开启了 TCP 延迟确认机制」,那么第二和第三次挥手就会合并传输,这样就出现了三次挥手。**当没有数据发送时,默认就是三次挥手,所以实际上抓包的话,3次挥手比四次挥手的情况还要多。

TCP相关面试题

TCP面向字节流/粘包拆包问题

TCP是面向字节流的,udp是面向报文的,怎么理解?

当用户消息用udp发送时,操作系统不会对消息拆分,发送出的udp报文的数据就是完整的用户数据。

但是TCP由于有发送窗口、拥塞窗口以及当前发送缓冲区的大小等条件,所以消息可能被拆分到不同的TCP包中(拆包)。

比如两个消息:hello和world,被不幸分成了两个报文,he和lloworld,那么就属于粘包了,需要自己找到边界。

如何解决粘包?

粘包的问题出现是因为不知道一个用户消息的边界在哪,如果知道了边界在哪,接收方就可以通过边界来划分出有效的用户消息。

一般有三种方式分包的方式:

- 固定长度的消息,例如规定每个消息都是64字节,这种方式效率不高,不太常用;

- 特殊字符作为边界:http的做法,HTTP 通过设置回车符、换行符作为 HTTP 报文协议的边界,消息中出现这俩字符需要转义;

- 自定义消息结构。

我们可以自定义一个消息结构,由包头和数据组成,其中包头包是固定大小的,而且包头里有一个字段来说明紧随其后的数据有多大。

比如这个消息结构体,首先 4 个字节大小的变量来表示数据长度,真正的数据则在后面。

struct {

u_int32_t message_length;

char message_data[];

} message;

当接收方接收到包头的大小(比如 4 个字节)后,就解析包头的内容,于是就可以知道数据的长度,然后接下来就继续读取数据,直到读满数据的长度,就可以组装成一个完整到用户消息来处理了。

自己的rpc项目如何解决粘包:

自定义的报文头部中,有头部长度和总长度两个字段,不定长的body长度就是总长度-头部长度

Http协议

http状态码

200:成功状态码,表示一切正常

301:表示永久重定向,说明请求的资源已经不存在了,需改用新的 URL 再次访问。

302:表示临时重定向,说明请求的资源还在,但暂时需要用另一个 URL 来访问

304:不具有跳转的含义,表示资源未修改,重定向已存在的缓冲文件,也称缓存重定向,也就是告诉客户端可以继续使用缓存资源,用于缓存控制。

400:表示客户端请求的报文有错误,但只是个笼统的错误

403:表示服务器禁止访问资源,并不是客户端的请求出错,可能是权限认证未通过

404:表示请求的资源在服务器上不存在或未找到,所以无法提供给客户端

500:与 400 类型,是个笼统通用的错误码,服务器发生了什么错误,我们并不知道。

502:通常是服务器作为网关或代理时返回的错误码,表示服务器自身工作正常,访问后端服务器发生了错误。

503:表示服务器当前很忙,暂时无法响应客户端,类似“网络服务正忙,请稍后重试”的意思。

http1.1/2/3的改进

本小结引用一下小林coding的文章片段:

HTTP/1.1 相比 HTTP/1.0 提高了什么性能?

HTTP/1.1 相比 HTTP/1.0 性能上的改进:

使用长连接的方式改善了 HTTP/1.0 短连接造成的性能开销。

支持管道(pipeline)网络传输,只要第一个请求发出去了,不必等其回来,就可以发第二个请求出去,可以减少整体的响应时间。

但 HTTP/1.1 还是有性能瓶颈:

请求 / 响应头部(Header)未经压缩就发送,首部信息越多延迟越大。只能压缩 Body 的部分;

发送冗长的首部。每次互相发送相同的首部造成的浪费较多;

服务器是按请求的顺序响应的,如果服务器响应慢,会招致客户端一直请求不到数据,也就是队头阻塞;

没有请求优先级控制;

请求只能从客户端开始,服务器只能被动响应。

#HTTP/2 做了什么优化?

HTTP/2 协议是基于 HTTPS 的,所以 HTTP/2 的安全性也是有保障的。

那 HTTP/2 相比 HTTP/1.1 性能上的改进:

头部压缩

二进制格式

并发传输

服务器主动推送资源

- 头部压缩

HTTP/2 会压缩头(Header)如果你同时发出多个请求,他们的头是一样的或是相似的,那么,协议会帮你消除重复的部分。

这就是所谓的 HPACK 算法:在客户端和服务器同时维护一张头信息表,所有字段都会存入这个表,生成一个索引号,以后就不发送同样字段了,只发送索引号,这样就提高速度了。

- 二进制格式

HTTP/2 不再像 HTTP/1.1 里的纯文本形式的报文,而是全面采用了二进制格式,头信息和数据体都是二进制,并且统称为帧(frame):头信息帧(Headers Frame)和数据帧(Data Frame)。

HTTP/1 与 HTTP/2

这样虽然对人不友好,但是对计算机非常友好,因为计算机只懂二进制,那么收到报文后,无需再将明文的报文转成二进制,而是直接解析二进制报文,这增加了数据传输的效率。

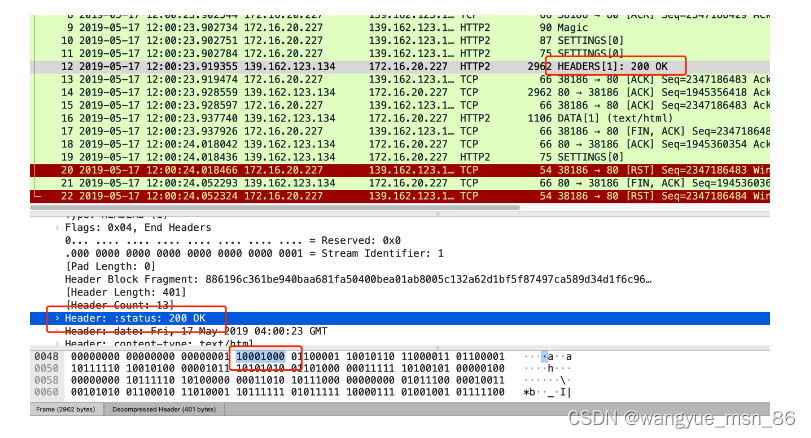

比如状态码 200 ,在 HTTP/1.1 是用 ‘2’‘0’‘0’ 三个字符来表示(二进制:00110010 00110000 00110000),共用了 3 个字节,如下图

在 HTTP/2 对于状态码 200 的二进制编码是 10001000,只用了 1 字节就能表示,相比于 HTTP/1.1 节省了 2 个字节,如下图:

Header: :status: 200 OK 的编码内容为:1000 1000,那么表达的含义是什么呢?

最前面的 1 标识该 Header 是静态表中已经存在的 KV。(至于什么是静态表,可以看这篇:HTTP/2 牛逼在哪? (opens new window))

在静态表里,“:status: 200 ok” 静态表编码是 8,二进制即是 1000。

因此,整体加起来就是 1000 1000。

- 并发传输

我们都知道 HTTP/1.1 的实现是基于请求-响应模型的。同一个连接中,HTTP 完成一个事务(请求与响应),才能处理下一个事务,也就是说在发出请求等待响应的过程中,是没办法做其他事情的,如果响应迟迟不来,那么后续的请求是无法发送的,也造成了队头阻塞的问题。

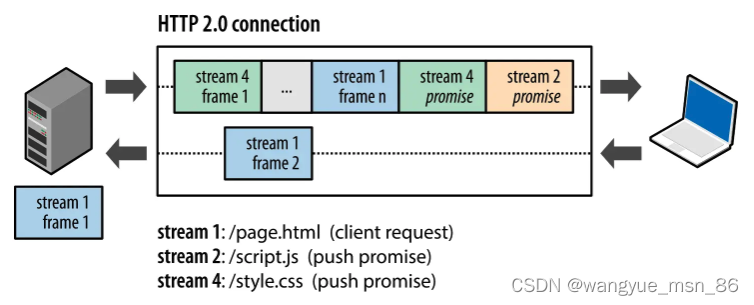

而 HTTP/2 就很牛逼了,引出了 Stream 概念,多个 Stream 复用在一条 TCP 连接。

从上图可以看到,1 个 TCP 连接包含多个 Stream,Stream 里可以包含 1 个或多个 Message,Message 对应 HTTP/1 中的请求或响应,由 HTTP 头部和包体构成。Message 里包含一条或者多个 Frame,Frame 是 HTTP/2 最小单位,以二进制压缩格式存放 HTTP/1 中的内容(头部和包体)。

针对不同的 HTTP 请求用独一无二的 Stream ID 来区分,接收端可以通过 Stream ID 有序组装成 HTTP 消息,不同 Stream 的帧是可以乱序发送的,因此可以并发不同的 Stream ,也就是 HTTP/2 可以并行交错地发送请求和响应。

比如下图,服务端并行交错地发送了两个响应: Stream 1 和 Stream 3,这两个 Stream 都是跑在一个 TCP 连接上,客户端收到后,会根据相同的 Stream ID 有序组装成 HTTP 消息。

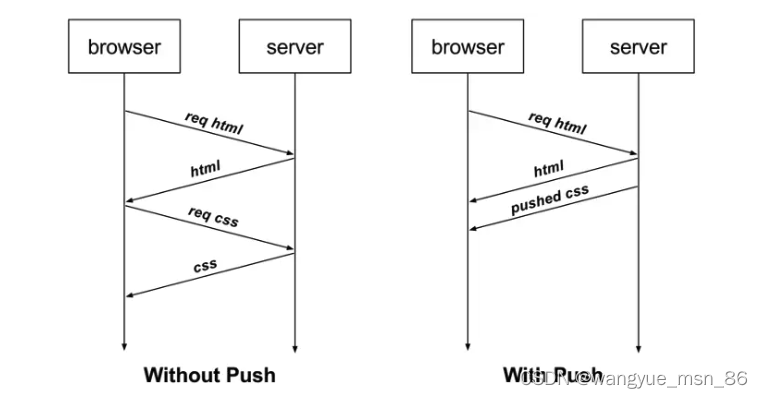

4、服务器推送

HTTP/2 还在一定程度上改善了传统的「请求 - 应答」工作模式,服务端不再是被动地响应,可以主动向客户端发送消息。

客户端和服务器双方都可以建立 Stream, Stream ID 也是有区别的,客户端建立的 Stream 必须是奇数号,而服务器建立的 Stream 必须是偶数号。

比如下图,Stream 1 是客户端向服务端请求的资源,属于客户端建立的 Stream,所以该 Stream 的 ID 是奇数(数字 1);Stream 2 和 4 都是服务端主动向客户端推送的资源,属于服务端建立的 Stream,所以这两个 Stream 的 ID 是偶数(数字 2 和 4)。

再比如,客户端通过 HTTP/1.1 请求从服务器那获取到了 HTML 文件,而 HTML 可能还需要依赖 CSS 来渲染页面,这时客户端还要再发起获取 CSS 文件的请求,需要两次消息往返,如下图左边部分:

如上图右边部分,在 HTTP/2 中,客户端在访问 HTML 时,服务器可以直接主动推送 CSS 文件,减少了消息传递的次数。

HTTP/2 有什么缺陷?

HTTP/2 通过 Stream 的并发能力,解决了 HTTP/1 队头阻塞的问题,看似很完美了,但是 HTTP/2 还是存在“队头阻塞”的问题,只不过问题不是在 HTTP 这一层面,而是在 TCP 这一层。

HTTP/2 是基于 TCP 协议来传输数据的,TCP 是字节流协议,TCP 层必须保证收到的字节数据是完整且连续的,这样内核才会将缓冲区里的数据返回给 HTTP 应用,那么当「前 1 个字节数据」没有到达时,后收到的字节数据只能存放在内核缓冲区里,只有等到这 1 个字节数据到达时,HTTP/2 应用层才能从内核中拿到数据,这就是 HTTP/2 队头阻塞问题。

举个例子,如下图:

图中发送方发送了很多个 packet,每个 packet 都有自己的序号,你可以认为是 TCP 的序列号,其中 packet 3 在网络中丢失了,即使 packet 4-6 被接收方收到后,由于内核中的 TCP 数据不是连续的,于是接收方的应用层就无法从内核中读取到,只有等到 packet 3 重传后,接收方的应用层才可以从内核中读取到数据,这就是 HTTP/2 的队头阻塞问题,是在 TCP 层面发生的。

所以,一旦发生了丢包现象,就会触发 TCP 的重传机制,这样在一个 TCP 连接中的所有的 HTTP 请求都必须等待这个丢了的包被重传回来。

HTTP/3 做了哪些优化?

前面我们知道了 HTTP/1.1 和 HTTP/2 都有队头阻塞的问题:

HTTP/1.1 中的管道( pipeline)虽然解决了请求的队头阻塞,但是没有解决响应的队头阻塞,因为服务端需要按顺序响应收到的请求,如果服务端处理某个请求消耗的时间比较长,那么只能等响应完这个请求后, 才能处理下一个请求,这属于 HTTP 层队头阻塞。

HTTP/2 虽然通过多个请求复用一个 TCP 连接解决了 HTTP 的队头阻塞 ,但是一旦发生丢包,就会阻塞住所有的 HTTP 请求,这属于 TCP 层队头阻塞。

HTTP/2 队头阻塞的问题是因为 TCP,所以 HTTP/3 把 HTTP 下层的 TCP 协议改成了 UDP!

UDP 发送是不管顺序,也不管丢包的,所以不会出现像 HTTP/2 队头阻塞的问题。大家都知道 UDP 是不可靠传输的,但基于 UDP 的 QUIC 协议 可以实现类似 TCP 的可靠性传输。

QUIC 有以下 3 个特点。

无队头阻塞

更快的连接建立

连接迁移

1、无队头阻塞

QUIC 协议也有类似 HTTP/2 Stream 与多路复用的概念,也是可以在同一条连接上并发传输多个 Stream,Stream 可以认为就是一条 HTTP 请求。

QUIC 有自己的一套机制可以保证传输的可靠性的。当某个流发生丢包时,只会阻塞这个流,其他流不会受到影响,因此不存在队头阻塞问题。这与 HTTP/2 不同,HTTP/2 只要某个流中的数据包丢失了,其他流也会因此受影响。

所以,QUIC 连接上的多个 Stream 之间并没有依赖,都是独立的,某个流发生丢包了,只会影响该流,其他流不受影响。

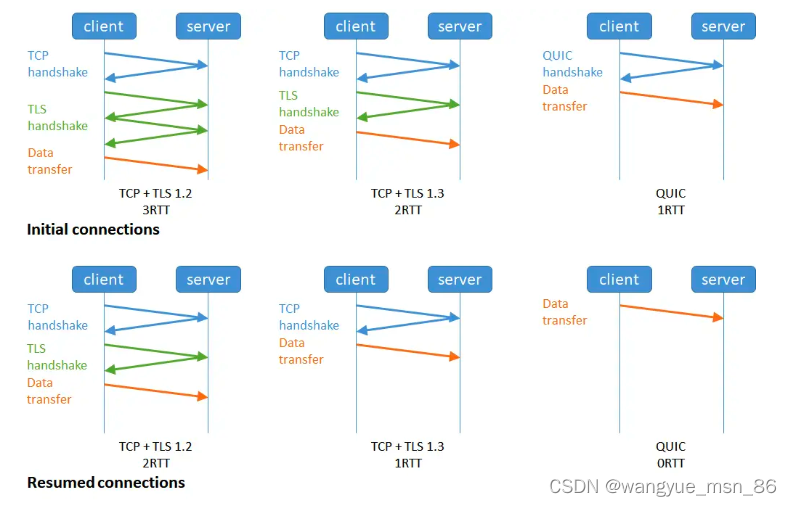

2、更快的连接建立

对于 HTTP/1 和 HTTP/2 协议,TCP 和 TLS 是分层的,分别属于内核实现的传输层、openssl 库实现的表示层,因此它们难以合并在一起,需要分批次来握手,先 TCP 握手,再 TLS 握手。

HTTP/3 在传输数据前虽然需要 QUIC 协议握手,但是这个握手过程只需要 1 RTT,握手的目的是为确认双方的「连接 ID」,连接迁移就是基于连接 ID 实现的。

但是 HTTP/3 的 QUIC 协议并不是与 TLS 分层,而是 QUIC 内部包含了 TLS,它在自己的帧会携带 TLS 里的“记录”,再加上 QUIC 使用的是 TLS/1.3,因此仅需 1 个 RTT 就可以「同时」完成建立连接与密钥协商,如下图:

甚至,在第二次连接的时候,应用数据包可以和 QUIC 握手信息(连接信息 + TLS 信息)一起发送,达到 0-RTT 的效果。

如下图右边部分,HTTP/3 当会话恢复时,有效负载数据与第一个数据包一起发送,可以做到 0-RTT(下图的右下角):

3、连接迁移

基于 TCP 传输协议的 HTTP 协议,由于是通过四元组(源 IP、源端口、目的 IP、目的端口)确定一条 TCP 连接。

那么当移动设备的网络从 4G 切换到 WIFI 时,意味着 IP 地址变化了,那么就必须要断开连接,然后重新建立连接。而建立连接的过程包含 TCP 三次握手和 TLS 四次握手的时延,以及 TCP 慢启动的减速过程,给用户的感觉就是网络突然卡顿了一下,因此连接的迁移成本是很高的。

而 QUIC 协议没有用四元组的方式来“绑定”连接,而是通过连接 ID 来标记通信的两个端点,客户端和服务器可以各自选择一组 ID 来标记自己,因此即使移动设备的网络变化后,导致 IP 地址变化了,只要仍保有上下文信息(比如连接 ID、TLS 密钥等),就可以“无缝”地复用原连接,消除重连的成本,没有丝毫卡顿感,达到了连接迁移的功能。

所以, QUIC 是一个在 UDP 之上的伪 TCP + TLS + HTTP/2 的多路复用的协议。

QUIC 是新协议,对于很多网络设备,根本不知道什么是 QUIC,只会当做 UDP,这样会出现新的问题,因为有的网络设备是会丢掉 UDP 包的,而 QUIC 是基于 UDP 实现的,那么如果网络设备无法识别这个是 QUIC 包,那么就会当作 UDP包,然后被丢弃。

操作系统

零拷贝

DMA 的全称叫直接内存存取(Direct Memory Access),是一种允许外围设备(硬件子系统)直接访问系统主内存的机制。

DMA下读取磁盘数据流程如下:·

- 用户进程向 CPU 发起 read 系统调用读取数据,由用户态切换为内核态,然后一直阻塞等待数据的返回。

- CPU 在接收到指令以后对 DMA 磁盘控制器发起调度指令。

- DMA 磁盘控制器对磁盘发起 I/O 请求,将磁盘数据先放入磁盘控制器缓冲区,CPU 全程不参与此过程。

- 数据读取完成后,DMA 磁盘控制器会接受到磁盘的通知,将数据从磁盘控制器缓冲区拷贝到内核缓冲区。

- DMA 磁盘控制器向 CPU 发出数据读完的信号,由 CPU 负责将数据从内核缓冲区拷贝到用户缓冲区。

- 用户进程由内核态切换回用户态,解除阻塞状态。

整个数据传输操作是在一个 DMA 控制器的控制下进行的。CPU 除了在数据传输开始和结束时做一点处理外(开始和结束时候要做中断处理),在传输过程中 CPU 可以继续进行其他的工作。这样在大部分时间里,CPU 计算和 I/O 操作都处于并行操作,使整个计算机系统的效率大大提高(主要cpu速度比IO快很多,用来等IO操作不值当,所以引入DMA来处理IO)。

- 传统方式:四次用户态和内核态的切换,四次拷贝(两次cpu拷贝,两次DMA拷贝)

程序传统IO实际上是调用系统的read()和write()实现,通过read()把数据从硬盘读取到内核缓冲区,再复制到用户缓冲区;然后再通过write()写入到socket缓冲区,最后写入网卡设备:(网卡和磁盘差不多,都是需要进行IO的)

整个过程发生了四次用户态和内核态的切换还有四次IO拷贝, 具体流程是:

- 用户进程通过

read()方法向操作系统发起调用,此时上下文从用户态转向内核态 - DMA控制器把数据从硬盘中拷贝到读缓冲区

- CPU把读缓冲区数据拷贝到应用缓冲区,上下文从内核态转为用户态,

read()返回 - 用户进程通过

write()方法发起调用,上下文从用户态转为内核态 - CPU将应用缓冲区中数据拷贝到socket缓冲区

- DMA控制器把数据从socket缓冲区拷贝到网卡,上下文从内核态切换回用户态,

write()返回

图中的read方法,就是一个系统调用,让程序从用户态到内核态,比如java FileInputStream的read方法,里面调用了本地方法read0,这个read0相当于图中的read,是个系统调用

零拷贝实现方式

方案一、内存映射(mmap+write)

mmap 是 Linux 提供的一种内存映射文件方法,即将一个进程的地址空间中的一段虚拟地址映射到磁盘文件地址。

mmap 主要实现方式是将**读缓冲区的地址和用户缓冲区的地址进行映射,内核缓冲区和应用缓冲区共享,**从而减少了从读缓冲区到用户缓冲区的一次CPU拷贝,然而内核读缓冲区(read buffer)仍需将数据拷贝到内核写缓冲区(socket buffer)。

你可以想象,就相当于一个hashmap记录了用户缓冲区和读缓冲区的映射,用空间换时间,减少了用户缓冲区往socket缓冲区的一次cpu拷贝

所以有4次用户态和内核态的上下文切换和3次拷贝

基于 mmap + write 系统调用的零拷贝方式,整个过程发生了4次用户态和内核态的上下文切换和3次拷贝,具体流程如下:

- 用户进程通过mmap()方法向操作系统发起调用,上下文从用户态转向内核态

- DMA控制器把数据从硬盘中拷贝到读缓冲区

- 上下文从内核态转为用户态,mmap调用返回

- 用户进程通过write()方法发起调用,上下文从用户态转为内核态

- CPU将读缓冲区中数据拷贝到socket缓冲区

- DMA控制器把数据从socket缓冲区拷贝到网卡,上下文从内核态切换回用户态,write()返回

mmap 主要的用处是提高 I/O 性能,特别是针对大文件。对于小文件,内存映射文件反而会导致碎片空间的浪费,因为内存映射总是要对齐页边界,最小单位是 4 KB,一个 5 KB 的文件将会映射占用 8 KB 内存,也就会浪费 3 KB 内存。

方案二、sendfile

就是把读和写变成一个整体了,不进行中间状态的转换了。读缓冲区直接在内核中拷贝到socket缓冲区,总共两次状态切换和三次拷贝。一次cpu拷贝

但是如果中间用户需要处理中间的数据,就不适用了

通过使用sendfile函数,数据可以直接在内核空间进行传输,因此避免了用户空间和内核空间的拷贝,同时由于使用sendfile替代了read+write从而节省了一次系统调用,也就是2次上下文切换。

image-20230328162114261

image-20230328162114261

整个过程发生了2次用户态和内核态的上下文切换和3次拷贝,具体流程如下:

- 用户进程通过sendfile()方法向操作系统发起调用,上下文从用户态转向内核态

- DMA控制器把数据从硬盘中拷贝到读缓冲区

- CPU将读缓冲区中数据拷贝到socket缓冲区

- DMA控制器把数据从socket缓冲区拷贝到网卡,上下文从内核态切换回用户态,sendfile调用返回

sendfile方法IO数据对用户空间完全不可见,所以只能适用于完全不需要用户空间处理的情况,比如静态文件服务器。

sendfile 只适用于把数据从磁盘中读出来往 socket buffer 发送的场景

方案三、sendfile+DMA scatter/gather

没有cpu拷贝,只有两次DMA拷贝,这个DMA拷贝是避免不了的。

Linux2.4内核版本之后对sendfile做了进一步优化,通过引入新的硬件支持,这个方式叫做DMA Scatter/Gather 分散/收集功能。

它将读缓冲区中的数据描述信息–内存地址和偏移量记录到socket缓冲区,由 DMA 根据这些将数据从读缓冲区拷贝到网卡,相比之前版本减少了一次CPU拷贝的过程。

整个过程发生了2次用户态和内核态的上下文切换和2次拷贝,其中更重要的是完全没有CPU拷贝,具体流程如下:

- 用户进程通过sendfile()方法向操作系统发起调用,上下文从用户态转向内核态

- DMA控制器利用scatter把数据从硬盘中拷贝到读缓冲区离散存储

- CPU把读缓冲区中的文件描述符和数据长度发送到socket缓冲区

- DMA控制器根据文件描述符和数据长度,使用scatter/gather把数据从内核缓冲区拷贝到网卡

- sendfile()调用返回,上下文从内核态切换回用户态

DMA gather和sendfile一样数据对用户空间不可见,而且需要硬件支持,同时输入文件描述符只能是文件,但是过程中完全没有CPU拷贝过程,极大提升了性能。

总结:

- 由于CPU和IO速度的差异问题,产生了DMA技术,通过DMA搬运来减少CPU的等待时间。

- 传统的

IO read/write方式会产生2次DMA拷贝+2次CPU拷贝,同时有4次上下文切换。 - 而通过

mmap+write方式则产生2次DMA拷贝+1次CPU拷贝,4次上下文切换,通过内存映射减少了一次CPU拷贝,可以减少内存使用,适合大文件的传输。 sendfile方式是新增的一个系统调用函数,产生2次DMA拷贝+1次CPU拷贝,但是只有2次上下文切换。因为只有一次调用,减少了上下文的切换,但是用户空间对IO数据不可见,适用于静态文件服务器。sendfile+DMA gather方式产生2次DMA拷贝,没有CPU拷贝,而且也只有2次上下文切换。虽然极大地提升了性能,但是需要依赖新的硬件设备支持。

netty的零拷贝:主要是内存角度,拷贝数组的次数少了

CompositeByteBuf 零拷贝

Composite buffer实现了透明的零拷贝,将物理上的多个 Buffer 组合成了一个逻辑上完整的 CompositeByteBuf.

比如在网络编程中, 一个完整的 http 请求常常会被分散到多个 Buffer 中。用 CompositeByteBuf 很容易将多个分散的Buffer组装到一起,而无需额外的复制:

ByteBuf header = Unpooled.buffer();// 模拟http请求头

ByteBuf body = Unpooled.buffer();// 模拟http请求主体

CompositeByteBuf httpBuf = Unpooled.compositeBuffer();

// 这一步,不需要进行header和body的额外复制,httpBuf只是持有了header和body的引用

// 接下来就可以正常操作完整httpBuf了

httpBuf.addComponents(header, body);

复制

而 JDK ByteBuffer 完成这一需求:

ByteBuffer header = ByteBuffer.allocate(1024);// 模拟http请求头

ByteBuffer body = ByteBuffer.allocate(1024);// 模拟http请求主体

// 需要创建一个新的ByteBuffer来存放合并后的buffer信息,这涉及到复制操作

ByteBuffer httpBuffer = ByteBuffer.allocate(header.remaining() + body.remaining());

// 将header和body放入新创建的Buffer中

httpBuffer.put(header);

httpBuffer.put(body);

httpBuffer.flip();

相比于JDK,Netty的实现更合理,省去了不必要的内存复制,可以称得上是JVM层面的零拷贝。

(3)wrap 操作实现零拷贝

例如我们有一个 byte 数组, 我们希望将它转换为一个 ByteBuf 对象, 以便于后续的操作, 那么传统的做法是将此 byte 数组拷贝到 ByteBuf 中, 即:

byte[] bytes = ...

ByteBuf byteBuf = Unpooled.buffer();

byteBuf.writeBytes(bytes);

这样的操作是有一次额外的拷贝,如果使用Unpooled相关的方法,包装这个byte数组生成一个新的的ByteBuf,而不需要进行拷贝,如:

byte[] bytes = ...

ByteBuf byteBuf = Unpooled.wrappedBuffer(bytes);

Unpooled.wrappedBuffer 方法来将 bytes 包装成为一个 UnpooledHeapByteBuf 对象, 而在包装的过程中, 是不会有拷贝操作的. 即最后我们生成的生成的 ByteBuf 对象是和 bytes 数组共用了同一个存储空间, 对 bytes 的修改也会反映到 ByteBuf 对象中

Unpooled 提供的方法可以将一个或多个 buffer 包装为一个 ByteBuf 对象, 从而避免了拷贝操作.

(4)通过 slice 操作实现零拷贝

slice 操作和 wrap 操作刚好相反, Unpooled.wrappedBuffer 可以将多个 ByteBuf 合并为一个 而 slice 操作将一个 ByteBuf 切片为多个共享一个存储区域的 ByteBuf 对象,如:

ByteBuf byteBuf = ...

ByteBuf header = byteBuf.slice(0, 5);

ByteBuf body = byteBuf.slice(5, 10);

用 slice 方法产生 byteBuf 的过程是没有拷贝操作的, header 和 body 对象在内部其实是共享了 byteBuf 存储空间的不同部分而已。

设计模式

你用过哪些设计模式?

单例模式

单例模式(Singleton Pattern)是 Java 中最简单的设计模式之一。这种类型的设计模式属于创建型模式,它提供了一种创建对象的最佳方式。

这种模式涉及到一个单一的类,该类负责创建自己的对象,同时确保只有单个对象被创建。这个类提供了一种访问其唯一的对象的方式,可以直接访问,不需要实例化该类的对象。

单例模式的主要有以下角色:

- 单例类。只能创建一个实例的类

- 访问类。使用单例类

面试要用双检查:

/**

* 双重检查方式

*/

public class Singleton {

//私有构造方法

private Singleton() {}

private static volatile Singleton instance;

//对外提供静态方法获取该对象

public static Singleton getInstance() {

//第一次判断,如果instance不为null,不进入抢锁阶段,直接返回实际

if(instance == null) {

synchronized (Singleton.class) {

//抢到锁之后再次判断是否为空

if(instance == null) {

instance = new Singleton();

}

}

}

return instance;

}

}

单例设计模式分类两种:

饿汉式:类加载就会导致该单实例对象被创建

懒汉式:类加载不会导致该单实例对象被创建,而是首次使用该对象时才会创建

-

饿汉式-方式1(静态变量方式)

/** * 饿汉式 * 静态变量创建类的对象 */ public class Singleton { //私有构造方法 private Singleton() {} //在成员位置创建该类的对象 private static Singleton instance = new Singleton(); //对外提供静态方法获取该对象 public static Singleton getInstance() { return instance; } }说明:

该方式在成员位置声明Singleton类型的静态变量,并创建Singleton类的对象instance。instance对象是随着类的加载而创建的。如果该对象足够大的话,而一直没有使用就会造成内存的浪费。

-

饿汉式-方式2(静态代码块方式)

/** * 恶汉式 * 在静态代码块中创建该类对象 */ public class Singleton { //私有构造方法 private Singleton() {} //在成员位置创建该类的对象 private static Singleton instance; static { instance = new Singleton(); } //对外提供静态方法获取该对象 public static Singleton getInstance() { return instance; } }说明:

该方式在成员位置声明Singleton类型的静态变量,而对象的创建是在静态代码块中,也是对着类的加载而创建。所以和饿汉式的方式1基本上一样,当然该方式也存在内存浪费问题。

-

懒汉式-方式1(线程不安全)

/** * 懒汉式 * 线程不安全 */ public class Singleton { //私有构造方法 private Singleton() {} //在成员位置创建该类的对象 private static Singleton instance; //对外提供静态方法获取该对象 public static Singleton getInstance() { if(instance == null) { instance = new Singleton(); } return instance; } }说明:

从上面代码我们可以看出该方式在成员位置声明Singleton类型的静态变量,并没有进行对象的赋值操作,那么什么时候赋值的呢?当调用getInstance()方法获取Singleton类的对象的时候才创建Singleton类的对象,这样就实现了懒加载的效果。但是,如果是多线程环境,会出现线程安全问题。

-

懒汉式-方式2(线程安全)

/** * 懒汉式 * 线程安全 */ public class Singleton { //私有构造方法 private Singleton() {} //在成员位置创建该类的对象 private static Singleton instance; //对外提供静态方法获取该对象 public static synchronized Singleton getInstance() { if(instance == null) { instance = new Singleton(); } return instance; } }说明:

该方式也实现了懒加载效果,同时又解决了线程安全问题。但是在getInstance()方法上添加了synchronized关键字,导致该方法的执行效果特别低。从上面代码我们可以看出,其实就是在初始化instance的时候才会出现线程安全问题,一旦初始化完成就不存在了。

-

懒汉式-方式3(双重检查锁)

再来讨论一下懒汉模式中加锁的问题,对于

getInstance()方法来说,绝大部分的操作都是读操作,读操作是线程安全的,所以我们没必让每个线程必须持有锁才能调用该方法,我们需要调整加锁的时机。由此也产生了一种新的实现模式:双重检查锁模式/** * 双重检查方式 */ public class Singleton { //私有构造方法 private Singleton() {} private static Singleton instance; //对外提供静态方法获取该对象 public static Singleton getInstance() { //第一次判断,如果instance不为null,不进入抢锁阶段,直接返回实例 if(instance == null) { synchronized (Singleton.class) { //抢到锁之后再次判断是否为null if(instance == null) { instance = new Singleton(); } } } return instance; } }双重检查锁模式是一种非常好的单例实现模式,解决了单例、性能、线程安全问题,上面的双重检测锁模式看上去完美无缺,其实是存在问题,在多线程的情况下,可能会出现空指针问题,出现问题的原因是JVM在实例化对象的时候会进行优化和指令重排序操作。

要解决双重检查锁模式带来空指针异常的问题,只需要使用

volatile关键字,volatile关键字可以保证可见性和有序性。/** * 双重检查方式 */ public class Singleton { //私有构造方法 private Singleton() {} private static volatile Singleton instance; //对外提供静态方法获取该对象 public static Singleton getInstance() { //第一次判断,如果instance不为null,不进入抢锁阶段,直接返回实际 if(instance == null) { synchronized (Singleton.class) { //抢到锁之后再次判断是否为空 if(instance == null) { instance = new Singleton(); } } } return instance; } }小结:

添加

volatile关键字之后的双重检查锁模式是一种比较好的单例实现模式,能够保证在多线程的情况下线程安全也不会有性能问题。 -

懒汉式-方式4(静态内部类方式)

静态内部类单例模式中实例由内部类创建,由于 JVM 在加载外部类的过程中, 是不会加载静态内部类的, 只有内部类的属性/方法被调用时才会被加载, 并初始化其静态属性。静态属性由于被

static修饰,保证只被实例化一次,并且严格保证实例化顺序。/** * 静态内部类方式 */ public class Singleton { //私有构造方法 private Singleton() {} private static class SingletonHolder { private static final Singleton INSTANCE = new Singleton(); } //对外提供静态方法获取该对象 public static Singleton getInstance() { return SingletonHolder.INSTANCE; } }说明:

第一次加载Singleton类时不会去初始化INSTANCE,只有第一次调用getInstance,虚拟机加载SingletonHolder

并初始化INSTANCE,这样不仅能确保线程安全,也能保证 Singleton 类的唯一性。

小结:

静态内部类单例模式是一种优秀的单例模式,是开源项目中比较常用的一种单例模式。在没有加任何锁的情况下,保证了多线程下的安全,并且没有任何性能影响和空间的浪费。

-

枚举方式

枚举类实现单例模式是极力推荐的单例实现模式,因为枚举类型是线程安全的,并且只会装载一次,设计者充分的利用了枚举的这个特性来实现单例模式,枚举的写法非常简单,而且枚举类型是所用单例实现中唯一一种不会被破坏的单例实现模式。

/** * 枚举方式 */ public enum Singleton { INSTANCE; }说明:

枚举方式属于饿汉式方式。

工厂模式

简单工厂,抽象工厂

策略模式

策略模式的主要角色如下:

- 抽象策略(Strategy)类:这是一个抽象角色,通常由一个接口或抽象类实现。此角色给出所有的具体策略类所需的接口。

- 具体策略(Concrete Strategy)类:实现了抽象策略定义的接口,提供具体的算法实现或行为。

- 环境(Context)类:持有一个策略类的引用,最终给客户端调用。

【例】促销活动

一家百货公司在定年度的促销活动。针对不同的节日(春节、中秋节、圣诞节)推出不同的促销活动,由促销员将促销活动展示给客户。类图如下:

代码如下:

定义百货公司所有促销活动的共同接口

public interface Strategy {

void show();

}

定义具体策略角色(Concrete Strategy):每个节日具体的促销活动

//为春节准备的促销活动A

public class StrategyA implements Strategy {

public void show() {

System.out.println("买一送一");

}

}

//为中秋准备的促销活动B

public class StrategyB implements Strategy {

public void show() {

System.out.println("满200元减50元");

}

}

//为圣诞准备的促销活动C

public class StrategyC implements Strategy {

public void show() {

System.out.println("满1000元加一元换购任意200元以下商品");

}

}

定义环境角色(Context):用于连接上下文,即把促销活动推销给客户,这里可以理解为销售员

public class SalesMan {

//持有抽象策略角色的引用

private Strategy strategy;

public SalesMan(Strategy strategy) {

this.strategy = strategy;

}

//向客户展示促销活动

public void salesManShow(){

strategy.show();

}

}

1,优点:

-

策略类之间可以自由切换

由于策略类都实现同一个接口,所以使它们之间可以自由切换。

-

易于扩展

增加一个新的策略只需要添加一个具体的策略类即可,基本不需要改变原有的代码,符合“开闭原则“

-

避免使用多重条件选择语句(if else),充分体现面向对象设计思想。

2,缺点:

- 客户端必须知道所有的策略类,并自行决定使用哪一个策略类。

- 策略模式将造成产生很多策略类,可以通过使用享元模式在一定程度上减少对象的数量。

使用场景

- 一个系统需要动态地在几种算法中选择一种时,可将每个算法封装到策略类中。

- 一个类定义了多种行为,并且这些行为在这个类的操作中以多个条件语句的形式出现,可将每个条件分支移入它们各自的策略类中以代替这些条件语句。

- 系统中各算法彼此完全独立,且要求对客户隐藏具体算法的实现细节时。

- 系统要求使用算法的客户不应该知道其操作的数据时,可使用策略模式来隐藏与算法相关的数据结构。

- 多个类只区别在表现行为不同,可以使用策略模式,在运行时动态选择具体要执行的行为。

JavaSE

对象头信息

Java对象信息:

对象头、实例数据,填充位:

对象头里还有Mark word ,元数据指针指向方法区的类型信,数组长度(数组才有)

64位虚拟机Markword情况

代码执行顺序:

下面我们来讨论下如果类存在父类的情况下,代码执行顺序。其实执行顺序还是按照上述给出类代码的执行顺序

public class ClassMethodOrder {

public static void main(String[] args) {

Apple apple = new Apple();

apple.getName("hello");

}

}

class Fruit {

static{

System.out.println("++++++++++++父类静态代码块+++++++++++++++");

}

{

System.out.println("++++++++++父类普通代码块++++++++++");

}

public Fruit() {

System.out.println("++++++父类构造方法+++++");

}

public void getName(String name) {

System.out.println("+++父类普通方法+++");

}

}

class Apple extends Fruit{

static{

System.out.println("++++++++++++子类静态代码块+++++++++++++++");

}

{

System.out.println("++++++++++子类普通代码块++++++++++");

}

public Apple() {

System.out.println("++++++子类构造方法+++++");

}

public void getName(String name) {

System.out.println("+++子类普通方法+++");

}

父类的总是要先执行的:

String

创建了几次字符串?

String类型为什么设计为不可变的?

public final class String

implements java.io.Serializable, Comparable<String>, CharSequence {

/** The value is used for character storage. */

private final char value[];

/** Cache the hash code for the string */

private int hash; // Default to 0

1、字符串常量池

在Java中,由于会大量的使用String常量,如果每一次声明一个String都创建一个String对象,那将会造成极大的空间资源的浪费。Java提出了String pool的概念,在堆内存中开辟一块存储空间String pool,当初始化一个String变量时,如果该字符串已经存在了,就不会去创建一个新的字符串变量,而是会返回已经存在了的字符串的引用。

如果字符串是可变的,某一个字符串变量改变了其值,那么其他string引用它的就会发生错误,String pool将不能够实现!

2.设计成不可变是线程安全的

因为读的时候并发是不会造成线程安全问题的,并且也没法写,所以string可以在多线程的情况下放心使用,如果写的话,是创建了新的线程,这一点有点写时复制的思想。

3、避免安全问题

在网络连接和数据库连接中字符串常常作为参数,例如,网络连接地址URL,文件路径path,反射机制所需要的String参数。其不可变性可以保证连接的安全性。如果字符串是可变的,黑客就有可能改变字符串指向对象的值,那么会引起很严重的安全问题。

因为String是不可变的,所以它的值是不可改变的。但由于String不可变,也就没有任何方式能修改字符串的值,每一次修改都将产生新的字符串,如果使用char[]来保存密码,仍然能够将其中所有的元素设置为空和清零,也不会被放入字符串缓存池中,用字符串数组来保存密码会更好。

4、加快字符串处理速度

由于String是不可变的,保证了hashcode的唯一性,于是在创建对象时其hashcode就可以放心的缓存了,不需要重新计算。这也就是Map喜欢将String作为Key的原因,处理速度要快过其它的键对象。所以HashMap中的键往往都使用String。

字符串是重写了hashcode方法的,那么是如何把字符串类型的值变成int类型的hashcode的呢?

public int hashCode() {

int h = hash;

if (h == 0 && !hashIsZero) {

h = isLatin1() ? StringLatin1.hashCode(value)

: StringUTF16.hashCode(value);

if (h == 0) {

hashIsZero = true;

} else {

hash = h;

}

}

return h;

}

可以看到hash是一个缓存,曾经如果计算过hash就可以直接拿缓存了,因为string不可变,所以计算一次之后就不用重复计算了。

那么string到底是怎么把byte数组变成hashcode的呢,看StringLatin1的hashCode方法

public static int hashCode(byte[] value) {

int h = 0;

for (byte v : value) {

h = 31 * h + (v & 0xff);

//更新哈希值。这里使用了一个经典的哈希算法,通过不断乘以 31 并加上当前字节的值。(v & 0xff) 用于确保将字节视为无符号整数,因为 Java 的字节是有符号的,取与 0xff 的按位与操作可以将其转换为无符号整数。

}

return h;

}

很简单,把byte的值,string每一个字节是一个ascii码,比如ABC,是65 66 67,按照上面的规则进行计算,但是这样算出来的不是完全不发生冲突的。

异常

异常执行顺序:try发生异常后的代码没有执行

public static void main(String[] args) {

System.out.println("try之前的代码");

try{

System.out.println("try中发生异常前部分");

int i = 1/0;

System.out.println("try中发生异常后部分");

}catch(Exception e){

System.out.println("catch异常啦");

}finally {

System.out.println("finally部分");

}

System.out.println("try之后的代码");

}

try之前的代码

try中发生异常前部分

catch异常啦

finally部分

try之后的代码

有return的情况:

public int test() {

int i = 0;

try {

i++;

//i = i / 0; 有没有异常

return i++;

} catch (Exception e) {

i++;

return i++;

} finally {

return ++i;

}

}

// 如果没有异常 走的顺序: try > try的return > finally的return i最终结果是3

// 如果没有异常 走的顺序: try > catch > catch的return > finally的return i最终结果是4

集合

Java集合图:

ArrayList

ArrayList 的底层是动态数组,它的容量能动态增长。在添加大量元素前,应用可以使用ensureCapacity 操作增加 ArrayList 实例的容量。ArrayList 继承了 AbstractList ,并实现了 List 接口。

ArrayList成员变量:

elementData是真实存放数据的数组

size是ArrayList的大小

defaultcapacity指定了第一次初始化的容量 就是10

三个构造函数:无参的,指定初始化容量的 根据别的集合构造的

无参构造执行分析:

第一次,确认容量,calculateCapacity返回的是defalutcapacity,是10,然后扩容,到grow方法扩容,老容量是0,所以执行第一次初始化为10的操作,刚new的时候arraylist是没有容量的,第一个add会扩容到10

第二次到第10次,都没有超过容量,直接添加就行了

第11次添加,超过容量,扩容1.5倍,右移1是除2,加本身,就是1.5倍

没有扩容:使用有参构造,直接初始化数组,不需要扩容

HashMap

红黑树结构:

为什么java用红黑树不用AVL?

最主要的一点是:

在CurrentHashMap中是加锁了的,实际上是读写锁,如果写冲突就会等待,

如果插入时间过长必然等待时间更长,而红黑树相对AVL树他的插入更快!

AVL树和红黑树有几点比较和区别:

(1)AVL树是更加严格的平衡,因此可以提供更快的查找速度,一般读取查找密集型任务,适用AVL树。

(2)红黑树更适合于插入修改密集型任务。

(3)通常,AVL树的旋转比红黑树的旋转更加难以平衡和调试

HashMap实现原理: 7和8的区别

HashMap源码分析

默认容量:16

默认加载因子:0.75

table:装数据的数组 Node是HashMap的内部类: hash值(计算完的),key,value,以及下一个Node (为了冲突时 链表)

size:集合中存储元素的个数

构造方法:懒惰加载,没有初始化table数组,只设置了加载因子为默认的 0.75

put方法的流程?

图解HashMap put方法:第一次put,会给map初始化长度为16的数组,根据key计算数组中的索引,如果该索引没有值,直接插入,然后看看长度需不需要扩容。阈值的数组长度✖️加载因子 16*0.75=12 没达到12不扩容,结束

当数组对应位置有值的时候,如果key存在了,那就覆盖value,不存在就去看看是不是红黑树,如果是链表在链表中查key,插入新的节点的话,考虑链表是不是需要转化为红黑树

源码:

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

static final int hash(Object key) {

int h;

//高16低16异或运算,减少hash碰撞

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

/**

* hash就是经过扰动的hashcode

* key 就是存入的key

* value 就是存入的value

* onlyIfAbsent if true,相同的key不会插值了,这里默认为false,

* @Override 这个方法是true

* public V putIfAbsent(K key, V value) {

* return putVal(hash(key), key, value, true, true);

* }

* evict为false,则hashmap的table处于创建模式

*/

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

// tab指代是hashmap的散列表再,在下方初始化,hashmap不是在创建的时候初始化,而是在put的时候初始化,属于懒初始化

// p表示当前散列表元素

// n表示散列表数组长度

// i表示路由寻址的结果

Node<K,V>[] tab; Node<K,V> p; int n, i;

//判断是否为空,为空的话初始化,不为空对tab和n进行赋值

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;//正的创建散列表,初始化入口,同时对n赋值

//这个i就是(n-1)和hash做与运算得到的位置,p就是这个位置的Node元素

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);//当这个位置为空,直接封装key和value,放入tab中

else {

//e 临时的node元素

//k 表示临时的一个key

Node<K,V> e; K k;

//表示这个桶的位置的元素的key和将要插入的key是一个,会进行替换

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

//当前节点是红黑树的节点,加入树中,instanceof 判断对象是不是谁的实例,返回boolean类型的值

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

//链表的情况,而且链表的头元素与我们要插入的key不一致

else {

for (int binCount = 0; ; ++binCount) {

//判断到最后也没有key是一样的,就在最末尾插入一个新的节点

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

//在插入完第九个节点,会进行树化

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);//树化函数

break;

}

//条件成立就是在遍历链表中有相同的key,直接跳出

if (e.hash == hash && ((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//这种属于覆盖操作,当e中有值进入操作

if (e != null) { // existing mapping for key

//oldValue保存老的值,方便return

V oldValue = e.value;

//onlyIfAbsent传入的是false,指定能进入判断

if (!onlyIfAbsent || oldValue == null)

e.value = value;//值的替换

afterNodeAccess(e);

return oldValue;

}

}

++modCount;//增加修改次数

if (++size > threshold)//插入新元素,size自增,大于扩容阈值会触发扩容

resize();//扩容

afterNodeInsertion(evict);

return null;

}

Hash算法?

Hash算法:取key的hashCode值、高位运算、取模运算。

在JDK1.8的实现中,优化了高位运算的算法,通过 hashCode() 的高16位异或低16位实现的:这么做可

以在数组比较小的时候,也能保证考虑到高低位都参与到Hash的计算中,可以减少冲突,同时不会有太

大的开销。

static final int hash(Object key) {

int h;

//高16低16异或运算,减少hash碰撞

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

h = key.hashCode()获取hashcode的值

h >>> 16 无符号右移 16位 然后按位异或,扰动算法,填充到数组中就比较均匀。

put的时候,寻找插入位置,使用按位与运算代替取模,性能更好 hash % 数组len 等价于 hash& (n-1)

HashMap 的长度为什么是 2 的幂次方?

Hash 值的范围值比较大,使用之前需要先对数组的长度取模运算,得到的余数才是元素存放的位置也

就是对应的数组下标。这个数组下标的计算方法是 (n - 1) & hash 。将HashMap的长度定为2 的幂次

方,这样就可以使用 (n - 1)&hash 位运算代替%取余的操作,提高性能。

HashMap扩容方式?

1.8扩容机制:当元素个数大于 threshold 时,会进行扩容,使用2倍容量的数组代替原有数组。采用尾插入的方式将原数组元素拷贝到新数组。1.8扩容之后链表元素相对位置没有变化,而1.7扩容之后链表元素会倒置。

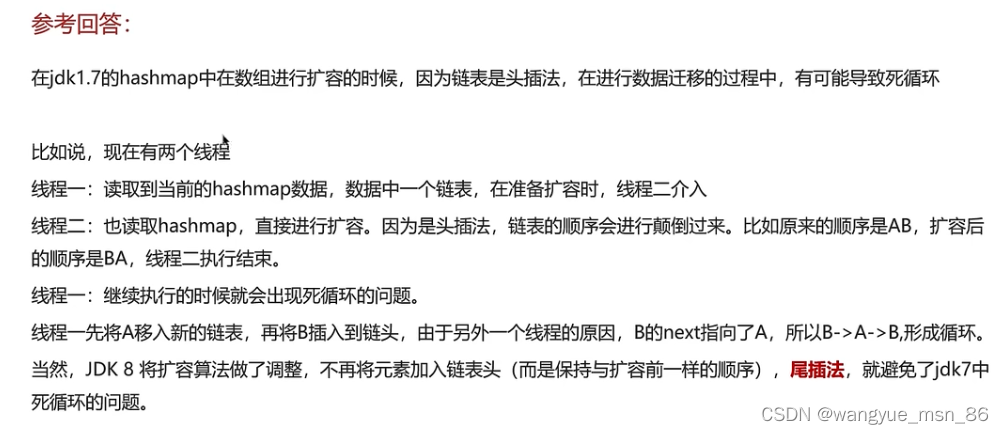

1.7链表新节点采用的是头插法,这样在线程一扩容迁移元素时,会将元素顺序改变,导致两个线程中出现元素的相互指向而形成循环链表,1.8采用了尾插法,避免了这种情况的发生。

原数组的元素在重新计算hash之后,因为数组容量n变为2倍,那么n-1的mask范围在高位多1bit。在元

素拷贝过程不需要重新计算元素在数组中的位置,只需要看看原来的hash值新增的那个bit是1还是0,

是0的话索引没变,是1的话索引变成“原索引+oldCap”(根据 e.hash & oldCap == 0 判断) 。这样可

以省去重新计算hash值的时间,而且由于新增的1bit是0还是1可以认为是随机的,因此resize的过程会

均匀的把之前的冲突的节点分散到新的bucket

Jdk1.7在多线程环境下造成的循环问题:

详细请看文章:

https://blog.csdn.net/u014571143/article/details/128599879?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169165159416800182113734%2522%252C%2522scm%2522%253A%252220140713.130102334…%2522%257D&request_id=169165159416800182113734&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2alltop_click~default-1-128599879-null-null.142v92insert_down28v1&utm_term=hashmap1.7%E5%A4%B4%E6%8F%92%E6%B3%95%E6%AD%BB%E5%BE%AA%E7%8E%AF&spm=1018.2226.3001.4187

NIO

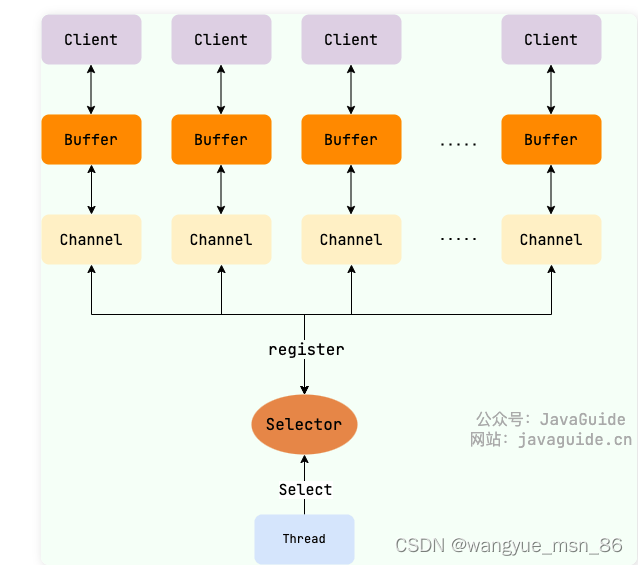

来自 java guide:NIO 主要包括以下三个核心组件:

- Buffer(缓冲区):NIO 读写数据都是通过缓冲区进行操作的。读操作的时候将 Channel 中的数据填充到 Buffer 中,而写操作时将 Buffer 中的数据写入到 Channel 中。

- Channel(通道):Channel 是一个双向的、可读可写的数据传输通道,NIO 通过 Channel 来实现数据的输入输出。通道是一个抽象的概念,它可以代表文件、套接字或者其他数据源之间的连接。(channel是一个抽象的模型,不是tcp的连接,而是要基于tcp的连接)

- Selector(选择器):允许一个线程处理多个 Channel,基于事件驱动的 I/O 多路复用模型。所有的 Channel 都可以注册到 Selector 上,由 Selector 来分配线程来处理事件。

三者的关系如下图所示

Buffer(缓冲区)

在传统的 BIO 中,数据的读写是面向流的, 分为字节流和字符流。netty中用的是更合理的bytebuf

在 Java 1.4 的 NIO 库中,所有数据都是用缓冲区处理的,这是新库和之前的 BIO 的一个重要区别,有点类似于 BIO 中的缓冲流。NIO 在读取数据时,它是直接读到缓冲区中的。在写入数据时,写入到缓冲区中。 使用 NIO 在读写数据时,都是通过缓冲区进行操作。

Buffer 的子类如下图所示。其中,最常用的是 ByteBuffer,它可以用来存储和操作字节数据。

Channel(通道)

Channel 是一个通道,它建立了与数据源(如文件、网络套接字等)之间的连接。我们可以利用它来读取和写入数据,就像打开了一条自来水管,让数据在 Channel 中自由流动。

BIO 中的流是单向的,分为各种 InputStream(输入流)和 OutputStream(输出流),数据只是在一个方向上传输。通道与流的不同之处在于通道是双向的,它可以用于读、写或者同时用于读写。

Channel 与前面介绍的 Buffer 打交道,读操作的时候将 Channel 中的数据填充到 Buffer 中,而写操作时将 Buffer 中的数据写入到 Channel 中。

另外,因为 Channel 是全双工的,所以它可以比流更好地映射底层操作系统的 API。特别是在 UNIX 网络编程模型中,底层操作系统的通道都是全双工的,同时支持读写操作。

Selector(选择器)

Selector(选择器) 是 NIO 中的一个关键组件,它允许一个线程处理多个 Channel。Selector 是基于事件驱动的 I/O 多路复用模型,主要运作原理是:通过 Selector 注册通道的事件,Selector 会不断地轮询注册在其上的 Channel。当事件发生时,比如:某个 Channel 上面有新的 TCP 连接接入、读和写事件,这个 Channel 就处于就绪状态,会被 Selector 轮询出来。Selector 会将相关的 Channel 加入到就绪集合中。通过 SelectionKey 可以获取就绪 Channel 的集合,然后对这些就绪的 Channel 进行响应的 I/O 操作。

selector就是IO多路复用的关键,就是selector线程一直循环的读取注册的channel的状态,当有读写事件的时候,就可以进行具体操作。相当于这个selector依着在发送select或者epoll这种系统调用在监控fd文件的状态,linux系统一切都是文件。

一个多路复用器 Selector 可以同时轮询多个 Channel,由于 JDK 使用了 epoll() 代替传统的 select 实现,所以它并没有最大连接句柄 1024/2048 的限制。这也就意味着只需要一个线程负责 Selector 的轮询,就可以接入成千上万的客户端。

Selector 可以监听以下四种事件类型:

SelectionKey.OP_ACCEPT:表示通道接受连接的事件,这通常用于ServerSocketChannel。SelectionKey.OP_CONNECT:表示通道完成连接的事件,这通常用于SocketChannel。SelectionKey.OP_READ:表示通道准备好进行读取的事件,即有数据可读。SelectionKey.OP_WRITE:表示通道准备好进行写入的事件,即可以写入数据。

Selector是抽象类,可以通过调用此类的 open() 静态方法来创建 Selector 实例。Selector 可以同时监控多个 SelectableChannel 的 IO 状况,是非阻塞 IO 的核心。

一个 Selector 实例有三个 SelectionKey 集合:

- 所有的

SelectionKey集合:代表了注册在该 Selector 上的Channel,这个集合可以通过keys()方法返回。 - 被选择的

SelectionKey集合:代表了所有可通过select()方法获取的、需要进行IO处理的 Channel,这个集合可以通过selectedKeys()返回。 - 被取消的

SelectionKey集合:代表了所有被取消注册关系的Channel,在下一次执行select()方法时,这些Channel对应的SelectionKey会被彻底删除,程序通常无须直接访问该集合,也没有暴露访问的方法。

简单演示一下如何遍历被选择的 SelectionKey 集合并进行处理:

Set<SelectionKey> selectedKeys = selector.selectedKeys();

Iterator<SelectionKey> keyIterator = selectedKeys.iterator();

while (keyIterator.hasNext()) {

SelectionKey key = keyIterator.next();

if (key != null) {

if (key.isAcceptable()) {

// ServerSocketChannel 接收了一个新连接

} else if (key.isConnectable()) {

// 表示一个新连接建立

} else if (key.isReadable()) {

// Channel 有准备好的数据,可以读取

} else if (key.isWritable()) {

// Channel 有空闲的 Buffer,可以写入数据

}

}

keyIterator.remove();

}

Selector 还提供了一系列和 select() 相关的方法:

int select():监控所有注册的Channel,当它们中间有需要处理的IO操作时,该方法返回,并将对应的SelectionKey加入被选择的SelectionKey集合中,该方法返回这些Channel的数量。依赖底层的系统调用,linux是epoll,windows是selectint select(long timeout):可以设置超时时长的select()操作。int selectNow():执行一个立即返回的select()操作,相对于无参数的select()方法而言,该方法不会阻塞线程。Selector wakeup():使一个还未返回的select()方法立刻返回。- ……

使用 Selector 实现网络读写的简单示例:

import java.io.IOException;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.channels.SelectionKey;

import java.nio.channels.Selector;

import java.nio.channels.ServerSocketChannel;

import java.nio.channels.SocketChannel;

import java.util.Iterator;

import java.util.Set;

public class NioSelectorExample {

public static void main(String[] args) {

try {

ServerSocketChannel serverSocketChannel = ServerSocketChannel.open();

serverSocketChannel.configureBlocking(false);

serverSocketChannel.socket().bind(new InetSocketAddress(8080));

Selector selector = Selector.open();

// 将 ServerSocketChannel 注册到 Selector 并监听 OP_ACCEPT 事件

serverSocketChannel.register(selector, SelectionKey.OP_ACCEPT);

while (true) {

int readyChannels = selector.select();

if (readyChannels == 0) {

continue;

}

Set<SelectionKey> selectedKeys = selector.selectedKeys();

Iterator<SelectionKey> keyIterator = selectedKeys.iterator();

while (keyIterator.hasNext()) {

SelectionKey key = keyIterator.next();

if (key.isAcceptable()) {

// 处理连接事件

ServerSocketChannel server = (ServerSocketChannel) key.channel();

SocketChannel client = server.accept();

client.configureBlocking(false);

// 将客户端通道注册到 Selector 并监听 OP_READ 事件

client.register(selector, SelectionKey.OP_READ);

} else if (key.isReadable()) {

// 处理读事件

SocketChannel client = (SocketChannel) key.channel();

ByteBuffer buffer = ByteBuffer.allocate(1024);

int bytesRead = client.read(buffer);

if (bytesRead > 0) {

buffer.flip();

System.out.println("收到数据:" +new String(buffer.array(), 0, bytesRead));

// 将客户端通道注册到 Selector 并监听 OP_WRITE 事件

client.register(selector, SelectionKey.OP_WRITE);

} else if (bytesRead < 0) {

// 客户端断开连接

client.close();

}

} else if (key.isWritable()) {

// 处理写事件

SocketChannel client = (SocketChannel) key.channel();

ByteBuffer buffer = ByteBuffer.wrap("Hello, Client!".getBytes());

client.write(buffer);

// 将客户端通道注册到 Selector 并监听 OP_READ 事件

client.register(selector, SelectionKey.OP_READ);

}

keyIterator.remove();

}

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

在示例中,我们创建了一个简单的服务器,监听 8080 端口,使用 Selector 处理连接、读取和写入事件。当接收到客户端的数据时,服务器将读取数据并将其打印到控制台,然后向客户端回复 “Hello, Client!”。

Mysql

存储引擎

MySQL中常见的存储引擎?

- innodb 5.1之后默认的

- myisam 5.1之前默认的

- memory 适用于读写效率高,能容忍数据丢失的

Innodb和myisam引擎的区别?

- 最大的区别是 innodb支持事务,myisam不支持事务

- Innodb支持到行级锁,Myisam不支持行级锁,只支持到表锁

- innodb支持外键,myisam不支持外键

- myisam性能比innodb高

- innodb支持崩溃后安全恢复,myisam不支持

- innodb主键查询性能高于myisam

- myisam支持fulltext类型的全文索引,innodb不支持,但是innodb可以使用sphinx插件来支持全文索引,且性能更好

索引

了解过索引吗,索引有什么用?

- 索引是帮助mysql高效查找数据的数据结构

- 提高数据检索效率,降低IO成本(B+树矮胖IO次数少)

- 通过索引对数据进行排序,降低了数据库排序的成本,降低了cpu的消耗

有哪些数据结构可以做索引?

B+树索引、Hash索引、FullText索引

Hash索引的缺点?

- Hash索引只能用于对等比较(=,in),不支持范围查询(between,>,< ,…)

- 无法利用索引完成排序操作

为什么不用二叉树?红黑树?

插入的数据多了二叉树会退化成链表,查找性能变低,即使红黑树可以保证平衡,但是数据多了树很高,说白了就是二叉不够用,需要多叉树,让索引尽可能的矮胖,查询性能较好。

请描述一下B树和B+树:

B树/B+树是多路平衡查找树,专门为提升数据库查询性能而产生的数据结构,是绝对平衡的m叉查找树,一个m叉树 最多 m-1个key,m个指针,在B-Tree中,非叶子节点和叶子节点都会存放数据,B+树中,非叶子结点只存放索引,数据全存放在叶子结点处,而且叶子结点用指针相连成了一个链表

为什么不用B树而用B+树:

1.B+树非叶子结点放的全是索引,而操作系统一个磁盘块的空间的有限的,那么一个磁盘块就能放下更多的索引,树也会更加的矮胖,查询IO次数更少,性能更高

2.B+树存放数据的叶子结点用指针相连成了链表,可以按照关键码排序的次序来有序遍历全部记录,由于数据顺序排列并且相连,所以便于区间查找和搜索(根据空间局部性原理),

B+树高度为3就能记录2000万条数据,就是因为足够矮胖:

这里我们先假设B+树高为2,即存在一个根节点和若干个叶子节点,那么这棵B+树的存放总记录数为:根节点指针数*单个叶子节点记录行数。

上文我们已经说明单个叶子节点(页)中的记录数=16K/1K=16。(这里假设一行记录的数据大小为1k,实际上现在很多互联网业务数据记录大小通常就是1K左右)。

那么现在我们需要计算出非叶子节点能存放多少指针,其实这也很好算,我们假设主键ID为bigint类型,长度为8字节,而指针大小在InnoDB源码中设置为6字节,这样一共14字节,我们一个页中能存放多少这样的单元,其实就代表有多少指针,即16384/14=1170。那么可以算出一棵高度为2的B+树,能存放1170*16=18720条这样的数据记录。

根据同样的原理我们可以算出一个高度为3的B+树可以存放:1170*1170*16=21902400条这样的记录。所以在InnoDB中B+树高度一般为1-3层,它就能满足千万级的数据存储。在查找数据时 一次页的查找代表一次IO, 所以通过主键索引查询通常 只需要1-3次IO操作 即可查找到数据。

从物理存储(innodb引擎)的角度来看,索引分为聚簇索引(主键索引)、二级索引(辅助索引/非聚簇索引),二者的区别?

- 主键索引的 B+Tree 的叶子节点存放的是实际数据(行数据),所有完整的用户记录都存放在主键索引的 B+Tree 的叶子节点里;

- 二级索引的 B+Tree 的叶子节点存放的是主键值,而不是实际数据。

在查询时如果走的是二级索引,并且查询的数据在二级索引里查询不到,那么要根据二级索引查到的主键值去主键索引回表查询,如果可以查询的到,(比如只查询二级索引的那个字段和主键字段),就不需要回表查询,这个过程叫覆盖索引。

聚簇索引选取原则?

- 如果存在主键,主键索引就是聚簇索引

- 如果没有主键,将使用第一个唯一索引来作为聚簇索引

- 如果没有主键,也没有合适的唯一索引,Innodb会自动生成一个rowid作为隐藏的聚簇索引

什么是覆盖索引?

上面写的就是,因为不用回表查询了,性能稍微好点,IO次数少点,所以可以建立联合索引。也要避免使用Select *(非必要),会回表查询降低效率

MySQl超大分页如何处理(因为数据量比较大时,limit分页查询,需要对数据进行排序,效率低)?

解决方案:覆盖索引+子查询

这样优化在了哪里呢,先走子查询查询9000000到90000010的id,虽然也要进行排序,并且丢弃9000000以前的数据,但是走的都是覆盖索引,都没回表,然后再关联到表中进行查询,性能较高。

创建索引的原则?

1、2、5、6点比较重要:超过10万再建立索引,经常作为查询条件的建立索引、尽量使用联合索引,可以覆盖索引,索引不是越多越好

如何判断SQL走没走索引?

使用explain查看sql执行计划

什么情况下索引会失效?(适当思考一下假装自己遇到过)

- (联合索引)违反最左前缀原则

- 范围查询右边的列,不能使用索引 >号可以改为>=

- 在索引列上进行运算操作,索引列将失效 … where substring(name,3,2)= ‘科技‘

- 字符串不加单引号,导致索引失效 (mysql查询优化器会进行自动类型转化,导致索引失效)

- 以%开头的Like模糊查询,索引失效(模糊查询不能头部模糊) where name like '%黑马程序员’会失效

最左前缀原则:走联合索引的情况下,如果字段不按索引顺序来作为条件查询,那么不按照顺序的部分将失效 如下是三个字段的联合索引

使用name和address作为条件只有name索引会生效(看key_len,索引长度只走了name一个索引)

sql优化

MySQL 的常见的优化手段有以下五种:

查询优化:

1、避免 SELECT *,只查询需要的字段。

2、小表驱动大表,即小的数据集驱动大的数据集,比如,当 B 表的数据集小于 A 表时,用 in 优化

exist,两表执行顺序是先查 B 表,再查 A 表,查询语句:select * from A where id in (select id from

B) 。

3、一些情况下,可以使用连接代替子查询,因为使用 join 时,MySQL 不会在内存中创建临时表。

优化索引的使用:

1、尽量使用主键查询,而非其他索引,因为主键查询不会触发回表查询。

2、不做列运算,把计算都放入各个业务系统实现

3、查询语句尽可能简单,大语句拆小语句,减少锁时间

4、不使用 select * 查询

5、or 查询改写成 in 查询

6、不用函数和触发器

7、避免 %xx 查询

8、少用 join 查询

9、使用同类型比较,比如 ‘123’ 和 ‘123’、123 和 123

10、尽量避免在 where 子句中使用 != 或者 <> 操作符,查询引用会放弃索引而进行全表扫描

11、列表数据使用分页查询,每页数据量不要太大

12、用 exists 替代 in 查询

13、避免在索引列上使用 is null 和 is not null

14、尽量使用主键查询

15、避免在 where 子句中对字段进行表达式操作

16、尽量使用数字型字段,若只含数值信息的字段尽量不要设计为字符型

表结构设计优化:

1、使用可以存下数据最小的数据类型。

2、使用简单的数据类型,int 要比 varchar 类型在 MySQL 处理简单。

3、尽量使用 tinyint、smallint、mediumint 作为整数类型而非 int。

4、尽可能使用 not null 定义字段,因为 null 占用 4 字节空间。

5、尽量少用 text 类型,非用不可时最好考虑分表。

6、尽量使用 timestamp,而非 datetime。

7、单表不要有太多字段,建议在 20 个字段以内。

表拆分当数据库中的数据非常大时,查询优化方案也不能解决查询速度慢的问题时,我们可以考虑拆分表,让

每张表的数据量变小,从而提高查询效率。

1、垂直拆分:是指数据表列的拆分,把一张列比较多的表拆分为多张表,比如,用户表中一些字段经

常被访问,将这些字段放在一张表中,另外一些不常用的字段放在另一张表中,插入数据时,使用事务

确保两张表的数据一致性。

垂直拆分的原则:

1、把不常用的字段单独放在一张表;

2、把 text,blob 等大字段拆分出来放在附表中;

4、经常组合查询的列放在一张表中。

2、水平拆分:指数据表行的拆分,表的行数超过200万行时,就会变慢,这时可以把一张的表的数据拆

成多张表来存放。

通常情况下,我们使用取模的方式来进行表的拆分,比如,一张有 400W 的用户表 users,为提高其查

询效率我们把其分成 4 张表 users1,users2,users3,users4,然后通过用户 ID 取模的方法,同时

查询、更新、删除也是通过取模的方法来操作。

读写分离:

一般情况下对数据库而言都是“读多写少”,换言之,数据库的压力多数是因为大量的读取数据的操作造

成的,我们可以采用数据库集群的方案,使用一个库作为主库,负责写入数据;其他库为从库,负责读

取数据。这样可以缓解对数据库的访问压力。

事务

你在开发中什么时候使用事务(Transactional注解)

Transactional是通过AOP实现的,环绕通知,执行方法前启动事务,执行方法后关闭事务

单条sql语句mysql是默认加事务的。如果一个方法里有多条sql语句,就要考虑是不是需要加事务了

1、原子性保障——多个insert,update,delete操作

这个应该是大家最熟悉的一种场景,保证多个insert,update,delete操作要么全都执行成功(Committed),要么全都不执行(Rollback)。

原子性的特点:

1、针对单事务的控制

2、针对多个insert,update,delete操作ååå

示例:

执行方法,添加多个商品。添加事务控制,保障所有商品要么全部添加成功,要么全部添加失败。

@Transactional(rollbackFor = Exception.class)

public void addList(List list){

list.forEach(e->{

goodsStockMapper.add(e);

});

}

2、隔离性保障——幻读、不可重复、脏读

事务处理过程中的中间状态应该对外部不可见,换句话说,事务在进行过程中是隔离的,事务之间不能互相干扰,不能访问到彼此未提交的数据。

幻读、不可重复需要在同一个事务中进行多次相同的查询才能体现,真是项目中需要这样操作的场景很少。

脏读就是读到其他事务没有提交的数据,只要隔离级别不是读未提交(Read Uncommitted)就不会出现。

所以相比对幻读、不可重复、脏读这些开发过程中基本不会遇到的问题,我们更应该关注事务的隔离性对业务产生的影响。

事务的默认隔离级别可重复读(Repeatable Read)基本满足日常开发90%的场景,一般不建议调整。

隔离性的特点:

1、针对多事务间数据可见性的控制。

2、控制加锁的粒度和加锁、释放锁的时机,提高事务的并发能力。

示例场景:

读到其他事务未提交数据,导致超卖。

1、幻读:

SELECT count(1) FROM books WHERE price < 100; /* 时间顺序:1,事务: T1 /

INSERT INTO books(name,price) VALUES (‘深入理解Java虚拟机’,90); COMMIT; / 时间顺序:2,事务: T2 /

SELECT count(1) FROM books WHERE price < 100; / 时间顺序:3,事务: T1 */

可串行化(Serializable)会对事务所有读、写的数据全都加上读锁、写锁和范围锁,所以由于T1事务对价格小于100的范围内的数据都加读锁、写锁和范围锁,所以T2不能插入价格为90的数据,所以不存在幻读的情况。

其他隔离级别下都会出现幻读。

2、不可重复度

SELECT * FROM books WHERE id = 1; /* 时间顺序:1,事务: T1 /

UPDATE books SET price = 110 WHERE id = 1; COMMIT; / 时间顺序:2,事务: T2 /

SELECT * FROM books WHERE id = 1; COMMIT; / 时间顺序:3,事务: T1 */

假如隔离级别是可重复读的话,由于数据已被事务 T1 施加了读锁且读取后不会马上释放,所以事务 T2 无法获取到写锁,更新就会被阻塞,直至事务 T1 被提交或回滚后才能提交。

读已提交对事务涉及的数据加的写锁会一直持续到事务结束,但加的读锁在查询操作完成后就马上会释放。

读已提交的隔离级别缺乏贯穿整个事务周期的读锁,无法禁止读取过的数据发生变化,此时事务 T2 中的更新语句可以马上提交成功,这也是一个事务受到其他事务影响,隔离性被破坏的表现。

事实上由于Mysql的MVCC机制,可重复读(Repeatable Read)和读已提交(Read Committed)在读的时候都不会加锁。如果读取的行正在执行delete或者update操作,这时读操作不会因此去等待行上锁的释放。相反的,InnoDB存储引擎会去读取行的一个快照数据。实现了对读的非阻塞,读不加锁,读写不冲突。

3、一致性保障——针对多个表的查询统计

很多同学一直认为,一个方法中如果都是查询请求,就不需要添加事务控制。那么真的是这样吗?

假设现在有3个表A,B,C,由于业务请求量非常高,导致3个表一直有新的数据不停的写入。

现在要求分别对3个表中的数据进行聚合统计,然后进行指标计算。

大致逻辑:

select A指标 from 表A; //步骤1

select B指标 from 表B; //步骤2

select C指标 from 表C; //步骤3

汇总指标 = A指标 + B指标 + C指标; //步骤4

如果按照这样去统计,当查询完A指标后,由于业务在正常进行,表B和表C仍然有数据写入,所以最后会导致查询的A,B,C3个指标,并不是同一时刻的,这样的汇总指标也就没有了参考意义。

这个时候就需要对统计的方法添加事务,保证数据的一致性。

一致性:在成功提交或失败回滚之后以及正在进行的事务期间,数据库始终保持一致的状态。如果正在多个表之间更新相关数据,那么查询将看到所有旧值或所有新值,而不会一部分是新值,一部分是旧值。

@Transactional(rollbackFor = Exception.class,isolation = Isolation.REPEATABLE_READ,readOnly = true)

public int count(){

select A指标 from 表A;

select B指标 from 表B;

select C指标 from 表C;

汇总指标 = A指标 + B指标 + C指标;

说明:

对汇总统计的方法添加事务控制,且指定事务的隔离级别为可重复读Isolation.REPEATABLE_READ,并设置只读属性readOnly对查询进行优先。

事务的特性?

ACID:讲解的时候可以转账300块为案例

- 原子性(atomicity):事务是不可分割的最小操作单元,要么同时成功,要么同时失败(如果转账300的人转账失败,收钱的人不能多300块)

- 一致性(Consistency):事务完成时,必须使所有的数据保持一致状态(转账300块,我少了300你就要多300)

- 隔离性(Isolation):数据库系统提供隔离机制,保证事务在不受外部并发操作的影响下独立环境下运行(转账这个事儿不能被别的事儿影响)

- 持久性(durability):事务一旦提交或回滚,对数据库中数据的改变是永久的(转账后的钱要被写进磁盘)

并发事务的问题?即脏读、不可重复读、幻读

脏读:一个事务读到了另一个事务还没有提交的数据。比如张三的工资是5000,事务1涨到了8000,事务2在事务1没有提交的时候就去读到了8000,但是事务1回滚了,最后结果还是5000,那么这个读到的8000就成了脏数据,事务b做了一次脏读

不可重复读:是指一个事务内多次读取数据,两次读取的结果不一样,在事务1两次读取之间有一个事务2修改了改数据。比如事务1要读两次张三的工资,第一次是5000,此时有一个事务2修改了张三工资为8000,事务1第二次读张三工资为8000,两次结果不一样

幻读:幻读,并不是说两次读取获取的结果集不同,幻读侧重的方面是某一次的 select 操作得到的结果所表征的数据状态无法支撑后续的业务操作。

更为具体一些:事务1select 某记录是否存在,不存在,准备插入此记录,但是事务2已经把这个记录插入了,但执行 insert 时发现此记录已存在,无法插入,此时就发生了幻读。

比如,事务1,查看id为1的学生信息,如果没有则插入,select的结果是不存在,此时事务2插入了id为1的学生信息,事务1再想插入id为1的学生信息的时候,发现已经存在了,无法插入。但是再查询的时候多出了这条幻影数据,像是有幻影一样,这就叫幻读。

如何解决这三个问题?事务隔离级别

数据库innodb引擎默认是可重复读

REDO LOG

重做日志,记录的是事务提交时数据页的物理修改,是用来实现事务的持久性。

该日志文件由两部分组成:重做日志缓冲(redo log buffer)以及重做日志文件(redo logfile),前者是在内存中,后者在磁盘中。当事务提交之后会把所有修改信息都存到该日志文件中, 用于在刷新脏页到磁盘,发生错误时, 进行数据恢复使用。

那为什么每一次提交事务,要刷新redo log到磁盘中呢,而不是直接将buffer pool中的脏页刷新到磁盘呢 ?

因为在业务操作中,我们操作数据一般都是随机读写磁盘的,而不是顺序读写磁盘。而redo log在往磁盘文件中写入数据,由于是日志文件,所以都是顺序写的。顺序写的效率,要远大于随机写。这种先写日志的方式,称之为WAL(Write-Ahead Logging)。

UNDO LOG

回滚日志,用于记录数据被修改前的信息,作用包含两个:提供回滚(保证事务的原子性)和MVCC(多版本并发控制) 。

undo log和redo log记录物理日志不一样,它是逻辑日志。可以认为当delete一条记录时,undolog中会记录一条对应的insert记录,反之亦然,当update一条记录时,它记录一条对应相反的update记录。当执行rollback时,就可以从undo log中的逻辑记录读取到相应的内容并进行回滚。

Undo log销毁:undo log在事务执行时产生,事务提交时,并不会立即删除undo log,因为这些日志可能还用于MVCC。

Undo log存储:undo log采用段的方式进行管理和记录,存放在rollback segment回滚段中,内部包含1024个undo log segment。

MVCC

MVCC和锁保证隔离性,两个日志保证一致性:

基本概念

当前读

读取的是记录的最新版本,读取时还要保证其他并发事务不能修改当前记录,会对读取的记录进行加锁。对于我们日常的操作,如:select … lock in share mode(共享锁),select …for update、update、insert、delete(排他锁)都是一种当前读。

快照读

简单的select(不加锁)就是快照读,快照读,读取的是记录数据的可见版本,有可能是历史数据,不加锁,是非阻塞读。

Read Committed:每次select,都生成一个快照读。

Repeatable Read:开启事务后第一个select语句才是快照读的地方。

Serializable:快照读会退化为当前读。

MVCC

MVCC全称``Multi-Version Concurrency Control,多版本并发控制。指维护一个数据的多个版本,使得读写操作没有冲突,快照读为MySQL实现MVCC提供了一个非阻塞读功能。MVCC的具体实现,还需要依赖于数据库记录中的三个隐式字段、undo log日志、readView`。

1.隐藏字段:三个,当表有主键时第三个隐藏字段没有

2.UNDO log 版本链

回滚日志,在insert、update、delete的时候产生的便于数据回滚的日志。当insert的时候,产生的undo log日志只在回滚时需要,在事务提交后,可被立即删除。而update、delete的时候,产生的undo log日志不仅在回滚时需要,在快照读时也需要,不会立即被删除。

最终我们发现,不同事务或相同事务对同一条记录进行修改,会导致该记录的undolog生成一条记录版本链表,链表的头部是最新的旧记录,链表尾部是最早的旧记录。

3.ReadView

RC(读已提交)级别的readview:事务的每一次查询都会创建readview,按照规则去undolog链中找数据,四个规则都不满足,那么就验证一下个指针指向的数据:

图中第一个readview:当前事务是 4 不等于5,不小于3,不大于6,在3,4,5中,都不满足,去下一个链中的结点,还四个不满足,然后再到下一个,2小于3,说明事务已经提交了,就读这条记录,所以叫读已提交

RR(可重复读)下面的查询直接复用上面的readview,规则都是一样的,所以读到的东西都是一样的,所以是可重复读

锁

锁是计算机协调多个进程或线程并发访问某一资源的机制。在数据库中,除传统的计算资源(CPU、RAM、I/O)的争用以外,数据也是一种供许多用户共享的资源。如何保证数据并发访问的一致性、有效性是所有数据库必须解决的一个问题,锁冲突也是影响数据库并发访问性能的一个重要因素。从这个角度来说,锁对数据库而言显得尤其重要,也更加复杂。

在MySQL中,按照粒度可以把锁分为三类:

- 全局锁:锁定数据库中的所有表

- 表级锁:锁定某个数据库中的一整张表

- 行级锁:锁定某个表中对应的某一行数据

全局锁

全局锁就是对整个数据库实例加锁,加锁后整个实例就处于只读状态,后续的DML的写语句,DDL语句,已经更新操作的事务提交语句都将被阻塞。

其典型的使用场景是做全库的逻辑备份,对所有的表进行锁定,从而获取一致性视图,保证数据的完整性。

全库备份语法:

加锁

FLUSH TABLES WITH READ LOCK;

数据备份

MYSQLDUMP -uusername -ppassword database > filename.sql

释放锁

UNLOCK TABLES;

特点:

-

如果在主库上进行加全局锁备份,那么在备份期间都不能执行更新,业务基本无法正常进行。

-

如果在从库上进行加全局锁备份,那么在备份期间从库就无法与主库进行同步,会导致主从不同步。

-

在InnoDB引擎中,可以在备份时加上–single-transaction参数来完成不加锁的一致性备分:

-

MYSQLDUMP --single-transaction -uusername -ppassword database > filename.sql

表级锁

表级锁,每次操作锁住整张表。锁定粒度大,发生锁冲突的概率最高,并发度最低。应用在MyISAM、InnoDB、BDB等存储引擎中。

对于表级锁,主要分为三类:

- 表锁

- 意向锁

- 元数据锁(META DATA LOCK,MDL)

表锁

对于表锁,又可以分为两类:

表共享读锁(read lock)

表独占写锁(write lock)

语法:

加锁

LOCK TABLES 表名… read/write;

释放锁

UNLOCK TABLES; /或者 客户端断开连接

读锁不会阻塞其他客户端的读,但是会阻塞写。写锁既会阻塞其他客户端的读,又会阻塞其他客户端的写。

元数据锁(META DATA LOCK,MDL)

MDL加锁过程是系统自动控制,无需显式使用,在访问一张表的时候会自动加上。MDL锁主要作用是维护表元数据的数据一致性,在表上有活动事务的时候,不可以对元数据进行写入操作。为了避免DML与DDL冲突,保证读写的正确性。

在MySQL5.5中引入了MDL,当对一张表进行增删改查的时候,加MDL读锁(共享);当对表结构进行变更操作的时候,加MDL写锁(排他)。

也就是说,当对数据库有增删改查操作的时候,不能改表表结构,这里锁住的元数据就是表结构,不能用alter语句,元数据读锁共享,元数据写锁排他

查看元数据锁:

select object_type,object_schema,object_name,lock_type,lock_duration from performance_schema.metadata_locks ;

意向锁

为了避免DML在执行时,加的行锁与表锁的冲突,在InnoDB中引入了意向锁,使得表锁不用检查每行数据是否加锁,使用意向锁来减少表锁的检查。

意向锁又可以分为两种:

意向共享锁(IS):由SELECT … LOCK IN SHARE MODE添加

意向排他锁(IX):由INSERT、UPDATE、DELETE、SELECT … FOR UPDATE添加

而两种锁和表锁的兼容情况如下:

意向共享锁(IS):与表锁共享锁(read)兼容,与表锁排他锁(write)互斥

意向排他锁(IX):与表锁共享锁(read)及排他锁(write)都互斥。意向锁之间不会互斥。

就是加表锁的时候加上了意向锁,意向共享锁可以允许加表读锁,意向排他锁不允许加表的任何锁,等事务执行完了才能加表锁。

可以通过以下语句,查看意向锁及行锁的加锁情况:

select object_schema,object_name,index_name,lock_type,lock_mode,lock_data from performance_schema.data_locks;

行级锁

行级锁,每次操作锁住对应的行数据。锁定粒度最小,发生锁冲突的概率最低,并发度最高。应用在InnoDB存储引擎中。

如果行级锁不加索引,会进化为表锁

InnoDB的数据是基于索引组织的,行锁是通过对索引上的索引项加锁来实现的,而不是对记录加的锁。对于行级锁,主要分为以下三类:

行锁(RECORD LOCK):锁定单个行记录的锁,防止其他事务对此行进行update和delete。在RC、RR隔离级别下都支持。

间隙锁(GAP LOCK):锁定索引记录间隙(不含该记录),确保索引记录间隙不变,防止其他事务在这个间隙进行insert,产生幻读。在RR隔离级别下都支持。

临键锁(NEXT-KEY LOCK):行锁和间隙锁组合,同时锁住数据,并锁住数据前面的间隙Gap。 在RR隔离级别下支持。

行锁

InnoDB实现了两种类型的行锁:

共享锁(S):允许一个事务去读一行,阻止其他事务获得相同数据集的排它锁。

排他锁(X):允许获取排他锁的事务更新数据,阻止其他事务获得相同数据集的共享锁和排他锁

在默认情况下,InnoDB在REPEATABLE READ可重复读的隔离级别下运行,InnoDB使用NEXT-KEY锁进行搜索和索引扫描,以此来防止幻读。

针对唯一索引进行检索时,对已存在的记录进行等值匹配时,将会自动优化为行锁。

InnoDB的行锁是针对于索引加的锁,不通过索引条件检索数据,那么InnoDB将对表中的所有记录加锁,此时 就会升级为表锁。

可以通过以下语句,查看意向锁及行锁的加锁情况:

select object_schema,object_name,index_name,lock_type,lock_mode,lock_data from performance_schema.data_locks;

间隙锁/临键锁

默认情况下,InnoDB在 REPEATABLE READ事务隔离级别运行,InnoDB使用 next-key 锁进行搜索和索引扫描,以防止幻读。

- 索引上的等值查询(唯一索引),给不存在的记录加锁时,优化为间隙锁

- 索引上的等值查询(非唯一普通索引),向右遍历时最后一个值不满足查询需求时,next-key lock退化为间隙锁

- 索引上的范围查询(唯一索引)会访问到不满足条件的第一个值为止

- 间隙锁唯一目的是防止其他事务插入间隙。间隙锁可以共存,一个事务采用的间隙锁不会阻止另一个事务在同一间隙上采用间隙锁。

慢查询

如何定位慢查询?

如何分析慢查询?

Redis

Redis数据结构

1.字典

所谓字典,其实就是key value的结构,整个Redis就是这么一个字典结构,因为都是一个key对应一个value,所以整个Redis的结构就是一个Hash表,但是从途中可见,是有两个哈希表的,第二个哈希表平时不使用,只是在第一个需要扩容的时候使用第二个,然后互换身份。

当第一个hash表满足扩容条件了,触发Rehash,慢慢把数据扩容到第二hash表中,这叫渐进式的rehash,因此一次扩容过去会导致停顿时间太长用户无法接受。渐进式rehash期间增删改查需要同时访问两个hash表了就。

触发Rehash的条件有两个:

- 没有执行BGSAVE和BGREWRITEAOF命令时,并且哈希表的负载因子大于等于1

- 在执行BGSAVE和BGREWRITEAOF命令,并且哈希表的负载因子大于等于,虽然在执行持久化,但是此时数组中的元素过多,冲突太频繁

负载因子 = 哈希表已经保存的结点数量/哈希表大小

2.String类型:sds

为什么不用c语言的字符数组而是自己实现了一个sds呢?

- 因为c语言字符串判断结尾是通过/0的方式判断的,如果用他的话字符串中不能出现反斜杠0

- 因为c语言字符串获取长度和在尾部追加字符串都需要遍历获取长度,性能太差,用sds以后,有一个字段记录了len,所以性能更好

3.Zset实现:跳表

Zset有两种实现方式:

1.同时满足元素数量小于128和所有成员长度都小于64字节的时候,使用压缩列表实现(ziplist),7.0版本后已经废弃,改为listpack

2.最重要的是使用跳表+hash表(字典的方式来实现),里面既有一个hash表,又有一个跳表··

Hash表的作用只是为了查找某个元素排名的时候,有O(1)的复杂度,其余操作是由跳表完成的。

为什么使用跳表,而不是红黑树或者B+树这种数据结构,只是因为跳表实现比较简单,也不需要树结构的调整过程,比较方便。结构上有点像b+树,最底层的叶子结点,指针相连,前后指针

详细一点的话:

- 从内存占用上来比较,跳表比平衡树更灵活一些。平衡树每个节点包含 2 个指针(分别指向左右子树),而跳表每个节点包含的指针数目平均为 1/(1-p),具体取决于参数 p 的大小。如果像 Redis里的实现一样,取 p=1/4,那么平均每个节点包含 1.33 个指针,比平衡树更有优势。

- 在做范围查找的时候,跳表比平衡树操作要简单。在平衡树上,我们找到指定范围的小值之后,还需要以中序遍历的顺序继续寻找其它不超过大值的节点。如果不对平衡树进行一定的改造,这里的中序遍历并不容易实现。而在跳表上进行范围查找就非常简单,只需要在找到小值之后,对第 1 层链表进行若干步的遍历就可以实现。

- 从算法实现难度上来比较,跳表比平衡树要简单得多。平衡树的插入和删除操作可能引发子树的调整,逻辑复杂,而跳表的插入和删除只需要修改相邻节点的指针,操作简单又快速。

跳表的相邻两层的节点数量最理想的比例是 2:1,查找复杂度可以降低到 O(logN)。

下图的跳表就是,相邻两层的节点数量的比例是 2 : 1。

因为2比1的话,查找的时候就相当于在链表上进行二分查找了

怎样创建各级索引,产生随机数,随机生成索引

Redis 则采用一种巧妙的方法是,跳表在创建节点的时候,随机生成每个节点的层数,并没有严格维持相邻两层的节点数量比例为 2 : 1 的情况。

具体的做法是,跳表在创建节点时候,会生成范围为[0-1]的一个随机数,如果这个随机数小于 0.25(相当于概率 25%),那么层数就增加 1 层,然后继续生成下一个随机数,直到随机数的结果大于 0.25 结束,最终确定该节点的层数。

这样的做法,相当于每增加一层的概率不超过 25%,层数越高,概率越低,层高最大限制是 64。

虽然我前面讲解跳表的时候,图中的跳表的「头节点」都是 3 层高,但是其实如果层高最大限制是 64,那么在创建跳表「头节点」的时候,就会直接创建 64 层高的头节点。

// 跳表结点信息

typedef struct zskiplistNode {

//Zset 对象的元素值

sds ele;

//元素权重值

double score;

//后向指针,指向上一个元素

struct zskiplistNode *backward;

//节点的level数组,保存每层上的前向指针和跨度

struct zskiplistLevel {

struct zskiplistNode *forward; // 指向右边元素的指针

unsigned long span; // 跨度

} level[];

} zskiplistNode;

有了跨度就可以近似做二分查找了

如果上面两个条件都不满足,或者下一个节点为空时,跳表就会使用目前遍历到的节点的 level 数组里的下一层指针,然后沿着下一层指针继续查找,这就相当于跳到了下一层接着查找。

举个例子,下图有个 3 层级的跳表。

如果要查找「元素:abcd,权重:4」的节点,查找的过程是这样的:

- 先从头节点的最高层开始,L2 指向了「元素:abc,权重:3」节点,这个节点的权重比要查找节点的小,所以要访问该层上的下一个节点;

- 但是该层的下一个节点是空节点( leve[2]指向的是空节点),于是就会跳到「元素:abc,权重:3」节点的下一层去找,也就是 leve[1];

- 「元素:abc,权重:3」节点的 leve[1] 的下一个指针指向了「元素:abcde,权重:4」的节点,然后将其和要查找的节点比较。虽然「元素:abcde,权重:4」的节点的权重和要查找的权重相同,但是当前节点的 SDS 类型数据「大于」要查找的数据,所以会继续跳到「元素:abc,权重:3」节点的下一层去找,也就是 leve[0];

- 「元素:abc,权重:3」节点的 leve[0] 的下一个指针指向了「元素:abcd,权重:4」的节点,该节点正是要查找的节点,查询结束。

4.hyperloglog、Geo、bitmap

hyperloglog:

UA统计适合用hyperloglog做,虽然有点误差,但是内存永远小于16kb,有一定的误差容忍的场景非常合适。UA统计可以统计一天大概有多少人来访问,然后合并每天的人数。

- UV:全称Unique Visitor,也叫独立访客量,是指通过互联网访问、浏览这个网页的自然人。1天内同一个用户多次访问该网站,只记录1次。

- PV:全称Page View,也叫页面访问量或点击量,用户每访问网站的一个页面,记录1次PV,用户多次打开页面,则记录多次PV。往往用来衡量网站的流量。

通常来说PV会比UV大很多,所以衡量同一个网站的访问量,我们需要综合考虑很多因素,所以我们只是单纯的把这两个值作为一个参考值

UV统计在服务端做会比较麻烦,因为要判断该用户是否已经统计过了,需要将统计过的用户信息保存。但是如果每个访问的用户都保存到Redis中,数据量会非常恐怖,那怎么处理呢?

Hyperloglog(HLL)是从Loglog算法派生的概率算法,用于确定非常大的集合的基数,而不需要存储其所有值。相关算法原理大家可以参考:https://juejin.cn/post/6844903785744056333#heading-0

Redis中的HLL是基于string结构实现的,单个HLL的内存永远小于16kb,内存占用低的令人发指!作为代价,其测量结果是概率性的,有小于0.81%的误差。不过对于UV统计来说,这完全可以忽略

BitMap:

位图,使用一个数组的某一个位来记录某个元素有没有出现过,打比方有个int的数组吧,每个int是32位,来了个数660,先找到这个数是数组的第几个数,用660除32,然后找到在这个数的第几位 设为n,用660余32,置1的时候,把1左移刚才求的n位数,然后按位或1就可以了

// 5.写入Redis SETBIT key offset 1,把某个用户作为key,今天是本月的第几天 对应的位置1,标志用户签到过

stringRedisTemplate.opsForValue().setBit(key, dayOfMonth - 1, true);

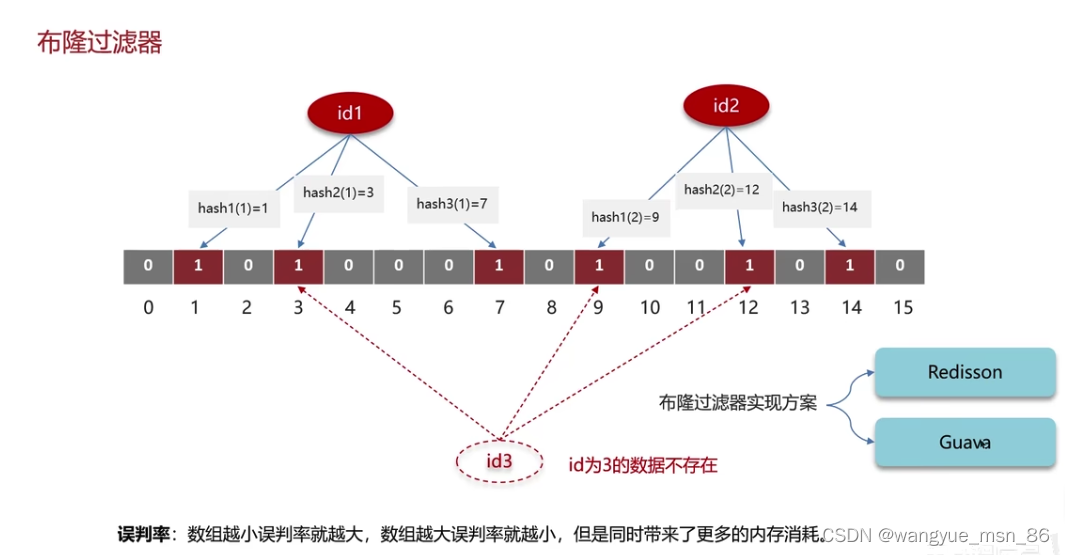

位图有一个升级版,布隆过滤器,使用的就是位图,外加多个hash函数,一个hashcode经过多次hash给不同的位置1,有一定的误判率,可以设置误判率,误判率设置小的话,那么显然数组长度比较大,哈希函数的数量也比较多。

Geo:

Redis GEO 是 Redis 3.2 版本新增的数据类型,主要用于存储地理位置信息,并对存储的信息进行操作

GEO 本身并没有设计新的底层数据结构,而是直接使用了 Sorted Set 集合类型。

GEO 类型使用 GeoHash 编码方法实现了经纬度到 Sorted Set 中元素权重分数的转换,这其中的两个关键机制就是「对二维地图做区间划分」和「对区间进行编码」。一组经纬度落在某个区间后,就用区间的编码值来表示,并把编码值作为 Sorted Set 元素的权重分数。

用途是可以把各个商家的地理位置,就是经纬度存进去,然后可以根据用户的位置排序,计算离用户最近的前几个商家,sortedSet的score可能是两者距离的差值

缓存

如何解决缓存穿透?

缓存穿透就是查询不存在的数据,请求都会到数据库:

- 缓存空数据(该项目使用这种方式)

- 布隆过滤器

缓存空对象的缺点:

- 缓存一致性问题: 使用缓存空数据时,需要考虑如何保持缓存的一致性。如果在数据库中的数据发生变化(例如新增、更新或删除数据),但缓存中的空数据没有及时更新,就会导致缓存与数据库不一致的问题。

- 缓存占用空间: 缓存空数据也会占用一定的内存空间。如果缓存中的空数据过多,可能会导致内存资源不足,从而影响其他重要数据的缓存。

布隆过滤器:

要确定误判率设置成多少,设置小的话需要增加哈希函数个数,并且增加数组长度。

要保证一致性,预热完了以后,那么数据库插入数据也要给布隆过滤器插入,删除就容忍

我们项目中使用的就是缓存空数据的方式来解决缓存穿透的,布隆过滤器比较 复杂,且有一定的误判率,如果想降低误判率要增大数组的大小。而我们的项目只有内网能访问到,使用缓存空数据的方法就可以了。在数据库查不到的时候,

黑马点评解决缓存穿透:

// 防止缓存穿透

public Shop queryWithPassThrough(Long id){

String key = CACHE_SHOP_KEY+id;

String shopJson = stringRedisTemplate.opsForValue().get(key);

if (StrUtil.isNotBlank(shopJson)){

// redis中存在,直接返回

Shop shop = JSONUtil.toBean(shopJson,Shop.class);

return shop;

}

// 判断命中的是否有空值

if (shopJson!=null){

return null;

}

// 不存在,根据id查询数据库

Shop shop = getById(id);

if (shop == null){

// 将空值写入redis中,防止缓存穿透

stringRedisTemplate.opsForValue().set(key,"",CACHE_NULL_TTL,TimeUnit.MINUTES);

return null;

}

// 存在,写入redis中

stringRedisTemplate.opsForValue().set(key,JSONUtil.toJsonStr(shop),CACHE_SHOP_TTL, TimeUnit.MINUTES);

return shop;

}

布隆过滤器:相当于一个大的字节类型的数组,key来了以后,通过3次不同的hash,计算数组对应的位置改为1,如果三个位置都是1,说明存在这个集合中

是有一定的误判率的,比如id为3的数据是不存在的,但是经过3次hash,对应位置也都是1,数组大误判率才小

如何解决缓存击穿?

缓存击穿就是热点key突然过期,然后大量的请求打到了数据库,数据库承担不了压力。

本项目使用的是逻辑过期的方式解决的。因为互斥锁的方式性能太低,而本项目一致性要求没有那么高,所以选择逻辑过期方式

互斥锁:就是分布式锁,查询如果拿不到锁就一直等待,性能比较低

逻辑过期:加锁,新开一个线程去查数据库写缓存,其他线程直接返回过期的值,一致性暂时没有那么好

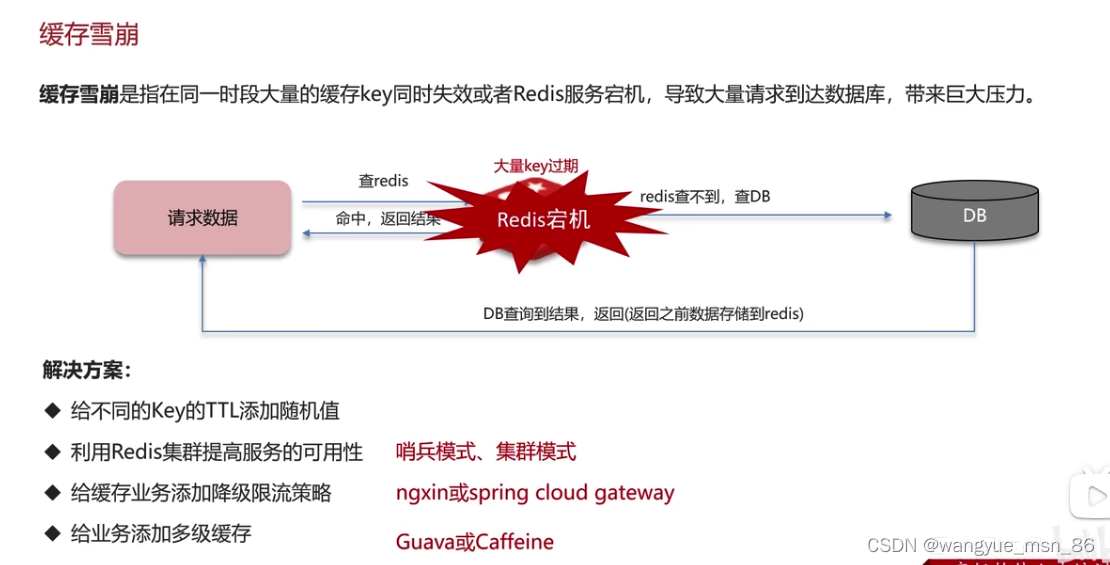

如何解决缓存雪崩?

本项目是尽量给不同的key的ttl添加随机值

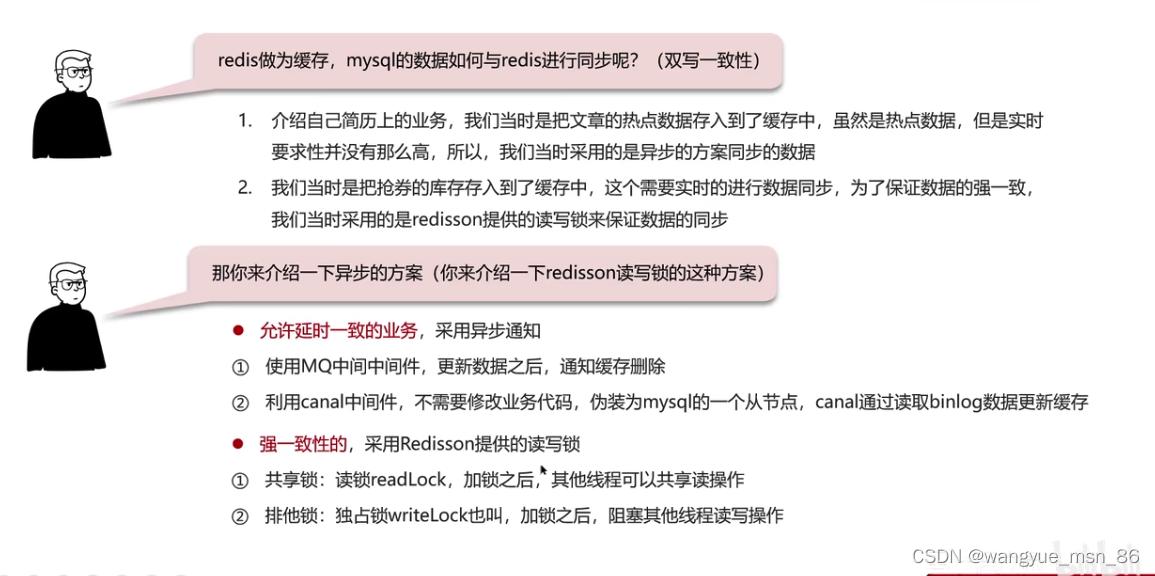

如何保证缓存双写一致性问题?

可见这两种方式都会出现不一致的现象:

延迟双删:

- 为什么双删? 上面的先删缓存再更新数据库也会出现问题。 所以再删除一次,减少脏数据的出现

- 为什么延时? 因为数据库经常是主从模式 需要一些时间 让主节点把数据传到从节点

但是延迟双删还是有出现脏数据,因为迟时间不容易判断,也没法保证强一致,在延时的时候有可能出现不一致

强一致手段:加分布式锁 redssion等。 加redssion的读写锁

如果不追求强一致性,只追求最终一致性的方法:

- 使用mq来保证最终一致性,数据库修改后发送消息,缓存服务来接收消息,更新缓存,因为MQ是可以保证可靠性的,所以保证了最终一致性

-

使用阿里的canal:基于mysql的主从同步来实现的无侵入性,比较推荐

回答:分两种

我的项目是不要求强一致性的,所以使用RabbitMQ的方式实现了最终一致性

Redis数据过期策略

Redis是惰性删除和定期删除配合使用的

只使用惰性删除的缺点:容易有很多过期的没有删除影响内存

只用定期删除:最大的问题是,比如1s钟删除一次,那么如果有正好要过期的,在下一次删除之前过期了,那么你仍然可以访问到这个过期数据,就会造成一致性问题。

还有定期删除会浪费cpu,要定期的执行

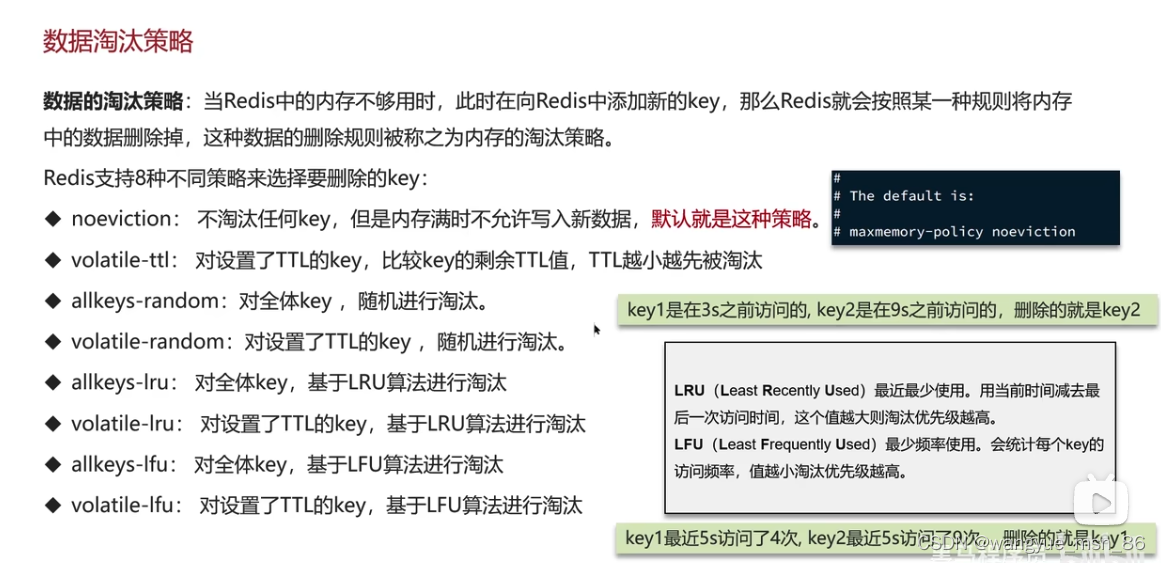

Redis数据淘汰策略(LRU和LFU)

记住默认的 理解LRU和LFU

数据淘汰策略建议:

Redis大key的处理方法

什么是Redis大key?

- string类型的值超过10kb

- hash,list,set,zset元素超过5000个

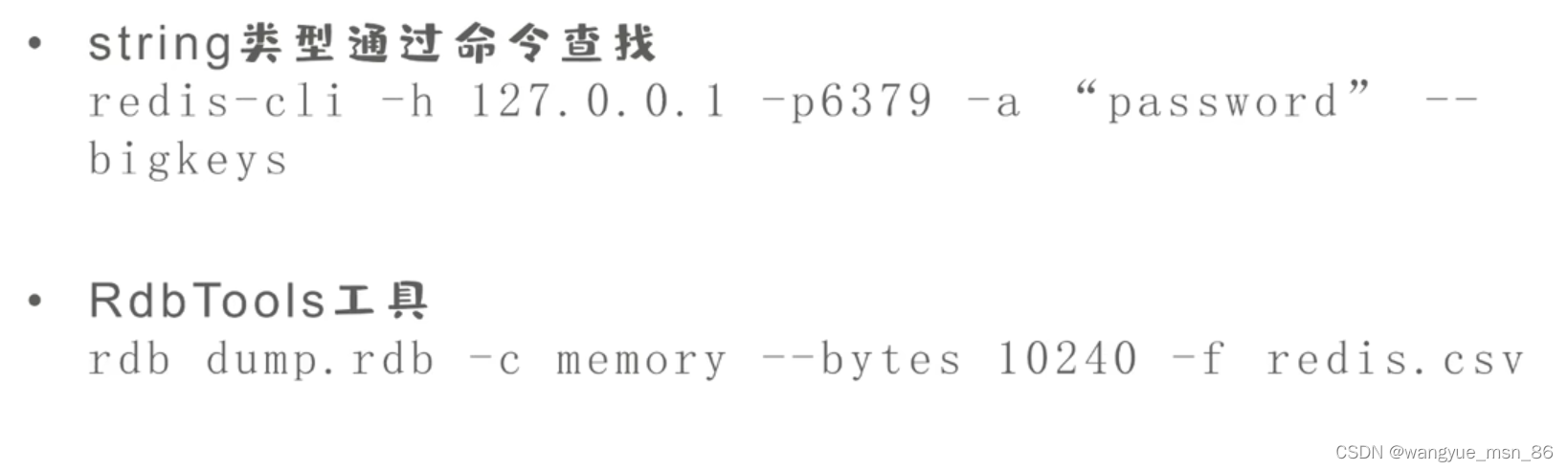

如何找到大key?string类型通过命令查找,其他类型通过一个工具(RDBTools)查找

删除大key:

推荐的方法:使用unlink代替del进行异步删除,会开启一个异步线程,不会阻塞主线程

直接删除会阻塞主线程,影响起来请求的执行,在凌晨挑选用户访问少的时候删除,或者分批次删除,但是还是异步删除的方式比较好

如何大key不能删除,比如业务上还需要用大key,那么可以把大key分掉,就像分库分表一样,比如跟据日期等进行拆分,或者使用分片集群模式,将大key分散到不同的服务器上。

持久化

Redis数据持久化是怎么做的?

RDB和AOF

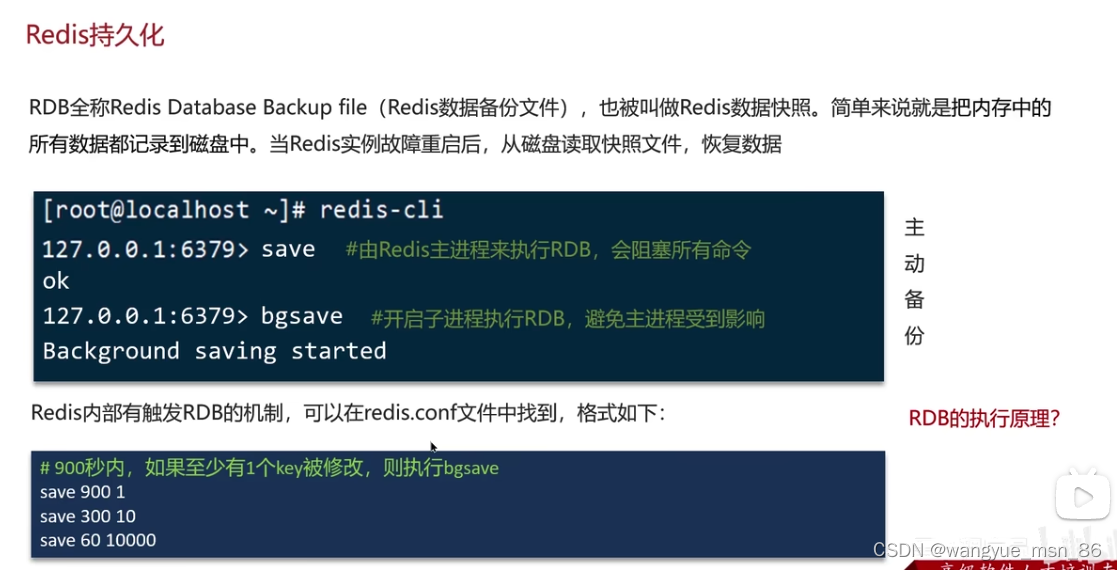

RDB:Redis数据快照,把内存中的数据都记录到磁盘。bgsave比较好,是开启子进程(注意是进程不是线程)执行RDB。通过设置配置文件,可以自动执行bgsave

RDB bgsave的原理:

主进程fork一个子进程,fork相当于复制了,操作系统通过页表来映射虚拟地址(逻辑地址)和物理地址,所以只需要复制页表到子进程就行了。

子进程将新的rdb文件替换旧的rdb文件,但是这时候主进程可以写,有可能造成脏数据怎么办

fork采用copy on write技术 当两个进程读时,访问共享内存,当主进程写时,拷贝一份数据,执行写操作,这以后主进程再读也是读拷贝的数据,避免了脏写的问题

AOF :追加文件,redis处理的写命令都会记录在AOF文件中

AOF默认关闭的:修改配置文件开启

配置频率:always 每执行写命令 都记录

everysec(就用这个):每隔一秒将缓冲区数据写到AOF文件

AOF重写:如果set一个key好几次 是不是只有最后一次有意义,可以对AOF文件重写,合并重复的命令。 也可以修改配置文件达到阈值自动重写

二者的比较:

我们使用的是AOF来恢复的,因为他丢失数据的风险比较小,当是设置的是每秒批量写入一次数据 ,当redis宕机的时候,用AOF文件再运行一遍命令就行了

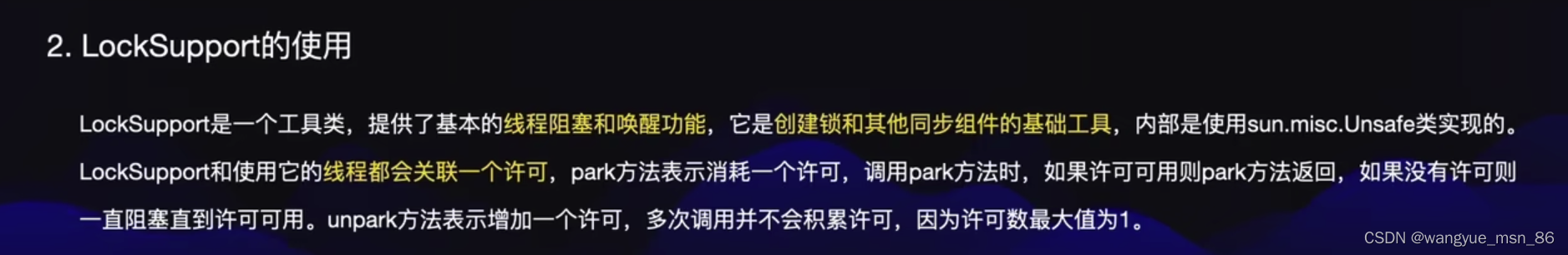

分布式锁

setNX命令,以及他的问题:

如果有个业务时间很长,业务没执行完setNX过期了怎么办:给锁续期,就是看门狗机制

redisson:强化了setNX,开一个看门狗线程为锁进行续期,这就比不设置过期时间强,遇到意外如宕机之类的情况锁可以释放。

其他获取锁的线程通过自旋的方式等待,比阻塞性能要好;

redisson可重入,redisson上锁和设置过期时间是通过lua脚本执行的,保证了原子性。

Redis为什么快

瓶颈在于网络而不是执行速度

单个线程监听多个Socket,相当于全班人去等饭,只留下一个人等消息,谁的饭好的就发消息告诉他好了,那么是不是其他人的时间就节省了

select和poll不知道具体是哪个socket就绪,epoll不用遍历

IO多路复用+事件派发 解析命令和命令回复是多线程

JVM

JVM内存结构

什么是程序计数器?

程序计数器用于保存字节码行号,用来记录正在执行的字节码指令的地址,是线程私有的

JVM内存结构?

共有5部分:

- 程序计数器:记录当前线程执行的字节码行号,线程私有

- 虚拟机栈:存放基本数据类型,引用类型,方法的出口,线程私有

- 本地方法栈:和虚拟机栈类似,不过服务的是本地方法,线程私有

- 堆:Java内存最大的一块,所有对象实例和数组的存放区,线程共享,垃圾回收的主要区域

- 方法区:存放已经被加载的类型信息,常量,静态变量,线程共享

方法区、元空间、永久代的区别?

方法区是Java虚拟机规范中规定的区域,而元空间和永久代是该规范的两个实现,java8之前叫永久代,java8之后叫元空间。

java8之后,元空间移动到了本地内存(防止放在堆里容易产生OOM),但字符串常量池仍留在堆里

讲讲虚拟机栈?

1.比较重要,由多个栈桢组成,对应着每次方法调用时占用的内存,以及只能有一个活动栈桢对应着当前正在执行的方法ddddddddddd

3.默认栈内存是1024k,加入机器总内存512m,那么目前能活动的线程就是512个,如果把栈内存改为2048,能活动的线程就减半了

堆内存不足 :oom outofmemoryError

栈内存不足:stackoverflowError 都是error类型,比较严重

什么是直接内存?

不属于jvm的内存结构,是操作系统分配给虚拟机的内存,操作系统和虚拟机都可以直接读取,常用于NIO,如图,如果系统一个缓冲区,java堆内存一个缓冲区,把数据从一个缓冲区复制到另一个,那么性能较差,就有了系统和java都可以访问的直接内存。

分配回收成本较高,但是读写性能高,不受JVM内存回收影响

垃圾回收

标记方法

有几种标记对象已死的方法?

- 引用计数法

- 可达性分析法

那么在JVM中究竟是如何标记一个死亡对象呢?简单来说,当一个对象已经不再被任何的存活对象继续引用时,就可以宣判为已经死亡。

引用计数法:引用计数算法(Reference Counting)比较简单,对每个对象保存一个整型的引用计数器属性。用于记录对象被引用的情况。

对于一个对象A,只要有任何一个对象引用了A,则A的引用计数器就加1;当引用失效时,引用计数器就减1。只要对象A的引用计数器的值为0,即表示对象A不可能再被使用,可进行回收。

优点:实现简单,垃圾对象便于辨识;判定效率高,回收没有延迟性。

缺点:它需要单独的字段存储计数器,这样的做法增加了存储空间的开销。

如果对象A和对象B相互引用,形成了循环引用。即使没有其他外部引用指向这两个对象,它们的引用计数永远不会达到零,因此无法被垃圾回收。内存就泄漏了

每次赋值都需要更新计数器,伴随着加法和减法操作,这增加了时间开销。

引用计数器有一个严重的问题,即无法处理循环引用的情况。这是一条致命缺陷,导致在Java的垃圾回收器中没有使用这类算法。

可达性分析法:可达性分析算法:也可以称为 根搜索算法、追踪性垃圾收集

相对于引用计数算法而言,可达性分析算法不仅同样具备实现简单和执行高效等特点,更重要的是该算法可以有效地解决在引用计数算法中循环引用的问题,防止内存泄漏的发生。

相较于引用计数算法,这里的可达性分析就是Java、C#选择的。这种类型的垃圾收集通常也叫作追踪性垃圾收集(Tracing Garbage Collection)

所谓"GCRoots”根集合就是一组必须活跃的引用。

基本思路:

- 可达性分析算法是以根对象集合(GCRoots)为起始点,按照从上至下的方式搜索被根对象集合所连接的目标对象是否可达。

- 使用可达性分析算法后,内存中的存活对象都会被根对象集合直接或间接连接着,搜索所走过的路径称为引用链(Reference Chain)

- 如果目标对象没有任何引用链相连,则是不可达的,就意味着该对象己经死亡,可以标记为垃圾对象。

- 在可达性分析算法中,只有能够被根对象集合直接或者间接连接的对象才是存活对象。

总结一句话就是,除了堆空间外的一些结构,比如 虚拟机栈、本地方法栈、方法区、字符串常量池 等地方对堆空间进行引用的,都可以作为GC Roots进行可达性分析,为什么三色标记的时候,第一步是要先标记GCRoots可以直接关联到的对象?

因为GCROOTS是一组引用集合,不是对象集合,先拿到所有关联的对象,然后去堆中去遍历整个对象图。

如果想要并发标记,就采用三色标记,先找到直接关联的对象,再并发的标记整个图,期间用户线程的改动,使用写屏障技术保证正确性,就是不让你写,然后最后再重新标记一下就行了,整个过程,只有并发标记是不需要STW的。

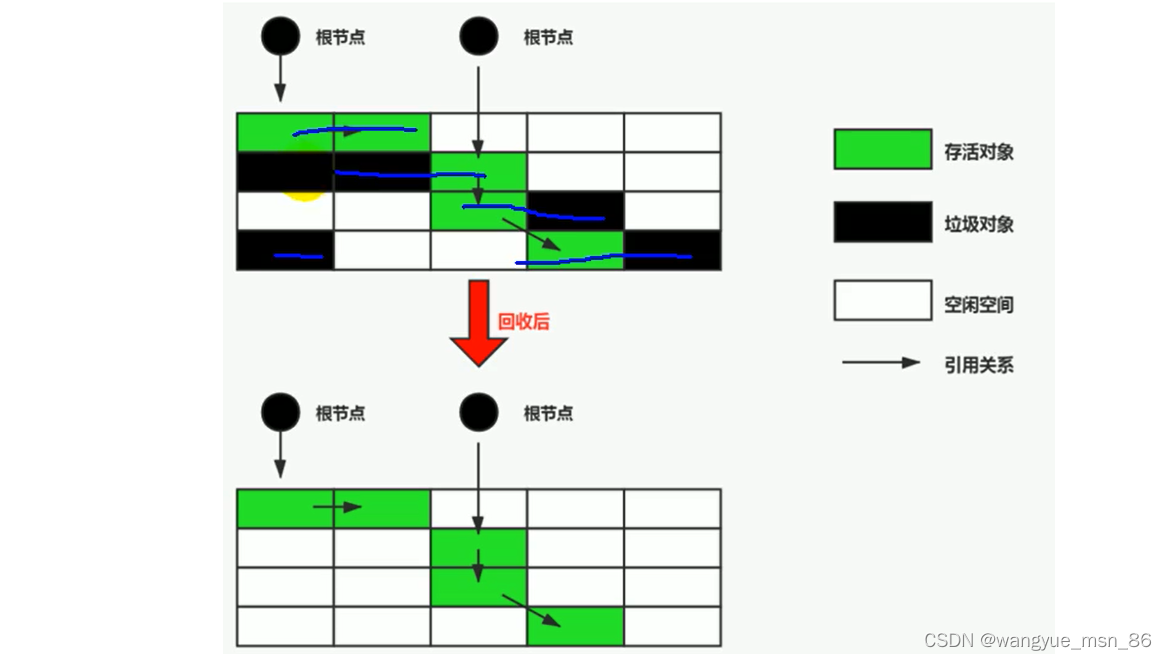

常用的垃圾回收算法

1.标记清除算法

当堆中的有效内存空间(available memory)被耗尽的时候,就会停止整个程序(也被称为stop the world),然后进行两项工作,第一项则是标记,第二项则是清除

- 标记:Collector从引用根节点开始遍历,标记所有被引用的对象。一般是在对象的Header中记录为可达对象。

- 标记的是引用的对象,不是垃圾!!

- 清除:Collector对堆内存从头到尾进行线性的遍历,如果发现某个对象在其Header中没有标记为可达对象,则将其回收(这里所谓的清除并不是真的置空,而是把需要清除的对象地址保存在空闲的地址列表里)

缺点:

- 标记清除算法的效率不算高

- 在进行GC的时候,需要停止整个应用程序,用户体验较差

- 这种方式清理出来的空闲内存是不连续的,产生内碎片,需要维护一个空闲列表

2.标记复制算法(主要用于回收新生代)

将活着的内存空间分为两块,每次只使用其中一块,在垃圾回收时将正在使用的内存中的存活对象复制到未被使用的内存块中,之后清除正在使用的内存块中的所有对象,交换两个内存的角色,最后完成垃圾回收

标记清除算法中分为标记和清除两个阶段,但是标记复制算法并没有标记阶段,为什么呢?

首先要明确判断对象是否存活的核心思想是用根可达算法找出存活对象,由于标记清除算法需要回收垃圾对象,所以需要对存活对象进行标记,然后清除不可用对象。

而复制算法是要复制存活对象到另一块区域,所以在根可达算法发现存活对象后是直接复制到另一块区域,即在根可达分析过程中就已经完成了筛选(复制),待复制完成后,直接清理掉另一块区域即可,所以没有标记的必要。我感觉也没啥提升,标记一下也费不了多少事儿(不还是得可达性分析遍历一遍gcroots吗)。

- 没有标记和清除过程,实现简单,运行高效

- 复制过去以后保证空间的连续性,不会出现“碎片”问题。

缺点: