论文名:Single image dehazing for a variety of haze scenarios using back projected pyramid network【基于反投影金字塔网络的多雾场景单幅图像去雾】

论文地址:2008.06713v1.pdf (arxiv.org)![]() https://arxiv.org/pdf/2008.06713v1.pdf

https://arxiv.org/pdf/2008.06713v1.pdf

目录

摘要

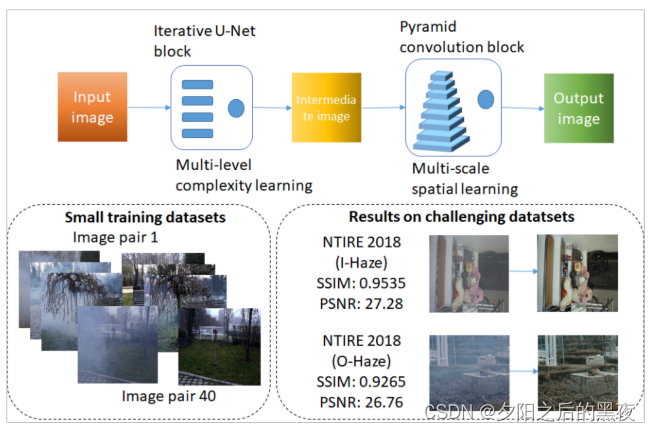

学习去雾单个模糊图像,特别是使用小的训练数据集是相当具有挑战性的。我们针对这个问题提出了一种新的生成对抗网络架构,即反向投影金字塔网络(BPPNet),它在各种具有挑战性的雾霾条件下具有良好的性能,包括密集的雾霾和不均匀的雾霾。我们的架构采用了多层次的复杂性的学习,同时保留通过迭代块的UNets和多尺度的结构信息,通过一个新的金字塔卷积块的空间上下文。这些块一起用于生成器,并且可以通过反向投影进行学习。我们已经证明,我们的网络可以在没有过度拟合的情况下使用少至20对模糊和非模糊图像进行训练。我们报告了NTIRE 2018室内和室外图像均匀雾霾数据集,NTIRE 2019 denseHaze数据集和NTIRE 2020非均匀雾霾数据集的最新性能。

关键词:单幅图像去雾,生成对抗网络,反投影,深度学习

1、 介绍

在日常生活中,由于尘埃、烟、雾等悬浮在环境中的颗粒物会极大地影响场景的图像质量,恶劣天气也会对此起到推波助澜的作用。 除了图像中明显较高和不均匀的噪声之外,通常的影响是能见度降低、清晰度降低、能见度范围内物体的对比度降低和其他物体的模糊。 因此,对这些图像进行目标检测、目标识别、跟踪和分割等计算机视觉任务变得复杂。 因此,计算机视觉赋能的自动化和远程监控系统如无人机和机器人的真正潜力无法在朦胧条件下实现。 因此,如何提高均匀性和非均匀性朦胧条件下的图像质量,恢复场景的细节是人们关注的问题。 雾霾去除或去雾算法解决了这个问题。

近几年来,去雾化的课题有了很大的发展。从基于物理学的求解器、基于图像处理的算法以及基于深度学习的方法等新算法正在被提出。此外,还有一些新的挑战正在进行中,包括在密集的雾霾、非同质的雾霾以及使用单一的场景RGB图像的情况下进行去雾化。人们认识到,如果有适当设计的大型数据集,深度学习架构在不同的、具有挑战性的脱灰场景中提供比其他方法更好的性能。然而,通过深度学习在小型数据集上使用单一的RGB图像进行图像脱灰是相当具有挑战性的,而且具有重要的实际意义。例如,在火灾管理或自然灾害管理的情况下,需要利用少量的雾霾图像和相应的灾前图像快速学习一个适合该情况的脱灰模型。

我们提出了一种新的深度学习体系结构,该体系结构能够使用小数据集对去黑海模型进行可靠的学习。 我们的生成对抗网络(GAN)结构包括UNets的迭代块和金字塔卷积块,该迭代块用于建模不同复杂度的雾霾特征,并用于保存和恢复不同尺度的空间特征。 本文的主要贡献如下:

- 提出了一种新的金字塔卷积去雾技术,以获得多尺度结构信息的空间特征。

- 我们使用迭代UNet块进行图像去雾任务,使生成器学习不同的和复杂的烟雾特征,而不会丢失局部和全局结构信息,也不会使网络太深而导致空间特征丢失。

- 所使用的模型是端到端可训练的,模糊图像作为输入,无模糊图像作为期望的输出。因此,避免了使用大气散射模型的常规实践,并且避免了逆重建中遇到的问题。这也使得该方法更通用,并适用于雾霾的情况下,传统的简化大气模型可能不适用。

- 在四个当代具有挑战性的数据集上进行了广泛的实验,即NTIRE 2018挑战的I-Haze和O-Haze数据集,NTIRE 2019挑战的稠密雾数据集,以及NTIRE 2020挑战的非均匀去雾数据集。

论文的提纲如下。第2节介绍了相关的工作,第3节介绍了我们的架构和学习方法。第4节给出了数值实验和结果。第5节包括对拟定方法的消融研究。第六节是论文的结论。

2、相关工作

由于本文的重点是单一的图像去雾,我们排除了讨论的研究,需要多个图像,例如,利用偏振,执行去雾。单个图像去雾是一个不适定的问题,因为测量的数量不足以学习雾度模型,并且雾度模型的非线性意味着对噪声的更高灵敏度。基于单个图像的去雾利用由Koschmieder [16]提出的与偏振无关的大气散射模型及其特性,例如暗通道、颜色衰减和无雾先验。根据该模型,模糊图像由大气光(通常假设均匀)、场景中物体的反照率和模糊介质的透射图指定。更多的细节可以在[16]及其随后的引文中找到,包括最近的引文[7,23]。我们必须预测未知的传输图和全球大气光。在过去,已经提出了许多方法用于该任务。这些方法可以分为两类,即(i)传统的基于手工先验的方法和(ii)基于学习的方法。

传统的手工制作的基于先验的方法:Fattal [9]通过估计场景的反照率提出了一种物理接地方法。Tan [22]提出使用马尔可夫随机场来最大化图像的局部对比度。He等人。[12]提出了一种用于估计传输图的暗通道先验。Fattal [10]提出了一种基于小图像块通常在RGB颜色空间中呈现一维分布的观察的色线方法。传统的手工先验方法对于某些情况给予良好的结果,但对于所有情况都不稳健。

基于学习的方法:近年来,已经提出了许多基于学习的方法用于单图像去雾,这些方法体现了深度学习在图像处理任务中的成功,大型数据集的可用性以及更好的计算资源。这里简要地提到一些例子。Cai等人。[6]提出了一种基于端到端CNN的深度架构来估计传输图。Ren等人。[20]提出了一种多尺度深度架构,该架构还可以从雾度图像中估计透射图。Zhang等人在[25]中提出了一种估计传输图和大气光的深度网络架构。这些估计然后与大气散射模型一起使用以生成无雾图像。

我们的方法在上下文中:与这些方法相比,我们的方法是基于端到端学习的方法,其中学习的模型直接预测无雾图像,而不需要重建透射图和大气光,或使用大气散射模型。因此,对于[16]的大气散射模型可能不适用或可能过于简单的情况,训练它是更通用的。示例包括不均匀的雾度。它还避免了与使用从透射图和大气光重建无雾图像的逆方法相关联的数值误差和伪影。

3、拟议方法

在本节中,我们将介绍我们的模型,即反向投影金字塔网络(BPPNet)。整体架构基于生成对抗网络[11],其中生成器从模糊图像生成无雾图像,并且鉴别器告诉提供给它的图像是否真实的。

3.1、生成器

生成器的架构如图2所示。它包括串联的两个块,即(i)迭代UNet块,(ii)金字塔卷积块,我们接下来描述。

迭代UNet块(IUB):该块由串联连接的多个UNet [21]单元组成,即一个UNet(补充中的架构)的输出作为下一个UNet的输入被馈送。此外,每个UNet的输出被传递到级联器,该级联器级联所有UNet的3通道输出,从而提供中间12通道特征图。描述IUB工作的方程如下。

其中是第

个UNet单元的输出,

是变换到YCbCr空间之后的输入模糊图像,并且IUB的输出

被给出为

其中,表示级联运算符,是UNet单元的数量。我们使用

= 4。关于

值的消融研究见第5节。在这里,我们讨论需要一个以上的UNet。

原则上,单个UNet可能能够在一定程度上支持去雾。然而,它可能无法提取复杂的特征并生成具有精细细节的输出。解决该问题的一种方式是增加编码器块中的层的数量,使得可以学习更复杂的特征。但是编码器块中的层以前馈方式布置,并且层的高度和宽度在进一步移动时减小。这导致空间信息的损失,并且降低了提取高复杂度的空间特征的可能性。因此,我们采用另一种方法来创建多个UNet的序列。UNet的序列可以被解释为具有跳过连接的多个编码器-解码器对的序列。每个UNet中的编码器从下采样特征图中的输入张量中提取特征,并且解码器使用这些特征并将它们投影到具有与输入张量相同的高度和宽度的上采样潜在空间中。以这种方式,每个生成器有助于学习越来越复杂的雾度特征,而解码器有助于保留图像中的空间信息。最后,级联步骤确保所有级别的复杂度可用于后续重构。

我们在图3中说明了使用多个UNet的效果。每个UNet的直方图均衡的3通道输出被示出为RGB图像。可以看出,空间背景被保留,并且同时在不同图像的输出中存在不同复杂度的雾引入的模糊。最后一个UNet输出中的雾度在整个图像上更平坦并且示出大尺度模糊,而第一个UNet中的雾度是局部的并且引入小尺度模糊。因此,大多数去雾都是在UNet1中完成的,尽管后续的UNet选择了先前UNet没有选择的去雾组件。图3还解释了我们仅选择四个UNet块,即使原则上可以使用更多块。我们分两部分来解释我们的选择。首先,在选择UNet块的数量时,在准确性和速度之间存在折衷。其次,如图3中的直方图所示,信道的动态范围随着每个后续UNet块而减小,从而指示可用信息内容的减少。UNet4后3个通道中强度值的标准偏差为12.2。添加更多的块将进一步降低该值,并且因此不能提供用于去雾的显著可利用的数据。

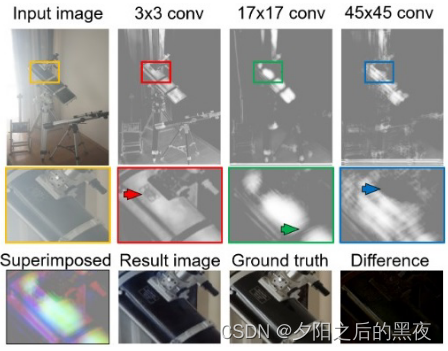

金字塔卷积(PyCon)块:虽然迭代UNet块确实提供了全局和局部结构信息,但是输出缺少针对不同大小的对象的全局和局部结构信息。一个根本原因是来自不同尺度的结构信息不直接用于生成输出。为了克服这个问题,我们使用了一种新的金字塔卷积技术。在[21]中已经使用了早期的金字塔池来利用全局结构信息。然而,由于池化层是不可学习的,因此我们采用可学习的卷积层,它可以轻松地在利用信息方面胜过池化层。

我们在输入映射(迭代UNet块的12通道输出12=4个UNet*3通道)上并行使用不同内核大小的许多卷积层。对应于用于卷积的不同核大小,利用不同空间尺度的结构信息生成不同的输出图。如图2中所示,核大小被选择为3、5、7、11、17、25、35和45。使用奇数大小的内核,因为假设中间特征图中的像素围绕输出像素对称。我们观察到使用均匀大小的内核时在层上引入失真,这表明利用输出像素周围的特征的对称性的重要性。零填充用于确保边缘处的特征不丢失。在从相应的内核生成特征图之后,所有生成的图被连接以生成128个通道的输出特征图,随后通过应用具有零填充的内核大小为3×3的卷积层来用于最终图像构造。以这种方式,局部到全局信息直接用于最终图像重建。【8个卷积层的输出拼接成128通道特征图=每层输出16通道特征图*8个卷积层】

使用金字塔卷积的效果如图4所示。在中间面板中所示的放大图中,箭头指示用于生成该特定特征图的卷积滤波器的大小的一些特征。所示的3个通道被叠加为图4的左下角中的假设RGB图像,以展示存在于输出特征图的子集中的细节的类型。由于我们使用了在12通道输入上操作的8个卷积滤波器,因此我们在输出特征图中生成了总共128个通道,其中包含学习和恢复的多种尺度的各种空间特征。因此,在底部面板中示出的结果图像具有与地面实况紧密匹配的空间特征,从而产生低差异图(在右下角中示出)。

使用金字塔卷积的效果如图4所示。在中间面板中所示的放大图中,箭头指示用于生成该特定特征图的卷积滤波器的大小的一些特征。所示的3个通道被叠加为图4的左下角中的假设RGB图像,以展示存在于输出特征图的子集中的细节的类型。由于我们使用了在12通道输入上操作的8个卷积滤波器,因此我们在输出特征图中生成了总共128个通道,其中包含学习和恢复的多种尺度的各种空间特征。因此,在底部面板中示出的结果图像具有与地面实况紧密匹配的空间特征,从而产生低差异图(在右下角中示出)。

可以考虑使用迭代UNet块的12通道输出来直接生成去雾图像,而不采用PyCon块。为了说明纳入PyCon阻滞的重要性,我们在第5节中纳入了消融研究。

3.2、判别器

我们已经使用了一个补丁鉴别器,以确定是否一个特定的补丁是现实的或不。为了消除边缘上的低性能问题,片重叠。我们在鉴别器中使用了4×4卷积层。在每个卷积层之后,我们添加了一个具有激活泄漏整流线性单元(Leaky ReLu)的激活层,除了激活函数为sigmoid的最后一层。使用的卷积核大小为4×4,对于大小为512×512的输入,输出映射大小为62×62。我们的鉴别器的架构如图5所示。

3.3、损失函数

大多数去雾模型使用均方误差(MSE)作为损失函数[26]。然而,已知MSE与人类对图像质量的感知仅弱相关[13]。因此,我们采用更接近人类感知的额外损失函数。为此,我们使用了MSE()、对抗性损失

、内容损失

和结构相似性损失

的组合。我们在下面定义剩余的损失函数。

生成器和鉴别器

的对抗损失被定义为:

其中是模糊图像和对应的地面实况的监督对。

是鉴别器对提供给它的数据实例

确实是真实的的概率的估计。类似地,

是输入实例

的生成器输出。此外,

。符号

指示所有监督对上的期望值。

MSE,也称为损失,被定义为

和

之间的平均范数2距离:

我们的内容损失是基于VGG的感知损失[14],定义为:

其中是VGG-19的第

次活化中的元素的数量,并且

表示VGG-19的第

次活化。

重建图像和地面实况

上的结构相似性损失

被定义为:

其中是图像

和

之间的SSIM [24]。我们注意到,尽管损失

和

直接比较预测图像和地面实况图像,但是它们之间的比较性质是完全不同的。

对结构细节不敏感,但保留了被比较的两个图像的一般能量和动态范围的比较。另一方面,

比较了图像中的结构内容,对对比度的敏感性较低。因此,包括这两个损失函数提供了预测图像和地面实况图像之间的比较的互补方面。

总发生器损耗和鉴别器损耗

给出为:

我们已经试探性地选择了上述等式中的恒定权重值为 = 0.7、

= 0.5、

= 1.0、

= 1.0和

= 1.0。

4、实验结果

4.1、数据集

我们已经在以下四个数据集上训练和测试了我们的模型,即NTIRE 2018图像去雾室内数据集(简称为I-Haze),NTIRE 2018图像去雾室外数据集(O-Haze),NTIRE 2019的Dense-Haze数据集,以及用于非均匀去雾挑战的NTIRE 2020数据集(NTIRE 2020)。

[4]和

[2]:这些数据集分别包含25和35个模糊图像(大小为2833×4657像素)用于训练。两个数据集都包含用于验证的5个模糊图像沿着它们相应的地面实况图像。对于这两个数据集,在训练数据上进行训练,并且使用验证图像进行测试,因为尽管给出了用于测试的5个模糊图像,但是它们的真实情况不可用于进行定量比较。

[1]:该数据集包含45个模糊图像(大小为1200×1600像素)用于训练,5个模糊图像用于验证,另外5个模糊图像用于测试其相应的地面实况图像。我们已经对训练数据进行了训练,并使用测试数据测试了我们的模型。

[8]:该数据集包含45个模糊图像(大小为1200×1600像素),用于使用其相应的地面实况进行训练。这是我们所知的第一个非均匀雾霾数据集。由于没有给出用于验证的基础事实,因此我们仅使用40个图像对进行训练,并在其余5个图像上计算我们的结果。

4.2、训练细节

用于训练的优化器是Adam [15],生成器和鉴别器的初始学习率分别为0.001和0.001。从训练图像中随机裁剪的大正方形块。NTIRE 2020和浓雾的作物尺寸为1024×1024。利用I-Haze和O-Haze数据集中甚至更大尺寸的图像,我们创建了四个作物,每个作物有两种不同的尺寸,1024×1024和2048×2048。然后,我们使用双三次插值将所有补丁的大小调整为512×512。对于每个时期随机裁剪这些块,即这些块对于每个时期都不相同。这已经从可用于训练每个所考虑的数据集的小数据集中创建了有效的更大数据集。对于名为I-Haze,O-Haze和NTIRE 2020的数据集,我们将这些随机裁剪的大小调整补丁从RGB空间转换到YCbCr空间,然后将它们用于训练。对于密集烟雾数据集,我们直接使用RGB补丁进行训练。

每当损失变得稳定时,我们降低了生成器的学习率。当发生器的学习率达到0.00001并且损失稳定时,我们停止了训练。我们也试图降低鉴别器的学习率,但发现这样做并没有给予最好的结果。

4.3、结果

在这里,我们提出了我们的研究结果和他们的比较与文献中的其他模型的结果。我们注意到,鉴于我们的硬件(GPU)内存限制,我们将所有数据集的测试输入图像大小转换为512×512,以生成我们的结果。使用SSIM度量和峰值信噪比(PSNR)进行定量评估。即使在YCbCr空间中完成训练,也在RGB空间中计算度量。将定量结果与表1中的早期现有技术进行比较。

其他方法的度量从[26]中复制,用于I-Haze和O-Haze数据集。[1]中提供了密集雾度的基准。我们进一步包括Morales等人[19]的结果以供比较。

:我们的方法在验证数据上针对该数据集的平均PSNR和SSIM分别为22.56和0.8994。从表1中可以明显看出,我们的模型在SSIM和PSNR指标方面都优于现有技术。试验数据的定性比较结果见图6。很明显,只有CVPRW'18 [26]在去雾图像的质量方面与我们的方法竞争,并与地面实况相匹配。

:验证数据上该数据集的平均PSNR和SSIM分别为24.27和0.8919,见表1。我们的模型明显优于所有国家的最先进的PSNR和SSIM指数的大幅度提高。对于SSIM,最接近的执行方法是CVPRW'18 [26],SSIM为0.7205,显著低于我们的0.8919。从所有方法的结果中值得注意的是,该数据集比I-Haze更具挑战性。尽管如此,我们的方法在I-Haze和O-Haze数据集上提供了相当的性能。试验数据结果的定性比较如图7所示。 与I-Haze数据集类似,只有CVPRW'18 [26]和我们的方法生成质量良好的去雾图像。

与图6中的I-Haze结果相比,在图7中更明显的是,我们的方法的色偏与地面实况稍微不匹配,其中CVPRW’18比我们的方法表现得更好。然而,CVPRW’18显示出比我们的方法更差的结构连续性,如图6中更明显的。

:从表1中可以明显看出,该数据集比I-Haze和0-Haze数据集明显更具挑战性。所有方法均执行与I-Haze和O-Haze数据集报告的数字相比,该数据集的结果相当差。尽管与其他数据集相比,我们的方法的性能对于该数据集也较差,但其SSIM和PSNR值显著优于其他8种方法,这些方法的结果包括在表1中用于该数据集。与选择方法的定性比较如图8所示。结果清楚地说明了该数据集的挑战,因为场景的特征和细节在浓密的薄雾中几乎无法察觉。只有我们的方法是能够有效地去雾的图像,并提出了场景的细节。尽管如此,偏色是非均匀补偿的,并且在区域中与地面实况不同。

:由于没有给出测试数据的基础事实,我们随机选择了5张图像进行测试,并使用其余的40张图像对进行训练。平均SSIM和PSNR分别为0.8726和19.40。此SSIM值优于在比赛中观察到的最佳SSIM,并在测试阶段后通过个人电子邮件通知参与者。定性结果示于图8中。观察结果通常类似于针对密集霾数据集的观察结果。我们的结果是定性的地面真相非常接近,并显示我们的方法恢复的细节丢失的阴霾,尽管非均匀性的阴霾的能力。其次,我们观察到一点的不匹配的颜色再现和不均匀的偏色,这需要进一步的工作。我们预期色偏不均匀性的问题可能与雾度本身的不均匀性有关,其也可能存在于浓雾度数据中,但可能由于雾度的一般高密度而不可察觉。

5、消融研究

我们使用I-Haze和O-Haze数据集进行消融研究。我们在第5.1节中考虑了与结构元素相关的消融,在第5.2节中考虑了损失组件,在第5.3节中考虑了训练中使用的图像空间。

5.1、架构消融

在这里,我们考虑与迭代UNet块中使用的UNet单元的数量以及金字塔卷积块的存在或不存在相关的消融研究。结果示于表2中。很明显,减少或增加UNet块的数量会降低性能,并且使用M = 4个UNet块对于该架构是最佳的。这与从图3得出的观察结果一致。类似地,丢弃PyCon块也会降低性能。

5.2、损失消融

我们在3.3节中建议使用四种类型的损失函数来训练生成器。在这里,我们考虑一次丢弃一个损失函数的效果。结果呈现在表2的下图中。可以看出,丢弃任何损失函数都会导致性能的显著恶化。这表明这些损失函数中的每一个都发挥着不同和互补的作用。我们对定性结果的观察,在第4节中讨论,我们可能需要引入另一个与色偏或颜色恒定性的保持相关的损失函数。

5.3、RGB与YCbCr空间的使用

如果我们使用RGB空间而不是YCbCr空间进行训练,我们观察到SSIM方面的性能下降,如第2(b)节中所报告的。然而,我们注意到,这一观察结果在所有数据集上并不一致。具体地,我们注意到,对于Dense-Haze数据集,YCbCr转换给出的结果比基于RGB的训练差一点点。因此,我们使用RGB补丁在Dense-Haze数据集上进行训练。

6、结论

所提出的单图像去雾方法是一种端到端可训练架构,其适用于各种情况,例如室内、室外、密集和非均匀雾度,即使在这些情况中的每一种情况下所使用的训练数据集都很小。在SSIM和PSNR方面,它击败了结果可用的所有三个数据集的最新结果。室内图像的定性结果表明,在I-Haze数据集中的重建图像中保留了颜色,而在其他数据集的结果中观察到较差的颜色重建。在未来,我们将改进我们的模型,使其固有地包括颜色保留和无缝的偏色。源代码、结果和训练模型在我们的项目页面上共享。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?