star: ⋆ ⋆ ⋆ \star\star\star ⋆⋆⋆ 一句话总结:贡献:一种视线数据集收集方式+一个基于时序的视线估计模型+一种误差估计损失函数(弹球损失)可以给预测出来的视线一个类似置信度的东西(文章中是不确定性)。核心是:模型在gaze360数据集训练出来可以在wild环境下进行视线估计,鲁棒性好。实验中:static方法:ResNet-18+两个最终层来计算预测效果也还可以,实现简单,可以试试

实验中还使用了头部姿态估计方法Deep Head Pose做对比实验,虽然在视线数据集上误差较大,但使用头部姿态估计展示效果应该还可以。

目录

Abstract

了解人们的目光是一个有益的社交线索。在这项工作中,我们提出了Gaze360,这是一种用于在自然环境中(即:非受控环境)进行具有鲁棒性的3D视线估计的大规模视线跟踪数据集和方法。 我们的数据集由室内和室外环境中的238个对象组成,并在各种头部姿态和距离范围内标记3D视线。无论是对象还是环境,它都是同类中最大的可公开获得的数据集,这是通过简单有效的收集方法实现的。我们提出的3D视线估计模型扩展了现有模型,以包括时间信息并直接输出视线估计值。 我们通过消融实验证明了我们模型的好处,并针对其他最新视线估计基准数据集,跨数据集地评估了模型,模型显示出良好的泛化性能。我们还提出了一种简单的自我监督方法,以改善跨数据集域的适应性。 最后,我们演示了我们的模型在估计超市环境中的客户注意力方面的应用。我们的模型和数据集可以在这里获取:http://gaze360.csail.mit.edu.

图1.概述:我们介绍了一种新颖的数据集和方法,用于在野外估计3D凝视。此图说明了我们模型在YouTube上收集的看不见的视频中的输出,展示了其对各种不受物理限制的场景的鲁棒性。

1.Introduction

为了更好地理解人类——他们的欲望、意图和精神状态,人们必须能够观察和感知某些行为线索。 视线方向就是这样一种线索:它是社交互动中非语言交流,信号传递,兴趣和注意力的一种强烈形式[1]。 例如,发现并跟踪他人的视线是早在儿童时期就开始发展的一项技能,例如,四个月大的婴儿会使用视线提示来帮助视觉处理物体,例如[21]。 就像父母的视线可以引导孩子的注意力一样,人的视线定位也有助于在各种情况下帮助机器学习或交互[18,22]。

近年来,虽然通过利用深度卷积神经网络的表示能力以及超大型带标注的数据集来解决诸如2D人体姿态和面部跟踪之类的相关人体建模问题的方法取得了令人瞩目的成功[2、6、9、14、26] ,但用于视线估计的方法尚未达到这样的性能水平。 这主要是由于缺少足够大且多样化的带标注的训练数据集。 收集准确且场景多变的真实性标注数据,尤其是在实验室外,是一项艰巨的任务。

在这项工作中,我们介绍了一种有助于解决此任务的方法并缩小感知上的性能差距:

- 我们首先描述一种在任意环境中有效收集带标注的3D注视数据的方法;

- 我们使用我们的方法按主题和种类来获取文献中最大的3D凝视数据集,捕获室内和室外条件下238个对象的视频,并仔细评估该数据集的误差和特征;

- 在收敛到最终模型之前,我们会在数据集上训练各种3D视线估计模型,最终的模型唯一地采用多帧输入(以帮助解决单个帧产生的歧义),并使用弹球回归损失函数进行误差分位数回归以获得视线的非确定性估计;

- 我们通过跨数据集的模型性能比较(在一个数据集上进行训练,在另一个数据集上进行测试)证明了我们的数据集与现有数据集相比所具有的实用价值,并介绍了一种简单的用于视线估计模型的自监督的域适应方法。

- 我们演示了如何将Gaze360模型应用于现实世界的例子,例如估计客户在超市中的关注点。

2.Related Work

2.1 凝视数据集(Gaze datasets)对比

表2-1 主流的凝视数据集比较。对比方面包括:凝视数据的标注类型,角度范围,对象的数量,图像类型(包括是否可以公开获取到图像数据),拍摄环境。 ‘‘Full’’ 代表全脸图像,’'Eyes" 表示眼睛区域的裁剪,而“N/A (not applicable)”表示该数据集不可获取。“*”表示包含部分遮挡的面部图像数据集。

表1对主流的凝视数据集进行了比较。尽管近年来已经发布了许多与凝视相关的数据集[10、12、16、17、20、23、27、30、31],但它们主要是针对身体受约束的应用环境,例如台式机或智能手机的凝视跟踪。通常,这些数据集是使用静态记录设备[17、20、27、34]或集成在智能手机中的相机[10、12、28]捕获的。静态方法允许更多的控制和更高的精度,但若是要更一般的应用,这些数据集缺乏照明和运动模糊的多样性。基于智能手机的解决方案克服了这些缺陷,并具有通过众多用户的使用来直接扩展数据规模以增加对象多样性的优势。但是,由于智能设备的摄像头和屏幕的位置固定以及屏幕上用于投射注视点的区域相对狭窄,它们缺乏头部姿态和视线的变化性。

为了能在任意自然场景中捕捉人的视线,重要的一点是不能过度限制对象的姿势,并且需要包含整个头部区域和眼球相对于相机的方向。虽然一些现有数据集的头部姿势和注视的变化相对较小[16、17、20],其他数据集的确提供了更大的范围[12、27、34],但仍仅限于正面视图而不是斜视图。的确,在较大的头部偏转下,眼睛会逐渐被遮挡,但我们希望捕获此类情况,以便我们的模型可以在较少约束的情况下使用。

在最全面的数据集中之一

朱和邓[34],作者通过使用一系列不同姿势的摄像机来提高采集速度和视点的多样性。但是,该设置仅限于在实验室环境中收集数据。尽管我们的方法也使用了多摄像机设置,但我们的是为了快速捕获多个对象,使用自由移动而不是固定的目标,可以使我们捕获全方位的注视方向,如图4和第4节所示。此外,由于我们的捕获设置是可移动的,这使我们能够在更加多样的自然光照环境中有效地从广泛的人群中收集数据,且更大范围的比例变化和捕获过程中对象运动引起的图像模糊。这更接近于系统的领域,例如交互式机器人或监测/监控摄像机,它们可能会受益于我们的凝视跟踪模型。

[4]的一项最新工作也是在自然环境中具有较大的相机-对象距离和较少受约束的对象运动的凝视估计。他们的数据集生成方法是无目标的,但是要求受试者戴上凝视追踪眼镜,使用运动捕捉相机捕捉头部姿势,且需要复杂的semantic in-painting 步骤才能从目标图像中移除凝视追踪眼镜。相比之下,我们的方法相对简单,可以扩展到更多的对象(238个对象[ours]与15个对象[4])和光照条件。

2.2 基于几何模型的视线估计(Geometric gaze models)

几何模型通常使用近红外光源[8、29、35]或其他光源的角膜反射,通过已知几何形状[10]来拟合眼球模型,从拟合的眼球模型中可以推断出视线方向。 由于这些方法依赖于物理模型,因此可以很容易地推广到几乎没有训练数据的新对象,但代价是对输入噪声(例如部分遮挡或光照干扰)的敏感性更高。 由于它们还依赖固定光源,因此在诸如我们这样的无约束环境中不可行。

2.3 基于表观的视线估计模型(Appearance-based gaze models)

基于表观的方法使用带标注的眼睛或面部图像的大型数据集进行训练,可以学习更直接的图像到注视的映射。 支持向量回归[28],随机森林[11]和最近的深度学习[4、12、30、31、34]都是基于表观来建立映射模型。 眼睛或面部检测的预处理步骤通常是必需的[12,30]。 我们的模型不依赖于眼睛或面部检测器,这使得它在所需特征被部分遮挡且不受约束的自然环境中实现了更高的鲁棒性。 注视和头部姿势之间的依赖性可以通过隐式训练[12、30、31]来解决,也可以通过单独的分支显式建模[34]。

在部分遮挡眼睛的情况下,凝视估计变得更加困难。即使在90-135°的头部偏转情况下,一个眼球的很大一部分仍然可见,并且对注视估计很有帮助(请参阅补充资料)。现有方法[12,32]不能处理这些情况,并且通常假定对象面对相机。但是,此类模型不能很好地推广到具有挑战性的应用中,例如机器人技术或监视领域。与以前的方法不同,我们的模型旨在始终提供尽力而为的预测以及适当的置信度来应对这种情况。我们通过pinball loss 学习的分位数回归[15]来预测不确定性。我们的模型通过依靠可见的头部特征来输出估计的凝视方向,即使眼睛完全被遮挡住,与此同时,通过输出相应更高的不确定性值来告知其预测的有限精度。此外,与以前的模型不同,我们研究了随着时间的推移通过图像证据的聚合来使用其他帧来改善注视估计的方法。这增加了捕获仅在几帧中可见的相关特征的机会。我们展示了使用运动如何在很大的视角范围内显着改善系统性能。

3. 数据集收集方法

当前没有适合于学习能够稳健估计野外3D凝视模型的数据集。以前记录大规模数据集的工作依赖于经过精确测量的对象和凝视目标定位的精心采集设置[17、23、34]。这样的设置几乎不可能移动到不同的位置,一次只能记录单个对象,并且需要不断验证对象的期望视线,这使得收集过程不灵活且非常缓慢。这就是为什么所有具有3D凝视标签的现有数据集都记录在室内环境中并且经常使用很少的主题的原因。如野外2D人体模型和面部跟踪模型的成功所证明的那样[2],要提高野外鲁棒性,重要的是收集具有大量不同主题,自然光照变化较大以及各种头部姿势和凝视方向的数据。

3.1 设置

为了解决这些问题,我们选择了一个安装在瓢虫5 360°全景相机(图2)上的设置,该相机放置在场景中央的三脚架上,并带有大型移动的刚性目标板,标有AprilTag [25]和一个交叉指示受试者持续注视。这样就可以同时记录来自多个主题的数据。 Ladybug5由五个同步且重叠的5百万像素摄像机单元组成,每个摄像机单元具有120°水平视场,另外还有一个我们不使用的朝上摄像机。鱼眼镜头校正后,我们将每个帧存储为3382×4096像素的图像。可以在其中至少一张视图中完全拍摄到距离相机一米远的拍摄对象的面部。相机经过工厂校准,拍摄后我们会校正所有图像,以消除镜筒变形。该装置的紧凑性由三脚架上的单个摄像头单元,笔记本电脑和便携式电源组成,可轻松携带和部署,以在许多环境中进行有效的数据收集。

测试者定位

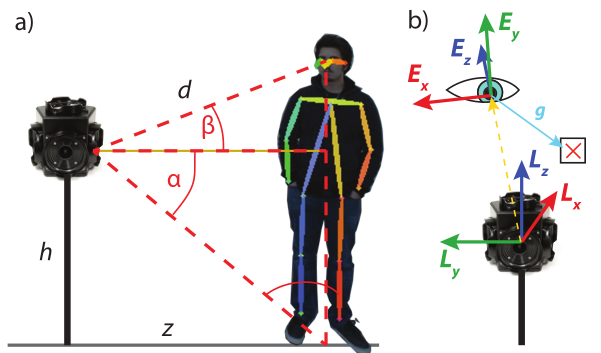

为了建立数据集,==我们使用AlphaPose [3]从每个摄像头单元独立检测校正帧中对象的头部关键点和脚的位置。==对于双脚超出相机视野的非常近距离的拍摄对象,我们使用站立拍摄对象的平均身体比例从其臀部位置估计他们的脚位置。瓢虫相机为每个图像像素在全局瓢虫笛卡尔坐标系L = [Lx,Ly,Lz]中提供3D射线。我们使用它来导出脚和眼睛在球坐标系中的位置。剩下的未知变量是瓢虫原点到眼睛的距离d。我们利用相机和所有对象站立的水平地面上方的相机高度进行测量。尽管这将我们的训练数据收集限制在平坦的表面上,但是在测试时并没有限制。有关三角的更多详细信息,请查阅补充材料。

注视目标定位

我们的目标包括一块白板,该白板的一侧有一个大的AprilTag [25],而两侧则有一个较小的十字形(图2)。十字架用作研究对象的注视目标,而标签则用于在3D空间中跟踪白板。我们使用原始的AprilTag库检测每个相机视图中的标记,并使用已知的相机校准参数和标记大小来估计其3D姿势。然后,我们使用姿势和已知的板几何形状来找到目标十字点pt的3D位置。

图2.采集设置。我们的设置使我们能够有效地收集大量不同的,带注释的数据,以进行3D凝视估计。我们创建了一个包含238个主体的数据集,这些主体在各种光照条件下(室内和室外)以及与主体的距离和角度。

视线方向

我们将瓢虫坐标系中的凝视矢量计算为一个简单的差gL = pt-pe。但是,这种形式会随着相机及其坐标系L的旋转而发生变化。为此,我们以观察相机的笛卡尔眼坐标系E = [Ex,Ey,Ez]表示注视。定义E使得原点为pe,与gLand Ex相同的方向位于由Lxand Ly(无侧倾)定义的平面中。然后我们可以通过以下方式将凝视向量转换为眼睛坐标系:

这种注视方向的定义保证了当被摄对象直接注视相机时,与被摄对象的位置无关,g = [0,0,−1],并且通常允许从头部的局部外观表达注视方向,而无需需要任何全局信息。

3.2 采集程序

我们的数据集收集实验获得了机构审查委员会的批准。指示受试者站在相机周围1-3m(平均2.2m)的距离,并在他们可见的标记板一侧连续跟踪目标十字(图3)。为了安全起见,指示对象大致停留在其起始位置,因为他们既不能跟踪目标,也不能看到移动时可能出现的障碍。

标记板由一名研究人员操纵,该标记板一次大圈地围绕被摄对象和相机(半径2-5m)携带,然后在相机和被摄对象之间移动(图3a)。在运动时,目标板同时上下移动(图3c)以引起注视间距的变化。轨迹的循环部分允许覆盖所有可能的注视方向。

内部路径被添加以采样更多的极端注视间距变化,由于标记在场景中的垂直位置受到限制,只能从更近的距离实现。我们确保标记板始终放置在面对相机的位置,并尽可能使AprilTag平行,以减少姿态估计误差(图3b)。

为了捕获各种相对的眼球和头部姿势,我们在每次捕获期间在“移动”和“冻结”指令之间进行了交替。在“移动”状态下,允许受试者自然地调整其头部和身体姿势以帮助跟踪目标。发出“冻结”指令时,仅允许受试者在保持固定头部姿势的情况下移动眼睛。

图3.数据集收集协议:(a)场景和目标板轨迹的俯视图,显示了受试者的全部覆盖范围; (b)来自摄像机的场景图像(仅用于说明目的); (c)场景和目标板轨迹的侧视图,显示出与目标之间的垂直高度变化。

4. Gaze360数据集总结

我们的数据集是独一无二的,因为它结合了3D凝视注解,广泛的凝视和头部姿势,各种室内和室外捕获环境以及主体的多样性。 GazeCapture [12]数据集(1,450个对象)仅超过了对象数量,该数据集是2D的,仅在有限的使用情况下覆盖了狭窄的注视范围。有关数据集比较,请参见表1。值得注意的是,我们的数据集也是第一个为短连续视频(8Hz)提供这些质量的数据集。

统计摘要

我们在9个记录时段内,在5个室内(53个主题)和2个室外(185个主题)位置收集了238个主题。这种采集速度是其他现场技术无法比拟的,只能与众包的方法进行比较,但是在实验控制方面无法与之竞争。我们总共获得了129K训练,17K验证和26K带有注视注释的测试图像。出于隐私方面的原因,我们没有调查有关受试者的其他数据,但是通过目视检查发现受试者的年龄,种族和性别分布广泛(女性为58%,男性为42%)。示例请参考图5。

图5. Gaze360数据集样本:显示环境,光照,年龄,性别,种族,头部姿势和注视方向的多样性。上:全身作物;下:近距离收割的庄稼。黄色箭头表示测得的地面真相注视。

数据分布

我们使用图4中的Mollweide投影绘制由我们的数据集和其他几个数据集覆盖的凝视标签的角度分布。这说明了我们的数据集如何覆盖360°的整个水平范围。虽然这些凝视方向的一部分对应于完全遮挡的眼睛(背对相机),但我们的数据集允许凝视估计达到眼睛可见度的极限。在某些情况下,此限制可能对应于大约+ 140°的注视偏航(头部姿势为90°,这样一只眼睛仍然可见,而另一只眼睛又旋转了50°)。垂直范围受标记可达到的高度限制。后方区域(围绕地图的左右边界)的采样密度较小。这可以通过受试者遮住目标板来解释。

图4.数据集统计。 TabletGaze [10],MPIIFaceGaze [31],iTracker [12]和我们的Gaze360数据集的凝视偏航和俯仰的联合分布。 Mollweide投影用于可视化整个单位球体表面。所有强度都是对数的。

误差检验

为了验证注视注释的准确性,我们进行了对照实验。我们对360°摄像头遵循标准的采集程序,一次让一名参与者戴着右眼上方安装的附加前置测试摄像头。我们使用标准的基于AprilTag的程序以及与相机相符的已知来源,对测试相机中的3D视线进行了测量。后台使用了附加的AprilTags来注册两个摄像机。在两个对象的三个记录中,我们测得两个注视标签之间的平均差异为2.9o。这完全在远距离的基于外观的眼睛跟踪误差之内,这验证了我们的采集程序作为收集带注释的3D凝视数据集的一种手段。

5. Gaze360模型

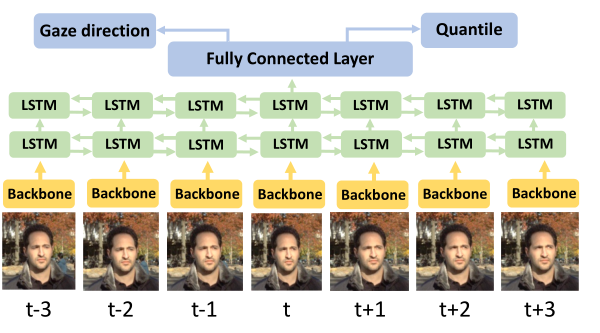

注视是自然的连续信号。凝视注视和过渡产生一系列凝视方向。为了利用这一点,我们提出了一个基于视频的凝视跟踪模型使用双向长期短期记忆胶囊(LSTM)[5],它提供了一种对序列进行建模的方法,其中一个元素的输出取决于过去和将来的输入。在本文中,我们利用7个帧的序列来预测中心帧的视线。注意,仅包括单个中央框架的其他序列长度也是可能的。

图6说明了Gaze360模型的体系结构。卷积神经网络(主干)分别处理每个帧中的头部作物,该神经网络产生具有256维的高级特征。这些特征被馈送到具有两层的双向LSTM,这些LSTM消化前向和后向向量中的序列。最后,将这些向量连接起来并通过一个完全连接的层,以产生两个输出:凝视预测和误差分位数估计。

图6. Gaze360模型架构。该模型接收通过骨干网传递的多个输入帧。每帧的输出被馈送到双向LSTM,以产生紧凑的表示形式,该表示形式用于对视线方向和分位数回归进行最终预测。我们使用以目标帧为中心的7帧输入窗口。

凝视预测输出使凝视相对于摄像机视图的角度回归。在先前的工作中,将3D凝视预测为单位凝视矢量[17,34]或其球形坐标[23,31]。我们使用球形坐标,我们认为在这种情况下可以更自然地解释球形坐标。我们定义球坐标,使得极点奇点对应于严格向上或向下定向的垂直注视,这是非常罕见的方向。我们使用ImageNet预训练的ResNet-18 [7]作为骨干网。所有模型都使用Adam优化器[13]在PyTorch中训练,学习速率为10^−4。

5.1 误差分位数估计

据我们所知,所有将神经网络应用于注视估计任务的现有研究都没有考虑误差范围。在不受限制的环境中估计注视时,误差范围很有用,因为当从侧面角度观察眼睛时,或者当一只或多只眼睛被部分遮挡时(eg. 被眼镜框遮挡),精度可能会下降。

为了对误差范围建模,我们使用弹球损失函数[15]来预测误差分位数。我们使用一个单一的网络来预测平均值以及10%和90%的分位数。这样做的效果是,对于给定的图像,我们通过一次向前通过来估计预期的凝视方向和误差锥,其中地面真相应占80%的时间。我们假设分布在我们的球坐标系中是各向同性的。这种假设并非完全正确,特别是对于大的俯仰角,由于极点奇异点周围的空间变形而引起的。但是,对于大多数观察到的注视方向(图4),这是一个合理的近似值,可以减小尺寸并简化结果的解释。

我们网络的输出为f(I)=(θ,φ,σ),其中(θ,φ)是球坐标系中的预期凝视方向,对此我们已经在眼睛坐标系中有了对应的地面真相凝视向量g(请参阅第3.1节),因为θ= −arctangx gzandφ=反弧形。

第三个参数σ对应于距预期注视的偏移,因此θ+σ和φ+σ是其分布的90%分位数,而θ-σ和φ-σ是10%的分位数。

最后,我们计算该输出的弹球损失。这自然会迫使φ和θ收敛到其基本真值,而σ收敛到分位数阈值。如果y =(θgt,φgt),则分位数τ的损耗Lτ和角度θ可写为:

角度φ使用相似的公式。我们将角度和分位数τ= 0.1和τ= 0.9的损耗平均。因此,σ是10%和90%分位数与期望值之差的度量。

分位数回归参考资料:

https://blog.csdn.net/jesseyule/article/details/95247155

https://www.jianshu.com/p/073bc0b0bbfa

5.2 Adapting to unseen domains

尽管Gaze360数据集的多样性,某些现实世界的应用程序可能会受益于模型更紧密地适应目标领域。因此,我们引入了一种自我监督的域自适应方法。我们的通用模型是通过混合使用标记的Gaze360图像和来自新域的未标记图像来进行微调的。受[24]的启发,我们引入了一种鉴别器,该鉴别器试图将图像特征的源域识别为二进制分类任务。功能是骨干网的输出。对于那些可获得地面真实性的图像,鉴别器损耗LD被添加到原始监督损耗Lτ中。

此外,我们还增加了另一损失,即利用注视估计任务的左右对称性来鼓励未标记数据上模型输出一致性。我们使用该模型来计算原始图像和水平翻转图像的视线,并使用弹球损失LS来最小化来自第一个输入的预测与来自第二个输入的水平镜像预测之间的角度差。虽然这种损失本身可能导致沿对称线的凝视预测崩溃,但我们在第二节中观察到。 6.2显示,这在用作正则化器以改善看不见的目标域中的性能时会有所帮助。总之,在我们的实验中,我们将L =α·Lτ+ LD +β·LS最小化,其中α= 60,β= 3。

Lτ:分位数损失

LD:鉴别器损失,鉴别是gaze360数据集,还是其他数据(例如:实际应用时候的数据)

Ls: 弹球损失,同一个样本水平镜像后,减少镜像前后的两次预测的误差

6.实验分析:实验对比分析得很到位

6.1 模型评估

在本节中,我们将比较使用Gaze360数据集的几种方法。我们比较了以下方法:均值-对所有预测使用训练集的均值凝视; Deep Head Pose-Ruiz等人的基于深度网络的头部姿势估计器。 [19];static-骨干模型,ResNet-18和两个最终层来计算预测; TRN-时间关系网络的一种版本[33],其中在对时间窗口的预测取平均之前,将时间t周围固定窗口处的帧特征进行合并; LSTM-指Gaze360架构。

对于以上介绍的三种体系结构,我们报告了不同基线的准确性,以进行不确定性评估:MSE-使用均方误差来仅使凝视的球面角回归而没有不确定性; MSE + Drop-使用MSE模型,不确定性通过每个输入的5次正向传递来估计,同时在最后一层随机放置神经元并计算输出的方差;作物增产-使用MSE训练模型的5个预测的方差,顺序评估5种随机头作物以估计不确定性;和弹球损失-注视方向和误差范围是使用弹球损失共同估算的。

表2中的角度误差是针对整个测试集(所有360°)以及被摄对象在相机方向的90°(正向180°)和20°(正向)范围内观看的样本单独提供的。我们还报告了误差分位数估计与实际误差之间的Spearman等级相关性,这是衡量预测误差范围对实际误差的估计程度的度量。

结果证实,无眼均值预测以及头部姿势不足以预测我们数据集中眼动的丰富变化。我们所有的凝视模型都优于这些简单的基准。我们还观察到,在相同条件下,使用弹球损失的模型的误差通常最低。对于预测不确定性和实际预测误差之间的相关性,可以看到相同的趋势。另外,预测仅需要一个前向通过。因此,我们选择弹球损失作为推荐的方法。

从单帧静态模型切换到时间模型也大大提高了凝视预测的准确性。我们得出的结论是,尽管TRN和LSTM的性能相似,但我们还是推荐弹球LSTM,因为它在度量和直接适应使用不同数量的输入帧方面具有更好的效果。

表2. Gaze360数据集上的性能比较。下表列出了Gaze360测试数据上各种型号和基准的平均角度误差。最后一列显示了实际误差与预测不确定性之间的相关性。

在图8中,我们展示了使用弹子球损失作为凝视偏航角函数的模型的预测误差。如预期的那样,精度随凝视偏航角的增加而降低。与传统的眼动仪不同,我们的模型可以平稳地转换为头部姿势估计(头部偏航在90-150°之间),即使对于后视,也能提供最佳的凝视猜测。这伴随着更高的相关不确定性(虚线)。尽管正面视图的误差通常大于现有高分辨率数据集上报告的误差,但我们接下来表明这是由于Gaze360具有挑战性的特性所致,该特性允许在其上训练的模型更好地转换为物理上不受约束的图像。

图8.使用弹球模型在Gaze360数据集上测量的误差。实线表示预测误差,虚线表示预测的不确定性。

在图7中,我们在测试数据上显示了示例结果。当眼睛由于距离而变小或由于头部姿势变化而被遮挡时,由黄条表示的角度误差会直观地增大。尽管远视姿势的预测误差平均很大,但是不确定性度量可以为这种行为提供合理的预测。

图7.测试集示例:显示了看不见的测试对象的地面真相注视(黄色)和Gaze360预测(红色)。条形图表示以度为单位的实际(黄色)和预测(红色)误差。插图显示了注视估计值和预测误差与地面真相的自顶向下视图。底行显示了模型过于自信的示例失败案例。

注:从实验展示上来看,弹球损失确实可以起到类似置信度的作用,但也有失败的例子,例如图7.中最后一行,模型过于自信

6.2 跨数据集评估

我们通过使用多个预先存在的3D凝视数据集训练Pinball静态模型并测量跨数据集测试误差来评估Gaze360数据集在野外进行凝视估计的价值。我们使用的比较数据集是:哥伦比亚[20]-高分辨率特写脸; MPIIFaceGaze [31]-网络摄像头捕获的人脸; RTGENE [4]-低分辨率人脸,使用绘画来掩盖眼动眼镜。 Gaze360(我们的)-分辨率不同的面孔;对于未提供正式划分的那些数据集[20,31],我们使用所有可用样本进行训练,并且不衡量域内误差。

表3总结了结果。该任务比域内测试更具挑战性。当我们的数据集用于训练时,始终可以获得最佳结果。此外,我们使用本节中介绍的自我监督方法在新域(Gaze360 + DA)上微调了Gaze360训练的模型。 5.2,它没有利用其他数据集中的地面真相标签。我们的域自适应策略进一步提高了所有数据集的性能。

表3.跨数据集评估:我们报告使用不同数据集训练的静态模型的平均角度误差。

7. 野外追踪注视

在不受限制的环境中进行预测:Gaze360数据集中主题外观的变化使我们的模型能够很好地运行,而无需进一步训练或微调来自未整理在线资源的看不见的图像和视频数据。我们在图1和2的许多示例中直观地演示了这一点。图 1和9,以及我们的补充视频。

图9.在野外估计3D视线:从ouTube收集的看不见的视频中我们模型输出的更多示例。

估计超市中的注意力:为了说明Gaze360的一种可能的应用,我们将其应用于预测在超市货架上正在看哪些对象的任务,这与在商店中放置产品有关。我们重新创建了一个超市货架,并要求受试者在自我报告这些物品的同时查看它们。如图10所示,我们用相机在架子旁边记录它们。尽管对被摄对象的看法不尽人意,但我们仍可以预测在51%的时间内正确观看了哪个对象。使用直接嵌入书架中的智能手机摄像头(使被摄对象的视线更接近正面),准确度提高到68%。底部架子上的物体具有最高的错误率,因为向下看时眼睛几乎完全被遮挡了。最后,我们能够产生客户关注的热点图,如图10所示。虽然简单,但该应用程序演示了我们的系统在各种实际应用中使用的灵活性。

图10.一个示例应用程序:当顾客浏览货架上的产品时,我们使用Gaze360通过货架旁边(右)的摄像机的视频(左)推断顾客的注意力。

8.Conclusion

我们引入了一种新颖的方法来有效地大规模收集带注释的注视数据,并使用它来生成大型多样的数据集,适用于从图像和视频中深度学习3D注视。我们提出了一个新的基于时间外观的凝视模型,它使用一种新颖的损失函数来估计误差分位数。最后,我们展示了(i)通过仔细的跨数据集性能比较与三个现有3D凝视数据集进行比较的数据集的价值,以及(ii)通过应用到YouTube视频中不受约束的可见图像的模型的价值。我们希望,通过使用我们的数据集和模型,跨领域的研究人员将能够更好地利用注视作为提高基于视觉的人类行为理解的线索。致谢。丰田研究院提供了资金来协助作者进行研究,但本文仅反映了其作者的观点和结论,而不是TRI或任何其他丰田实体。

补充材料

4. Further dataset collection details

4.1 Subject positioning(测试者定位)

为了建立数据集,我们使用AlphaPose [1]从每个摄像头单元独立检测校正帧中头部特征和对象的脚的位置。对于双脚超出相机视野的非常近距离的拍摄对象,我们使用站立拍摄对象的平均身体比例从其臀部位置估计他们的脚位置。 Ladybugcamera为每个图像像素提供3DrayinaglobalLadybugCartesian坐标系L = [Lx,Ly,Lz](图2b)。我们使用它来导出脚和眼睛在球坐标系中的位置(图2a中显示的2D切片中的角度α和β)。剩下的未知变量是到眼睛的距离d。我们利用相机测得的高于地面h的高度,并假设相机和所有被摄体都站在同一水平面上。

尽管这将我们的训练数据收集限制在平坦的表面上,但是在测试时并没有限制。然后,我们使用三角函数来计算相机基座与被摄对象的脚之间的水平距离z,最后计算出相机与被摄对象的眼睛之间的距离d

这使我们能够计算瓢虫坐标系中眼睛的位置pe。

图2.设置参数:用于估计(a)使用地平面假设的对象与相机的眼睛距离,以及(b)对象的眼睛坐标系(E)和Ladybug相机的坐标系(L)之间的凝视变换。正Ez指向远方。

1446

1446

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?