Logstash简介

Logstash是一个具有实时流水线功能的开源数据收集引擎。Logstash 可以动态地统一来自不同来源的数据,并将数据规范化到您选择的目的地。为各种高级下游分析和可视化用例清理和普及所有数据。

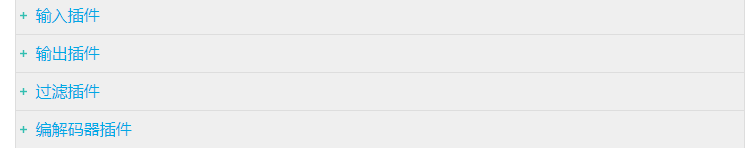

虽然 Logstash 最初推动了日志收集的创新,但它的功能远远超出了该用例。任何类型的事件都可以通过广泛的输入、过滤器和输出插件进行丰富和转换,许多本地编解码器进一步简化了摄取过程。Logstash 通过利用更大量和更多样化的数据来加速您的洞察力。

Elasticsearch 等的摄取主力

具有强大 Elasticsearch 和 Kibana 协同作用的水平可扩展数据处理管道

可插拔管道架构混合、匹配和编排不同的输入、过滤器和输出,以在管道中和谐播放

社区可扩展且对开发人员友好的插件生态系统

超过 200 个插件可用,以及创建和贡献自己的灵活性

适用于服务系统日志的采集,例如nginx,redis,linux

可以和kafka,Filebeat等一起使用

see https://www.elastic.co/guide/en/logstash/7.6/index.html

环境准备

这里我用的是docker容器技术

1.logstash7.6.2 kibana7.6.2 elasticsearch7.6.2

怎么下载安装容器可以参考我这篇文章

docker安装指定版本的镜像

因为我们还需要部署 kibana 容器,因此需要让 es 和 kibana 容器互联。这里先创建一个网络:

docker network create es-net

启动eleasticsearch

docker run -d --name my-es -e "ES_JAVA_OPTS=-Xms512m -Xmx512m" -e "discovery.type=single-node" -v es-data:/usr/share/elasticsearch/data -v es-plugins:/usr/share/elasticsearch/plugins --privileged --network es-net -p 9200:9200 -p 9300:9300 elasticsearch:7.6.2

启动成功访问localhost:9200

启动 kibana

docker run -d --name my-kibana -e ELASTICSEARCH_HOSTS=http://my-es:9200 --network=es-net -p 5601:5601 kibana:7.6.2

启动成功访问localhost:5601

启动logstash

docker run -d --name my-logstash -e ELASTICSEARCH_HOSTS=http://my-es:9200 --network=es-net -p 5044:5044 -p 9600:9600 -p 5055:5055 -p 5056:5056 -p 5057:5057 -p 5058:5058 kibana:7.6.2

修改logstash配置

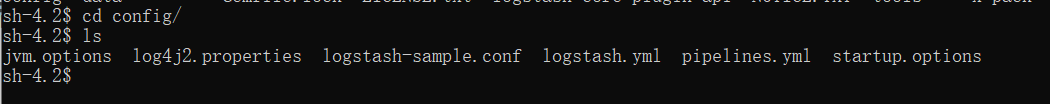

修改logstash.yml配置 在config路径下

vi config/logstash.yml

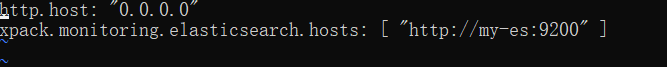

把xpack.monitoring.elasticsearch.hosts修改为"http://my-es:9200"

注意前面有空格 因为是yml格式

修改logstash配置文件logstash.conf 在pipeline下面

vi pipeline/logstash.conf

input {

tcp {

#模式选择为server

mode => "server"

host => "0.0.0.0"

#这里的端口号要和logback-spring.xml里面的destination匹配

port => 5044

# 设定type以区分每个输入源

type => "getway"

codec => json_lines

}

tcp {

mode => "server"

host => "0.0.0.0"

port => 5047

type => "admin"

codec => json_lines

}

tcp {

mode => "server"

host => "0.0.0.0"

port => 5046

type => "auth"

codec => json_lines

}

}

output {

# See: https://www.elastic.co/guide/en/logstash/current/plugins-outputs-elasticsearch.html

if [type]=="admin"{

elasticsearch {

hosts => "my-es:9200"

#index => "springboot-logback-admin-%{+YYYY.MM.dd}"

index => "springboot-logstash-admin"

}

}

if [type]=="getway"{

elasticsearch {

hosts => "my-es:9200"

index => "springboot-logstash-getway"

}

}

if [type]=="auth"{

elasticsearch {

hosts => "my-es:9200"

index => "springboot-logstash-auth"

}

}

stdout {

codec => rubydebug { }

}

}

修改完后保存退出

检测配置文件是否正确

bin/logstash -f pipeline/logstash.conf -t

看见这个就说明配置没有问题

重新启动logstash

看到这个就说明启动成功了

启动成功访问localhost:9600

spring配置

然后就是spring上面的配置了我这里以gateway为例

环境依赖

<!--集成logstash-->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.3</version>

</dependency>

logback-spring.xml配置

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE configuration>

<configuration>

<include resource="org/springframework/boot/logging/logback/defaults.xml"/>

<include resource="org/springframework/boot/logging/logback/base.xml"/>

<springProperty scope="context" name="mall-admin" source="spring.application.name"/>

<!-- 日志在工程中的输出位置 -->

<property name="LOG_FILE" value="${BUILD_FOLDER:-build}/${spring.application.name}"/>

<!-- 控制台的日志输出样式 -->

<property name="CONSOLE_LOG_PATTERN" value="%clr(%d{yyyy-MM-dd HH:mm:ss.SSS}){faint} %clr(${LOG_LEVEL_PATTERN:-%5p}) %clr(${PID:- }){magenta} %clr(---){faint} %clr([%15.15t]){faint} %m%n${LOG_EXCEPTION_CONVERSION_WORD:-%wEx}}"/>

<!-- 控制台输出 -->

<appender name="console" class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>INFO</level>

</filter>

<!-- 日志输出编码 -->

<encoder>

<pattern>${CONSOLE_LOG_PATTERN}</pattern>

<charset>utf8</charset>

</encoder>

</appender>

<!--logstash配置-->

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>127.0.0.1:5044</destination>

<!-- 日志输出编码 -->

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LoggingEventCompositeJsonEncoder">

<providers>

<timestamp>

<timeZone>UTC</timeZone>

</timestamp>

<pattern>

<pattern>

{

"logLevel": "%level",

"serviceName": "${mall-getway:-}",

"pid": "${PID:-}",

"thread": "%thread",

"class": "%logger{40}",

"rest": "%message"

}

</pattern>

</pattern>

</providers>

</encoder>

<!--<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder"/>-->

</appender>

<root level="INFO">

<appender-ref ref="LOGSTASH"/>

<appender-ref ref="CONSOLE"/>

</root>

</configuration>

然后在yml配置文件上加上配置

logging:

config: classpath:logback-spring.xml

工程项目目录

然后启动项目

可以看到logstash的日志,这时候说明已经采集上去了

然后我们访问kibana查看localhost:5601

然后就可以看到我们采集到的日志了

第一次进来这里没有需要自己创建

1295

1295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?