此文章主要是结合哔站shuhuai008大佬的白板推导视频:sigmoid信念网络_92min

全部笔记的汇总贴:机器学习-白板推导系列笔记

对应花书19.5、20.10

一、背景介绍

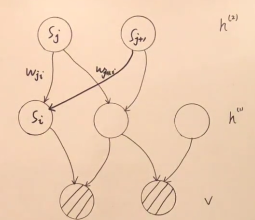

sigmoid信念网络是一种具有特定条件概率分布的有向图模型的简单形式。一般我们将sigmoid信念网络视为具有二值向量的状态 s s s,其中状态的每个元素都受其祖先的影响。

s = { s 1 , s 2 , ⋯ , s T } = { v , h } = { v , h ( 1 ) , h ( 2 ) } σ ( x ) = 1 1 + exp ( − x ) s=\{s_1,s_2,\cdots,s_T\}=\{v,h\}=\{v,h^{(1)},h^{(2)}\}\\\sigma(x)=\frac1{1+\exp(-x)} s={ s1,s2,⋯,sT}={ v,h}={ v,h(1),h(2)}σ(x)=1+exp(−x)1 1 − σ ( x ) = 1 + exp ( − x ) 1 + exp ( − x ) − 1 1 + exp ( − x ) = exp ( − x ) 1 + exp ( − x ) = 1 1 + exp ( x ) = σ ( − x ) 1-\sigma(x)=\frac{1+\exp(-x)}{1+\exp(-x)}-\frac1{1+\exp(-x)}\\=\frac{\exp(-x)}{1+\exp(-x)}=\frac1{1+\exp(x)}=\sigma(-x) 1−σ(x)=1+exp(−x)1+exp(−x)−1+exp(−x)1=1+exp(−x)exp(−x)=1+exp(x)1=σ(−x)

P ( s i = 1 ∣ s j : j < i ) = σ ( ∑ j < i w j i ⋅ s j ) P ( s i = 0 ∣ s j : j < i ) = 1 − σ ( ∑ j < i w j i ⋅ s j ) = σ ( − ∑ j < i w j i ⋅ s j ) P(s_i=1|s_{j:j<i})=\sigma(\sum_{j<i}w_{ji\cdot s_j})\\P(s_i=0|s_{j:j<i})=1-\sigma(\sum_{j<i}w_{ji\cdot s_j})\\=\sigma(-\sum_{j<i}w_{ji\cdot s_j}) P(si=1∣sj:j<i)=σ(j<i∑wji⋅sj)P(si=0∣sj:j<i)=1−σ(j<i∑wji⋅sj)=σ(−j<i∑wji⋅sj)

P ( s i ∣ s j : j < i ) = σ ( s i ∗ ∑ j < i w j i ⋅ s j ) s i ∗ = 2 s i − 1 P(s_i|s_{j:j<i})=\sigma(s_i^*\sum_{j<i}w_{ji}\cdot s_j)\\s_i^*=2s_i-1 P(si∣sj:j<i)=σ(si∗j<i∑wji⋅sj)si∗=2si−1

二、Gradient of log-likelihood

这里为了推导方便,我们没有考虑偏执 b b b。

P ( s ) = ∏ i P ( s i ∣ s j : j < i ) = P ( v , h ) P(s)=\prod_iP(s_i|s_{j:j<i})=P(v,h) P(s)=i∏P(si∣sj:j<i)=P(v,h)

log-likelihood:

∑ v ∈ V l o g P ( v ) \sum_{v\in V}log P(v) v∈V∑logP(v)

∂ ∂ w i j log P ( v ) = 1 P ( v ) ∂ ∂ w i j P ( v ) = 1 P ( v ) ∂ ∑ h P ( v , h ) ∂ w i j = ∑ h 1 P ( v ) ∂ P ( v , h )

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2673

2673

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?