SparkStreaming入门+WordCount案例

1. Spark Streaming概述

1.1 离线和实时的概念

数据处理的延迟

- 1)离线计算

就是在计算开始前已知所有输入数据,输入数据不会产生变化,一般计算量级较大,计算时间也较长。例如,今天早上一点,把昨天累积的日志,计算出所需结果。最经典的就是Hadoop的MapReduce方式; - 2)实时计算

输入数据是可以以序列化的方式一个个输入并进行处理的,也就是说在开始的时候并不需要知道所有的输入数据。与离线计算相比,运行时间短,计算量级相对较小。强调计算过程的时间要短,即所查当下给出结果。

1.2 批量和流式的概念

数据处理的方式

-

1)批式处理

处理离线数据,冷数据。单个处理数据量大,处理速度比流慢。

-

2)流式处理

在线,实时产生的数据。单次处理的数据量小,但处理速度更快。

近年来,在Web应用、网络监控、传感监测等领域,兴起了一种新的数据密集型应用——流数据,即数据以大量、快速、时变的流形式持续到达。实例:PM2.5检测、电子商务网站用户点击流。

-

流数据具有如下特征:

1)数据快速持续到达,潜在大小也许是无穷无尽的;

2)数据来源众多,格式复杂;

3)数据量大,但是不十分关注存储,一旦经过处理,要么被丢弃,要么被归档存储;

4)注重数据的整体价值,不过分关注个别数据。

1.3 Spark Streaming是什么

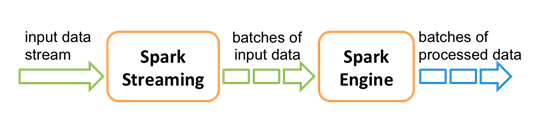

- Spark Streaming用于流式数据的处理。Spark Streaming支持的数据输入源很多,例如:Kafka、Flume、Twitter、ZeroMQ和简单的TCP套接字等等。数据输入后可以用Spark的高度抽象算子如:map、reduce、join、window等进行运算。而结果也能保存在很多地方,如HDFS,数据库等。

- 在 Spark Streaming 中,处理数据的单位是一批而不是单条,而数据采集却是逐条进行的,因此 Spark Streaming系统需要设置间隔使得数据汇总到一定的量后再一并操作,这个间隔就是批处理间隔。批处理间隔是Spark Streaming的核心概念和关键参数,它决定了Spark Streaming提交作业的频率和数据处理的延迟,同时也影响着数据处理的吞吐量和性能。

- 和Spark基于RDD的概念很相似,Spark Streaming使用了一个高级抽象离散化流(discretized stream),叫作DStreams。DStreams是随时间推移而收到的数据的序列。在内部,每个时间区间收到的数据都作为RDD存在,而DStreams是由这些RDD所组成的序列(因此得名“离散化”)。DStreams可以由来自数据源的输入数据流来创建,也可以通过在其他的 DStreams上应用一些高阶操作来得到。

1.4 Spark Streaming特点

- 优点

易用、容错、易整合到Spark体系中等。 - 缺点

Spark Streaming是一种“微量批处理”架构, 和其他基于“一次处理一条记录”架构的系统相比, 它的延迟会相对高一些。

1.5 Spark Streaming架构

- Spark1.5以前版本,用户如果要限制Receiver的数据接收速率,可通过设置静态配置参数:“spark.streaming.rec

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1420

1420

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?