首先需要安装好pycharm和anaconda

开始安装tensorflow-GPU版

一.查看版本

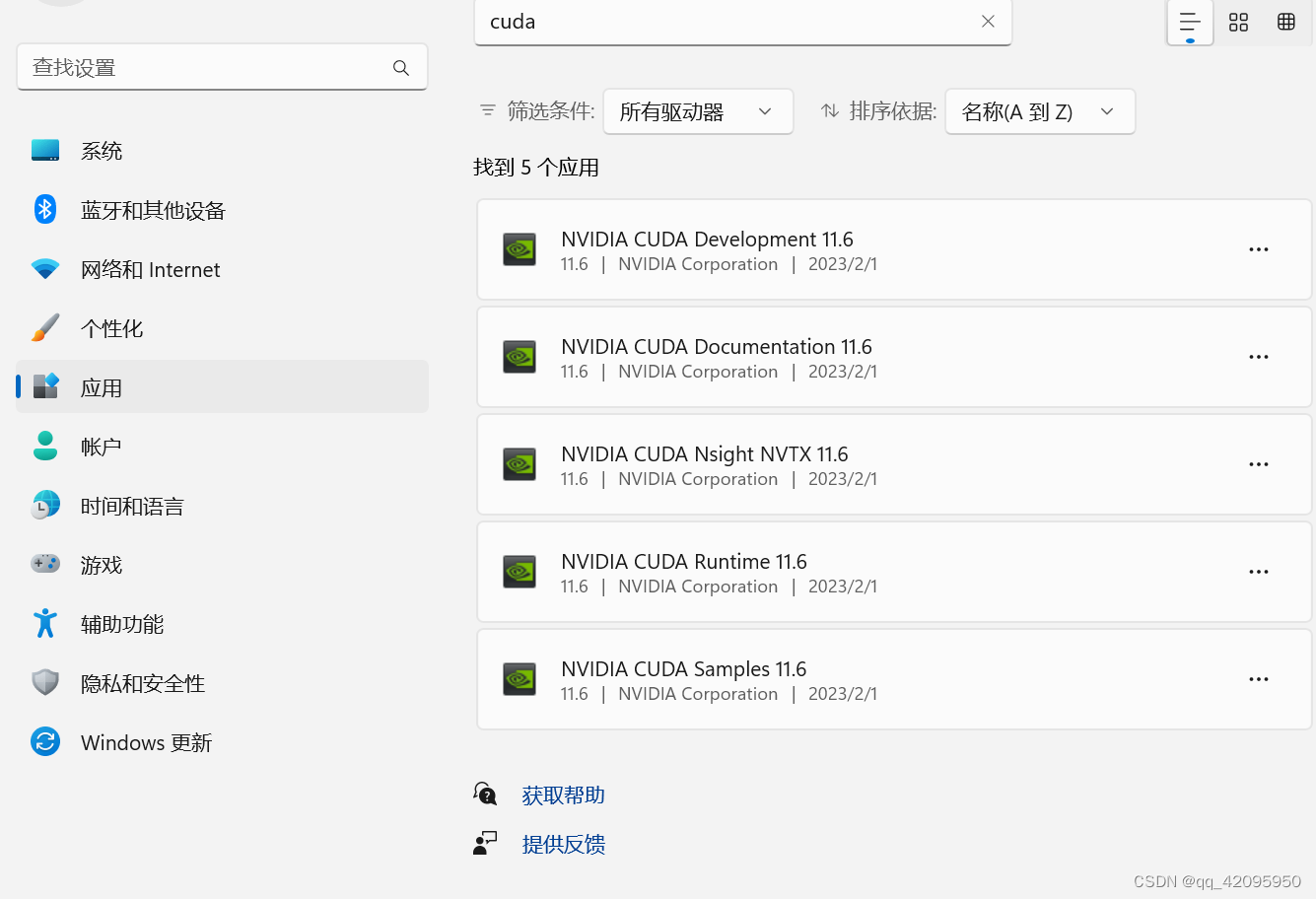

1.首先检查自己电脑的cudn版本,开始----->设置----->应用----->安装的应用,搜cuda。我的是cuda 11.6

2.查看显卡型号

在控制面板----->硬件和声音----->设备管理器----->显示适配器 查看显卡型号。我的为RTX3060

3.查找显卡对应算力CUDA GPUs - Compute Capability | NVIDIA Developer

对应8.6

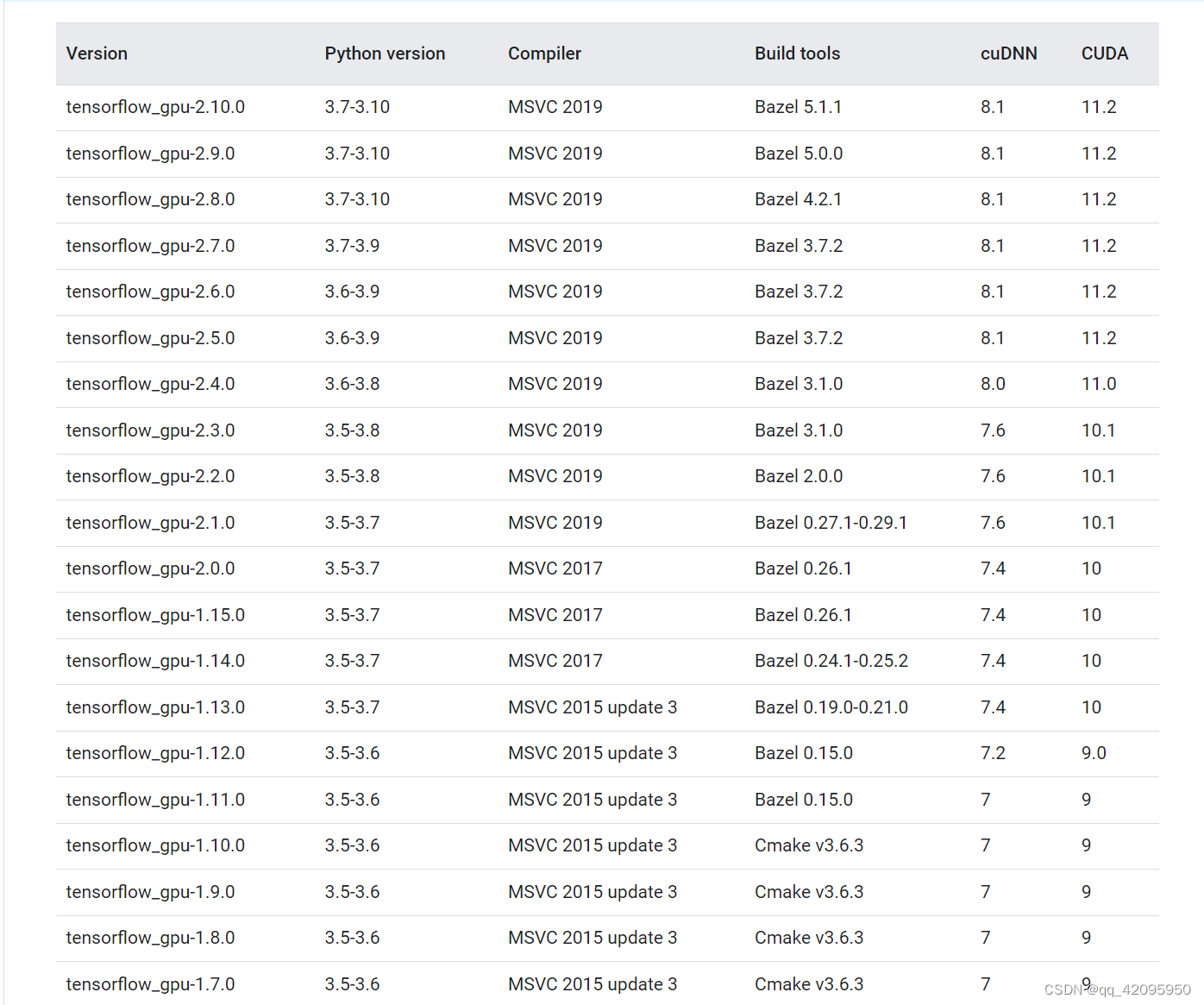

4.在Build from source on Windows | TensorFlow

查找对应版本。

Note: GPU support on native-Windows is only available for 2.10 or earlier versions, starting in TF 2.11, CUDA build is not supported for Windows. For using TensorFlow GPU on Windows, you will need to build/install TensorFlow in WSL2 or use tensorflow-cpu with TensorFlow-DirectML-Plugin

注意:本机Windows上的GPU支持仅适用于2.10或更早版本,从TF 2.11开始,Windows不支持CUDA构建。要在Windows上使用TensorFlow GPU,您需要在WSL 2中构建/安装TensorFlow,或者将tensorflow-cpu与TensorFlow-DirectML-Plugin一起使用

这个表里面没有新的对应版本。

安装tensorflow-gpu -2.9.0. python3.9

| Version | Python version | Compiler | Build tools | cuDNN | CUDA |

|---|---|---|---|---|---|

| tensorflow_gpu-2.9.0 | 3.7-3.10 | MSVC 2019 | Bazel 5.1.1 | 8.3.3 | 11.5 |

二. cuda下载和安装

下载cuda和cuDNN。在官网上下载对应的cuda和cuDNN,版本可以低于上面查到的CUDA版本但不能高于电脑支持的版本。

cuda下载地址:

CUDA Toolkit Archive | NVIDIA Developer

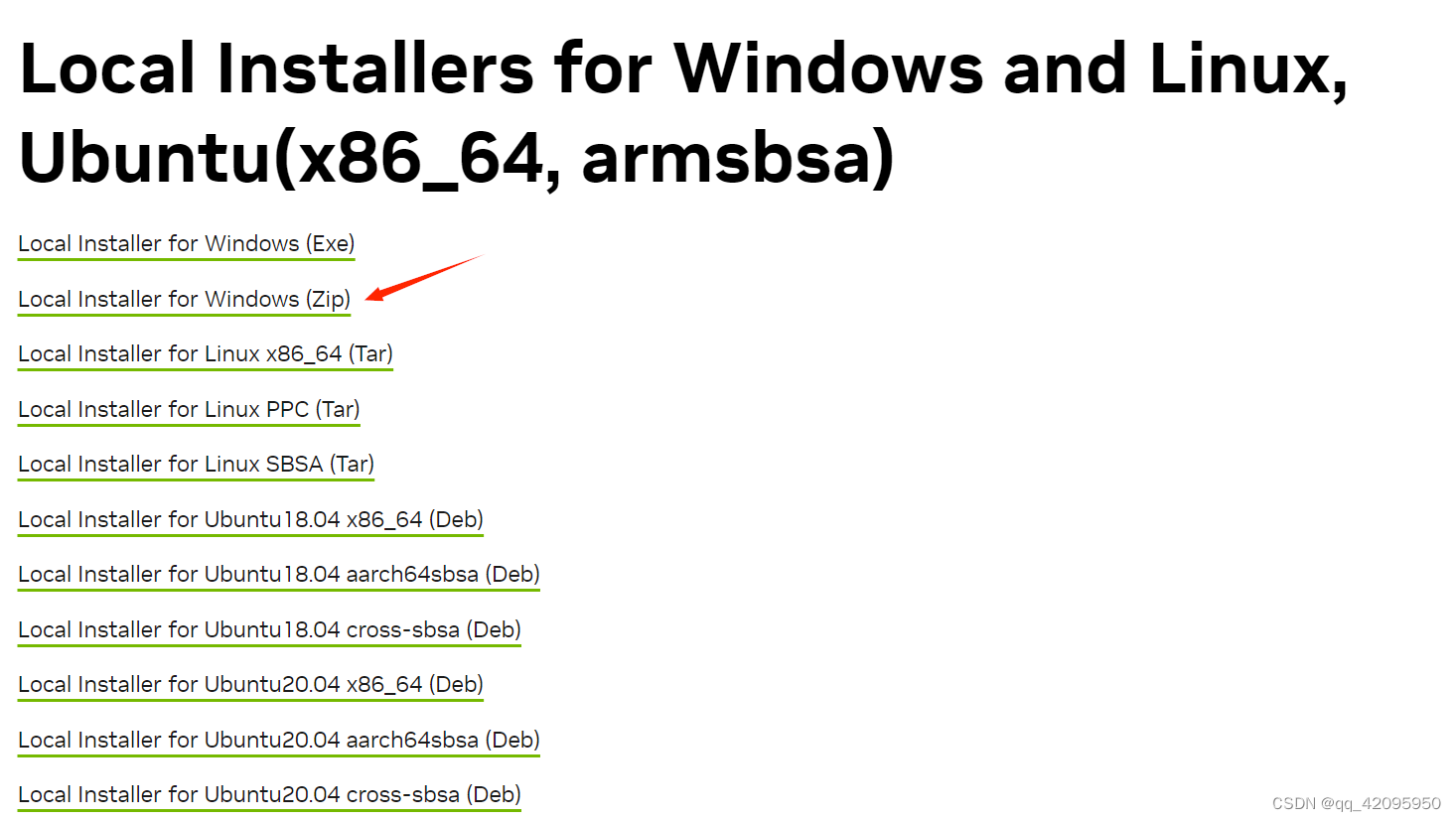

cudnn下载地址:cuDNN Archive | NVIDIA Developer。

cuDNN Archive | NVIDIA Developer

CUDA Toolkit 11.5 Downloads

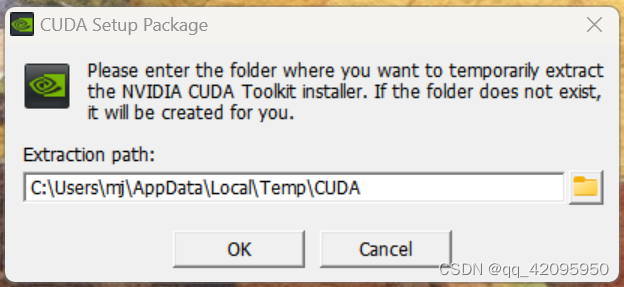

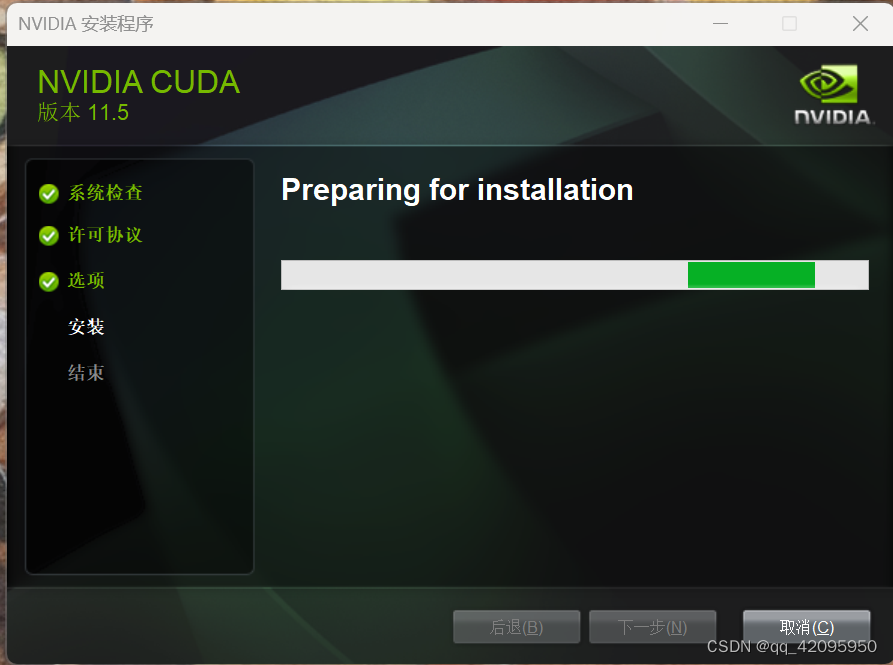

安装CUDA

双击安装包,此时会出现一个提示框,让你选择临时解压位置(该位置的内容在你安装完cuda之后会自动删除),这里默认即可,点击ok

点击同意并继续:

选择自定义,然后点下一步

这里CUDA一定要勾选上,下面的可选可不选,对后续没有影响。

- 在组件CUDA一栏中,取消勾选Visual Studio Integration(因为我们并没有使用Visual Stduio环境,即使勾选上了也会安装失败)

在Driver components一栏比较Display Driver的新版本和当前版本的信息。

- 若当前版本高于新版本,则取消勾选Display Driver;

- 若当前版本低于新版本,则保留默认安装信息即可,否则电脑会死机或者卡顿,甚至可能蓝屏。

下一步。

这个安装位置可以自己改。要截图记录一下你装到哪里了,后面要用到!我选择了默认安装位置。

点击关闭即可!

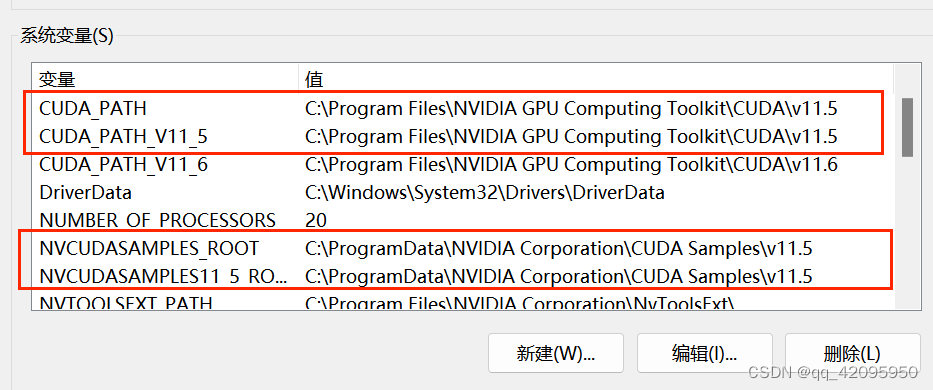

检查环境变量:

完成安装后,检查一下环境变量是否存在,一般安装完成会自动配置好环境变量,若是没有,则需手动配置,具体过程如下。

打开 电脑属性,找到 高级系统设置,选择 环境变量 打开。

查看是否有以下系统变量,没有则需要自行添加,对应图片上的名称和值,配置你电脑CUDA安装所在的位置。

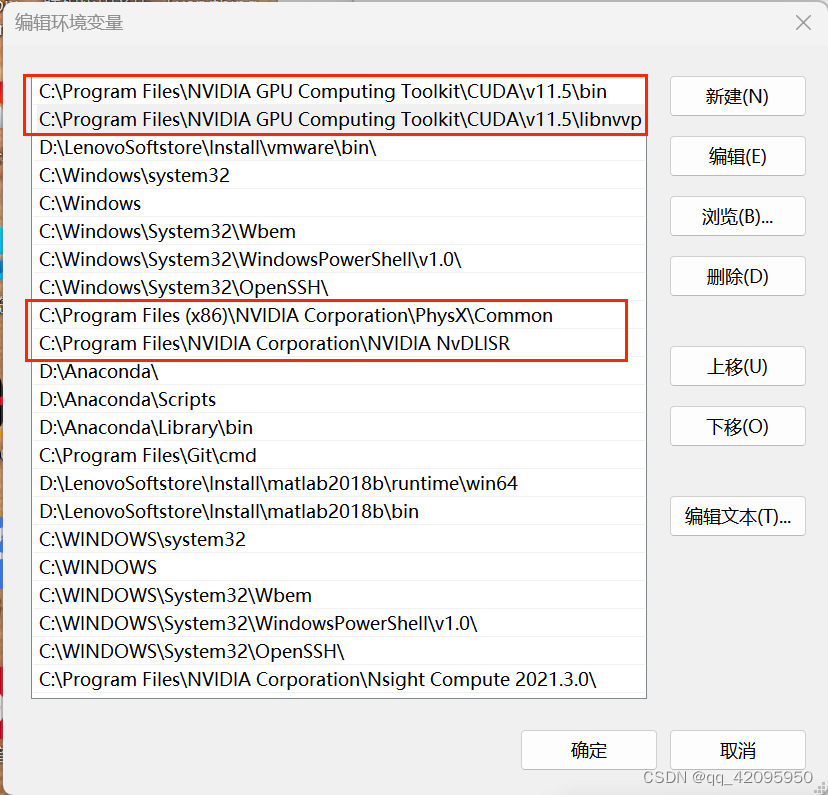

- 打开系统变量的Path,查看是否有一下两条内容,若没有则需自行添加,一定要配置对安装的位置。

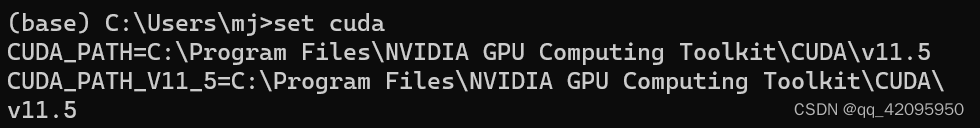

我们检查CUDA是否安装成功。

- 打开cmd,输入以下命令查看CUDA是否安装成功(二选一)

如果不能显示以下信息,则说明安装失败。

nvcc -V

nvcc --version

- 还可以查看CUDA 设置的环境变量。

set cuda

下载cudnn

从cuDNN Archive | NVIDIA Developer下载cudnn。版本为8.3.3

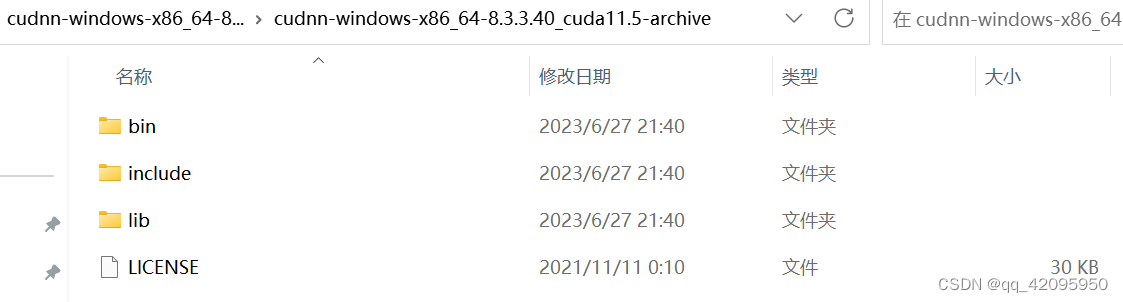

、下载解压好安装包后,我们解压可以看到有四个文件:

- 要将

cudnn文件中的对应文件夹下的所有文件复制 到对应的安装目录中, - 而 不是 把

cudnn文件中的文件夹复制过去。eg:复制的不是cudnn中的bin文件夹,而是bin文件夹下的所有文件。(有重复的文件是正常的,覆盖掉就好!

- 打开

cudnn文件中的bin文件夹,将该文件夹中所有的 文件 复制粘贴 到CUDA\v11.5\bin文件夹中 - 打开

cudnn文件中的include文件夹,将该文件夹中所有的 文件 复制粘贴 到CUDA\v11.5\include文件夹中 - 打开

cudnn文件中的lib文件夹,将该文件夹中所有的 文件 复制粘贴 到CUDA\v11.5\lib\x64文件夹中 - 打开

cudnn文件中的剩下的文件, 复制粘贴 到CUDA\v11.5文件夹中

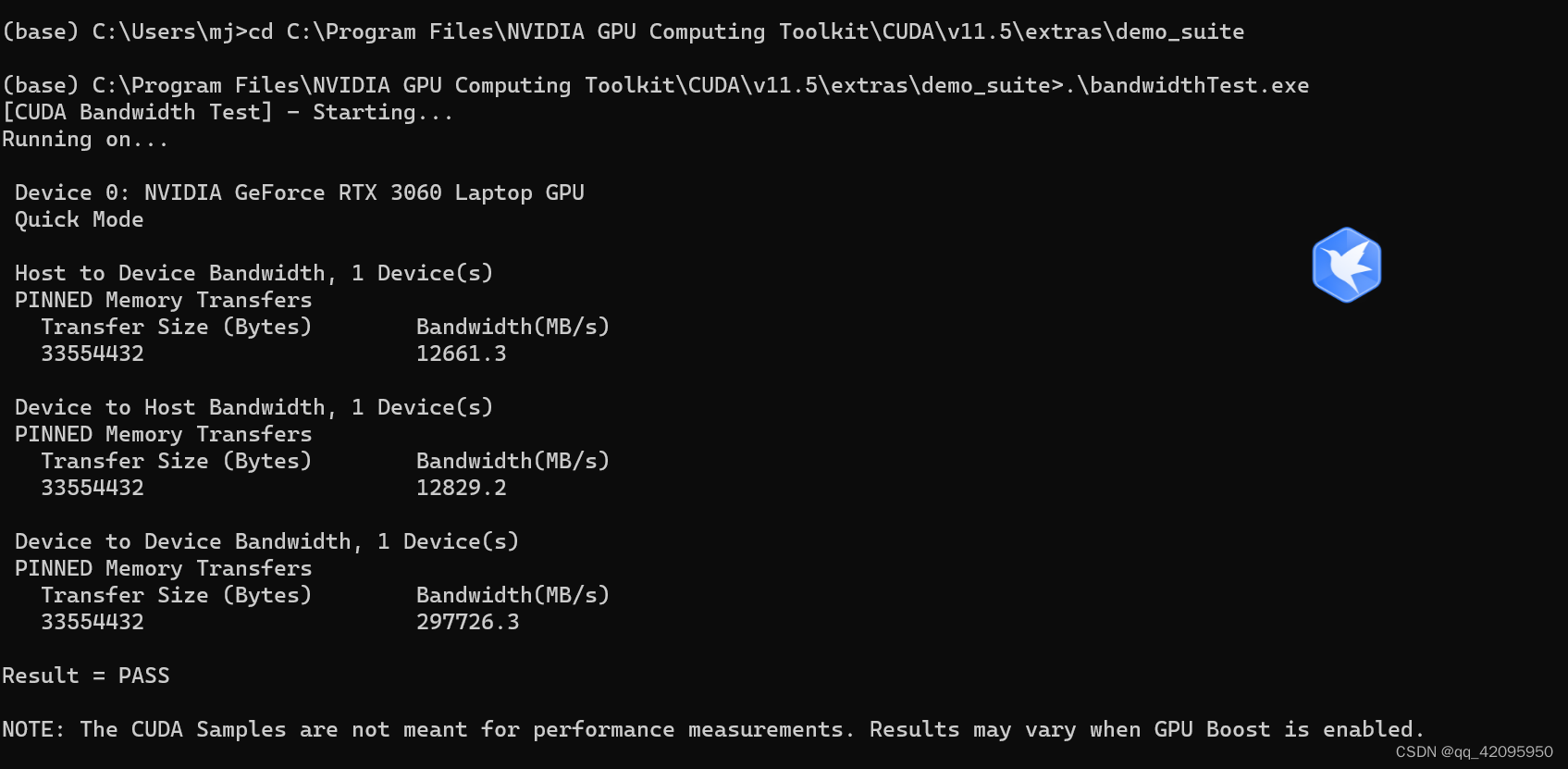

测试cudnn是否安装成功

都出现Result=pass,即为成功。

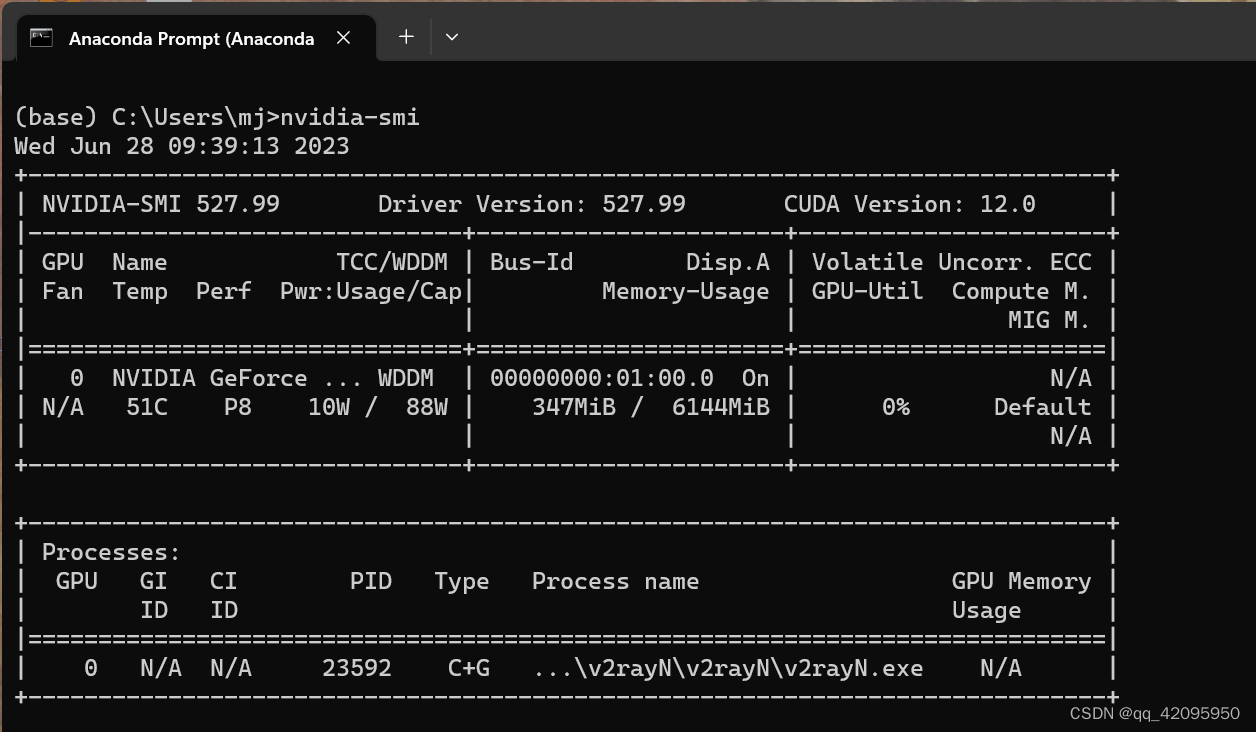

都安装好之后,我们可以继续输入nvidia-smi查看CUDA的信息,然后根据安装版本的信息再去实现其他的库(环境)安装和使用!

nvidia-smi

如图所示,可以看到驱动的版本是527.99;最高支持的CUDA版本是12.0版本。

三、创建 tensorflow 环境

1)打开anaconda prompt

2)创建tensorflow环境,

输入命令:conda create -n tensorflow-GPU python=3.9,表示创建一个名字为tensorflow的环境,这个环境用的python版本是3.9版本的,如果默认创建,会在C盘!

conda create -n tensorflow python=3.9

创建成功。使用 conda activate tensorflow-GPU 来进入tensorflow-GPU环境

退出

conda deactivate

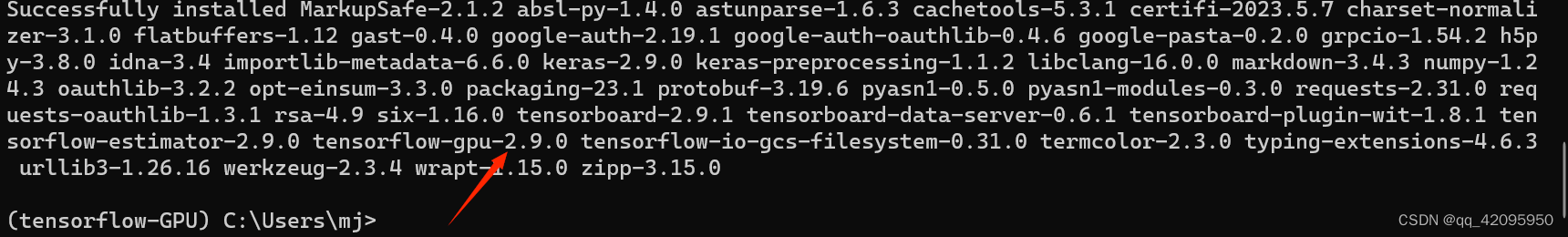

3)安装tensorflow-gpu,版本为2.9.0.

pip install tensorflow-gpu==2.9.0 -i https://pypi.mirrors.ustc.edu.cn/simple

成功

四、测试。

打开python环境,导入tensorflow包进行测试 ,

在pycharm里面,导入新建的虚拟环境tensorflow-GPU,

文件------>设置 ------>项目------>添加解释器------>选择本地解释器------>选择新建环境中的python.exe------>确定

1.查看tensorflow的版本信息, 输入命令:

import tensorflow as tf

tf.__version__

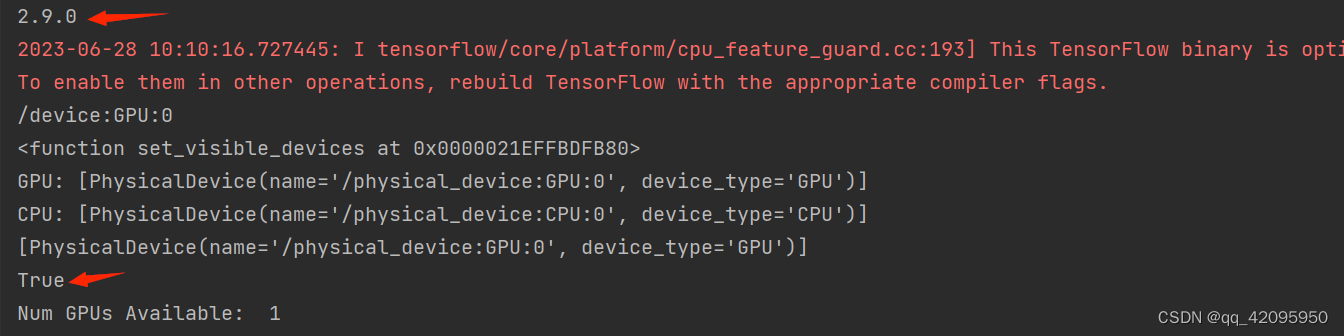

2.在pycharm输入以下测试代码:

import tensorflow as tf

print(tf.__version__)

print(tf.test.gpu_device_name())

print(tf.config.experimental.set_visible_devices)

print('GPU:', tf.config.list_physical_devices('GPU'))

print('CPU:', tf.config.list_physical_devices(device_type='CPU'))

print(tf.config.list_physical_devices('GPU'))

print(tf.test.is_gpu_available())

# 输出可用的GPU数量

print("Num GPUs Available: ", len(tf.config.experimental.list_physical_devices('GPU')))

# 查询GPU设备

3.测试一下GPU的运算速度

import tensorflow as tf

import timeit

#指定在cpu上运行

def cpu_run():

with tf.device('/cpu:0'):

cpu_a = tf.random.normal([10000, 1000])

cpu_b = tf.random.normal([1000, 2000])

c = tf.matmul(cpu_a, cpu_b)

return c

#指定在gpu上运行

def gpu_run():

with tf.device('/gpu:0'):

gpu_a = tf.random.normal([10000, 1000])

gpu_b = tf.random.normal([1000, 2000])

c = tf.matmul(gpu_a, gpu_b)

return c

cpu_time = timeit.timeit(cpu_run, number=10)

gpu_time = timeit.timeit(gpu_run, number=10)

print("cpu:", cpu_time, " gpu:", gpu_time)

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?