Autograd: 自动求导机制

autograd 和 Function 的官方文档 https://pytorch.org/docs/autograd

PyTorch 中所有神经网络的核心是 autograd 包。

autograd包为张量上的所有操作提供了自动求导。它是一个在运行时定义的框架,这意味着反向传播是根据代码来确定如何运行,并且每次迭代可以是不同的。

示例

张量(Tensor)

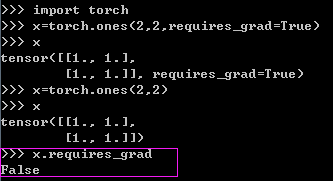

torch.Tensor是核心类。如果设置.requires_grad为True,那么将会追踪所有对于该张量的操作。当完成计算后通过调用.backward(),自动计算所有的梯度,这个张量的所有梯度将会自动积累到.grad属性。

要阻止张量跟踪历史记录,可以调用.detach()方法将其与计算历史记录分离,并禁止跟踪它将来的计算记录。

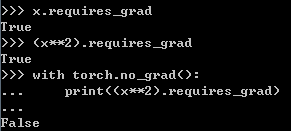

为了防止跟踪历史记录(和使用内存),可以将代码块包装在with torch.no_grad():中。 在评估模型时特别有用,因为模型可能具有requires_grad = True的可训练参数,但是我们不需要梯度计算。

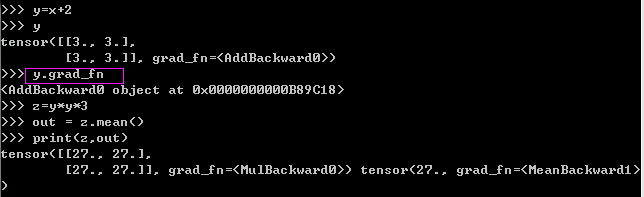

Tensor 和 Function互相连接并生成一个非循环图,它表示和存储了完整的计算历史。 每个张量都有一个.grad_fn属性,这个属性引用了一个创建了Tensor的Function(除非这个张量是用户手动创建的,即,这个张量的 grad_fn 是 None)。

如果需要计算导数,你可以在Tensor上调用.backward()。 如果Tensor是一个标量(即它包含一个元素数据)则不需要为backward()指定任何参数, 但是如果它有更多的元素,你需要指定一个gradient 参数来匹配张量的形状。

在其他的文章中你可能会看到说将Tensor包裹到Variable中提供自动梯度计算,Variable 这个在0.41版中已经被标注为过期了,现在可以直接使用Tensor,官方文档在这里: (https://pytorch.org/docs/stable/autograd.html#variable-deprecated)

张量默认的require_grad=False

.requires_grad_( ... ) 可以改变现有张量的 requires_grad属性。 如果没有指定的话,默认输入的flag是 False。

梯度

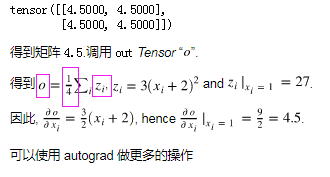

反向传播 因为 out是一个标量(scalar),out.backward() 等于out.backward(torch.tensor(1))。

在参数tensors不是标量的情况下,tensor.backward(grad_tensors)实现的是代价函数(loss=tensors.dot(grad_tensors))关于叶子节点的导数。

每次backward之前,需要注意叶子梯度节点是否清零,如果没有清零,第二次backward会累计上一次的梯度。

out.backward()

print(x.grad)

y.data.norm()

is equivalent to

torch.sqrt(torch.sum(torch.pow(y, 2)))#L2 Normx = torch.randn(3, requires_grad=True)

y = x * 2

while y.data.norm() < 1000:

y = y * 2

print(y)

gradients = torch.tensor([0.1, 1.0, 0.0001], dtype=torch.float)

y.backward(gradients)

print(x.grad)

如果.requires_grad=True但是你又不希望进行autograd的计算, 那么可以将变量包裹在 with torch.no_grad()中:

print(x.requires_grad)

print((x ** 2).requires_grad)

with torch.no_grad():

print((x ** 2).requires_grad)

参考:

https://github.com/zergtant/pytorch-handbook/blob/master/chapter1/2_autograd_tutorial.ipynb

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?