一、《Encoding Sentences with Graph Convolutional Networks for Semantic Role Labeling》

语义角色标注Semantic role labeling (SRL):以句子的谓词为中心,不对句子所包含的语义信息进行深入分析,只分析句子中各成分与谓词之间的关系,即句子的谓词(Predicate)- 论元(Argument)结构,并用语义角色来描述这些结构关系, 核心的语义角色: A0-5 六种,A0 通常表示动作的施事,A1通常表示动作的影响等,A2-5 根据谓语动词不同会有不同的语义含义。

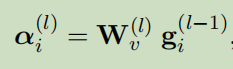

1、GCN+LSTM,在GCN中加入gates,就可以决定图中的哪一条边更重要,每条边有标签,其包含句法函数和判断这条边是句法依赖弧中的边(1)还是其反向边(2)还是连接自己的弧(3),其权重W针对3种不同的边有不同的权重(V,dir=1,2,3)

2、SRL一部分的弧与依存树中的弧有一部分重合,基于此可以想到,依存树中的边如果和SRL中的边重合,则应该加大此依存树上边的权重,不重合的边应该降低权重,所以加入Gates(g)

3、输入的向量包括四部分:随机初始化的、预训练、词性、谓语的向量,进行拼接,所有随机的向量参与训练,进入多层双向LSTM,每一层前向LSTM与后向LSTM的输出进行拼接,进入下一层双向LSTM,进入GCN,其中节点之间的边由外部解析工具得到,然后将GCN输出的候选词和谓语词特征表示连接起来,进入分类器softmax,其中参数W是由非线性变换得到。

二、《GraphIE: A Graph-Based Framework for Information Extraction》

命名实体识别

1、别人都用了依赖树,本论文用了其他信息

2、构建两种图:句子间的图(边为sentence dependencies),词之间的图(co-referent tokens)

3、模型:encoder(LSTM)generates local contextaware hidden representations for the textual unit、图模型learning non-local and non-sequential dependencies between textual units、decoder

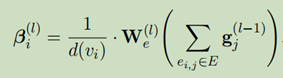

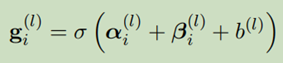

4、句子间的图:词的向量表示和charCNN学习的特征进行拼接,进入Bi-LSTM,输出的句子表示中的每个词相加求均值得到句子的向量表示,把句子作为节点,进入多层GCN(每层GCN有两部分组成,分别得到alpha和beta),得到新的句子表示,构建图的过程中有两种形式:一种简单的形式,无向图,边没有类型;一种是有向图,边有类型,此时把有向图的两种方向的边当做边的两种类型,赋予不同的权重W,此实验用的是第二种,

然后将GCN的输出分成两部分,进入Bi-LSTM的前向和后向,再进入CRF做最后的预测

5、词之间的图:只有在图模型中节点是词,输出的是一句话中的词的表示,然后进入Bi-LSTM,第一层的LSTM的隐藏状态有初始化0向量表示

三、 《Learning Interpretable Relationships between Entities, Relations and Concepts via Bayesian Structure Learning on Open Domain Facts》

【百度,知识推理】

通过贝叶斯结构学习开放领域中实体、关系、概念之间的可解释的关系

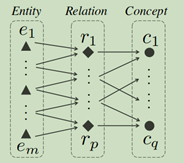

1、概念图(知识图谱)中的节点为实体和概念,实体到概念之间的边表示实体是概念的一个实例。BNSL模型找出开放领域中实例中实体之间的关系和概念图中实体和概念之间的联系。

2、实体和表达实体行为和属性的实体之间有关系,知识图中的概念是与对应关系集相关联的那些实体。一个概念是和有共同的行为和属性的实体联系着,概念的本质是一系列的关系,那么和这些关系有联系的实体就和这个概念有联系,在开放领域中,实体之间的关系可以找到,但概念和关系之间的关系找不到。

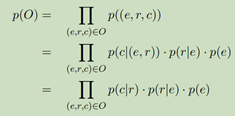

3、 基于图可以得出公式P(O),最关键的是要求出p(c/r),这里使用Bayesian Network Structure Learning (BNSL) technique提取relation和概念之间的关系,进而得到p(c/r),由于时间复杂度所以可以用近似算法进行优化。

4、优化过程:由于关系和概念之间的联系的稀疏性,所以把一个大问题分为多个子问题,每个子问题只有一个概念,对于每个概念获得其可能的关系,并用BNSL算法构建他们之间的网路结构,

(1)子问题构建过程:对于一个概念,获取其在知识图谱中所有的实体,然后获得实体所在的句子实例Fc,把实体在句子实例中是subject或object分为实例subject(Fcs)和实例object(Fco)。

(2)关系选择:选择在Fc中出现次数最多的关系为和这个概念c有联系的关系,基于Fcs和Fco可以产生两部分,分别选择在两部分中出现次数前K多的关系

5、得到数据:对于每个实体e,用1表示concept observation,表示实体e是概念c的一个实例,用e和r(前面获得的Fcs)共同出现在Fcs中的次数作为e和r的relation observation,这前K个relation observations 和concept observation成为概念c的正例,然后得到和正例数据相同的负例,正例和负例表示为Xcs,按相同的方法得到Xco。

6、构建网络结构:使用Chow-Liu tree building 算法作为BNSL方法,这个算法近似参数作为一个依存树,每个节点只有一个父节点,图中无环。把基于subject和object的关系连接起来作为一个完整的关系表示,

四、《Disentangled Graph Convolutional Networks》

1、现实世界中的图都是一些潜在因素相互作用的结果,即它们之间有边相连是因为各种各样的原因(具有各种各样的因素)。目前的深度学习方法忽略了这种潜在因素,导致学习的表示不健壮和不可解释。本文提出DisenGCN可以学习解耦节点表示,并提出新的邻域路由机制,可以动态的识别引起节点之间有边相连的潜在因素。把邻居放到一个通道可以提取和卷积特定因素的特征。

2、解耦GCN(DisenGCN)可以学习解耦节点表示,模型的核心是一个解耦多通道卷积层(DisenConv),邻域路由机制作用在这里面,去识别节点之间有边相连的因素,根据此把邻居放到针对特定因素的通道中。把它们映射到不同的子空间后,通过迭代的分析节点和其邻居潜在的子空间簇来推断潜在因素。DisenConv中的每一个通道从它收到的邻居那里,针对每一个解耦因素提取特征,独立的进行卷积操作。每一层只吸收局部邻居的信息,通过叠加多层可以捕获更远邻居的信息。

3、学习节点的解耦表示yu可以分解为K个独立的组件[c1,c2,…..ck],代表解耦出的K个潜在因素。第k个组件ck代表和第k个因素相关的描述。关键是找到节点的因为因素k而和其连接的邻居,从而可以很好的表示节点的ck。

4、DisenConv层输出的就是上述的[c1,c2,…..ck],共包含K个通道,每个通道提取不同的特征,每一个通道的输出对应相应的ci。计算z,通过zk和zk的邻居一起构建ck,但邻居选用的是和因素k有关的邻居而不是全部邻居,这里选邻居的方法是通过邻居路由机制。

五、《GCAN: Graph-aware Co-Attention Networks for Explainable Fake News Detection on Social Media》

1、强调证据以提高可解释性,本文基于假设:短文本、无用户评论、无社交网络架构和扩散网络。当判断为假新闻时,强调出证据,以提高了可解释性。

2、步骤

(1)从用户的序言和社会交互中提取特征,从短文本学习embedding

(2)在这些特征上应用CNN和RNN学习representation of retweet propagation

(3)构建图学习用户潜在的交互,并应用GCN,学习graph-aware representation of user interactions。

(4)使用双重co-attention机制学习源tweet和转发传播之间的交互,在源tweet和用户交互之间的 co-influence

3、模型包括五部分

(1)用户特征提取:构造特征说明一个用户是如何参与到社交网络中的,即为x

(2)新故事encoding:生成源tweet的表示。用一个MLP学习源tweet的one-hot表示,得到V,然后进入GRU,得到S

(3)用户转发表示:建模和表示用户的转发过程。S分别进入GRU和CNN得到两个表示h和C。用户和转发用户之间构造图,图的边权重为两个用户的x的余弦相似度值。用GCN学习节点表示G

(4)双重co-attention机制:捕获源tweet和用户转发之间的交互。包括Source-Interaction Co-attention和Source-Propagation Co-attention

(5)预测:拼接所有表示

948

948

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?