Kernelized Synaptic Weight Matrices

synaptic adj. 联合的,突触的

Abstract

一种新颖的神经网络架构,将权重参数用低维向量通过核方法交互后重参数化。描述了支撑(underpin)该模型的理论,并在推荐系统中应用该神经网络加强结构。

Introduction

神经网络有大量自由参数,训练集的最优性并不能保证在看不到的相似数据上有良好的行为,这就是过拟合。正则化技术被广泛应用到神经网络优化中。

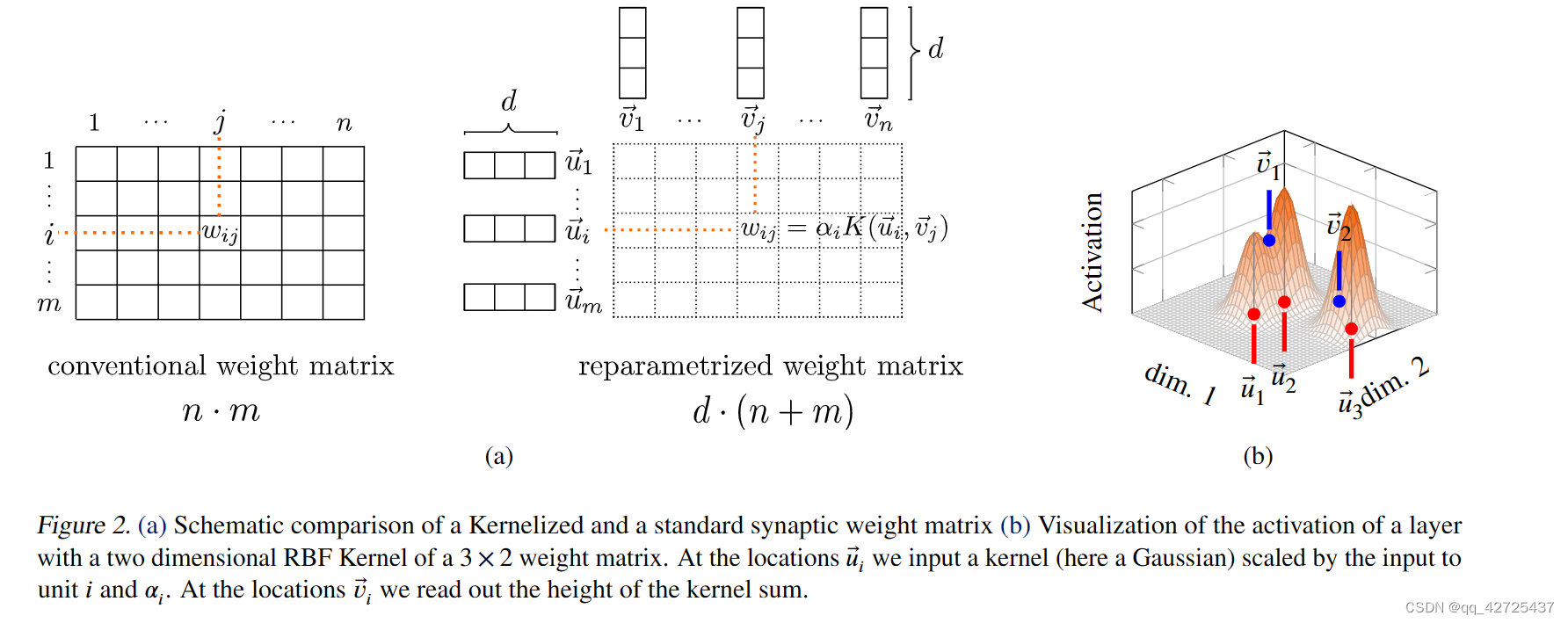

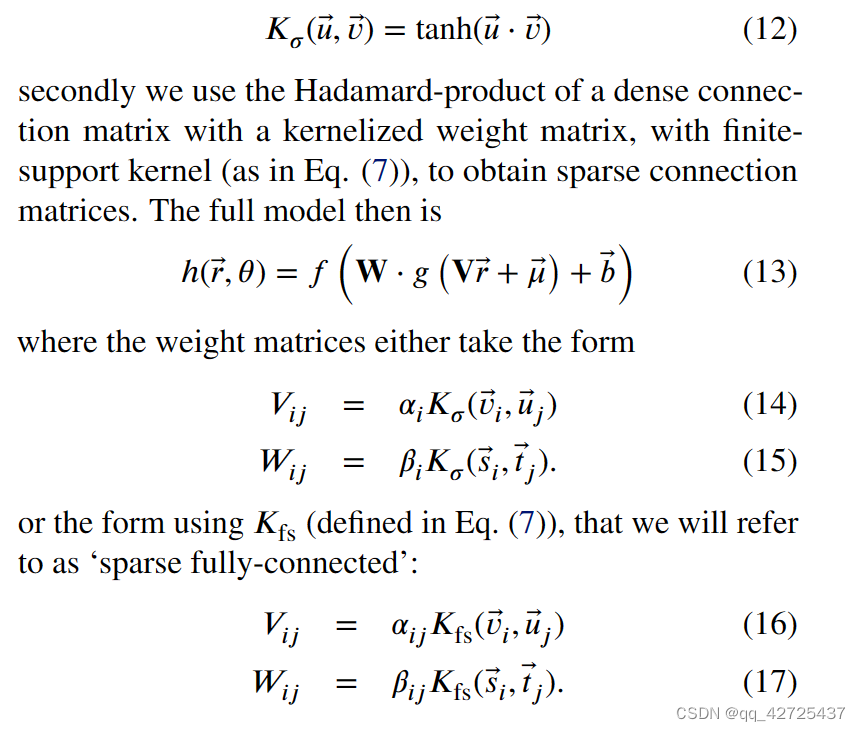

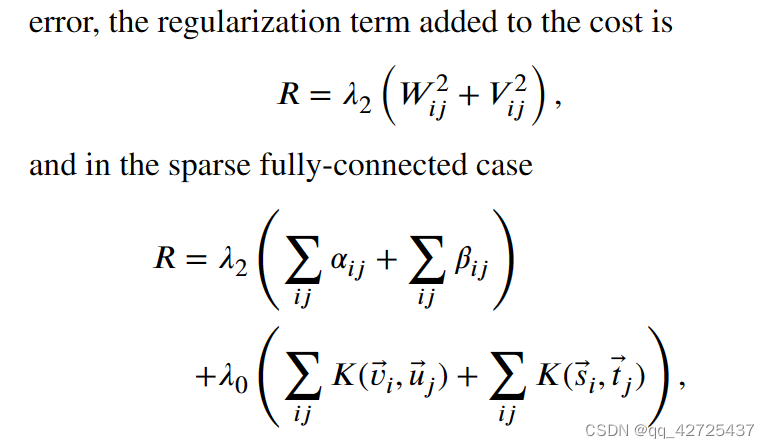

本文中,我们表明,通过把一个神经网络的权重表示为自由参数的地位向量的核交互,我们可以将权重矩阵嵌入到某些特征空间中;嵌入核函数控制。该技术提供了一个结构化的权重矩阵正则化的方法。

Theory

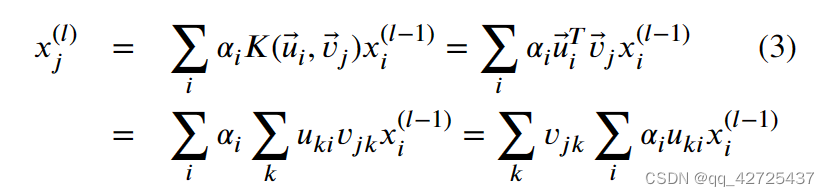

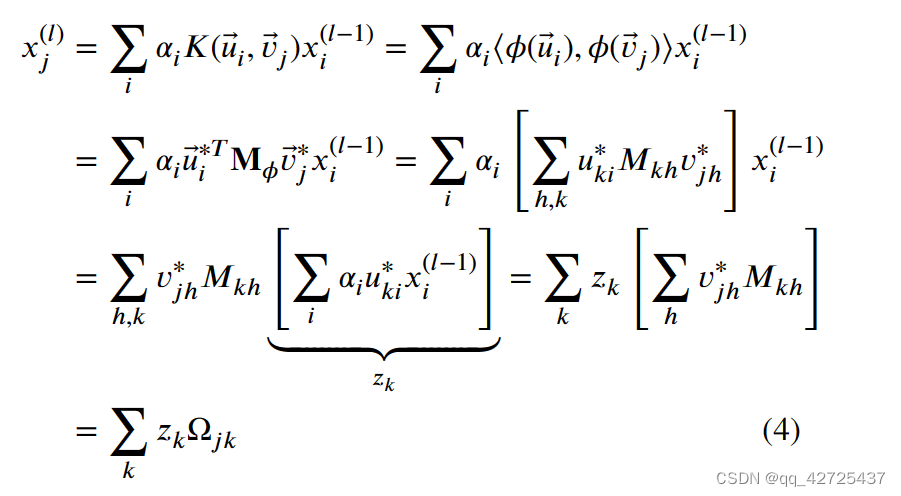

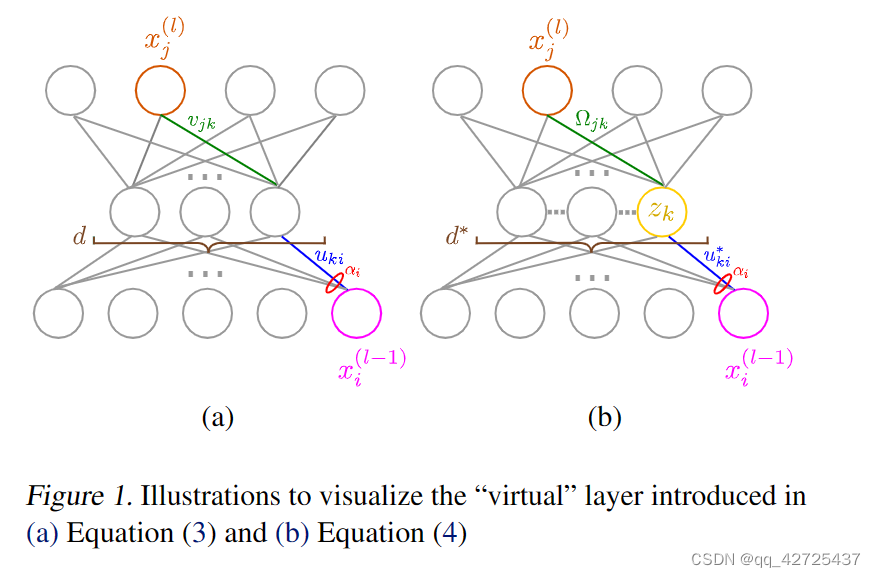

2.1 Definition:kernelNet

把d维的核化神经网络定义为分层函数逼近器,其中输入为

x

⃗

(

0

)

\vec{x}^{(0)}

x(0),输出为

x

⃗

(

N

)

\vec{x}^{(N)}

x(N):

x

j

(

l

)

=

f

j

(

∑

i

α

i

(

l

)

K

(

u

⃗

i

(

l

)

,

v

⃗

i

(

l

)

)

x

i

(

l

−

1

)

)

x_j^{(l)}=f_j(\sum_i \alpha_i^{(l)}K(\vec{u}_i^{(l)}, \vec{v}_i^{(l)})x_i^{(l-1)})

xj(l)=fj(i∑αi(l)K(ui(l),vi(l))xi(l−1))

其中上标是层索引,fi是非线性函数,

α

i

\alpha_i

αi是标量,K是核函数内积,在一些嵌入空间中:

K

(

u

⃗

,

v

⃗

)

=

⟨

ϕ

(

u

⃗

)

,

ϕ

(

v

⃗

)

⟩

=

⟨

u

⃗

∗

,

v

⃗

∗

⟩

K(\vec{u}, \vec{v}) = \langle\phi(\vec{u}), \phi(\vec{v})\rangle = \langle \vec{u}^*,\vec{v}^*\rangle

K(u,v)=⟨ϕ(u),ϕ(v)⟩=⟨u∗,v∗⟩

2.2 Relation to Fully-Connected Neural Networks

2.3 Radial Basis Function Kernels

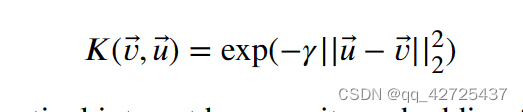

Guassian RBF Kernels

高斯RBF核

映射到无限空间,相同vector映射为1,当向量距离很远时,趋近为0

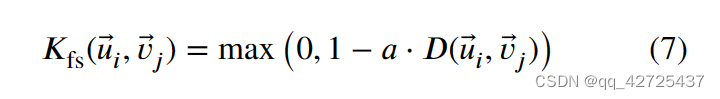

FINITE SUPPORT RBF KERNELS

有限支持的RBF核对嵌入网络的有限连接世家不同程度的稀疏性;这可以被用于非核化网络,通过非限制矩阵和有限支持核矩阵的hadamard积

3.5 Recommender Systems

550

550

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?