tagging scheme:

对每个关系生成单独的标签sequence,只有头实体和尾实体会被标注,其他被标注为O,此方法能解决重叠三元组问题

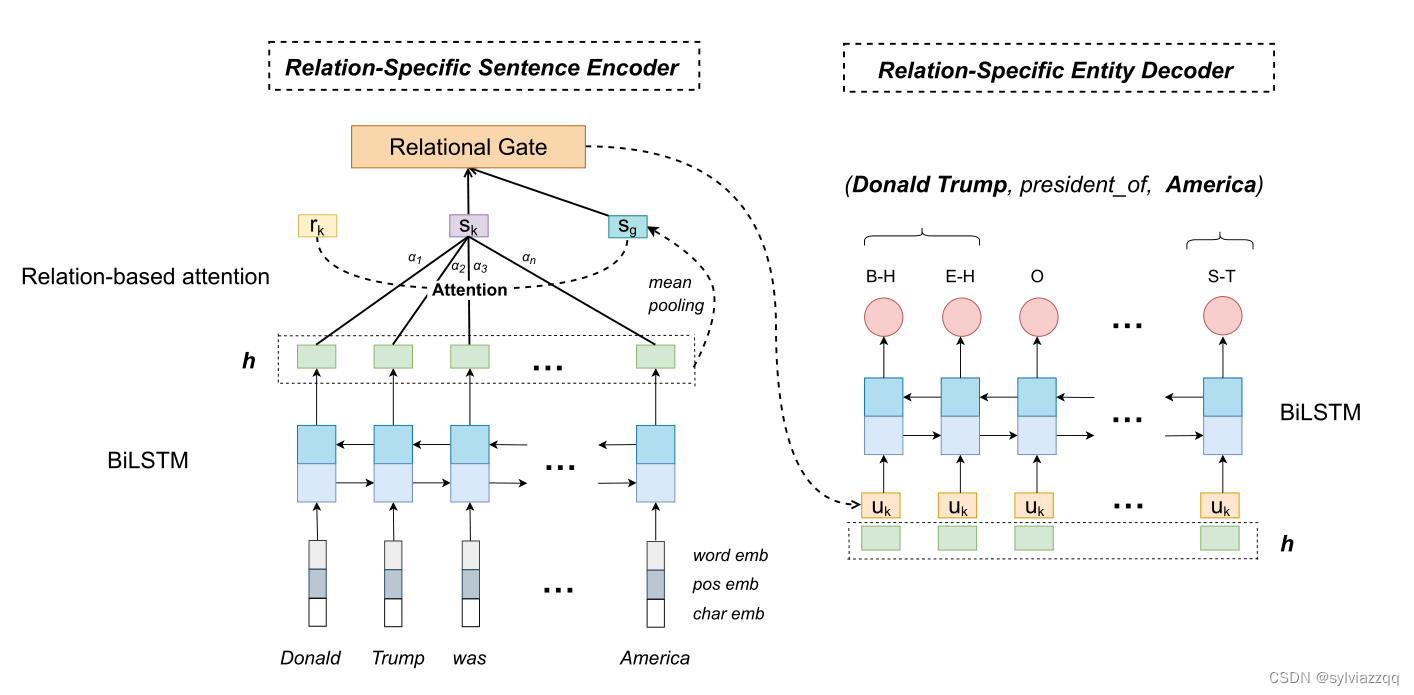

这张图是在rk关系下的模型图

input:a sentenc

经过bilstm进行编码得到句子向量{h1, h2......hn},然后应用注意机制来构建rk的特定句子表征。

Relation-Based Attention Mechanism(最重要的机制)

基于我们的假设,句子中的词在不同的关系下扮演不同的角色。为此,我们提出了一种基于关系的注意机制,为每个关系下的上下文词分配不同的权重。注意力得分按如下方式获得:

sg是全句向量 rk是关系 hi是词向量

这个公式计算的是hi这个词向量在这个关系对这句话的的贡献

sk是经过attention的句子向量

Relational Gated Mechanism:

sg是global representation

gk这个公式 是为了衡量 到底是sk关系的representation 还是sg这个global representation 对实体抽取更有用(保留的信息数)

uk是保留的关系信息

![]()

hi 词向量

hik即为最终句子representation

Relation-Specific Entity Decoder:

hik喂入lstm

P (yki)表示在关系rk下第I个单词的预测标签的概率。

9817

9817

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?