使用ollmam安装llmama3等模型

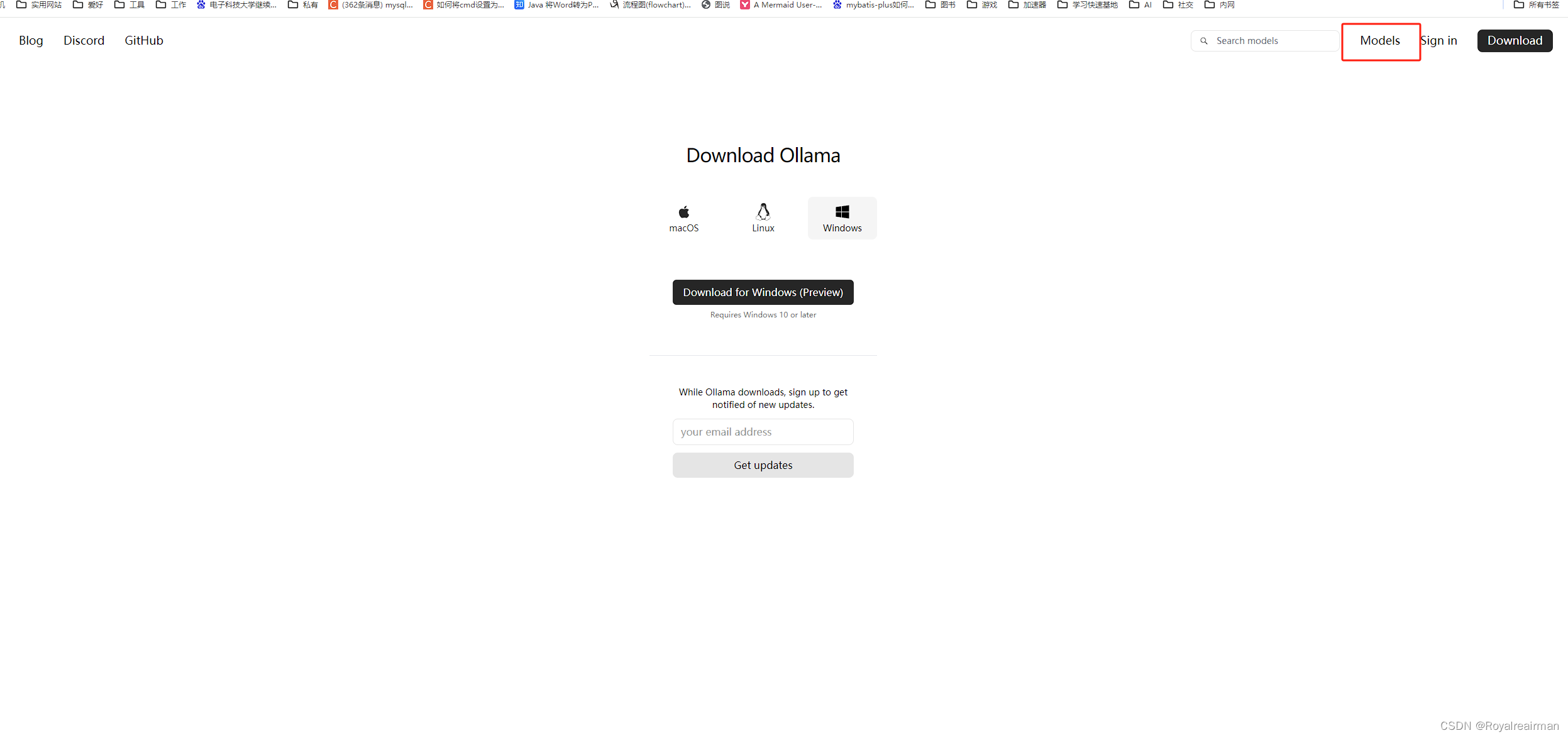

1.打开ollmam下载对应系统的软件,安装即可

官网:Ollama, 安装直接点就就行了,没有其他操作

2.安装模型

在官网找到对于的模型下载命令

记录命令:ollama run llama3

打开一个cmd窗口,输入命令等下载完成即可,

3.使用接口工具,调用,

http://localhost:11434/api/chat

{

"model": "llama3",

"messages": [

{

"role": "user",

"content": "用中文说一下java程序员怎么样"

}

],

"stream": false

}

缺点没有可视化界面,但是用于项目集成很不错,我这里已经卸载了,问的问题是回答是英文,我的建议找一个中文的模型导入进行,

使用LM Studio部署本地大模型

这种方案我比较推荐,简单下载快,有可视化界面,个人集成项目也可以,

1.下载LM StudioLM Studio - Discover, download, and run local LLMs

如果打不开网站,开一个加速器,这个安装也是直接无脑安装即可,

2.下载模型

这个社区别开加速器,不然打不开,这三个随便下一个就行了,全下载也行

新建一个存放模型的文件,把模型放进去,你也可以和我类似的文件结构

3.导入模型

打开软件LM studio

跟新模型文件夹

选择模型回答模板

4.使用模型

加载模型

等他加载完就可以使用了,

5.优化

文本改为markdom格式

6.本地启用api接口

点击启动服务即可

根据文档调用接口即可,如果文档没有看懂,可以在b站看大佬视频电脑本地部署Llama3中文版 - LM studio_哔哩哔哩_bilibili

docker部署还有一种使用open-webui我没有用过,有兴趣可以试一下,

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?