接上篇第4章的4.5:Flink(上):Flink入门,Flink特点介绍,批处理WordCount,流式处理WordCount,Flink安装部署集群,standalone与yarn模式,运行架构,任务流程调度并行数据流

文章目录

3.1 滚动窗口(TumblingEventTimeWindows)

3.2 滑动窗口(SlidingEventTimeWindows)

3.3 会话窗口(EventTimeSessionWindows)

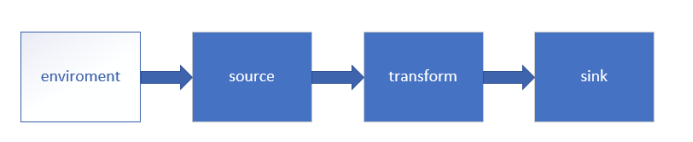

第五章 Flink 流处理Api

Environment

getExecutionEnvironment

创建一个执行环境,表示当前执行程序的上下文。 如果程序是独立调用的,则此方法返回本地执行环境;如果从命令行客户端调用程序以提交到集群,则此方法返回此集群的执行环境,也就是说,getExecutionEnvironment会根据查询运行的方式决定返回什么样的运行环境,是最常用的一种创建执行环境的方式。

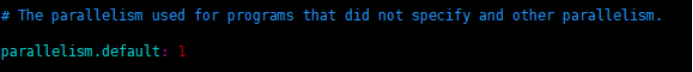

val env: ExecutionEnvironment = ExecutionEnvironment.getExecutionEnvironment如果没有设置并行度,会以flink-conf.yaml中的配置为准,默认是

createLocalEnvironment

返回本地执行环境,需要在调用时指定默认的并行度。

val env = StreamExecutionEnvironment.createLocalEnvironment(1)createRemoteEnvironment

返回集群执行环境,将Jar提交到远程服务器。需要在调用时指定JobManager的IP和端口号,并指定要在集群中运行的Jar包。

val env = ExecutionEnvironment.createRemoteEnvironment("jobmanager-hostname", 6123,"C://jar//flink//wordcount.jar")Source

创建kafka工具类

object MyKafkaUtil {

val prop = new Properties()

prop.setProperty("bootstrap.servers","hadoop1:9092")

prop.setProperty("group.id","gmall")

def getConsumer(topic:String ):FlinkKafkaConsumer011[String]= {

val myKafkaConsumer:FlinkKafkaConsumer011[String] = new FlinkKafkaConsumer011[String](topic, new SimpleStringSchema(), prop)

myKafkaConsumer

}

}增加业务主类 StartupApp

object StartupApp {

def main(args: Array[String]): Unit = {

val environment: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

val kafkaConsumer =MyKafkaUtil.getConsumer("GMALL_STARTUP")

val dstream: DataStream[String] = environment.addSource(kafkaConsumer)

dstream.print()

environment.execute()

}

}Flink+kafka是如何实现exactly-once语义的

Flink通过checkpoint来保存数据是否处理完成的状态

由JobManager协调各个TaskManager进行checkpoint存储,checkpoint保存在 StateBackend中,默认StateBackend是内存级的,也可以改为文件级的进行持久化保存。

执行过程实际上是一个两段式提交,每个算子执行完成,会进行“预提交”,直到执行完sink操作,会发起“确认提交”,如果执行失败,预提交会放弃掉。

如果宕机需要通过StateBackend进行恢复,只能恢复所有确认提交的操作。

3 Transform

转换算子

3.1 map

val streamMap = stream.map { x => x * 2 }3.2 flatMap

val streamFlatMap = stream.flatMap{

x => x.split(" ")

}3.3 Filter

val streamFilter = stream.filter{

x => x == 1

}3.4 KeyBy

DataStream → KeyedStream:输入必须是Tuple类型,逻辑地将一个流拆分成不相交的分区,每个分区包含具有相同key的元素,在内部以hash的形式实现的。

3.5 Reduce

KeyedStream → DataStream:一个分组数据流的聚合操作,合并当前的元素和上次聚合的结果,产生一个新的值,返回的流中包含每一次聚合的结果,而不是只返回最后一次聚合的最终结果。

//求各个渠道的累计个数

val startUplogDstream: DataStream[StartUpLog] = dstream.map{ JSON.parseObject(_,classOf[StartUpLog])}

val keyedStream: KeyedStream[(String, Int), Tuple] = startUplogDstream.map(startuplog=>(startuplog.ch,1)).keyBy(0)

//reduce //sum

keyedStream.reduce{ (ch1,ch2)=>

(ch1._1,ch1._2+ch2._2)

} .print().setParallelism(1)flink是如何保存累计值的,

flink是一种有状态的流计算框架,其中说的状态包括两个层面:

- operator state 主要是保存数据在流程中的处理状态,用于确保语义的exactly-once。

- keyed state 主要是保存数据在计算过程中的累计值。

这两种状态都是通过checkpoint机制保存在StateBackend中,StateBackend可以选择保存在内存中(默认使用)或者保存在磁盘文件中。

3.6 Split 和 Select

Split

图 会话窗口

3 Window API

TimeWindow

TimeWindow是将指定时间范围内的所有数据组成一个window,一次对一个window里面的所有数据进行计算。

- 滚动窗口

Flink默认的时间窗口根据Processing Time 进行窗口的划分,将Flink获取到的数据根据进入Flink的时间划分到不同的窗口中。

val keyedStream: KeyedStream[(String, Int), Tuple] = startUplogDstream.map(startuplog=>(startuplog.ch,1)).keyBy(0)

//每10统计一次各个渠道的计数

val windowedStream: WindowedStream[(String, Int), Tuple, TimeWindow] = keyedStream.timeWindow(Time.seconds(10))

val sumDstream: DataStream[(String, Int)] = windowedStream.sum(1)时间间隔可以通过Time.milliseconds(x),Time.seconds(x),Time.minutes(x)等其中的一个来指定。

- 滑动窗口(SlidingEventTimeWindows)

滑动窗口和滚动窗口的函数名是完全一致的,只是在传参数时需要传入两个参数,一个是window_size,一个是sliding_size。

下面代码中的sliding_size设置为了2s,也就是说,窗口每2s就计算一次,每一次计算的window范围是5s内的所有元素。

val keyedStream: KeyedStream[(String, Int), Tuple] = startUplogDstream.map(startuplog=>(startuplog.ch,1)).keyBy(0)

//每5秒统计一次最近10秒的各个渠道的计数

val windowedStream: WindowedStream[(String, Int), Tuple, TimeWindow] = keyedStream.timeWindow(Time.seconds(10),Time.seconds(5))

val sumDstream: DataStream[(String, Int)] = windowedStream.sum(1)时间间隔可以通过Time.milliseconds(x),Time.seconds(x),Time.minutes(x)等其中的一个来指定。

CountWindow

CountWindow根据窗口中相同key元素的数量来触发执行,执行时只计算元素数量达到窗口大小的key对应的结果。

注意:CountWindow的window_size指的是相同Key的元素的个数,不是输入的所有元素的总数。

滚动窗口

默认的CountWindow是一个滚动窗口,只需要指定窗口大小即可,当元素数量达到窗口大小时,就会触发窗口的执行。

val keyedStream: KeyedStream[(String, Int), Tuple] = startUplogDstream.map(startuplog=>(startuplog.ch,1)).keyBy(0)

//每当某一个key的个数达到10的时候,显示出来

val windowedStream: WindowedStream[(String, Int), Tuple, GlobalWindow] = keyedStream.countWindow(10)

val sumDstream: DataStream[(String, Int)] = windowedStream.sum(1)滑动窗口

滑动窗口和滚动窗口的函数名是完全一致的,只是在传参数时需要传入两个参数,一个是window_size,一个是sliding_size。

下面代码中的sliding_size设置为了2,也就是说,每收到两个相同key的数据就计算一次,每一次计算的window范围是5个元素。

val keyedStream: KeyedStream[(String, Int), Tuple] = startUplogDstream.map(startuplog=>(startuplog.ch,1)).keyBy(0)

//每当某一个key的个数达到2的时候,触发计算,计算最近该key最近10个元素的内容

val windowedStream: WindowedStream[(String, Int), Tuple, GlobalWindow] = keyedStream.countWindow(10,2)

val sumDstream: DataStream[(String, Int)] = windowedStream.sum(1)第七章 EventTime与Window

1 EventTime的引入

在Flink的流式处理中,绝大部分的业务都会使用eventTime,一般只在eventTime无法使用时,才会被迫使用ProcessingTime或者IngestionTime。

如果要使用EventTime,那么需要引入EventTime的时间属性,引入方式如下所示:

val env = StreamExecutionEnvironment.getExecutionEnvironment

// 从调用时刻开始给env创建的每一个stream追加时间特征

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

2 Watermark

2.1 基本概念

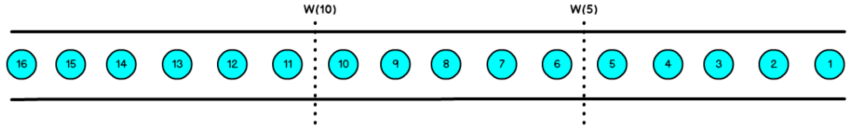

我们知道,流处理从事件产生,到流经source,再到operator,中间是有一个过程和时间的,虽然大部分情况下,流到operator的数据都是按照事件产生的时间顺序来的,但是也不排除由于网络、分布式等原因,导致乱序的产生,所谓乱序,就是指Flink接收到的事件的先后顺序不是严格按照事件的Event Time顺序排列的。

图 数据的乱序

那么此时出现一个问题,一旦出现乱序,如果只根据eventTime决定window的运行,我们不能明确数据是否全部到位,但又不能无限期的等下去,此时必须要有个机制来保证一个特定的时间后,必须触发window去进行计算了,这个特别的机制,就是Watermark。

Watermark是一种衡量Event Time进展的机制,它是数据本身的一个隐藏属性,数据本身携带着对应的Watermark。

Watermark是用于处理乱序事件的,而正确的处理乱序事件,通常用Watermark机制结合window来实现。

数据流中的Watermark用于表示timestamp小于Watermark的数据,都已经到达了,因此,window的执行也是由Watermark触发的。

Watermark可以理解成一个延迟触发机制,我们可以设置Watermark的延时时长t,每次系统会校验已经到达的数据中最大的maxEventTime,然后认定eventTime小于maxEventTime - t的所有数据都已经到达,如果有窗口的停止时间等于maxEventTime – t,那么这个窗口被触发执行。

有序流的Watermarker如下图所示:(Watermark设置为0)

图 有序数据的Watermark

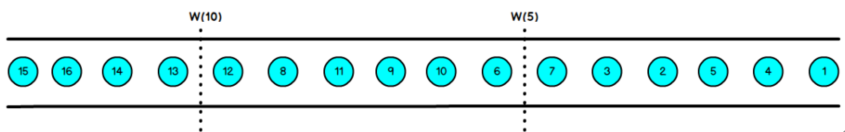

乱序流的Watermarker如下图所示:(Watermark设置为2)

图 无序数据的Watermark

当Flink接收到每一条数据时,都会产生一条Watermark,这条Watermark就等于当前所有到达数据中的maxEventTime - 延迟时长,也就是说,Watermark是由数据携带的,一旦数据携带的Watermark比当前未触发的窗口的停止时间要晚,那么就会触发相应窗口的执行。由于Watermark是由数据携带的,因此,如果运行过程中无法获取新的数据,那么没有被触发的窗口将永远都不被触发。

上图中,我们设置的允许最大延迟到达时间为2s,所以时间戳为7s的事件对应的Watermark是5s,时间戳为12s的事件的Watermark是10s,如果我们的窗口1是1s~5s,窗口2是6s~10s,那么时间戳为7s的事件到达时的Watermarker恰好触发窗口1,时间戳为12s的事件到达时的Watermark恰好触发窗口2。

Watermark 就是触发前一窗口的“关窗时间”,一旦触发关门那么以当前时刻为准在窗口范围内的所有所有数据都会收入窗中。

只要没有达到水位那么不管现实中的时间推进了多久都不会触发关窗。

2.2 Watermark的引入

val textWithEventTimeDstream: DataStream[(String, Long, Int)] = textWithTsDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[(String, Long, Int)](Time.milliseconds(1000)) {

override def extractTimestamp(element: (String, Long, Int)): Long = {

return element._2

}

})7.3 EvnetTimeWindow API

3.1 滚动窗口(TumblingEventTimeWindows)

def main(args: Array[String]): Unit = {

// 环境

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

env.setParallelism(1)

val dstream: DataStream[String] = env.socketTextStream("hadoop1",7777)

val textWithTsDstream: DataStream[(String, Long, Int)] = dstream.map { text =>

val arr: Array[String] = text.split(" ")

(arr(0), arr(1).toLong, 1)

}

val textWithEventTimeDstream: DataStream[(String, Long, Int)] = textWithTsDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[(String, Long, Int)](Time.milliseconds(1000)) {

override def extractTimestamp(element: (String, Long, Int)): Long = {

return element._2

}

})

val textKeyStream: KeyedStream[(String, Long, Int), Tuple] = textWithEventTimeDstream.keyBy(0)

textKeyStream.print("textkey:")

val windowStream: WindowedStream[(String, Long, Int), Tuple, TimeWindow] = textKeyStream.window(TumblingEventTimeWindows.of(Time.seconds(2)))

val groupDstream: DataStream[mutable.HashSet[Long]] = windowStream.fold(new mutable.HashSet[Long]()) { case (set, (key, ts, count)) =>

set += ts

}

groupDstream.print("window::::").setParallelism(1)

env.execute()

}

}结果是按照Event Time的时间窗口计算得出的,而无关系统的时间(包括输入的快慢)。

3.2 滑动窗口(SlidingEventTimeWindows)

def main(args: Array[String]): Unit = {

// 环境

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

env.setParallelism(1)

val dstream: DataStream[String] = env.socketTextStream("hadoop1",7777)

val textWithTsDstream: DataStream[(String, Long, Int)] = dstream.map { text =>

val arr: Array[String] = text.split(" ")

(arr(0), arr(1).toLong, 1)

}

val textWithEventTimeDstream: DataStream[(String, Long, Int)] = textWithTsDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[(String, Long, Int)](Time.milliseconds(1000)) {

override def extractTimestamp(element: (String, Long, Int)): Long = {

return element._2

}

})

val textKeyStream: KeyedStream[(String, Long, Int), Tuple] = textWithEventTimeDstream.keyBy(0)

textKeyStream.print("textkey:")

val windowStream: WindowedStream[(String, Long, Int), Tuple, TimeWindow] = textKeyStream.window(SlidingEventTimeWindows.of(Time.seconds(2),Time.milliseconds(500)))

val groupDstream: DataStream[mutable.HashSet[Long]] = windowStream.fold(new mutable.HashSet[Long]()) { case (set, (key, ts, count)) =>

set += ts

}

groupDstream.print("window::::").setParallelism(1)

env.execute()

}3.3 会话窗口(EventTimeSessionWindows)

相邻两次数据的EventTime的时间差超过指定的时间间隔就会触发执行。如果加入Watermark, 会在符合窗口触发的情况下进行延迟。到达延迟水位再进行窗口触发。

def main(args: Array[String]): Unit = {

// 环境

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

env.setParallelism(1)

val dstream: DataStream[String] = env.socketTextStream("hadoop1",7777)

val textWithTsDstream: DataStream[(String, Long, Int)] = dstream.map { text =>

val arr: Array[String] = text.split(" ")

(arr(0), arr(1).toLong, 1)

}

val textWithEventTimeDstream: DataStream[(String, Long, Int)] = textWithTsDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[(String, Long, Int)](Time.milliseconds(1000)) {

override def extractTimestamp(element: (String, Long, Int)): Long = {

return element._2

}

})

val textKeyStream: KeyedStream[(String, Long, Int), Tuple] = textWithEventTimeDstream.keyBy(0)

textKeyStream.print("textkey:")

val windowStream: WindowedStream[(String, Long, Int), Tuple, TimeWindow] = textKeyStream.window(EventTimeSessionWindows.withGap(Time.milliseconds(500)) )

windowStream.reduce((text1,text2)=>

( text1._1,0L,text1._3+text2._3)

) .map(_._3).print("windows:::").setParallelism(1)

env.execute()

}第八章 Table API 与SQL

Table API是流处理和批处理通用的关系型API,Table API可以基于流输入或者批输入来运行而不需要进行任何修改。Table API是SQL语言的超集并专门为Apache Flink设计的,Table API是Scala 和Java语言集成式的API。与常规SQL语言中将查询指定为字符串不同,Table API查询是以Java或Scala中的语言嵌入样式来定义的,具有IDE支持如:自动完成和语法检测。

1 需要引入的pom依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table_2.11</artifactId>

<version>1.7.0</version>

</dependency>2 构造表环境

def main(args: Array[String]): Unit = {

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

val myKafkaConsumer: FlinkKafkaConsumer011[String] = MyKafkaUtil.getConsumer("GMALL_STARTUP")

val dstream: DataStream[String] = env.addSource(myKafkaConsumer)

val tableEnv: StreamTableEnvironment = TableEnvironment.getTableEnvironment(env)

val startupLogDstream: DataStream[StartupLog] = dstream.map{ jsonString =>JSON.parseObject(jsonString,classOf[StartupLog]) }

val startupLogTable: Table = tableEnv.fromDataStream(startupLogDstream)

val table: Table = startupLogTable.select("mid,ch").filter("ch ='appstore'")

val midchDataStream: DataStream[(String, String)] = table.toAppendStream[(String,String)]

midchDataStream.print()

env.execute()

}动态表

如果流中的数据类型是case class可以直接根据case class的结构生成table

tableEnv.fromDataStream(startupLogDstream) 或者根据字段顺序单独命名

tableEnv.fromDataStream(startupLogDstream,’mid,’uid .......) 最后的动态表可以转换为流进行输出

table.toAppendStream[(String,String)]字段

用一个单引放到字段前面 来标识字段名, 如 ‘name , ‘mid ,’amount 等

3 通过一个例子 了解TableAPI

//每10秒中渠道为appstore的个数

def main(args: Array[String]): Unit = {

//sparkcontext

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

//时间特性改为eventTime

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

val myKafkaConsumer: FlinkKafkaConsumer011[String] = MyKafkaUtil.getConsumer("GMALL_STARTUP")

val dstream: DataStream[String] = env.addSource(myKafkaConsumer)

val startupLogDstream: DataStream[StartupLog] = dstream.map{ jsonString =>JSON.parseObject(jsonString,classOf[StartupLog]) }

//告知watermark 和 eventTime如何提取

val startupLogWithEventTimeDStream: DataStream[StartupLog] = startupLogDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[StartupLog](Time.seconds(0L)) {

override def extractTimestamp(element: StartupLog): Long = {

element.ts

}

}).setParallelism(1)

//SparkSession

val tableEnv: StreamTableEnvironment = TableEnvironment.getTableEnvironment(env)

//把数据流转化成Table

val startupTable: Table = tableEnv.fromDataStream(startupLogWithEventTimeDStream , 'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)

//通过table api 进行操作

// 每10秒 统计一次各个渠道的个数 table api 解决

//1 groupby 2 要用 window 3 用eventtime来确定开窗时间

val resultTable: Table = startupTable.window(Tumble over 10000.millis on 'ts as 'tt).groupBy('ch,'tt ).select( 'ch, 'ch.count)

//把Table转化成数据流

//val appstoreDStream: DataStream[(String, String, Long)] = appstoreTable.toAppendStream[(String,String,Long)]

val resultDstream: DataStream[(Boolean, (String, Long))] = resultSQLTable.toRetractStream[(String,Long)]

resultDstream.filter(_._1).print()

env.execute()

}关于group by

如果使用 groupby table转换为流的时候只能用toRetractDstream

val rDstream: DataStream[(Boolean, (String, Long))] = table.toRetractStream[(String,Long)]toRetractDstream 得到的第一个boolean型字段标识 true就是最新的数据,false表示过期老数据

val rDstream: DataStream[(Boolean, (String, Long))] = table.toRetractStream[(String,Long)]

rDstream.filter(_._1).print()如果使用的api包括时间窗口,那么时间的字段必须,包含在group by中。

val table: Table = startupLogTable.filter("ch ='appstore'").window(Tumble over 10000.millis on 'ts as 'tt).groupBy('ch ,'tt).select("ch,ch.count ")关于时间窗口

用到时间窗口,必须提前声明时间字段,如果是processTime直接在创建动态表时进行追加就可以

val startupLogTable: Table = tableEnv.fromDataStream(startupLogWithEtDstream,'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)如果是EventTime要在创建动态表时声明

val startupLogTable: Table = tableEnv.fromDataStream(startupLogWithEtDstream,'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ps.processtime)滚动窗口可以使用Tumble over 10000.millis on

val table: Table = startupLogTable.filter("ch ='appstore'").window(Tumble over 10000.millis on 'ts as 'tt).groupBy('ch ,'tt).select("ch,ch.count ")4 SQL如何编写

def main(args: Array[String]): Unit = {

//sparkcontext

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

//时间特性改为eventTime

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

val myKafkaConsumer: FlinkKafkaConsumer011[String] = MyKafkaUtil.getConsumer("GMALL_STARTUP")

val dstream: DataStream[String] = env.addSource(myKafkaConsumer)

val startupLogDstream: DataStream[StartupLog] = dstream.map{ jsonString =>JSON.parseObject(jsonString,classOf[StartupLog]) }

//告知watermark 和 eventTime如何提取

val startupLogWithEventTimeDStream: DataStream[StartupLog] = startupLogDstream.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractor[StartupLog](Time.seconds(0L)) {

override def extractTimestamp(element: StartupLog): Long = {

element.ts

}

}).setParallelism(1)

//SparkSession

val tableEnv: StreamTableEnvironment = TableEnvironment.getTableEnvironment(env)

//把数据流转化成Table

val startupTable: Table = tableEnv.fromDataStream(startupLogWithEventTimeDStream , 'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)

//通过table api 进行操作

// 每10秒 统计一次各个渠道的个数 table api 解决

//1 groupby 2 要用 window 3 用eventtime来确定开窗时间

val resultTable: Table = startupTable.window(Tumble over 10000.millis on 'ts as 'tt).groupBy('ch,'tt ).select( 'ch, 'ch.count)

// 通过sql 进行操作

val resultSQLTable : Table = tableEnv.sqlQuery( "select ch ,count(ch) from "+startupTable+" group by ch ,Tumble(ts,interval '10' SECOND )")

//把Table转化成数据流

//val appstoreDStream: DataStream[(String, String, Long)] = appstoreTable.toAppendStream[(String,String,Long)]

val resultDstream: DataStream[(Boolean, (String, Long))] = resultSQLTable.toRetractStream[(String,Long)]

resultDstream.filter(_._1).print()

env.execute()

}

3995

3995

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?