ElasticSearch可以说是当下最火爆的全文搜索引擎!开整!!

第一步,准备3台虚拟机,系统为CentOS 7,如下

| IP | 角色 |

|---|---|

| 172.16.31.191 | elasticsearch-1 |

| 172.16.31.192 | elasticsearch-2 |

| 172.16.31.193 | elasticsearch-3 |

第二步,在虚拟机上装好docker并启动(不会使用 docker 的话请先百度了解一下),3台虚拟机都要

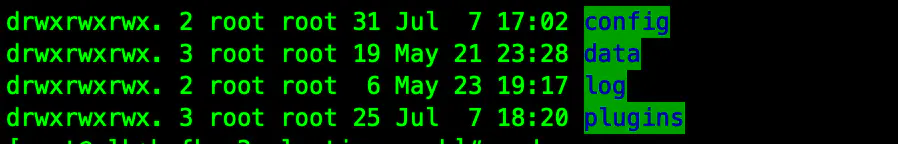

第三步,创建存储目录 /usr/local/docker/elasticsearch,3台虚拟机都要,如下

mkdir /usr/local/docker/elasticsearch

并创建相关挂载目录,3台虚拟机都要,如下

mkdir /usr/local/docker/elasticsearch/config

mkdir /usr/local/docker/elasticsearch/data

mkdir /usr/local/docker/elasticsearch/log

mkdir /usr/local/docker/elasticsearch/plugins

还要对文件夹加设置开放权限,如果不开放权限,则会报错无法写入数据的情况,3台虚拟机都要,如下

chmod 777 /usr/local/docker/elasticsearch/config

chmod 777 /usr/local/docker/elasticsearch/data

chmod 777 /usr/local/docker/elasticsearch/log

chmod 777 /usr/local/docker/elasticsearch/plugins

第四步,在 /usr/local/docker/elasticsearch/config 目录下新建 elasticsearch.yml 配置文件,3台虚拟机都要,如下

vim /usr/local/docker/elasticsearch/config/elasticsearch.yml

172.16.31.191

# 集群名称

cluster.name: elasticsearch-cluster

# 当前该节点的名称

node.name: node-1

# 是不是有资格竞选主节点

node.master: true

# 是否存储数据

node.data: true

# 最大集群节点数

node.max_local_storage_nodes: 3

# 给当前节点自定义属性(可以省略)

#node.attr.rack: r1

# 数据存档位置

path.data: /usr/share/elasticsearch/data

# 日志存放位置

path.logs: /usr/share/elasticsearch/log

# 是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

# 设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

# 然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 172.16.31.191

# 设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

# 如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 172.16.31.191

# 设置映射端口

http.port: 9200

# 内部节点之间沟通端口

transport.tcp.port: 9300

# 集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["172.16.31.191:9300","172.16.31.192:9300","172.16.31.193:9300"]

# 当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

# 其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

# 如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

# 在群集完全重新启动后阻止初始恢复,直到启动N个节点

# 简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

# 删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 加入跨域配置

http.cors.enabled: true

http.cors.allow-origin: "*"

172.16.31.192

# 集群名称

cluster.name: elasticsearch-cluster

# 当前该节点的名称

node.name: node-2

# 是不是有资格竞选主节点

node.master: true

# 是否存储数据

node.data: true

# 最大集群节点数

node.max_local_storage_nodes: 3

# 给当前节点自定义属性(可以省略)

#node.attr.rack: r1

# 数据存档位置

path.data: /usr/share/elasticsearch/data

# 日志存放位置

path.logs: /usr/share/elasticsearch/log

# 是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

# 设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

# 然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

# 设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

# 如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 172.16.31.192

# 设置映射端口

http.port: 9200

# 内部节点之间沟通端口

transport.tcp.port: 9300

# 集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

# es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["172.16.31.191:9300","172.16.31.192:9300","172.16.31.193:9300"]

# 当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

# 其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

# 如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

# 在群集完全重新启动后阻止初始恢复,直到启动N个节点

# 简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

# 删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 加入跨域配置

http.cors.enabled: true

http.cors.allow-origin: "*"

172.16.31.193

# 集群名称

cluster.name: elasticsearch-cluster

# 当前该节点的名称

node.name: node-3

# 是不是有资格竞选主节点

node.master: true

# 是否存储数据

node.data: true

# 最大集群节点数

node.max_local_storage_nodes: 3

# 给当前节点自定义属性(可以省略)

#node.attr.rack: r1

# 数据存档位置

path.data: /usr/share/elasticsearch/data

# 日志存放位置

path.logs: /usr/share/elasticsearch/log

# 是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

# 设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

# 然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

# 设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

# 如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 172.16.31.193

# 设置映射端口

http.port: 9200

# 内部节点之间沟通端口

transport.tcp.port: 9300

# 集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

# es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["172.16.31.191:9300","172.16.31.192:9300","172.16.31.193:9300"]

# 当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

# 其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

# 如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

# 在群集完全重新启动后阻止初始恢复,直到启动N个节点

# 简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

# 删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 加入跨域配置

http.cors.enabled: true

http.cors.allow-origin: "*"

第五步,docker方式启动 ElasticSearch,3台虚拟机都要,如下

172.16.31.191

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9200:9200 -p 9300:9300 -v /usr/local/docker/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /usr/local/docker/elasticsearch/plugins:/usr/share/elasticsearch/plugins -v /usr/local/docker/elasticsearch/data:/usr/share/elasticsearch/data -v /usr/local/docker/elasticsearch/log:/usr/share/elasticsearch/log --name elasticsearch-1 elasticsearch:7.7.0

172.16.31.192

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9200:9200 -p 9300:9300 -v /usr/local/docker/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /usr/local/docker/elasticsearch/plugins:/usr/share/elasticsearch/plugins -v /usr/local/docker/elasticsearch/data:/usr/share/elasticsearch/data -v /usr/local/docker/elasticsearch/log:/usr/share/elasticsearch/log --name elasticsearch-2 elasticsearch:7.7.0

172.16.31.193

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9200:9200 -p 9300:9300 -v /usr/local/docker/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /usr/local/docker/elasticsearch/plugins:/usr/share/elasticsearch/plugins -v /usr/local/docker/elasticsearch/data:/usr/share/elasticsearch/data -v /usr/local/docker/elasticsearch/log:/usr/share/elasticsearch/log --name elasticsearch-3 elasticsearch:7.7.0

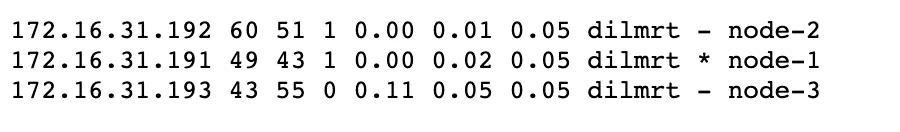

通过访问 172.16.31.191:9200/_cat/nodes?pretty 查看集群状态,如下则表示集群部署成功

注意,如果出现docker容器启动后自动崩溃的问题,其实主要的问题是分配给ES的内存太小了,通过以下方式解决

# 编辑 /etc/sysctl.conf 文件

vi /etc/sysctl.conf

# 添加 vm.max_map_count=262144 配置

vm.max_map_count=262144

# 保存后执行 sysctl -p

sysctl -p

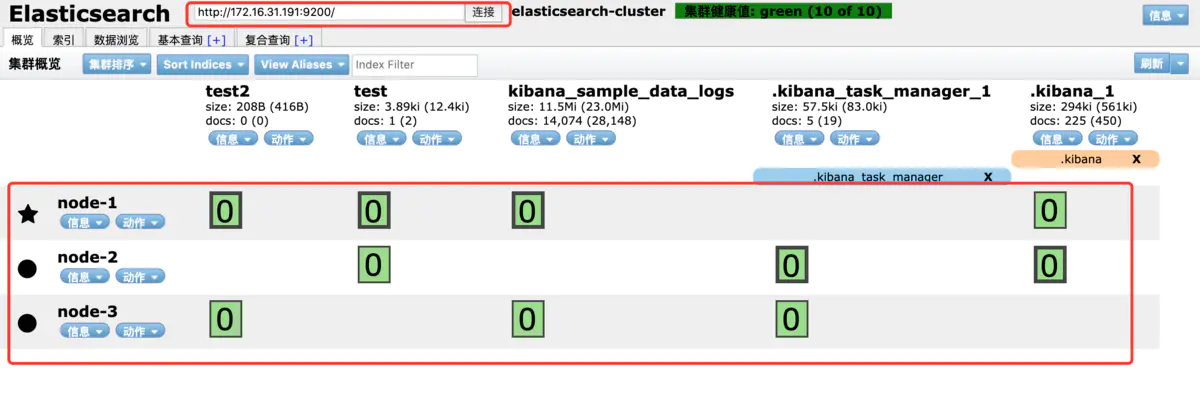

第六步,任选一台虚拟机使用docker方式配置 elasticsearch-head 插件,我选的是 172.16.31.191,如下

docker run -d --name elasticsearch-head -p 9100:9100 mobz/elasticsearch-head:5

通过访问 172.16.31.191:9100 查看,输入节点ip端口进行连接,如下则表示部署成功

注意

如果出现在 elasticsearch-head 数据浏览中查询不出数据的问题,通过修改容器里面的 vendor.js 配置文件解决,如下

- 因为docker容器里面无法使用vi/vim,所以需要先将文件拷贝出来

docker cp elasticsearch-head:/usr/src/app/_site/vendor.js ./

- 修改以下配置

vi vendor.js

共有两处:

1、6886行

contentType: “application/x-www-form-urlencoded”

改成

contentType: “application/json;charset=UTF-8”

2、7573行

var inspectData = s.contentType === “application/x-www-form-urlencoded” &&

改成

var inspectData = s.contentType === “application/json;charset=UTF-8” &&

- 将改完后的文件拷贝回容器

docker cp vendor.js elasticsearch-head:/usr/src/app/_site

无需重启,刷新页面即可

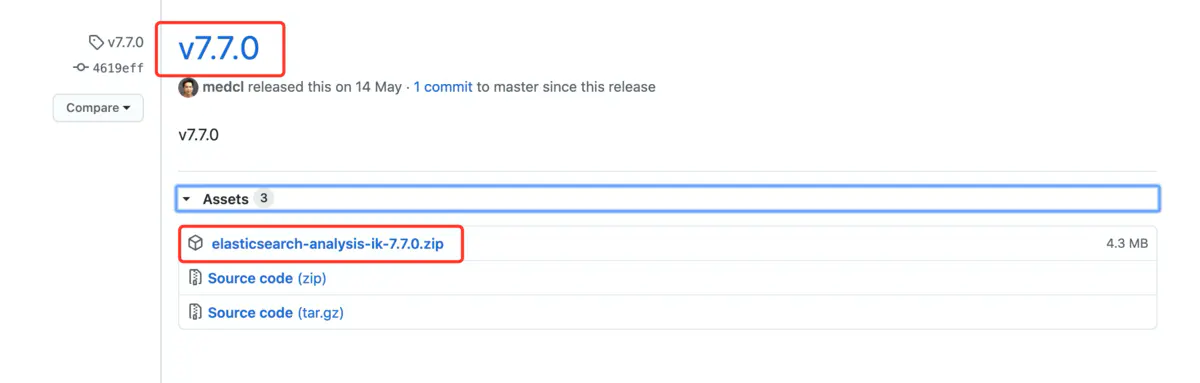

第七步,配置ik分词器,3台虚拟机都要

1、GitHub下载压缩包,注意选择的版本要跟 ElasticSearch 7.7.0 版本一致!选择 7.7.0 版本,如下

https://github.com/medcl/elasticsearch-analysis-ik/releases

2、将压缩包上传到 /usr/local/docker/elasticsearch/plugins 目录下,并进入该目录执行 unzip elasticsearch-analysis-ik-7.7.0.zip -d ik-analyzer 命令解压缩,注意!解压后要把 elasticsearch-analysis-ik-7.7.0.zip 删除掉

cd /usr/local/docker/elasticsearch/plugins

unzip elasticsearch-analysis-ik-7.7.0.zip -d ik-analyzer

3、重启 ElasticSearch 即可

172.16.31.191

docker restart elasticsearch-1

172.16.31.192

docker restart elasticsearch-2

172.16.31.193

docker restart elasticsearch-3

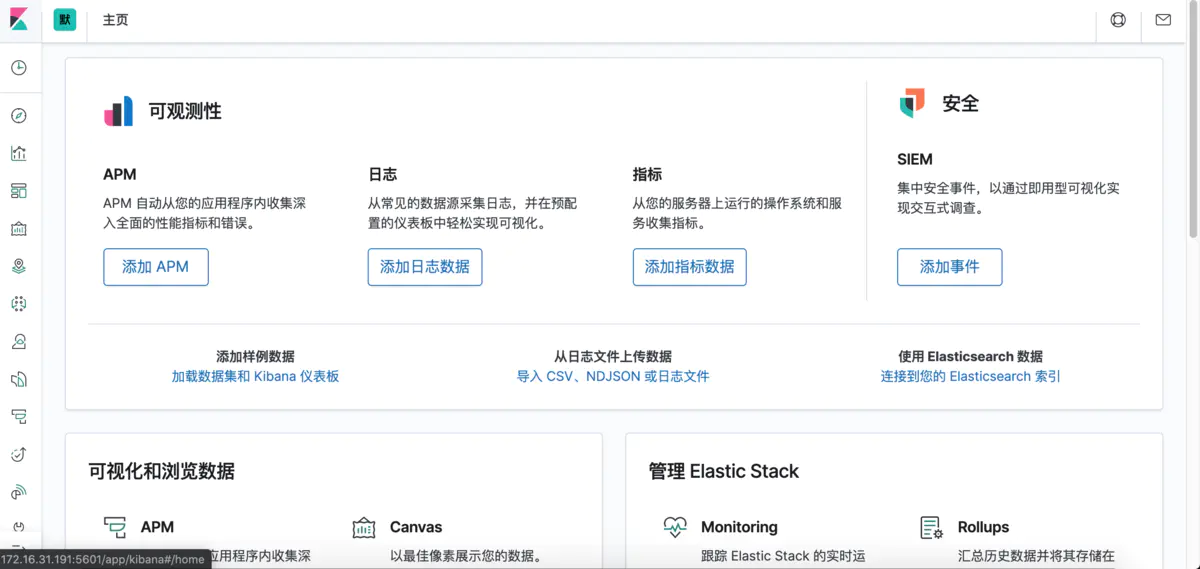

第八步,docker方式安装部署 Kibana 7.7.0(版本一定要跟ElasticSearch 7.7.0 一致),任选一台虚拟机使用docker方式配置 elasticsearch-head 插件,我选的是 172.16.31.191

- 创建存储目录 /usr/local/docker/kibana,如下

mkdir /usr/local/docker/kibana

并创建相关挂载目录,如下

mkdir /usr/local/docker/kibana/config

- 在 /usr/local/docker/kibana/config 目录创建 kibana.yml 配置文件,如下

vim /home/kibana/config/kibana.yml

kibana.yml

# kibana的映射端口

server.port: 5601

# 网关地址

server.host: "0.0.0.0"

# Kibana实例对外展示的名称

server.name: "kibana-172.16.31.191"

# ElasticSearch的集群地址,也就是说所有的集群IP

elasticsearch.hosts: ["http://172.16.31.191:9200","http://172.16.31.192:9200","http://172.16.31.193:9200"]

# 设置页面语言,中文使用zh-CN,英文使用en

i18n.locale: "zh-CN"

# 这个配置还没理解清楚………………

xpack.monitoring.ui.container.elasticsearch.enabled: true

- docker方式安装部署 Kibana 7.7.0,如下

docker run -d -p 5601:5601 -v /usr/local/docker/kibana/config/kibana.yml:/usr/share/kibana/config/kibana.yml --name kibana kibana:7.7.0

通过访问 172.16.31.191:5601 查看,如下则表示部署成功

第九步,通过Kibana可视化平台简单操作ElasticSearch集群,并使用ik分词器,如下

4042

4042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?