一、Apache Flume

1、概述

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的软件

Flume的核心把数据从数据源(Source)收集过来,再将收集到的数据送到指定的目的地(sink)。为了保证输送的过程一定成功,在数据送到目的地(sink)后,flume在删除主键缓存的数据。

2、运行机制

Flume系统中核心的角色是agent,agent本身是一个Java进程,一般运行在日志收集节点。

每一个agent相当于一个数据传递员,内部有三个组件:

Source:采集源,用于跟数据源对接,以获取数据;

Sink:下沉地,采集数据的传送目的,用于往下一级agent传递数据或者往

最终存储系统传递数据;

Channel:agent内部的数据传输通道,用于从source将数据传递到sink;

在整个数据的传输的过程中,流动的是event,它是Flume内部数据传输的最基本单元。event将传输的数据进行封装。如果是文本文件,通常是一行记录,event也是事务的基本单位。event从source,流向channel,再到sink,本身为一个字节数组,并可携带headers(头信息)信息。event代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

一个完整的event包括:event headers、event body、event信息,其中event信息就是flume收集到的日记记录。

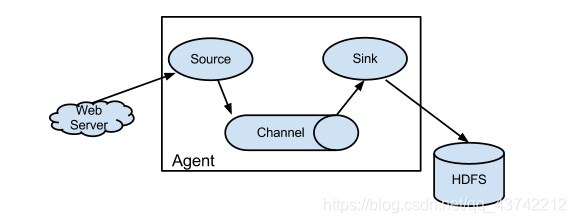

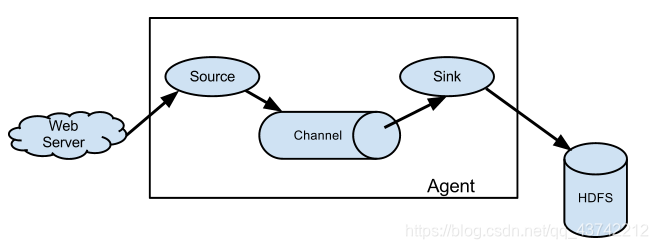

Flume采集系统结构图

1. 简单结构

单个agent采集数据

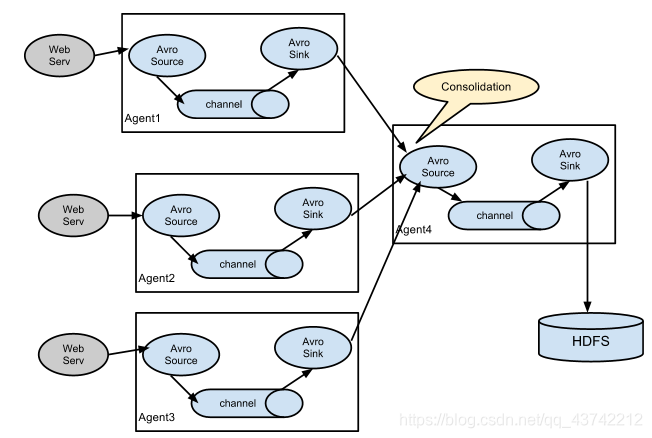

2、复杂结构

多级agent之间串联

二、安装Flume

第一步:上传压缩包并解压

tar -zxvf apache-flume-1.8.0-bin.tar.gz -C /export/servers

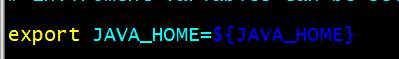

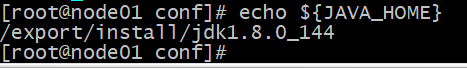

第二步:在配置文件里面添加JAVA_HOME的路径

进入到flume的conf

cd /export/servers/apache-flume-1.8.0-bin/conf

cp flume-env.sh.template flume-env.sh

vim flume-env.sh

export JAVA_HOME=${JAVA_HOME}

测试JAVA_HOME配置是否配置

echo ${JAVA_HOME}

第三步:新建文件 进行测试

1.

先在flume的conf目录下新建一个文件

vim netcat-logger.conf

# 定义这个agent中各组件的名字

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# 描述和配置source组件:r1

a1.sources.r1.type = netcat

a1.sources.r1.bind = 192.168.100.201

a1.sources.r1.port = 44444

# 描述和配置sink组件:k1

a1.sinks.k1.type = logger

# 描述和配置channel组件,此处使用是内存缓存的方式

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# 描述和配置source channel sink之间的连接关系

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

1、启动agent去采集数据

/export/servers/apache-flume-1.8.0-bin

bin/flume-ng agent -c conf -f conf/netcat-logger.conf -n a1

-Dflume.root.logger=INFO,console

-c conf 指定flume自身的配置文件所在目录

-f conf/netcat-logger.con 指定我们所描述的采集方案

-n a1 指定我们这个agent的名字3.安装文件并测试

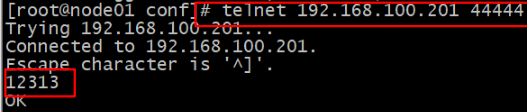

先要往agent采集监听的端口上发送数据,让agent有数据可采。

随便在一个能跟agent节点联网的机器上:

使用rpm -qa|grep telnet查telnet是否安装

如果没有安装

yum install telnet-server 安装telnet服务

yum install telnet.* 安装telnet客户端

检查memcached是否安装,且已开启memcached服务

rpm -qa memcached 有输出说明已安装

如果没有输出则没有安装

yum install memcached

telnet 192.168.100.201 44444

输入传输数据例如12313

2512

2512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?