在服务器上解压完成压缩包后进行环境配置

export FLINK_HOME=/opt/soft/flink

export PATH=$PATH:$FLINK_HOME/bin

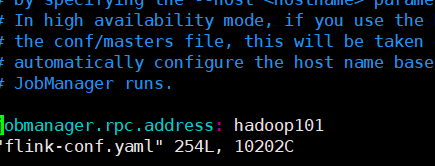

进入flink conf目录下修改flink-conf.yaml 的address 前面一定要有一个空格不然会报错。

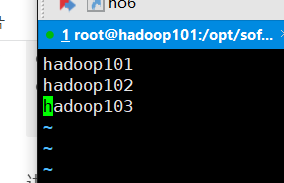

保存后去配置slaves

把flink和环境配置分发到另外两台服务器

启动flink集群

start-cluster.sh

通过端口号8081进入前端

http://192.168.10.101:8081/#/overview

运行测试案例

flink/examples/streaming 进入到案例目录

[root@hadoop101 streaming]#

2679

2679

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?