小罗碎碎念

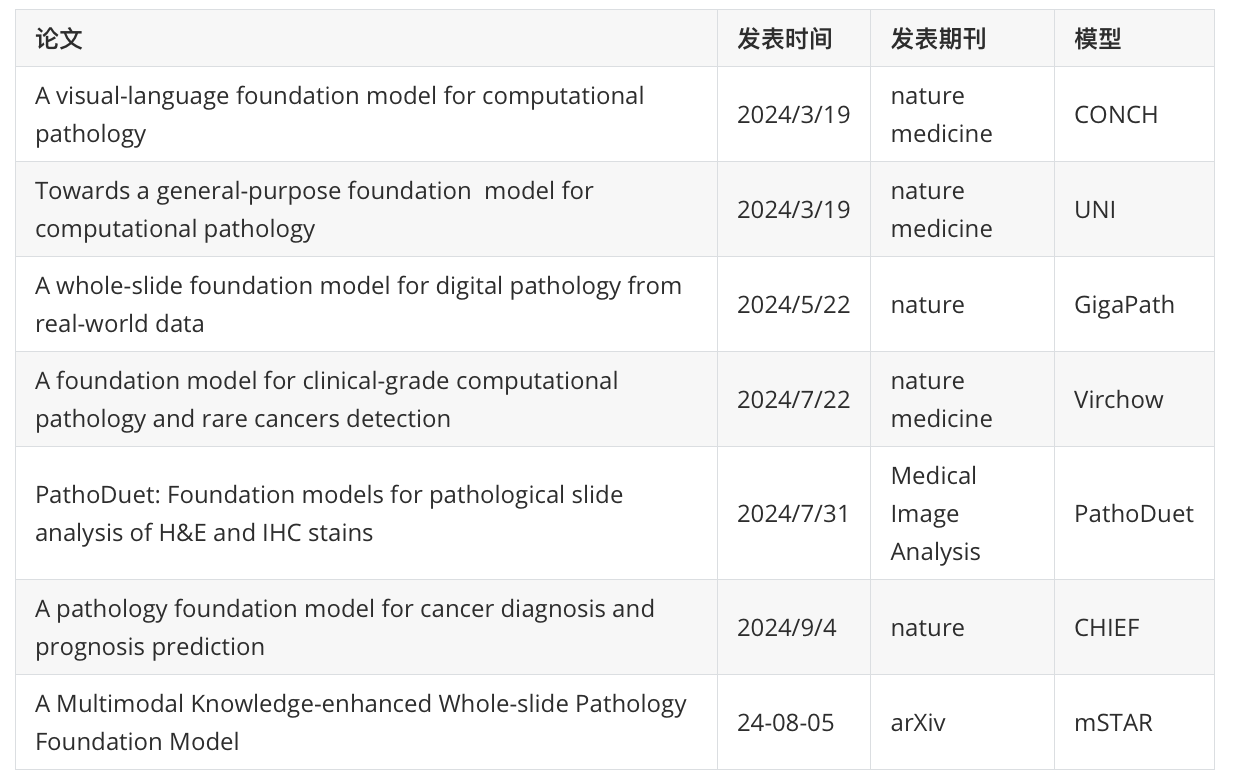

这期推文总结一下24年发表的与病理AI相关的基础模型。

本来这期推文只准备了6篇文献,但是昨天上午听完陈浩老师的报告以后,又多了一篇。

总共七篇文献,除了陈老师那篇还未开源(文章接收后才会公开),其余的文献都有公开的模型,所以我接下来就是分析每个模型的代码了。(希望不会拖得太久,哈哈)

一、CONCH:零样本学习在病理图像分析中的基础模型

| 作者类型 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Ming Y. Lu | 哈佛医学院布里格姆和妇女医院病理科,波士顿,马萨诸塞州,美国 |

| 第一作者 | Bowen Chen | 哈佛医学院布里格姆和妇女医院病理科,波士顿,马萨诸塞州,美国 |

| 第一作者 | Drew F. K. Williamson | 哈佛医学院布里格姆和妇女医院病理科,波士顿,马萨诸塞州,美国 |

| 通讯作者 | Faisal Mahmood | 哈佛医学院布里格姆和妇女医院病理科,波士顿,马萨诸塞州,美国 |

文献概述

这篇文章介绍了一种名为CONCH的视觉语言基础模型,通过对比学习从大量组织病理学图像和文本描述中进行预训练,实现了在多种病理学任务上的零样本学习和优异性能。

CONCH模型在14个不同的基准测试中进行了评估,包括图像分类、分割、描述和文本到图像及图像到文本的检索任务,均取得了最先进的性能。

CONCH模型的预训练使用了超过117万个图像-标题对,这些数据来自不同的组织病理学图像、生物医学文本等。在预训练过程中,模型通过对比学习目标和标题生成目标,将图像和文本模态在模型的表示空间中对齐。这使得CONCH在零样本(zero-shot)转移能力上表现出色,即在没有进一步的标记样本或微调的情况下,能够直接应用于不同的下游数据集。

文章还讨论了CONCH在罕见疾病分类、少量样本(few-shot)分类和跨模态检索方面的性能。在这些任务中,CONCH显示出了对其他视觉语言预训练模型的显著优势。此外,CONCH模型还能够在没有标记样本的情况下,对全切片图像(WSIs)进行粗粒度的组织分割。

尽管CONCH在多个任务上表现出色,但文章也指出,当前的视觉语言预训练模型在处理具有大量类别和罕见疾病的挑战性零样本问题时,性能仍有待提高。这表明在构建能够真正实现通用零样本识别或检索的基础模型方面,还有很长的路要走。

最后,文章讨论了CONCH模型的局限性,包括预训练数据的规模和质量,以及在不同数据队列中的稳健性。作者强调了继续研究和评估基础模型在计算病理学中的优势和局限性的重要性,并提供了模型的代码和权重,以便学术研究使用。

代码&数据

以下是文章中提到的所有代码链接和数据集,以及它们在文章中的作用:

| 代码/数据集 | 作用 |

|---|---|

| CONCH模型代码 | 用于访问和使用CONCH模型的预训练代码,以便研究人员可以复现和应用该模型进行研究 |

| Hugging Face模型库 | 提供了CONCH模型的预训练权重,供学术研究使用 |

| TCGA数据集 | 提供了用于训练和评估CONCH模型的全切片图像(WSIs)和标签数据 |

| DHMC LUAD数据集 | 提供了用于零样本分类的肺腺癌全切片图像数据 |

| SICAP数据集 | 提供了用于零样本分类和分割的前列腺癌全切片图像和组织学图像数据 |

| CRC100k数据集 | 提供了用于零样本分类的结直肠腺癌图像数据 |

| WSSS4LUAD数据集 | 提供了用于零样本分类的肺腺癌图像数据 |

| EBRAINS数据集 | 提供了用于分类罕见疾病的全切片图像数据 |

| AGGC和PANDA数据集 | 提供了用于前列腺癌Gleason分级的全切片图像数据 |

二、UNI:一种用于计算病理学的通用自监督基础模型

| 作者类型 | 姓名 | 单位(英文) | 单位(中文) |

|---|---|---|---|

| 第一作者 | Richard J. Chen | Department of Pathology, Brigham and Women’s Hospital, Harvard Medical School, Boston, MA, USA | 哈佛医学院附属布莱根妇女医院病理科,马萨诸塞州波士顿,美国 |

| 第一作者 | Tong Ding | Department of Pathology, Massachusetts General Hospital, Harvard Medical School, Boston, MA, USA | 哈佛医学院附属麻省总医院病理科,马萨诸塞州波士顿,美国 |

| 第一作者 | Ming Y. Lu | Cancer Data Science Program, Dana-Farber Cancer Institute, Boston, MA, USA | 达纳-法伯癌症研究所癌症数据科学项目,马萨诸塞州波士顿,美国 |

| 通讯作者 | Faisal Mahmood | Department of Pathology, Brigham and Women’s Hospital, Harvard Medical School, Boston, MA, USA | 哈佛医学院附属布莱根妇女医院病理科,马萨诸塞州波士顿,美国 |

文献概述

这篇文章介绍了一个名为UNI的新型自监督通用模型,它在计算病理学任务中通过在大规模组织图像上预训练,展现出了卓越的性能和泛化能力。

UNI通过在超过10万张诊断性的苏木精-伊红(H&E)染色的全切片图像(WSIs)上预训练,这些图像涵盖了20种主要组织类型,数据量超过77TB。

研究者们对UNI在34个具有代表性的CPath任务上进行了评估,这些任务的诊断难度各不相同。UNI不仅超越了之前的最先进模型,还展示了在CPath中新的建模能力,例如分辨率无关的组织分类、使用少量样本原型的切片分类,以及在OncoTree分类系统中对多达108种癌症类型的疾病亚型泛化分类。

文章强调了病理学临床实践的多样性,包括肿瘤检测、亚型分类、分级和分期等任务。由于获取病理学家注释和构建大型组织学收藏的挑战,从头开始训练模型存在实际限制。因此,研究者们提出了转移学习技术,这在CPath中的多项任务中已被证明是有效的。然而,当前CPath中的预训练模型受到预训练数据规模和多样性的限制,并且对不同组织类型的泛化性能评估也有限。

为了解决这些限制,研究者们引入了一个通用的、自监督的视觉编码器UNI,它在名为“Mass-100K”的最大组织切片集合上进行了预训练。这个数据集包含了超过100万个组织补丁,这些补丁来自麻省总医院(MGH)和布莱根妇女医院(BWH)以及基因型-组织表达(GTEx)联盟收集的100,426张诊断性H&E WSIs。在预训练阶段,研究者们使用了一种名为DINOv2的自监督学习方法,该方法已被证明能够在不需要进一步微调标记数据的情况下,为下游任务提供强大的、现成的表示。

研究者们在多种机器学习设置中评估了UNI的多功能性,包括ROI级别的分类、分割和图像检索,以及切片级别的弱监督学习。UNI在34个临床任务中的表现超越了以前的先进模型,如CTransPath和REMEDIS。此外,UNI还展示了在高分辨率图像上的鲁棒性,以及在少量样本学习(few-shot learning)中的标签效率。

文章还讨论了UNI在不同图像分辨率下的鲁棒性,以及在SegPath数据集上对主要细胞类型进行分割的能力。此外,研究者们还评估了UNI在少量样本设置下的ROI和切片分类性能,展示了其作为CPath中稀有和代表性不足疾病筛查工作流程的基础模型的潜力。

最后,文章讨论了UNI作为CPath中通用AI模型的潜力,以及它如何促进创新的临床应用,这些应用通常需要更多的数据。研究者们指出,UNI的预训练编码器的质量优于任务特定的模型开发,这可能会将CPath的研究方向转移到开发具有更高性能和灵活性的通用AI模型上,以针对病理学中的多样化临床应用。

尽管UNI基于ViT-L架构,可能缺乏解决CPath中密集预测任务的视觉特定偏见,但研究者们认为,随着更好的方法的出现,ViT架构的适应性可能会进一步提高。

代码&数据

代码链接

- DINOv2 self-supervised learning algorithm: https://github.com/facebookresearch/dinov2

- 作用:用于大规模视觉预训练,是训练UNI模型的关键算法。

- Timm library: https://huggingface.co

- 作用:提供了视觉transformer的实现,用于构建UNI模型的编码器骨干网络。

- LGSSL codebase: https://github.com/mbanani/lgssl

- 作用:提供了SimpleShot实现,用于few-shot学习评估。

- CLAM codebase: https://github.com/mahmoodlab/CLAM

- 作用:用于WSI(全切片图像)处理和训练弱监督ABMIL模型。

- Mask2Former implementation: https://github.com/facebookresearch/Mask2Former

- 作用:用于语义分割任务,基于detectron2框架。

- ViT-Adapter: https://github.com/czczup/ViT-Adapter

- 作用:用于改进UNI模型,以进行更精确的细胞类型分割。

- HIPT codebase: https://github.com/mahmoodlab/HIPT

- 作用:提供多头自注意力(MHSA)可视化工具。

数据集

- The Cancer Genome Atlas (TCGA): https://portal.gdc.cancer.gov

- 作用:提供了大量的癌症组织切片图像和标签,用于模型预训练和评估。

- Genotype-Tissue Expression (GTEx) project: https://www.gtexportal.org

- 作用:提供了非癌症的人体尸检WSIs,用于扩展预训练数据集的多样性。

- CAMELYON16: https://doi.org/10.6084/m9.figshare.c.5927795.v1

- 作用:用于评估模型在淋巴结转移检测任务上的性能。

- CPTAC: https://proteomic.datacommons.cancer.gov

- 作用:提供了用于评估模型在不同癌症亚型分类任务上的性能的外部测试集。

- CRC-100K: https://zenodo.org/record/1214456

- 作用:用于评估模型在结直肠组织分类任务上的性能。

- HunCRC: https://doi.org/10.7937/tcia.9cjf-0127

- 作用:用于评估模型在结直肠癌筛查任务上的性能。

- BACH: https://iciar2018-challenge.grand-challenge.org/Dataset/

- 作用:用于评估模型在乳腺癌亚型分类任务上的性能。

- BRACS: https://www.bracs.icar.cnr.it

- 作用:用于评估模型在乳腺癌亚型分类任务上的性能。

- PANDA: https://panda.grand-challenge.org

- 作用:用于评估模型在前列腺癌ISUP分级任务上的性能。

- SegPath: https://zenodo.org/record/7412731

- 作用:用于评估模型在细胞类型分割任务上的性能。

三、Prov-GigaPath:基于大规模真实数据的数字病理基础模型

| 作者角色 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Hanwen Xu | 微软研究院,雷德蒙德,华盛顿州,美国 |

| 第一作者 | Naoto Usuyama | 华盛顿大学保罗G.艾伦计算机科学与工程学院,西雅图,华盛顿州,美国 |

| 通讯作者 | Carlo Bifulco | Providence Genomics,波特兰,俄勒冈州,美国 |

| 通讯作者 | Sheng Wang | 华盛顿大学保罗G.艾伦计算机科学与工程学院,西雅图,华盛顿州,美国 |

| 通讯作者 | Hoifung Poon | 微软研究院,雷德蒙德,华盛顿州,美国 |

文献概述

这篇文章介绍了一种名为Prov-GigaPath的新型数字病理基础模型,它利用大规模真实世界数据预训练,显著提高了病理图像分析的准确性和效率。

Prov-GigaPath模型在预训练阶段使用了171,189张完整切片中的1.3亿个256×256病理图像瓦片,这些切片涵盖了超过30,000名患者的31种主要组织类型。为了处理这些大规模数据,研究者提出了GigaPath,这是一种新的视觉变换器架构,它通过适应LongNet方法来实现切片级别学习。

Prov-GigaPath在26项任务中的25项上达到了最先进的性能,这些任务包括9种癌症亚型任务和17项病理组学任务。该模型在18项任务上显著优于第二好的方法。此外,研究者还展示了Prov-GigaPath在病理报告的视觉-语言预训练方面的潜力,通过结合病理报告,该模型在多种临床应用中显示出了对真实世界数据和全切片建模的重要性。

文章还讨论了Prov-GigaPath在突变预测和癌症亚型分类方面的性能提升,以及在多模态视觉-语言处理方面的应用。通过使用与每个切片相关联的病理报告,Prov-GigaPath在零样本癌症亚型分类和突变预测方面表现出色。

最后,文章讨论了Prov-GigaPath的潜力,以及如何通过使用更大的预训练数据集和模型来进一步提高模型性能。研究者还提供了模型的代码和预训练模型权重,以便其他研究人员可以使用和复制Prov-GigaPath。

代码&数据

| 链接类型 | 链接地址 | 作用描述 |

|---|---|---|

| 代码链接 | DINOv2 | 用于预训练视觉变换器模型的ViT瓦片编码器。 |

| 代码链接 | OpenCLIP | 用于训练视觉-语言对齐模型。 |

| 代码链接 | torchscale | 用于实现LongNet模型的并行处理。 |

| 数据集 | TCGA WSIs | 用于模型的微调和测试,包含全切片图像和标签。 |

| 数据集 | Prov-Path Sample Data 1 | 提供给研究人员使用模型的去标识化数据子集。 |

| 数据集 | Prov-Path Sample Data 2 | 提供给研究人员使用模型的去标识化数据子集。 |

四、Virchow:助力罕见癌症检测的病理基础模型

| 作者角色 | 作者姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Eugene Vorontsov | 纽约,美国,Paige公司 |

| 第一作者 | Alican Bozkurt | 纽约,美国,Paige公司 |

| 第一作者 | Adam Casson | 纽约,美国,Paige公司 |

| 第一作者 | George Shaikovski | 纽约,美国,Paige公司 |

| 第一作者 | Michal Zelechowski | 纽约,美国,Paige公司 |

| 第一作者 | Kristen Severson | 纽约,美国,Paige公司 |

| 通讯作者 | Siqi Liu | 纽约,美国,Paige公司 |

| 通讯作者 | Thomas J. Fuchs | 纽约,美国,纪念斯隆凯特琳癌症中心(MSKCC) |

文献概述

这篇文章介绍了Virchow,一个基于人工智能的计算病理学基础模型,它能够通过分析数字化病理切片图像来检测常见和罕见癌症,具有提高诊断准确性和减少对昂贵测试依赖的潜力。

Virchow是迄今为止最大的计算病理学基础模型,它通过深度学习和自监督学习算法处理大量的病理图像数据。这项研究的主要目标是提高对罕见癌症的检测能力,并减少对特定和昂贵的免疫组化(IHC)或基因组测试的依赖。

研究者们使用来自纪念斯隆凯特琳癌症中心(MSKCC)的约100,000名患者的数据,训练了Virchow模型,该数据集包含约150万张H&E染色的病理切片图像。Virchow模型在预测生物标志物和识别细胞方面表现出色,并且在泛癌检测方面,它在九种常见和七种罕见癌症中实现了0.95的标本级下接收者操作特征曲线(AUC)。

文章强调了基础模型的价值,并展示了在标记训练数据有限的情况下,Virchow模型在多种高影响应用中的潜力。研究还比较了Virchow模型与现有的临床级AI产品的性能,发现Virchow在某些罕见癌症变体的检测上超过了这些产品。此外,研究还探讨了Virchow模型在预测常规H&E染色图像中的生物标志物状态方面的潜力,这可能减少对额外测试的需要,并加快为患者提供数据以做出更明智的治疗决策。

文章还讨论了Virchow模型的泛化能力,即它对训练数据中未观察到的组织类型或来自不同机构的切片的检测能力。研究表明,Virchow模型在这些情况下仍然能够保持良好的性能。此外,文章还提到了Virchow模型在临床应用中的潜在价值,包括提高诊断速度、减少侵入性测试和提高治疗决策的数据可用性。

尽管Virchow模型展示了显著的潜力,但文章也指出了其发展的一些局限性,包括训练数据的来源单一、模型和数据规模的饱和点未知以及对硬件部署的考虑。作者提出,进一步的研究可能会揭示改进这些设计选择以提高病理学领域性能的方法。

代码&数据

| 链接类型 | 链接地址 | 作用描述 |

|---|---|---|

| 代码链接 | DINO v.2模型架构 | 用于自监督预训练的模型架构,Virchow模型的训练基础 |

| 代码链接 | PyTorch Lightning训练框架 | 用于模型训练和推理的框架 |

| 代码链接 | torch库 | 用于训练和推理的基础库 |

| 数据集 | CRC数据集 | 用于训练和测试Virchow模型的病理图像数据集 |

| 数据集 | WILDS数据集 | 用于测试模型的泛化能力 |

| 数据集 | PCam数据集 | 用于测试模型的病理图像数据集 |

| 数据集 | MHIST数据集 | 用于测试模型的病理图像数据集 |

| 数据集 | TCGA TIL数据集 | 用于测试模型的病理图像数据集 |

| 数据集 | MIDOG数据集 | 用于测试模型的病理图像数据集 |

| 数据集 | TCGA CRC-MSI数据集 | 用于测试模型的病理图像数据集 |

五、PathoDuet:面向H&E和IHC的基础模型

| 角色 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Shengyi Hua | 上海交通大学清源研究院 |

| 通讯作者 | Xiaofan Zhang | 上海交通大学清源研究院,上海人工智能实验室 |

文献概述

这篇文章介绍了一个名为PathoDuet的新自监督学习框架,旨在改善病理图像分析,特别是针对苏木精-伊红(H&E)和免疫组化(IHC)染色的病理切片。

PathoDuet通过引入一个预文本令牌(pretext token)和任务提升器(task raiser)来增强模型对病理图像的理解。文章提出了两个预文本任务:跨尺度定位(cross-scale positioning)和跨染色转移(cross-stain transferring),以提高模型对不同放大倍数下H&E图像的理解,并将H&E模型的知识迁移到IHC图像上。

研究者们使用大型公共H&E数据集来开发H&E模型,并使用自适应实例归一化(AdaIN)来将H&E模型迁移到IHC图像上。为了验证模型的有效性,研究者们在多种下游任务上评估了模型的性能,包括H&E图像上的结直肠癌细胞亚型分类、整个切片图像(WSI)级别分类,以及IHC图像上的标记表达水平预测、肿瘤识别和切片级别定性分析。实验结果表明,PathoDuet在大多数任务上都优于现有的模型。

文章还讨论了PathoDuet与大型病理模型的比较,强调了数据量和为病理图像量身定制的自监督学习方法的重要性。最后,文章总结了PathoDuet的贡献,并提出了未来的研究方向,包括收集更多数据来迭代和升级模型。

代码&数据

代码链接:

- 链接:https://github.com/openmedlab/PathoDuet

- 作用:这个GitHub链接提供了PathoDuet模型的代码和预训练模型,供研究者和开发者下载和使用。

数据集

- 数据集名称:The Cancer Genome Atlas (TCGA)

- 作用:TCGA是一个大型的公共数据库,包含了多种癌症的基因组、表观基因组、转录组和图像数据。在这篇文章中,研究者从TCGA收集了约30,000个WSIs(整个切片图像),并选择了约11,000个诊断性的甲醛固定石蜡包埋(FFPE)WSIs用于H&E模型的训练。此外,还使用了HyReCo和BCI数据集来训练和评估跨染色转移任务。这些数据集为模型提供了大量的病理图像数据,用于模型的预训练和下游任务的评估。

六、CHIEF:支持癌症诊断和预后预测的基础模型

| 作者类型 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Xiyue Wang | 哈佛 |

| 第一作者 | Junhan Zhao | 斯坦福大学 |

| 通讯作者 | Sen Yang | 斯坦福大学 |

| 通讯作者 | Kun-Hsing Yu | 哈佛 |

文献概述

这篇文章介绍了一种名为Clinical Histopathology Imaging Evaluation Foundation (CHIEF)的新型机器学习框架,它用于病理图像的分析,以支持癌症诊断和预后预测。

CHIEF模型通过弱监督预训练方法,从大量的病理图像中提取特征,这些图像涵盖了19个解剖部位的60,530张全切片图像。该模型在癌症细胞检测、肿瘤起源识别、分子档案表征和生存预测等方面表现出色,并且在国际24家医院和队列的19,491张全切片图像上进行了验证,显示出比现有深度学习方法高达36.1%的优越性能。

CHIEF模型的开发利用了无监督预训练和弱监督预训练两种方法,以提取多样化的病理表示。它在癌症检测任务中,通过在15个独立数据集上进行广泛的外部验证,显示出对多种癌症的泛化能力。在肿瘤起源预测方面,CHIEF能够预测癌症样本的组织起源,并在CPTAC的独立测试集上进行了验证。此外,CHIEF还能够预测癌症样本的基因组档案,包括预测普遍存在的基因突变、与靶向治疗相关的基因突变、IDH状态和MSI状态。

在生存预测方面,CHIEF通过分析初始诊断时获得的病理图像,成功预测了患者的长期和短期生存结果。在所有癌症类型和研究队列中,CHIEF能够区分不同生存结果的患者,并且与现有方法相比,CHIEF在独立队列中的表现更为出色。

总体而言,CHIEF是一个通用的、适用于多种癌症类型的病理评估的基础模型。它在多个临床应用中展示了泛化能力,并且能够从WSI中提取详细的定量特征,为病理模式、分子异常和重要临床结果之间的关系提供了系统性分析。CHIEF的准确、稳健和快速病理样本评估将有助于发展个性化癌症管理。

代码&数据

| 代码链接或数据集名称 | 作用描述 |

|---|---|

| TCGA | 提供了用于模型预训练的病理图像数据集,包括多种癌症类型的全切片图像 (WSIs) |

| GTEx | 提供了基因型-组织表达项目数据,用于模型预训练 |

| PAIP | 提供了用于前列腺癌分级评估的病理图像数据集,用于模型预训练 |

| PANDA | 提供了前列腺癌组织学图像数据集,用于模型预训练 |

| BCC | 提供了基底细胞癌图像数据集,用于模型预训练 |

| ACROBAT | 提供了乳腺癌组织图像数据集,用于模型预训练 |

| BCNB | 提供了早期乳腺癌淋巴结转移预测的病理图像数据集,用于模型预训练 |

| TOC | 提供了卵巢癌治疗效果评估的病理图像数据集,用于模型预训练 |

| CPTAC | 提供了多种癌症类型的病理图像数据集,用于模型预训练和验证 |

| DROID-Breast | 提供了乳腺癌图像数据集,用于模型验证 |

| Dataset-PT | 提供了病理图像数据集,用于模型验证 |

| Diagset-B | 提供了前列腺癌病理图像数据集,用于模型验证 |

| MUV | 提供了用于模型验证的病理图像数据集 |

| PLCO | 提供了用于模型验证的病理图像数据集 |

| PAIP2020 | 提供了用于模型验证的病理图像数据集 |

| TissueNet | 提供了用于模型验证的宫颈活检图像数据集 |

| CHIEF代码仓库 | 提供了CHIEF模型的源代码,用于实现和验证研究中描述的方法和结果 |

七、mSTAR:整合病理、文本以及测序数据的多模态基础模型

| 角色 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Yingxue Xu | 香港科技大学 |

| 第一作者 | Yihui Wang | 香港科技大学 |

| 通讯作者 | Hao Chen | 香港科技大学 |

文献概述

这篇文章介绍了mSTAR,一个多模态知识增强型全切片病理基础模型,它通过整合病理图像、报告和基因表达数据,显著提高了病理诊断和分析的性能。

该模型由香港科技大学、香港中文大学、威尔士亲王医院、南方医科大学等机构的研究人员共同开发,旨在通过整合H&E染色的全切片图像(WSIs)、病理报告和RNA测序数据,提高病理学中的计算机辅助诊断和分析性能。

mSTAR模型的核心在于其创新的全切片预训练范式,该范式通过在全切片层面注入多模态知识,使病理基础模型能够获取更广泛的上下文信息。这包括两个阶段:第一阶段是切片层面的对比学习,第二阶段是通过自学习训练将多模态知识传授给局部区域提取器。

研究者们创建了一个包含26,169个切片级模态对的数据集,涵盖了10,275名患者的32种癌症类型。这些数据来源于癌症基因组图谱(TCGA)。mSTAR模型在43个子任务上的7种不同类型任务上进行了广泛的实验,结果显示其在不同类型任务中的平均性能显著优于其他现有的基础模型。

mSTAR模型在多模态任务中表现出色,特别是在整合多模态知识后,其在分子预测方面的能力得到了显著提升。此外,该模型还展示了在低样本情况下的泛化能力,以及在零样本和少样本分类任务中的应用潜力。

文章还讨论了mSTAR模型在病理报告生成方面的性能,强调了其在预训练过程中整合的多模态数据如何有助于生成更准确和全面的病理报告。尽管mSTAR模型在多模态能力方面取得了显著进展,但文章也指出了其在数据规模和端到端基础模型方面的局限性,并提出了未来可能的改进方向。

总的来说,mSTAR模型通过其创新的预训练方法和多模态数据整合,为病理学中的计算机辅助诊断和分析提供了一个强大的基础模型,有潜力改善临床实践。

代码&数据

以下是文章中提到的所有代码链接和数据集,以及它们在文章中的作用:

| 代码链接或数据集名称 | 作用描述 |

|---|---|

| mSTAR代码链接 | 文章接收以后才会开源 |

| CLAM代码链接 | 用于作为基线模型,比较不同模型在病理图像分析上的性能。 |

| PLIP代码链接 | 一个视觉-语言架构,用于病理图像分析的预训练模型。 |

| CONCH代码链接 | 一个视觉-语言CoCa框架,用于病理图像分析的预训练模型。 |

| UNI代码链接 | 一个纯视觉的病理图像块提取器,用于病理图像分析的预训练模型。 |

| TransMIL代码链接 | 用于作为“教师”模型,通过自学习训练将多模态知识传授给“学生”模型。 |

| MCAT代码链接 | 用于多模态生存分析的融合模型。 |

| Porpoise代码链接 | 用于多模态生存分析的融合模型。 |

| MOTCat代码链接 | 用于多模态生存分析的融合模型。 |

| CMTA代码链接 | 用于多模态生存分析的融合模型。 |

| HistGen代码链接 | 用于病理报告生成任务的模型。 |

| TCGA数据集 | 提供了用于预训练和评估的病理图像、病理报告和RNA测序数据。 |

| cBioPortal RNASeq数据 | 提供了用于预训练和评估的RNA测序数据。 |

| Camelyon16&17数据集 | 用于乳腺癌转移检测的病理图像数据集。 |

| PANDA数据集 | 用于前列腺癌Gleason分级的病理图像数据集。 |

| UBCOCEAN数据集 | 用于卵巢癌亚型分类的病理图像数据集。 |

| BCNB数据集 | 用于乳腺癌ER、PR和HER2预测的病理图像数据集。 |

| RCC-DHMC数据集 | 用于肾癌亚型分类的病理图像数据集。 |

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?