在使用word2vec时涉及gensim.utils.simple_preprocess(),用于将句子分割为单词列表,效果等同于

sen = "my daddy is a ab good man man"

sp= gensim.utils.simple_preprocess(sen)

print(sentence,type(sp))

print(list(sen.split()))

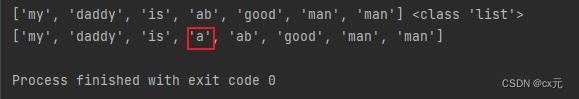

结果如下:

两者不同之处在于,simple_preprocess自动过滤了单词长度小于2的词汇。

316

316

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?