简介

简单是说: 在距离空间里,如果一个样本的最接近的k个邻居里,绝大多数属于某个类别,则该样本也属于这个类别。

API官网链接

api

class sklearn.neighbors.KNeighborsClassifier(n_neighbors=5, *, weights='uniform', algorithm='auto', leaf_size=30, p=2, metric='minkowski', metric_params=None, n_jobs=None)

参数说明:

n_neighbors – 选定参考几个邻居默认= 5

algorithm:{‘auto’,‘ball_tree’,‘kd_tree’,‘brute’}

- 快速k近邻搜索算法,默认参数为auto,可以理解为算法自己决定合适的搜索算法。除此之外,用户也可以自己指定搜索算法ball_tree、kd_tree、brute方法进行搜索,

- brute是蛮力搜索,也就是线性扫描,当训练集很大时,计算非常耗时。

- kd_tree,构造kd树存储数据以便对其进行快速检索的树形数据结构,kd树也就是数据结构中的二叉树。以中值切分构造的树,每个结点是一个超矩形,在维数小于20时效率高。

- ball tree是为了克服kd树高纬失效而发明的,其构造过程是以质心C和半径r分割样本空间,每个节点是一个超球体。

leaf_size:可选参数(默认为 30),这个是构造树的大小,值一般选取默认值即可,太大会影响速度。

n_jobs :默认值1,选取-1占据CPU比重会减小,但运行速度也会变慢,所有的core都会运行。

P : 距离参数(默认为 2)

P是有“明科夫斯基距离”得来的

只有当KNN算法考虑距离权重超参数(weights)时,才会考虑是否输入距离参数(P)

K值选择

K值过小:

容易受到异常点的影响

过拟合

模型过于复杂

k值过大:

受到样本均衡的问题

欠拟合

模型过于简单

kd树

根据KNN每次需要预测一个点时,我们都需要计算训练数据集里每个点到这个点的距离,然后选出距离最近的k个点进行投票。当数据集很大时,这个计算成本非常高,针对N个样本,D个特征的数据集,其算法复杂度为O(DN^2)。

kd树:为了避免每次都重新计算一遍距离,算法会把距离信息保存在一棵树里,这样在计算之前从树里查询距离信息,尽量避免重新计算。其基本原理是,如果A和B距离很远,B和C距离很近,那么A和C的距离也很远。有了这个信息,就可以在合适的时候跳过距离远的点。

这样优化后的算法复杂度可降低到O(DNlog(N))。感兴趣的读者可参阅论文:Bentley,J.L.,Communications of the ACM(1975)。

1989年,另外一种称为Ball Tree的算法,在kd Tree的基础上对性能进一步进行了优化。感兴趣的读者可以搜索Five balltree construction algorithms来了解详细的算法信息。

(1)选择向量的那一维进行划分;

(2)如何划分数据;

第一个问题简单的解决方法可以是随机选择某一维或按顺序选择,但是更好的方法应该是在数据比较分散的那一维进行划分(分散的程度可以根据方差来衡量)。好的划分方法可以使构建的树比较平衡,可以每次选择中位数来进行划分,这样问题2也得到了解决。

案例分析

给定一个二维空间数据集:T={(2,3),(5,4),(9,6),(4,7),(8,1),(7,2)},构造一个平衡kd树。

第一次:

x轴–2,5,9,4,8,7–>2,4,5,7,8,9

y轴–3,4,6,7,1,2–>1,2,3,4,6,7

x轴数据较分散,先选择x轴,找中间点,发现是(7,2)

第二次:

左面:(2,3),(4,7),(5,4)–>3,4,7

右面:(8,1),(9,6)–>1,6

从y轴开始选择,左边选择点是(5,4),右边选择点(9,6)–右边只有2个数,中间数可任选一个

第三次:

从x轴开始选择

在上述数据集中查找点(2.1,3.1)与哪个点最近

按第一次比较x轴大小,第二次比较y轴大小,第三次x轴的上述遍历方法。

在(7,2)点测试到达(5,4),在(5,4)点测试到达(2,3),然后search_path中的结点为<(7,2),(5,4), (2,3)>,从search_path中取出(2,3)作为当前最佳结点nearest, dist为0.141;

然后回溯至(5,4),以(2.1,3.1)为圆心,以dist=0.141为半径画一个圆,并不和超平面y=4相交,如上图,所以不必跳到结点(5,4)的右子空间去搜索,因为右子空间中不可能有更近样本点了。

于是再回溯至(7,2),同理,以(2.1,3.1)为圆心,以dist=0.141为半径画一个圆并不和超平面x=7相交,所以也不用跳到结点(7,2)的右子空间去搜索。

至此,search_path为空,结束整个搜索,返回nearest(2,3)作为(2.1,3.1)的最近邻点,最近距离为0.141。

同样在上述数据集中查找点(2,4.5)与哪个点最近

在(7,2)处测试到达(5,4),在(5,4)处测试到达(4,7)【优先选择在本域搜索】,然后search_path中的结点为<(7,2),(5,4), (4,7)>,从search_path中取出(4,7)作为当前最佳结点nearest, dist为3.202;

然后回溯至(5,4),以(2,4.5)为圆心,以dist=3.202为半径画一个圆与超平面y=4相交,所以需要跳到(5,4)的左子空间去搜索。所以要将(2,3)加入到search_path中,现在search_path中的结点为<(7,2),(2, 3)>;另外,(5,4)与(2,4.5)的距离为3.04 < dist = 3.202,所以将(5,4)赋给nearest,并且dist=3.04。

回溯至(2,3),(2,3)是叶子节点,直接平判断(2,3)是否离(2,4.5)更近,计算得到距离为1.5,所以nearest更新为(2,3),dist更新为(1.5)

回溯至(7,2),同理,以(2,4.5)为圆心,以dist=1.5为半径画一个圆并不和超平面x=7相交, 所以不用跳到结点(7,2)的右子空间去搜索。

至此,search_path为空,结束整个搜索,返回nearest(2,3)作为(2,4.5)的最近邻点,最近距离为1.5。

优缺点

优点:

1.简单有效(天然可以解决多分类问题,也可以解决回归问题)

2.重新训练代价底

3.适合类域交叉样本

4.适合大样本自动分类

缺点:

1.惰性学习

2.类别评分不是规格化

3.输出可解释性不强

4.对不均衡的样本不擅长

样本不均衡:收集到的数据每个类别占比严重失衡

5.计算量较大

k-近邻算法是分类数据最简单最有效的算法,使用算法时我们必须有接近实际数据的训练样本数据,k-近邻算法必须保存全部的数据集,如果训练数据集的很大,必须使用大量的存储空间。此外,由于必须对数据集中的每个数据计算距离值,实际使用时可能非常耗时。

k-近邻算法的另一个缺陷是它无法给出任何数据的基础结构信息,因此我们也无法知晓平均实例样本和典型实例样本具有什么特征。

示例

鸢尾花种类预测/电影分类

#鸢尾花种类预测

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.neighbors import KNeighborsClassifier

# 1.获取数据集

iris = load_iris()

# 2.数据基本处理

# x_train,x_test,y_train,y_test为训练集特征值、测试集特征值、训练集目标值、测试集目标值

x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.2, random_state=22)

# 3、特征工程:标准化

transfer = StandardScaler()

x_train = transfer.fit_transform(x_train)

x_test = transfer.transform(x_test)

# 4、机器学习(模型训练)

#4.1实例化一个转化器

estimator = KNeighborsClassifier(n_neighbors=9)

#4.2模型训练

estimator.fit(x_train, y_train)

# 5、模型评估

# 方法1:比对真实值和预测值

y_predict = estimator.predict(x_test)

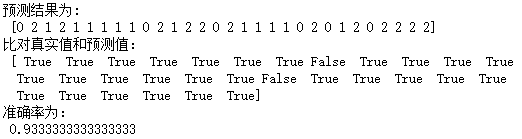

print("预测结果为:\n", y_predict)

print("比对真实值和预测值:\n", y_predict == y_test)

# 方法2:直接计算准确率

score = estimator.score(x_test,y_test)

print("准确率为:\n", score)

# 电影数据分类

from sklearn import neighbors # 导入KNN分类模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

plt.rcParams['font.sans-serif'] = ['KaiTi']

data = pd.DataFrame({'name':['北京遇上西雅图','喜欢你','疯狂动物城','战狼2','力王','敢死队'],

'fight':[3,2,1,101,99,98],

'kiss':[104,100,81,10,5,2],

'type':['Romance','Romance','Romance','Action','Action','Action']})

knn = neighbors.KNeighborsClassifier() # 取得knn分类器

knn.fit(data[['fight','kiss']], data['type'])

print('预测电影类型为:', knn.predict([[18, 90]]))

# 加载数据,构建KNN分类模型

# 预测未知数据

plt.scatter(data[data['type'] == 'Romance']['fight'],data[data['type'] == 'Romance']['kiss'],color = 'r',marker = 'o',label = 'Romance')

plt.scatter(data[data['type'] == 'Action']['fight'],data[data['type'] == 'Action']['kiss'],color = 'g',marker = 'o',label = 'Action')

plt.grid()

plt.legend()

plt.scatter(18,90,color = 'r',marker = 'x',label = 'Romance')

plt.ylabel('kiss')

plt.xlabel('fight')

plt.text(18,90,'《你的名字》',color = 'r')

# 绘制图表

1996

1996

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?