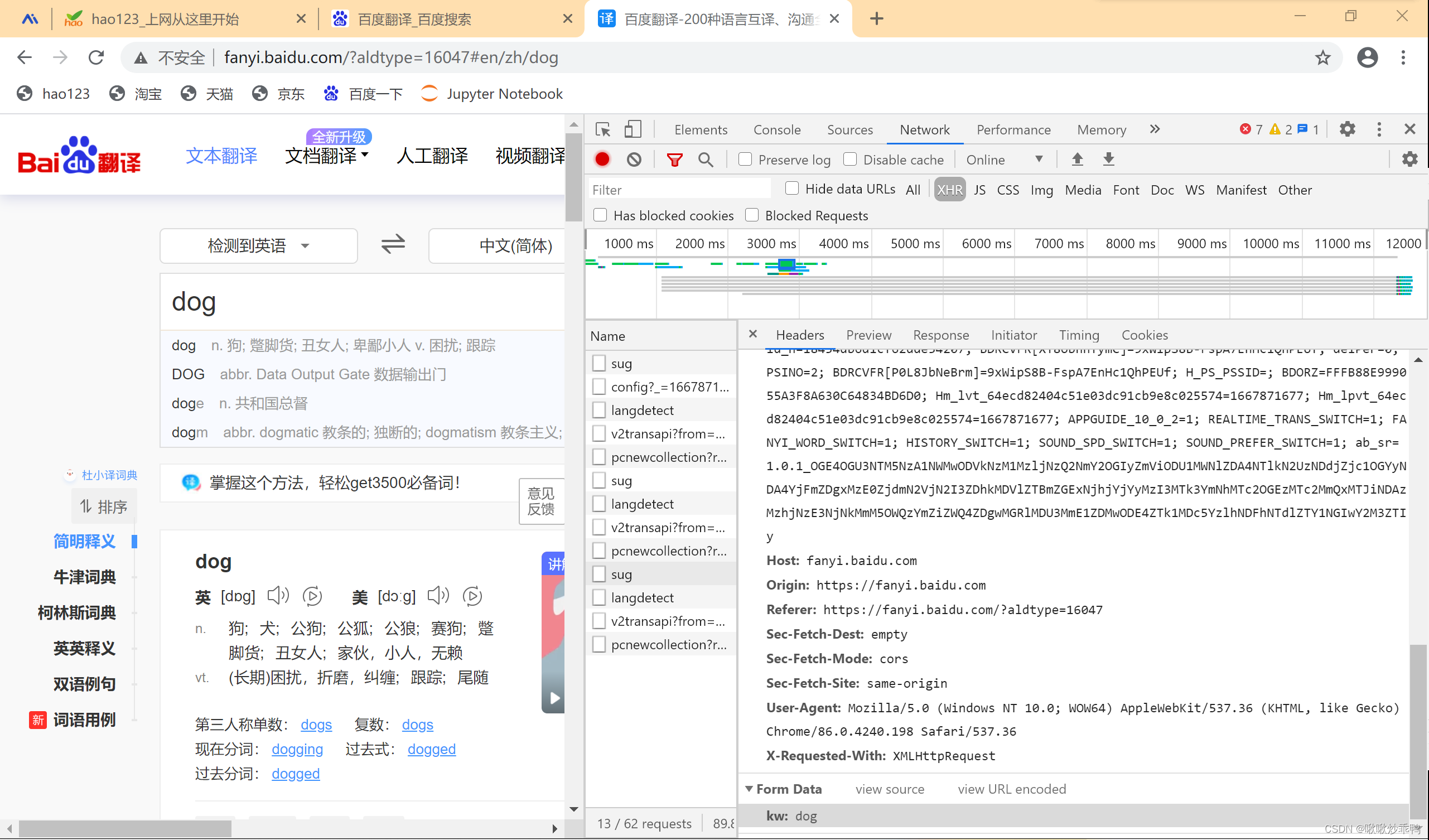

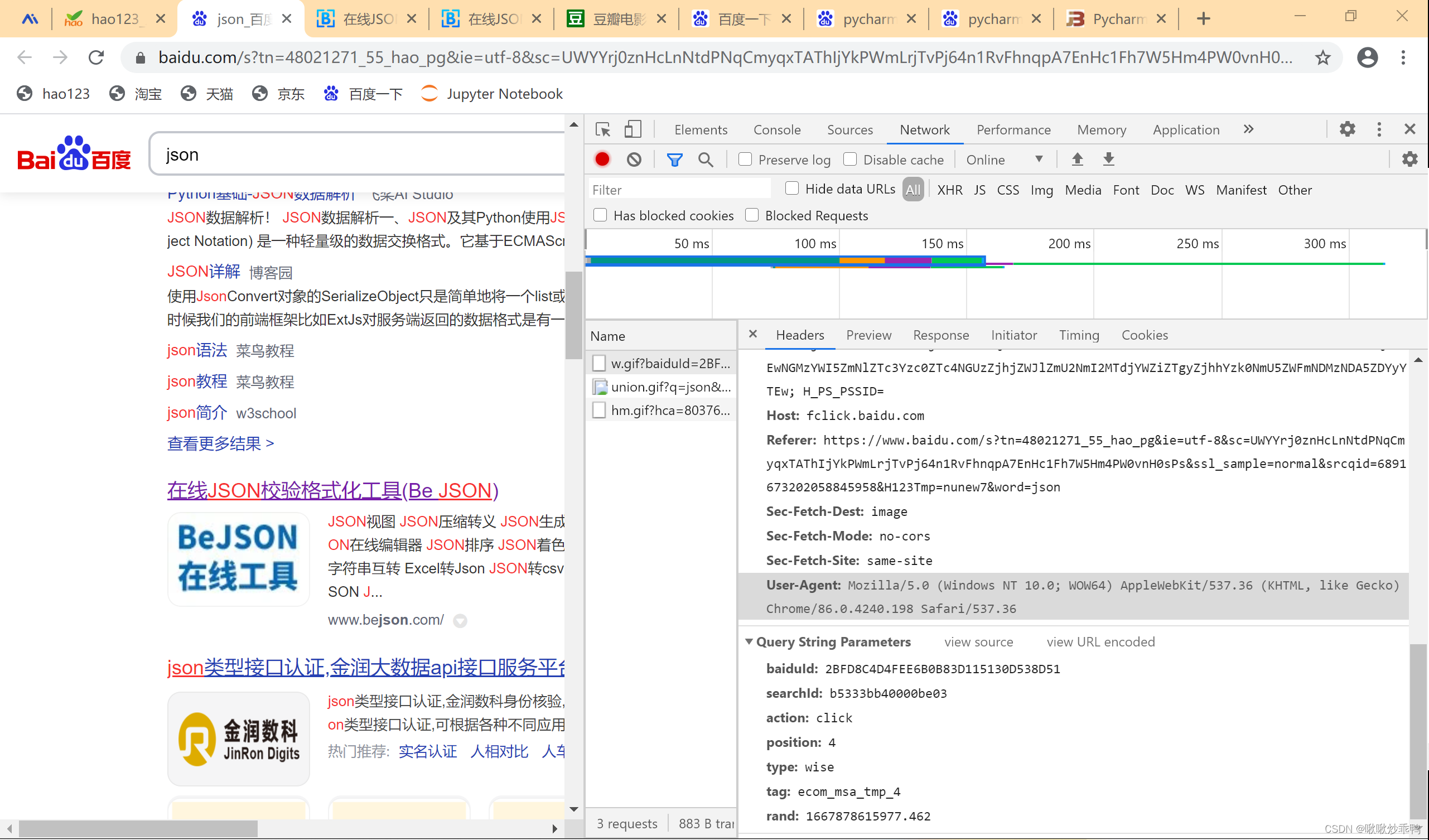

1.抓包

打开所爬网站,右键单击,选择”检查“。

选择”network"

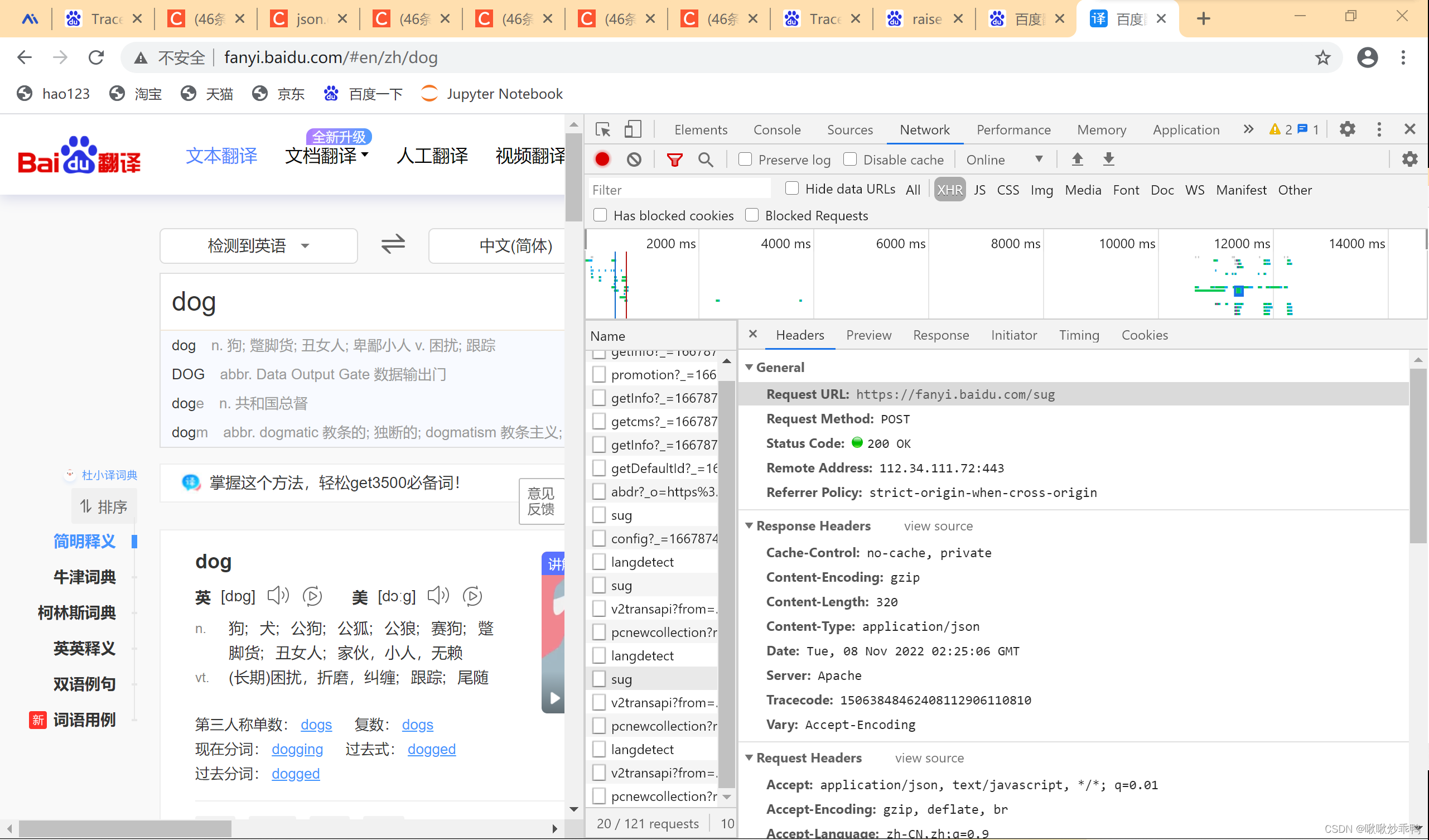

2.查看网站url:

3.查看请求方法

下面一行紧接着就是请求方法(requests调用的方法)

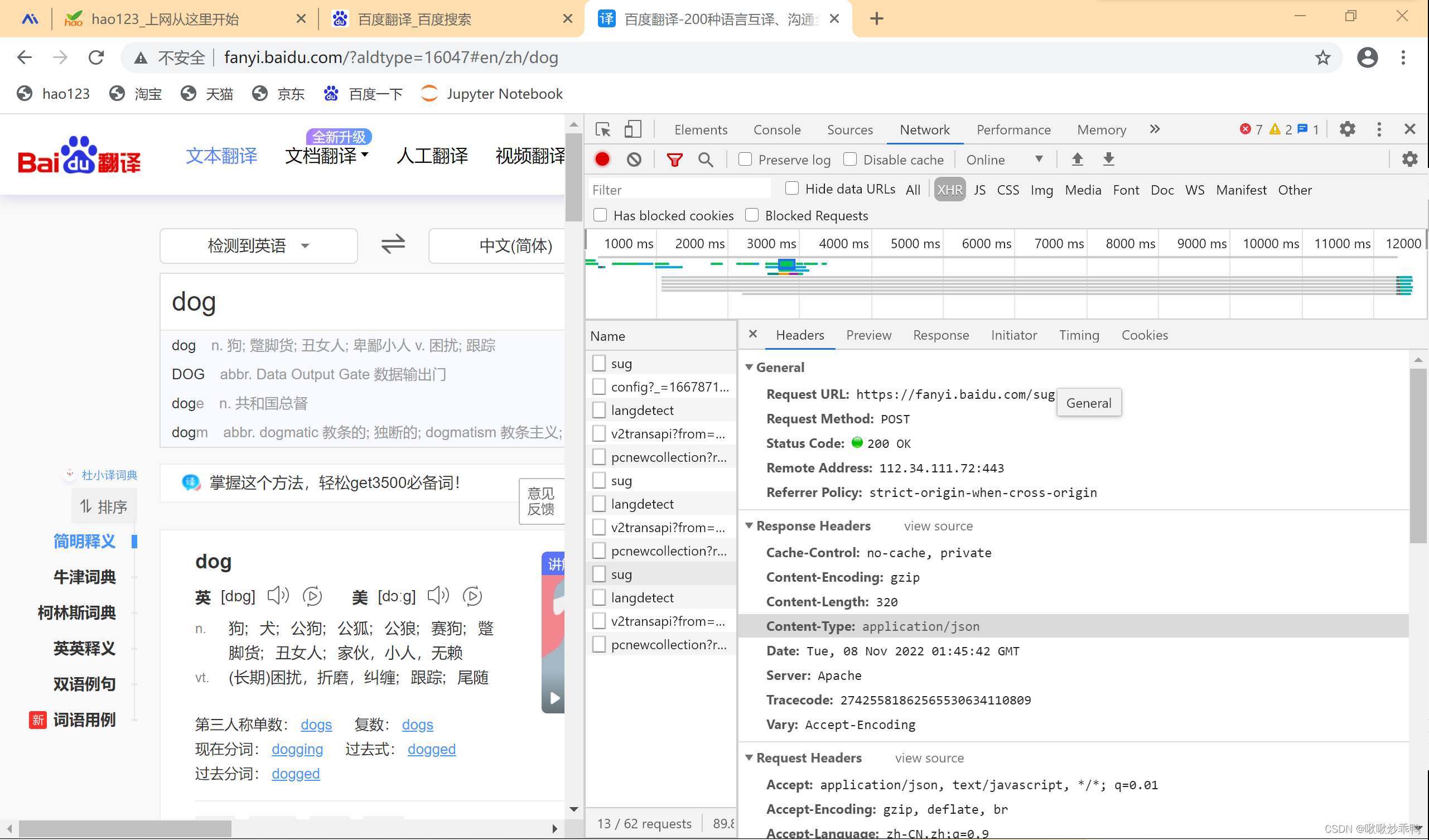

4.查看 返回内容的类型:

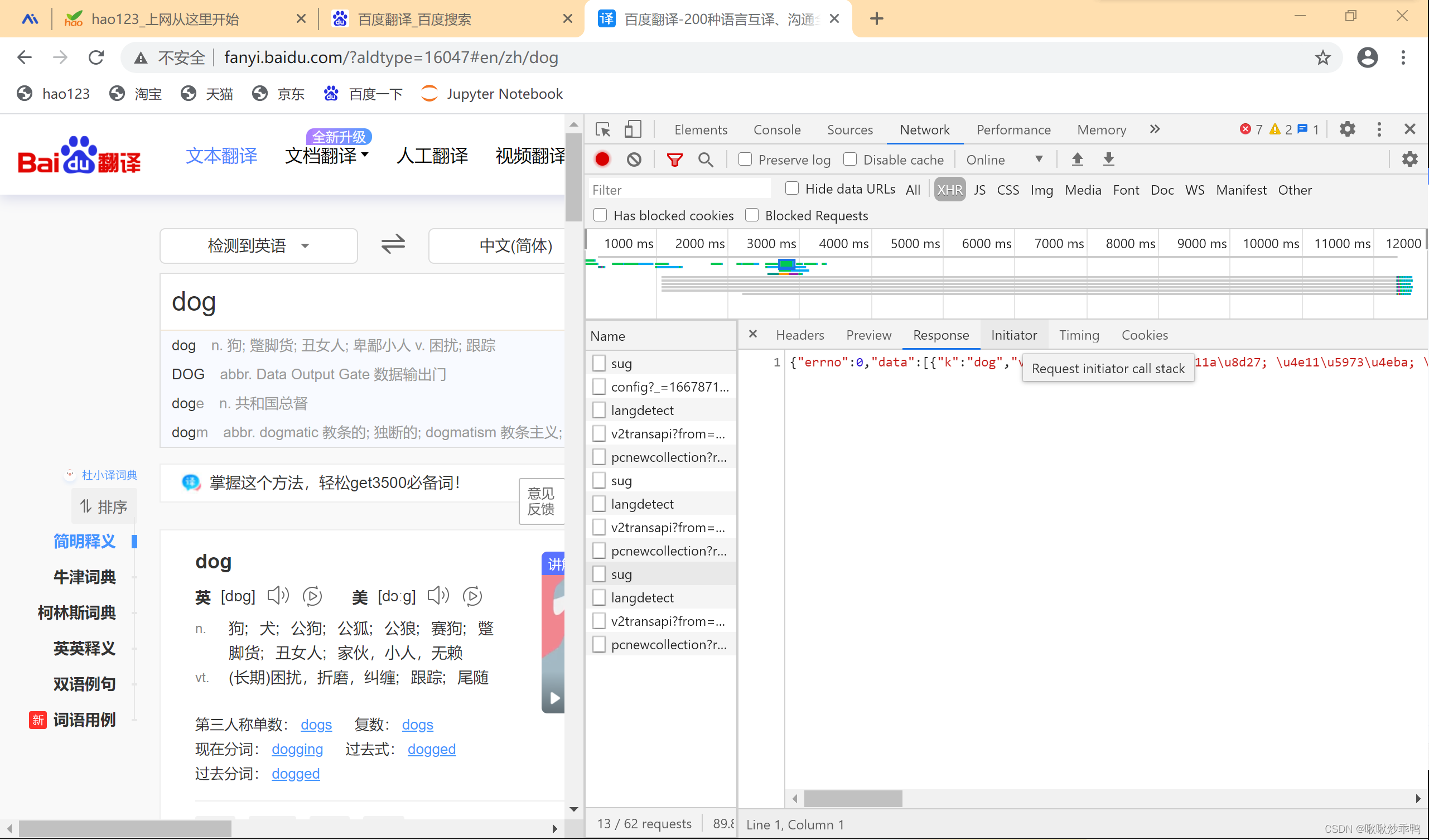

5. 查看返回内容:

6.查看User-Agent

主要用来进行UA伪装。

#UA伪装 UA:User-Agent #UA检测:门户网站会检测对应请求的身份载体,如果检测到是一款浏览器,就说明该请求正常。就不会拒绝,如果检测到身份标识不是某一款浏览器,则请求不正常,是基于爬虫的,服务器端很有可能拒绝该次请求。 #UA伪装:让爬虫对应的请求身份载体伪装成某一款浏览器

1085

1085

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?