1、创建集群所需要的目录

创建ES的挂载目录

mkdir -p /usr/local/elasticsearch_jiqun_3_node/node-{1..3}/{config,plugins,data,log}

chmod 777 /usr/local/elasticsearch_jiqun_3_node/node-{1..3}/{config,plugins,data,log}创建kibana的挂载目录

mkdir -p /usr/local/elasticsearch_jiqun_3_node/kibana/config/

chmod 777 /usr/local/elasticsearch_jiqun_3_node/kibana/config/2、修改Linux的句柄数

vim /etc/sysctl.conf添加如下内容:(vm.max_map_count=655360)

接下来再关闭swap

swapoff -a3、修改最大线程数

因为ES运行期间可能创建大量线程,如果线程数支持较少可能报错

vim /etc/security/limits.conf# 添加以下内容

* soft nofile 65536

* hard nofile 131072

* soft nproc 4096

* hard nproc 4096如下图

重启

reboot4、添加IK分词器

首先需要下载IK分词器压缩包

下载方式1

链接: https://pan.baidu.com/s/1zxetPFZyRPyxwFFIL113DQ 提取码: 9m6a

下载方式2

在github中下载对应版本的分词器,网址:Releases · infinilabs/analysis-ik · GitHub

将下载的分词器复制到ES安装目录的plugins目录中并进行解压

mkdir ik && cd ik

unzip elasticsearch-analysis-ik-7.17.5.zip将这个ik目录分别添加到ES的三个节点的plugins目录里

cp -R ik/ /usr/local/elasticsearch_jiqun_3_node/node-1/plugins/

cp -R ik/ /usr/local/elasticsearch_jiqun_3_node/node-2/plugins/

cp -R ik/ /usr/local/elasticsearch_jiqun_3_node/node-3/plugins/5、编写配置文件

node-1

vi /usr/local/elasticsearch_jiqun_3_node/node-1/config/elasticsearch.yml#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-1

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-2

vi /usr/local/elasticsearch_jiqun_3_node/node-2/config/elasticsearch.yml#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-2

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-3

vi /usr/local/elasticsearch_jiqun_3_node/node-3/config/elasticsearch.yml#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-3

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsekibana

vi /usr/local/elasticsearch_jiqun_3_node/kibana/config/kibana.ymlserver.host: 0.0.0.0

# 监听端口

server.port: 5601

server.name: "kibana"

# kibana访问es服务器的URL,就可以有多个,以逗号","隔开

elasticsearch.hosts: ["http://node-1:9200","http://node-2:9201","http://node-3:9202"]

monitoring.ui.container.elasticsearch.enabled: true

# kibana访问Elasticsearch的账号与密码(如果ElasticSearch设置了的话)

elasticsearch.username: "kibana"

elasticsearch.password: "12345"

# kibana日志文件存储路径

logging.dest: stdout

# 此值为true时,禁止所有日志记录输出

logging.silent: false

# 此值为true时,禁止除错误消息之外的所有日志记录输出

logging.quiet: false

# 此值为true时,记录所有事件,包括系统使用信息和所有请求

logging.verbose: false

ops.interval: 5000

# kibana web语言

i18n.locale: "zh-CN"6、编写Docker部署文档

cd /usr/local/elasticsearch_jiqun_3_node/

vi docker-compose.yml文件内容如下:

version: "3"

services:

node-1:

image: elasticsearch:7.17.5

container_name: es_jiqun_3node-node-1

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9200:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /usr/local/elasticsearch_jiqun_3_node/node-1/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /usr/local/elasticsearch_jiqun_3_node/node-1/plugins:/usr/share/elasticsearch/plugins

- /usr/local/elasticsearch_jiqun_3_node/node-1/data:/usr/share/elasticsearch/data

- /usr/local/elasticsearch_jiqun_3_node/node-1/log:/usr/share/elasticsearch/log

networks:

- elastic

node-2:

image: elasticsearch:7.17.5

container_name: es_jiqun_3node-node-2

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9201:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /usr/local/elasticsearch_jiqun_3_node/node-2/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /usr/local/elasticsearch_jiqun_3_node/node-2/plugins:/usr/share/elasticsearch/plugins

- /usr/local/elasticsearch_jiqun_3_node/node-2/data:/usr/share/elasticsearch/data

- /usr/local/elasticsearch_jiqun_3_node/node-2/log:/usr/share/elasticsearch/log

networks:

- elastic

node-3:

image: elasticsearch:7.17.5

container_name: es_jiqun_3node-node-3

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9202:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /usr/local/elasticsearch_jiqun_3_node/node-3/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /usr/local/elasticsearch_jiqun_3_node/node-3/plugins:/usr/share/elasticsearch/plugins

- /usr/local/elasticsearch_jiqun_3_node/node-3/data:/usr/share/elasticsearch/data

- /usr/local/elasticsearch_jiqun_3_node/node-3/log:/usr/share/elasticsearch/log

networks:

- elastic

kibana:

container_name: es_jiqun_3node_node-kibana

image: kibana:7.17.5

volumes:

- /usr/local/elasticsearch_jiqun_3_node/kibana/config/kibana.yml:/usr/share/kibana/config/kibana.yml

ports:

- 5601:5601

networks:

- elastic

cerebro:

image: lmenezes/cerebro:0.9.4

container_name: es_jiqun_3node_node-cerebro

environment:

TZ: 'Asia/Shanghai'

ports:

- '9000:9000'

networks:

- elastic

networks:

elastic:

driver: bridge启动服务

docker-compose up -d7、测试集群

查询集群健康状态

GET /_cluster/health

status字段是我们最关心的,status字段指示着当前集群在总体上是否工作正常。它的三种颜色含义如下

green:所有的主分片和副本分片都正常运行yellow:所有数据可用,但有些副本尚未分配(集群功能完全)red:有主分片没能正常运行

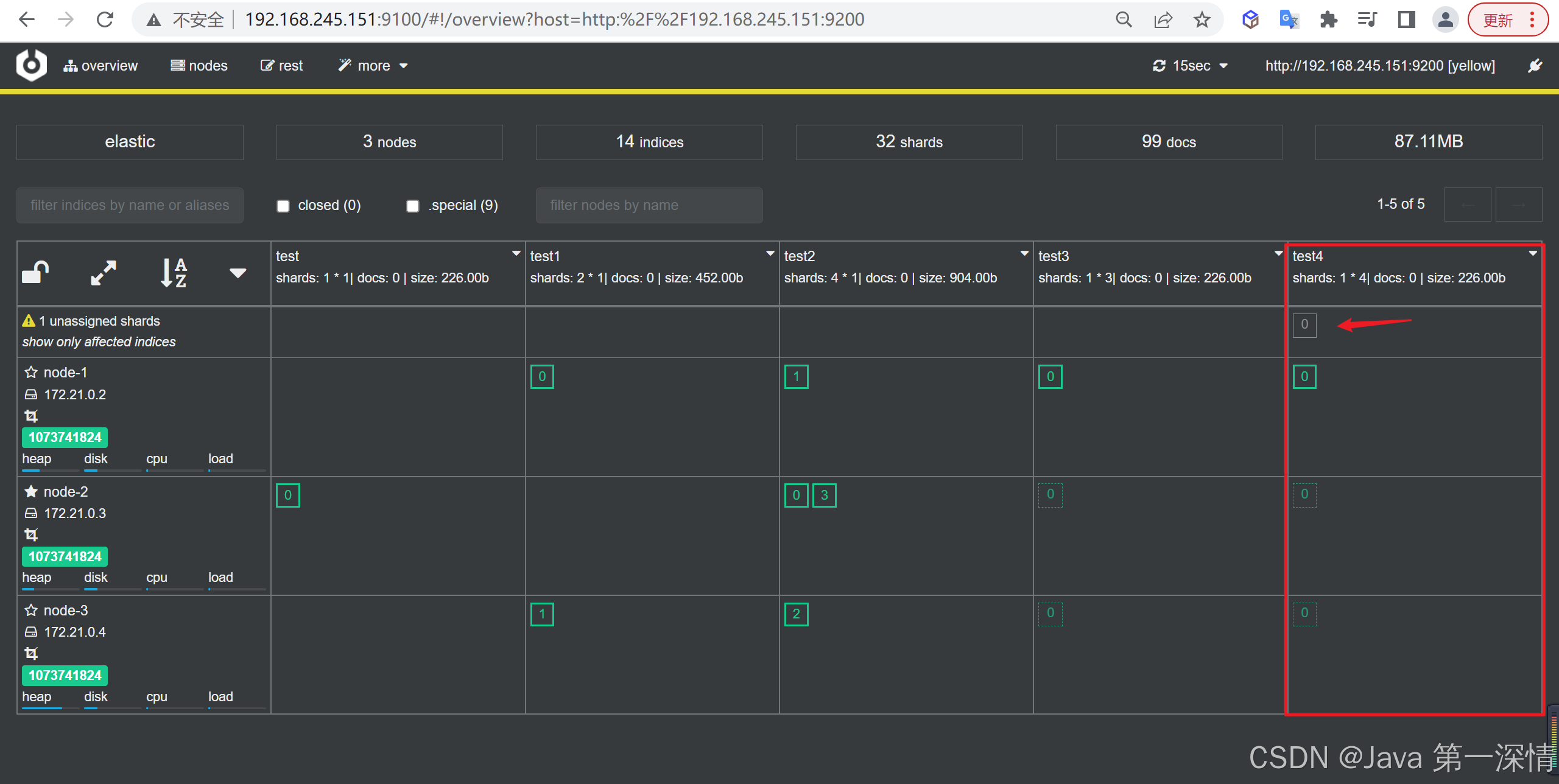

创建索引测试

PUT test

{

"settings":{

"index":{

"number_of_shards" : "1",

"number_of_replicas" : "0"

}

}

}"number_of_shards" : "1":指定索引的分片个数

"number_of_replicas" : "0":指定每个分片的副本个数

注意:如果某一个节点上存储了分片及分片自身的副本 ,会导致什么现象

如上图所示我们看到多出一个Unassigned的副本,这个副本其实是多余的了,因为每个节点已经包含了分片的本身和其副本,多于这个没有意义!

并且因为多出来了一个副本无法分配,整个集群都变成了yellow的状态

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?