目录

摘要

基于路侧摄像头的车辆位置视觉检测方法是一种广泛应用于智能交通系统和自动驾驶领域的技术。该方法利用摄像头采集到的车辆图像,通过图像处理和分析技术提取车辆的特征信息,并将其转换为在道路坐标系中的位置信息,从而实现对车辆位置的检测。本文介绍了该技术的基本流程,包括车辆图像采集和预处理、图像坐标系与道路坐标系的映射关系建立以及车辆位置信息的确定。此外,本文还介绍了基于颜色的特征点提取方法和基于背景减除法的特征点提取方法这两种方法的原理,以及连通域分割方法,并提出了将这几种方法结合使用的建议。

关键词:位置视觉; 回归分析 ;机器视觉;BP神经网络;图像处理

The visual detection method of vehicle position based on roadside cameras is a technology widely used in the field of intelligent transportation systems and autonomous driving. The method uses the vehicle images captured by the camera, extracts the vehicle's feature information through image processing and analysis technology, and converts it into the position information in the road coordinate system, thereby achieving the detection of vehicle position. This article introduces the basic process of this technology, including vehicle image acquisition and preprocessing, establishment of mapping relationship between image coordinate system and road coordinate system, and determination of vehicle location information. In addition, this article also introduces the principle of two feature point extraction methods based on color and background subtraction method, as well as the connected domain segmentation method, and proposes the recommendation of combining these methods.

Keywords:Position Vision; Regression Aanalysis; Machine Vision; BP Neural Network; Image Processing

第一章 绪论

第一节 课题背景及研究的目的和意义

随着人民生活水平的提高和城市化进程的加速,汽车已经成为现代城市居民生活中不可或缺的代步工具之一。然而,随之而来的是日益拥堵的道路交通和安全问题,这对于驾驶员的驾驶安全和舒适度提出了更高的要求[1]。

为了协助汽车在道路上更加安全、舒适的行驶,道路监测视觉系统的建设在我国道路建设中不断发展。这些系统包括道路监控摄像头、交通信号灯、交通指示牌等一系列设备,可为驾驶员提供实时的路况信息、交通事件信息和交通指示信息,提高驾驶员的安全性和行驶效率。

在这些设备中,路侧摄像头是非常重要的组成部分之一。它可以通过检测道路上行驶的车辆和行人,提供准确的位置、速度和方向等信息,帮助驾驶员避免潜在的危险,并提供更加精准和实时的路况信息。

同时,路侧摄像头还可以通过图像识别技术,检测道路上的障碍物和交通标志等,将这些信息反馈给驾驶员,提高驾驶员的认知能力和反应速度,从而减少事故的发生。

因此,基于道路监测视觉系统中的路侧摄像头检测道路车辆的相关位置,给出更精准更丰富的相关数据信息,将会为驾驶员提供更加智能化、个性化和安全的驾驶体验,同时也有助于提升城市道路交通的整体效率和安全性。

一、位置视觉检测方法国内外研究现状

位置视觉测量算法是一种用于处理采集的图像并获取目标在世界坐标系中位置的技术,可以用于检测车辆的位置。它最早源于图像摄影,旨在解决光学透镜产生的畸变[2]。随着摄影、测绘技术和图像采集设备的发展,该技术得到了迅速发展。

在20世纪中叶,Abdal-Aziz提出了直接线性变换方法,利用世界坐标系和摄像机图像坐标系中对应点之间的关系,通过线性的投影模型来解释摄像机的成像原理,并通过求解线性模型来进行测量[3]。到1980年,为了解决摄像机畸变现象,Tsai提出了径向一致约束法,并提出了经典摄像机模型,该方法测量结果精度高,多用于解决精密测距的场景[4]。虽然用线性方程实现位置视觉测量的方法相对简单且结果具有较好的鲁棒性,但对标定设备的要求很高,因此具有局限性。

在90年代后期,摄像机自标定法被提出,具有灵活性强、应用广泛的优点,但由于结果的鲁棒性较差,主要用于对精度要求不高的场合。21世纪,国内外学者提出了基于平面运动的自标定法,用于位置视觉测量。对于位置视觉测量算法的研究和优化仍在继续。

国内对位置视觉测量算法的研究较晚,直到20世纪90年代才开始。1996年,马颂德提出了基于主动视觉的位置视觉测量算法,通过解线性方程求解,结果鲁棒性不错,但测量的前提是运动参数已知且可控,而通常情况下,运动参数是不可控的。为了解决这个问题,胡占义等人提出了基于平面的单应性矩阵的正交运动方法[5]。此外,在1988年,张正友提出了一种结合传统标定法和自标定法的标定法,用于位置视觉测量,具有高鲁棒性和标定精度高,适用范围广泛。

目前,国内对位置视觉测量算法的研究仍在深入,该技术在多数领域均得到广泛应用。

二、车辆识别算法的国内外研究现状

随着汽车保有量不断增加,智能汽车的发展迅猛。位置视觉测量算法的升级,为驾驶员提供了更多的道路信息获取方式。而检测车辆位置需要先使用车辆识别算法对车辆进行识别,然后才能进行位置检测算法分析。

车辆识别算法是指通过图像处理技术和模式识别方法,对道路上行驶的车辆进行自动识别的技术[6]。车辆识别算法是计算机视觉和人工智能领域的重要研究方向之一。在国内外,已经有大量的研究工作投入到车辆识别算法的研究中。顾曦龙在2022年提出了一种基于YOLOv3与改进VGGNet的车辆多标签实时识别算法,旨在实现对视频中车辆信息的快速、有效识别。该算法结合了YOLOv3算法和CNN算法的优点,在车辆监测和定位方面利用了YOLOv3的高效性和准确性,在车辆多标签识别方面利用了类VGGNet多标签分类网络的优势。[7] 在2021年陶英杰提出了一种基于边缘智能的车辆目标检测方法,采用强化学习优化模型压缩效率,并在嵌入式设备和云端部署实现高精度目标检测[8]。在国际上,深度学习技术[9]已经成为车辆识别算法的主流方法,如Faster R-CNN、YOLO、SSD等。这些方法能够对车辆进行准确的检测和分类,并且在精度和速度方面都有很好的表现。

也有一些研究者针对车辆在城市环境下的特殊情况进行了深入研究,如复杂背景、遮挡和光照变化等。同时,一些研究者还将车辆识别算法应用于交通流量监测、交通管理和智能交通等方面,取得了良好的实验效果。另外,一些新的算法也逐渐被应用到车辆识别算法中,如基于注意力机制的算法、基于图卷积网络的算法等[10]。

总的来说,车辆识别算法是一个不断发展和进步的领域,国内外的研究者都在不断地提出新的算法和方法,为实现更加准确和高效的车辆识别贡献力量。

第二节 课题的主要研究内容

基于路侧摄像头的车辆位置视觉检测方法具有广泛的应用前景。该方法包括图像的处理和分析、映射关系的建立以及车辆位置信息的确定等方面。具体而言,该方法主要包括图像灰度化、二值化、形态学运算、BP神经网络[11]、回归分析[12]等步骤,可以有效地提取车辆图像信息和确定车辆位置信息。通过建立图像坐标系和道路坐标系之间的映射关系,可以实现图像坐标系向道路坐标系的转换,并为车辆位置的确定提供数学模型。其主要研究内容如下:

一、车辆图像的采集和处理

车辆图像的采集和处理是基于路侧摄像头的车辆位置视觉检测方法的重要组成部分。针对不同场景,图像采集可以分为室内实验小车仿真的图像采集和室外实验道路汽车图像采集。在采集到车辆图像后,需要进行图像预处理,例如图像灰度化、二值化等操作,以完成对车辆图像信息的提取和后续处理工作。这些预处理步骤能够帮助提高车辆位置检测的准确性和可靠性。

二、研究图像坐标系与道路坐标系的映射关系

此次研究建立基于BP神经网络算法和基于回归分析算法的两种数学模型,用于建立图像坐标系与道路坐标系之间的映射关系。通过对采集到的车辆图像进行处理,提取出车辆位置信息,然后将该信息转换为在道路坐标系中的位置。其中,BP神经网络算法和回归分析算法分别具有不同的优缺点,可以根据实际应用场景选择合适的方法来建立映射关系模型。

三、车辆位置信息的确定

通过采集和处理路侧摄像头获取的车辆图像,以及基于BP神经网络算法或回归分析算法建立的图像坐标系和道路坐标系之间的映射关系,可以确定车辆在道路上的位置信息。最终实验结果可以通过计算图像中车辆的位置信息,并经过坐标系转换得出车辆在道路坐标系中的位置信息。

第二章 图像的采集和处理

车辆图像的采集和处理是车辆位置视觉检测方法中的重要环节,为后续的图像处理和车辆位置信息的确定奠定了基础。在室内实验中,通过摄像头对小车进行图像采集,将采集到的图像通过预处理步骤,如灰度化、二值化、形态学运算等操作,提取出车辆图像的信息[13]。在室外道路汽车实验中,车辆图像的采集相对复杂,需要考虑光照、天气等因素,采集到的图像也需要进行预处理,如图像增强、去噪等操作。最终提取出车辆的轮廓信息,用于作为图像坐标系与道路坐标系的映射关系的数学模型的输入部分。采集到的高质量图像和处理后得到的有效信息是车辆位置视觉检测方法的重要基础。

第一节 车辆图像

数字图像是指将实际场景中的图像通过数字化技术转换为数字信号的过程,其本质是将图像上的每个像素点的位置和颜色信息转换为数字信息进行存储和处理[14]。由于数字图像具有数字化、可计算和可储存等特点,使得图像处理变得更加便利和高效。数字图像处理可以通过计算机算法来对图像进行分析、处理和操作,可以实现对图像的增强、恢复、压缩、分类、识别等多种功能。如图2.1是室外拍摄的实验车辆图像,图2.2是室内实验拍摄车辆图像。

一、像素点

像素点的颜色或灰度值可以用不同的数字来表示。在二值图像中,每个像素点只有两种可能的取值,通常用0和1表示,其中0代表黑色,1代表白色。在灰度图像中,每个像素点的取值通常在0到255之间,代表了不同的灰度级别,0代表黑色,255代表白色。在彩色图像中,每个像素点的颜色由三个基本颜色(红色、绿色和蓝色)的强度组合而成,通常使用24位的颜色编码表示,其中每个颜色通道的取值在0到255之间。

像素点的密度(即每英寸像素数)通常被称为分辨率,分辨率越高,图像的质量和清晰度就越高。像素点是数字图像的基本单元,每个像素点代表了图像中的一个小区域。像素点的颜色或灰度值可以用不同的数字来表示,不同的图像类型和用途会使用不同的像素表示方式。

在二值图像中,每个像素点只有两种可能的取值,即黑色和白色。这种图像常用于文本识别、边缘检测、形态学处理等应用。

灰度图像中,每个像素点的取值通常在0到255之间,代表了不同的灰度级别,0代表黑色,255代表白色。这种图像常用于计算机视觉、医学影像、数字图书馆等领域。

彩色图像中,每个像素点的颜色由三个基本颜色(红色、绿色和蓝色)的强度组合而成,通常使用24位的颜色编码表示,其中每个颜色通道的取值在0到255之间。

像素点的密度通常被称为分辨率,它表示每英寸像素数。分辨率越高,图像的质量和清晰度就越高。常见的分辨率包括72 dpi、300 dpi、600 dpi等。分辨率对于我们处理和输出的车辆图像非常重要,因为它可以影响的基于路侧摄像头的车辆位置视觉检测方法最终结果的精度。如图2.3 是在图像中的像素点。

二、RGB颜色空间

RGB颜色空间是一种将颜色表示为红、绿、蓝三个通道的方式,它是数字图像处理和计算机视觉中最常用的颜色表示方式之一[15]。在RGB颜色空间中,每个颜色通道的取值通常在0到255之间,代表了不同的强度或亮度级别。这种方式可以组合出数百万种颜色,因此非常适合在计算机显示器和电视屏幕中使用,以生成各种颜色。在数字图像处理中,我们可以使用RGB颜色空间来对图像进行增强、滤波、分割和识别等处理,以获得更好的图像质量和准确性。在计算机视觉和机器学习中,RGB颜色空间可以用来训练和识别各种对象、场景和行为。此外,RGB颜色空间还被广泛应用于图形设计、艺术创作、游戏开发等领域,以创造出各种绚丽多彩的效果。RGB颜色空间是数字图像处理和计算机视觉中最常用的颜色表示方式之一,它的应用范围非常广泛,对于我们日常生活和工作中的各种领域都有很重要的意义。本文所采集的图像均使用RGB颜色空间进行表示,为后续实验提供了基础。其RGB空间颜色模型如图2.4所示。

RGB颜色模型是一种基于人眼对彩色的感受来表示颜色的模型。人眼中的锥状细胞通过吸收红、绿、蓝三种光波来传递信息,使大脑感知色彩。因此,RGB模型使用红、绿、蓝三种光的亮度值组合来表示颜色。每种光的亮度值在0~255的范围内取值,这个范围对应了8位二进制数的取值范围。

当红、绿、蓝三种光的亮度值均为255时,可以得到一种白色,而当三种光的亮度值均为0时,则得到一种黑色。调节每种光的亮度值可以得到各种颜色。例如,增加红光的亮度值可以得到偏红的颜色,增加绿光的亮度值可以得到偏绿的颜色,增加蓝光的亮度值可以得到偏蓝的颜色。因此,RGB颜色模型被广泛应用于数字图像处理、计算机视觉和图形设计等领域。

三、连通域

在图像处理领域中,连通域分析是一种常用的图像分割方法,其主要目的是将图像分成多个连通域,以便于进一步的处理[16]。连通域是指由相邻的像素点组成的像素集合,这些像素点在某种意义上是连通的,也就是说它们可以通过一系列相邻的像素点从一个点到达另一个点。

在连通域分析中,常用的连接方式有四连通和八连通。四连通指的是只考虑上下左右四个方向的像素点是否相邻,即只有当两个像素点在上下左右方向上都相邻时才算是连通的。八连通则是考虑所有方向上的像素点是否相邻,即除了上下左右四个方向,还包括对角线方向。

在实际应用中,如果要检测的物体形状比较简单,那么使用四连通的方法就可以得到比较好的结果。但如果物体形状比较复杂,使用八连通的方法会更加准确。同时,使用八连通的方法会比四连通的方法更加耗时,因为需要考虑更多的像素点是否相邻。如图2.5是四连通,图2.6是八连通。

第二节 车辆图像采集环境

对于车辆位置视觉检测方法的研究,采集环境是一个非常重要的因素。良好的采集环境能够保证采集到的图像质量高、清晰度好,从而能够提高车辆位置视觉检测的准确性和可靠性。而采集环境差的情况下,由于光线、背景等因素的影响,图像质量会大幅下降,可能会导致图像质量和可用性。良好的车辆图像采集环境可以提供高质量的图像,有助于提高车辆位置视觉检测方法的准确性和可靠性,进而提高实验结果的可信度。

室内实验所采集的图像为仿真小车图像,相较于室外真实场景,其采集环境要求略有不同。在室内环境下,实验可以通过控制光源和背景等因素,来保证光线均匀和光照条件稳定,从而提高图像质量。同时,没有背景干扰因素,如植物、装饰品、电线等,也减少了图像处理的难度。在室内实验布局上,本文选择单摄像头的布局,摄像机位置位于车辆的正后方,这种布局可以有效地捕捉车辆的运动状态和位置信息,为后续的视觉检测方法提供了有效的图像数据。

二、室外采集环境

在室外实验中,道路汽车车辆图像采集环境的要求和室内实验略有不同,因为室外环境更加复杂和多变,需要考虑更多因素的影响。选择光照较好的晴天和中午时间段进行采集,可以避免光线不足或光线不均匀等问题,有利于采集高质量的图像。实验路段具有简单、整洁的道路背景,减少了背景干扰因素,有利于提高车辆位置的视觉检测准确性。在选择摄像机位置时,布局在道路侧方的具备一定高度山坡上,用于模拟道路摄像头,可以更好地模拟真实道路场景,提高实验的可靠性。此外,封闭路段和无其他车辆行驶也可以保证室外实验的安全性。

第三节 车辆图像采集

本文中的室内实验和室外实验采用了不同型号的相机设备来采集车辆图像,分别为尼康的单反相机和C19的塔菲克相机,两种设备均采用典型的针孔相机模型,具有高分辨率和高进光量,能够采集到清晰度较高的图像,并还原环境的颜色。如图2.7和图2.8是实验相机设备图。

在室内实验的车辆图像采集过程中,为了保证采集图像的正确性,需要采取一系列措施。首先,需要使用三脚架对摄像机进行固定,确保图像采集时相机的位置不变,防止摄像机晃动影响图像清晰度。其次,需要保证镜头拍摄的位置光照均匀,以避免因光线不均匀而导致的图像质量问题。在室内实验中,本摄像机位置位于车辆的正后方,摄像机高度为80cm,与水平夹角约为35度,这种布局可以有效地捕捉车辆的运动状态和位置信息,为后续的视觉检测方法提供了有效的图像数据。如图2.9是室内采集工作照。

三、室外图像采集

在室外实验中,同样需要采取一系列措施以保证采集图像的正确性。首先,需要使用固定支架将摄像机固定在路侧的山坡,用于模拟路侧摄像头。确保摄像机的位置不变,避免操作过程中震动影响图像清晰度。其次,需要调整摄像机的参数,以适应不同环境下的光线条件,保证图像光线均匀。将建立室外道路坐标系,以斑马线的第二个横向斑马线的右下角点为原点,以X为横坐标,Y为纵坐标,以便后续对采集到的图像进行处理和分析。同时,在采集过程中还需要注意车速和路况,以确保图像中的物体不会出现模糊或失真的情况。如图2.10是室外采集工作照。

第四节 车辆图像分割

(一)、基于颜色的特征提取

基于颜色的特征点提取方法是一种常用的计算机视觉方法,它通过检测图像中的颜色变化来提取特征点,从而实现目标检测和跟踪等应用[17]。在室内小车仿真实验中,采用红色车身是为了避免颜色干扰因素对实验结果的影响,同时也方便使用基于颜色的特征点提取方法对仿真小车进行定位和跟踪。这种方法简单易用,对实时性要求较高,适用于室内实验等背景较为简单的场景。如图2.11是室内实验小车原图。

图2.11是RGB图像,同时观察仿真小车的颜色特征可知是红色。查询附录1红色的RGB分布空间表可知,红色的RGB的R分量均大于128,G分量均小于160,B分量均小于128。对图2.4进行以下处理,将图2.4中的R分量大于128并且G分量小于160和B分量小于128的像素点全部赋值为0,除此之外,均赋值为255。得到图2.12室内实验基于颜色的特征提取图。观察图2.12可以发现,仿真小车的特征基本提取出来,但是图中许多的白色噪点需要后面再继续进行处理

(二)、基于背景减除法的特征提取

在室外实验中,由于道路背景复杂,实验车辆亦无明显的车身颜色,使用基于颜色的特征提取方法效果并不理想,所以我们采用背景减除法来提取目标车辆的特征[18]。背景减除法对光照变化和背景变化十分敏感,但是其计算简单、实时性好,并且一般能够获取比较完整的运动目标轮廓。背景减除法适用于背景相对静止情况下的运动目标检测,与帧间差分法相似,该方法将视频序列的当前帧与背景帧作差分运算,用当前帧减去背景帧,得到运动中的目标车辆的轮廓。如图2.13是室外道路实验的背景帧。图2.14是道路实验某一时刻的当前帧。图2.15室外实验各时刻的背景消除法特征提取图。

车辆图像分割是指将车辆图像分成不同的区域或像素,以便识别车辆中的不同部分或对象[19]。在实际应用中,为了达到良好的图像分割效果,通常需要选择合适的分割阈值。分割阈值是用于将数据或图像分成不同类别或区域的一个界限值,选择合适的分割阈值对于图像分割的准确性和效率具有重要的影响。在选择分割阈值时,需要根据具体问题和数据特点进行分析和调整,常用的方法包括基于统计量的阈值选择方法、基于聚类分析的阈值选择方法等。在车辆图像分割中,根据车辆图像的特点,可以采用不同的阈值选择方法,例如基于车辆颜色、形状以及连通域等特征进行阈值选择。通过选择合适的分割阈值,可以将车辆图像分成不同的区域或像素,从而实现车辆识别的目的。

(一)、室内实验车辆图像分割

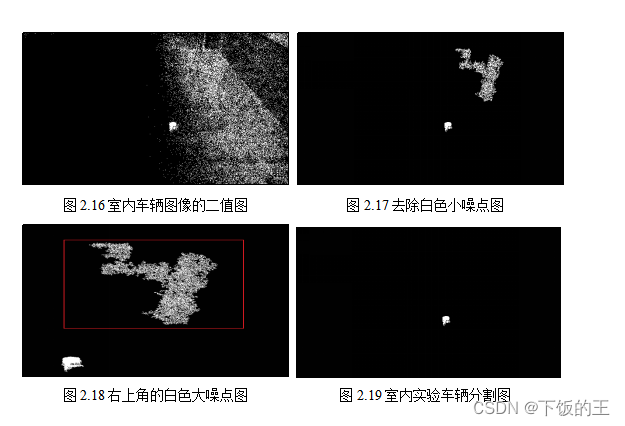

观察图2.12,可以发现,目标车辆区域连通,而白色小噪点连通域面积,明显要小于目标车辆的连通域面积,但是使用连通域分割方法,需要先将图2.12室内实验基于颜色的特征提取图进行二值化,得到如图2.16的二值图。虽然白色的噪点没有去除,但是二值化图像可以通过计算连通域的面积实现图像分割。因为目标车辆体积小且形状较为简单。可以使用四连通对连通域进行判断是否属于同一区域,对同一区域的区域面积的值小于20000的小噪点进行去除,得到如图2.17去除白色小噪点的图像。如图2.18所示,可以发现在图2.17的右上角处仍然存在一个连通域面积较大的白色大噪点。白色大噪点的面积远远大于目标车辆的连通域。所以只需要对图2.17进行去除白色小噪点的反向操作,将大的白色噪点去除即可。在实际处理过程中将连通域大于40000的对象去除,最终便可得到如图2.19室内实验车辆分割图像。

(一)、室外实验车辆图像分割

观察图2.15室外实验某一时刻背景消除法特征提取图,可以发现仍存在许多噪点,如图2.20室外实验提取特征后的噪点,在红色矩形外的周围区域均是白色噪点。这些噪点的影响导致无法准确的识别分出车辆区域。在室外实验中,与室内实验不同,车身面积大,侧面车身轮廓的细节多。为了能更好的识别目标车辆轮廓,研究改为使用八连通对连通域进行判断是否属于同一区域,计算同意区域的面积,手动选择合适的阈值将小面积的对象去除。在实际处理过程中将同一连通域面积低于4000的小对象进行去除,得到如图2.21室外实验车辆图像分割图

第二节、实验结果分析

一、室内实验结果分析

基于颜色的特征提取方法是一种常用的目标检测技术,在识别具有不同颜色特征的目标时特别有用。在室内实验中,红色被用作汽车的颜色标识符。通过提取图像中的红色特征点,识别出仿真小车的位置信息。这种方法可以快速有效地识别仿真小车的位置。在室内实验中完成标定图像的图像采集后,观察到如图2.4是室内实验仿真小车原图,目标颜色特征清晰。当使用基于颜色的特征点提取方法提取红色目标时,得到了如图2.5的室内实验基于颜色的特征提取图。这种方法通过分析各种红色的RGB空间分布的特征,对与红色和与其相近的颜色进行特征提取,这种方法算法简单快速,并且能够将目标车辆的大致轮廓提取出来,但是结果可能会存在噪点,需要通过连通域分割方法进行后续的处理。同时由于室内实验使用的仿真车辆虽然整体车身是红色,但是也有不是红色的车轮,车窗等区域,所以提取的车身不够清晰完整,导致在进行车辆图像的分割时,虽然能够很好的通过连通域分割方法将大小噪点去除,只留下目标车辆的区域,但是最终处理结果还是存在下部分车身缺失的问题。这可能会影响最终实验结果的精度。

二、室外实验结果分析

在室外实验中,基于颜色的特征方法并不适用,实验车辆并无明显的颜色特征。此外,实验道路背景相较于室内更复杂多变,颜色也多种多样。因此在实际的处理过程中,改用背景减除法提取车辆特征。当使用基于背景减除法的特征点提取方法提取目标车辆时,可以得到如图2.8的室外实验某一时刻背景消除法特征提取图。观察如图2.8发现,由于光照变化和背景变化等原因,虽然可以识别目标车辆,但是从图2.13 室外实验提取特征后的噪点图中可以发现在目标区域外,还存在许多的白色小噪点。这些白色小噪点连通域面积相比于目标车辆的连通域面积更小。在处理过程中研究对连通域面积进行阈值分割,去除连通域面积小于2000的对象,只留下目标车辆区域。背景消除法通过使用当前帧减去背景帧的原理,在车辆的移动过程中,相较于背景而言变化较大,易于识别,所以提取出来的车身轮廓非常完整清晰,但是对于车轮和车窗区域,识别效果仍然不是很理想。

第三章 图像坐标系和道路坐标系的映射关系

在车辆位置视觉检测方法中建立图像坐标系和道路坐标系之间映射关系是不可或缺的一步,用描述两坐标系之间的映射关系的数学模型决定了图像坐标系在转换成道路坐标系的精度和误差[20]。由于测量的结果是道路坐标,所以映射关系应当是从图像坐标系映射到道路坐标系,图像坐标系与道路坐标系映射对应点坐标已通过图像处理求得,本章就是运用不同的方法求得映射函数。

第一节 坐标系

坐标系是一个用于表示平面或空间中点位置的系统,它由一组坐标轴和一组标记在轴上的数值组成。在平面坐标系中,通常使用水平的x轴和垂直的y轴来表示点的位置。在本研究中主要涉及图像坐标系和道路坐标系。

一、图像坐标系

图像坐标系,是指在每张图片中以二维图像为基准建立的坐标系,如图3.1所示,以左上角为原点Opixel,横坐标u、纵坐标v,来描述图片中各像素点的位置,来表示该像素点所在的列,

表示像素点所在的行。本研究中使用图像坐标系来描述目标车辆在图像中的位置,在本文中简称为车辆图像位置。表达式为图像坐标(u,v)。

二、道路坐标系

道路坐标系是以世界中得某个点建立坐标系来描述物体在世界中的位置,主要用来描述道路中的车辆的位置,表达式为道路坐标(X,Y)。室内实验道路坐标系如图3.2所示,以黑白方格标定板中心线直线距离87cm的三脚架正下方为原点,以X为横坐标,以Y为纵坐标。从摄像机视角看,向右为X正方向,向上为Y正方向进行展开。室外实验道路坐标系如图3.3所示,以斑马线的第二个白色长方形的右下角点为原点,以X为横坐标,Y为纵坐标,从摄像机视角看,向左为X正方向,向上为Y正方向进行展开。将指定点设为A点,A点的道路坐标为(500,0)。

第三节 基于BP神经网络的映射关系

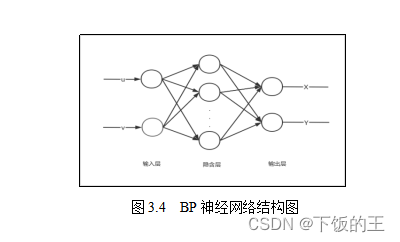

BP神经网络是一种经典的前馈神经网络模型,其基本原理是利用误差反向传播算法进行训练,通过多次迭代调整网络权值和阈值,使得网络能够完成对输入数据的映射关系[21]。

在BP神经网络中,输入层接收外部输入数据,中间隐藏层通过对输入数据进行非线性变换,提取出数据的特征信息,并传递给输出层。输出层对隐藏层输出的结果进行加权求和,并经过激活函数的处理后,得到最终的输出结果。

在训练过程中,BP神经网络通过计算输出结果与实际结果之间的误差,利用误差反向传播算法逐层调整网络的权值和阈值。具体来说,误差反向传播算法根据误差值计算每个神经元的梯度,然后根据梯度更新该神经元的权值和阈值。通过多次迭代更新,最终使得网络的输出结果能够与实际结果相符,从而完成对输入数据的映射关系。

BP神经网络是一种基于误差反向传播算法的前馈神经网络模型,其能够通过多次迭代调整网络的权值和阈值,完成对输入数据的映射关系。在实际的处理中,研究将样本点的图像坐标系中的横坐标u和纵坐标v作为BP神经网络的输入,将样本点道路坐标系中横坐标X和纵坐标Y作为BP神经网络的输出,构建了一个双输入双输出的BP神经网络模型。如图3.4是BP神经网络的结构图。建立的BP神经网络结构如图3.4所示。

回归分析是一种用于研究变量之间关系的统计方法。在回归分析中,试图找到一个映射关系,使得一个或多个自变量可以用来预测一个因变量的值。这个映射关系可以用一个数学方程来表示,通常是一个线性方程。

在回归分析中,自变量是用来预测因变量的变量,而因变量是希望预测的变量。

回归分析可以用来建立一种映射关系,使得可以用已知的自变量值来预测因变量的值。这种关系可以用回归方程来表示:

其中,Y是因变量,X是自变量,a和b是常数,称为回归系数。通过回归分析,然后可以确定a和b的值,从而得到一个用于预测Y的方程。

回归模型是一种预测性的建模技术,它研究的是因变量(目标)和自变量(预测器)之间的关系。在位置视觉测量中可以通过已知的图像坐标点求出目标在地面坐标系中的坐标,验证图像坐标系和道路坐标系是存在某种映射关系的,而回归分析能够对已确定的自变量与因变量的相关系数进行求解,通过研究图像坐标横坐标u和道路坐标X或图像坐标v和道路坐标Y建立回归模型,即可使用回归分析对位置进行预测。由于u,v同时与X或Y存在关系,所以可使用多元回归分析进行位置预测。通过上述关系,可以建立多元回归模型,其多元线性回归方程:

在回归方程3-2和3-3中图像坐标u,v是自变量,道路坐标X和Y分别对应两个方程的因变量,ak和bk(k=0,1,2,3)则为回归方程待求解的系数,回归系数可以用最小二乘法求解[22]。

本章分别运用了基于BP神经网络的映射关系和基于回归分析的映射关系两种方法求得映射函数。

一、室内实验结果与分析

BP神经网络在室内实验实际的训练过程中使用了已知的504个样本的图像坐标(u,v)和504个样本点的道路坐标(X,Y),其中450个是训练样本。54个是测试样本,研究通过测试样本来判断研究过程中建立的BP神经网络的性能。下表1是54个测试样本点中随机选择的部分数据的测试样本的图像坐标和道路坐标以供参考。将BP神经网络中450个的训练样本输出的值和54个测试样本道路坐标进行检验。得到如图3.5的室内实验BP神经网络性能图。图3.5中的蓝色曲线是训练样本,红色曲线是测试样本。可以发现,两个曲线几乎重合,说明在室内实验中建基于BP神经网络建立的映射函数性能较好,可以用于后续的研究。

表1 室内实验部分测试样本点的图像坐标和道路坐标

| 测试样本点的图像坐标 | 测试样本点的道路坐标 | |||

| 序号 | u/像素 | v/像素 | X/cm | Y/cm |

| 1 | 3412.60 | 566.52 | -20 | 267 |

| 2 | 3332.22 | 677.71 | -15 | 252 |

| 3 | 3139.24 | 640.23 | -5 | 257 |

| 4 | 2487.21 | 605.84 | 30 | 262 |

| 5 | 2581.45 | 604.61 | 25 | 262 |

线性回归分析在室内实验实际的训练过程中同样使用了已知的504个样本的图像坐标(u,v)和504个样本点的道路坐标(X,Y),其中450个是训练样本。54个是测试样本。与BP神经网络不同的是,回归分析建立了两个多元线性回归方程,分别计算得出道路坐标的横坐标和纵坐标。将54个测试样本点道路坐标系中的横坐标的映射函数计算结果和其已知的54个样本点的道路坐标的横坐标进行数据拟合得到如图3.6回归分析横坐标的测试样本结果,同理可以得到如图3.7纵坐标的测试样本结果。观察可知。回归分析横坐标的映射函数比纵坐标的映射函数输出的值精度更高。

二、室外实验结果与分析

BP神经网络在室外实验实际的训练过程中使用了已知的40个样本的图像坐标(u,v)和40个样本点的道路坐标(X,Y),其中10个是训练样本。10个是测试样本,研究通过测试样本来判断研究过程中建立的BP神经网络的性能。下表2是10个测试样本点中的图像坐标和道路坐标。如图3.8的室外实验BP神经网络性能图。将BP神经网络中30个的训练样本输出的值和10个测试样本的道路坐标进行检验,得到如图3.8的室外实验BP神经网络性能图。图3.8中的蓝色曲线是训练样本,红色曲线是测试样本。可以发现,两个曲线重合性没有室内的好,室外实验中基于BP神经网络建立映射函数输出数据结果不理想,是因为在室外实验中,由于相机设备的拍摄视野较广,在选取BP神经网络的样本点图像坐标时范围过小,无法像室内实验能够一样在相机的拍摄视野中选取足够的样本点。所以难以预测样本外的区域时。

表2 室外实验部分测试样本点的图像坐标和道路坐标

| 测试样本点的图像坐标 | 测试样本点的道路坐标 | |||

| 序号 | u/像素 | v/像素 | X/cm | Y/cm |

| 1 | 1346 | 650 | 0 | 450 |

| 2 | 1318 | 637 | 0 | 513 |

| 3 | 1314 | 631 | 0 | 553.5 |

| 4 | 1289 | 620 | 0 | 614 |

| 5 | 1284 | 613 | 0 | 655 |

| 6 | 1260 | 603 | 0 | 716 |

| 7 | 1254 | 596 | 0 | 756 |

| 8 | 1236 | 588 | 0 | 814 |

| 9 | 1228 | 580 | 0 | 859 |

| 10 | 1209 | 572 | 0 | 919 |

第四章 车辆图像位置和道路位置的测量

室内实验车辆位置的测量方法和室外实验的测量方法有一定的差异,实验过程也不尽相同。室内仿真环境不同于室外道路环境,室内仿真环境较好,目标与背景差异明显,且噪声干扰少;而室外道路环境目标与其背景差异不明显,且常常存在噪声干扰。而且用于实验的仿真小车和家用汽车两者之间在颜色和尺寸上差异也十分明显。

车辆图像采集完毕后要进行图像处理以获取目标车辆的图像位置,即目标车辆的像素坐标。

(一)、室内实验车辆图像位置提取

本文针对室内实验,对获取采集的图像进行了图像预处理操作,使用基于颜色的特征提取方法来识别和提取图像中的车辆,并对其进行图像分割及形态学处理。通过定位处理后的二值化图像中白点来检测和定位目标车辆,并从图像中提取车辆的位置信息,得出目标车辆的图像位置。

(二)、室内实验车辆图像位置测量结果与分析

室内实验中车辆图像位置的人工测量值和算法提取测量值记录在表3。通过使用算法测量值减去人工测量值得到它们的绝对误差,以及用绝对误差除以人工测量值得到相对误差。红色仿真小车在室内实验图像坐标系的绝对误差与相对误差记录在表4。

表3 红色仿真小车在室内实验图像坐标系的人工测量值和算法测量值

| 图像坐标系的人工测量值 | 图像坐标系的算法测量值 | |||

| 序号 | u1/像素 | v1/像素 | u2/像素 | v2/像素 |

| 1 | 3543 | 2578 | 3529 | 2545 |

| 2 | 3548 | 2575 | 3532 | 2541 |

| 3 | 2553 | 1877 | 2545 | 1867 |

| 4 | 2560 | 1883 | 2547 | 1863 |

表4 红色仿真小车在室内实验图像坐标系的绝对误差与相对误差

| 室内实验图像坐标系的绝对误差 | 室内实验图像坐标系的相对误差 | |||

| 序号 | △u3 | △v3 | &u4/% | &v4/% |

| 1 | 14 | 33 | 0.0039 | 0.0128 |

| 2 | 16 | 34 | 0.0045 | 0.0132 |

| 3 | 8 | 10 | 0.0023 | 0.0039 |

| 4 | 13 | 20 | 0.0037 | 0.0078 |

绝对误差是指测量值与真实值之间的差值的绝对值,通常用于衡量测量结果的准确度。绝对误差越小,说明测量结果越接近真实值,准确度越高。在实际应用中,绝对误差常常与相对误差一起使用,来评估测量结果的精度和可靠性。

相对误差是指用真实值减去测量值,再除以真实值得到的误差值。它用于评估测量结果的准确程度,并可以帮助比较不同数据集之间的误差大小。相对误差通常以百分比的形式表示,公式如下:

相对误差 = (真实值 - 测量值) / 真实值 x 100%

其中,真实值是指被测量的物理量的实际值,而测量值是指使用某种测量工具或方法得到的值。相对误差越小,表示测量结果越接近真实值,准确度越高。

观察表4,对红色仿真小车在X方向的像素坐标最大绝对误差为14,相对误差均在5%以内,在本研究中,相对误差小于5%可以被认为是很精确的,因此测量值u2满足后续实验要求;在Y方向的像素坐标最大绝对误差为34,相对误差均在5%左右,在本研究中,相对误差小于5%可以被认为是很精确的,因此测量值u2满足后续实验要求。

二、室外实验车辆图像位置

(一)、室外实验车辆的图像位置测量

对采集的室外实验的车辆图像进行预处理是目标检测的重要一步,这一步的目的是提高图像质量,为后续的特征提取和目标检测做好准备。在本次室外实验中,使用基于背景减除法的特征提取方法来识别和提取图像中的车辆。这种方法通过对图像中目标物体和背景的差异进行分析,将目标物体从图像中分离出来。在此基础上,进行了图像分割和形态学处理,以进一步提高目标检测的准确性。最终,通过定位处理后的二值化图像中的白点来检测和定位目标车辆,并提取目标车辆的位置信息。获得车辆图像位置。

(二)、室外实验车辆图像位置测量结果与分析

室外实验车辆图像位置的人工测量值和算法提取结果记录在表5。通过使用算法测量值减去人工测量值得到它们的绝对误差,以及用绝对误差除以人工测量值得到相对误差。实验汽车在室外实验图像坐标系的绝对误差与相对误差记录在表6。

表5 室外实验图像坐标系的人工测量值和算法测量值

| 图像坐标系的人工测量值 | 图像坐标系的算法测量值 | |||

| 序号 | u1/像素 | v1/像素 | u2/像素 | v2/像素 |

| 1 | 284 | 727 | 283 | 684 |

| 2 | 460 | 740 | 461 | 711 |

| 3 | 675 | 739 | 676 | 708 |

| 4 | 888 | 732 | 888 | 707 |

| 5 | 1059 | 726 | 1060 | 699 |

表6 在室外实验图像坐标系的绝对误差与相对误差

| 室外实验图像坐标系的绝对误差 | 室外实验图像坐标系的相对误差 | |||

| 序号 | △u3 | △v3 | &u4/% | &v4/% |

| 1 | 1 | 43 | 0.09% | 5.81% |

| 2 | 1 | 29 | 0.09% | 3.92% |

| 3 | 1 | 31 | 0.09% | 4.19% |

| 4 | 0 | 25 | 0% | 3.38% |

| 5 | 1 | 27 | 0.09% | 3.65% |

观察表6,对实验在X方向的像素坐标最大绝对误差为1,相对误差均在5%以内。在本研究中,相对误差小于5%可以被认为是很精确的,因此测量值u1满足后续实验要求;在Y方向的像素坐标最大绝对误差为43,相对误差大部分在5%以内,但还是有个别数据的相对误差超过5%,为了提高最终结果的精度,这里对v2的数据进行修正。

修正的定义式为:

修正值 = 真值 - 测量值

修正是指对测量结果进行调整,以补偿系统误差。修正的目的是使得修正后的测量值更加接近真实值。修正值的计算方法是将真实值减去测量值,即修正值等于真实值与测量值之差。修正后的测量值可以用以下公式计算:

修正后的测量值 = 测量值 + 修正均值

修正均值 = 修正值 / 总数据个数

经过计算,得到修正后的测量值,并记录在下表7。观察表7,修正后的测量值的绝对误差和相对误差都在误差研究允许范围之内。因此测量值u5满足后续实验要求。

表7 室外实验图像坐标系的人工测量值与修正后的算法测量值的绝对误差、相对误差

| 图像坐标系的人工测量值 | 修正后的算法测量值 | 修正后的绝对误差 | 修正后的相对误差 | |||||

| 序号 | u1/像素 | v1/像素 | u2/像素 | 2/像素 | △u3 | △v3 | &u4/% | &v4/% |

| 1 | 284 | 727 | 283 | 715 | 1 | 12 | 0.09% | 1.62% |

| 2 | 460 | 740 | 461 | 742 | 1 | 2 | 0.09% | 0.27% |

| 3 | 675 | 739 | 676 | 739 | 1 | 0 | 0.09% | 0% |

| 4 | 888 | 732 | 888 | 738 | 0 | 6 | 0% | 0.82% |

| 5 | 1059 | 726 | 1060 | 730 | 1 | 4 | 0.09% | 0.54% |

第二节 车辆道路位置测量

一、室内实验车辆道路位置

(一)、室内实验车辆的道路位置测量

由于8*3.5cm的仿真小车的尺寸过小,所以使用车辆的中心点来表示车辆的位置。本文所采用的方法能够有效地检测和定位室内实验中所采集的图像中的目标车辆。为使测量结果更加准确,选择用质心描述目标车辆的位置。查阅资料可知相机在成像时存在畸变,目标会存在一定程度变形,许多形状特征仅描述了目标的局部性质,质心是最能体现一个目标中心的一个特征。通过求取目标区域中所有白点的坐标,再求出目标车辆的质心像素点的图像坐标。

求出目标车辆的质心像素点的图像坐标后,调用建立的BP神经网络和回归模型,通过图像坐标系和道路坐标系的映射关系数学模型对室内车辆位置进行测量,通过相同的实验步骤将室内实验中的不同位置的目标车辆的质心坐标放入模型,即可测得结果。

(二)、室内实验车辆道路位置测量结果与分析

记录室内实验道路坐标系的人工测量值、BP神经网络测量值、线性回归测量值如表8。对表8所记录的测量值进行误差分析,得到室内实验道路坐标绝对误差、相对误差如表9。

表8 室内实验道路坐标系的人工测量值、BP神经网络测量值、线性回归测量值

| 室内实验道路坐标系的人工测量值 | 室内实验道路坐标系BP神经网络的测量值 | 室内实验道路坐标系线性回归的测量值 | ||||

| 序号 | X /cm | Y /cm | XBP/cm | YBP/cm | X回归/cm | Y回归/cm |

| 1 | -15 | 115 | -14.49 | 118.71 | -15.56 | 122.37 |

| 2 | -15 | 115 | -15.22 | 121.48 | -15.67 | 122.82 |

| 3 | 15 | 145 | 15.77 | 151.29 | 16.83 | 164.24 |

| 4 | 15 | 145 | 15.38 | 152.30 | 16.79 | 164.69 |

表9 室内实验道路坐标绝对误差、相对误差

| BP神经绝对误差 | BP神经相对误差 | 线性回归绝对误差 | 线性回归相对误差 | |||||

| 序号 | △XBP | △YBP | &XBP/% | &YBP/% | △X回归 | △Y回归 | &X回归/% | &Y回归/% |

| 1 | 0.5100 | 3.7099 | 3.40% | 2.56% | 0.5600 | 7.3700 | 3.73% | 5.08% |

| 2 | 0.2200 | 6.4800 | 1.47% | 4.47% | 0.6700 | 7.8199 | 4.46% | 5.39% |

| 3 | 0.7700 | 6.2900 | 5.13% | 4.34% | 1.8300 | 19.4200 | 12.20% | 13.39% |

| 4 | 0.3800 | 7.3000 | 2.53% | 5.03% | 1.7900 | 19.6900 | 11.93% | 13.58% |

观察表8,发现对通过基于BP神经网络所求的映射函数得出的测量值在X方向的道路坐标最大绝对误差为0.77cm,最大相对误差5.13%。在Y方向的道路坐标最大绝对误差为7.3cm,最大相对误差为5.03%。通过基于线性回归方程所求的映射函数得出的测量值在X方向的道路坐标最大绝对误差为1.83cm,最大相对误差12.20%。在Y方向的道路坐标最大绝对误差为19.69cm,最大相对误差为13.58%。同时对两种方法的测得值进行修正。获得表10。误差分析得表11。

表10 室内实验道路坐标系的人工测量值和修正后测量值

| 室内实验道路坐标的人工测量值 | 室内实验修正后的BP神经网络测量值 | 室内实验修正后线性回归的测量值 | ||||

| 序号 | X /cm | Y /cm | XBP/cm | YBP/cm | X回归/cm | Y回归/cm |

| 1 | -15 | 115 | -14.85 | 112.7675 | -16.1275 | 108.84000 |

| 2 | -15 | 115 | -15.58 | 115.5375 | -16.2375 | 109.2900 |

| 3 | 15 | 145 | 15.41 | 145.3475 | 16.2625 | 150.71000 |

| 4 | 15 | 145 | 15.02 | 146.3575 | 16.2225 | 151.16000 |

表11 室内实验道路坐标修正后的绝对误差和相对误差

| BP神经绝对误差 | BP神经相对误差 | 线性回归绝对误差 | 线性回归相对误差 | |||||

| 序号 | △XBP | △YBP | &XBP/% | &YBP/% | △X回归 | △Y回归 | &X回归/% | &Y回归/% |

| 1 | 0.15 | -2.23 | -1.00% | -1.54% | -1.13 | 0.07 | -6.16% | -4.24% |

| 2 | -0.58 | 0.53 | 3.86% | 0.37% | -1.24 | 0.08 | -5.71% | -3.93% |

| 3 | 0.41 | 0.34 | -2.73% | 0.24% | 1.26 | -0.08 | 5.71% | 3.94 |

| 4 | 0.02 | 1.35 | -0.13% | 0.94% | 1.22 | -0.08 | 6.16% | 4.25% |

观察表7,发现对通过基于BP神经网络所求的映射函数修正后得出的测量值在X方向的道路坐标最大绝对误差为0.58cm,最大相对误差3.867%。在Y方向的道路坐标最大绝对误差为2.2325cm,最大相对误差为1.539%。通过基于线性回归方程所求的映射函数修正后得出的测量值在X方向的道路坐标最大绝对误差为1.2625cm,最大相对误差5.71%。在Y方向的道路坐标最大绝对误差为0.0841cm,最大相对误差为4.248%。

通过对比,研究发现在室内实验中基于BP神经网络算法所求得的图像坐标系与道路坐标系的映射关系比基于线性回归方程算法更好,误差更小。

二、室外实验车辆道路位置

(一)、室外实验车辆的道路位置测量

为使测量结果更加准确,选择用车的右前方接触地面的点描述仿真车辆图像的位置。因为右前方接触地面的点在实验过程中更加方便测量。求出目标车辆的位置像素点的图像坐标后,由于BP神经模型无法预测标定区域外的点。只能调用建立的回归模型,通过图像坐标系和道路坐标系的映射关系数学模型对室外道路车辆位置进行测量,即可测得结果。在室外实验中,车辆的位置用与X坐标正方向上距离原点500cm处的A点的描述,所以还对获取的道路坐标(X,Y),使用勾股定理计算距离,得出最终结果。

(二)、室外实验车辆道路位置测量结果与分析

对记录的室内车辆的位置用与X坐标正方向上距离原点500cm处的A点的距离真值和测量值进行误差分析,得到下表12。 观察表12,得出距离最大绝对误差为169cm,最小绝对误差为23cm;距离最大相对误差为12.50%,最小相对误差为1.70%;相对误差大于5%的分别为序号1和序号2两组的车辆位置离标定区域较远。产生的误差较大,所以需要对其进行修正。并对修正后的测量值进行误差分析,记录在表13。

表12 室外实验距离A点的人工测量、线性回归测量值、绝对误差、相对误差

| 人工测量值 | 线性回归测量值 | 绝对误差 | 相对误差 | |

| 序号 | L1/cm | L2/cm | △L3 | &L4 |

| 1 | 1352 | 1521 | 169 | 12.50% |

| 2 | 1129 | 1221 | 92 | 6.80% |

| 3 | 835 | 864 | 29 | 2.14% |

| 4 | 537 | 514 | 23 | 1.70% |

| 5 | 303 | 241 | 62 | 4.59% |

表13 室外实验距离A点修正后的人工测量、线性回归测量值、绝对误差、相对误差

| 人工测量值 | 修正后的线性回归测量值 | 绝对误差 | 相对误差 | |

| 序号 | L1/cm | L2cm | △L/cm | &L/cm |

| 1 | 1352 | 1391 | 39 | 2.88% |

| 2 | 1129 | 1091 | -38 | -2.81% |

| 3 | 835 | 864 | 29 | 2.14% |

| 4 | 537 | 514 | -23 | -1.70% |

| 5 | 303 | 241 | -62 | -4.59% |

观察表12可以发现,修正后的测量值最大绝对误差为62cm,最小绝对误差为23cm;距离最大相对误差为4.59%,最小相对误差为1.70%;相对误差均在5%以内。

第五章 结论和展望

第一节 结论

本文主要研究基于路侧摄像头的车辆位置视觉检测方法,实验主要分为室内实验和室外实验两个方向进行,分别运用了不同的特征提取方法,以及使用两种不同的方法求取图像坐标系和道路坐标系的映射关系。通过提取车辆图片的信息,得到目标车辆的图像坐标,再调用所求的映射函数得出测量值。通过对实验结果的简要分析,可以知道BP神经网络算法和回归分析适用的不同的条件,虽然用BP神经网络建立的映射函数的精度比回归分析要更好,但是在室外实验中回归分析建立的映射模型要更好,BP神经网络无法预测样本区域外的点,效果并不理想。终上所述,使用BP神经网络和回归分析各有不同的优缺点。

第二节 展望

本文对基于路侧摄像头的车辆位置视觉检测方法进行了研究。但由于初步涉及该研究领域,对机器视觉研究的相关算法和分析方法的运用还有待提高,因此本文中谈及的算法还有继续完善和深入研究的空间。

在算法部分,对BP网络,由于初步掌握BP网络的基本知识,所以在对BP网络模型的参数还有优化的空间,该算法的测量精度还有待提高;对回归分析,影响测量结果的主要因素有两个,一是假设的回归方程与问题的匹配度,二是回归方程的维度,通过优化回归方程和适当提高回归方程的维度,也可以达到提高测量精度的目的。

室内实验和室外实验在环境、光照、拍摄条件等方面存在较大的差异,因此它们的对比性较弱。在进行视觉检测实验时,实验准备十分关键。在室内实验中,可以通过控制光源和背景等因素,来保证光线均匀和光照条件稳定,从而提高图像质量。同时,在实验布局上,选择适当的摄像头位置和角度,能够有效地捕捉车辆的运动状态和位置信息,为后续的视觉检测方法提供有效的图像数据。但是实验过程中没有考虑周全。

总结

本文介绍了基于路侧摄像头的车辆位置视觉检测方法,并提出了一种基于颜色的特征点提取方法和基于背景减除法的特征点提取方法,并对它们的基本原理进行简单的介绍。同时,我们还介绍了车辆图像的采集和处理、图像坐标系与道路坐标系的映射关系建立以及车辆位置信息的确定方法,这些步骤为车辆位置检测提供了关键性的支持。

基于颜色的特征点提取方法通过颜色空间的变换和阈值的设定来提取车辆的颜色特征,对车辆的检测效果较好,但对于光照变化和阴影的鲁棒性不足。基于背景减除法的特征点提取方法通过对图像的前景和背景进行分离,可以有效地减少光照变化和阴影对车辆检测的影响,但对于背景的变化和干扰比较敏感,需要对算法进行进一步优化。

在图像采集和处理方面,我们介绍了常见的图像预处理方法,包括图像灰度化、二值化等,以及对采集到的车辆图像进行的特征提取和图像处理方法,这些方法可以提高车辆位置检测的准确性和可靠性。

在图像坐标系与道路坐标系的映射关系建立方面,我们提出了基于BP神经网络算法和基于回归分析算法的两种数学模型,可以根据实际应用场景选择合适的方法来建立映射关系模型。

最后,在车辆位置信息的确定方面,我们介绍了如何通过图像处理和坐标系转换来确定车辆在道路上的位置信息。通过本文的研究,我们可以看出,基于路侧摄像头的机器视觉检测方法在车辆位置检测方面具有广阔的应用前景,并且不断完善和优化算法可以进一步提高检测的准确性和可靠性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?