Kafka Broker

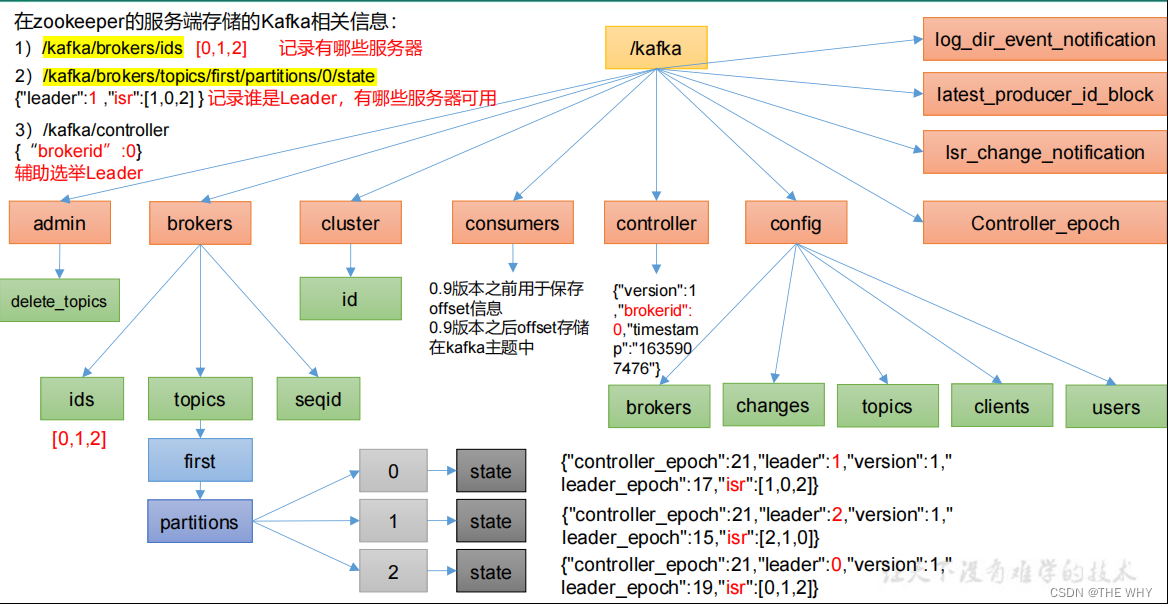

zookeeper存储kafka相关信息

例:

查看kafka信息的相关zk指令

查看当前已启动的broker:ls /kafka/brokers/ids

查看当前controller:get /kafka/controller

查看各个分区的leader和可用服务器相关信息:get /kafka/brokers/topics/first/partitions/0/state

0指的是broker id

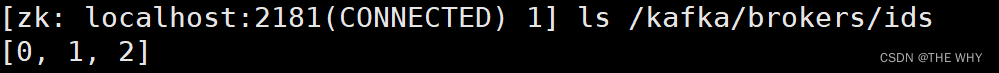

broker工作流程

1)broker启动后在zk中注册:集群中哪一台机器的kafka启动,就在zk中注册其对应的broker id

2)最先注册的broker中的controller负责进行leader选举

6)信息同步是为了controller挂掉之后,替补的controller能正常进行leader选举

10)按例,broker1挂掉了,controller从zk中获取到当前的isr信息,从中剔除1号id,然后按照选举规则选举出新的leader,进而更新zk

broker相关参数

所有的参数配置都在/config/server.properties中进行设置;(大部分都没有默认值,需要手动添加)

broker节点服役和退役

新节点服役:

1.启动新的broker,设置broker id

2.创建一个要均衡的主题:vim topics-to-move.json(主题名自拟)

3.向其中写入内容:

{

"topics": [

{"topic": "first"}

],

"version": 1

}

4.生成一个负载均衡的计划:

bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --topics-to-move-json-file

topics-to-move.json --broker-list "0,1,2,3" --generate

--topics-to-move-json-file:需要进行均衡的主题

--broker-list:共有哪些broker参与均衡

5.创建副本存储计划(所有副本存储在 broker0、broker1、broker2、broker3 中)

新建一个文件:vim increase-replication-factor.json

将上面新生成的内容添加到文件中去

6.执行副本存储计划

bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file

increase-replication-factor.json --execute

--reassignment-json-file:存放副本存储计划的文件名

7.验证副本存储计划:

bin/kafka-reassign-partitions.sh --bootstrap-server hadoop102:9092 --reassignment-json-file

increase-replication-factor.json --verify

新节点退役:

与节点服役的流程相同,区别在于第4步生成负载均衡计划的时候,需要修改broker-list

执行完副本存储计划之后,关闭相关服务器即可

Kafka 副本

副本的作用在于提高数据可靠性;Kafka 默认副本 1 个,生产环境一般配置为 2 个,保证数据可靠性;太多副本会增加磁盘存储空间,增加网络上数据传输,降低效率

副本分类:

Kafka 中副本分为:Leader 和 Follower。Kafka 生产者只会把数据发往 Leader,然后 Follower 找 Leader 进行同步数据

副本组成:

Kafka 分区中的所有副本统称为 AR(Assigned Repllicas)

AR = ISR(和 Leader 保持同步的 Follower 集合)+ OSR(表示 Follower 与 Leader 副本同步时,延迟过多的副本)

leader选举示例

1.启动broker id 为0,1,2的三台机器,创建副本和分区数均为3的topic:testar

查看其信息:

2.关闭broker id为3的服务器:

查看该topic的信息;

可以验证leader的选举规则

分区副本分配策略

分区数大于服务器台数的情况:

例:4台服务器,16个分区(3个副本):

这种情况下每台服务器不只存储一个分区的数据

手动调整副本存储策略:

与服务器上下线类似,需要执行副本存储计划

首先还是创建文件:

{

"version":1,

"partitions":[{"topic":"three","partition":0,"replicas":[0,1]},

{"topic":"three","partition":1,"replicas":[0,1]},

{"topic":"three","partition":2,"replicas":[1,0]},

{"topic":"three","partition":3,"replicas":[1,0]}]

}

向文件中写入副本存储计划,需要注意的是,这里的副本存储计划是手动设置的,不是自动生成的;

如上的内容就表明了3个分区的所有副本全部存储到0和1服务器中;

之后执行该副本存储计划即可

通过查看topic的详细信息(--describe)即可验证

Leader 和 Follower 故障处理细节

首先要明确两个概念:

LEO(Log End Offset):每个副本的最后一个offset,LEO其实就是最新的offset + 1。

HW(High Watermark):所有副本中最小的LEO

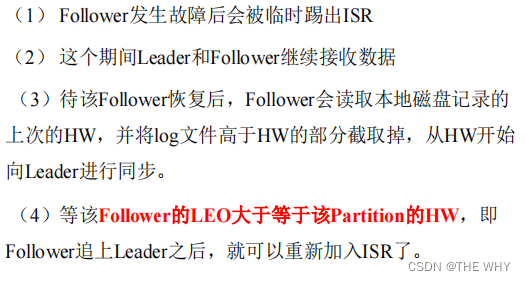

Follower故障

Leader故障

注意:这只能保证副本之间的数据一致性,并不能保证数据不丢失或者不重复

生产经验

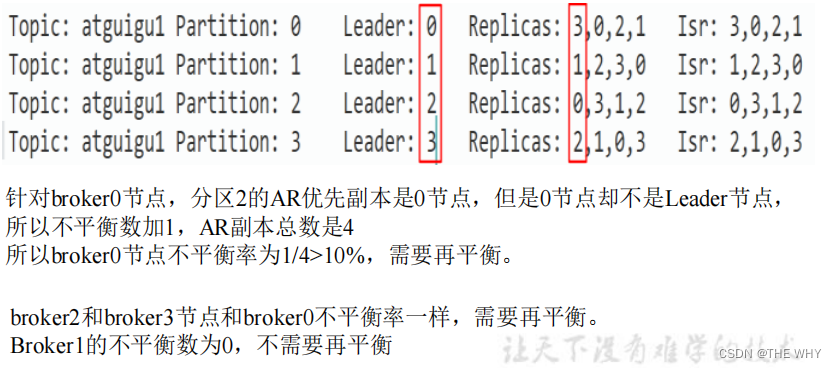

Leader Partition 负载平衡

正常情况下,Kafka本身会自动把Leader Partition均匀分散在各个机器上,来保证每台机器的读写吞吐量都是均匀的。但是如果某些broker宕机,会导致Leader Partition过于集中在其他少部分几台broker上,这会导致少数几台broker的读写请求压力过高,其他宕机的broker重启之后都是follower partition,读写请求很低,造成集群负载不均衡

相关参数:

auto.leader.rebalance.enable:默认是true;自动进行Leader Partition 平衡

注意:在生产环境中,建议设置为 false 关闭,因为leader 重选举的代价比较大,可能会带来性能影响

leader.imbalance.per.broker.percentage

默认是10%。每个broker允许的不平衡的leader的比率。如果每个broker超过了这个值,控制器会触发leader的平衡。

leader.imbalance.check.interval.seconds

默认值300秒。检查leader负载是否平衡的间隔时间

示例:

增加副本因子

在生产环境当中,由于某个主题的重要等级需要提升,可以增加副本

1.创建topic:

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --create --partitions 3 --replication-factor 1 --topic four

可以看到只有一个副本

2.创建副本存储计划,手动写入要增加的副本

示例:

{"version":1,"partitions":[{"topic":"four","partition":0,"replica

s":[0,1,2]},{"topic":"four","partition":1,"replicas":[0,1,2]},{"t

opic":"four","partition":2,"replicas":[0,1,2]}]}

通过手动的修改,将副本数增加到了3个,在其他两台服务器上也进行副本的备份

3.执行副本存储计划即可

文件存储机制

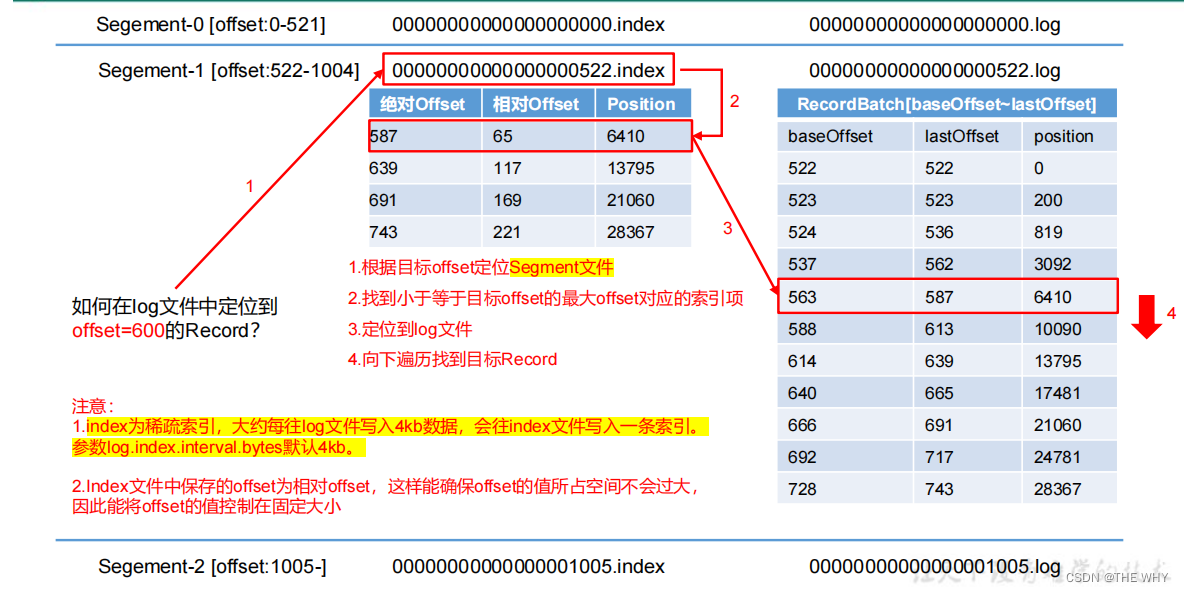

kafka的每个partition对应于一个log文件,该log文件中存储的就是Producer生产的数据。Producer生产的数据会被不断追加到该log文件末端,为防止log文件过大导致数据定位效率低下,Kafka采取了分片和索引机制,将每个partition分为多个segment(默认大小为1G);每个segment包括:“.index”文件、“.log”文件和.timeindex等文件

segment命名规则:topic名称+分区序号

例:

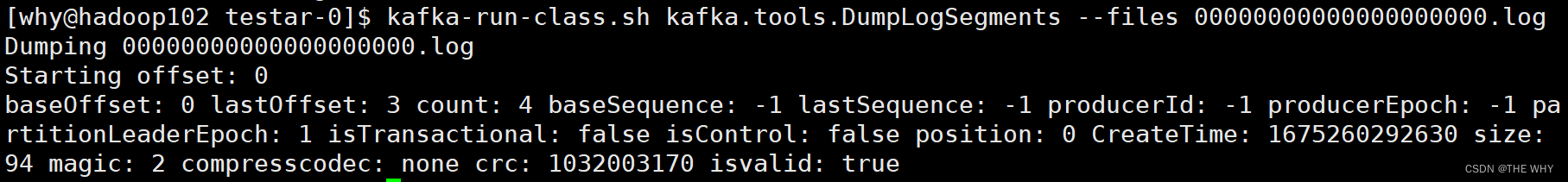

查看文件内容

直接cat查看会出现乱码

正确方法:

kafka-run-class.sh kafka.tools.DumpLogSegments --files 文件名

查看.index

查看.log:

log文件和index文件详解

1.每存储1G的数据,分为一个segment

2.需要注意,index为稀疏索引,其中保存的offset为相对offset

对应上图中的

3.查找某一条记录时,先根据其offset找到所在的segment,然后根据相对offset计算其index索引,根据索引中的position到RecordBatch中找到相应的位置,向下查找即可

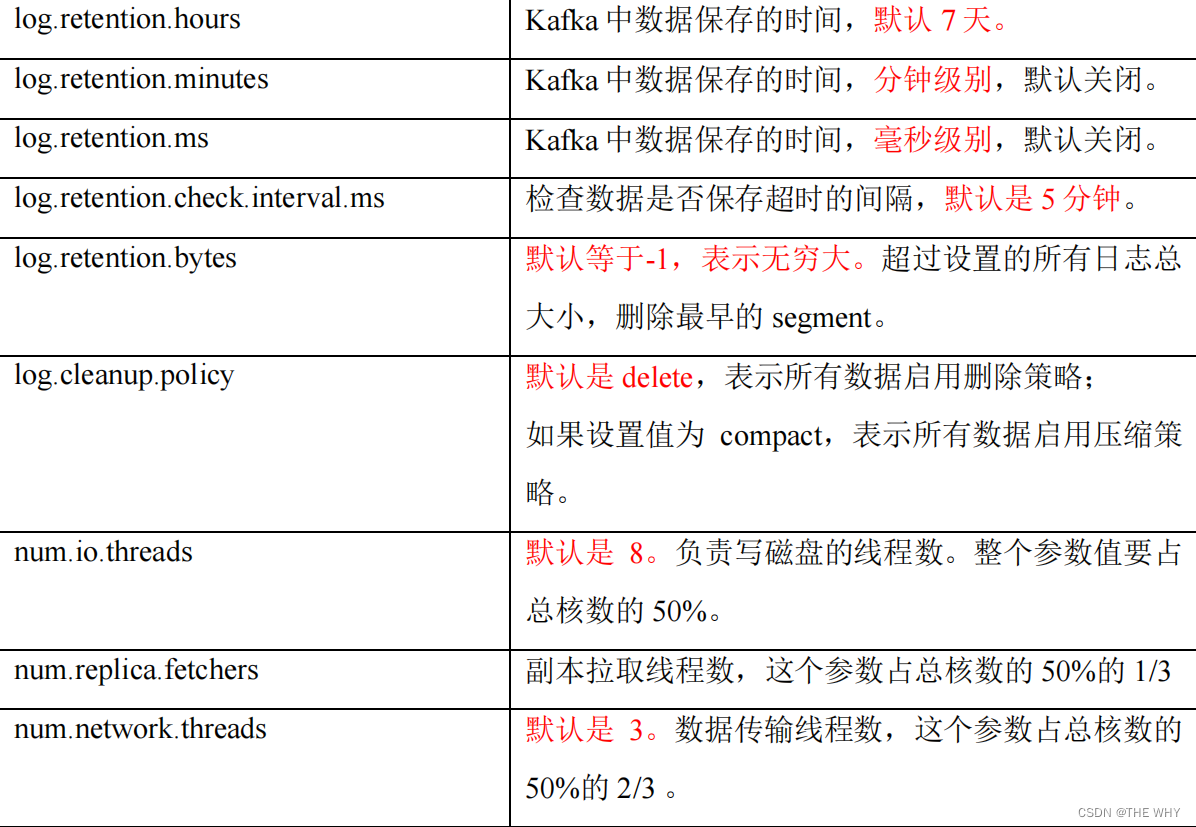

文件清理策略

日志保存时间设置:

log.retention.hours,最低优先级小时,默认 7 天。

log.retention.minutes,分钟。

log.retention.ms,最高优先级毫秒。

log.retention.check.interval.ms,负责设置检查周期,默认 5 分钟

日志清理策略设置:

log.cleanup.policy = delete/compact

delete:删除策略

(1)基于时间:默认打开。以 segment 中所有记录中的最大时间戳作为该文件时间戳。

(2)基于大小:默认关闭。超过设置的所有日志总大小,删除最早的 segment。

log.retention.bytes,默认等于-1,表示无穷大

compact:压缩策略

对于相同key的不同value值,只保留最后一个版本

这种策略只适合特殊场景,比如消息的key是用户ID,value是用户的资料,通过这种压缩策略,整个消息集里就保存了所有用户最新的资料

高效读写数据

策略:

采用分区技术,并行度高

读数据采用稀疏索引,可以快速定位要消费的数据

顺序写磁盘;Kafka 的 producer 生产数据,要写入到 log 文件中,写的过程是一直追加到文件末端,为顺序写。官网有数据表明,同样的磁盘,顺序写能到 600M/s,而随机写只有 100K/s。这与磁盘的机械机构有关,顺序写之所以快,是因为其省去了大量磁头寻址的时间

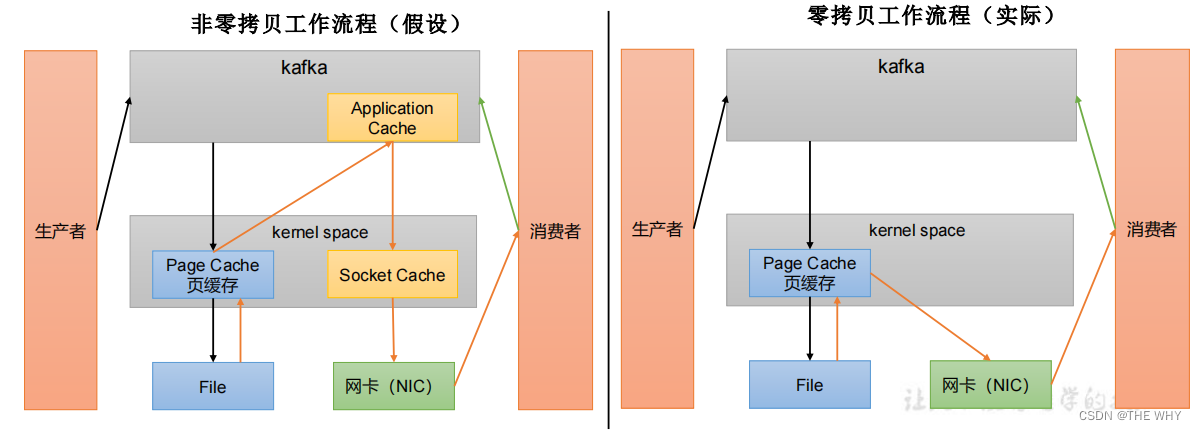

页缓存 + 零拷贝技术

零拷贝:Kafka的数据加工处理操作交由Kafka生产者和Kafka消费者处理。Kafka Broker应用层不关心存储的数据(对数据的操作都在生产者和消费者应用层完成),所以就不用走应用层,传输效率高

PageCache页缓存:Kafka重度依赖底层操作系统提供的PageCache功能。当上层有写操作时,操作系统只是将数据写入PageCache。当读操作发生时,先从PageCache中查找,如果找不到,再去磁盘中读取。实际上PageCache是把尽可能多的空闲内存都当做了磁盘缓存来使用。

相关参数:

log.flush.interval.messages:强制页缓存刷写到磁盘的条数,默认是 long 的最大值,9223372036854775807。一般不建议修改,交给系统自己管理

log.flush.interval.ms:每隔多久,刷数据到磁盘,默认是 null。一般不建议修改,交给系统自己管理

1351

1351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?