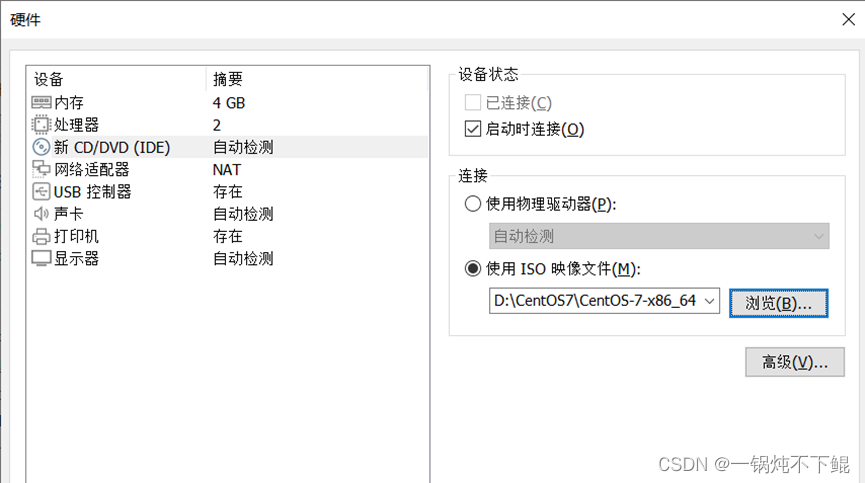

1镜像准备

CentOS-7-x86_64-Minimal-2009.iso

2、虚拟机配置

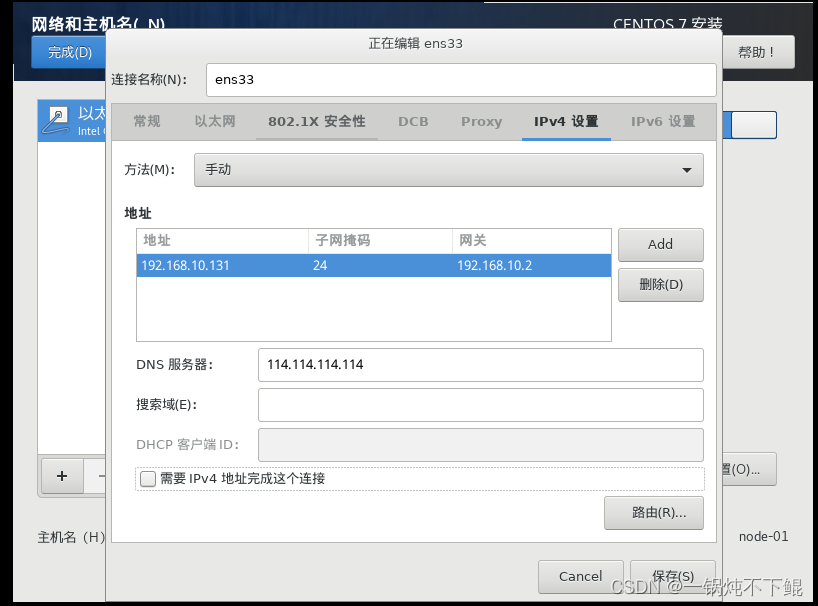

2.1提前设置静态网络

2.2安装net-tools

yum upgrade

yum net-tools.x86_64 -y

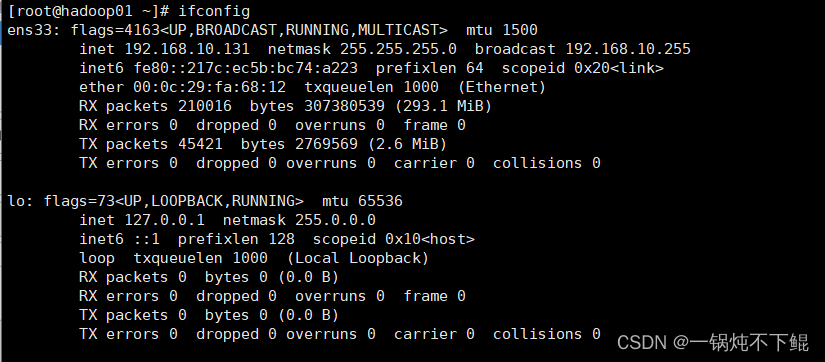

2.3查看本机id

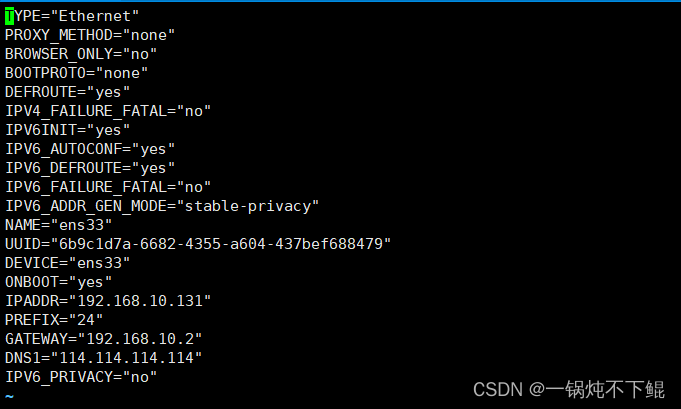

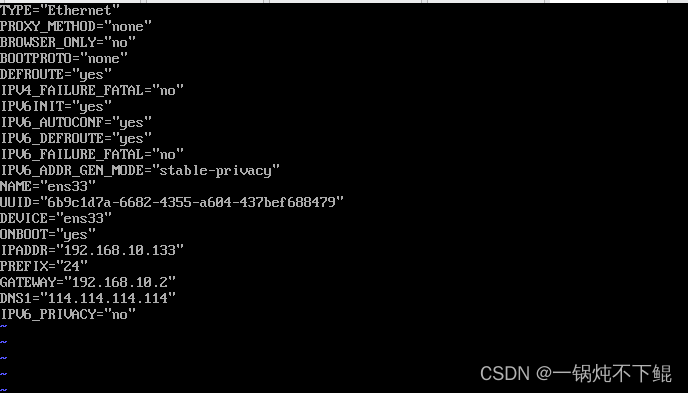

2.4查看网络配置文件

vi /etc/sysconfig/network-scripts/ifcfg-ens33

已经提前设置为静态不需要修改哦

2.5查看,修改主机名

vi /etc/hostname

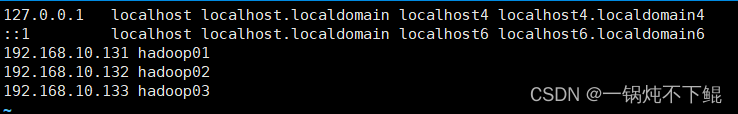

3、配置hosts文件

修改hosts配置文件(所有虚拟机都需要配置此文件)

4、克隆虚拟机

修改Hadoop02/03的网络配置文件

5、重启网络

![]()

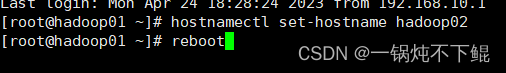

6、修改虚拟机名在重启更新主机名

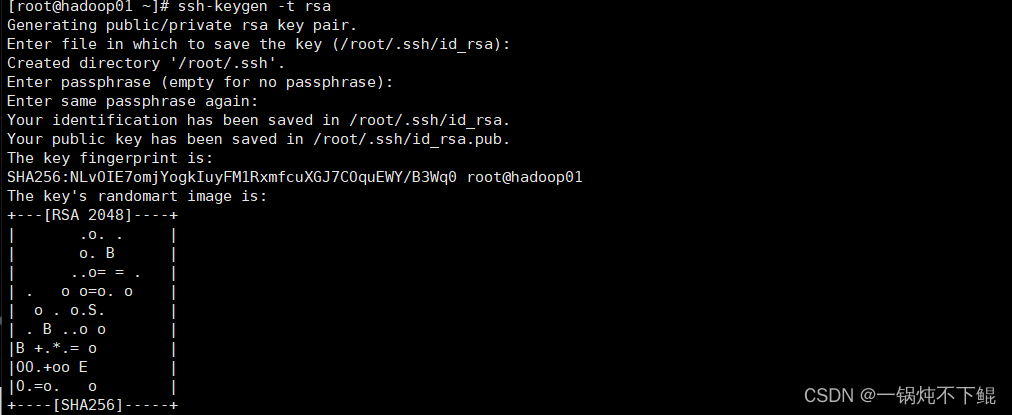

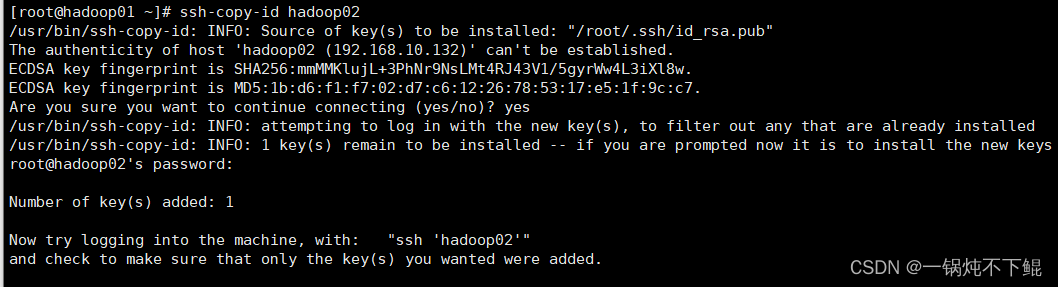

7、ssh免密登录

回车四次

将本机公钥文件复制到其它虚拟机上(接收方需先开机)

![]()

8、HADOOP集群配置

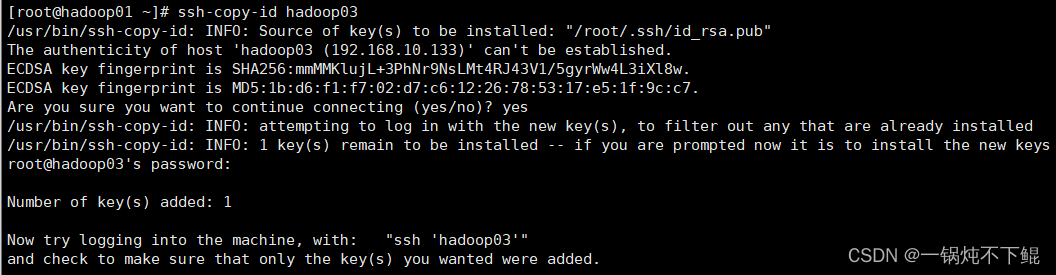

8.1在所有虚拟机根目录下创建文件夹

8.2准备安装包

hadoop-2.7.3.tar.gz

jdk-8u144-linux-x64.tar.gz

8.3在Xshell先进入software文件内,然后下载rz命令,并使用rz命令进行文件上传,此时会弹出上传的窗口,选择要上传的文件,点击确定即可将本地文件上传到Linux上。

![]()

8.4安装jdk

解压jdk

tar -zxvf jdk-8u144-linux-x64.tar.gz -C /export/servers/

重命名jdk文件目录

![]()

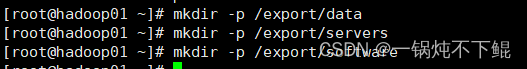

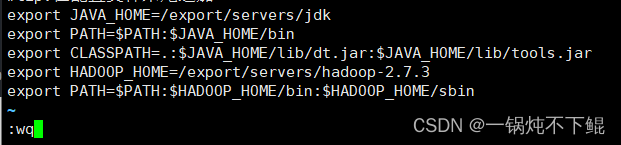

配置环境变量

vi /etc/profile

使配置生效

source /etc/profile

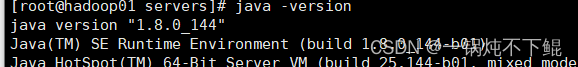

查看配置是否成功

8.5安装hadoop-2.7.3

解压文件到servers目录

tar -zxvf hadoop-2.7.3.tar.gz -C /export/servers/

打开配置文件

vi /etc/profile

使配置生效

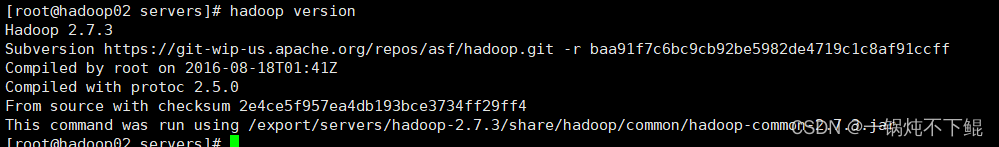

查看是否配置成功

9、Hadoop集群配置

9.1进入主节点配置目录

![]()

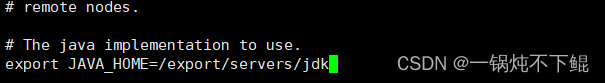

9.2修改hadoop-env.sh文件

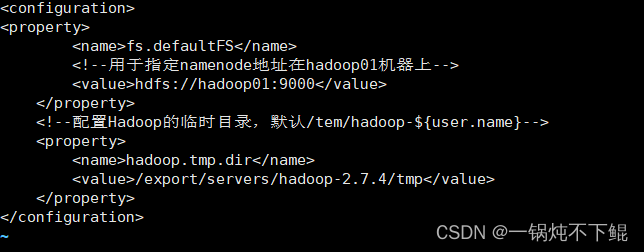

9.3 修改core-site.xml文件

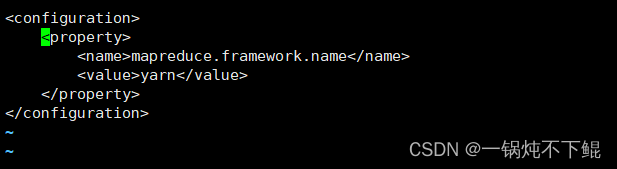

9.4 修改mapred-site.xml文件

![]()

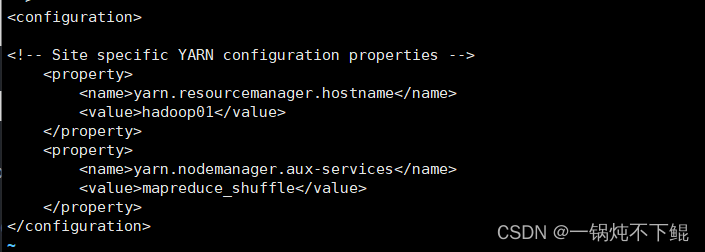

9.5 修改yarn-site.xml文件

vi yarn-site.xml

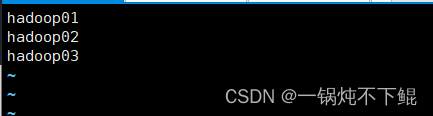

9.6 修改slaves文件

Vi slaves

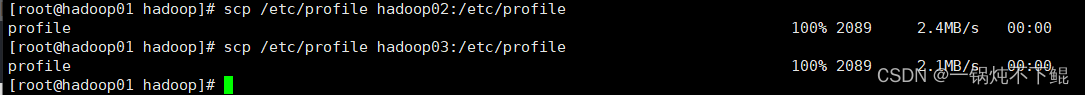

9.7 将主节点中配置好的文件和hadoop目录copy给子节点

scp /etc/profile hadoop02:/etc/profile

scp /etc/profile hadoop03:/etc/profile

scp -r /export/ hadoop02:/

scp -r /export/ hadoop03:/

9.8使字节点中的配置文件生效

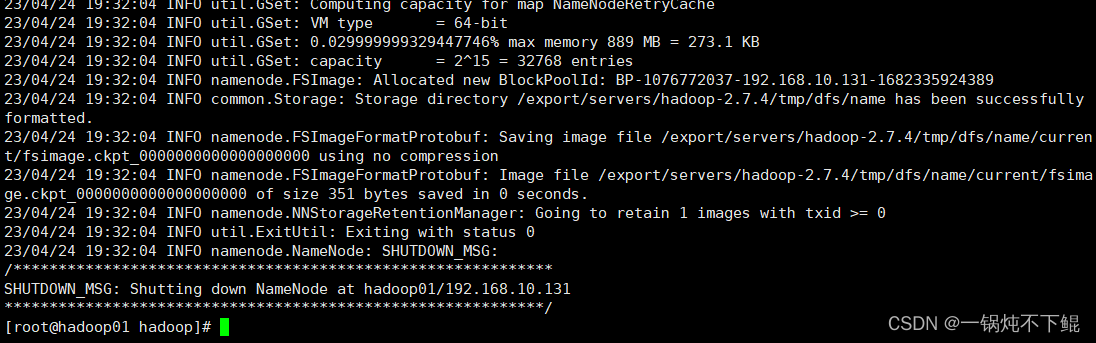

10、在主节点格式化文件系统(successfully formatted 格式化成功)

hdfs namenode -format

出现successful代表格式化成功

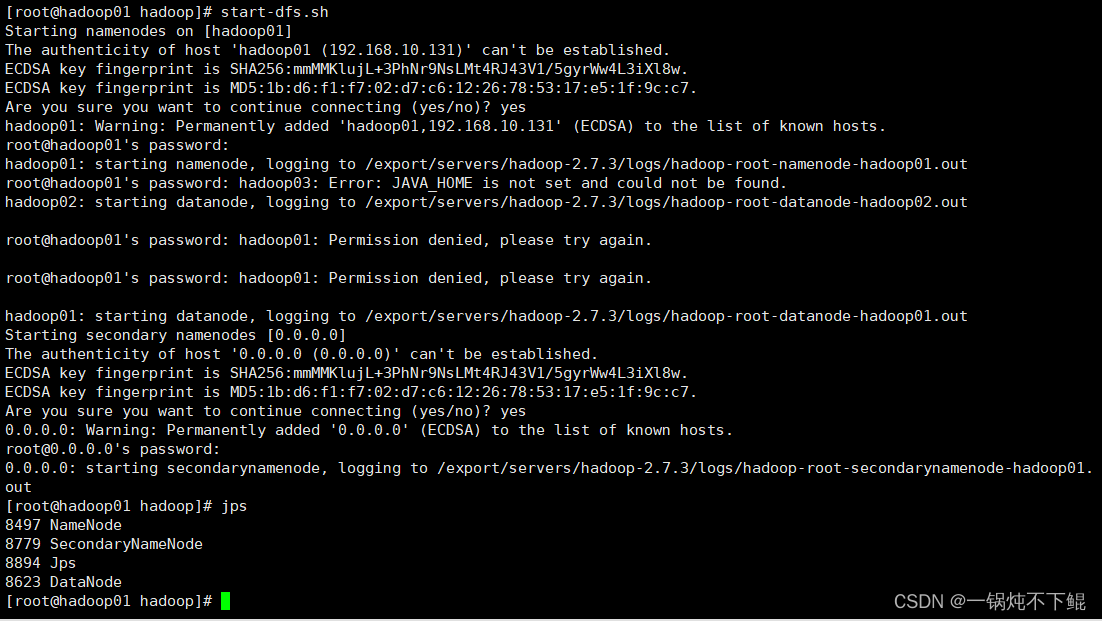

11、Hadoop集群测试

启动集群

start-dfs.sh

start-yarn.sh11.1在主节点启动所有HDFS服务进程

3581

3581

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?