目录

SD3-512*(仅提供 Inference)*

Huggingface:https://huggingface.co/stabilityai/stable-diffusion-3-medium/tree/main

SD1.5的基础模型是用512x512的size训练, 相较于 SDXL,SD3 拥有更强的语义理解能力,更真实的人像体验,更丰富的细节,更准确的文字生成。

此次开放的模型准确来说是 Stable Diffusion 3 Medium,包含 20 亿参数,具有体积小、适合在消费级 PC 和笔记本电脑上运行的优点,所以普通人也可以将其部署到自己的电脑上使用。SD3 Medium 的优点包括:

① 图像质量整体提升,能生成照片般细节逼真、色彩鲜艳、光照自然的图像;能灵活适应多种风格,无需微调,仅通过提示词就能生成动漫、厚涂等风格化图像;具有 16 通道的 VAE,可以更好地表现手部以及面部细节。

② 能够理解复杂的自然语言提示,如空间推理、构图元素、姿势动作、风格描述等。对于「第一瓶是蓝色的,标签是“1.5”,第二瓶是红色的,标签是“SDXL”,第三瓶是绿色的,标签是“SD3”」这样复杂的内容,SD3 依旧能准确生成,而且文本效果比 Midjourney 还要准确。

③ 通过 Diffusion Transformer 架构,SD3 Medium 在英文文本拼写、字距等方面更加正确合理。Stability AI 在发布 SD3 官方公告时,头图就是直接用 SD3 生成的,效果非常惊艳。

stable-diffusion-3-medium 的模型一共有三个:sd3_medium_incl_clips.safetensors、sd3_medium_incl_clips_t5xxlfp8.safetensors、sd3_medium_incl_clips_t5xxlfp16.safetensors,带 t5xxlf 的模型相比不带 t5xxlf 的模型就是文字生成能力更强,fp8 相对于 fp16 就是质量生成方面会有所降低,但是更省资源,达成一个质量换资源的平衡。其实官方是提供了 4 个模型的,不过最最小的那个模型需要特殊的工作流并且搭配特定的文本编码器才行,还得下十几个 G 的模型没必要,直接用上边这三个模型就可以了,已经把文本编码器内置了。

基础模型大概需要 8G 显存,t5xxlfp8 大概需要 12G 的显存,t5xxlfp16 大概需要 16G 的显存。

SD3.5*(仅提供 Inference)*

https://github.com/Stability-AI/sd3.5

6 月的时候,Stability AI发布了 Stable Diffusion 3 Medium,但是在在 FLUX 发布后 SD3 基本沦为弃子,由于各方面都被 FLUX 吊打,加上Stability AI 的霸王条款让 SD3 口碑直线下滑。这次官方吸取了教训,进一步开发了 3.5 版本,并且承诺SD3.5 即为构建者和创作者提供可广泛访问、尖端且在大多数用例中免费的工具。

目前两个版本的介绍:

Stable Diffusion 3.5 Large:该基本模型具有 80 亿个参数,具有卓越的质量和及时的依从性,是 Stable Diffusion 系列中最强大的。此型号非常适合 1 MP 分辨率的专业用例。

Stable Diffusion 3.5 Large Turbo:Stable Diffusion 3.5 Large 的精简版本只需 4 个步骤即可生成具有出色快速粘附性的高质量图像,使其比 Stable Diffusion 3.5 Large 快得多。官方声称还有个 Medium 版本将在 10 月 29 号发布:【github已经发布Medium的inference】

在线体验 Large 在线体验:https://huggingface.co/spaces/stabilityai/stable-diffusion-3.5-large

Turbo 在线体验:https://huggingface.co/spaces/stabilityai/stable-diffusion-3.5-large-turbo

模型下载 Large 下载:https://huggingface.co/stabilityai/stable-diffusion-3.5-large

Turbo 下载:https://huggingface.co/stabilityai/stable-diffusion-3.5-large-turbo

出图效果

SD3.5 的出图非常占显存即使是 4090 24G 显存也非常容易被跑满,正常跑一张 1024*1024 的图大概要 40s

总结

SD3.5人物的手还是有问题,可能开发团队也知道这些问题,所以藏手的情况会比FLUX更明显一点。优点是SD3.5出图有时候更写实,FLUX对皮肤的绘制一般都比较油腻,SD3.5比较细腻更真实一点,长文本和提示词遵循的效果两者都差不多,美学方面有时候SD3.5会更好一些,性能方面SD3.5不如FLUX,出图比FLUX久显存占用还更多,不过目前FLUX生态更完善,所以短时间SD3.5应该还是超越不了FLUX的。

SDXL-1024*(训练、数据集均开源)*

基础信息

**论文:**SDXL: Improving Latent Diffusion Models for High-Resolution Image Synthesis

**组织:**Stability AI, Applied Research

论文地址:*https://arxiv.org/pdf/2307.01952.pdf*

代码地址:*https://github.com/Stability-AI/generative-models (训练、数据集均开源)*

模型权重:*https://huggingface.co/stabilit*

- 更高的分辨率:SDXL 1.0的基础分辨率为1024 x 1024,比其前身产生了更好的图像细节,同时SDXL 1.0处理宽高比效果更好(宽高比“拉伸”越严重,出现变形和突变的可能性就越大)

- 微调和高级控制:使用SDXL 1.0,微调模型以适应自定义数据比以往更容易。可以使用更少的数据整理来生成自定义LoRAs或检查点。Stability AI团队正在构建T2I/ControlNet专门针对SDXL构建下一代的特定任务结构、样式和组成控制。

分辨率

SDXL是在1024 x 1024的图像上训练的。虽然可以以512x512的分辨率生成图像,但结果质量较低,会出现变形。为了获得最佳效果,应该将高度和宽度都保持在1024。SDXL 1.0也支持超过1024的分辨率。这里有一些常见的分辨率,它们使用1024作为最小值,您可以尝试:

- 16:9(电影摄影)1820宽度x 1024高度

- 3:2(专业摄影)1536宽度x 1024高度

- 4:3(普通图片)1365宽度x 1024高度

这里需要注意的是:您的宽高比“拉伸”越严重,出现变形和突变的可能性就越大。

采样步数

在之前基于SD 1.5微调的模型中一般采样步数设置为20就能取得不错的图片。但是在SDXL中,如果将采样步数设置为20会给人一种图片精细度不够,给人一种并没有画完的感觉。因此可以将采样步数适当调大,这样可以获得更好的出图质量。当然这就需要更好的显卡和更大的现存。具体调多大,还是要根据你本地显卡的算力才取舍。

采样器

采样方法对SDXL 1.0来说比以前的版本更重要。建议使用任何DPM++采样器,特别是带有Karras采样器的DPM++。比如DPM++ 2M Karras或DPM++ 2S a Karras。

Prompt: Portrait photo of an anthropomorphic farmer cat holding a shovel in a garden vintage film photo

Negative Prompt: anime, cartoon, graphic, text, painting, crayon, graphite, abstract, glitch, deformed, mutate

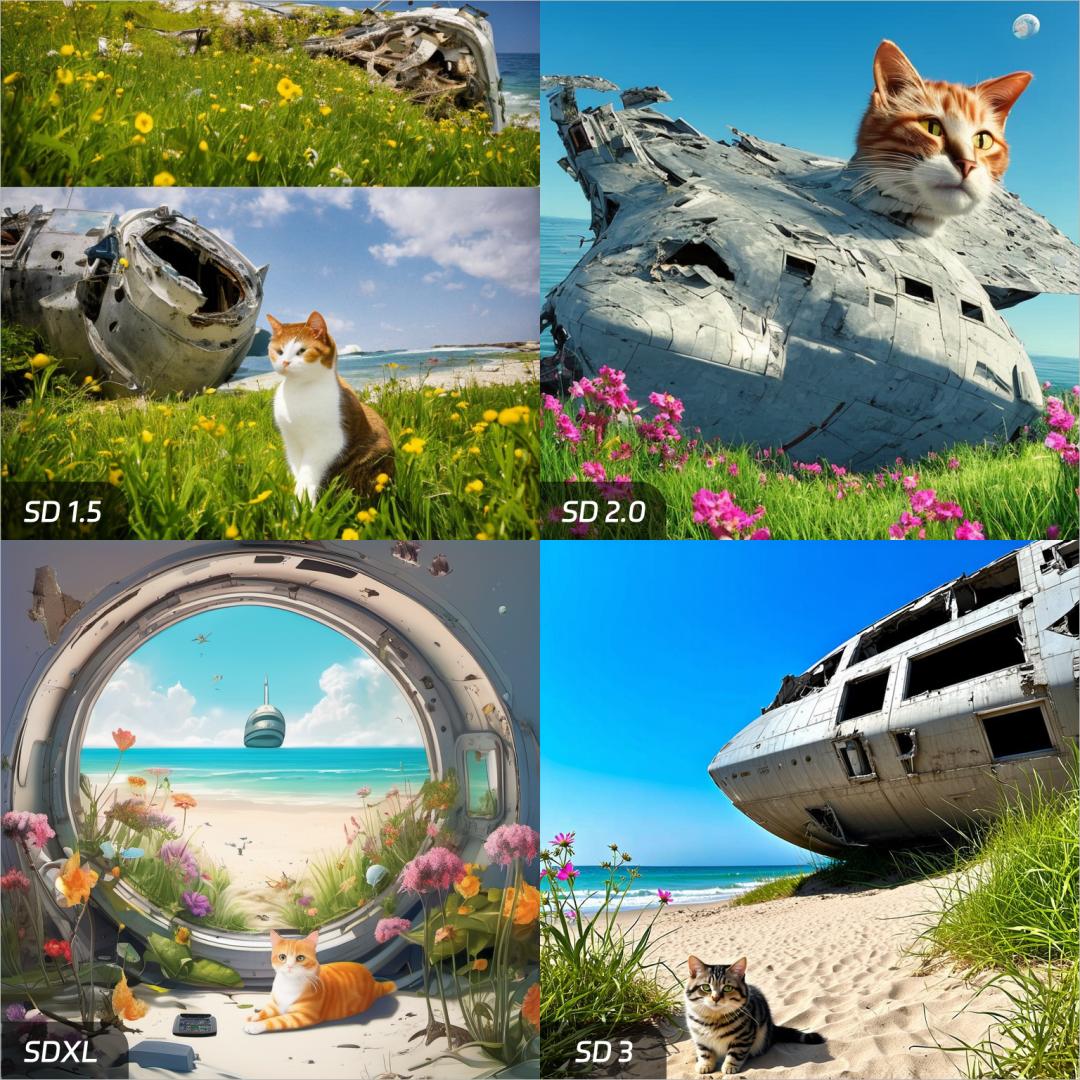

SD1.5\SD2.0\SDXL\SD3的七组对比测试

1. 第一组内容提示词,看一下语义理解能力。

a cat,a destroyed badly damaged space ship,beautiful beach,broken windows, grass and flowers grow around,sunny,ocean(一只猫,一艘被摧毁的严重受损的宇宙飞船,美丽的海滩,破碎的窗户,周围长着草和鲜花,阳光明媚,海洋)

SD1.5:emmmmmm,这怎么成两张了,小猫咪看起来不太高兴啊,挎着个脸,海滩不太美丽雅,阳光呢?

SD2.0:不是,小猫怎么从船里长出来了,还有月亮你是怎么回事儿?不是说好的太阳吗。

SDXL:整体还行,但画面有点昏暗,配色不是很舒服。

SD3:王炸!语义理解能力极强,阳光明媚,美丽的海滩,鲜花……关键细节什么的都很好,画面也很和谐。

-

2. 再来测一下相对位置关系理解,这个更加考验模型能力。

a dog,hold hot dog,outdoors,grass(一只狗,叼着热狗,户外,草地)

SD1.5:emmmmmm,这小狗的热狗怎么悬空了啊?你的热狗怎么成香肠了?

SD2.0:SD2.0比较聪明,他直接把热狗放到了地上,哈哈这样你就挑不出我毛病了吧,但是语义理解不对啊大哥。

SDXL:基本理解了我的意思,但是这个画风,以及这个舌头衔接太奇怪了吧。

SD3:王炸!光效衔接都非常自然,小狗很可爱,热狗也很有食欲。

-

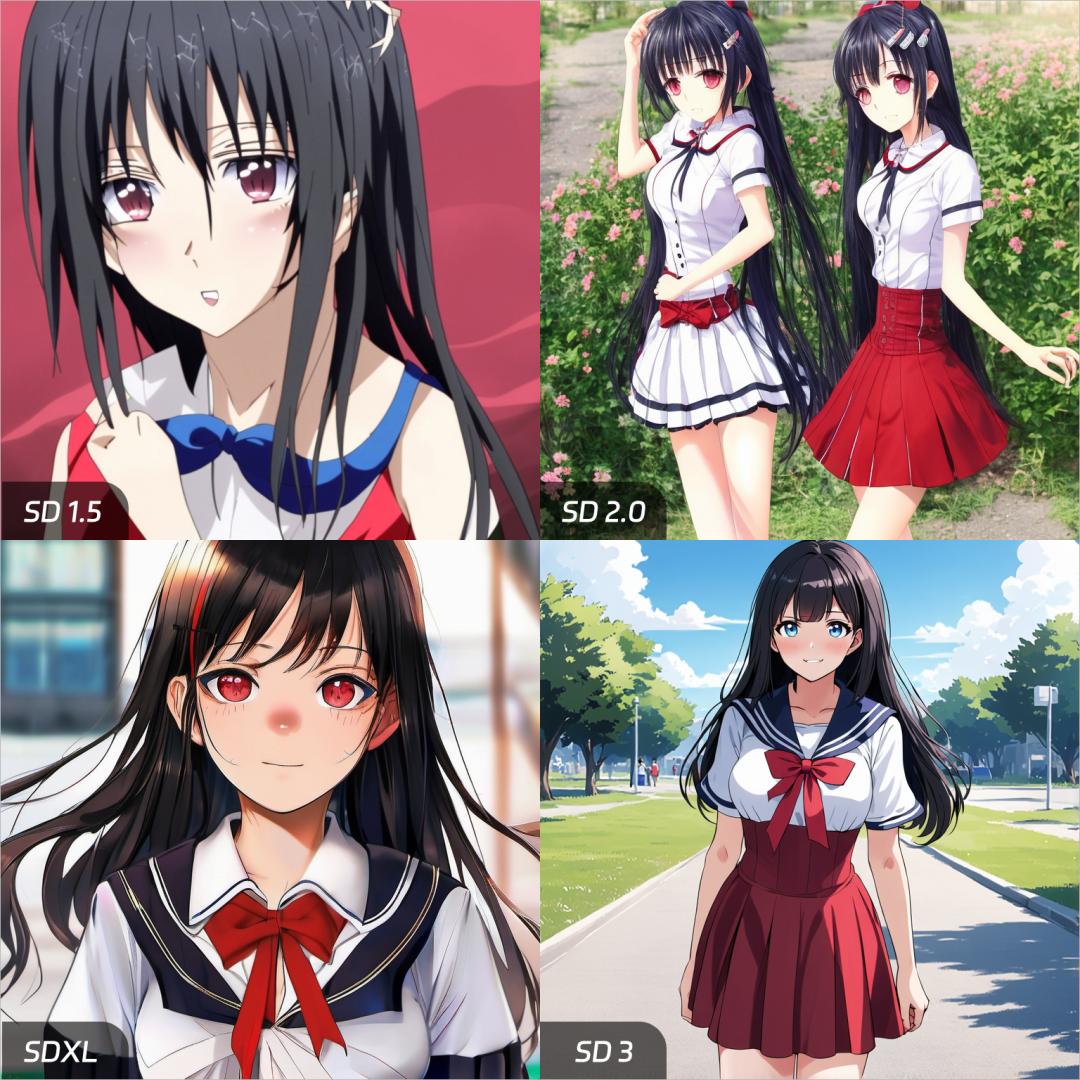

3.测试一下二次元动漫人物。

((anime style)),1girl, indoors, sitting on the sofa, living room, pink hair, blue eyes, from back, from above, face towards viewer, playing video games, holding controller, white shirt, short, parted lips, anime production(((动漫风格)),1女孩,室内,坐在沙发上,客厅,粉红色的头发,蓝眼睛,从后面,从上面,脸朝向观众,玩电子游戏,拿着手柄玩游戏,白衬衫,短,分开的嘴唇,动漫制作)

SD1.5:底模过于抽象。。。很多细节都丢失了,对比着看一下吧,从头发到眼睛。

SD1.5:千手观音?

SDXL:有点感觉了,但是你的画风画质很难评

SD3:没的说,依然是王炸!从头发到眼镜,从整体画质,到细节,No1!

动漫还做了另一组对比图。

你懂的= =

-

4. 再测试一下不同的科幻风格

robot droids, in the desert , colorful, dutch angle(机器人, 在沙漠中, 五颜六色)

SD1.5:这机器人,是营养不良吧?哈哈哈 还有说好的五颜六色呢?

SD2:右边这哥们你的手臂掉了~其他不必多说了,懂得都懂嘿嘿

SDXL:还行,但是这个机器人怎么这么丑呢,三条腿不对称

SD3:同样很Nice,依然是王炸,除了这颜色跟我理解的五颜六色不太一样。

-

5. 再测一组真人图片,难度也蛮大的,要求在水下。

1boy,underwater,green eyes,white skirt,looking at viewer(1个男孩,水下,绿色眼睛,白色裙子,看着观众)

SD1.5:恐怖片。。。

SD 2.0:更恐怖了,有点像泡开的奥特曼。。

SDXL:还可以,凑合能看,就是这绿的啊。

SD3:非常NIce!

再测另一组真人的。

-

6. 来一组风景。

universe,stars,moon(宇宙、星星、月亮)

SD1.5:有点像我爸的微信头像。。。

SD 2.0:凑合,就是构图雪崩。

SDXL:SDXL是真的好容易画卡通。

SD3:这氛围就到位了。

-

7.最后一个SD3最棒的,文字嵌入。

Cyberpunk style,urban,1 robot,an electronic screen with“ Khazix”(赛博朋克风格,都市,1个机器人,一个带有“卡兹克斯”的电子屏幕)

这个就不评价了,因为过往的SD模型,都不支持文字嵌入,目前SD3是独一份。

上面简单对比完之后,你可以直观感受到SD3的威力了,也能感受到,Stable Diffusion这个模型,一路以来的进化史。

FLUX*(仅提供 Inference)*

black-forest-labs/flux: Official inference repo for FLUX.1 models

FLUX.1是由Stable Diffusion创始团队推出的开源A|图像生成模型,拥有12B参数,是迄今为止最大的文生图模型。包含三种变体:顶级性能的FLUX.1[pro]、开源非商业用途的FLUX.1 [dev]和 快速高效的FLUX.1[schnel]。FLUX.1以卓越的图像质量、高度逼真的人体解剖学表现和先进的提示词遵循能力脱颖而出,为A图像生成设定了新的行业标准。

FLUX.1的功能特色

- **大规模参数:**拥有12B(120亿)参数,是迄今为止最大的开源文本到图像模型之一

- **多模态架构:**基于多模态和并行扩散Transformer块的混合架构,提供强大的图像生成能力。

- **高性能变体:**提供三种不同性能和用途的模型变体,包括专业版(FLUX.1[pro])、开发版(FLUX.1[dev])和快速版(FLUX.1[schnel)。

- **图像质量:**在视觉质量、提示词遵循、大小纵横比可变性、字体和输出多样性等方面超越了其他流行的模型,

- **开源和可访问性:**部分模型变体如FLUX.1和FLUX.1[schnel是开源的,易于研究和非商业应用。

- **技术创新:**引入了流匹配训练方法、旋转位置嵌入和并行注意力层,提高了模型性能和硬件效率。

FLUX.1的技术原理

- **多模态架构:**FLUX.1采用了多模态架构,这意味着模型能够同时处理和理解多种类型的数据,如文本和图像,从而更好地捕捉不同数据间的关联性。

- **并行扩散Transformer块:**模型利用并行扩散Transformer结构,这是一种先进的神经网络组件,能够高效地处理序列数据,增强模型对信息的编码和解码能力。

- **流匹配训练方法:**FLUX.1通过流匹配方法改进了传统的扩散模型。这种方法是一种通用的训练生成模型的技术,能够简化训练过程并提高模型的生成质量。

- **旋转位置嵌入:**模型引入了旋转位置嵌入技术,这是一种特殊的编码方式,可以增强模型对图像中不同位置特征的识别能力,从而提升图像的细节表现。

- **并行注意力层:**通过并行注意力机制,模型能够同时关注输入序列中的多个部分,这有助于捕捉长距离依赖关系并提高生成图像的准确性。

VAR 256\512 (训练、数据集均开源)

由北京大学和字节跳动联合研究团队近日发布其最新图像生成模型研究成果,论文标题为 "Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction" (视觉自回归建模:通过预测下一尺度来生成可扩展图像),并同步上线项目介绍及演示网站。

项目演示地址:https://var.vision/demo

Hugging Face 地址:FoundationVision/var · Hugging Face

论文地址:https://arxiv.org/abs/2404.02905

本文介绍了一种名为 Visual AutoRegressive modeling (VAR) 的新视觉生成框架。VAR重新定义了图像上的自回归学习,采用从粗糙到精细的“下一尺度预测”或“下一分辨率预测”的方法,与传统的栅格扫描“下一个标记预测”不同。VAR方法简单直观,使得自回归(AR)变换器能够快速学习视觉分布并具有良好的泛化能力。

VAR 在 ImageNet 256×256 基准测试中显著提高了AR基线的性能,通过将 Fréchet inception distance (FID) 从18.65降至1.80,inception score (IS) 从80.4提高到356.4,并实现了20倍更快的推理速度。这是首次GPT风格的自回归模型在图像生成方面超越了扩散变换器 (DiT),在图像质量、推理速度、数据效率和可扩展性等多个维度上均表现出色。

VAR模型的缩放行为呈现出与大型语言模型 (LLMs) 类似的幂律缩放定律,具有线性相关系数接近-0.998的明确证据。VAR还展示了在包括图像修复、外扩和编辑等下游任务中的零样本泛化能力。这些结果表明VAR已经初步模仿了LLMs的两个重要特性:缩放定律和零样本泛化。

论文的主要贡献包括:

- 提出了一种使用多尺度自回归范式的新视觉生成框架,为计算机视觉中的自回归算法设计提供了新的见解。

- 实证验证了VAR模型的缩放定律和零样本泛化潜力,这些特性模仿了大型语言模型(LLMs)的吸引力。

- 在图像合成方面,实现了自回归模型性能的突破,首次超越了强大的扩散模型。

- 提供了一个全面的开源代码套件,包括VQ tokenizer和自回归模型训练流程,以推动视觉自回归学习的进步。

论文还讨论了大型自回归语言模型的特性,如缩放定律和零样本泛化,并探讨了视觉生成领域的相关工作,包括图像tokenizer和自回归模型、遮蔽预测模型和扩散模型。此外,论文详细介绍了VAR的方法、实现细节,并提供了实证结果,包括与其他图像生成模型家族的比较、效率比较、缩放定律的验证以及零样本任务泛化的能力。最后,论文还进行了消融研究,验证了VAR框架的有效性和效率,并对未来的工作进行了展望。

Infinity-1024*(训练、数据集均开源)*

项目官网:Infinity

Hugging:FoundationVision/Infinity · Hugging Face

论文地址:2412.04431

Infinity是字节跳动推出的基于位级自回归建模的视觉生成模型,能根据语言指令生成高分辨率、逼真的像。Infinity通过无限词汇量的标记器、分类器和位自纠正机制,显著提升图像生成的细节和质量,超越现有的顶级扩散模型,生成一张1024x1024的高质量图像仅需0.8秒,比SD3-Medium快2.6倍,且具有更快的推理速度。Infinity为自回归文本到图像生成模型设定了新的性能标准。

Infinity的主要功能

- **文本到图像合成:**用户输入文本描述,系统将生成相应的图像内容。

- **空间推理:**在生成图像时考虑空间关系,确保图像的空间布局合理。

- **文本渲染:**在图像中渲染文本,根据用户的指令调整字体、样式、颜色等。

- **多风格和长宽比适应:**生成不同风格和长宽比的图像,适应多样化的视觉效果需求。

Infinity的技术原理

- **位视觉自回归建模:**基于位级别的预测框架重新定义视觉自回归模型,用无限词汇量的标记器和分类器。

- **无限词汇量标记器:**将标记器的词汇量扩展到无穷大,减少量化误差,提高细节重建能力。

- **位自纠正机制:**在训练过程中随机翻转某些位模拟预测错误,并重新量化残差特征,让系统具备自我纠正的能力。

- **变换器(Transformer)扩展:**扩展变换器的大小增强模型的生成能力。

- **量化连续特征:**将连续的特征量化为索引标签,通过位标签(量化特征)提供稳定的监督信号。

References

-如何看待SD3 版本,和SDXL相比有何优势?_sd3和sdxl-CSDN博客

-试完刚刚开源的Stable Diffusion 3,我觉得能打败它的只有下一代_澎湃号·湃客_澎湃新闻-The Paper

-SD3.5模型详细测评!Stability.AI 发布 SD3.5 Large 模型,能否逆风翻盘超越FLUX?-CSDN博客

-FLUX.1 - Stable Diffusion创始团队推出的开源AI图像生成模型 | AI工具集

-Visual AutoRegressive modeling (VAR) 视觉自回归建模:通过下一尺度预测生成图像的新模型 - 知乎

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?