#dataDir=/tmp/zookeeper

dataDir=temp/zookeeper/data

dataLogDir=temp/zookeeper/log

the port at which the clients will connect

clientPort=2181

the maximum number of client connections.

increase this if you need to handle more clients

#maxClientCnxns=60

Be sure to read the maintenance section of the

administrator guide before turning on autopurge.

http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

Purge task interval in hours

Set to “0” to disable auto purge feature

#autopurge.purgeInterval=1

server.0=127.0.0.1:2888:3888

server.1=127.0.0.1:2889:3889

server.2=127.0.0.1:2890:3890

dayuan@MY-20190430BUDR:/mnt/d/zookeeper-cluster/zookeeper-1$

解释:server.服务器ID=服务器IP地址:服务器之间通信端口:服务器之间投票选举端口

启动集群

启动集群就是分别启动每个实例,启动后我们查询一下每个实例的运行状态

itcast@Server-node:/mnt/d/zookeeper-cluster/zookeeper-1$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /mnt/d/zookeeper-cluster/zookeeper-1/bin/…/conf/zoo.cfg

Mode: leader

itcast@Server-node:/mnt/d/zookeeper-cluster/zookeeper-2$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /mnt/d/zookeeper-cluster/zookeeper-2/bin/…/conf/zoo.cfg

Mode: follower

itcast@Server-node:/mnt/d/zookeeper-cluster/zookeeper-3$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /mnt/d/zookeeper-cluster/zookeeper-3/bin/…/conf/zoo.cfg

Mode: follower

2.Kafka集群搭建

集群目录

itcast@Server-node:/mnt/d/kafka-cluster$ ll

total 0

drwxrwxrwx 1 dayuan dayuan 512 Aug 28 18:15 ./

drwxrwxrwx 1 dayuan dayuan 512 Aug 19 18:42 …/

drwxrwxrwx 1 dayuan dayuan 512 Aug 28 18:39 kafka-1/

drwxrwxrwx 1 dayuan dayuan 512 Jul 24 14:02 kafka-2/

drwxrwxrwx 1 dayuan dayuan 512 Jul 24 14:02 kafka-3/

drwxrwxrwx 1 dayuan dayuan 512 Aug 28 18:15 kafka-4/

itcast@Server-node:/mnt/d/kafka-cluster$

server.properties

broker 编号,集群内必须唯一

broker.id=1

host 地址

host.name=127.0.0.1

端口

port=9092

消息日志存放地址

log.dirs=/tmp/kafka/log/cluster/log3

ZooKeeper 地址,多个用,分隔

zookeeper.connect=localhost:2181,localhost:2182,localhost:2183

启动集群

分别通过 cmd 进入每个 Kafka 实例,输入命令启动

…

[2019-07-24 06:18:19,793] INFO [Transaction Marker Channel Manager 2]: Starting (kafka.coordinator.transaction.TransactionMarkerChannelManager)

[2019-07-24 06:18:19,793] INFO [TransactionCoordinator id=2] Startup complete. (kafka.coordinator.transaction.TransactionCoordinator)

[2019-07-24 06:18:19,846] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

[2019-07-24 06:18:19,869] INFO [SocketServer brokerId=2] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

[2019-07-24 06:18:19,879] INFO Kafka version: 2.2.1 (org.apache.kafka.common.utils.AppInfoParser)

[2019-07-24 06:18:19,879] INFO Kafka commitId: 55783d3133a5a49a (org.apache.kafka.common.utils.AppInfoParser)

[2019-07-24 06:18:19,883] INFO [KafkaServer id=2] started (kafka.server.KafkaServer)

三、多集群同步

MirrorMaker是为解决Kafka跨集群同步、创建镜像集群而存在的;下图展示了其工作原理。该工具消费源集群消息然后将数据重新推送到目标集群。

1.配置

创建镜像

使用MirrorMaker创建镜像是比较简单的,搭建好目标Kafka集群后,只需要启动mirror-maker程序即可。其中,一个或多个consumer配置文件、一个producer配置文件是必须的,whitelist、blacklist是可选的。在consumer的配置中指定源Kafka集群的Zookeeper,在producer的配置中指定目标集群的 Zookeeper(或者broker.list)。

kafka-run-class.sh kafka.tools.MirrorMaker –

consumer.config sourceCluster1Consumer.config –

consumer.config sourceCluster2Consumer.config –num.streams 2 –

producer.config targetClusterProducer.config –whitelist=“.*”

consumer配置文件:

format: host1:port1,host2:port2 …

bootstrap.servers=localhost:9092

consumer group id

group.id=test-consumer-group

What to do when there is no initial offset in Kafka or if the current

offset does not exist any more on the server: latest, earliest, none

#auto.offset.reset=

producer配置文件:

format: host1:port1,host2:port2 …

bootstrap.servers=localhost:9092

specify the compression codec for all data generated: none, gzip, snappy, lz4, zstd

compression.type=none

2.调优

同步数据如何做到不丢失 首先发送到目标集群时需要确认:request.required.acks=1 发送时采用阻塞模式,否则缓冲区满了数据丢弃:queue.enqueue.timeout.ms=-1

总结

本章主要对Kafka集群展开讲解,介绍了集群使用场景,Zookeeper和Kafka多借点集群的搭建,以及多集群的同步操作。

参考资料:《Java中高级核心知识全面解析》

Java工程师18种简历模板免费获取方式:私信【资料】免费获取

还有更多Java PDF学习资料等你来拿!!!

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

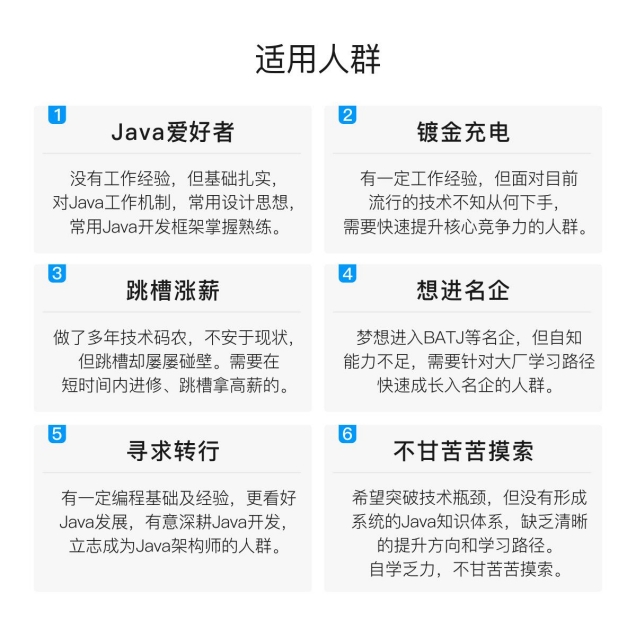

深知大多数Java工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Java开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

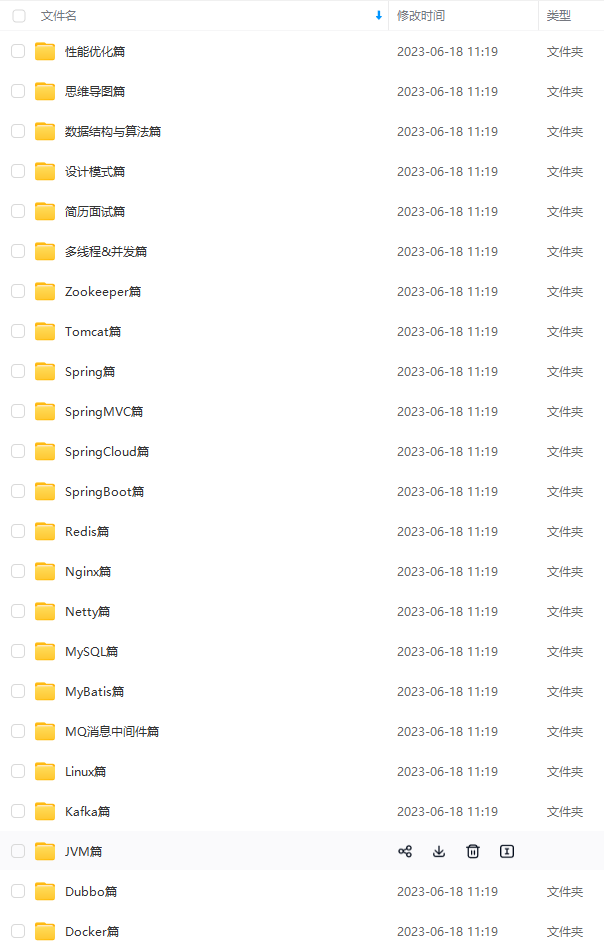

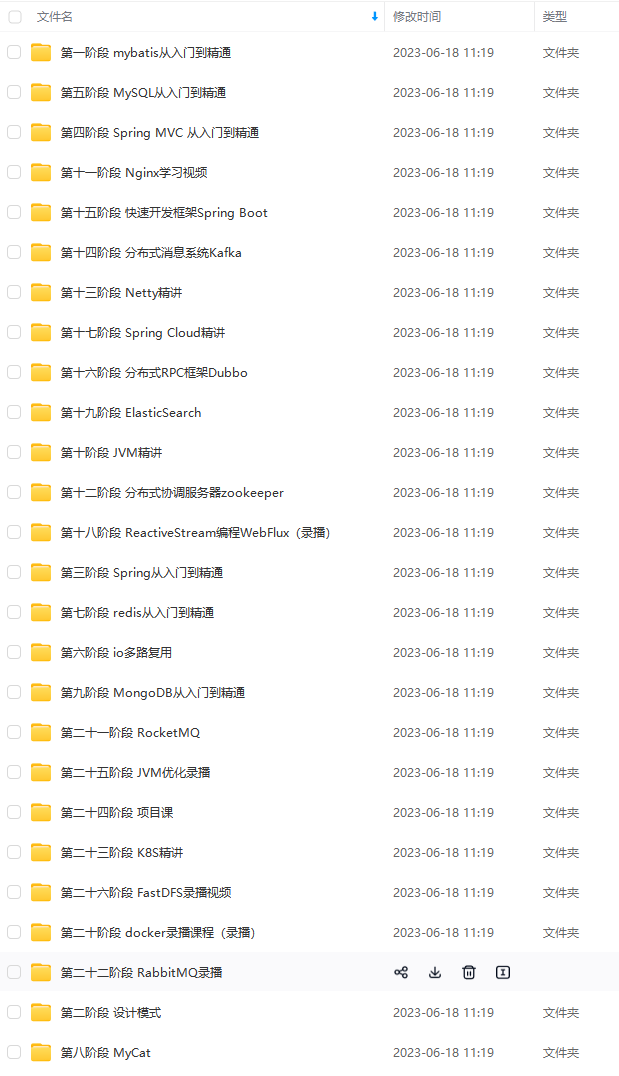

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Java开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024b (备注Java)

最后

针对最近很多人都在面试,我这边也整理了相当多的面试专题资料,也有其他大厂的面经。希望可以帮助到大家。

下面的面试题答案都整理成文档笔记。也还整理了一些面试资料&最新2021收集的一些大厂的面试真题(都整理成文档,小部分截图)

最新整理电子书

下面的面试题答案都整理成文档笔记。也还整理了一些面试资料&最新2021收集的一些大厂的面试真题(都整理成文档,小部分截图)

[外链图片转存中…(img-6aQQitS3-1711963506084)]

最新整理电子书

[外链图片转存中…(img-oXjbVE0c-1711963506084)]

1276

1276

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?