习题2.1

平方损失函数:

L(x)=1N∑Ni=1(yi−yi^)2

它直接测量机器学习模型的输出与实际结果之间的距离,为学习模型的输出,

为实际结果。

交叉熵损失函数:

L(x)=−∑ni=1p(xi)log(q(xi))L(x)=−∑i=1np(xi)log(q(xi))

交叉熵是用来评估当前训练得到的概率分布与真实分布的差异情况,减少交叉熵损失就是在提高模型的预测准确率。是真实分布的概率,是模型通过数据计算出来的概率估计

1.为什么平方损失函数不适用于分类问题?

我们要明确分类问题的概念:在二分类问题中 y = { + 1 , − 1 } ,在 C分类问题中 y = { 1 , 2 , 3 , ⋅ ⋅ ⋅ , C }可以看出分类问题输出的结果为离散的值。分类问题中的标签,是没有连续的概念的。每个标签之间的距离也是没有实际意义.比如分类 1,2,3, 真实分类是1, 而被分类到2和3错误程度应该是一样的,但是明显当我们预测到2的时候是损失函数的值为1/2而预测到3的时候损失函数为2.

2.为什么交叉熵损失函数不适用于回归问题?

通过交叉熵损失函数,我们可以看出交叉熵损失函数针对只分类正确的预测结果,和分类错误的预测结果无关,而在回归中,考虑错误是极其必要的,需要让回归的函数尽可能满足所有的样本包括错误的样本,所以交叉地损失函数不适用回归问题。

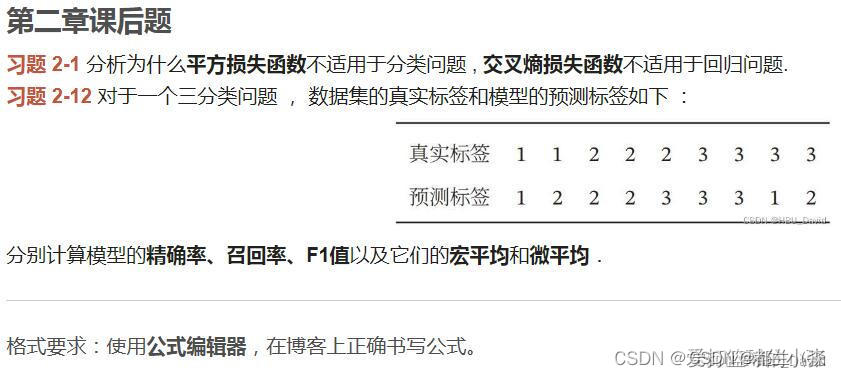

习题 2-12

分类结果混淆矩阵如下:

| 真实情况 | 预测结果 | ||

| 正例 | 反例 | ||

| 正例 | TP(真正例) | FN(假反例) | |

| 反例 | FP(假正例) | TN(真反例) | |

精确率(查准率):

P=TP/(TP+FP)

召回率(查全率):

R=TP/(TP+FN)

所以由此得

P1=1/2

P2=1/2

P3=2/3

R1=1/2

R2=2/3

R3=1/2

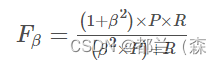

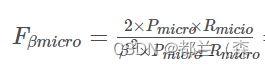

F1值(综合评价指标):

F1值是精确率和召回率的加权调和平均。

为了满足人们查全率与查准率的不同偏好,F1度量的一般形式为Fβ

其中β>0度量了查全率对查准率的相对重要性。β=1时退化为标准的F1;β>1时查全率影响更大,β<1时查准率影响更大 。

这道题令β=1

得到

Fβ1=1/2

Fβ2=4/7

Fβ3=4/7

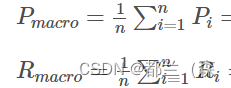

宏平均(每一类性能指标的算术平均):

由公式得

Pmacro=5/9

Rmacro=5/9

Fmacro=5/9

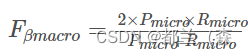

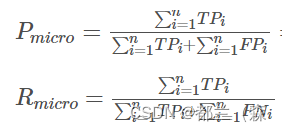

微平均(每个样本的性能指标的算术平均值):

由公式得

Pmicro=59

Rmicro=59

Fmicro=59

本次博客由于公式功能不熟练,一些公式直接通过照片截屏放置,之后会进行专项学习弥补欠缺

73

73

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?