目录

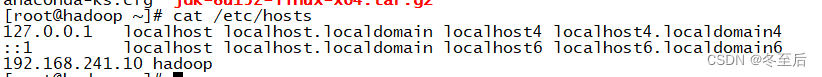

1.查看Linux是否安装了java jdk,如果查询有其他的java版本,则需要删除

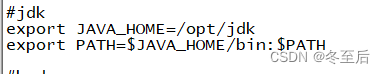

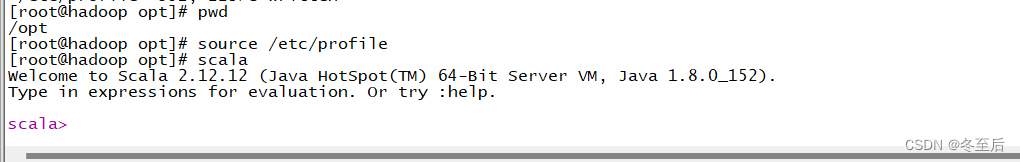

4.配置文件生效 source /etc/profile---也可以写成 . /etc/profile

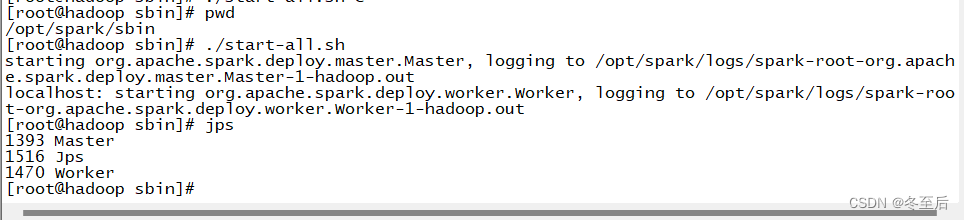

4.启动集群:spark下sbin目录下:./start-all.sh编辑

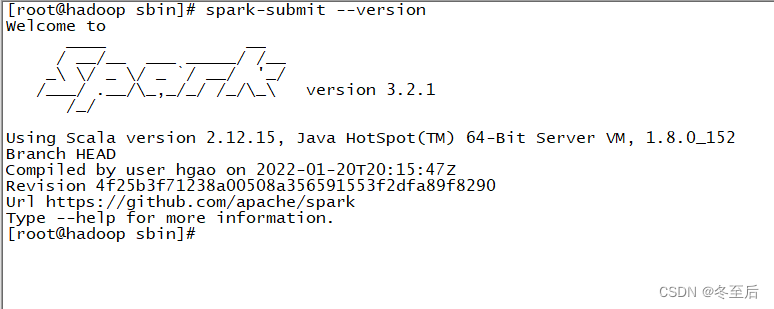

6.查看spark是否安装成功 返回主目录下输入spark-submit --version

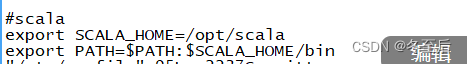

1.scala的配置文件,直接写在/etc/profile下

2.source /etc/profile使环境变量生效,接着scala -version查看是否安装成功,出现画线版本号即为成功(或者直接输入scala)编辑

以下是要准备的包:

1.java的包--jdk

![]()

2.hadoop的包

![]()

spark和scala是基于Hadoop环境部署安装的

3.scala包:

https://www.scala-lang.org/download/all.html

注意:这里spark与scala的包最好都统一版本,还有下以.tgz结尾的包

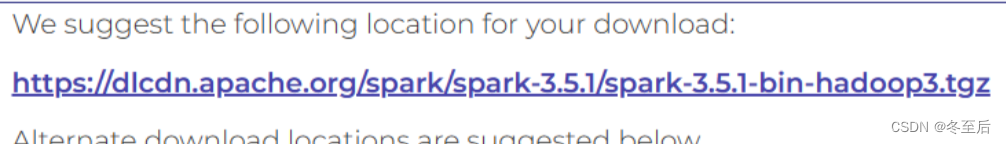

4.spark包:

Index of /spark/spark-3.5.1 (apache.org)

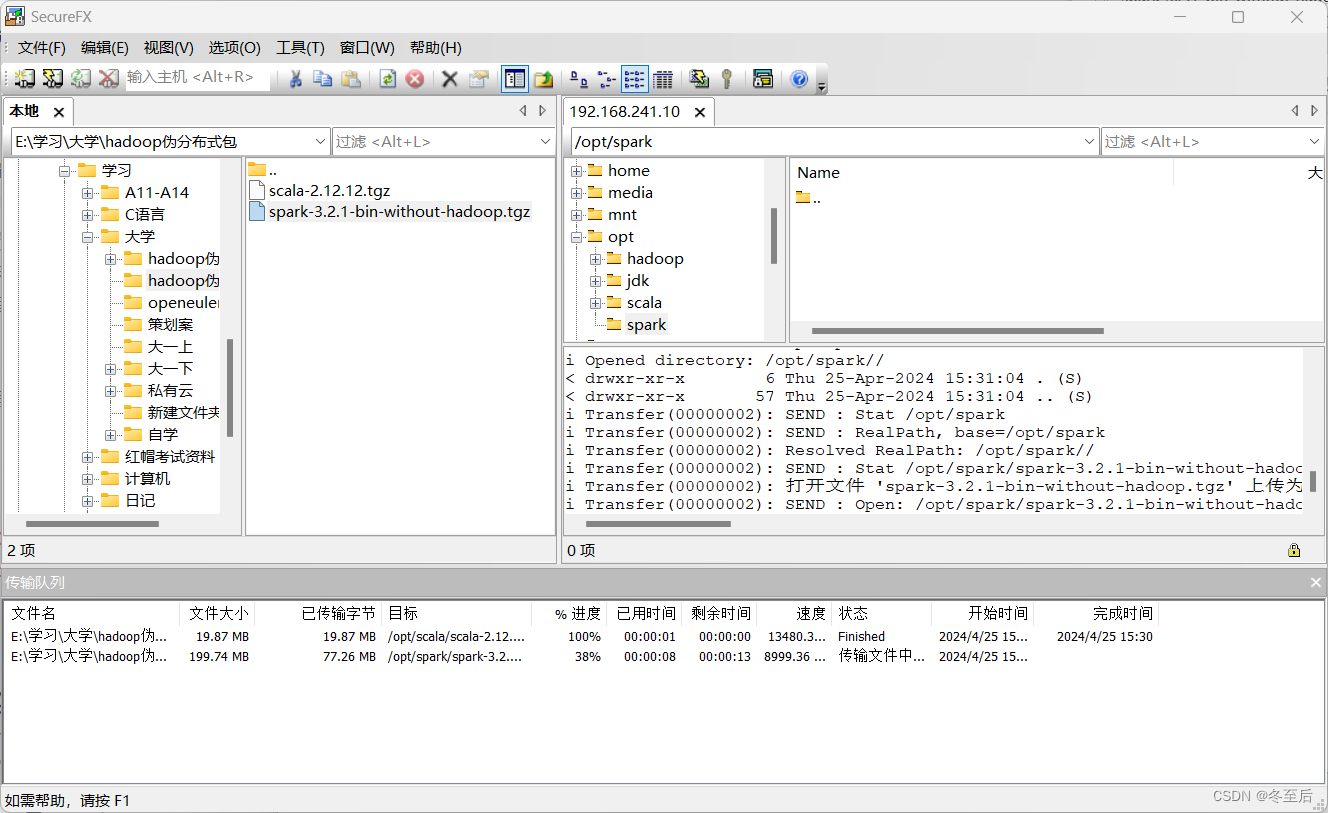

上传到linux上(记住位置)

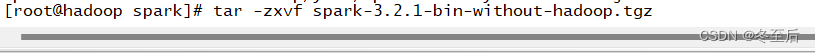

首先解压spark

之后在解压scala,与spark的解压同理

hadoop与java也是一样的解压方式

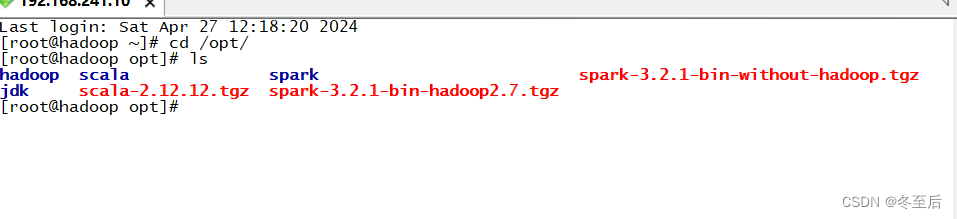

我的文件位置,以下的操作皆为我的文件位置来写

把以上的压缩包都准备好,接下来开始搭建hadoop+spark+scala伪分布式集群

基础环境

注意:在搭建Hadoop的时候需要关闭防火墙与安全上下文(这里默认以及配好ip)

1.修改主机名

hostnamectl set-hostname hadoop[修改的主机名]

bash //启动

2.网络映射

vi /etc/hosts

java环境配置

1.查看Linux是否安装了java jdk,如果查询有其他的java版本,则需要删除

删除命令:rpm -e --nodeps [java名]

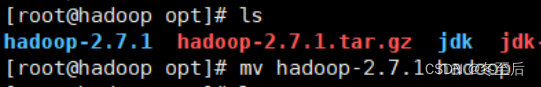

2.解压,压缩包与重命名

重命名: mv [原文件] [新文件]

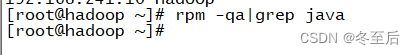

3.修改java环境变量

在最后三行写:vi /etc/profile

export JAVA_HOME=/opt/jdk

export PATH=$JAVA_HOME/bin:$PATH

4.配置文件生效 source /etc/profile---也可以写成 . /etc/profile

hadoop的环境配置

1.解压hadoop

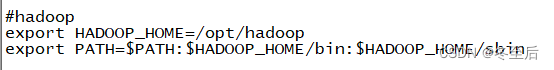

2.修改配置文件vi /etc/profile

在最后三行写!! 以下所有的配置文件都是在最后写

#hadoop

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

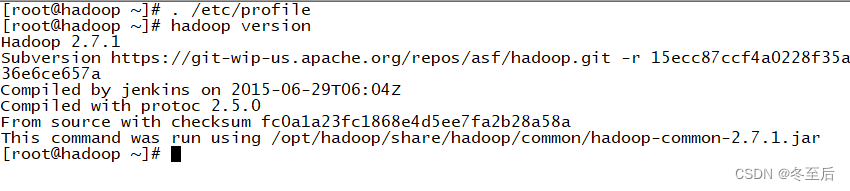

3.配置文件生效,查看hadoop的版本

hadoop集群伪分布式

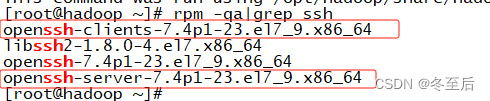

一、查看是否安装了ssh

主要的圈了起来:

如果没有的话需要安装:

yum install -y openssh-clients openssh-server

2.启动ssh服务

systemctl restart sshd

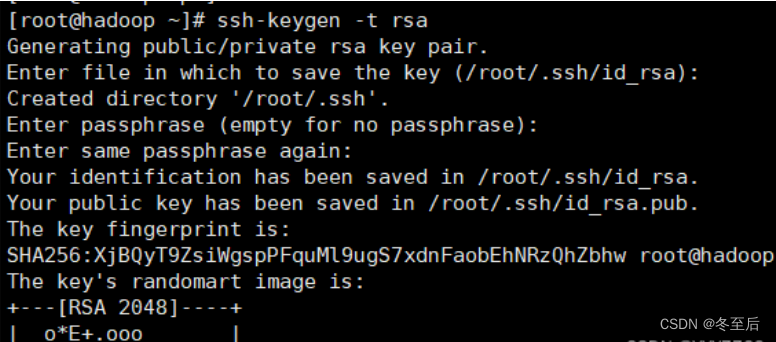

3.本机生成公钥,私钥和验证文件

回车三次即可

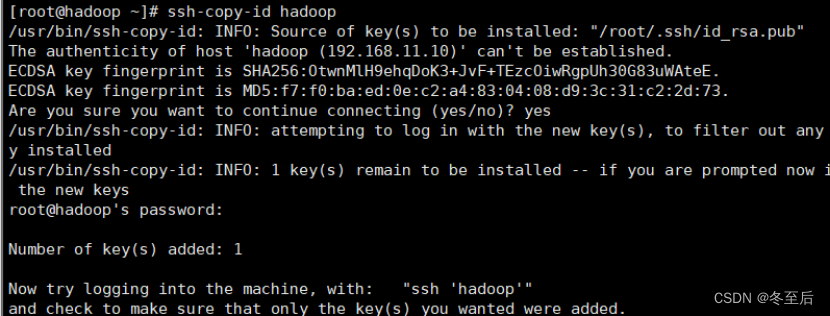

4.将登录的信息复制到验证文件

注意:输入该指令后需要自行输入登录密码

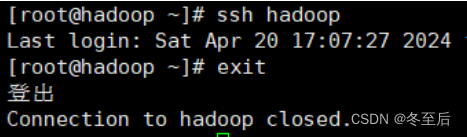

这样就配置好免密登录了可以尝试ssh登录命令查看是否配置成功:

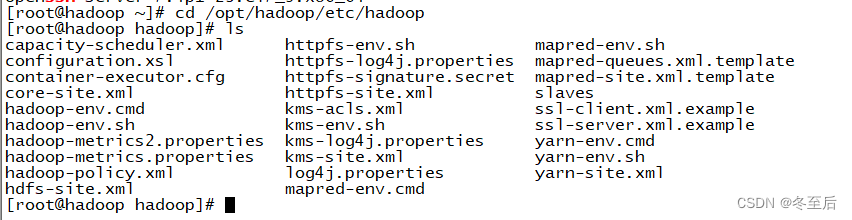

二、HDFS的配置文件

进入到hadoop的配置目录:

![]()

以下的配置文件都在这个目录下改

1.配置hadoop-env.sh

在这个配置文件最后换行添加

vi hadoop-env.sh

export JAVA_HOME=/opt/jdk //自己配置文件位置

2.配置vi core-site.xml

<configuration>

<!--配置hdfs文件系统的命名空间-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!-- 配置临时数据存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp/</value>

</property>

</configuration>

3.配置vi hdfs-site.xml

<configuration>

<!--指定HDFS副本的数量-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--设置默认端口,如果不加上会导致启动hadoop-3.1.0后无法访问50070端口查看HDFS管理界面,hadoop-2.7.7可以不加-->

<property>

<name>dfs.http.address</name>

<value>hadoop:50070</value>

</property>

</configuration>

4.格式化HDFS

配置好HDFS文件系统后首次启动需要进行格式化

注意:不可随意格式化namenode,格式化会删除namenode image和edits文件

再创建新的 image 和 edits,数据将会丢失,需要谨慎使用!!(以及格式化也是在上面的目录下)

hdfs namenode -format

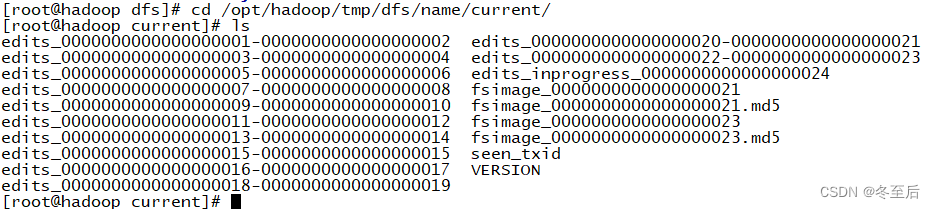

格式化成功后,会在hadoop.tmp.dir配置的/opt/hadoop/tmp目录生成目录dfs/name/current/,里面包含几个文件如下:

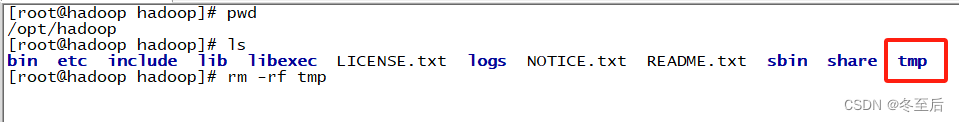

如果多次格式化应该做的是

找到这个文件夹下的tmp文件夹,删除这个文件夹,之后在mkdir tmp 一个文件夹

注意:名字不要改,文件夹的位置也不要改

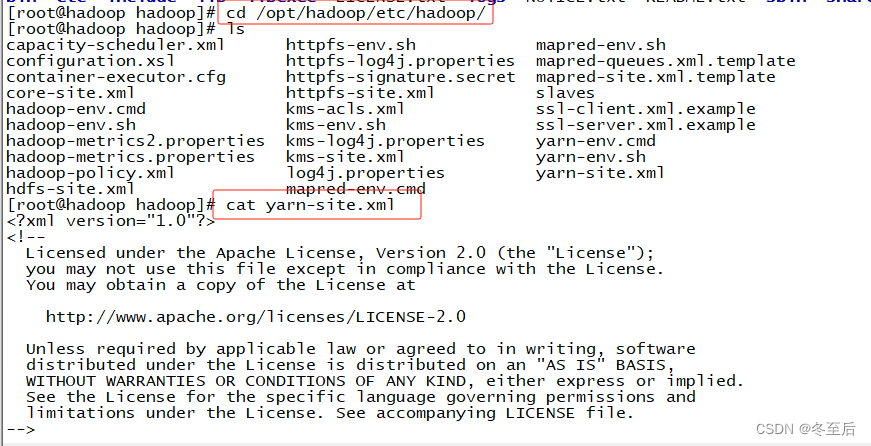

三、YARN的配置

1.进入hadoop配置目录:

cd /opt/hadoop/etc/hadoop/

在这个文件写写入

<configuration>

<!--RM的hostname-->

<property>

<name>yarn.resourcemanager.hostsname</name>

<value>hadoop</value>

</property>

<!--NodeManager上运行的附属服务。需配置成mapreduce_shuffle,才可运行MapReduce程序-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

2.配置mapred-site.xml.template

![]()

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

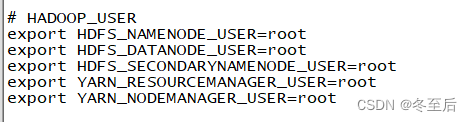

四、启动服务用户定义

1.用户定义 vi /etc/profile

# HADOOP_USER

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

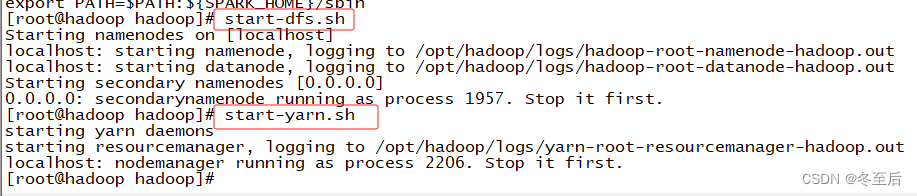

2.启动hdfs或yarn服务

启动:start-dfs.sh

启动:start-yarn.sh

![]() 这个目录下

这个目录下

spark的环境搭建

spark的配置文件位置

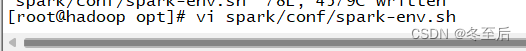

1.拷贝文件 在解压的目录下的../conf/

cd /opt/spark/conf/ //进入目录下

cp spark-env.sh.tmplate spark-env.sh //拷贝

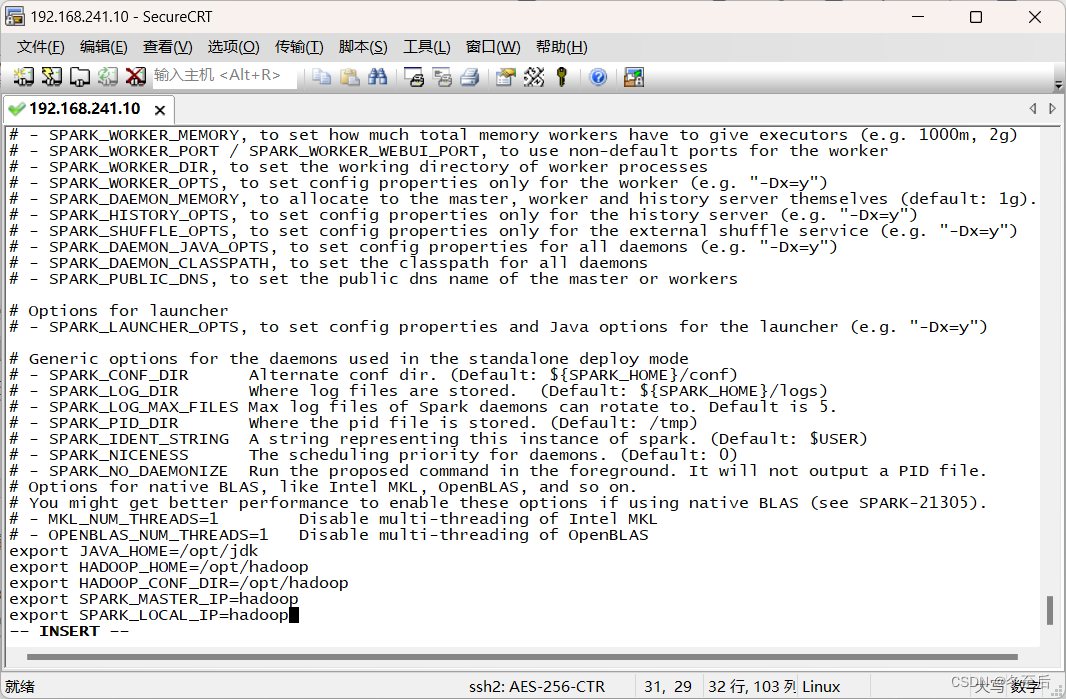

/conf/spark-env.sh

export JAVA_HOME=/opt/jdk //java的解压位置

export HADOOP_HOME=/opt/hadoop //hadoop的解压位置

export HADOOP_CONF_DIR=/opt/hadoop //hadoop的配置文件的位置,如果这个spark安装不起来那就换一个路径,就是hadoop的主配置文件位置 /opt/hadoop/etc/hadoop(如下所示)

export SPARK_MASTER_IP=hadoop //写本机名或者本机IP

export SPARK_LOCAL_IP=hadoop //写本机名或者本机IP![]()

2.主配置文件也要写/etc/profile

配置环境变量 vim /etc/profile

#SPARK

export SPARK_HOME=/opt/spark

export PATH=$PATH:${SPARK_HOME}/bin

export PATH=$PATH:${SPARK_HOME}/sbin

3. source /etc/profile使环境生效

4.启动集群:spark下sbin目录下:./start-all.sh

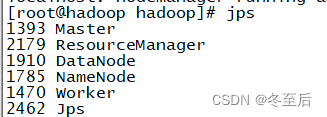

5.可用jps看是否有这三个进程

6.查看spark是否安装成功 返回主目录下输入spark-submit --version

scala环境搭

1.scala的配置文件,直接写在/etc/profile下

export SCALA_HOME=/opt/scala

export PATH=$PATH:${SCALA_HOME}/bin

2312

2312

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?