提前注意:请注意路径是否和我的相同,放置的位置不同(2024.08.13补充:修改后不再标红,请注意路径/export/server为你安装软件的路径)

HDFS部署

2024.08.11批注:俩篇文章没法互引,总有一篇链接会失效,如果需要的话去我主页找吧!一下就能翻到。Hadoop集群部署【一】HDFS详细介绍以及HDFS集群环境部署

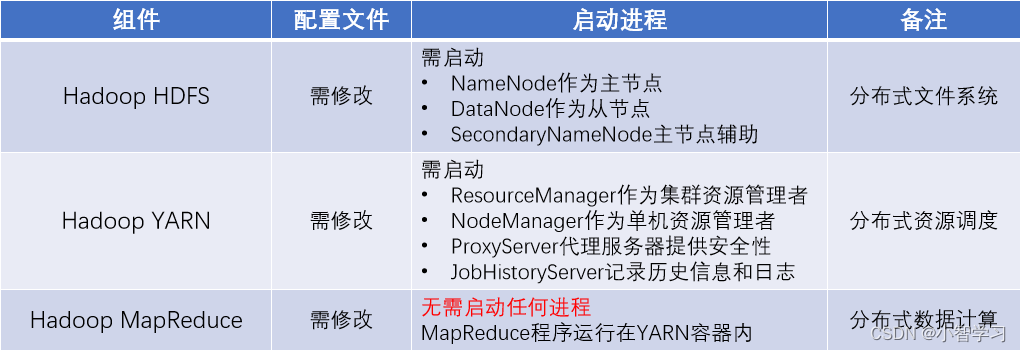

部署说明

Hadoop HDFS分布式文件系统,我们会启动:

NameNode进程作为管理节点

DataNode进程作为工作节点

SecondaryNamenode作为辅助

同理,Hadoop YARN分布式资源调度,会启动:

ResourceManager进程作为管理节点

NodeManager进程作为工作节点

ProxyServer、JobHistoryServer这两个辅助节点

那么,MapReduce呢?

MapReduce运行在YARN容器内,无需启动独立进程

所以关于MapReduce和YARN的部署,其实就是2件事情:

关于MapReduce: 修改相关配置文件,但是没有进程可以启动

关于YARN: 修改相关配置文件, 并启动ResourceManager、NodeManager进程以及辅助进程(代理服务器、历史服务器)。

通过表格进行汇总

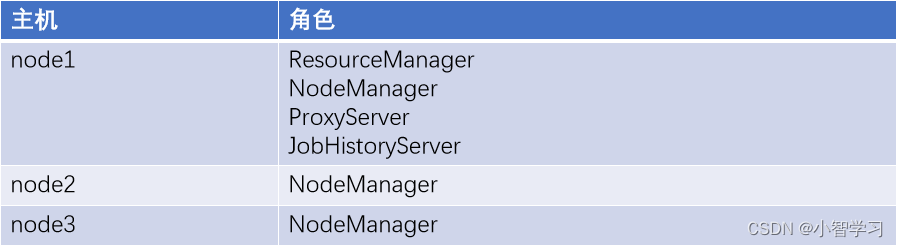

集群规划

注意:如果给的最高权限用户是hadoop,请在hadoop用户下进行下面的操作,其他用户同理。比如对于我的/export/server最高权限用户是Hadoop。

记住权限不够就换用户,比如修改系统配置文件/etc/profile时就需要root用户,当然可以sudo,如何给用户配置sudo权限,这里不做教程。

MapReduce配置文件

在 $HADOOP_HOME/etc/hadoop 文件夹内,修改:

mapred-env.sh文件,

添加如下

export JAVA_HOME=/export/server/jdk

export HADOOP_JOB_HISTORYSERVER_HEAPSIZE=1000

export HADOOP_MAPRED_ROOT_LOGGER=INFO,RFAmapred-site.xml文件

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> <description></description> </property> <property> <name>mapreduce.jobhistory.address</name> <value>node1:10020</value> <description></description> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>node1:19888</value> <description></description> </property> <property> <name>mapreduce.jobhistory.intermediate-done-dir</name> <value>/data/mr-history/tmp</value> <description></description> </property> <property> <name>mapreduce.jobhistory.done-dir</name> <value>/data/mr-history/done</value> <description></description> </property> <property> <name>yarn.app.mapreduce.am.env</name> <value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value> </property> <property> <name>mapreduce.map.env</name> <value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value> </property> <property> <name>mapreduce.reduce.env</name> <value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value> </property> </configuration>格式自己对一下哈!

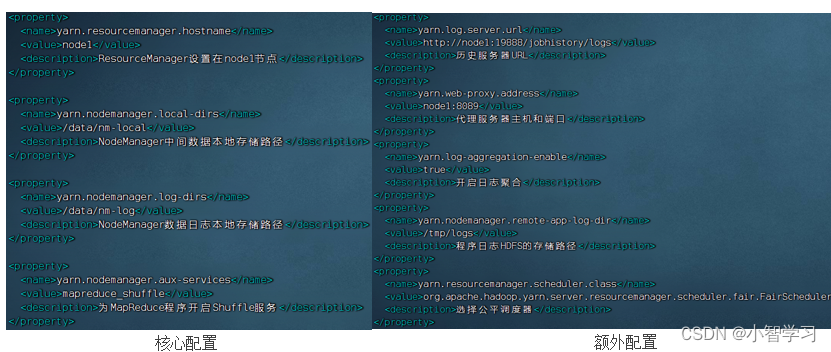

YARN配置文件

在 $HADOOP_HOME/etc/hadoop 文件夹内,修改:

yarn-env.sh文件

export JAVA_HOME=/export/server/jdk

export HADOOP_HOME=/export/server/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_LOG_DIR=$HADOOP_HOME/logsyarn-site.xml文件

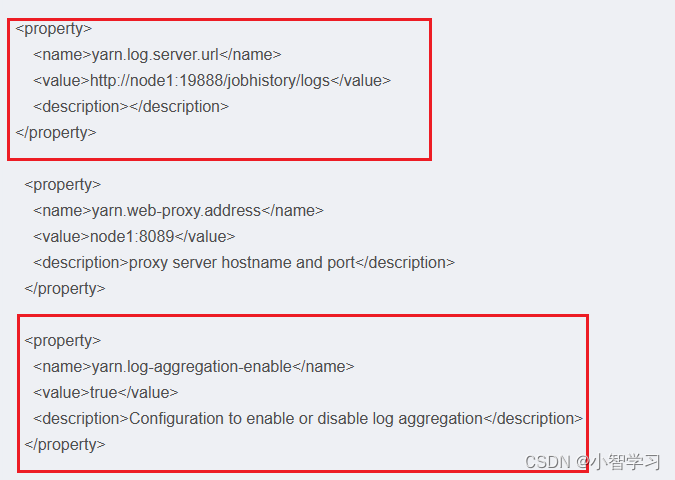

<configuration> <property> <name>yarn.resourcemanager.hostname</name> <value>node1</value> <description></description> </property> <property> <name>yarn.nodemanager.local-dirs</name> <value>/data/nm-local</value> <description>Comma-separated list of paths on the local filesystem where intermediate data is written.</description> </property> <property> <name>yarn.nodemanager.log-dirs</name> <value>/data/nm-log</value> <description>Comma-separated list of paths on the local filesystem where logs are written.</description> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> <description>Shuffle service that needs to be set for Map Reduce applications.</description> </property> <property> <name>yarn.log.server.url</name> <value>http://node1:19888/jobhistory/logs</value> <description></description> </property> <property> <name>yarn.web-proxy.address</name> <value>node1:8089</value> <description>proxy server hostname and port</description> </property> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> <description>Configuration to enable or disable log aggregation</description> </property> <property> <name>yarn.nodemanager.remote-app-log-dir</name> <value>/tmp/logs</value> <description>Configuration to enable or disable log aggregation</description> </property> <property> <name>yarn.resourcemanager.scheduler.class</name> <value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</value> <description></description> </property> <property> <name>yarn.nodemanager.log.retain-seconds</name> <value>10800</value> <description>Default time (in seconds) to retain log files on the NodeManager Only applicable if log-aggregation is disabled.</description> </property> </configuration>

解释:

MapReduce和YARN的配置文件修改好后,需要分发到其它的服务器节点中。

分发

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node2:`pwd`/

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node3:`pwd`/分发完成配置文件,就可以启动YARN的相关进程啦。

集群启动命令介绍(单纯介绍命令,正式启动请往下翻)

常用的进程启动命令如下:

一键启动YARN集群:

$HADOOP_HOME/sbin/start-yarn.sh会基于yarn-site.xml中配置的yarn.resourcemanager.hostname来决定在哪台机器上启动resourcemanager

会基于workers文件配置的主机启动NodeManager

一键停止YARN集群:

$HADOOP_HOME/sbin/stop-yarn.sh在当前机器,单独启动或停止进程

$HADOOP_HOME/bin/yarn --daemon start|stop resourcemanager|nodemanager|proxyserverstart和stop决定启动和停止

可控制resourcemanager、nodemanager、proxyserver三种进程

历史服务器启动和停止

$HADOOP_HOME/bin/mapred --daemon start|stop historyserver独立进程启停可用

$HADOOP_HOME/bin/yarn --daemon控制resourcemanager、nodemanager、proxyserver

$HADOOP_HOME/bin/mapred --daemon控制historyserver

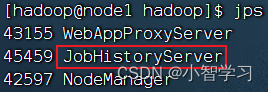

开始启动YARN集群

在node1服务器,以hadoop用户执行

首先执行:

$HADOOP_HOME/sbin/start-yarn.sh

一键启动所需的: ResourceManager NodeManager ProxyServer(代理服务器)

其次执行:

$HADOOP_HOME/bin/mapred --daemon start historyserver

启动: HistoryServer(历史服务器)

jps查看java进程

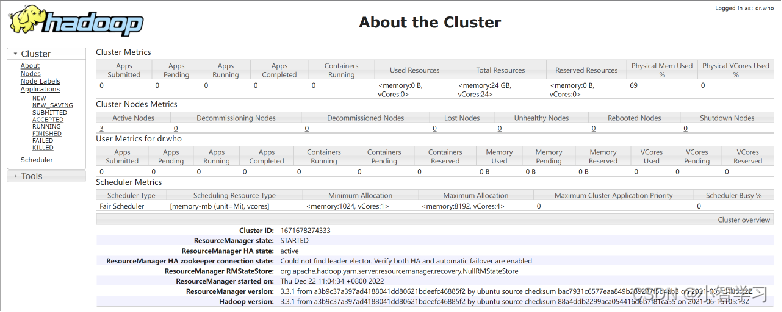

查看YARN的WEB UI页面

打开 http://node1:8088 即可看到YARN集群的监控页面(ResourceManager的WEB UI)

在最后,可以给虚拟机打上快照,保存安装状态

在最后,可以给虚拟机打上快照,保存安装状态

提交MapReduce程序至YARN运行

在部署并成功启动YARN集群后,我们就可以在YARN上运行各类应用程序了。

们目前先来体验一下在YARN上执行MapReduce程序的过程。

Hadoop官方内置了一些预置的MapReduce程序代码,我们无需编程,只需要通过命令即可使用。

常用的有2个MapReduce内置程序:

wordcount:单词计数程序。 统计指定文件内各个单词出现的次数

pi:求圆周率 通过蒙特卡罗算法(统计模拟法)求圆周率

这些内置的示例MapReduce程序代码,都在: $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar 这个文件内。

可以通过 hadoop jar 命令来运行它,提交MapReduce程序到YARN中。

语法:

hadoop jar 程序文件 java类名 [程序参数] ... [程序参数]提交wordcount示例程序

单词计数示例程序的功能很简单:

给定数据输入的路径(HDFS)、给定结果输出的路径(HDFS)

将输入路径内的数据中的单词进行计数,将结果写到输出路径

我们可以准备一份数据文件,并上传到HDFS中。

请随意填写内容,假设文件为words.txt,上传到HDFS

hadoop fs -mkdir -p /input/wordcount

hadoop fs -mkdir /output

hadoop fs -put words.txt /input/wordcount/执行如下命令,提交示例MapReduce程序WordCount到YARN中执行

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar wordcount hdfs://node1:8020/input/wordcount/ hdfs://node1:8020/output/wc1注意: 参数wordcount,表示运行jar包中的单词计数程序(Java Class)

参数1是数据输入路径(hdfs://node1:8020/input/wordcount/)

参数2是结果输出路径(hdfs://node1:8020/output/wc1), 需要确保输出的文件夹不存在

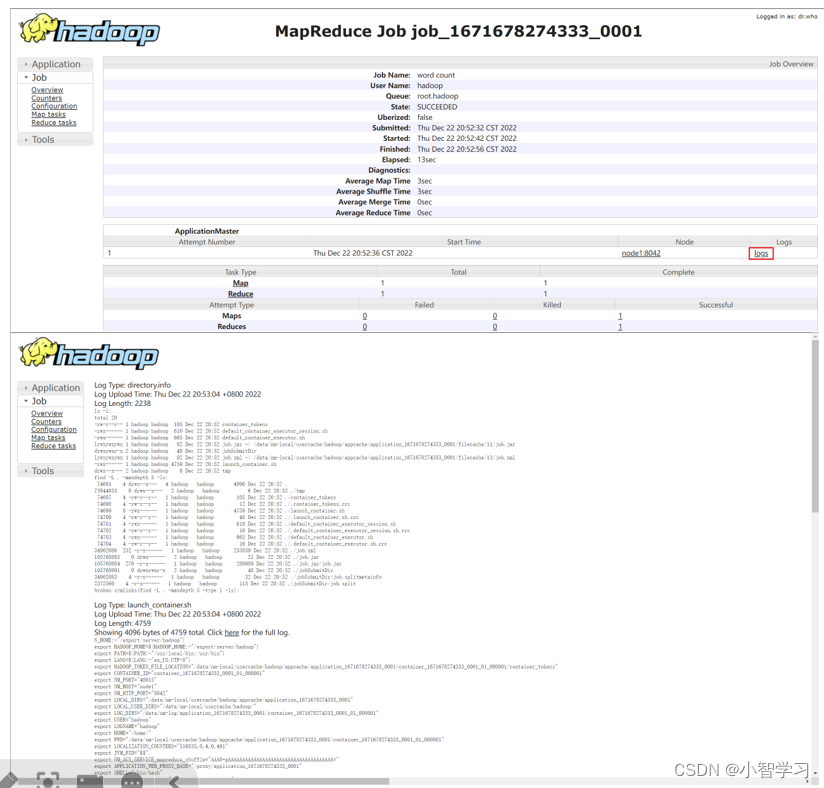

提交程序后,可以在YARN的WEB UI页面看到运行中的程序(http://node1:8088/cluster/apps)

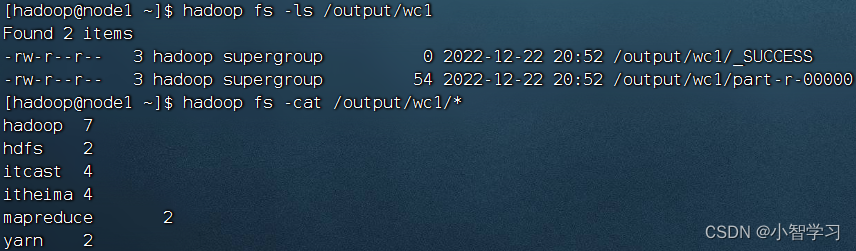

执行完成后,可以查看HDFS上的输出结果

执行完成后,可以查看HDFS上的输出结果

_SUCCESS文件是标记文件,表示运行成功,本身是空文件

part-r-00000,是结果文件,结果存储在以part开头的文件中

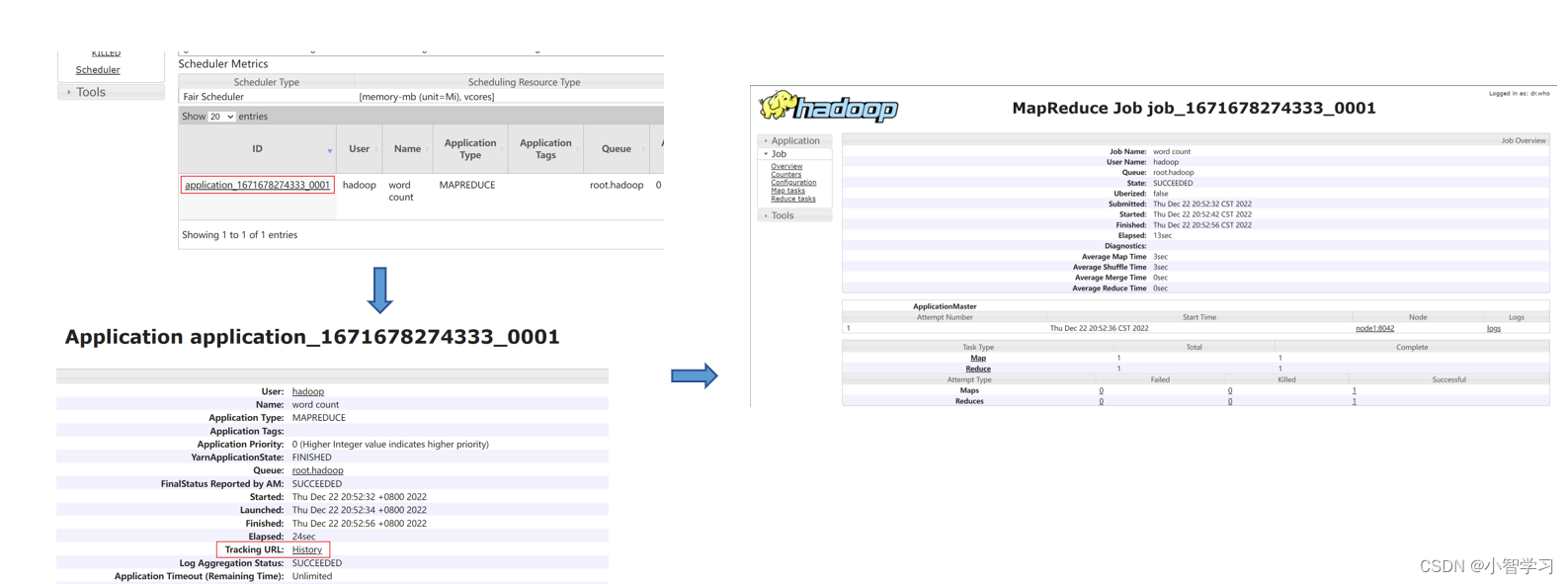

执行完成后,可以借助历史服务器查看到程序的历史运行信息 ps:如果没有启动历史服务器和代理服务器,此操作无法完成(页面信息由历史服务器提供,鼠标点击跳转到新网页功能由代理服务器提供)

查看运行日志

点击logs链接,可以查看到详细的运行日志信息。 此功能基于:

1. 配置文件中配置了日志聚合功能,并设置了历史服务器

2. 启动了代理服务器和历史服务器

3. 历史服务器进程会将日志收集整理,形成可以查看的网页内容供我们查看。

所以,如果发现无法查看程序运行历史以及无法查看程序运行日志信息,请检查上述1、2、3是否都正确设置。

关机可使用(有序关机,会先把启动的进程全部关闭后再关机)

shutdown -h now

3954

3954

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?